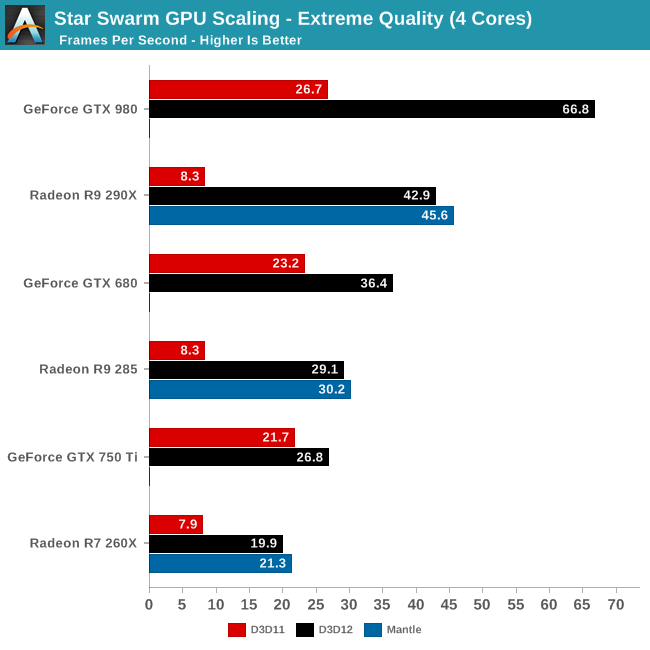

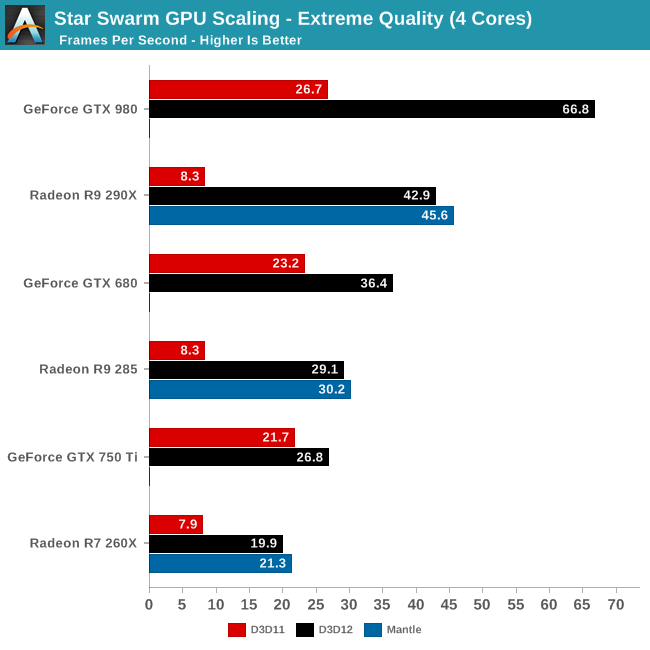

Interesante, así que al final vemos que:

1.- Todo el ruido generado con Mantle no ha servido para nada, no aporta nada respecto a D3D12 en cuanto a gestión del API por la cpu (sobre todo llamadas). Ya que el principal test con su argumento troncal sobre la utilidad de Mantle,

rinde básicamente igual con sus drivers D3D12 que con los Mantle, supuestamente más maduros los segundos y más ajustados a la arquitectura.2.- Después de que nvidia tirara el guante modificando y mejorando el driver D3D11 hace ya más de un año, AMD ha demostrado su nula intención de recogerlo ya que su rendimiento en D3D11 sigue siendo muy negligente comparativamente, teniendo en cuenta que la grandísima mayoría de juegos se portan y portarán a D3D11 antes que a cualquier otro lado (tanto por simplicidad como retrocompatibilidad con hard gráfico potente que sólo es compatible con éste), es una "gran idea" de AMD no haber hecho los deberes con D3D11.

Que una 750Ti esté a nada de triplicar el rendimiento de una 290X habla claro.3.- Nvidia para variar hace los deberes, no porque soporte dos arquitecturas distintas más que correctamente (como mínimo igual en kepler y maxwell 1.0, sino algo mejor), sino que además

lo hace de forma mucho más notable en un caso concreto, maxwell 2.0, sacando más de un 50% de ventaja a su rival "directo" en D3D12. O sea, que los drivers son en el peor de los casos equivalentes (habría que discutir si es normal que una 750Ti esté tan cerca en un test aunque se centre mucho en API y cpu, a una 285, y si la distancia relativamente baja entre 290X y 680 es "normal"), y en el mejor de los casos mucho mejor.

Habría que saber porqué rinde tanto maxwell 2.0, quizás viendo en contraste otras gpus de nvidia más potentes y kepler, y otras maxwell 2.0 menos potentes.

4.- Y por fin asistimos a la puntilla final para darle matarile a Mantle.

Ha dejado de tener sentido viendo estos datos, porque ni AMD ha permitido el acceso abierto a Mantle como había prometido (incumplimiento sistemático de la liberación del SDK "privado" que actualmente tiene con acceso sólo bajo autorización y firma de NDA), ni ahora tiene la menor importancia dado que falta bastante poco para la salida de windows 10 y D3D12.

Su principal argumento para vender Mantle siempre ha sido el evitar la sobrecarga de la cpu al gestionar el API, pues bien, con D3D12 esto se ha acabado, faltan meses para el lanzamiento de Windows 10 y D3D12, y cuando se haga, se hará de forma oficial y con las herramientas que nos tiene acostumbrados los de microsoft en sus lanzamientos de revisiones de DirectX, esto es, con SDKs y documentación a porrillo disponible y accesible para todo el mundo, de forma abierta aunque sea una plataforma cerrada y propietaria.

Muy al contrario de lo que se sigue viendo a día de hoy con AMD y su plataforma "abierta y no-pero-sí-propietaria", donde ni se dejan entrar a otros fabricantes de gpus (intel), ni se permite el acceso a SDKs a desarrolladores excepto autorización y firma de NDA.

¿Qué va a hacer AMD ahora, abrir por fin el SDK al público a 2-3 meses del lanzamiento de Windows 10, sí? Porque aún siguen sin decir nada de su último incumplimiento de fechas de publicación del SDK, donde juraban y perjuraban (R.Huddy) que como muy tarde días últimos de diciemde del.... 2014. Y eso dicho durante noviembre.

Ni en febrero ni en marzo se le espera, a este ritmo y callada como respuesta a su último incumplimiento (van tres como mínimo), ¿quién se va a molestar entre los desarrolladores independientes, los de verdad, los que no firman NDAs para hacer su trabajo que es hacer juegos o aplicaciones 3D, en usar un API si es que se abre al final antes de que salga DirectX12, si sólo será a meses vista y para soportar un hard limitado?

AMD promete (y ahora se ve porqué insistía especialmente en esto Huddy en su última conferencia) en que Mantle era "multiplataforma" como punto de crítica a D3D12. Bien, su "multiplataforma" se limita a Windows y además sabores relacionados con Vista en adelante, si no me equivoco. ¿Dónde está el soporte universal inicialmente prometido de linux y otras plataformas? Ah... otra promesa quedando en el tintero, y otro argumento que no puede usar contra DX12.

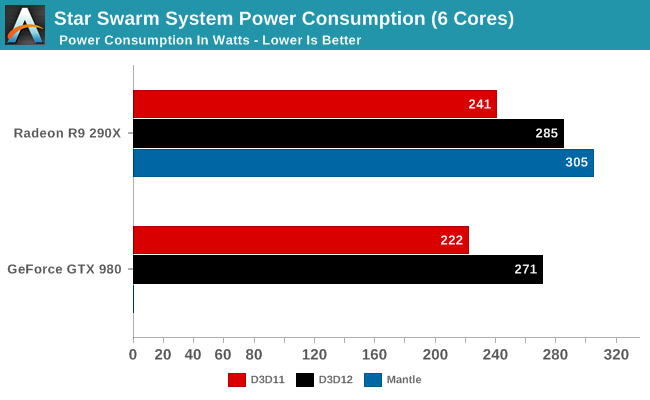

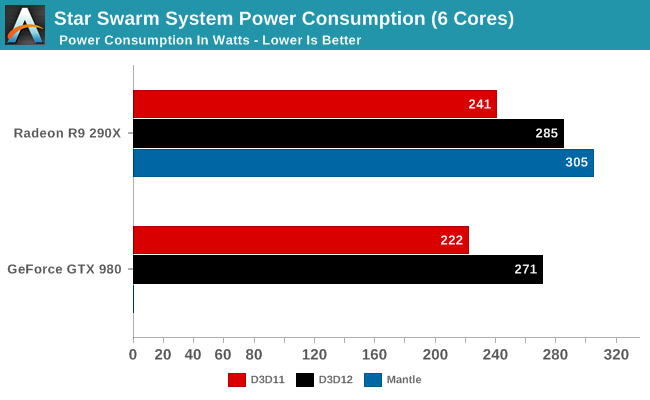

Sobre consumos:No es cierto que la gpu consuma más al usar APIs más "rápidas" como afirma algún compañero, no es así, es TODO el sistema lo que consume más.

Un error de cajón que suele cometer mucha gente al hablar de consumos es coger y comparar distintos rendimientos y comparar consumos como si fueran comparables. Y más cuando se habla de consumos de sistemas completos.

Si se ofrece más rendimiento, también aumenta el consumo en la cpu al aumentar el número de frames procesados, se aumenta también el trabajo de ésta, no ya en lo que cueste procesar temas del API, no. Sino en todos los subsistemas que nada tienen que ver con el API gráfica, como la IA, físicas, etc.

Habría que tener en cuenta este detalle en toda medida de consumo (por eso en muchos aspectos es mejor mirar el consumo por rendimiento, o W/frame, resultado de dividir el consumo por la tasa de fps), sobre todo porque además existen pruebas o juegos con rendimientos bastante distintos según la gráfica usada, un problema de la falta de muestreo que se hace evidente en las "disparidades" que hay entre muchos websites, habría que mirar bien estas dos gráficas para interpretar correctamente el coste en consumo y demás de un API:

Aunque sea comparando rendimientos con 4 cores con consumos de 6 activos, debería ser comparable dado que o no se usan o son negativos (AMD) o la mejora es mínima al pasar a 6(nvidia y GTX 980, por cierto que también es la que más mejora con diferencia al pasar de 2 a 4 cores).

GTX 980:66,8 fps y 271W -> 4,05W por frame. (D3D12)

26,7 fps y 222W -> 8,31W por frame. (D3D11)

R9 290X:8,3 fps y 241W -> 29,04W por frame. (D3D11)

42,9 fps y 285W -> 6,64W por frame. (D3D12)

45,6 fps y 305W -> 6,68W por frame. (mantle)

A nivel de sistema, sólo usando D3D11 y no por mucho, es menos eficiente el sistema con una GTX 980 en hacer su trabajo. Y al comparar sólo contra Mantle o D3D12, esto es, peras con manzanas. Comparando

contra su equivalente en AMD la diferencia es abismal en cuanto a eficiencia energética para dicho rendimiento (cuatro veces menos energía por frame renderizado).Lo cual demuestra el grado de ineficiencia con las drawcalls que tiene el driver D3D11 de AMD, que sigue exactamente donde estaba un año atrás, sin apuntar nada de nvidia. En APIs "futuras" el balance no es tan bestial a favor de nvidia, porque se supone que no hay un "problema basal" como con D3D11, pero aún así, hay

más de un 50% de diferencia entre GTX 980 y 290X en consumo por frame renderizado con las "nuevas APIs".

![como la niña del exorcista [360º]](/images/smilies/nuevos/vueltas.gif)

![fumando [fumando]](/images/smilies/nuevos/fumando.gif)

para cacharrearlo

para cacharrearlo ![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif) .

.

![Ok! [oki]](/images/smilies/net_thumbsup.gif)

![Ok! [oki]](/images/smilies/net_thumbsup.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)