J_Ark escribió:No entiendo, el amante de feedback es otro. De todas maneras es coña, en el de Ps4 se comentaron alguna que otra noticia, pero no parecía haber ganas de escribir millones de páginas comentando bulos.

papatuelo escribió:J_Ark escribió:No entiendo, el amante de feedback es otro. De todas maneras es coña, en el de Ps4 se comentaron alguna que otra noticia, pero no parecía haber ganas de escribir millones de páginas comentando bulos.

La verdad es que el hilo del interior está lleno de bulos, como que la gráfica es una HD7790, o que XBOX no funcionaria con DX12 o que DX12 no mejoraría para nada a la consola o que no podría manejar más de un contexto gráfico, o que no es compatible con HSA...

Muuuchos bulos, es bueno que lo reconozcas.

Ahora antes de contestar que este hilo no es para hablar de esas cosas, preguntate xq habéis sacado ese tema en este hilo.

J_Ark escribió:papatuelo escribió:J_Ark escribió:No entiendo, el amante de feedback es otro. De todas maneras es coña, en el de Ps4 se comentaron alguna que otra noticia, pero no parecía haber ganas de escribir millones de páginas comentando bulos.

La verdad es que el hilo del interior está lleno de bulos, como que la gráfica es una HD7790, o que XBOX no funcionaria con DX12 o que DX12 no mejoraría para nada a la consola o que no podría manejar más de un contexto gráfico, o que no es compatible con HSA...

Muuuchos bulos, es bueno que lo reconozcas.

Ahora antes de contestar que este hilo no es para hablar de esas cosas, preguntate xq habéis sacado ese tema en este hilo.

Pregúntaselo al autor del derrail: viewtopic.php?p=1739692379

Pero tampoco te pases que se altera enseguida

J_Ark escribió:eloskuro escribió:

que tiene que ver eso? Morepower mismamente dijo que no se lo creía, pero dejaba el dato ahí para debatirlo en el hilo del interior de xbo. Lo normal vamos....

Ahora podemos seguir hablando de API´s modernas y como mejorarán los juegos de las dos consolas?

Cuando queráis, que parece que no estáis mucho por la labor.

Y a Brad Wardell y compañía los tengo en el mismo lugar de antes. El "problema" es que intento racionalizar sus palabras de mejora del rendimiento dentro del aprovechamiento típico que se hace desde hace siglos en cualquier máquina por una simple razón de necesidad y de aprovechamiento de la arquitectura para subsistir, cuando venga a decir que una consola ha hecho majia tecnológica y ha entrado en super saiyajin nv 2 matadme antes de que se extienda, por favor xD

EDIT: Dios mio lo de los 5,4 Tflops, me desñoclo xDDDDDDDDDD

![por aquí! [poraki]](/images/smilies/nuevos/dedos.gif)

papatuelo escribió:Que grande eres, jajajajaja.

Asi que en ese mensaje se habla del interior de XBOX ONE???

Eres un tio espectacular, de verdad. Tienes que hacerlo en plan coña, porque si de verdad te crees lo que dices, amijo, puedo echarte una mano, no estás solo.

Ese mensaje solo pregunta que si es que ya se considera esa fuente fiable, te recuerdo la que te marcaste en torno a esa fuente, tanto tu como David Ricardo, pidiendo en feedback que no se aceptara. Vacilaste hasta a moderación que, cómo no, hizo la vista gorda:

J_Ark escribió:papatuelo escribió:Que grande eres, jajajajaja.

Asi que en ese mensaje se habla del interior de XBOX ONE???

Eres un tio espectacular, de verdad. Tienes que hacerlo en plan coña, porque si de verdad te crees lo que dices, amijo, puedo echarte una mano, no estás solo.

Ese mensaje solo pregunta que si es que ya se considera esa fuente fiable, te recuerdo la que te marcaste en torno a esa fuente, tanto tu como David Ricardo, pidiendo en feedback que no se aceptara. Vacilaste hasta a moderación que, cómo no, hizo la vista gorda:

No, en ese mensaje empieza tu enésimo rant persecutorio contra determinados usuarios, derivado de tu actitud de creyente que se desvive por poder meterle un zasca a alguien. De ahí viene el resto, por mucho que os empeñéis xD

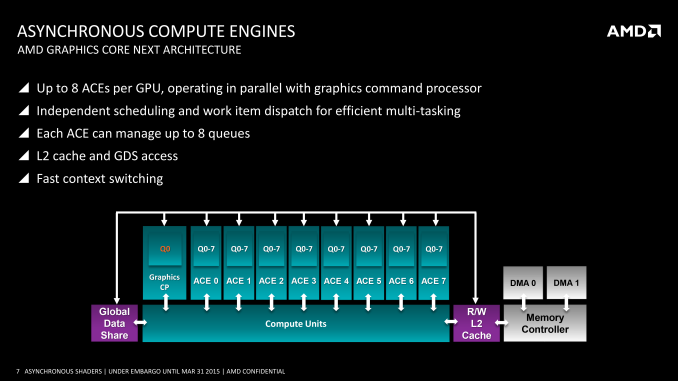

En la noticia de David Ricardo se habla de que mediante el uso de los ACEs se gana rendimiento. GENIUS, Oxyde, gracias por la info. No es un tío que no ha trabajado nunca en una consola diciendo que la misma duplicará el rendimiento por un simple cambio de API cuando en el SDK filtrado de MS se ve que muchas de las características de Dx12 ya están implementadas y disponibles para los desarrolladores (como es normal en consolas, donde se utiliza una API propietaria para sacar el máximo rendimiento al hard y no comerse los mocos frente al PC).

Aunque pretendas igualar los casos para zasquear no va a colar, sigue buscando.

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

papatuelo escribió:

La verdad es que el hilo del interior está lleno de bulos, como que la gráfica es una HD7790, o que XBOX no funcionaria con DX12 o que DX12 no mejoraría para nada a la consola o que no podría manejar más de un contexto gráfico, o que no es compatible con HSA...

papatuelo escribió:Y si me vas a decir que al habla de computo asincrono habla de ACES te diré sí, pero no.

David Ricardo escribió:Según un miembro de Oxide, desarrolladora de Ashes of the singularity, las GPUs de Nvidia no soportan computación asíncrona.

As far as I know, Maxwell doesn't really have Async Compute so I don't know why their driver was trying to expose that

darksch escribió:Eso es para Kepler y anteriores. Las Maxwell y posteriores sí tienen soporte completo. Por lo menos eso tenía entendido.

J_Ark escribió:papatuelo escribió:Y si me vas a decir que al habla de computo asincrono habla de ACES te diré sí, pero no.

Eso ponlo en el otro hilo que lo leeré igual, no ensucies esto.

Si no entiendes la diferencia de Wardell flipandose con Dx12 y la compañía hablando de que la computación asincrona mola es tu problema, no el mio. Aunque pongas cuatro interrogantes en vez de tres

papatuelo escribió:Las Maxwell son feature level 12_1, pero solo tier 2. Ya lo puse unas páginas más atrás.

Parece que el rendimiento de verdad se consigue con tier 3 y no con feature level 12_1.

Eso indican las primeras pruebas, aunque Brad Wardell en twitter dijo que probablemente Nvidia podría solventarlo por medio de Drivers, no sé hasta qu punto será cierto lo uno y lo otro.

The only other thing that is different between them is that Nvidia does fall into Tier 2 class binding hardware instead of Tier 3 like AMD which requires a little bit more CPU overhead in D3D12, but I don't think it ended up being very significant.

josemurcia escribió:papatuelo escribió:Las Maxwell son feature level 12_1, pero solo tier 2. Ya lo puse unas páginas más atrás.

Parece que el rendimiento de verdad se consigue con tier 3 y no con feature level 12_1.

Eso indican las primeras pruebas, aunque Brad Wardell en twitter dijo que probablemente Nvidia podría solventarlo por medio de Drivers, no sé hasta qu punto será cierto lo uno y lo otro.

Decir Tier 2 sin decir de que feature es lo mismo que no decir nada, lo digo porque algunos siempre decís tier 2 y tier 3 como si por si solos significaran algo cuando os referís a una feature concreta, Resource Binding.

Después de puntualizar eso, es justo lo contrario, en el propio blog de Oxide donde han dicho que Maxwell no soporta realmente computación asíncrona dice que la diferencia entre un hardware con resource binding tier 3 y uno tier 2 es que el segundo será un poco más intensivo con la CPU, pero nada muy significativo.The only other thing that is different between them is that Nvidia does fall into Tier 2 class binding hardware instead of Tier 3 like AMD which requires a little bit more CPU overhead in D3D12, but I don't think it ended up being very significant.

eloskuro escribió:Lo mismo dicen de 12_1

Que para los juegos no se necesitará casi nunca ser 12_1 Con 12_0 valdrá.

darksch escribió:Creo que no son lo mismo "feature levels" que "hardware tiers". Una cosa es lo que soporta, la otra el cómo lo hace. Maxwell puede tener todas las features que se quieran, pero luego cómo las ejecuta internamente. Es decir, puedes soportar async computing para poder ejecutar el mismo código, pero luego internamente se separan y se ejecutan en serie.

josemurcia escribió:papatuelo escribió:Las Maxwell son feature level 12_1, pero solo tier 2. Ya lo puse unas páginas más atrás.

Parece que el rendimiento de verdad se consigue con tier 3 y no con feature level 12_1.

Eso indican las primeras pruebas, aunque Brad Wardell en twitter dijo que probablemente Nvidia podría solventarlo por medio de Drivers, no sé hasta qu punto será cierto lo uno y lo otro.

Decir Tier 2 sin decir de que feature es lo mismo que no decir nada, lo digo porque algunos siempre decís tier 2 y tier 3 como si por si solos significaran algo cuando os referís a una feature concreta, Resource Binding.

Después de puntualizar eso, es justo lo contrario, en el propio blog de Oxide donde han dicho que Maxwell no soporta realmente computación asíncrona dice que la diferencia entre un hardware con resource binding tier 3 y uno tier 2 es que el segundo será un poco más intensivo con la CPU, pero nada muy significativo.The only other thing that is different between them is that Nvidia does fall into Tier 2 class binding hardware instead of Tier 3 like AMD which requires a little bit more CPU overhead in D3D12, but I don't think it ended up being very significant.

papatuelo escribió:Cómo he dicho hasta ahora, según los test, las resource bindings Tier 3 se están pasando por la piedra a las Tier 2, eso es un hecho. ¿Por qué? Pues no lo sé, pero las pruebas están sobre la mesa.

Que a posteriori Nvidia es realmente capaz de mejorar gracias a la optimización de los drivers, pues entonces demostrarán que no es cierto. Pero de momento la realidad es esa.

La realidad es que gráficas con un máximo de 8 contextos y FL 12_0 están pasandole la mano por la cara a otra con 32 y FL 12_1.

josemurcia escribió:No se están pasando por la piedra a nada, a misma potencia de cómputo NVIDIA sigue ganando a AMD. Sólo que los drivers DX11 de AMD son basura infecta y por eso la brutal mejora de rendimiento al dejar de depender de ellos mientras que los de NVIDIA eran la polla en vinagre.

darksch escribió:josemurcia escribió:No se están pasando por la piedra a nada, a misma potencia de cómputo NVIDIA sigue ganando a AMD. Sólo que los drivers DX11 de AMD son basura infecta y por eso la brutal mejora de rendimiento al dejar de depender de ellos mientras que los de NVIDIA eran la polla en vinagre.

Eso ya lo dije antes. Nvidia pasa por encima a AMD porque, según yo lo veo, el modelo antiguo lastra mucho a la tecnología de AMD. Basándose en muchas más unidades más pequeñas, me parece a mí que tanto cuello de botella y procesamiento en serie de las cosas les pesa demasiado. No es que a AMD mágicamente les haya dado por sacar buenos drivers justo ahora.

[erick] escribió:Buenas tardes,

Es evidente que hay dos grupos que no OS gustais y queréis que la moderación solucione el problema, la solución va a ser banearos a todos, empezando por papatuelo y terminando por Jark. IGNORAROS, por favor.

La funcion del botón de reportar no es formar parte de vuestro argumentario.

Por último me gustaría pedir vuestra colaboración y agradeceros de antemano esa colaboración.

[erick] escribió:Buenas tardes,

Es evidente que hay dos grupos que no OS gustais y queréis que la moderación solucione el problema, la solución va a ser banearos a todos, empezando por papatuelo y terminando por Jark. IGNORAROS, por favor.

La funcion del botón de reportar no es formar parte de vuestro argumentario.

Por último me gustaría pedir vuestra colaboración y agradeceros de antemano esa colaboración.

.David Ricardo escribió:Edit: por cierto, si miras bien el hilo, verás que ese mensaje provocador hacia mí es el que inició toda la pelotera que se acaba de montar aquí. Así que ahí tienes las consecuencias de tu labor como moderador. Tienes el foro que te mereces.