DarthSnake escribió:A ver que creo que os estáis haciendo un lío, y al final vais a confundir a la gente. Lo que se ha dicho no es que no se pueda hacer efectos post-procesado en 3D, si no que no se pueden hacer todos a la vez (por lo menos no sin que afecte al framerate). De hecho Capcom ya demostró hace tiempo lo que se puede hacer, o más bien dicho, lo que habían conseguido hacer:Efectos técnicos posibles en Nintendo 3DS con el MT Framework (Normal mapping, profundidad de campo, motion blur o HDR)Tras la incertidumbre levantada por el tráiler y las imágenes de Resident Evil Revelations en Nintendo 3DS, Capcom ha salido al paso para reiterar que se trata de un trabajo original que corre sobre la portátil. En concreto, sobre la versión MT Framework Mobile de su último motor, que es capaz de sacar adelante efectos gráficos como los de las actuales consolas de alta definición.

Han presentado una secuencia de imágenes de Resident Evil Revelations en las que se compara el juego con y sin efectos como normal mapping, profundidad de campo, motion blur o HDR. Todo con el juego corriendo a 30 fps cuando el efecto 3D está activado. Sin embargo, algunos como el anti-aliasing, se desactivan con la visión estereoscópica y otros como el motion blur siguen en fase de pruebas, aunque Capcom garantiza una calidad de imagen muy semejante.

"Desde la revelación del juego en el E3, las imágenes han sido todas renderizadas en tiempo real en el hardware de desarrollo de 3DS. Al principio parecía que la gente no se lo creía, pero nos gustaría que supieseis que la 3DS es capaz de este nivel de poder expresivo".

Jun Takeuchi, jefe de producción de Capcom, ha recordado que se trata de "un proyecto totalmente nuevo que arrancó cuando supimos de Nintendo 3DS. No es un proyecto que fue progresando en un hardware aparte que después pasamos a la 3DS".

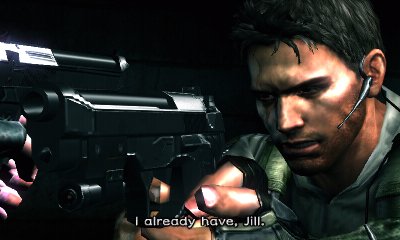

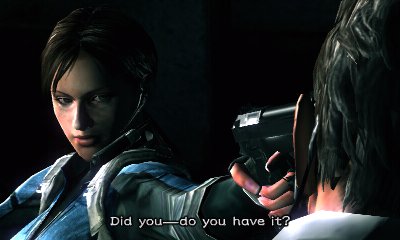

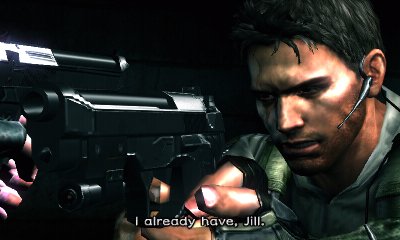

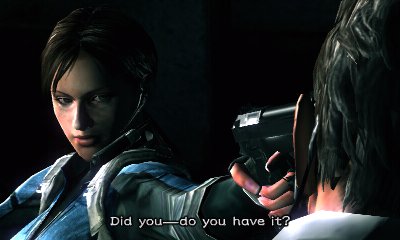

Aquí tenéis la secuencia de imágenes de Resident Evil Revelations:

HDR Rendering Off (left) and On (right):

Color Correction Off (left) and On (right):

Self Shadows Off (left) and On (right):

Normal Maps Off (left) and On (right):

Depth of Field Off (left) and On (right):

Motion Blur Off (left) and On (right):

Fuente

En fin en resumidas cuentas, que se pueden hacer efectos como motion blur, HDR, y demás en modo 3D, pero no tantos a la vez como en 2D así que hay que desactivar algunos, en el caso del MT Framework se desactiva el anti-aliasing (y otros como el motion blur estaban en fase de pruebas).

Blue escribió:DarthSnake escribió:A ver que creo que os estáis haciendo un lío, y al final vais a confundir a la gente. Lo que se ha dicho no es que no se pueda hacer efectos post-procesado en 3D, si no que no se pueden hacer todos a la vez (por lo menos no sin que afecte al framerate). De hecho Capcom ya demostró hace tiempo lo que se puede hacer, o más bien dicho, lo que habían conseguido hacer:Efectos técnicos posibles en Nintendo 3DS con el MT Framework (Normal mapping, profundidad de campo, motion blur o HDR)Tras la incertidumbre levantada por el tráiler y las imágenes de Resident Evil Revelations en Nintendo 3DS, Capcom ha salido al paso para reiterar que se trata de un trabajo original que corre sobre la portátil. En concreto, sobre la versión MT Framework Mobile de su último motor, que es capaz de sacar adelante efectos gráficos como los de las actuales consolas de alta definición.

Han presentado una secuencia de imágenes de Resident Evil Revelations en las que se compara el juego con y sin efectos como normal mapping, profundidad de campo, motion blur o HDR. Todo con el juego corriendo a 30 fps cuando el efecto 3D está activado. Sin embargo, algunos como el anti-aliasing, se desactivan con la visión estereoscópica y otros como el motion blur siguen en fase de pruebas, aunque Capcom garantiza una calidad de imagen muy semejante.

"Desde la revelación del juego en el E3, las imágenes han sido todas renderizadas en tiempo real en el hardware de desarrollo de 3DS. Al principio parecía que la gente no se lo creía, pero nos gustaría que supieseis que la 3DS es capaz de este nivel de poder expresivo".

Jun Takeuchi, jefe de producción de Capcom, ha recordado que se trata de "un proyecto totalmente nuevo que arrancó cuando supimos de Nintendo 3DS. No es un proyecto que fue progresando en un hardware aparte que después pasamos a la 3DS".

Aquí tenéis la secuencia de imágenes de Resident Evil Revelations:

HDR Rendering Off (left) and On (right):

Color Correction Off (left) and On (right):

Self Shadows Off (left) and On (right):

Normal Maps Off (left) and On (right):

Depth of Field Off (left) and On (right):

Motion Blur Off (left) and On (right):

Fuente

En fin en resumidas cuentas, que se pueden hacer efectos como motion blur, HDR, y demás en modo 3D, pero no tantos a la vez como en 2D así que hay que desactivar algunos, en el caso del MT Framework se desactiva el anti-aliasing (y otros como el motion blur estaban en fase de pruebas).

Pero eso no es lo que dice en el primer post. Dice que no se puede porque no hay edram suficiente para ambas pantallas.

Blue escribió:Pero eso no es lo que dice en el primer post. Dice que no se puede porque no hay edram suficiente para ambas pantallas.

El motivo es que en modo 2D tenemos 2MB para los buffers (triple buffer de 18 bits, Stencil Buffer de 8 bits y Z-Buffering de 24 bits) y 2MB para almacenar la geometría de escena para el multitexturizado, en el modo 3D tenemos la mitad disponible para cada núcleo. Si usamos el HDR, el MSAA y demás efectos entonces la imagen no cabe en la eDRAM y entonces tenemos que mover la información a la RAM principal, la cual tiene una velocidad de acceso mucho más baja y por tanto una latencia mayor, lo que se traduce en una pérdida sustancial del rendimiento. Los buffers en la eDRAM y la geometría en la eDRAM toman un número determinado de ciclos dependiendo de la instrucción, pero en el caso del acceso a la RAM esos accesos se doblan y el rendimiento se parte por la mitad.

DarthSnake escribió:Blue escribió:Pero eso no es lo que dice en el primer post. Dice que no se puede porque no hay edram suficiente para ambas pantallas.

Bueno, tampoco dice eso exactamente:El motivo es que en modo 2D tenemos 2MB para los buffers (triple buffer de 18 bits, Stencil Buffer de 8 bits y Z-Buffering de 24 bits) y 2MB para almacenar la geometría de escena para el multitexturizado, en el modo 3D tenemos la mitad disponible para cada núcleo. Si usamos el HDR, el MSAA y demás efectos entonces la imagen no cabe en la eDRAM y entonces tenemos que mover la información a la RAM principal, la cual tiene una velocidad de acceso mucho más baja y por tanto una latencia mayor, lo que se traduce en una pérdida sustancial del rendimiento. Los buffers en la eDRAM y la geometría en la eDRAM toman un número determinado de ciclos dependiendo de la instrucción, pero en el caso del acceso a la RAM esos accesos se doblan y el rendimiento se parte por la mitad.

Ahí lo que yo leo es que si usas varios efectos (entiendo que a la vez) no caben en la eDRAM, y no que no se puedan usar efectos post-procesado, o por lo menos eso es lo que yo entiendo. En todo caso ya quedo demostrado por Capcom que si se pueden hacer.

meloncito escribió:Aun no ha salido y ya se le echa en falta eDram....con x360 paso años despues, q se soluciono bajando la resolucion para poder meter todo en el framebuffer, pero en este caso, q hacemos? juegos en 2D? y donde esta la gracia entonces? jaja

meloncito escribió:Aun no ha salido y ya se le echa en falta eDram....con x360 paso años despues, q se soluciono bajando la resolucion para poder meter todo en el framebuffer, pero en este caso, q hacemos? juegos en 2D? y donde esta la gracia entonces? jaja

Paco20011 escribió:meloncito escribió:Aun no ha salido y ya se le echa en falta eDram....con x360 paso años despues, q se soluciono bajando la resolucion para poder meter todo en el framebuffer, pero en este caso, q hacemos? juegos en 2D? y donde esta la gracia entonces? jaja

No sé, yo cada vez veo más instaurada la moda de "yo la tengo más larga", y aquí lo que vende no es una consola buena o que ofrezca diversas funcionalidades. Aquí vende que en el lateral de la caja ponga: Chorrocientos Mhz, 5000 gigas de RAM, 40000000 teras de disco duro. Y cuantos más numerines ponga mejor.

Y los programadores, pues ahora la moda es hacerlo todo en entorno PC y usar el programa mágico de port a Xbox, PS3 o lo que se tercie. Y claro, si el hardware destino del port no tiene recursos a mansalva, el juego no tira. Y así nos ahorramos la optimización y el poder jugar al juego perfectamente con la mitad de recursos. Pa qué, si es más fácil hacerlo a lo chapuza y que consuma el doble.

En esto hay muchas compañías expertas. Porque no es normal ver algunos juegos lo que son y lo que piden para ir bien, y luego ver otros como Dead Space, que lo metes en un pentium III y te tira (vale que son entornos cerrados casi siempre pero el juego tiene una optimización de la leche). Y no hay diferencia apreciable en calidad gráfica.

Y esto se ve en Wii, la mayoría hacen mierda técnica porque "la consola no da para más" y luego se ve que sí, lo que pasa es que es más fácil programar desperdiciando recursos.

capitanquartz escribió:DarthSnake escribió:Blue escribió:Pero eso no es lo que dice en el primer post. Dice que no se puede porque no hay edram suficiente para ambas pantallas.

Bueno, tampoco dice eso exactamente:El motivo es que en modo 2D tenemos 2MB para los buffers (triple buffer de 18 bits, Stencil Buffer de 8 bits y Z-Buffering de 24 bits) y 2MB para almacenar la geometría de escena para el multitexturizado, en el modo 3D tenemos la mitad disponible para cada núcleo. Si usamos el HDR, el MSAA y demás efectos entonces la imagen no cabe en la eDRAM y entonces tenemos que mover la información a la RAM principal, la cual tiene una velocidad de acceso mucho más baja y por tanto una latencia mayor, lo que se traduce en una pérdida sustancial del rendimiento. Los buffers en la eDRAM y la geometría en la eDRAM toman un número determinado de ciclos dependiendo de la instrucción, pero en el caso del acceso a la RAM esos accesos se doblan y el rendimiento se parte por la mitad.

Ahí lo que yo leo es que si usas varios efectos (entiendo que a la vez) no caben en la eDRAM, y no que no se puedan usar efectos post-procesado, o por lo menos eso es lo que yo entiendo. En todo caso ya quedo demostrado por Capcom que si se pueden hacer.

Sí que se pueden usar todos esos efectos a la vez, pero claro, los FPS caen porque cuando el framebuffer se llena, se pasa a usar RAM, que es más lenta. Lo suyo es desactivar los filtros que sobren para mantener 60 FPS en 3D.

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

nanoxxl escribió:lo que no entiendo es si ponen dos gpu por que solo ponen un framebuffer y no dos ( uno para cada gpu ) , si ponen una segunda gpu solo para doblar frames para las 3d tambien tendrian que meter un segundo buffers y no compartir el mismo ,

por cierto para mi la ram y la eDRAM son memorias , por eso e dicho antes lo de la memoria

capitanquartz escribió:nanoxxl escribió:lo que no entiendo es si ponen dos gpu por que solo ponen un framebuffer y no dos ( uno para cada gpu ) , si ponen una segunda gpu solo para doblar frames para las 3d tambien tendrian que meter un segundo buffers y no compartir el mismo ,

por cierto para mi la ram y la eDRAM son memorias , por eso e dicho antes lo de la memoria

No cambiaría nada, la velocidad de acceso sería prácticamente la misma. Han puesto la cantidad que han visto conveniente. Si después ha sido insuficiente, eso es otra cosa.

nanoxxl escribió:capitanquartz escribió:nanoxxl escribió:lo que no entiendo es si ponen dos gpu por que solo ponen un framebuffer y no dos ( uno para cada gpu ) , si ponen una segunda gpu solo para doblar frames para las 3d tambien tendrian que meter un segundo buffers y no compartir el mismo ,

por cierto para mi la ram y la eDRAM son memorias , por eso e dicho antes lo de la memoria

No cambiaría nada, la velocidad de acceso sería prácticamente la misma. Han puesto la cantidad que han visto conveniente. Si después ha sido insuficiente, eso es otra cosa.

si cambiaria , el fallo es que solo tiene un buffers para las dos gpu , cuando usa una gpu ( 2d ) puede usar el 100% del buffers , cuando usa las dos gpu ( 3d ) solo puede usar el 50% del buffers para cada gpu , si cada gpu contase con su propio buffers no pasaria esto

Thorin_Saeba escribió:Paco20011 escribió:No sé, yo cada vez veo más instaurada la moda de "yo la tengo más larga", y aquí lo que vende no es una consola buena o que ofrezca diversas funcionalidades. Aquí vende que en el lateral de la caja ponga: Chorrocientos Mhz, 5000 gigas de RAM, 40000000 teras de disco duro. Y cuantos más numerines ponga mejor.

Y los programadores, pues ahora la moda es hacerlo todo en entorno PC y usar el programa mágico de port a Xbox, PS3 o lo que se tercie. Y claro, si el hardware destino del port no tiene recursos a mansalva, el juego no tira. Y así nos ahorramos la optimización y el poder jugar al juego perfectamente con la mitad de recursos. Pa qué, si es más fácil hacerlo a lo chapuza y que consuma el doble.

En esto hay muchas compañías expertas. Porque no es normal ver algunos juegos lo que son y lo que piden para ir bien, y luego ver otros como Dead Space, que lo metes en un pentium III y te tira (vale que son entornos cerrados casi siempre pero el juego tiene una optimización de la leche). Y no hay diferencia apreciable en calidad gráfica.

Y esto se ve en Wii, la mayoría hacen mierda técnica porque "la consola no da para más" y luego se ve que sí, lo que pasa es que es más fácil programar desperdiciando recursos.

Te aplaudo sinceramente. Tienes más razón que un santo. Coge el Call of duty black ops de pc, su pésima optimización que, usando el mismo motor que entregas anteriores, impide jugar en ordenadores potentes. Ya no se trabaja depurando el código como antes, ahora se va a sacar un juego en dos días y ganar una millonada con precios desorbitados. Poco esfuerzo pero muchas ganancias. Suerte que aún nos quedan los desarrolladores "indies" y sus joyas, y en 3DS los juegos de Nintendo, inimitables le pese a quién le pese.

capitanquartz escribió:Eso tendría lógica si fuese un problema de velocidad en la transferencia de datos, el cual no es el caso. El problema es que no hay espacio para framebuffer (2MiB) en la eDRAM, y se pasa a usar la RAM principal, la cual es más lenta. Por tanto, no es un problema de la velocidad en las transferencias de datos sino en la capacidad.

pero que dices , lo que digo es que si en lugar de tener un framebuffer (2MiB) en la eDRAM para las dos gpu le hubieran metido dos framebuffer (2MiB) en la eDRAM uno para cada gpu no tendria que tirar de ram para pasar de 2d a 3d por falta de eDRAM , el problema es que cuando usa una gpu tiene la eDRAM completa , cuando usa las dos gpu tiene que compartir la eDRAM , si cada gpu hubieran tenido su propia eDRAM no pasaria esto

pero que dices , lo que digo es que si en lugar de tener un framebuffer (2MiB) en la eDRAM para las dos gpu le hubieran metido dos framebuffer (2MiB) en la eDRAM uno para cada gpu no tendria que tirar de ram para pasar de 2d a 3d por falta de eDRAM , el problema es que cuando usa una gpu tiene la eDRAM completa , cuando usa las dos gpu tiene que compartir la eDRAM , si cada gpu hubieran tenido su propia eDRAM no pasaria esto nanoxxl escribió:capitanquartz escribió:Eso tendría lógica si fuese un problema de velocidad en la transferencia de datos, el cual no es el caso. El problema es que no hay espacio para framebuffer (2MiB) en la eDRAM, y se pasa a usar la RAM principal, la cual es más lenta. Por tanto, no es un problema de la velocidad en las transferencias de datos sino en la capacidad.

pero que dices , lo que digo es que si en lugar de tener un framebuffer (2MiB) en la eDRAM para las dos gpu le hubieran metido dos framebuffer (2MiB) en la eDRAM uno para cada gpu no tendria que tirar de ram para pasar de 2d a 3d por falta de eDRAM , el problema es que cuando usa una gpu tiene la eDRAM completa , cuando usa las dos gpu tiene que compartir la eDRAM , si cada gpu hubieran tenido su propia eDRAM no pasaria esto

capitanquartz escribió:nanoxxl escribió:capitanquartz escribió:No cambiaría nada, la velocidad de acceso sería prácticamente la misma. Han puesto la cantidad que han visto conveniente. Si después ha sido insuficiente, eso es otra cosa.

si cambiaria , el fallo es que solo tiene un buffers para las dos gpu , cuando usa una gpu ( 2d ) puede usar el 100% del buffers , cuando usa las dos gpu ( 3d ) solo puede usar el 50% del buffers para cada gpu , si cada gpu contase con su propio buffers no pasaria esto

Eso tendría lógica si fuese un problema de velocidad en la transferencia de datos, el cual no es el caso. El problema es que no hay espacio para framebuffer (2MiB) en la eDRAM, y se pasa a usar la RAM principal, la cual es más lenta. Por tanto, no es un problema de la velocidad en las transferencias de datos sino en la capacidad.

Blue escribió:Si no ha dicho nada de la velocidad xD. Ha dicho lo que es correcto, que si necesitan duplicar todo para la generación de dos imágenes distintas, tienen que duplicarlo todo, incluida la eDRAM que la consola debería tener una por GPU.

Y si que hay diferencia. Una diferencia gordisima: la calidad de la imagen no se vería reducida al pasar a modo 3D. Y otra todavía más grande: los programadores no tendrían que programar dos veces el procesado de imagen: una en 2D y otra en 3D yp odría n invertir ese esfuerzo en otras cosas.

capitanquartz escribió:Blue escribió:Si no ha dicho nada de la velocidad xD. Ha dicho lo que es correcto, que si necesitan duplicar todo para la generación de dos imágenes distintas, tienen que duplicarlo todo, incluida la eDRAM que la consola debería tener una por GPU.

Y si que hay diferencia. Una diferencia gordisima: la calidad de la imagen no se vería reducida al pasar a modo 3D. Y otra todavía más grande: los programadores no tendrían que programar dos veces el procesado de imagen: una en 2D y otra en 3D yp odría n invertir ese esfuerzo en otras cosas.

Mirémoslo de otro modo: Imagina que Nintendo llegó a la conclusión que para los juegos que ella iba a hacer, solo necesitaría 1 MiB de framebuffer, pero que por tener que renderizar 2 imágenes al mismo tiempo (3D) puso 2 MiB. En ese caso, sí que habrían puesto la cantidad que ellos vieron necesaria. Lo mismo podría ocurrir de ponerse 4 MiB de framebuffer: los programadores aprovecharían casi todos esos 4 MiB solo para el modo 2D, no quedando para el 3D.

Conclusión: Los programadores no pueden usar más de la mitad del framebuffer en el modo 2D, porque en el 3D esta se dobla. ¿Que no se pueden aplicar tantos filtros de postprocesado? Es lo que hay, sabíais desde el principio que para Nintendo lo primordial no son los gráficos.

capitanquartz escribió:nanoxxl escribió:capitanquartz escribió:Eso tendría lógica si fuese un problema de velocidad en la transferencia de datos, el cual no es el caso. El problema es que no hay espacio para framebuffer (2MiB) en la eDRAM, y se pasa a usar la RAM principal, la cual es más lenta. Por tanto, no es un problema de la velocidad en las transferencias de datos sino en la capacidad.

pero que dices , lo que digo es que si en lugar de tener un framebuffer (2MiB) en la eDRAM para las dos gpu le hubieran metido dos framebuffer (2MiB) en la eDRAM uno para cada gpu no tendria que tirar de ram para pasar de 2d a 3d por falta de eDRAM , el problema es que cuando usa una gpu tiene la eDRAM completa , cuando usa las dos gpu tiene que compartir la eDRAM , si cada gpu hubieran tenido su propia eDRAM no pasaria esto

El número de módulos de eDRAM aquí no tiene que ver, y lo que estabas diciendo era de meter otro módulo de eDRAM más (o al menos lo que se entendía). El problema parcialmente se solucionaría cambiando el tamaño del framebuffer de 2 MiB a 4 MiB, aunque claro, si pones 4 MiB de framebuffer, nadie te dice que CAPCOM no hubiese metido aún más filtros que llenasen esos 4 MiB solo en el 2D.

Blue escribió:Si nintendo hubiese sido lista y necesitase 1 MB para sus juegos, hubiese puesto una eDRAM de 1Mb para una GPU u otra de 1MB para la otra. De esta forma cualquier desarrolladora por ingeniosa que sea dispondría de la misma edram para 2d y para 3d, y lo que hagan en 2D se verá también en 3D.

, eso es lo que pienso yo , pero puedo esta equivocado

, eso es lo que pienso yo , pero puedo esta equivocado ![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

nanoxxl escribió:Blue escribió:Si nintendo hubiese sido lista y necesitase 1 MB para sus juegos, hubiese puesto una eDRAM de 1Mb para una GPU u otra de 1MB para la otra. De esta forma cualquier desarrolladora por ingeniosa que sea dispondría de la misma edram para 2d y para 3d, y lo que hagan en 2D se verá también en 3D.

eso es lo que quiero decir , si en 2d usa una gpu y en 3d las dos para doblar frames , tambien tendria que tener una eDRAM para cada gpu , si es en 2d usa una gpu y una eDRAM , si es en 3d usa las dos gpu y las dos eDRAM , de esta forma creo que en 2d se desaprovecha la mitad de eDRAM y una gpu para que al poner en 3d no tenga ningun bajon, eso es lo que pienso yo , pero puedo esta equivocado

capitanquartz escribió:Por una parte os quejáis de que no dejan usar a los desarrolladores las 2 GPUs en el modo 2D.

Y por otra parte os quejáis de que sí dejan usar los 2 MiB de framebuffer en el 2D en vez de solo 1 MiB...

¿En qué quedamos entonces? Creo que los desarrolladores ya son mayorcitos como para saber que no deberían usar más de 1 MiB de framebuffer por el 3D

capitanquartz escribió:Por lo de poner 2 módulos de eDRAM sería un gasto inútil, y más con los precios en los que está cada módulo. Si un solo módulo de eDRAM tiene velocidad de transferencia suficiente para satisfacer ambas GPUs, sencillamente no se necesitan 2 módulos, sería solo aumentar los gastos por la incompetencia de los desarrolladores.

, no es cuestion de velocidad , es cuestion de espacio , si bloqueas una gpu para las 3d por que no bloquear eDRAM para las 3d , el mismo gasto inútil es si juegas en 2d

, no es cuestion de velocidad , es cuestion de espacio , si bloqueas una gpu para las 3d por que no bloquear eDRAM para las 3d , el mismo gasto inútil es si juegas en 2d nanoxxl escribió:capitanquartz escribió:Por una parte os quejáis de que no dejan usar a los desarrolladores las 2 GPUs en el modo 2D.

Y por otra parte os quejáis de que sí dejan usar los 2 MiB de framebuffer en el 2D en vez de solo 1 MiB...

¿En qué quedamos entonces? Creo que los desarrolladores ya son mayorcitos como para saber que no deberían usar más de 1 MiB de framebuffer por el 3D

o bloquea las dos cosas o deja libre las dos cosas , claro que bloqueando la gpu tambien bloquea la eDRAM ( como tu dices por muchos 2 MiB que tenga solo pueden usar 1 MiB en 2d )capitanquartz escribió:Por lo de poner 2 módulos de eDRAM sería un gasto inútil, y más con los precios en los que está cada módulo. Si un solo módulo de eDRAM tiene velocidad de transferencia suficiente para satisfacer ambas GPUs, sencillamente no se necesitan 2 módulos, sería solo aumentar los gastos por la incompetencia de los desarrolladores.

cuanto cuesta el modulo de eDRAM, no es cuestion de velocidad , es cuestion de espacio , si bloqueas una gpu para las 3d por que no bloquear eDRAM para las 3d , el mismo gasto inútil es si juegas en 2d

capitanquartz escribió:Si la segunda GPU no es accesible en el 2D puede ser también por limitaciones técnicas. Además, tener 2 GPUs funcionando consume mucha batería. Por la eDRAM han hecho lo que tenían que hacer. Poner 2 módulos habría sido una estupidez.

, en fin

, en fin  , la segunda gpu es solo para 3d por que la funcion que hace es doblar los frames , si el juego en 2d funciona a 30fps con una gpu en 3d con la segunda gpu funciona a 60fps con la misma calidad grafica , si se usaran las dos gpu en 2d el juego funcionaria a 60fps y al pasarlo igual en 3d bajaria a 30fps , ese es el motivo de no usar las dos gpu en 2d , solo es para darle mayor importancia y soporte a las 3d frente a las 2d , un juegos en 2d con las dos gpu seria imposible pasarlo a 3d sin perder rendimiento

, la segunda gpu es solo para 3d por que la funcion que hace es doblar los frames , si el juego en 2d funciona a 30fps con una gpu en 3d con la segunda gpu funciona a 60fps con la misma calidad grafica , si se usaran las dos gpu en 2d el juego funcionaria a 60fps y al pasarlo igual en 3d bajaria a 30fps , ese es el motivo de no usar las dos gpu en 2d , solo es para darle mayor importancia y soporte a las 3d frente a las 2d , un juegos en 2d con las dos gpu seria imposible pasarlo a 3d sin perder rendimiento nanoxxl escribió:capitanquartz escribió:Si la segunda GPU no es accesible en el 2D puede ser también por limitaciones técnicas. Además, tener 2 GPUs funcionando consume mucha batería. Por la eDRAM han hecho lo que tenían que hacer. Poner 2 módulos habría sido una estupidez.

, en fin

, la segunda gpu es solo para 3d por que la funcion que hace es doblar los frames , si el juego en 2d funciona a 30fps con una gpu en 3d con la segunda gpu funciona a 60fps con la misma calidad grafica , si se usaran las dos gpu en 2d el juego funcionaria a 60fps y al pasarlo igual en 3d bajaria a 30fps , ese es el motivo de no usar las dos gpu en 2d , solo es para darle mayor importancia y soporte a las 3d frente a las 2d , un juegos en 2d con las dos gpu seria imposible pasarlo a 3d sin perder rendimiento

capitanquartz escribió:La función de la segunda GPU no es "doblar los frames", es crear una segunda imagen que será la usada en el 3D.

capitanquartz escribió: Las cosas no funcionan así, por arte de magia, y no puedes hacer de forma tan sencilla que 2 GPUs procesen una misma imagen. En todo caso, podría servir como CPU de apoyo, pero puede que esto no fuese posible debido al diseño del circuito.

NVIDIA® SLI™ es una tecnología revolucionaria que permite aumentar drásticamente el rendimiento gráfico combinando varias GPUs NVIDIA en sistemas con una placa base certificada para SLI. SLI utiliza algoritmos de software exclusivos de NVIDIA y una lógica de escalabilidad especial en cada unidad de procesamiento gráfico (GPU) para duplicar el rendimiento (con 2 tarjetas) o multiplicarlo por 2,8 (con 3 tarjetas) en comparación con las soluciones basadas en un solo procesador gráfico

ATI CrossFireX™ is the ultimate multi-GPU performance gaming platform. Enabling game-dominating power, ATI CrossFireX technology enables two or more discrete graphics processors to work together to improve system performance. For The Ultimate Visual Experience™, be sure to select ATI CrossFireX ready motherboards for AMD and Intel® processors and multiple ATI Radeon™ HD graphics cards.

nanoxxl escribió:capitanquartz escribió:La función de la segunda GPU no es "doblar los frames", es crear una segunda imagen que será la usada en el 3D.

es lo mismo , en 2d a 30fps , en 3d 60fps ( 30fps para cada ojo )

nanoxxl escribió:capitanquartz escribió: Las cosas no funcionan así, por arte de magia, y no puedes hacer de forma tan sencilla que 2 GPUs procesen una misma imagen. En todo caso, podría servir como CPU de apoyo, pero puede que esto no fuese posible debido al diseño del circuito.

NVIDIA SLI http://www.nvidia.es/object/sli-technol ... ew-es.htmlNVIDIA® SLI™ es una tecnología revolucionaria que permite aumentar drásticamente el rendimiento gráfico combinando varias GPUs NVIDIA en sistemas con una placa base certificada para SLI. SLI utiliza algoritmos de software exclusivos de NVIDIA y una lógica de escalabilidad especial en cada unidad de procesamiento gráfico (GPU) para duplicar el rendimiento (con 2 tarjetas) o multiplicarlo por 2,8 (con 3 tarjetas) en comparación con las soluciones basadas en un solo procesador gráfico

[img*]http://s2.subirimagenes.com/otros/previo/thump_5891570asus780i1nvidia.jpg[/img]

ATI CrossFireX http://game.amd.com/us-en/crossfirex_about.aspxATI CrossFireX™ is the ultimate multi-GPU performance gaming platform. Enabling game-dominating power, ATI CrossFireX technology enables two or more discrete graphics processors to work together to improve system performance. For The Ultimate Visual Experience™, be sure to select ATI CrossFireX ready motherboards for AMD and Intel® processors and multiple ATI Radeon™ HD graphics cards.

[img*]http://s3.subirimagenes.com:81/otros/previo/thump_5891571atiquadcrossfire.jpg[/img]

capitanquartz escribió:Y yo vuelvo a decirte: La consola no está preparada para eso. Las cosas en informática y electrónica no ocurren así como por arte de magia. Esas tecnologías requieren cambios en la placa, soporte específico en la tecnología de la GPU (la cual dudo que tenga PICA200) y la salida de vídeo de la segunda gráfica sale a la pantalla como una segunda imagen.

capitanquartz escribió:nanoxxl escribió:capitanquartz escribió:La función de la segunda GPU no es "doblar los frames", es crear una segunda imagen que será la usada en el 3D.

es lo mismo , en 2d a 30fps , en 3d 60fps ( 30fps para cada ojo )

Creo que te estás haciendo un lío. Los FPS no se suman. Si en 2D son 30FP, al pasar a 3D no se duplican los FPS, continuarán los mismos FPS en cada imagen, por lo que siguen siendo 30FPS.

capitanquartz escribió:nanoxxl escribió:capitanquartz escribió: Las cosas no funcionan así, por arte de magia, y no puedes hacer de forma tan sencilla que 2 GPUs procesen una misma imagen. En todo caso, podría servir como CPU de apoyo, pero puede que esto no fuese posible debido al diseño del circuito.

NVIDIA SLI http://www.nvidia.es/object/sli-technol ... ew-es.htmlNVIDIA® SLI™ es una tecnología revolucionaria que permite aumentar drásticamente el rendimiento gráfico combinando varias GPUs NVIDIA en sistemas con una placa base certificada para SLI. SLI utiliza algoritmos de software exclusivos de NVIDIA y una lógica de escalabilidad especial en cada unidad de procesamiento gráfico (GPU) para duplicar el rendimiento (con 2 tarjetas) o multiplicarlo por 2,8 (con 3 tarjetas) en comparación con las soluciones basadas en un solo procesador gráfico

[img*]http://s2.subirimagenes.com/otros/previo/thump_5891570asus780i1nvidia.jpg[/img]

ATI CrossFireX http://game.amd.com/us-en/crossfirex_about.aspxATI CrossFireX™ is the ultimate multi-GPU performance gaming platform. Enabling game-dominating power, ATI CrossFireX technology enables two or more discrete graphics processors to work together to improve system performance. For The Ultimate Visual Experience™, be sure to select ATI CrossFireX ready motherboards for AMD and Intel® processors and multiple ATI Radeon™ HD graphics cards.

[img*]http://s3.subirimagenes.com:81/otros/previo/thump_5891571atiquadcrossfire.jpg[/img]

Y yo vuelvo a decirte: La consola no está preparada para eso. Las cosas en informática y electrónica no ocurren así como por arte de magia. Esas tecnologías requieren cambios en la placa, soporte específico en la tecnología de la GPU (la cual dudo que tenga PICA200) y la salida de vídeo de la segunda gráfica sale a la pantalla como una segunda imagen.

pero realmente sabes lo que dices

pero realmente sabes lo que dices  , la 3ds no trabaja con dos imagenes ( una para cada ojo , por eso lo de la dos gpu )

, la 3ds no trabaja con dos imagenes ( una para cada ojo , por eso lo de la dos gpu )

capitanquartz escribió:Aclarar cosas:

1. La imagen procesada en cada GPU no es exactamente la misma. Existe un desplazamento en el eje de las X para poder llevar a cabo el efecto 3D.

capitanquartz escribió:2. La placa está diseñada para generar 2 imágenes a la vez mediante 2 GPUs, trabajando cada GPU por separado en una imagen diferente.

capitanquartz escribió:3. Efectivamente han tenido que poner 2 GPUs para evitar la desincronización, pero la velocidad de transferencia de la eDRAM es suficiente para las 2 imágenes. No se necesita por tanto otro módulo de eDRAM. Se duplican componentes, pero solo los necesarios, y otro módulo de eDRAM no se necesita.

Saludos.

nanoxxl escribió:capitanquartz escribió:Aclarar cosas:

1. La imagen procesada en cada GPU no es exactamente la misma. Existe un desplazamento en el eje de las X para poder llevar a cabo el efecto 3D.

y , desde hace mucho tiempo se puede conectar dos monitores con dos imagenes distintas en una sola grafica , nada nuevocapitanquartz escribió:2. La placa está diseñada para generar 2 imágenes a la vez mediante 2 GPUs, trabajando cada GPU por separado en una imagen diferente.

de donde lo sacas , fuentes , eso mismo se puede hacer con una sola gpu , la 3ds tiene dos gpu para que en 2d use una gpu y cuando pase a 3d use las dos y no sufra un bajo de frames ( en 2d 30frs = 30 imagenes , 3d 30frs = 60 imagenes ) y perdida de calidad graficacapitanquartz escribió:3. Efectivamente han tenido que poner 2 GPUs para evitar la desincronización, pero la velocidad de transferencia de la eDRAM es suficiente para las 2 imágenes. No se necesita por tanto otro módulo de eDRAM. Se duplican componentes, pero solo los necesarios, y otro módulo de eDRAM no se necesita.

Saludos.

no hace falta tener 2 gpu para eso , y otra vez con la velocidad , ¿ Se duplican componentes, pero solo los necesarios ?

En cuanto al uso de la segunda GPU, se ha de tener en cuenta que el 3D requiere duplicar recursos y por tanto aumentar la tasa de framerate al doble por lo que el sistema pasa a tener la mitad de tiempo para realizar el segundo frame, la segunda GPU no es accesible por el desarrollador y esta completamente controlada por el sistema, se encarga de hacer de apoyo a la primera y en el modo 2D de los juegos esta segunda GPU no hace acto de presencia y queda completamente apagada.

nanoxxl escribió:y , desde hace mucho tiempo se puede conectar dos monitores con dos imagenes distintas en una sola grafica , nada nuevo

capitanquartz escribió:Si lees el texto te lo explican. Es por el framerate.En cuanto al uso de la segunda GPU, se ha de tener en cuenta que el 3D requiere duplicar recursos y por tanto aumentar la tasa de framerate al doble por lo que el sistema pasa a tener la mitad de tiempo para realizar el segundo frame, la segunda GPU no es accesible por el desarrollador y esta completamente controlada por el sistema, se encarga de hacer de apoyo a la primera y en el modo 2D de los juegos esta segunda GPU no hace acto de presencia y queda completamente apagada.

Si tan convencido estás de que todo el equipo técnico de Nintendo está equivocado, vas allí con tu título de ingienería y se lo dices. Pero en lo que a mí respecta, creo que esta conversación está durando demasiado.

![Lee! [rtfm]](/images/smilies/rtfm.gif) , yo me quejo de que para fomentar las 3d an bloqueado la segunda gpu ya que si se usan las dos gpu para juegos 2d es imposible pasarlo a 3d sin perder calidad grafica , lo de la eDRAM me da igual pero es mas de lo mismo , no se puede usar toda la eDRAM en 2d para no perjudicar las 3d

, yo me quejo de que para fomentar las 3d an bloqueado la segunda gpu ya que si se usan las dos gpu para juegos 2d es imposible pasarlo a 3d sin perder calidad grafica , lo de la eDRAM me da igual pero es mas de lo mismo , no se puede usar toda la eDRAM en 2d para no perjudicar las 3d ![Nop [noop]](/images/smilies/net_thumbsdown.gif)

Carlos A. escribió:nanoxxl escribió:y , desde hace mucho tiempo se puede conectar dos monitores con dos imagenes distintas en una sola grafica , nada nuevo

Pero realmente es la misma imagen, aunque esté dividida (que es diferente a a generar dos imágenes diferentes).

Un saludo.

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

Carlos A. escribió:nanoxxl escribió:y , desde hace mucho tiempo se puede conectar dos monitores con dos imagenes distintas en una sola grafica , nada nuevo

Pero realmente es la misma imagen, aunque esté dividida (que es diferente a a generar dos imágenes diferentes).

Un saludo.

nanoxxl escribió:capitanquartz escribió:Si lees el texto te lo explican. Es por el framerate.En cuanto al uso de la segunda GPU, se ha de tener en cuenta que el 3D requiere duplicar recursos y por tanto aumentar la tasa de framerate al doble por lo que el sistema pasa a tener la mitad de tiempo para realizar el segundo frame, la segunda GPU no es accesible por el desarrollador y esta completamente controlada por el sistema, se encarga de hacer de apoyo a la primera y en el modo 2D de los juegos esta segunda GPU no hace acto de presencia y queda completamente apagada.

Si tan convencido estás de que todo el equipo técnico de Nintendo está equivocado, vas allí con tu título de ingienería y se lo dices. Pero en lo que a mí respecta, creo que esta conversación está durando demasiado.

y quien a dicho que el equipo técnico de Nintendo está equivocado , una gpu en 2d crea x framerate y dos gpu en 3d ( aumentar la tasa de framerate al doble ) crea el doble de framerate , lo que estoi diciendo yo, yo me quejo de que para fomentar las 3d an bloqueado la segunda gpu ya que si se usan las dos gpu para juegos 2d es imposible pasarlo a 3d sin perder calidad grafica , lo de la eDRAM me da igual pero es mas de lo mismo , no se puede usar toda la eDRAM en 2d para no perjudicar las 3d

capitanquartz escribió:No se usa el segundo en modo 2D por cuestiones técnicas.

capitanquartz escribió:Si lees el texto te lo explican. Es por el framerate.

Blue escribió:capitanquartz escribió:Si lees el texto te lo explican. Es por el framerate.

No es por el framerate. Es por la memoria. Se acaba la memoria, se empieza a usar la ram en sustitución y al ser la mitad de lenta baja a la mitad el framerate. El framerrate es el daño colateral

Aunque yo hablaba de los problemas en el uso del segundo procesador también para el 2D

Aunque yo hablaba de los problemas en el uso del segundo procesador también para el 2D

nanoxxl escribió:yo puedo ver una pelicula en un monitor y navegar en el otro , eso no son dos imagenes distintas

, y si no pues dilo, intentaré ser más explicativo.

, y si no pues dilo, intentaré ser más explicativo.Carlos A. escribió:nanoxxl escribió:yo puedo ver una pelicula en un monitor y navegar en el otro , eso no son dos imagenes distintas

Veamos, si, son dos imágenes distintas pero por decirlo fácil y rápido las podrías combinar en una sola, ¿cierto? Imagina pegar las dos pantallas, tendríamos una imagen 2D (con un viaje de pixeles, pero 2D).

Cuanto tú quieres hacer el efecto 3D si que tienen que ser dos imágenes diferentes pero, como entenderás, no pueden ser cualquiera: tienen que venir de la misma representación de una realidad 3D pero entre ambas tiene que haber una diferencia de distancia en el eje de abscisas. Eso implica unos costes computacionales que cuando tú quieres representar la reproducción de una película y el navegador en pantallas diferentes no existen, es más, con tu PC actual seguro que puedes abrir cinco navegadores y siete películas simultáneamente que no se cosca, ahora intenta que de un mundo 3D te saque 5-6 perspectivas diferentes de forma dinámica... (piensa en cuantos juegos no puedes poner con una sola perspectiva en una resolución determinada).

Espero que me hayas entendido, y si no pues dilo, intentaré ser más explicativo.

Un saludo.

es lo mismo , en 2d a 30fps , en 3d 60fps ( 30fps para cada ojo )

Carlos A. escribió:nanoxxl escribió:yo puedo ver una pelicula en un monitor y navegar en el otro , eso no son dos imagenes distintas

Veamos, si, son dos imágenes distintas pero por decirlo fácil y rápido las podrías combinar en una sola, ¿cierto? Imagina pegar las dos pantallas, tendríamos una imagen 2D (con un viaje de pixeles, pero 2D).

Cuanto tú quieres hacer el efecto 3D si que tienen que ser dos imágenes diferentes pero, como entenderás, no pueden ser cualquiera: tienen que venir de la misma representación de una realidad 3D pero entre ambas tiene que haber una diferencia de distancia en el eje de abscisas. Eso implica unos costes computacionales que cuando tú quieres representar la reproducción de una película y el navegador en pantallas diferentes no existen, es más, con tu PC actual seguro que puedes abrir cinco navegadores y siete películas simultáneamente que no se cosca, ahora intenta que de un mundo 3D te saque 5-6 perspectivas diferentes de forma dinámica... (piensa en cuantos juegos no puedes poner con una sola perspectiva en una resolución determinada).

Espero que me hayas entendido, y si no pues dilo, intentaré ser más explicativo.

Un saludo.

para que quiero combinarlas , lo que dije es que un pc con una grafica se puede conectar dos monitores y tener dos imagenes distinta ( no hace falta dos gpu para crear dos imagenes distintas ) ,

para que quiero combinarlas , lo que dije es que un pc con una grafica se puede conectar dos monitores y tener dos imagenes distinta ( no hace falta dos gpu para crear dos imagenes distintas ) ,  , en el mio no asin que no puedo hacer lo que dices

, en el mio no asin que no puedo hacer lo que dices

![Ok! [oki]](/images/smilies/net_thumbsup.gif)

Natsu escribió:No se suman los fps, si cada GPU está generando 30fps para cada ojo, tu percibes 30fps y no sesenta.

Otra cosa seria que entre ambas generaran una unica perspectiva y se repartieran la tarea para alcanzar las 60 ips

Por cierto alguien me explica por que el DOA en modo 2D va a 60fps y con el 3D activado lo hace a 30? es por culpa del framebuffer?

Natsu escribió:es lo mismo , en 2d a 30fps , en 3d 60fps ( 30fps para cada ojo )

No se suman los fps, si cada GPU está generando 30fps para cada ojo, tu percibes 30fps y no sesenta.

Otra cosa seria que entre ambas generaran una unica perspectiva y se repartieran la tarea para alcanzar las 60 ips

Natsu escribió:Por cierto alguien me explica por que el DOA en modo 2D va a 60fps y con el 3D activado lo hace a 30? es por culpa del framebuffer?

nanoxxl escribió:Carlos A. escribió:nanoxxl escribió:yo puedo ver una pelicula en un monitor y navegar en el otro , eso no son dos imagenes distintas

Veamos, si, son dos imágenes distintas pero por decirlo fácil y rápido las podrías combinar en una sola, ¿cierto? Imagina pegar las dos pantallas, tendríamos una imagen 2D (con un viaje de pixeles, pero 2D).

Cuanto tú quieres hacer el efecto 3D si que tienen que ser dos imágenes diferentes pero, como entenderás, no pueden ser cualquiera: tienen que venir de la misma representación de una realidad 3D pero entre ambas tiene que haber una diferencia de distancia en el eje de abscisas. Eso implica unos costes computacionales que cuando tú quieres representar la reproducción de una película y el navegador en pantallas diferentes no existen, es más, con tu PC actual seguro que puedes abrir cinco navegadores y siete películas simultáneamente que no se cosca, ahora intenta que de un mundo 3D te saque 5-6 perspectivas diferentes de forma dinámica... (piensa en cuantos juegos no puedes poner con una sola perspectiva en una resolución determinada).

Espero que me hayas entendido, y si no pues dilo, intentaré ser más explicativo.

Un saludo.

pero que diceaspara que quiero combinarlas , lo que dije es que un pc con una grafica se puede conectar dos monitores y tener dos imagenes distinta ( no hace falta dos gpu para crear dos imagenes distintas ) ,

lo de ( con tu PC actual seguro que puedes abrir cinco navegadores y siete películas simultáneamente que no se cosca ) en tu pc puedes conectar 12 monitores, en el mio no asin que no puedo hacer lo que dices

creo que no as entendido mi comentario anterior

Por lo que sé del tema. Y la cuestión no es tanto que sea la misma imagen o no, sino que los frames se repiten en el mismo momento... para hacer lo que tú quieres tendrían que sincronizarse las GPUs para mostrar las imágenes de forma escalada (lo cual ya de por sí es complicado) porque no te sirve de nada tener 2 imágenes en la misma milésima de segundo, ya que solo puedes mostrar una. Después están las limitaciones técnicas, como que la salida de vídeo de la segunda GPU es diferente.

Por lo que sé del tema. Y la cuestión no es tanto que sea la misma imagen o no, sino que los frames se repiten en el mismo momento... para hacer lo que tú quieres tendrían que sincronizarse las GPUs para mostrar las imágenes de forma escalada (lo cual ya de por sí es complicado) porque no te sirve de nada tener 2 imágenes en la misma milésima de segundo, ya que solo puedes mostrar una. Después están las limitaciones técnicas, como que la salida de vídeo de la segunda GPU es diferente.capitanquartz escribió:Mira qué casualidad. Yo sí tengo un Dual Screen y un equipo potentePor lo que sé del tema. Y la cuestión no es tanto que sea la misma imagen o no, sino que los frames se repiten en el mismo momento... para hacer lo que tú quieres tendrían que sincronizarse las GPUs para mostrar las imágenes de forma escalada (lo cual ya de por sí es complicado) porque no te sirve de nada tener 2 imágenes en la misma milésima de segundo, ya que solo puedes mostrar una. Después están las limitaciones técnicas, como que la salida de vídeo de la segunda GPU es diferente.

Saludos.

esplica como lo haces

esplica como lo haces ![Aplausos [plas]](/images/smilies/aplauso.gif)

nanoxxl escribió:capitanquartz escribió:Mira qué casualidad. Yo sí tengo un Dual Screen y un equipo potentePor lo que sé del tema. Y la cuestión no es tanto que sea la misma imagen o no, sino que los frames se repiten en el mismo momento... para hacer lo que tú quieres tendrían que sincronizarse las GPUs para mostrar las imágenes de forma escalada (lo cual ya de por sí es complicado) porque no te sirve de nada tener 2 imágenes en la misma milésima de segundo, ya que solo puedes mostrar una. Después están las limitaciones técnicas, como que la salida de vídeo de la segunda GPU es diferente.

Saludos.

en un Dual Screen puedes conectar 12 monitoresesplica como lo haces