Nvidia lidera cómodamente y con grandes réditos el apetitoso mercado de los procesadores que aceleran las cargas de trabajo de la IA, pero no puede dormirse en los laureles debido a que algunos de sus clientes están

diseñando sus propios chips para reducir su dependencia. Mientras estas compañías se intentan poner al día con el hardware, Nvidia avanza y para seguir alimentando a las tecnológicas que quieren entrenar y ejecutar sus modelos de IA presenta la arquitectura Blackwell liderada por la GPU B200 y el superchip GB200.

Blackwell B200 se ha concebido con 208.000 millones de transistores mediante un proceso de fabricación de 4NP de TSMC, y según Nvidia sus GPUs “incluyen los chips más potentes jamás creados”. La nueva G200 ofrece hasta 20 petaflops de potencia FP4 por los 4 petaflops de su antecesor H100, y en caso de combinar dos de estas GPUs con un procesador Grace en un superchip GB200 se puede obtener hasta 30 veces más rendimiento para ejecutar cargas de trabajo de inferencia para grandes modelos de lenguaje (LLM, por sus siglas en inglés), como son GPT de Open IA, Gemini de Google, Llama de Meta o Claude de Anthropic.

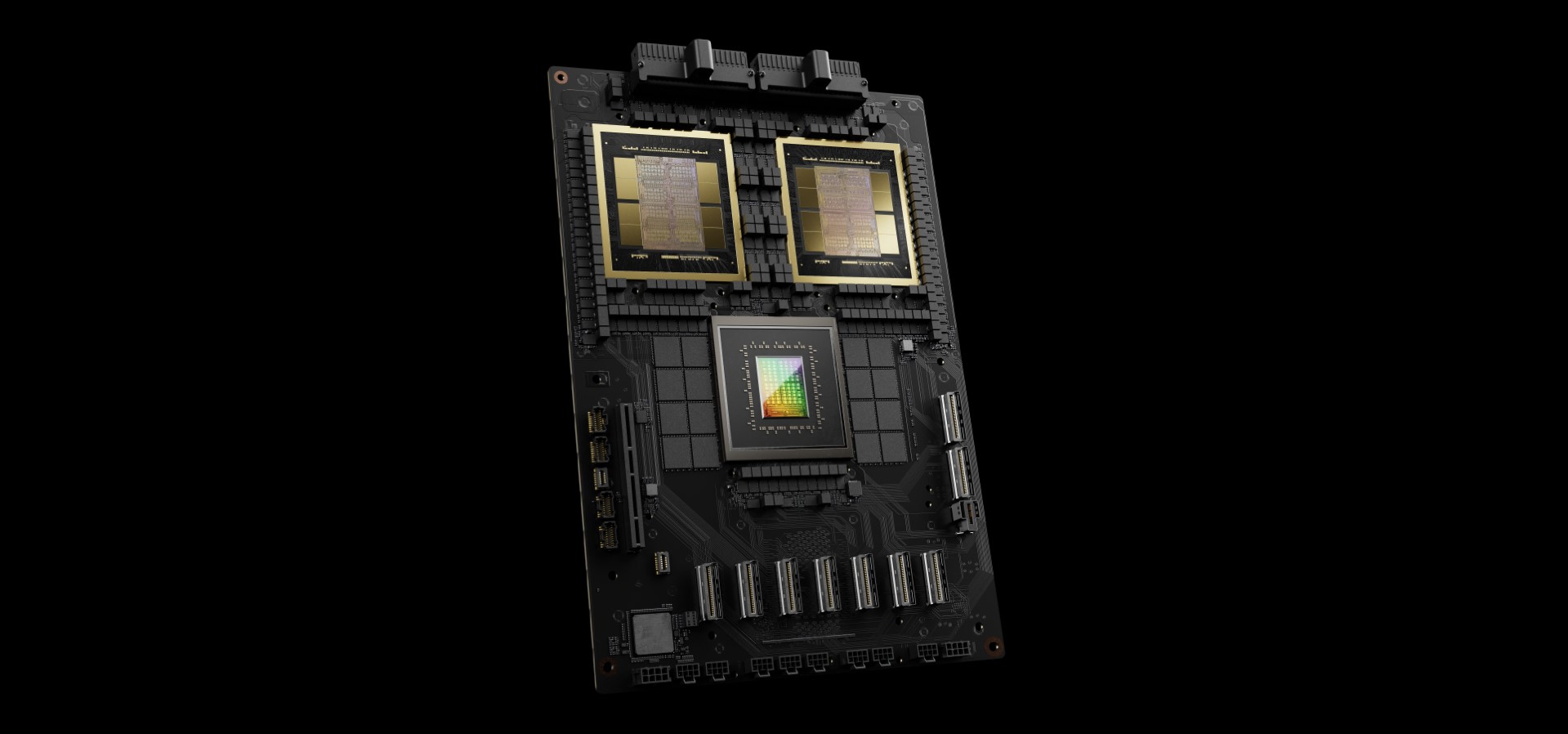

El superchip GB200 con dos GPU B200 Blackwell y una CPU Grace.

El superchip GB200 con dos GPU B200 Blackwell y una CPU Grace.El B200 no solo supera el rendimiento del actual H100 que ha transformado a Nvidia en una empresa con un valor bursátil superior al de Amazon o Alphabet, sino que además lo hace con “un coste y consumo de energía hasta 25 veces menor”.

Según la compañía, para entrenar un modelo de IA de 1.800 millones de parámetros hacen falta 8.000 GPUs Hopper (H100) y 15 megavatios de potencia, mientras que la arquitectura Blackwell hace el mismo trabajo con 2.000 GPUs y cuatro megavatios.

Estas GPUs liberan todo su potencial de computación cuando se conectan entre ellas en un clúster de servidores. Ahí es donde entra en juego la nueva generación del protocolo NVLink, que permite que 576 B200 instaladas en diferentes servidores se comuniquen entre sí con una interconexión de 1,8 TB/s. Nvidia también destaca el uso del motor de descompresión de Blackwell y su capacidad para acceder a grandes cantidades de memoria en la CPU Grace a través de un enlace de alta velocidad de 900 GB/s de ancho de banda bidireccional.

En resumen, la arquitectura Blackwell promete abrir un nuevo capítulo de la IA generativa “con un rendimiento, una eficacia y una escala sin precedentes”, cosa que espera conseguir entrenando modelos de IA de “billones y billones de parámetros”.

Rack GB200 NVL72 con 36 CPUs y 72 GPUs.

Rack GB200 NVL72 con 36 CPUs y 72 GPUs.¿Y las GPUs para juegos? Nvidia ha presentado la arquitectura Blackwell junto al chip B200 y el superchip GB200 en la GTC, una conferencia para desarrolladores centrada en la computación por GPU y la IA, así que no se esperaba nada sobre videojuegos. Sin embargo, muy probablemente la Blackwell impulsará las tarjetas gráficas de la serie RTX 50, que serán presentadas y se pondrán a la venta cuando estén listas.

Fuente: Nvidia