esami escribió:Añado la siguiente:

- Para jugar a 4K es necesario el procesador mas rapido y caro del mercado porque si no va ir fatal el juego y va a hacer de cuello de botella a la GPU.

![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

esami escribió:@Mayban36 si correcto, pero es un hilo de desmontando mitos (Frases que parecen verdad pero que no lo son) (o al menos asi lo he entendido yo)

![angelito [angelito]](/images/smilies/nuevos/angelito.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

javier español escribió:@VanSouls el problema de esa RL es que no dura tanto como el Noctua, ni tiene el mismo servicio de atención post-venta, por algún grado menos, yo por lo menos no la recomendaría, salvo para quienes les gusten las RL por la estética o tal.

Saludos.

![adios [bye]](/images/smilies/nuevos2/adio.gif)

Mayban36 escribió:esami escribió:Añado la siguiente:

- Para jugar a 4K es necesario el procesador mas rapido y caro del mercado porque si no va ir fatal el juego y va a hacer de cuello de botella a la GPU.

Todo lo contrario, cuanto mayor sea la resolución, menos le afecta a la CPU.

![burla2 [burla2]](/images/smilies/nuevos/burla_ani1.gif) Pues para 1080p pedían un 8700k a 59fps y para 2160p pedían el 3950x como recomendación.

Pues para 1080p pedían un 8700k a 59fps y para 2160p pedían el 3950x como recomendación.Benzo escribió:«GOD OF WAR PARA PC REVELA SUS REQUISITOS

Requisitos recomendados (1080p a 30 FPS)SO: Windows 10 64 bit (versión 1809)

- CPU: Intel 8400 o AMD Ryzen 5 2600

- GPU: Nvidia GTX 1060 (6 GB) o AMD RX 570 (4 GB)

- RAM: 8 GB

- Almacenamiento: 70 GB SSD

Requisitos ultra (4K a 60 FPS)

[list]SO: Windows 10 64 bit (versión 1809)

[*]CPU: AMD Ryzen 9 3950X

[*]GPU: Nvidia GTX 3080 (10 GB) o AMD RX 6800 XT (16 GB)

[*]RAM: 16 GB

VanSouls escribió:javier español escribió:@VanSouls el problema de esa RL es que no dura tanto como el Noctua, ni tiene el mismo servicio de atención post-venta, por algún grado menos, yo por lo menos no la recomendaría, salvo para quienes les gusten las RL por la estética o tal.

Saludos.

Sigamos con el hilo please

Mi peocesador consume poquisimo, tengo un tdp de 65w.

El tdp en un chip es un indice que indica la cantidad maxima de calor que genera, que aunque se mide en watts no tiene nada que ver con su consumo energetico, por ejemplo, un ryzen 3700x tiene un tdp de 65w pero de consumo energetico maximo sobrepasa los 200w.

esami escribió:Añado la siguiente:

Mito: Para jugar a 4K es necesario el procesador mas rapido y caro del mercado porque si no va ir fatal el juego y va a hacer de cuello de botella a la GPU.

Realidad: A mayor resolucion, menos afecta la potencia de la CPU en la tasa de fps.

![llorando [snif]](/images/smilies/nuevos/triste_ani1.gif)

![por aquí! [poraki]](/images/smilies/nuevos/dedos.gif) Se petan porque windows 10 necesita un poco mas de 1,5gb para funcionar y entre las dos maquinas te dan 2gb ram con lo cual si o si estas tirando de ram virutal sata2 de un mecánico del 2009

Se petan porque windows 10 necesita un poco mas de 1,5gb para funcionar y entre las dos maquinas te dan 2gb ram con lo cual si o si estas tirando de ram virutal sata2 de un mecánico del 2009javier español escribió:Otro mito: "como voy muy justo de dinero, de momento me compro la placa más barata con solo 2 slots para la RAM y le pongo solo 1 módulo hasta que más adelante ahorre y le compro otro igual para que vayan en Dual Channel." (Luego pasa el tiempo y no encuentra otro módulo de la misma referencia en tiendas, o se compra otro diferente porque el que tiene es más caro y claro, luego no son compatibles porque no tienen los mismos chips internos, ni las mismas latencias, uno es Single Rank y el otro Dual Rank, etc... y no los puede configurar en Dual Channel porque tiene inestabilidades y no se explica por qué "¡si son de la misma frecuencia!")

Saludos.

Fleishmann escribió:Mito: Poned filtros de polvo en todas las entradas y salidas de aire de la caja o se os ensuciará.

Realidad: Si pones filtros en las salidas, evitas que el polvo salga de tu caja.

*Este lo pongo porque lo aprendí hace poco y llevaba haciéndolo mal unos siglos.

Dfx escribió:Para mi el mayor mito de hace años fueron los de "con un i5 sobrado", ahora hoy en día esos 4c/4t son nada y los i7 por lo menos se defienden. Yo en su día elegí al 5820k por encima de un 6700k y sigo pensando que fue la mejor decisión que tome.

Otro que también se veía mucho por este foro era lo de las "configs equilibradas" con algunas GPU que eran mucho para ciertas CPU o viceversa, como si por ejemplo no pudieras disfrutar de una RTX 3080 con un Ryzen 3600.

kevin! escribió:Dfx escribió:Para mi el mayor mito de hace años fueron los de "con un i5 sobrado", ahora hoy en día esos 4c/4t son nada y los i7 por lo menos se defienden. Yo en su día elegí al 5820k por encima de un 6700k y sigo pensando que fue la mejor decisión que tome.

Otro que también se veía mucho por este foro era lo de las "configs equilibradas" con algunas GPU que eran mucho para ciertas CPU o viceversa, como si por ejemplo no pudieras disfrutar de una RTX 3080 con un Ryzen 3600.

Eso mismo decían con el famoso FX8350, decían que no rendían, y que era mejor el i5 2500, y que en juegos iba mejor.

Ahora 2021, muchos juegos actuales el FX rinde como un i7 3770, que costo la mitad.

Hasta hace poco tuve un i5 4690, cuando se me estropeo el Ryzen 2700, estuve con el i5 y iba a pedales en mi uso cotidiano cosa que con el FX8350 no pasaba, y ya te aseguro, la diferencia entre el FX8350 y el i5 4690 no hay color, el FX8350 en multitarea se lo come con patatas.

El FX8350 me costo 156€ y no me arrepiento de su compra, esa cosa se defiende que te cagas.

Rocker0990 escribió:-Mito:Los procesadores actuales de intel son "tostadoras" (testeado generacion 8-9 y 12 con AIO nzxt kraken x62).

Falso:

- la temperatura de la cpu en mayor medida dependera del uso de la cpu,si es cierto que si hay un uso 100% de la cpu en una cpu caliente alcanzara temperatura,pero para un uso en juegos donde seguramente no supere el 60% de uso no es cierto con una buena disipacion no habria problema.

Cuanto mas años pasen y esa cpu vaya haciendo mas cuello de botella elevando el uso de la cpu en juegos mayor sera la temperatura.

![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

dCrypt escribió:Con todos mis respetos, no sé de dónde sacas esos "mitos" y esas "afirmaciones", que no me parecen acertadas, precisas ni correctas.

Además, de lo que hablas en tu post yo no lo denominaría "mitos" ni "creencias".

Saludos.

javier español escribió:Mito: "espérate y no te compres todavía una GPU de la serie RTX 3000, que recién lanzadas están muy caras y en poco tiempo van a bajar de precio que no veas..." (En este mismo foro vi muchos comentarios como ese o parecidos)

Otro mito: "como voy muy justo de dinero, de momento me compro la placa más barata con solo 2 slots para la RAM y le pongo solo 1 módulo hasta que más adelante ahorre y le compro otro igual para que vayan en Dual Channel." (Luego pasa el tiempo y no encuentra otro módulo de la misma referencia en tiendas, o se compra otro diferente porque el que tiene es más caro y claro, luego no son compatibles porque no tienen los mismos chips internos, ni las mismas latencias, uno es Single Rank y el otro Dual Rank, etc... y no los puede configurar en Dual Channel porque tiene inestabilidades y no se explica por qué "¡si son de la misma frecuencia!")

colado escribió:Pues los saco de los años que llevo leyendo foros de informatica y diferentes afirmaciones de la gente que escribe en ellos. Que no te parecr acertado, preciso o correcto?

- Tu pc no puede con un monito 4k, mejor 1440 144hz.

La resolucion 4k (3840x2160) 60fps equivale en potencia de procesamiento de la gpu a el mal

llamado 2k (2560x1440) 135fps o a ultrawide “2k” (3440x1440) 100fps

- Mi procesador consume poquisimo, tengo un tdp de 65w.

El tdp en un chip es un indice que indica la cantidad maxima de calor que genera, que aunque se mide en watts no tiene nada que ver con su consumo energetico, por ejemplo, un ryzen 3700x tiene un tdp de 65w pero de consumo energetico maximo sobrepasa los 200w.

- Mi fuente Mars Gaming Vulcano 750W puede con todo y va genial.

Una fuente de alimentacion no siempre da los watts que indica, las genericas y las baratas normalmente un 30% menos de lo indicado, ademas de tener pocos o ningun sistema de proteccion, valores de tension inconstantes

- Mi juego pide 12gb de vram, en 2021 no pueden tener menos memoria.

Los videojuegos reservan una cantidad de ram de video, cuanta mas haya mas reservaran, esto no indica que sea la que consume realmente.

- Le cambie la pasta grafica a mi cpu, xo siguen los problemas.

La pasta termica, ni se degrada tan rapido como muchos creen, ni ofrece tanta diferencia de temperaturas. Es recomendable cambiarla cada año par de años pero no hace milagros, puede mejorar la temperatura entorno al 10% como mucho.

fulfidor escribió:Mito: Los ssd mejoran el rendimiento del PC ya que al cargar más rapido, gestiona mejor la información

Realidad: los ssd no mejoran nada el rendimiento de un PC, simplemente el tiempo de carga de los elementos necesarios para funcionar

PD: fui víctima de esto. Me pille un m2 sn750 black western digital para "solo" ahorrarme tiempos de carga. Que ya solo por eso si que merece la pena. Pero 0 rendimiento

nirvana17 escribió:alguna vez se escucha fuente de muchos watios consume mas ,

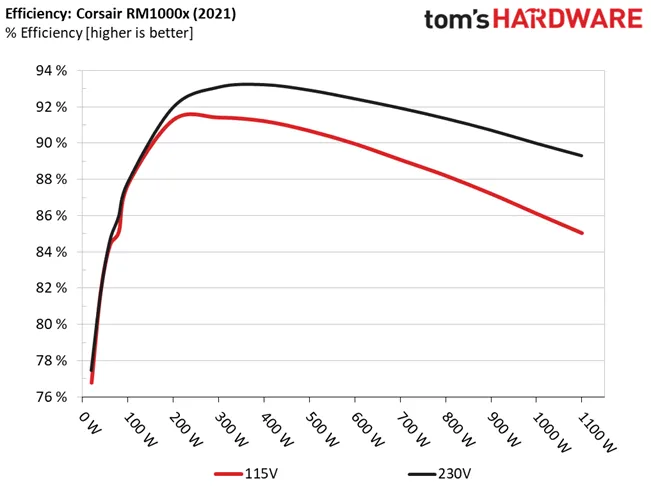

Dfx escribió:@javier español la curva de eficiencia en las fuentes de muchos watios y calidad hace que ese consumo en niveles bajos sea anecdótico o irrelevante.

Otra cosa es que compres una fuente de las de incendio asegurado y tenga una eficiencia pésima.

javier español escribió:nirvana17 escribió:alguna vez se escucha fuente de muchos watios consume mas ,

Y eso es correcto, si está muy sobredimensionada respecto a lo que consuman los componentes, depende del modelo en concreto de fuente que sea, pero normalmente si el consumo de los componentes está por debajo del 20% de la potencia que la fuente sea capaz de suministrar apróximadamente, las fuentes pierden bastante eficiencia y consumen más.

Dicho esto, tampoco es que eso sea algo muy exagerado normalmente, depende de la cantidad de horas de uso del equipo, pero si p.ej. es para un servidor que vaya a estar enchufado 24/7 y el consumo del equipo fuera muy bajo, pues si se pusiera una fuente exageradamente sobredimensionada en potencia, pues sí, se notaría en el recibo de la luz más que si se pusiera una fuente más ajustada en potencia a lo que consuma realmente el equipo.

Saludos.

Dfx escribió:@javier español por eso te digo que hagas el cálculo que supone 50 a 100w entre el 84 y 90% eficiencia, a lo sumo estás hablando de 1w, irrelevante. Ya que las de menor potencia también tienen su curva en esos rangos.