pues imaginar los juegos de Xbox

pues imaginar los juegos de Xbox

aun no he visto un juego como Sonic adventure 2 en pc, si, esa maravilla de Dreamcast, para mi uno de los plataformas mas preciosos y divertidos que he jugado junto con Jak and Dexter de Ps2

aun no he visto un juego como Sonic adventure 2 en pc, si, esa maravilla de Dreamcast, para mi uno de los plataformas mas preciosos y divertidos que he jugado junto con Jak and Dexter de Ps2

Originalmente enviado por Tails

aun no he visto un juego como Sonic adventure 2 en pc, si, esa maravilla de Dreamcast, para mi uno de los plataformas mas preciosos y divertidos que he jugado junto con Jak and Dexter de Ps2

Un saludo y no os preocupeis porque saquen nuevos chips

Originalmente enviado por Raine

Ojo que la GF4 es el NV25 y la Xbox es la NV2a mientras que la GF3 es la NV17...

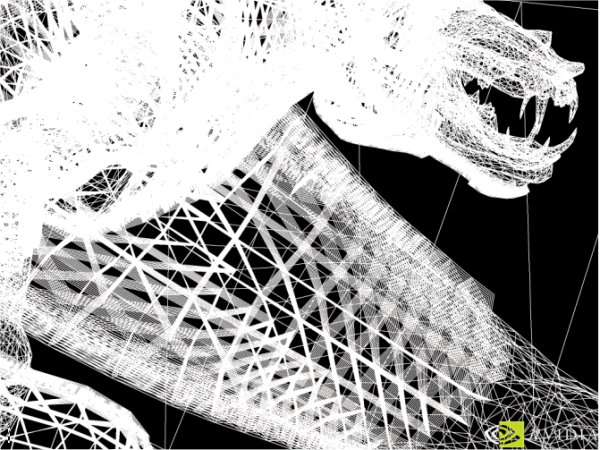

COMDEX - LAS VEGAS, NEVADA - NOVEMBER 12, 2001 - Addressing the major concerns of today's most demanding road warriors: battery life, DVD playback, performance, and size, NVIDIA® Corporation (Nasdaq: NVDA) today introduced their new-generation mobile graphics processing unit (GPU), code-named NV17M. With its stellar power management features, including NVIDIA's PowerMizer Technology; integrated Video Processing Engine (VPE); revolutionary antialiasing technology for superior display quality; and an ultra-efficient memory architecture--NVIDIA's new mobile GPU provides graphics capabilities previously unavailable on a portable platform.

XDXDXD

XDXDXD

Originalmente enviado por shadow land

GF4 es a la Xbox como la Gf2 MX400 es a la GF2 Ultra.

Es decir, GF4 es una Xbox capada.

Originalmente enviado por Raine

La NV20 es la GF3 Ti 500

el Nv17 es la primera GF3 ..

y el NV17M es la GF3 Go o como se llame

o te crees que lo que Nvidia desarrollo hace un año aun no tienen permiso para superarlo, o que?

Originalmente enviado por M3D

Es que soy el unico de la pradera que NO SE CREE que la Xbox mueva 125 millones de poligonos?

habra hardware mejor de aqui a 6 meses (Ati Radeon 9000 (R300)).

NV2A es una tecnologia COMPRADA por MS y no dio permiso a nVIDIA a sacar algo equivalente hasta 2 años mas tarde, es decir, las DirectX 9.

en lo q se usen, claro).

en lo q se usen, claro).

Originalmente enviado por shadow land

GeForce 3 DCC renderizo en tiempo real la película de Final Fantasy, a 30fps (mas o menos

Yo sigo feliz con mi Kyro II jugando a 1024 a 32bits a todo sin problema alguno... y es la polla.

Yo sigo feliz con mi Kyro II jugando a 1024 a 32bits a todo sin problema alguno... y es la polla.

Originalmente enviado por shadow land

es que Sony tuvo q fabricar un Superordenador basado en el Emotion Engine para poder renderizar la película

)/lightwave/3DS MAX x.x (os aseguro q se renderizo mediante ligthwave... conozco a alguien de la distribuidora de este producto en españa... (o una de las q lo distribuyen jejeje)), la calidad siempre sera incomparable... eso es muy dificil de igualar, y pasaran unas decadas hasta q se llegue a igualar... es tan simple como q en el tiempo real, aun no se usan técnicas de raytracing, si no de ray casting, q es parecido, pero no lo mismo. Aunque se incluye algo d eraytracing es mínimo...

)/lightwave/3DS MAX x.x (os aseguro q se renderizo mediante ligthwave... conozco a alguien de la distribuidora de este producto en españa... (o una de las q lo distribuyen jejeje)), la calidad siempre sera incomparable... eso es muy dificil de igualar, y pasaran unas decadas hasta q se llegue a igualar... es tan simple como q en el tiempo real, aun no se usan técnicas de raytracing, si no de ray casting, q es parecido, pero no lo mismo. Aunque se incluye algo d eraytracing es mínimo...

XDXD (30fps en GeForce 3 asegurados por John Carmack).

XDXD (30fps en GeForce 3 asegurados por John Carmack).

Originalmente enviado por shadow land

Mueve 3 veces mas polígonos q GeForce 3 gracias a su segundo Vertex Shader (cerca de los 100Millones por Segundo, Xbox 125, ahora veis por que decia lo de "capada"?)

(yo no me referia solo a la potencia bruta si no a las características reales del producto...)..

(yo no me referia solo a la potencia bruta si no a las características reales del producto...)..

XDXD

XDXD