Vamos por partes (Resumen)

1) El mayor retraso hoy en día es como dicen el Software (Lenguajes de programación con un rendimiento pésimo (algunos mucho peor que otros)) pero es que crear un lenguaje versátil y potente es una tarea casi imposible por la enorme cantidad de trabajo y de mentes brillantes que requeriría (si alguien se piensa que algo así puede hacerlo una persona en su casa va listo).

2) Al contrario de lo que muchos creen la realidad es que ya estamos llegando al limite de lo que la tecnología digital basada en el silicio puede dar (al ritmo actual alcanzaremos ese limite en la década de 2020 probablemente en 2025-2027) (en el mejor de los casos optimizando/reduciendo otros componentes del PC podríamos alargar la decadencia 10 años más hasta 2035 y que seguramente sera lo que se haga puesto que 2020 tecnológicamente hablando lo tenemos ya encima) ten en cuenta que la "

Unidad mínima indivisible de Materia" es el

ÁTOMO (No puedes fabricar nada que requiera menos de un Átomo pues es la unidad mínima de cualquier elemento de la Tabla periódica. Todo el desarrollo electrónico del planeta esta basado en el silicio (hay sustitutos (Oro, Galio, Germanio) y el material que paga fuerte son los grafenos pero son caros y difíciles de producir por el momento) por lo que actualmente estamos con el silicio que ya esta llegando a su limite Actualmente cada soldadura de los transistores tiene tan solo 28 átomos de silicio y el limite teórico en el cual un transistor no puede reducirse más (no puedes soldar con menos de un Átomo (unidad indivisible de materia recuerdas) es de 5 nm por debajo de eso es imposible integrar los transistores al circuito eléctrico de la placa base.

Hacer transistores más pequeños que estos requerirá usar elementos distintos del silicio que tuvieran un radio atómico más pequeño, o el uso de partículas subatómicas (como electrones o protones) como transistores.

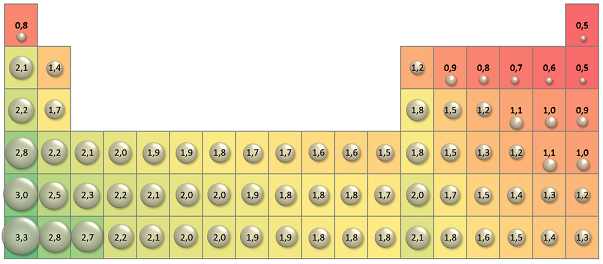

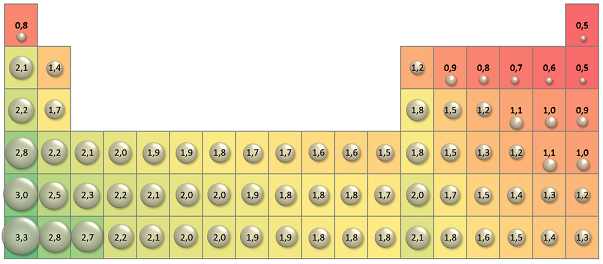

Radio Atómico de los elementos (comparar con la tabla de abajo para los que no os sepáis la "Sagrada Tabla" de memoria

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

(El silicio se representa por "Si" y es el décimo cuarto (14) elemento en la tabla

Tabla Periódica

Así pues salvo que se halle la forma de hacer asequible el grafeno (o los otros materiales arriba comentados) o que se pueda utilizar las partículas subatómicas como transistores en un plazo máximo de 20 años (si no en 10 años) habremos llegado al limite.

Este es el motivo por lo que ahora ya no se aumenta la potencia tan rápido como antes (reducir más nm es jodido pues estamos al limite), fabricar a menos nm requiere muchas más inversión maquinas más precisas lo que encarece el coste (aparte de que no puedes reducir mucho más) y por otro lado antes menos nm era sinónimo de

disminución de consumo y aumento de potencia y fíjate si estamos llegando al limite de lo que el Silicio puede hacer que ya disminuir de 22nm a 14nm apenas a incrementado la potencia un misero 5% y estudios científicos dicen que a partir de los 7nm incluso de perderá rendimiento por interacciones atómicas (siempre refiriéndonos al Silicio).

Según Bob Colwell, el nodo de 5 nm será el fin de la Ley de Moore (y estudios más recientes como digo sitúan esa cifra en los 7nm y no en los 5nm)

https://en.wikipedia.org/wiki/Bob_ColwellAsí pues los esfuerzos desde hace años se centran en optimizar (en lugar de reducir porque ya no puedes sacar más de donde no hay) entiéndase entre comillas "intel hyper-threading", "AMD Simultaneous multithreading (SMT)", Dx12, Vulkan ect...

Articulo de la revista Nature (una de las revistas más prestigiosas sobre ciencia a nivel internacional)

http://www.nature.com/news/the-chips-ar ... aw-1.19338Saludos

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif) (El silicio se representa por "Si" y es el décimo cuarto (14) elemento en la tabla

(El silicio se representa por "Si" y es el décimo cuarto (14) elemento en la tabla