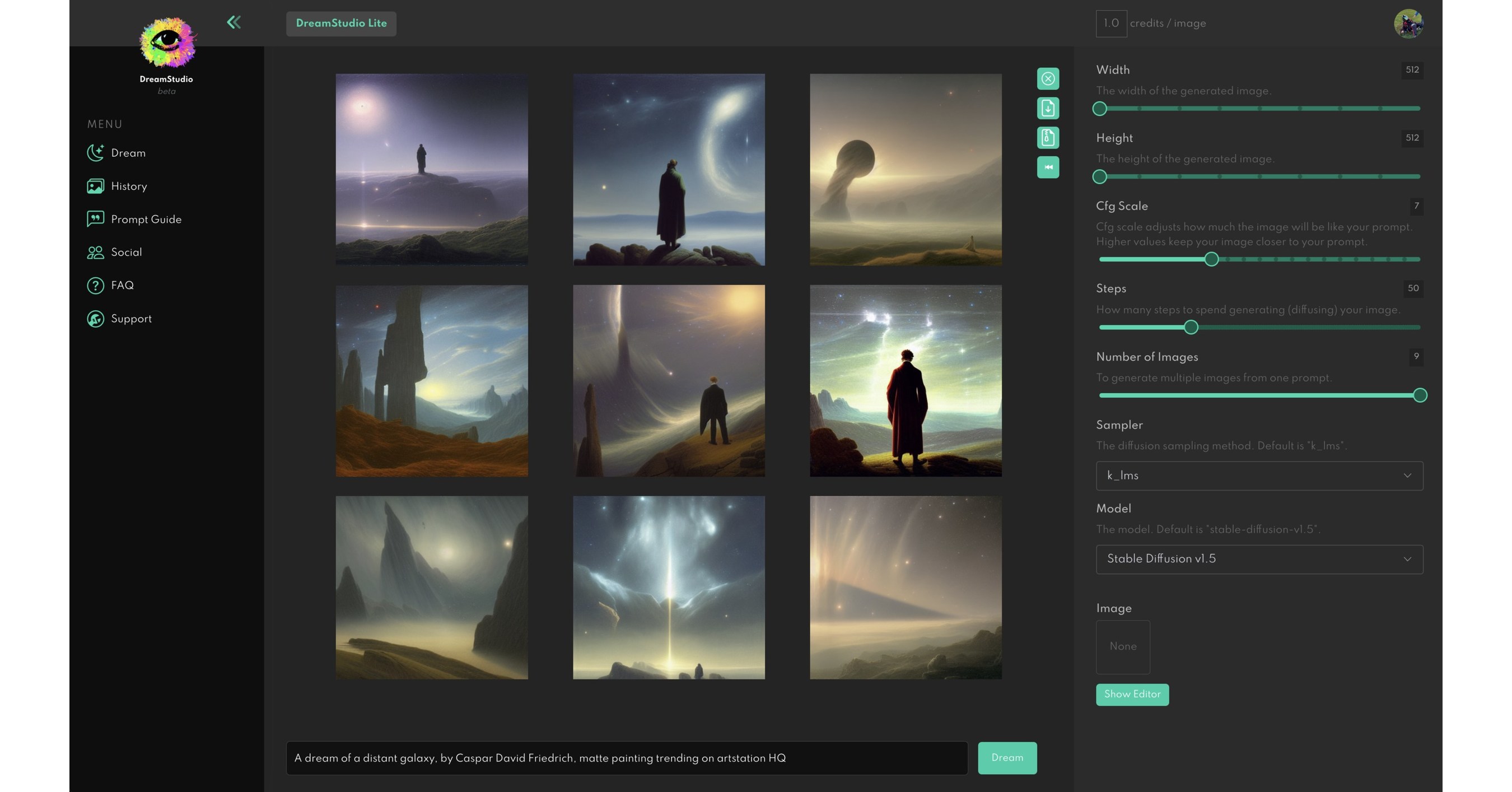

INSTALAR FLUX CON PINOKIO (software que instala IAs y herramientas para IA) https://pinokio.computer/En el vídeo creo que instala webui, yo recomiendo forge ya que tiene más opciones, instaláis pinokio y buscáis forge y allí os saldrá para instalar, todo es automatizado como si fuese un exe que te instala todo.

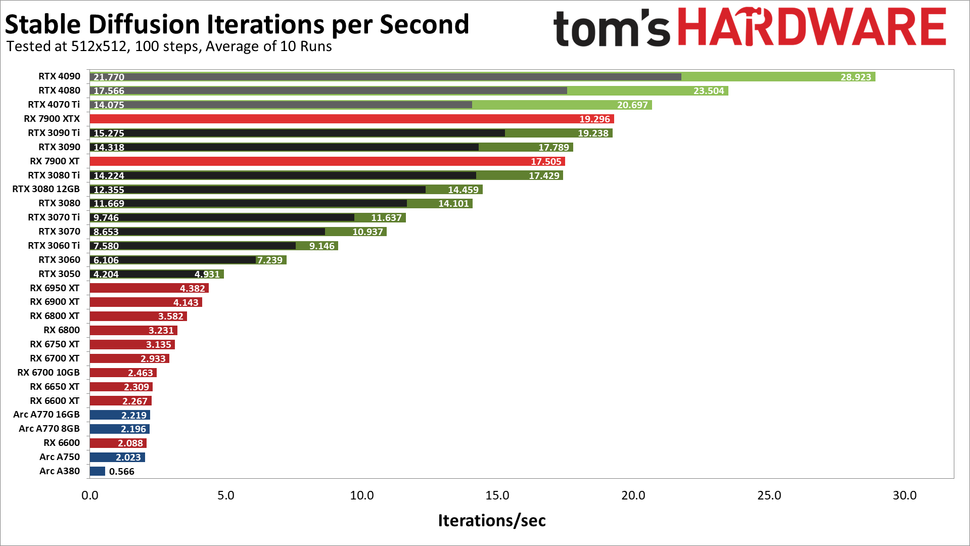

CREA LORAS PARA FLUX EN LOCAL PARA GPUS CON 8 GBs o MÁS DE FORMA SENCILLAEste tutorial está muy bien para crear LORAS con datasets para flux usando la herramienta de pinokio+flux gym, además flux gym se apoya en una IA que se llama florence-2 que añade descripción de forma automática a todas las imágenes del dataset mejorando el entendimiento a la hora de crear el modelo.

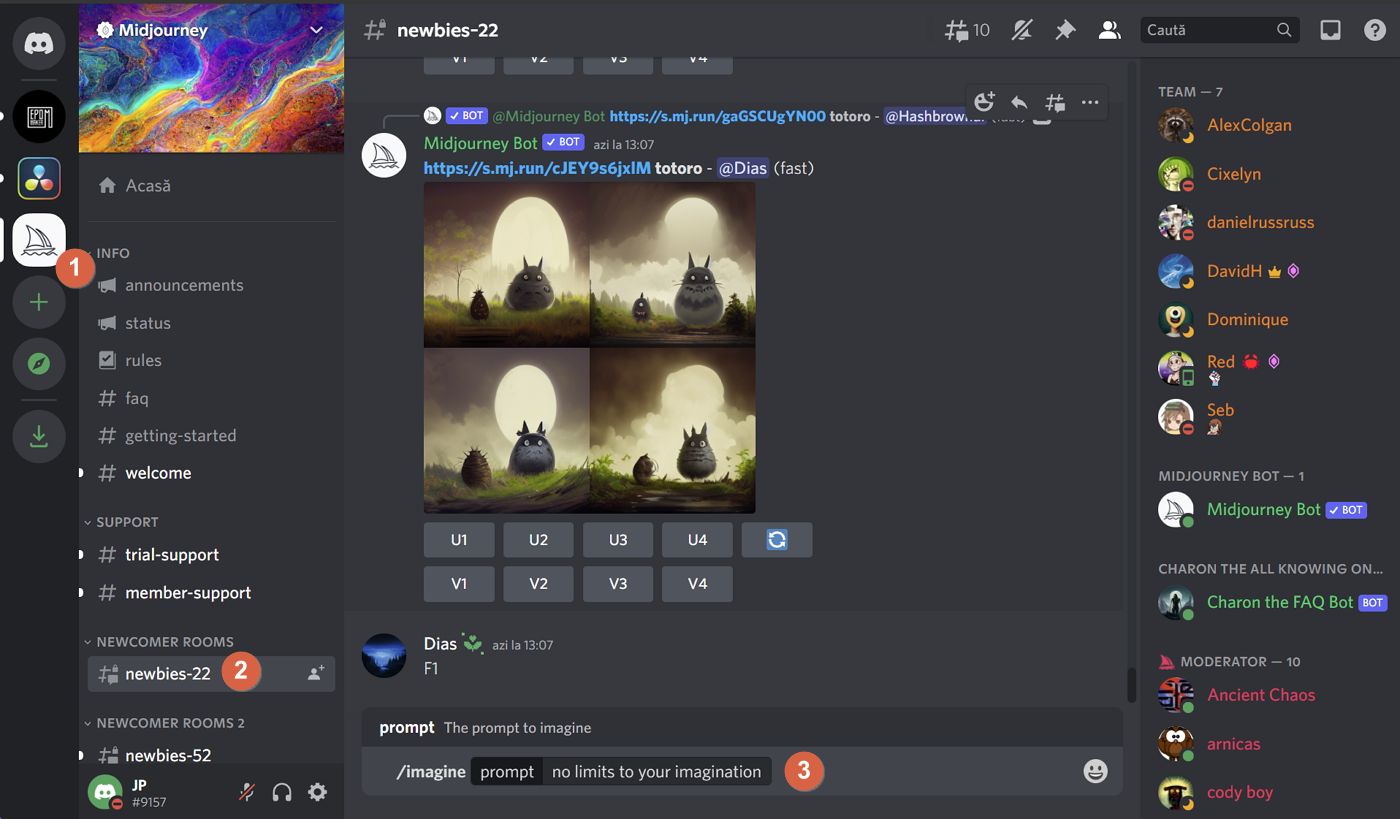

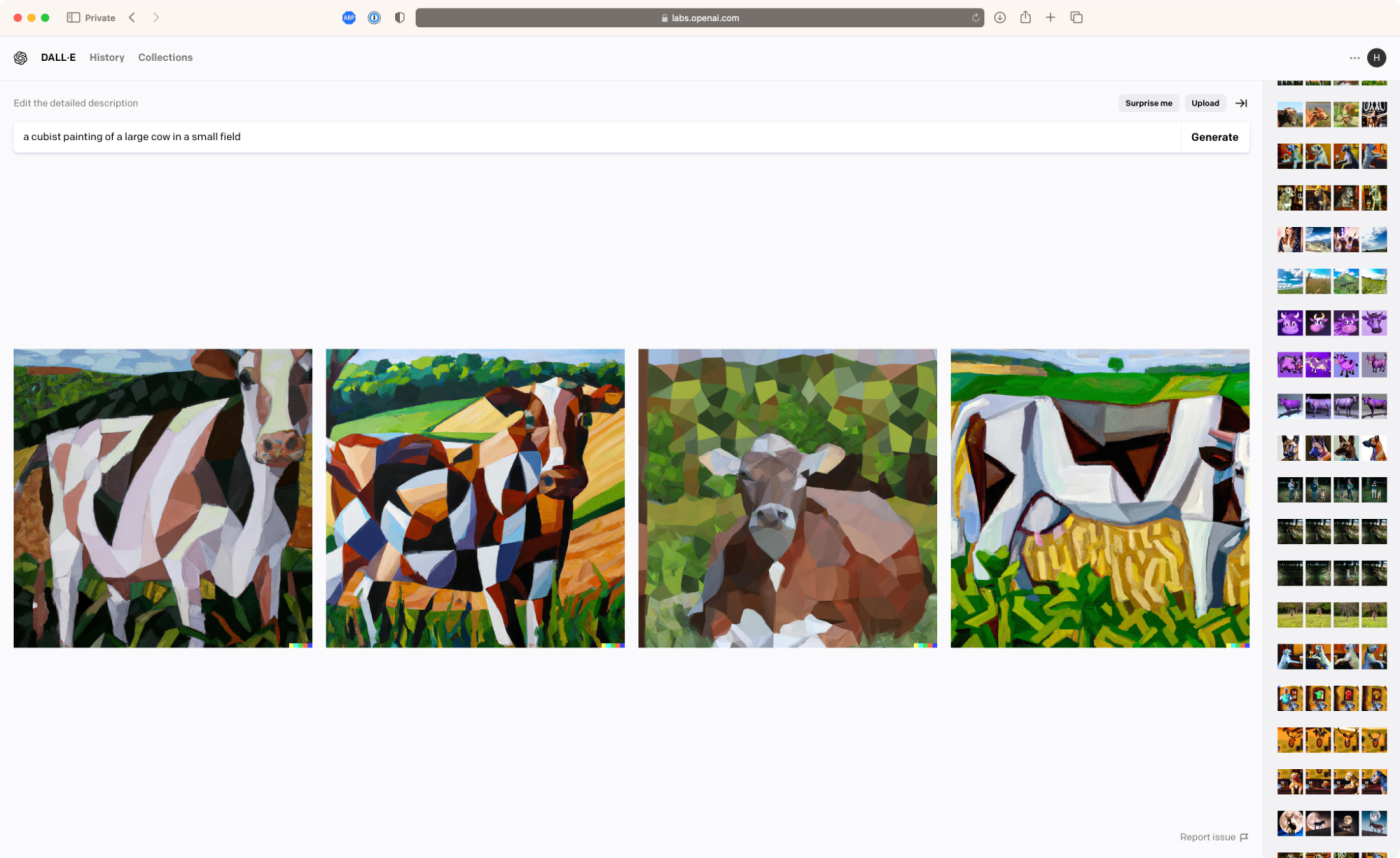

SORA, EL MODELO DE VÍDEO DE OPENAI SE HA FILTRADOhttps://www.20minutos.es/tecnologia/int ... i-5659215/OpenAI está detrás de las herramientas con inteligencia artificial con más público en España y todo el mundo, como el generador de imágenes DALL-E y el modelo de lenguaje grande ChatGPT. Sin embargo, para ampliar su abanico de tecnologías, a mediados de febrero, esta entidad de Sam Altman presentó a Sora, una IA capaz de crear vídeos de hasta 60 segundos a partir de texto.

Ahora un grupo artístico molesto con OpenAI parece haber filtrado Sora mediante una interfaz y muchos usuarios generaron a través de ella diferentes videos. El grupo ha mostrado su descontento ante como se ha implementado el programa para los artistas.

Unos artistas filtran Sora, el generador de video de OpenAI

Hace pocos días, tal y como informan desde TechCrunch, un grupo artístico publicó en Hugging Face, una plataforma de desarrollo, un proyecto vinculado a la API Sora de OpenAI, el cual no está disponible de forma pública. Como se puede ver en la publicación de X, antes Twitter, hicieron pública una interfaz de Sora y una gran cantidad de usuarios las utilizaron como base para generar videos de 10 segundos en 1080p mediante descripciones de texto.

A las pocas horas la herramienta dejó de funcionar y, según el grupo, la compañía de Sam Altman suspendió el acceso temprano a Sora tras tres horas, alegando que la empresa presiona a los desarrolladores iniciales para hablar de forma positiva del generador de videos sin compensarlos justamente. También denuncian controles estrictos alegando que cada video debe ser aprobado por OpenAI y solo unos pocos creadores pueden compartir públicamente sus trabajos.

Artistas enfadados filtran Sora, el revolucionario generador de vídeo con inteligencia artificial de OpenAI

El grupo afirma apoyar la IA en el arte, pero critica cómo OpenAI gestiona Sora, pidiendo un mayor apoyo a los artistas más allá de los intereses de las relaciones públicas. En respuesta, OpenAI declaró que Sora está en “vista previa de investigación” y que trabajan en medidas de seguridad. También alegan que la participación en la versión en desarrollo es voluntaria, ofrecen acceso gratuito y apoyan a los artistas con subvenciones y eventos.

Sin embargo, pidieron evitar compartir detalles confidenciales mientras sigue en desarrollo, sin especificar qué implica el uso "responsable". Desde su lanzamiento, Sora ha enfrentado problemas técnicos, pero la versión filtrada parece ser una variante “turbo” con opciones limitadas de personalización y estilo.

HUNYUAN VÍDEO: TENCENT PUBLICA UN MODELO DE VÍDEO OPEN SOURCE DE 13 BILLONES DE PARÁMETROShttps://comfyui-wiki.com/es/news/2024-1 ... yuan-videoTencent ha lanzado oficialmente HunyuanVideo, actualmente el modelo de generación de vídeo más grande de la industria. Con 13 mil millones de parámetros, el modelo logra un rendimiento líder en múltiples aspectos, incluyendo calidad de vídeo y estabilidad de movimiento, y ahora está completamente disponible como código abierto en las plataformas GitHub y Hugging Face.

Características principales del modeloArquitectura unificada de generación de imágenes y vídeos

Emplea un diseño de modelo híbrido “dual-stream to single-stream”

Utiliza arquitectura Transformer con mecanismo de atención completa

Soporta la generación unificada de imágenes y vídeos

Características técnicas avanzadasUtiliza un modelo de lenguaje multimodal (MLLM) como codificador de texto

Implementa VAE 3D para compresión espacio-temporal

Reescritura de prompts incorporada con modos Normal y Master

Soporta generación de vídeo en alta resolución hasta 720p

Ventajas únicasExcelente rendimiento con contenido de estilo chino, incluyendo temas tradicionales y modernos

Soporta transiciones de escena a través de prompts manteniendo la consistencia de ID

Mantiene física estable en escenas de movimiento intenso

Las evaluaciones profesionales muestran un rendimiento superior en alineación de texto, calidad de movimiento y calidad visual

Requisitos de hardwareMínimo: 45GB VRAM GPU (resolución 544x960)

Recomendado: 60GB VRAM GPU (resolución 720x1280)

Compatible con GPUs H800/H20 y otros

Recursos de código abierto

El modelo está disponible en:Repositorio GitHub: Tencent/HunyuanVideo

Modelo en Hugging Face: tencent/HunyuanVideo

Experiencia en líneaLos usuarios pueden experimentar HunyuanVideo a través de:

Sitio web oficial: Plataforma de generación de vídeo Hunyuan

Sección de AI Video en la APP Tencent Yuanbao

Tecnologías complementarias

Además del modelo principal de generación de vídeo, Tencent ha lanzado una serie de tecnologías complementarias:

Tecnología de generación conjunta de voz e imagenSoporta generación de vídeo con habla facial y acciones

Permite control preciso del movimiento corporal completo

Comprensión de contenido de vídeo y narración

Reconocimiento inteligente del contenido del vídeoGenera narraciones coincidentes basadas en prompts

Transferencia de expresiones faciales

Sincronización labial precisaEfectos naturales de transferencia de expresiones

Perspectivas futurasEl lanzamiento de código abierto de HunyuanVideo no solo marca un avance significativo en la tecnología de generación de vídeo, sino que también trae nuevas posibilidades a todo el campo de la generación de vídeo por IA. Al abrir el código fuente y los pesos pre-entrenados, Tencent espera impulsar el desarrollo de todo el ecosistema de generación de vídeo.

Con la optimización continua del modelo y los esfuerzos de la comunidad, podemos esperar que la tecnología de generación de vídeo por IA desempeñe un papel cada vez más importante en la expresión creativa y la producción de contenido en un futuro próximo.

![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

![Adorando [tadoramo]](/images/smilies/adora.gif)