Segun eses datos la GTX Titan no llegaria a ser ni siquiera lo doble de potente que la 8970m de portátil. Sin embargo en double precision seria unas 9 veces más potente

. Parece que no hay una relación directa entre eses dos métodos de calcular la potencia.

Voy a intentar aclarar un poco lo de los FLOPS y la precisión simple (32 bits) y doble (64 bits).

Hasta hace pocos años, la potencia bruta de cómputo de una tarjeta gráfica pasaba bastante desapercibida. Era un dato que sólo importaba en las carísimas GPUs profesionales como Tesla, que marcaban las diferencias en el rendimiento de aplicaciones de diseño y modelado en 3D. Para los juegos actuales todavía tiene una importancia muy pequeña y se usan cálculos de precisión simple. A partir de la nueva generación, cuando realmente se le empiece a sacar el jugo a la potencia de cómputo para físicas, iluminación y otros cálculos más complejos, ya sea por OpenCL o CUDA, estaremos utilizando un montón de tareas que necesitan hacer cálculos de doble precisión. Por ejemplo, el pelo TressFX de Lara en el nuevo Tomb Raider utiliza cálculos de doble precisión.

Veamos la potencia de cálculo de unas gráficas:

AMD 7970 Ghz (400€)Single: 3800 GFLOPS

Double: 1126 GFLOPS

GTX 680 (450-500€)Single: 3090 GFLOPS

Double: desconocido, aunque se indica FP64= 1/24 FP32, lo que quiere decir que hay que dividir 3090/24= 128,75 GFLOPS

GTX TITAN (1000€)Single: 4500 GFLOPS

Double: 1300 GFLOPS (además de especificarlo, se indica 1/3 FP32, corroborando el dato de la GTX680)

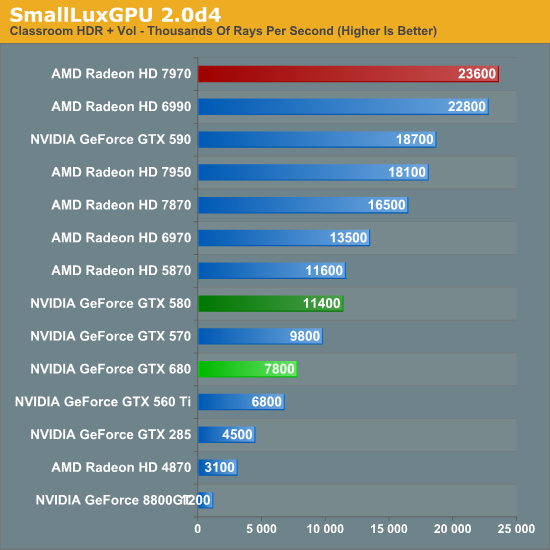

Un benchmark ilustrativo de rendimiento de doble precisión aunque hay muchos más:

La explicación del paupérrimo rendimiento de la serie GTX 600 en doble precisión, incluso muy por debajo de la anterior generación GTX500, se debe a que en esta gama recortaron el rendimiento en doble precisión de 1/8 FP32 a 1/24, seguramente para ahorrar costes. Y de hecho les ha salido bien, porque en la mayoría de juegos está a la par en rendimiento con la 7970Ghz, y como aún los juegos todavía apenas utilizan cómputo de doble precisión han vendido bien su producto en el timing adecuado. Ahora que se acercan juegos next-gen que utilizan cómputo DP sacarán su GTX780 basada en el núcleo GK110 (igual que titan) que vuelve a potenciar esa parte.

Volviendo a las consolas, se que a muchos os preocupa el famoso número de 2,5 TFlops (en precisión simple) de la diapositiva del techdemo de Epic de Samaritan, como marcando el mínimo para conseguir esa calidad gráfica, que además es la causante de tanto revuelo con los FLOPS que ahora parecen el nuevo Mhz... Creo que debemos pasar página. Esa demo se hizo hace ya unos cuantos años y las cosas han cambiado mucho. Acordaros, 3x GTX580 y al año siguiente una sola 680, ¡y eso que tiene peor rendimiento en cómputo que una sola 580! Y ahora te sacan Infiltrator con una sola 680 también y mucho más bestia y con un escenario gigantesco.

Al final lo más importante con lo que debemos quedarnos es que por ejemplo Battlefield 3 quizás está sacando el 90% de provecho de los shaders de una GPU 7970, pero no está sacando ni un 20% de provecho de la potencia de cómputo, o del 50% de los ROPS, por no hablar de lo que se pierde con DirectX o por no estar optimizando para un solo hardware. Y es ahí donde llegas a la conclusión que comparar consolas con PCs es absurdo. ¿Tengo que recordar lo increíble que se ve y lo fluido que va Crysis 3 a 720p equivalente a calidad media en PC en una consola de 8 años?