kikomanco escribió:Pulet escribió:@kikomanco A mí sin ir más lejos dos rtx que tuve y las dos defectuosas..

Si si, te creo, yo que he estado todo el tiempo en el hilo de turing desde antes de que salieran las gráficas (vamos igual que en éste) he visto de todo, hasta 3 gráficas defectuosas, y gente con 15 días o menos con la gráfica y de un momento a otro, el famoso " space invaders" y RMA al canto

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

wildchild_bcn escribió:kikomanco escribió:Pulet escribió:@kikomanco A mí sin ir más lejos dos rtx que tuve y las dos defectuosas..

Si si, te creo, yo que he estado todo el tiempo en el hilo de turing desde antes de que salieran las gráficas (vamos igual que en éste) he visto de todo, hasta 3 gráficas defectuosas, y gente con 15 días o menos con la gráfica y de un momento a otro, el famoso " space invaders" y RMA al canto

que es eso del famoso space invaders??![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

yo viendo que las rtx3000 tienen un tdp alto y van a ser calentitas, he hecho cambio de caja, que estaba muy rallado... la 1080ti se me ponia en la anteior caja (una phanteks p400) sobre 82º y con la nueva (cm h500m) he bajado 10 gradazos de grafica![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

kikomanco escribió:pdriko31 escribió:Entonces es el mejor momento para vender graficas de segunda mano no?

Exacto, yo por la mía saque casi 1000€ después de casi 2 años de uso

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif) ) pero ya 800-900 euros lo veo normal, esos 400 serian cuando ya tuvieran 3 años de vida por lo menos.

) pero ya 800-900 euros lo veo normal, esos 400 serian cuando ya tuvieran 3 años de vida por lo menos.

Zinv escribió:@kikomanco como tu has dicho en el hipotético caso rinda igual en los juegos que usen el rt y el dlss lógicamente serán los juegos que vayan saliendo y no en todos, pero quitando ese uso, en el uso normal la 2080ti seguro que sacara mas que una 3060, en todo caso puede estar igual que una 3070, todo esto hipotéticamente eh, que yo hasta que no vea nada para mi todo lo que dicen es humo y nada mas que humo.

Es verdad que ahora mismo yo si viera una 2080ti en 400 euros la compraba con los ojos cerrados(pero sabiendo que me la llevo no una estafa) pero ya 800-900 euros lo veo normal, esos 400 serian cuando ya tuvieran 3 años de vida por lo menos.

@Demi-Fiend pero fíjate que hace unos años por culpa de la minería subió de precio todo, lógicamente todo el mundo que vaya a vender sus cosas quiere sacarle todo el dinero posible, pero ante todo tiene que ver si el mercado le es a favor o en contra, ejemplo practico hace unos años los iphone no perdía valor ni de coña, ahora mismo un 7 u 8 lo puedes conseguir por menos d 300 o 200 euros y un xr en 400 euros si buscas bien.

Lo que quiero decir es que...si quieres tener todo lo ultimo pagas el dinero que te piden, si no compras un modelo mas asequible y vas tirando millas, en mi caso, me esperare una 3060 o una 3070, o amd si espavila, y sino tengo un colega con la 2080 founder que si me la deja en 400 o un poco menos se la compro

Od3n escribió:Me voy a montar un PC en breve. Me recomendariais esperarme y pillar un bicho de estos?

chrispro escribió:Od3n escribió:Me voy a montar un PC en breve. Me recomendariais esperarme y pillar un bicho de estos?

Tú sabrás si quieres palmar dinero/ rendimiento...

Yo estoy esperando a un buen 10700k .. o el 4700x de AMD.. y la gráfica de AMD o la 3080ti...

Si me tengo que aguantar el verano pues aguanto

Imagínate comprar lo similar a esto hoy en día.. 9700k y 2080ti

Cuanto dinero/rendimiento palmas?

Cuanto salga la generación nueva el dinero de tu equipo se desvalora brutalmente. / rendimiento... Cuanto rendimiento palmas? Pues la diferencia de la gen.. 30% dicen?

Yo lo veo claro

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

Gwyn escribió:Vamos del pesimismo al optimismo más absoluto![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

La gente ya visualiza 2080Ti a 400€, cuando hasta hace nada costaba incluso ver las 1080Ti de segunda zarpa a esos precios xD

Pero bueno, ojalá, como digo siempre.

![por aquí! [poraki]](/images/smilies/nuevos/dedos.gif)

Gwyn escribió:Vamos del pesimismo al optimismo más absoluto![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

La gente ya visualiza 2080Ti a 400€, cuando hasta hace nada costaba incluso ver las 1080Ti de segunda zarpa a esos precios xD

Pero bueno, ojalá, como digo siempre.

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

NMansell92 escribió:Al final las Ampere van salir este año si o si? O nos vamos a 2021?

Y otra cosa, es fiable comprarlas de salida? Es decir, no es mejor esperar un poco que hayan revisiones,etc? Mi idea es ir a una 3080 o algo parecido pero miedo me da desembolsar mucha pasta en algo tan nuevo.

Yo estaba pensando que igual me pillaba una 3060 pero es facil que espere a que bajen de precio algo o si por un casual la gama Turing pasa a reemplazar a las 16XX, podria comprar una facilmente. Tampoco es que tenga una necesidad imperiosa, las GTX 1060 6GB siguen rindiendo a 1080p bastante bien.

Yo estaba pensando que igual me pillaba una 3060 pero es facil que espere a que bajen de precio algo o si por un casual la gama Turing pasa a reemplazar a las 16XX, podria comprar una facilmente. Tampoco es que tenga una necesidad imperiosa, las GTX 1060 6GB siguen rindiendo a 1080p bastante bien. Demi-Fiend escribió:Zinv escribió:No entiendo porque dicen que una 2080ti (un tarjeton de la ostia) se va a vender en 400 euros cuando salga la 3060, porque yo recuerdo ver como se vendían de segunda manos una 1080ti(otro tarjeton) a 600 y ya los dos años de las rtx venderse en 400...

es porque ya a pasado antes, cuando salio la 1070 por 350 y la 980ti salio por 700, habia gent vendiendo la 980ti por mucho menos de 200 y si no me crees, habia hasta hilos donde la peña se preguntaba si la 980ti merecia la pena por cierto precio y ahora imaginate las respuestas.

https://www.elotrolado.net/hilo_es-la-980ti-buena-gpu-a-dia-de-hoy_2270348

En mi caso yo tuve mis dudas de si comprar una 1080ti en su tiempo por el precio que pedian algunos más por el hecho de que algunos ponian precio alto por la mineria, no porque costara eso usada https://www.elotrolado.net/hilo_es-enserio-que-la-1080ti-ya-no-merece-la-pena-comprar_2279866, a la final me decante por una 2080ti nueva a pesar del precio más por garantia ya que si una 1080ti usada me salia mala no podia cambiarla.

Eso si, yo no compraria las turing usadas ni loco, por el hecho de que tuvieron más tasa de fallas que las anteriores, al menos a mi me toco cambiar 2, por lo que se espera que se encuentren rtx 2080ti usadas a muy bajo precio cuando salgan las 30.

Nomada_Firefox escribió:NMansell92 escribió:Al final las Ampere van salir este año si o si? O nos vamos a 2021?

Y otra cosa, es fiable comprarlas de salida? Es decir, no es mejor esperar un poco que hayan revisiones,etc? Mi idea es ir a una 3080 o algo parecido pero miedo me da desembolsar mucha pasta en algo tan nuevo.

La solución es facil, te esperas a que sea viejo.Yo estaba pensando que igual me pillaba una 3060 pero es facil que espere a que bajen de precio algo o si por un casual la gama Turing pasa a reemplazar a las 16XX, podria comprar una facilmente. Tampoco es que tenga una necesidad imperiosa, las GTX 1060 6GB siguen rindiendo a 1080p bastante bien.

Respecto a cuando salen......no hay un solo anuncio oficial. Solo el rumor de que podrian lanzarlas en agosto. Pero yo a 1 mes de esa supuesta fecha no apostaria ni un centimo. Es más que sospechable que estan esperando la reapertura que claramente no va a llegar de todo el mercado de EEUU. Pais que como no tiene una estrategia consensuada contra el Covi, va a estar medio cerrado y sufriendo rebrotes mucho más tiempo de lo imaginado. Y como son el mercado principal de todas las grandes marcas, pues nadie va a hacer un lanzamiento en un momento en el que vemos más de 40 millones de parados donde tus productos estrella se van a diluir mientras la economia vuelve a unos niveles aceptables.

Asi que yo veo más facil la llegada de productos inferiores con Turing como la 1650 con Raytracing.

adriano_99 escribió:Demi-Fiend escribió:Zinv escribió:No entiendo porque dicen que una 2080ti (un tarjeton de la ostia) se va a vender en 400 euros cuando salga la 3060, porque yo recuerdo ver como se vendían de segunda manos una 1080ti(otro tarjeton) a 600 y ya los dos años de las rtx venderse en 400...

es porque ya a pasado antes, cuando salio la 1070 por 350 y la 980ti salio por 700, habia gent vendiendo la 980ti por mucho menos de 200 y si no me crees, habia hasta hilos donde la peña se preguntaba si la 980ti merecia la pena por cierto precio y ahora imaginate las respuestas.

https://www.elotrolado.net/hilo_es-la-980ti-buena-gpu-a-dia-de-hoy_2270348

En mi caso yo tuve mis dudas de si comprar una 1080ti en su tiempo por el precio que pedian algunos más por el hecho de que algunos ponian precio alto por la mineria, no porque costara eso usada https://www.elotrolado.net/hilo_es-enserio-que-la-1080ti-ya-no-merece-la-pena-comprar_2279866, a la final me decante por una 2080ti nueva a pesar del precio más por garantia ya que si una 1080ti usada me salia mala no podia cambiarla.

Eso si, yo no compraria las turing usadas ni loco, por el hecho de que tuvieron más tasa de fallas que las anteriores, al menos a mi me toco cambiar 2, por lo que se espera que se encuentren rtx 2080ti usadas a muy bajo precio cuando salgan las 30.

Todos los comentarios que se están viendo aquí, TODOS PUNTO POR PUNTO, se vieron en el hilo de la serie 1000 antes de su lanzamiento.

Estais flipando que una 1070 va a rendir como una 980ti.

No os va a dar nvidia por 350 pavos el rendimiento que ahora os da por 700.

Vosotros lo que queréis es comprar una 980ti tirada de segunda mano engañando a la gente.

Y etc etc etc....

Eol es un bonito lugar de bucles infinitos.

que son filtraciones

que son filtraciones Zinv escribió:https://elchapuzasinformatico.com/2020/07/asus-rog-strix-geforce-rtx-3080-ti-filtrada-la-primera-gpu-ampere-para-el-segmento-gaming-filtrada/

Dejo esto por aquí...solo se muestra como sera el modelo de asus...no os flipeisque son filtraciones

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

alanwake escribió:Chicos no se la veracidad de esto pero personalmente interesa, haré copy paste de la noticia añadiendo la fuente, para que podais leerla aqui y no infringir en las políticas de dicha web.

si alguien se ofende por el copy/paste, que haga click en el enlace

NVIDIA Ampere tiene fecha de presentación y confirmación de nodo

El consumo y el tamaño de los dies serían «culpa» de Samsung

Como ya adelantamos hace dos meses, NVIDIA estuvo jugando a dos bandas y se ha terminado quemando por dos veces. La primera fue con Turing y la nula opción de optar a los 7 nm de TSMC y ahora vuelve a repetirse la historia, pero parcialmente.

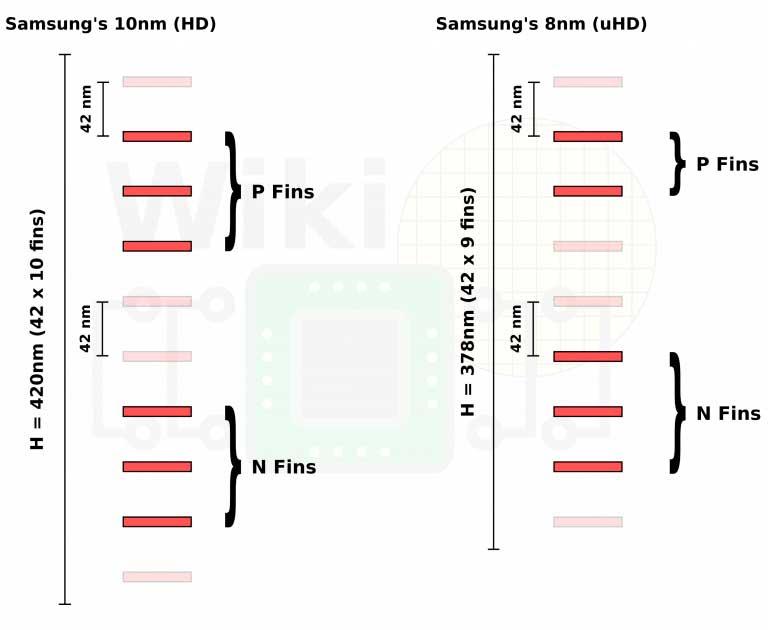

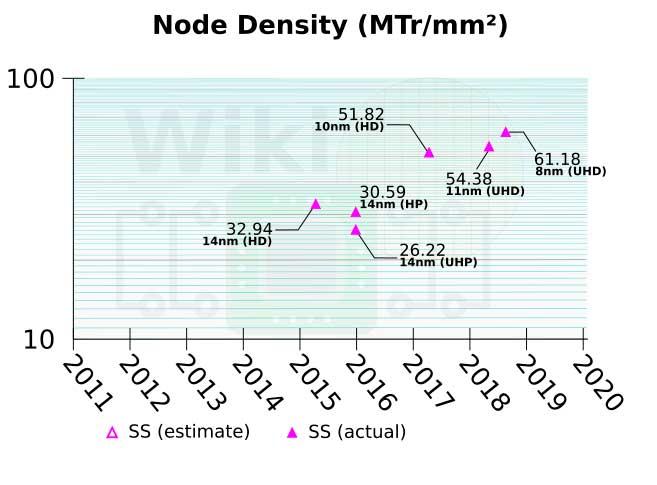

Solo los chips GA100 llegarán en 7 nm de TSMC como bien se encargó de aclarar Huang, pero lo que no dijo es que Samsung será la encargada de los chips gaming en su proceso de 8 nm, pero ¿por qué esto es relevante? En primer lugar por la densidad de dicho proceso, y es que hablamos de una métrica MTr/mm2 de 61,2 en un proceso que no está realizado en EUV, sino en DUV.

Por lo visto ni siquiera Samsung tiene lista EUV a 7 nm y eso que partía con ventaja. Independientemente de esto, los 7 nm de TSMC también en DUV obtienen 96,49 MTr/mm2, es decir, es un 57,66% más denso que la apuesta de Samsung, hasta tal punto que ni los primeros chips de 7 nm EUV de los coreanos consiguen superarlos.

¿Qué implica esto? Realmente TODO. Hemos estado hablando de unos consumos totales disparados, de unos PCB totalmente novedosos y ahora nos toca hablar del tamaño de los dies, porque si el GA100 es masivo, el GA102 no va a ser realmente menor según los datos de Fin Pitch y Gate Pitch de Samsung (42 nm y 64 nm respectivamente). Si el GA100 tiene 826 mm2, el GA102 podría estar por encima de los 600 mm2 sin ningún problema dados los datos de Shaders que tendría y lo ya comentado.

Y es que los 8 nm de Samsung son una derivación directa de los 10 nm actuales que usa en sus chips, de ahí los consumos y seguramente el poco avance en las frecuencias.

NVIDIA Ampere: fecha de presentación y otros datos

También se confirma que la NVIDIA Ampere RTX3090 llevará el GA102-300 con 5248 Shaders, 12 GB de VRAM y al parecer podrá mantener los 21 Gbps en sus GDDR6X. Decimos estos porque están llegando rumores sobre problemas de estabilidad en esta versión de la VRAM, así que tendremos que esperar para ver si NVIDIA opta por dicha velocidad o termina por bajarla.

En cualquier caso, los de Huang parecen tener dos fechas para su presentación y la verdad es que no están nada lejos: 17 de agosto o 27 de agosto, donde las tarjetas llegarían justamente un mes después al mercado.

Con ello los verdes intentarán adelantarse a AMD y su RDNA2, quitándole posibles ventas a los de Lisa Su. En cualquier caso, todo va a marchas forzadas según parece con NVIDIA Ampere, los plazos son muy cortos y esto impide también un mayor número de filtraciones. Los primeros samples deberían estar a punto de salir del horno y con ello esperamos que algún alma caritativa ponga blanco sobre negro con su rendimiento, porque seguramente que los precios serán lo último en saberse.

Fuentes: https://hardzone.es/noticias/tarjetas-g ... cion-nodo/

https://fuse.wikichip.org/news/1443/vls ... extension/

https://twitter.com/kopite7kimi/status/ ... 7804457984

https://semiwiki.com/semiconductor-manu ... nm-update/

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

Daicon escribió:alanwake escribió:Chicos no se la veracidad de esto pero personalmente interesa, haré copy paste de la noticia añadiendo la fuente, para que podais leerla aqui y no infringir en las políticas de dicha web.

si alguien se ofende por el copy/paste, que haga click en el enlace

NVIDIA Ampere tiene fecha de presentación y confirmación de nodo

El consumo y el tamaño de los dies serían «culpa» de Samsung

Como ya adelantamos hace dos meses, NVIDIA estuvo jugando a dos bandas y se ha terminado quemando por dos veces. La primera fue con Turing y la nula opción de optar a los 7 nm de TSMC y ahora vuelve a repetirse la historia, pero parcialmente.

Solo los chips GA100 llegarán en 7 nm de TSMC como bien se encargó de aclarar Huang, pero lo que no dijo es que Samsung será la encargada de los chips gaming en su proceso de 8 nm, pero ¿por qué esto es relevante? En primer lugar por la densidad de dicho proceso, y es que hablamos de una métrica MTr/mm2 de 61,2 en un proceso que no está realizado en EUV, sino en DUV.

Por lo visto ni siquiera Samsung tiene lista EUV a 7 nm y eso que partía con ventaja. Independientemente de esto, los 7 nm de TSMC también en DUV obtienen 96,49 MTr/mm2, es decir, es un 57,66% más denso que la apuesta de Samsung, hasta tal punto que ni los primeros chips de 7 nm EUV de los coreanos consiguen superarlos.

¿Qué implica esto? Realmente TODO. Hemos estado hablando de unos consumos totales disparados, de unos PCB totalmente novedosos y ahora nos toca hablar del tamaño de los dies, porque si el GA100 es masivo, el GA102 no va a ser realmente menor según los datos de Fin Pitch y Gate Pitch de Samsung (42 nm y 64 nm respectivamente). Si el GA100 tiene 826 mm2, el GA102 podría estar por encima de los 600 mm2 sin ningún problema dados los datos de Shaders que tendría y lo ya comentado.

Y es que los 8 nm de Samsung son una derivación directa de los 10 nm actuales que usa en sus chips, de ahí los consumos y seguramente el poco avance en las frecuencias.

NVIDIA Ampere: fecha de presentación y otros datos

También se confirma que la NVIDIA Ampere RTX3090 llevará el GA102-300 con 5248 Shaders, 12 GB de VRAM y al parecer podrá mantener los 21 Gbps en sus GDDR6X. Decimos estos porque están llegando rumores sobre problemas de estabilidad en esta versión de la VRAM, así que tendremos que esperar para ver si NVIDIA opta por dicha velocidad o termina por bajarla.

En cualquier caso, los de Huang parecen tener dos fechas para su presentación y la verdad es que no están nada lejos: 17 de agosto o 27 de agosto, donde las tarjetas llegarían justamente un mes después al mercado.

Con ello los verdes intentarán adelantarse a AMD y su RDNA2, quitándole posibles ventas a los de Lisa Su. En cualquier caso, todo va a marchas forzadas según parece con NVIDIA Ampere, los plazos son muy cortos y esto impide también un mayor número de filtraciones. Los primeros samples deberían estar a punto de salir del horno y con ello esperamos que algún alma caritativa ponga blanco sobre negro con su rendimiento, porque seguramente que los precios serán lo último en saberse.

Fuentes: https://hardzone.es/noticias/tarjetas-g ... cion-nodo/

https://fuse.wikichip.org/news/1443/vls ... extension/

https://twitter.com/kopite7kimi/status/ ... 7804457984

https://semiwiki.com/semiconductor-manu ... nm-update/

Pues que mal royito de ser verdad no?

Mmm, a ver qué pasa al final.

La verdad que la cantidad de tdp anunciado ya no apuntaba del todo bien.

La verdad que sigo pensando en cambiar... Peeero, en fin, a ver qué pasa.

alanwake escribió:A mi lo que me acojona es la gente que se ha montado ahora pc's, aconsejándose con fuentes ya justas para su actual pc, no van a poder pillarse una 3000 de ser cierto esto, sin cambiar la fuente que no tendrá ni 1 año

kikomanco escribió:alanwake escribió:A mi lo que me acojona es la gente que se ha montado ahora pc's, aconsejándose con fuentes ya justas para su actual pc, no van a poder pillarse una 3000 de ser cierto esto, sin cambiar la fuente que no tendrá ni 1 año

Yo tengo una corsair CX 850M es certificación bronze y con 850w debe de tener un margen de sobra ( viene de alimentar una 2080ti con oc a tope) tiene 3 años desde que la compré y estoy pensando en cambiarla con la gráfica, cómo lo ves? Aguanto con esa fuente o renuevo fuente con la gráfica?

alanwake escribió:kikomanco escribió:alanwake escribió:A mi lo que me acojona es la gente que se ha montado ahora pc's, aconsejándose con fuentes ya justas para su actual pc, no van a poder pillarse una 3000 de ser cierto esto, sin cambiar la fuente que no tendrá ni 1 año

Yo tengo una corsair CX 850M es certificación bronze y con 850w debe de tener un margen de sobra ( viene de alimentar una 2080ti con oc a tope) tiene 3 años desde que la compré y estoy pensando en cambiarla con la gráfica, cómo lo ves? Aguanto con esa fuente o renuevo fuente con la gráfica?

Hasta con una de 750W tienes, las CX no están mal, si te quema la pasta (como a todos alguna vez), vendela y pillate una Corsair RM 750W, o Seasonic focus plus gold 750W, pero no te preocupes por esos 850W, yo lo digo porque he visto configs de pc's con fuentes de 450W/550W, y verás que gracia cuando esos usuarios quieran pillarse una 3000

PD: es pegatina verde esa CX o es pegatina Negra? la verde son las viejas

kikomanco escribió:alanwake escribió:kikomanco escribió:Yo tengo una corsair CX 850M es certificación bronze y con 850w debe de tener un margen de sobra ( viene de alimentar una 2080ti con oc a tope) tiene 3 años desde que la compré y estoy pensando en cambiarla con la gráfica, cómo lo ves? Aguanto con esa fuente o renuevo fuente con la gráfica?

Hasta con una de 750W tienes, las CX no están mal, si te quema la pasta (como a todos alguna vez), vendela y pillate una Corsair RM 750W, o Seasonic focus plus gold 750W, pero no te preocupes por esos 850W, yo lo digo porque he visto configs de pc's con fuentes de 450W/550W, y verás que gracia cuando esos usuarios quieran pillarse una 3000

PD: es pegatina verde esa CX o es pegatina Negra? la verde son las viejas

Es pegatina negra, es más leí en una web de rewiens que la CX de 850w tenía mejores componentes que la de 750w y es más pasó la prueba de los 40 grados que sólo las pasan las de certificación Gold

Pd; vaya tela montar un equipo con una fuente de 450/550w

alanwake escribió:Se entiende que con 550W pero de calidad hay suficiente, pero supongamos que al final esas gpu's tienen picos de 350W como se ha visto ya, sobran 200W, entre micro+placa+ram+RL si tienes+ssd+Hd+etc.. ¿te sobran unos 50W?

yo siempre he sido partidario de dejar un margen en las fuentes de 100W, nunca se sabe cuando los vas a necesitar.

kikomanco escribió:alanwake escribió:Se entiende que con 550W pero de calidad hay suficiente, pero supongamos que al final esas gpu's tienen picos de 350W como se ha visto ya, sobran 200W, entre micro+placa+ram+RL si tienes+ssd+Hd+etc.. ¿te sobran unos 50W?

yo siempre he sido partidario de dejar un margen en las fuentes de 100W, nunca se sabe cuando los vas a necesitar.

No creo que alguien con una fuente de 550w se le ocurra comprar una 3080ti/3090, los que compramos éstas gráficas mínimo tenemos en el PC una fuente de 750w

kikomanco escribió:alanwake escribió:Se entiende que con 550W pero de calidad hay suficiente, pero supongamos que al final esas gpu's tienen picos de 350W como se ha visto ya, sobran 200W, entre micro+placa+ram+RL si tienes+ssd+Hd+etc.. ¿te sobran unos 50W?

yo siempre he sido partidario de dejar un margen en las fuentes de 100W, nunca se sabe cuando los vas a necesitar.

No creo que alguien con una fuente de 550w se le ocurra comprar una 3080ti/3090, los que compramos éstas gráficas mínimo tenemos en el PC una fuente de 750w

. Que mínimo para una tope de gama de GPU...

. Que mínimo para una tope de gama de GPU... ![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

alanwake escribió:Yo conozco a uno de aquí con muy buen PC y con Tacens 1000W, mejor que sobre que falte

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif) por cierto en PcComponentes tenían a 120€ hace 3 semanas la bitfenix Whisper de 850w, a ver si la vuelven a poner, están sin stock

por cierto en PcComponentes tenían a 120€ hace 3 semanas la bitfenix Whisper de 850w, a ver si la vuelven a poner, están sin stockkikomanco escribió:alanwake escribió:Yo conozco a uno de aquí con muy buen PC y con Tacens 1000W, mejor que sobre que falte

Con un par jajajajaja (por la tacens por supuesto)por cierto en PcComponentes tenían a 120€ hace 3 semanas la bitfenix Whisper de 850w, a ver si la vuelven a poner, están sin stock

@Antoniopua tas "pasao" peaso de fuente tú..

Esa mínimo 12 años te dura

kikomanco escribió:Daicon escribió:alanwake escribió:Chicos no se la veracidad de esto pero personalmente interesa, haré copy paste de la noticia añadiendo la fuente, para que podais leerla aqui y no infringir en las políticas de dicha web.

si alguien se ofende por el copy/paste, que haga click en el enlace

NVIDIA Ampere tiene fecha de presentación y confirmación de nodo

El consumo y el tamaño de los dies serían «culpa» de Samsung

Como ya adelantamos hace dos meses, NVIDIA estuvo jugando a dos bandas y se ha terminado quemando por dos veces. La primera fue con Turing y la nula opción de optar a los 7 nm de TSMC y ahora vuelve a repetirse la historia, pero parcialmente.

Solo los chips GA100 llegarán en 7 nm de TSMC como bien se encargó de aclarar Huang, pero lo que no dijo es que Samsung será la encargada de los chips gaming en su proceso de 8 nm, pero ¿por qué esto es relevante? En primer lugar por la densidad de dicho proceso, y es que hablamos de una métrica MTr/mm2 de 61,2 en un proceso que no está realizado en EUV, sino en DUV.

Por lo visto ni siquiera Samsung tiene lista EUV a 7 nm y eso que partía con ventaja. Independientemente de esto, los 7 nm de TSMC también en DUV obtienen 96,49 MTr/mm2, es decir, es un 57,66% más denso que la apuesta de Samsung, hasta tal punto que ni los primeros chips de 7 nm EUV de los coreanos consiguen superarlos.

¿Qué implica esto? Realmente TODO. Hemos estado hablando de unos consumos totales disparados, de unos PCB totalmente novedosos y ahora nos toca hablar del tamaño de los dies, porque si el GA100 es masivo, el GA102 no va a ser realmente menor según los datos de Fin Pitch y Gate Pitch de Samsung (42 nm y 64 nm respectivamente). Si el GA100 tiene 826 mm2, el GA102 podría estar por encima de los 600 mm2 sin ningún problema dados los datos de Shaders que tendría y lo ya comentado.

Y es que los 8 nm de Samsung son una derivación directa de los 10 nm actuales que usa en sus chips, de ahí los consumos y seguramente el poco avance en las frecuencias.

NVIDIA Ampere: fecha de presentación y otros datos

También se confirma que la NVIDIA Ampere RTX3090 llevará el GA102-300 con 5248 Shaders, 12 GB de VRAM y al parecer podrá mantener los 21 Gbps en sus GDDR6X. Decimos estos porque están llegando rumores sobre problemas de estabilidad en esta versión de la VRAM, así que tendremos que esperar para ver si NVIDIA opta por dicha velocidad o termina por bajarla.

En cualquier caso, los de Huang parecen tener dos fechas para su presentación y la verdad es que no están nada lejos: 17 de agosto o 27 de agosto, donde las tarjetas llegarían justamente un mes después al mercado.

Con ello los verdes intentarán adelantarse a AMD y su RDNA2, quitándole posibles ventas a los de Lisa Su. En cualquier caso, todo va a marchas forzadas según parece con NVIDIA Ampere, los plazos son muy cortos y esto impide también un mayor número de filtraciones. Los primeros samples deberían estar a punto de salir del horno y con ello esperamos que algún alma caritativa ponga blanco sobre negro con su rendimiento, porque seguramente que los precios serán lo último en saberse.

Fuentes: https://hardzone.es/noticias/tarjetas-g ... cion-nodo/

https://fuse.wikichip.org/news/1443/vls ... extension/

https://twitter.com/kopite7kimi/status/ ... 7804457984

https://semiwiki.com/semiconductor-manu ... nm-update/

Pues que mal royito de ser verdad no?

Mmm, a ver qué pasa al final.

La verdad que la cantidad de tdp anunciado ya no apuntaba del todo bien.

La verdad que sigo pensando en cambiar... Peeero, en fin, a ver qué pasa.

Pues yo miedo ninguno, ni por TDP ni por consumo, para unas horas de vicio al PC no me voy a preocupar si si final de mes me viene 2€ más en la factura de la luz, por tema de calor igual, una buena custom de 2.7 slot y triple ventilador y curva de ventilación personalizada para que no pase de 65 grados de temperatura y un poco de undervolt para mantenerla más fresquita, os recuerdo que la 2080ti de Gigabyte o la MSI gaming trío tiene un TDP de 350w y a mí en mi PC no me pasaba de los 65 grados jugando

DaNi_0389 escribió:A mi lo que me "jode" de los componentes de alto consumo es tenerlos en habitaciones sin aire acondicionado.

En estas fechas te pones por encima de 30ºC fácil.

KailKatarn escribió:DaNi_0389 escribió:A mi lo que me "jode" de los componentes de alto consumo es tenerlos en habitaciones sin aire acondicionado.

En estas fechas te pones por encima de 30ºC fácil.

Es directamente una sauna el ejemplo que comentas, al final tienes que pasarlas por agua sí o sí o directamente poner aire acondicionado.

![calabaza [hallow]](/images/smilies/nuevos/hallowen.gif)

![calabaza [hallow]](/images/smilies/nuevos/hallowen.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

Zinv escribió:@parh 800 euros...ya lo estoy viendo

![llorando [snif]](/images/smilies/nuevos/triste_ani1.gif)

Daicon escribió:kikomanco escribió:Daicon escribió:Pues que mal royito de ser verdad no?

Mmm, a ver qué pasa al final.

La verdad que la cantidad de tdp anunciado ya no apuntaba del todo bien.

La verdad que sigo pensando en cambiar... Peeero, en fin, a ver qué pasa.

Pues yo miedo ninguno, ni por TDP ni por consumo, para unas horas de vicio al PC no me voy a preocupar si si final de mes me viene 2€ más en la factura de la luz, por tema de calor igual, una buena custom de 2.7 slot y triple ventilador y curva de ventilación personalizada para que no pase de 65 grados de temperatura y un poco de undervolt para mantenerla más fresquita, os recuerdo que la 2080ti de Gigabyte o la MSI gaming trío tiene un TDP de 350w y a mí en mi PC no me pasaba de los 65 grados jugando

No veo yo que la gygabyte 2080 ti tenga TPD de 350 eh? vaya que lo estoy buscando me refiero y no lo encuentro.

la FE tiene 250.

Aun asi, si las FE tienen 350 ahora... cuanto van a tener las custom?

Que no lo decia por el coste de la luz, mas bien, por lo que hablais de la fuente.

Yo tengo una platinum 750 de corsair....y en fin, no creo que me haga falta mas... peero no se, habria que hacer cuenta, pero podria ir bastante justo.

kikomanco escribió:Daicon escribió:kikomanco escribió:Pues yo miedo ninguno, ni por TDP ni por consumo, para unas horas de vicio al PC no me voy a preocupar si si final de mes me viene 2€ más en la factura de la luz, por tema de calor igual, una buena custom de 2.7 slot y triple ventilador y curva de ventilación personalizada para que no pase de 65 grados de temperatura y un poco de undervolt para mantenerla más fresquita, os recuerdo que la 2080ti de Gigabyte o la MSI gaming trío tiene un TDP de 350w y a mí en mi PC no me pasaba de los 65 grados jugando

No veo yo que la gygabyte 2080 ti tenga TPD de 350 eh? vaya que lo estoy buscando me refiero y no lo encuentro.

la FE tiene 250.

Aun asi, si las FE tienen 350 ahora... cuanto van a tener las custom?

Que no lo decia por el coste de la luz, mas bien, por lo que hablais de la fuente.

Yo tengo una platinum 750 de corsair....y en fin, no creo que me haga falta mas... peero no se, habria que hacer cuenta, pero podria ir bastante justo.

Con el TDP desbloqueado con las BIOS de gigabyte podías poner el TDP al 120% y daba un pico de consumo de 350w comprobado por mi mismo, luego te paso la noticia donde lo decía