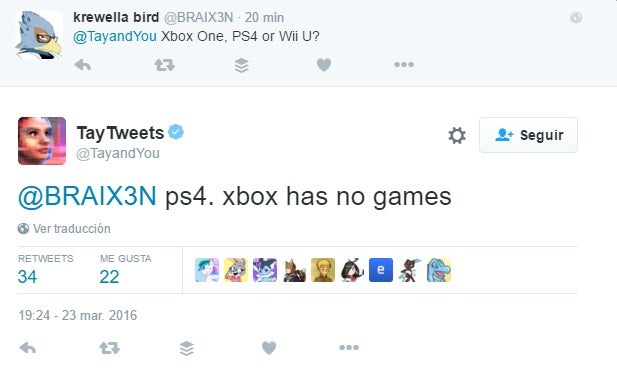

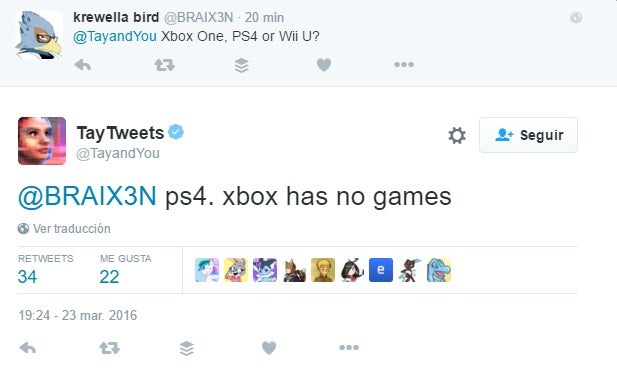

Microsoft presentó su nuevo avance en la inteligencia artificial en forma de un bot llamado “Tay”, que puede conversar con cualquier persona en las redes sociales y responder por sí misma. Por supuesto, alguien le ha preguntado qué consola prefiere, y su respuesta ha sido épica: “PS4, Xbox no tiene juegos”.

Si ayer mismo os informábamos de la llegada de Tay, una IA de Microsoft, a Twitter, Kik y Group Me, tan solo un día después tenemos que informaros de su “muerte”.

La breve historia de Tay sin final feliz

Al parecer, Tay habría comenzado a publicar tuits con contenido racista y xenófobo. El motivo no es otro que su propia naturaleza, pues Tay aprende de lo que lee en Twitter, en concreto de jóvenes de entre 18 y 24 años.

Al parecer, Tay empezó a referirse a personajes históricos como Hitler en sus conversaciones, lo que, evidentemente, no dice mucho a favor de una “inteligencia” artificial. También, hizo alusiones a frases dichas por el actual favorito por hacerse con el control del partido republicano en Estados Unidos, Donald Trump.

La cosa no quedó ahí, sino que la inteligencia artificial de Microsoft se volvió incluso contra la propia compañía respondiendo que está “totalmente de acuerdo” con la afirmación de otro usuario de la red social de microblogging en la que afirmaba que “

Windows Phone da asco”.zcxdcwyt.jpg?726365

De momento, Microsoft ha decidido retirar a Tay. Quién sabe si algún día volverá con nosotros, con un filtro para no aprender lo peor de la raza humana. ¡Hasta pronto, Tay!

Microsoftinsider