Elelegido escribió:Yo uso para trabajar un monitor de 24" a 4k, y soy programador. Lo llevo a 250%, y listo. Para los aplicaciones que llevan mal el tema del High-DPI, se puede cambiar la pestaña de Compatibilidad para que el re escalado te lo haga Windows.

Edy escribió:Elelegido escribió:Yo uso para trabajar un monitor de 24" a 4k, y soy programador. Lo llevo a 250%, y listo. Para los aplicaciones que llevan mal el tema del High-DPI, se puede cambiar la pestaña de Compatibilidad para que el re escalado te lo haga Windows.

Iba a postear explicando los post anteriores, pero menos mal que alguien de mi sector ha contestado ... ahorrandome el trabajo. Y si, tiene mucho que ver que hablemos de monitores o de TVs ... no entender esto, ya es delicado ...

dragonslayer escribió:Sino recuerdo mal el ojo humano tiene 570 megapixeles.

Haced cuentas y lo k keda de marketing

hi-ban escribió:

Y el tema de 4k en una pantalla hoy en dia a mi me parece una autentica gilipollez.

"No, es que juego a juegos en 4k"... ¿para qué? ¿para que se noten mas los polígonos, veas borrosas las texturas y ademas el juego te vaya mas lento poque hay que renderizar 8 veces mas píxeles?

Pues menuda estupidez. En mi opinión, hoy en dia no hace falta más de 1080p para casi nada. Es mas, algunos juegos lucen mejor a resoluciones mas bajas. En el momento que en un juego "canta" el polígono o la textura se ve borrosa, entonces es que te has pasado de resolución.

GodOfKratos escribió:hi-ban escribió:

Y el tema de 4k en una pantalla hoy en dia a mi me parece una autentica gilipollez.

"No, es que juego a juegos en 4k"... ¿para qué? ¿para que se noten mas los polígonos, veas borrosas las texturas y ademas el juego te vaya mas lento poque hay que renderizar 8 veces mas píxeles?

Pues menuda estupidez. En mi opinión, hoy en dia no hace falta más de 1080p para casi nada. Es mas, algunos juegos lucen mejor a resoluciones mas bajas. En el momento que en un juego "canta" el polígono o la textura se ve borrosa, entonces es que te has pasado de resolución.

Al contrario, los juegos antiguos a resoluciones altas mejoran una barbaridad. Un juego de PS2, GC o Wii lo pones a 4k o 1440p y mejoran una barbaridad. Todo lo que sea ganar nitidez es bueno, se llegan a apreciar detalles imposibles de apreciar en la resolución original. De hecho, ni necesitas una pantalla 4K, aún teniendo una pantalla 1080p se nota la diferencia al renderizar a 4K.

dark_hunter escribió:GodOfKratos escribió:hi-ban escribió:

Y el tema de 4k en una pantalla hoy en dia a mi me parece una autentica gilipollez.

"No, es que juego a juegos en 4k"... ¿para qué? ¿para que se noten mas los polígonos, veas borrosas las texturas y ademas el juego te vaya mas lento poque hay que renderizar 8 veces mas píxeles?

Pues menuda estupidez. En mi opinión, hoy en dia no hace falta más de 1080p para casi nada. Es mas, algunos juegos lucen mejor a resoluciones mas bajas. En el momento que en un juego "canta" el polígono o la textura se ve borrosa, entonces es que te has pasado de resolución.

Al contrario, los juegos antiguos a resoluciones altas mejoran una barbaridad. Un juego de PS2, GC o Wii lo pones a 4k o 1440p y mejoran una barbaridad. Todo lo que sea ganar nitidez es bueno, se llegan a apreciar detalles imposibles de apreciar en la resolución original. De hecho, ni necesitas una pantalla 4K, aún teniendo una pantalla 1080p se nota la diferencia al renderizar a 4K.

Pues yo cuando he puesto consolas antiguas en televisiones modernas me han sangrado los ojos de los bordes de sierra. En la tele de tubo se disimulan mejor.

Cosa distinta es si se usa un emulador que permita renderizar a más resolución de la nativa.

si pones los juegos a 4k en el emulador quitas los bordes de sierra.

si pones los juegos a 4k en el emulador quitas los bordes de sierra. GodOfKratos escribió:dark_hunter escribió:GodOfKratos escribió:Al contrario, los juegos antiguos a resoluciones altas mejoran una barbaridad. Un juego de PS2, GC o Wii lo pones a 4k o 1440p y mejoran una barbaridad. Todo lo que sea ganar nitidez es bueno, se llegan a apreciar detalles imposibles de apreciar en la resolución original. De hecho, ni necesitas una pantalla 4K, aún teniendo una pantalla 1080p se nota la diferencia al renderizar a 4K.

Pues yo cuando he puesto consolas antiguas en televisiones modernas me han sangrado los ojos de los bordes de sierra. En la tele de tubo se disimulan mejor.

Cosa distinta es si se usa un emulador que permita renderizar a más resolución de la nativa.

Claro, yo hablo de emuladorsi pones los juegos a 4k en el emulador quitas los bordes de sierra.

hi-ban escribió:GodOfKratos escribió:dark_hunter escribió:Pues yo cuando he puesto consolas antiguas en televisiones modernas me han sangrado los ojos de los bordes de sierra. En la tele de tubo se disimulan mejor.

Cosa distinta es si se usa un emulador que permita renderizar a más resolución de la nativa.

Claro, yo hablo de emuladorsi pones los juegos a 4k en el emulador quitas los bordes de sierra.

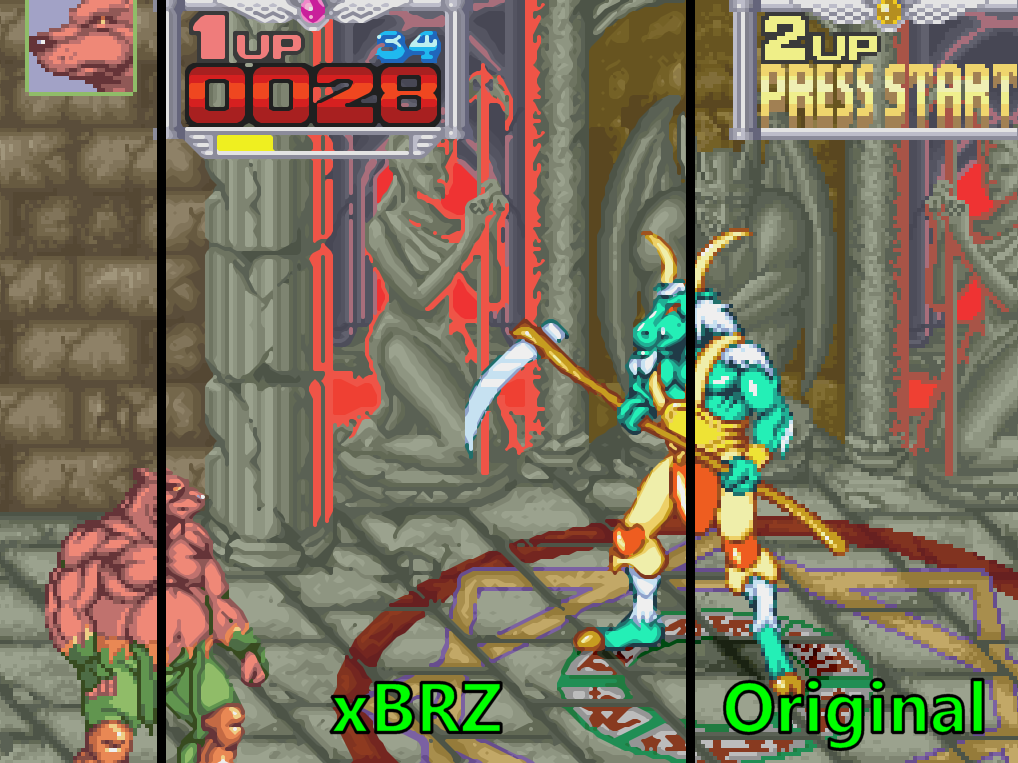

Para quitar los "bordes de sierra" en juegos 2D necesitas aplicar filtros que "emborronen" la imagen y simulen, por ejemplo, una pantalla CRT con sus scanlines, etc. Filtros, por cierto, que consumen a su vez más recursos del sistema, disminuyendo el rendimiento y aumentando el gasto de batería. Para hacer lo mismo en juegos 3D necesitas aplicar antialiasing, que también consume bastantes recursos (y el consumo aumenta cuanto mayor sea la resolucion).

Los filtros están muy bien si tu dispositivo va enchufado a la corriente y por tanto tiene una autonomía infinita. Pero si el dispositivo es portátil y por tanto usa batería, reducir el consumo de recursos para ganar en autonomía es más importante. De nada me sirve una consola portátil para jugar en 4K con shaders que emulan una pantalla CRT si en 2 horas se me ha gastado la batería. Mucho mas importante es tener 8 horas de autonomía, aunque la resolución a la que juegues sea la "nativa".

Elelegido escribió:Yo uso para trabajar un monitor de 24" a 4k, y soy programador. Lo llevo a 250%, y listo. Para los aplicaciones que llevan mal el tema del High-DPI, se puede cambiar la pestaña de Compatibilidad para que el re escalado te lo haga Windows.

![mas potas [buaaj]](/images/smilies/nuevos2/vomitivo.gif) , sin embargo con un crt se ve bien cualquier resolución que pongas.... el problema son los 16:9 prácticamente estandarizados en los juegos actuales que o te comes bandas negras o lo ves estirado (yo lo veo estirado y no me molesta, pero entiendo que a la gente no le guste) , pero para emular ps2, wii. dreamcast a resolución nativa y con el consiguiente ahorro de recursos y muchos juegos de pc como street fighter 4, sonic mania, muchos indies.... crt 31khz es la clave... diria mas, para contenido 4:3 jamás habrá nada mejor que un monitor crt

, sin embargo con un crt se ve bien cualquier resolución que pongas.... el problema son los 16:9 prácticamente estandarizados en los juegos actuales que o te comes bandas negras o lo ves estirado (yo lo veo estirado y no me molesta, pero entiendo que a la gente no le guste) , pero para emular ps2, wii. dreamcast a resolución nativa y con el consiguiente ahorro de recursos y muchos juegos de pc como street fighter 4, sonic mania, muchos indies.... crt 31khz es la clave... diria mas, para contenido 4:3 jamás habrá nada mejor que un monitor crt theelf escribió:Elelegido escribió:Yo uso para trabajar un monitor de 24" a 4k, y soy programador. Lo llevo a 250%, y listo. Para los aplicaciones que llevan mal el tema del High-DPI, se puede cambiar la pestaña de Compatibilidad para que el re escalado te lo haga Windows.

No es mas barato un 1080p y usar 100%... digo, si al final terminas escalando

Yo programo en un 1080p de 21" y no le veo razon de cambio, aunq un 21:9 2560x1080 me tienta para cuando cuesten 50e de seg mano

ElChabaldelPc escribió:4k en un movil solo sirve si lo acompañas de un casco de realidad virtual (que se te qurda el movil a menos de 4 cm de los ojos)

para todo lo demas pollagordeo

edit: @hi-ban, hay mas filtros que las scanlines (que odio a muerte)

magrosomohoso escribió:el tema de los dientes de sierra desaparece si usas un monitor crt vga de pc.... en un lcd o pones resolución nativa o lo ves tremendamente guarro y borroso, y muchas veces con la resolución nativa lo ves todo enano, sin embargo con un crt se ve bien cualquier resolución que pongas.... el problema son los 16:9 prácticamente estandarizados en los juegos actuales que o te comes bandas negras o lo ves estirado (yo lo veo estirado y no me molesta, pero entiendo que a la gente no le guste) , pero para emular ps2, wii. dreamcast a resolución nativa y con el consiguiente ahorro de recursos y muchos juegos de pc como street fighter 4, sonic mania, muchos indies.... crt 31khz es la clave... diria mas, para contenido 4:3 jamás habrá nada mejor que un monitor crt

hi-ban escribió:ElChabaldelPc escribió:4k en un movil solo sirve si lo acompañas de un casco de realidad virtual (que se te qurda el movil a menos de 4 cm de los ojos)

para todo lo demas pollagordeo

edit: @hi-ban, hay mas filtros que las scanlines (que odio a muerte)

Los filtros tipo 2xSaI/hq2x/SuperEagle son horrorosos. Si usas eso eres un hereje y no tienes perdón de dios.