Pollonidas escribió:El tema es que precisamente la ventaja de tener una capturadora por hardware es tener un chip que se ocupe de la captura (valga la redundancia) para que el impacto en el rendimiento del ordenador (o del dispositivo que estés capturando) sea 0. No muy bajo, sino 0 (salvando lo que tenga que hacer el procesador para "hablar" con la capturadora y escribirlo a disco, pero vaya, que a un nivel profesional de eso se ocupa otro PC entero diferente al que se usa para jugar, para que el impacto sea nulo de verdad)

Que yo sepa la mayoría de capturadoras no privan de rendimiento cero, como bien dices se suele utilizar otro ordenador dedicado únicamente a llevar el streaming, eso en caso de personas profesionales, porque realmente para hacer un streaming del fortnite a 1080p por twitch, aunque seas el más famoso de la plataforma, si tienes una 3090 o una 3080 vas más que sobrado, yo mismo he hecho streamings en 4K con una 970 a 30 fps ejecutando algunos juegos en 4K, aunque confieso que eso ya era llevarla a su límite, con una 3060ti he hecho streamings en 4K de RDR2 e incluso con cámara al vez. Eso de usar dos PC's es más por el tema de capturar la imagen de la persona que por el propio juego, además que si usas el software de nvidia (NVIDIA BROADCAST) chupa bastante, por lo que usar un PC únicamente para procesar señales de vídeo es una forma de garantizar ahorrarse algún problema que pueda surgir o pérdidas de rendimiento dependiendo de si vas a usar efectos o filtros sobre el vídeo que puedan consumir recursos, por ejemplo, nvidia broadcast tiene efectos de cancelación de ruido para el audio o de hacer un croma sin necesidad de croma borrando el fondo, además de seguimiento de la persona automático, le metes zoom y la imagen te sigue como si fuese una cámara moviéndose enfocando a la persona de forma automática, todo eso consume recursos y no pocos si vas a jugar a un juego exigente a una resolución alta con presets altos.

Aunque repito, con una 3080 o 3090, e incluso más tarjetas inferiores, deberías de poder hacer lo mismo sin mucho sacrificio, sin necesidad de un PC adicional, lo único que a menos potencia vas a tener que reducir efectos e historias.

Luego está el tema del audio, igual te interesa procesar el audio con compresores digitales de calidad, añadir puertas de ruido, etc... aunque también podrías comprarlos analógicos si te sobra la pasta, pero tampoco creo que sea necesario, pero si es cierto que hay mucha gente que usa daws de audio para procesar la voz con plugins porque OBS creo que no soporta VST3, por lo que eso también consumiría recursos, los plugins de audio consumen CPU. OBS también tiene sus propios compresores y efectos, incorporados, aunque no son ni de broma como unos desarrollados por una empresa que se dedica exclusivamente al desarrollo de plugins.

Creo que se ha discutido mucho el soporte de plugins VST3 en OBS.

Pero bueno, que para hacer un streaming normal de juego+cámara puedes hacerlo perfectamente con un hardware muy humilde, no necesitas ni una RTX.

Pollonidas escribió:Si se hace por GPU (o por software, que es perfectamente posible y con los procesadores actuales hay potencia de sobra) el tema es que siempre va a tener un impacto en el rendimiento, por pequeño que sea. Que para la mayoría de usuarios no es un problema, pero para streamers de cierto "tamaño" empieza a ser conveniente (y hasta necesario) no sacrificar nada de rendimiento y tener la máxima calidad posible.

¿Pero qué problema va representar un impacto en el rendimiento si tu objetivo es capturar una jodida consola externa o una cámara que es para eso la captura del purto in, si en ese momento vas a dedicar exclusivamente la GPU de NVIDIA o el procesador de la CPU para capturar un dispositivo externo? ¿Qué más te da que el rendimiento del ordenador se vea levemente perjudicado si el objetivo es precisamente ese? En ese momento estás destinando el ordenador únicamente a procesar señales de vídeo y a hacer streaming, no a ejecutar un juego, no entiendo ese razonamiento.

En ese momento no te vas a meter a jugar en el PC porque vas a estar jugando en la consola capturando con el PC, no tiene sentido eso de perder rendimiento, te da igual perder rendimiento porque al solo estar haciendo eso, y como mucho capturando la imagen de una cámara, vas más que sobrado, además de poder leer el chat de la plataforma en la que estés, añadir overlays al streaming, etc...

Pollonidas escribió:Puestos así, para capturar imagen del PC utilizando recursos de la GPU, se puede utilizar el encoder NVENC que mencionas en la salida de vídeo de la gráfica y es un efecto similar al que tendría una hipotética entrada de vídeo en la GPU como comentas pero sin tener que sacar la imagen para volverla a meter a la GPU (esto es justamente lo que hace cualquier software de streaming con la configuración por defecto). Claro que esto no sirve para capturar otros dispositivos,

Es que básicamente esto es lo que busco debatir con este por ¿Por qué no hay una entrada que permita utilizar ese encoder para capturar dispositivos externos? No lo que sucede dentro del PC.

Pollonidas escribió: pero vaya, para capturar del propio PC el efecto es justamente el que buscas con una capturadora (encodear vídeo con la máxima calidad posible y con muy poco impacto en el rendimiento) sin necesidad de hacer nada especial.

Me parece extraño que expliques todo esto para no entender que el objetivo de un input en el PC no es capturar el propio PC, es capturar god of war ragnarok, por ponerte un ejemplo, mientras haces un streaming desde el mismo PC con OBS con overlays, cámara, etc...

Pollonidas escribió:Sería bueno que los HDMI fueran bidireccionales desde luego, pero esto tiene un coste tanto de i+d como de implementación muy elevado, por eso no se hace. No es que las GPUs cuesten 1500€ y por eso deberían llevarlo, es que si llevaran algo similar tendrías que sumar a todo lo caro que cueste unos 300€ (a ojo) para algo que muy poca gente aprovecharía.

Lo que podría aumentar los costes aún, aunque tendríamos que ver cuanto, lo de que lo aprovecharían cuatro gatos ¿Y cuánta gente aprovecha los varios puertos de una tarjeta de gráfica? Y se meten puertos de salida a punta pala.

Me estás diciendo que la gente que tiene una GPU decente no va a tener la intención de capturar un juego de una consola como PS5? Además que el coste en el caso de NVIDIA sería ridículo, me refiero a poner un HDMI IN adicional, como para ir diciendo eso...

Pollonidas escribió:Algunos iMac viejos pueden funcionar como monitor, pero aunque es una buena cosa cara a minimizar residuos no deja de ser un "gimmick" para tener un monitor con peores prestaciones y más consumo que lo más barato de lo barato que puedas tener en cualquier tienda, y eso cuando se compró el aparato tuvo desde luego un coste que te repercuten como cliente.

Yo tengo un imac del 2007 y creo que no puede funcionar como monitor externo, supongo que te referirás a un eMac, mi iMAC tiene un display port para extender otra pantalla, la calidad de la pantalla es brutal, ojalá lo pudiera usar como pantalla externa de un PC más actual para no tener que comprar otro monitor, además que es precioso como diseño y tiene una pantalla enorme.

Pollonidas escribió:En conclusión... entiendo la queja, pero para la mayoría de los "mortales", cuesta mucho desarrollar algo así para aportar poco.

Yo creo que poco no aporta el tener un simple puerto in que te permita poder capturar dispositivos externos, pero bueno, y aún menos hoy en día que es más necesario que nunca con la revolución del streaming.

Pollonidas escribió:Desconocía el caso de la Xbox que comentas, en este caso probablemente haga el transcoding por software, con toda probabilidad. La otra probabilidad es que tenga un chip que se ocupe del transcoding para la entrada (el integrado como tal no es TAN caro), pero lo dudo para una cosa "auxiliar".

Ni idea de como funciona en xbox, lo único que se es que lo quitaron en series, lo pusieron creo que para la televisión digital que es bastante popular el uso en usa, la verdad que me parece un poco fumada, supongo que para no ocupar un HDMI adicional en la TV con el dispositivo.

calimar escribió: hace años que no estaban las famosas ati All-in-Wonder y las nvidia VIVO Video-in video-out

No tenía conocimiento de ese pasado borrado, aunque entiendo su desaparición, en ese momento capturar no era algo muy común, hablamos que cesaron en 2008, la revolución del streaming y de youtube se movió durante la década del 2010 al 2020, antes todo eso era campo, por lo que ahora hay más motivo que nunca para implementar esta feature, hablamos que esa tecnología no está desde hace 14 años según lo que he leído, y ha faltado justo en los años que ha hecho más falta que nunca, en 2008 para atrás la gente no iba compartiendo sus gameplays ni haciendo streaming jugando a juegos, ni teníamos la suerte de ver análisis comparativos de juegos capturados, etc...

De hecho acabo de mirar a mi vieja asus 9600gt y creo que tiene VIVO, para mi que sabiendo esto que acabas de decir me queda más que claro que se ha dado un paso de gigante para atrás.

https://en.wikipedia.org/wiki/Video-in_video-outhttps://en.wikipedia.org/wiki/All-in-Wonder

https://en.wikipedia.org/wiki/Video-in_video-outhttps://en.wikipedia.org/wiki/All-in-WonderAunque no, parece que el de la 9600gt es un TV out para conectar a la TV, no era entrada.

Además no encuentro ningún vídeo review de las capacidades de esta tecnología, que capacidades tenían como capturadoras, resolución, framerate, etc... Es como si la tecnología hubiera pasado sin pena ni gloria, lo cual entiendo perfectamente en ese momento, un uso interesante en esa época hubiera sido digitalizar vídeos en cinta, capturar programas de TV, etc...

Some practical uses of VIVO include being able to display multimedia stored on a computer on a TV, and being able to connect a DVD player or video game console to a computer while continuing to allow viewing via a TV monitor. VIVO itself, however, can not decode broadcast signals from any source, and so, like HDTV sets without tuners and composite monitors, additional equipment is required to be able to show broadcast TV programs.

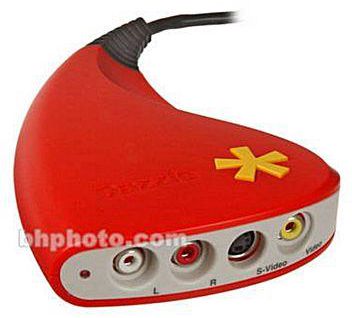

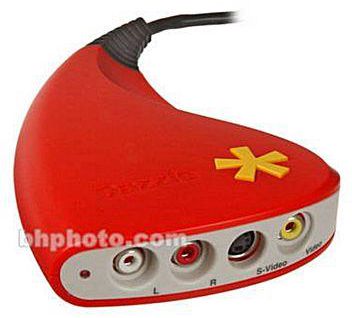

Some manufacturers enable their version of the VIVO port to also transfer sound.Yo recuerdo que por esa época, entre 2009-2010 me pillé esta pinnacle dazzle para capturar vídeo de una cámara