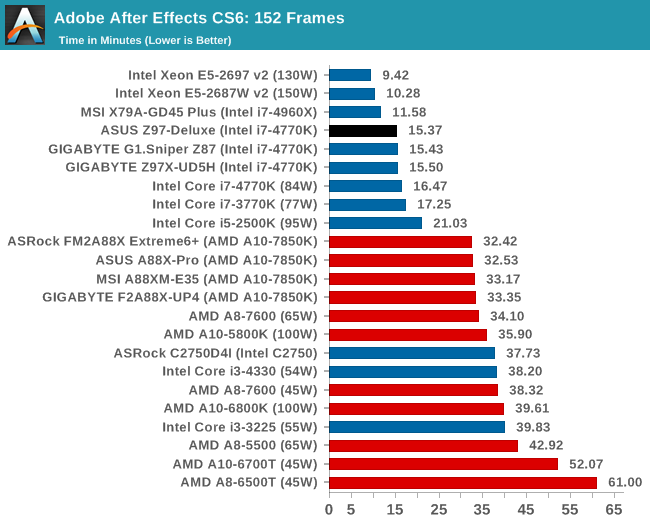

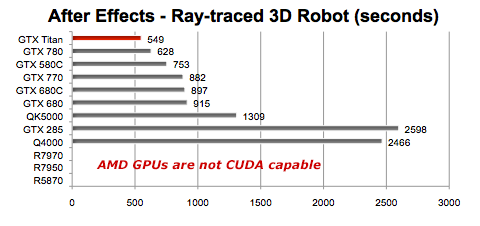

"IMPORTANTE: En general, After Effects no necesita las funciones CUDA de un conjunto específico de GPU de Nvidia. Solo las necesita el procesador 3D con trazo de rayo y aceleración de GPU. Las otras funciones de la GPU funcionan en cualquier GPU que cumpla ciertos requisitos básicos, incluidas las GPU de AMD y de Intel. Siga leyendo para ver más funciones."

yo trabajo mucho importando secuencias de imágenes PNG numeradas, pues eso no es capaz de reproducirlodurante la edición. En mi portátil viejo las reproducía en tiempo real en el premiere muy suavemente, como si se tratase de un archivo de vídeo

pero desde premiere CS5, eso no lo hace nada bien

se traba, y además tarda en responder (se continúa oyendo la pista de audio, pero la imágen se queda desde los primeros fotogramas congelada, y al detener tarda unos 5 seg en responder)

en todo caso, en edición de vídeo son más cosas. Va cojonudo, hasta q superpones 2 ó más capas, o le añades algunos efectos (efectos, eso sí, q suelen consumir muchos recursos, de programas terceros

Scylla escribió:Buenas a todos,

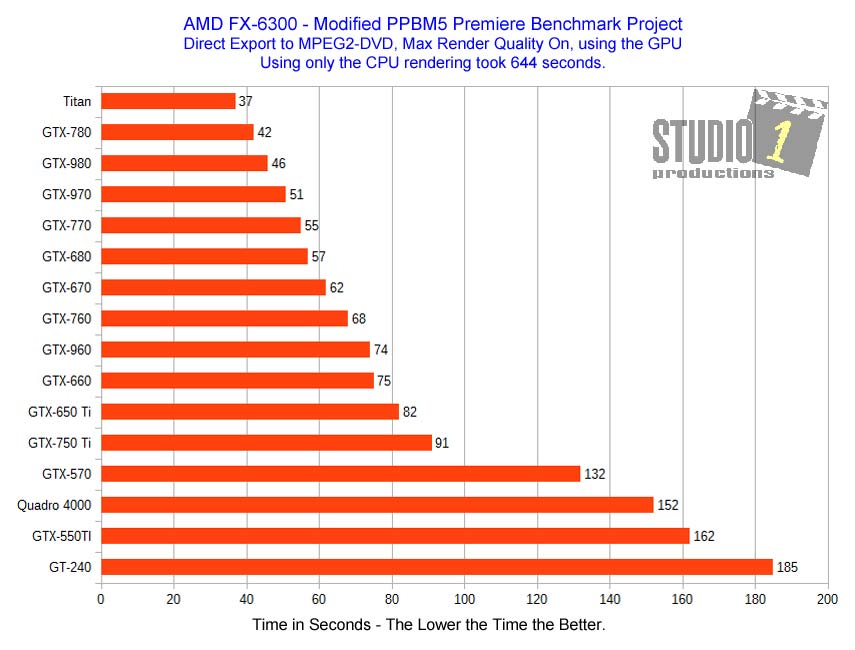

Un compañero diseñador me ha pedido ayuda. Tiene problemas con el After Effects y el Premiere, asegurando que al meter efectos y capas la cosa se le ralentiza mucho. Funciona, en líneas generales, bien pero cuando le mete caña le demora mucho a su trabajo. A mí en realidad me escribió pensando que le hacía falta más gráfica: toda la vida mi entendimiento ha sido que en editar imágenes estáticas y vídeo la tarjeta gráfica como tal no afecta casi nada o apenas, sobre todo en renderizar efectos, por más que haya plugins que admitan procesamiento CUDA y demás. Este hombre es un profesional, vive de ello, pero toca muchos palos: hace sobre todo 2D para lo que le va

Donde sí tenía entendido que las Quadro brillaban era en proceso de vídeo y modelado 3D muy tocho, mostrar wireframes, y que además de que los drivers están certificados y si uno se compra la placa que dice el fabricante, la gráfica y los drivers del fabricante y todo como lo dice el fabricante el software sencillamente tiene que funcionar.

Adobe indica lo siguiente para After Effects, CUDA y la aceleración gráfica:"IMPORTANTE: En general, After Effects no necesita las funciones CUDA de un conjunto específico de GPU de Nvidia. Solo las necesita el procesador 3D con trazo de rayo y aceleración de GPU. Las otras funciones de la GPU funcionan en cualquier GPU que cumpla ciertos requisitos básicos, incluidas las GPU de AMD y de Intel. Siga leyendo para ver más funciones."

Entonces, mis preguntas son dos: profesionales del vídeo y la imagen, ¿merecen la pena las Quadro para Adobe Premiere, After Affects y 3D Studio? Y más concretamente, ¿qué le faltaría a este muchacho para que fuera más fluido el render y los efectos del After Effects.

Especificaciones del equipo:

- Intel Core i7 3770

- 16 GB memoria DDR3

- Quadro 2000

- SSD Samsung 840 256 GB

- varios TB de HDD mecánicos

Programas que usa y que renquean:

- Adobe Premiere CS6

- After Effects CS6

- DaVinci Resolve 12

También usa estos que curiosamente no nota que petardeen:

- ZBrush R4.7

- 3D Max 2012

- 3D Max 2015

Scylla escribió:

yo trabajo mucho importando secuencias de imágenes PNG numeradas, pues eso no es capaz de reproducirlodurante la edición. En mi portátil viejo las reproducía en tiempo real en el premiere muy suavemente, como si se tratase de un archivo de vídeo

pero desde premiere CS5, eso no lo hace nada bien

se traba, y además tarda en responder (se continúa oyendo la pista de audio, pero la imágen se queda desde los primeros fotogramas congelada, y al detener tarda unos 5 seg en responder)

en todo caso, en edición de vídeo son más cosas. Va cojonudo, hasta q superpones 2 ó más capas, o le añades algunos efectos (efectos, eso sí, q suelen consumir muchos recursos, de programas terceros

TRASTARO escribió:Scylla escribió:

yo trabajo mucho importando secuencias de imágenes PNG numeradas, pues eso no es capaz de reproducirlodurante la edición. En mi portátil viejo las reproducía en tiempo real en el premiere muy suavemente, como si se tratase de un archivo de vídeo

pero desde premiere CS5, eso no lo hace nada bien

se traba, y además tarda en responder (se continúa oyendo la pista de audio, pero la imágen se queda desde los primeros fotogramas congelada, y al detener tarda unos 5 seg en responder)

en todo caso, en edición de vídeo son más cosas. Va cojonudo, hasta q superpones 2 ó más capas, o le añades algunos efectos (efectos, eso sí, q suelen consumir muchos recursos, de programas terceros

Entonces ¿quiere o no quiere ayuda?

Scylla escribió:Eso no importa: lo quiero saber yo.

Vamos a probar a meterle una GeForce GTX 970 y ver si mejora en algo el asunto.

owenfran escribió:Por no abrir un hilo: ¿y para uso exclusivo de edición fotográfica con photoshop y algo de illustrator, cual recomendais? ¿una geforce tocha?

owenfran escribió:Por no abrir un hilo: ¿y para uso exclusivo de edición fotográfica con photoshop y algo de illustrator, cual recomendais? ¿una geforce tocha?

maxpower91 escribió:owenfran escribió:Por no abrir un hilo: ¿y para uso exclusivo de edición fotográfica con photoshop y algo de illustrator, cual recomendais? ¿una geforce tocha?

De no utilizar una Quadro o FirePro, te recomiendo una Radeon. En fotografía es muy importante la calibración del monitor, y las GeForce suelen dar problemas de Banding al tener solo 8-bits para sus tablas LUT (donde, digamos, se guardan los ajuste de calibrado). Las Radeon tienen 10-bits (creo que actualmente 12-bits), y eso mitiga el problema.

También es cierto que quien se dedica a ello profesionalmente suele tener un monitor con calibración interna (las tablas LUT se guardan en éste y no en la GPU), de modo que no tiene problemas de Banding aunque tenga una GeForce.

Eso si, de tener un monitor tan bueno, lo recomendable es que le acompañen una Quadro o una FirePro, ya que son las únicas capaces de ofrecer 10-bits por canal en profundidad de color.

Resumiendo, si tienes un monitor profesional, Quadro o FirePro para aprovecharlo sí o sí. Si solo vas a dedicarlo a fotografía, aunque tengas un monitor sencillo, también son recomendables.

Pero si por alguna razón tiene que ser una gráfica para juegos, mejor que sea una Radeon.

Buba-ho-tep escribió:Me interesa mucho este tema y ya he abierto dos hilos donde he sido completamente ignorado.

Yo quiero montarme una estación de trabajo orientada a Maya (odio el 3ds Max y no tiene la mitad de cosas que Maya sí), Realflow y After Effects.

Estoy pensando ponerme una 1070 o 1080 pero quizás esté malgastando la pasta porque no voy a notar diferencia con respecto a una 970 o 980. No voy a jugar a nada. Lo digo porque siempre surgen los comentarios de ese tipo. Quiero rapidez en los previos al cambiar la iluminación de la escena, las texturas y las animaciones. También que renderice en tiempo record.

Yo vengo de Apple y no me pensaba que iba a ser tan complicado decidirse

Leopold escribió:maxpower91 escribió:owenfran escribió:Por no abrir un hilo: ¿y para uso exclusivo de edición fotográfica con photoshop y algo de illustrator, cual recomendais? ¿una geforce tocha?

De no utilizar una Quadro o FirePro, te recomiendo una Radeon. En fotografía es muy importante la calibración del monitor, y las GeForce suelen dar problemas de Banding al tener solo 8-bits para sus tablas LUT (donde, digamos, se guardan los ajuste de calibrado). Las Radeon tienen 10-bits (creo que actualmente 12-bits), y eso mitiga el problema.

También es cierto que quien se dedica a ello profesionalmente suele tener un monitor con calibración interna (las tablas LUT se guardan en éste y no en la GPU), de modo que no tiene problemas de Banding aunque tenga una GeForce.

Eso si, de tener un monitor tan bueno, lo recomendable es que le acompañen una Quadro o una FirePro, ya que son las únicas capaces de ofrecer 10-bits por canal en profundidad de color.

Resumiendo, si tienes un monitor profesional, Quadro o FirePro para aprovecharlo sí o sí. Si solo vas a dedicarlo a fotografía, aunque tengas un monitor sencillo, también son recomendables.

Pero si por alguna razón tiene que ser una gráfica para juegos, mejor que sea una Radeon.

Las Radeon tienen 10 bits de salida actualmente y la Geforce en Linux desde 2012 puedes habilitar los 10 bits de salida, de todas formas la nueva serie de nvidia 1080/1070 ya tienen soporte para 10 y 12 bits de color. Las Quadro tienen ciertas compatibilidades con el video profesional como soportar las conexiones SDI.

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif) .

.De hecho nunca he sabido con exactitud el tamaño de las LUTs de la GTX 980, y quizas hasta tengan 10 bits. Es un infierno encontrar datos del tema, pero en cuanto tenga un rato le pego un repaso.

Buba-ho-tep escribió:@xNezz Al final, después de darle tantas vueltas, me he pillado la Quadro m2000 viendo que ya empiezan a escasear.

Sí, me puedes llamar gilipollas. Lo voy a compensar con un i7 5820k y 32 gb de ram. Es que no voy a jugar a nada de nada y para emuladores creo que ya me iría bien.