@wwwendigoA ver, en I+D no siempre tener más pasta es igual a tener una clara "ventaja", es como casi en todo en esta vida, más que ser una relación linear entre inversión y recursos y resultados, es más una curva exponencial, la inversión devuelve rápido resultados en un inicio, pero tener "infinitos recursos" no quiere decir que se obtengan mejores resultados que una inversión moderada pero suficiente.

Ahí no estoy de acuerdo. Más pasta es justamente tener una clara ventaja. Otra cosa es que se aproveche o no, pero ventaja es: puedes permitirte arriesgarte más aunque palmes pasta, tener más equipos de investigación, desarrollar mejores tecnologías de integración (cosa que Intel hace), incluso fallar sin arriesgar la compañía.

La ventaja se nota hasta cierto punto, cuando se habla de empresas de cierto tamaño con unas inversiones fuertes en I+D, empiezan a decrecer los beneficios de la mayor potencia económica de algunas de las más grandes. Evidentemente existe la ventaja de mantener múltiples proyectos en paralelo, y temas así. Pero fue justo así como AMD consiguió superar a intel con Athlon, y el P4 demuestra que hay un punto de inversión en I+D que no evita meteduras de pata colosales.

No estamos hablando de unos aficionados, ambas empresas son MUY grandes, supongo que la conversación con el ingeniero de intel sería en la época del Athlon64, porque si es de ahora, estaría mostrando una amabilidad y bondad casi infinita con sus rivales...

Ambas empresas son efectivamente muy grandes, pero Intel es MUCHO más grande que AMD:

http://en.wikipedia.org/wiki/Intelhttp://en.wikipedia.org/wiki/Advanced_Micro_DevicesSegún Wikipedia, Intel tiene más de 10 veces más empleados que Intel y sus ganancias este año también han sido 10 veces mayores. Tú me dirás. En cuanto a lo del ingeniero de Intel, el AMA creo recordar que es éste:

http://www.reddit.com/r/IAmA/comments/1 ... _intel_ama Creo que te gustará leerlo, es bastante interesante. A lo que me refería era a esto:

How do you feel about AMD? (No really, let it out  )They have fantastic people. I cannot underscore this enough, with the resources they have the fact that they're able to compete in the same ballpark we do shows their quality. Sadly for all of us, execution is key. We want to see an exciting marketplace as much as you do.You mean something like selling all of your fabrication capacity is a bad idea?

)They have fantastic people. I cannot underscore this enough, with the resources they have the fact that they're able to compete in the same ballpark we do shows their quality. Sadly for all of us, execution is key. We want to see an exciting marketplace as much as you do.You mean something like selling all of your fabrication capacity is a bad idea?

Or do they have design issues now and are falling behind?AMD had to sell their fabs, otherwise they wouldn't be in business today. There are advantages to having fabs. You'll see many things, especially with Broadwell, that you cannot do without owning a fab.

The design issues we see today are things that happened a year, maybe a year-and-a-half, ago. But they were falling behind behind and it's hard to recover.

La conclusión a la que llego es que ese ingeniero de intel es realmente amable....

No creo que ningún ingeniero serio de intel diga que el diseño de Bulldozer es "fantástico", como esa gente de AMD a la que menciona el chico de intel, puede que a nivel teórico pueda interesar algún fleco de Bulldozer (como lo hacía del P4), pero en general es un disparate buscando "ganar" con frecuencias y número de cores, y hasta mal ejecutado en ese sentido (relación área de die por core integrado).

Yo no soy tan políticamente correcto hablando como el hombre éste.

Tienes ejemplos como el de ARM o de equipos para nada mayores a los de AMD en diseños de algunas arquitecturas RISC usadas en HPC o servidores/workstations haciendo cosas MUY interesantes. De hecho muchas "ideas" de las que se ven hoy en día en cpus x86 fueron recogidas de cpus diseñadas por empresas más pequeñas, y cpus que siguen siendo un referente en potencia.

AMD lo hizo medianamente bien con el K6 (y el K5 no era para nada un mal diseño, sin embargo tuvo problemas), no ninguna maravilla pero fue el primer diseño exitoso de verdad sin ser un clon de las arquitecturas intel (aunque gran parte del mérito provenga de nextgen), después ya vino Athlon que fue un éxito sin dudas (con gente de DEC que había trabajado en Alpha, de ahí ciertos paralelismos en buses y algún fleco más), empezó a crecer y ya con mucha más pasta que ahora y con unas inversiones excesivas en infraestructuras sacaron el Athlon64 que era otra vuelta de tuerca del éxito original de Athlon, un buen diseño continuista pero a la vez suficientemente innovador en puntos clave.

Y ahí se acaba la buena historia en AMD en diseños de cpus, a partir de ahí entre inversiones alocadas, en infraestructuras de producción excesivas, entre compras gigantescas como la de ATI, y un diseño ya no tan bueno, de hecho deficiente en la primera implementación (el Phenom original fue una gran cagada en frecuencias y sobre todo su ridículamente reducida L3, casi inútil, diseñada así de mínima por problemas de tamaño y coste de la die).

¿Tienes más info o web que de más detalles de la historia y de los diseños detallados (más que en Wikipedia) de esos procesadores? Porque estaría bastante interesante ver la evolución.

Buff, a ver que la mayoría de datos que tengo es de leer documentación o análisis "serios" de las arquitecturas a lo largo de muchos años, hay informaciones interesantes en realworldtech y arstechnica, aunque algunos de los mejores artículos están enterrados en versiones de los sites "antiguas", como la arspaedia de arstechnica, que es donde se ven unos análisis arquitectónicos bastante buenos de cpus ya antiguas (pero no mucho, depende de lo que se entienda por antiguo, yo la leía para cpus de 32 bits PowerPC, x86, etc, SPARC, tampoco se va tan lejos, vamos).

Básicamente el chollo se le acabó a AMD una vez intel se puso las pilas, y AMD además se dedicó a tropezar una y otra vez. Eso es mérito suyo, básicamente.

Sí, es un buen resumen.

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

Dicho esto, hay más mercado que el de alto rendimiento, claro. Y ya venden APUs que son una solución "conveniente" para equipos de gamas bajas o frugales, si el rendimiento no importa.

El problema es que en muchos de los escenarios en los que no importa el rendimiento sí importa el consumo, y ahí tampoco dominan.

Lo que básicamente digo de "posición incómoda" de AMD con estas cpus, es que su consumo no es maravilloso aunque sea más bajo (en APUs, da igual si basadas en Kaveri o en Jaguar, lo que sea) que otras cpus y hasta "medio decentemente" bajos, porque hay otras cpus x86 que consumen mucho menos (pero o algo más lentas o mucho más caras, intel ahí juega la baza de segmentar el mercado con los Atom y los Pentium ULV y similares)

Sería muy mala idea usar diseños como el de las APUs de consolas para PCs, más que nada porque en la parte de la cpu son diseños bastante incompetentes, cpus con un IPC inferior a bulldozer (sí, es posible) y baja frecuencia, que darían un rendimiento negligente en PC en cualquier cosa mínimamente pesada que se mueva.

¿Entiendo que los núcleos Jaguar de las consolas son más simples que los de las APUs Kaveri? Sé que los Jaguar eran los de bajo consumo, pero pensaba que las APU de escritorio tenían los mismos núcleos. El problema sigue siendo que para juegos, y mientras no se aprovechen los 8 procesadores (que es bastante más complicado), necesitas tener un buen IPC y una buena frecuencia, motivo por el cual 8 núcleos Jaguar a 1.6 GHz es un despropósito (y motivo por el cual, las anteriores consolas tenían procesadores PowerPC con buenas frecuencias a pesar de coste y consumo)

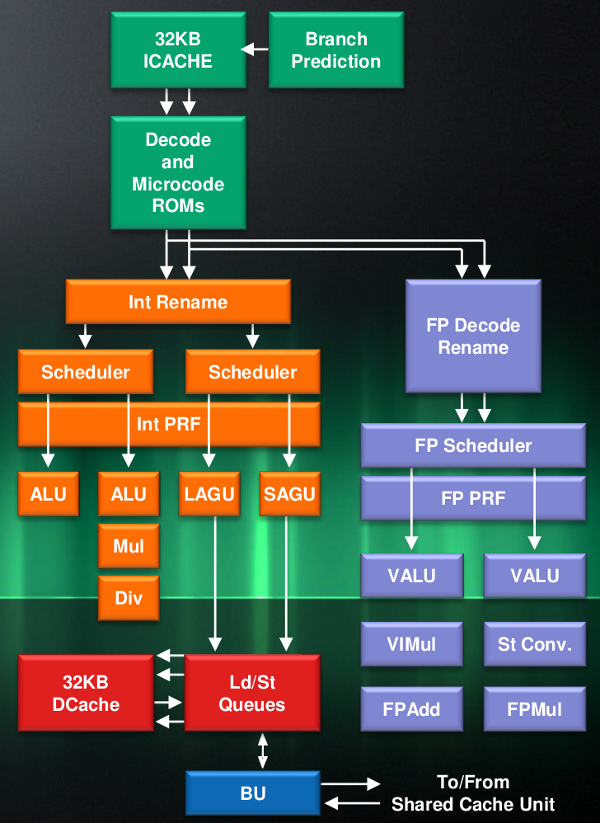

Sí, son más simples, son diseños de 2 vías fuera de orden más parecidos a las primeras cpus x86 fuera de orden que otra cosa. De hecho son MAS SIMPLES que el diseño básico de un P-Pro (que es de tres vías) o parecidos a un K6 en sus generalidades. Son más "modernas" y se les supone que tienen mejoras heredadas de cpus x86 más modernas, pero tampoco creo que sean muy muy distintas en rendimiento (IPC).

De la misma forma que Atom inicialmente era un diseño "cercano" al Pentium original en generalidades, que no literalmente, parece que fuera de parecidos en nivel macroscópico de funcionamiento, realmente es un diseño "nuevo", a diferencia de las cpus integradas en los diseños derivados de Larrabee (para lo que hoy se venden como Xeon Phi), que éste sí usaba como base arquitectónica los Pentium y los mejoraba y ampliaba para crear una solución muy compacta en transistores y con grandes capacidades computacionales.

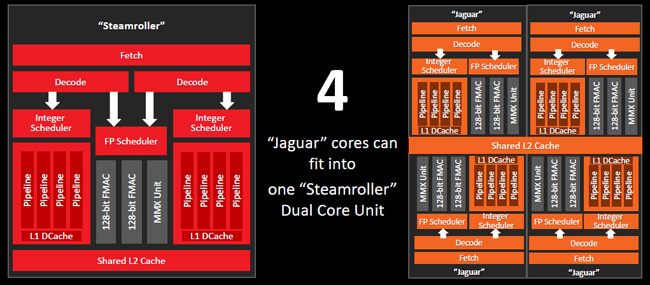

Sea como sea, esta cpu se parece a Bulldozer sólo en el "ancho efectivo" de la arquitectura, 2 vías bajo carga, porque los módulos de Bulldozer y derivados, hasta ahora, no han tenido nunca 4 decodificadores para uso particular, o 4 compartidos, o lo que parecen ser 2 por cada cpu como en las últimas iteraciones, por cierto mal documentadas y confusas en la documentación de AMD, que parece que no quiere dar una descripción EXACTA del funcionamiento de la etapa de decodificación de sus cpus, esta discusión y su posible interpretación ya la tuve yo con otra gente, y no llegamos a un acuerdo ni a una conclusión segura de lo que AMD decía en sus documentos exactamente al respecto, lo cual nos llevó a pensar que seguramente la peor opción era la real. O sea, realmente dos decodificadores exclusivos que pueden producir 4 instrucciones internas, y ahí entraría el juego de marear la perdiz dando a entender que son 4 decodificadores reales, cuando no sería así (además que no tendría sentido en un diseño como el derivado de Bulldozer, 3 decodificadores sí tendría sentido pero no tantos como 4, sin ampliar la etapa de ejecución).

Realmente la forma en que AMD está documentando sus cpus en los últimos tiempos es muy inferior a cómo lo hacía antes con cpus más "lustrosas", hasta han bajado la calidad e información útil de los pases de diapositivas enviados a prensa. Los diagramas son confusos y no descriptivos a diferencia de los que enviaban antes. Cada vez que veo una noticia "técnica" sobre arquitecturas de AMD que se van a lanzar, más claro me queda esto.

Es un espectáculo ver la falta de información clara en estos documentos a la hora de hablar de Puma-Jaguar o los bulldozer y prole. Tanto el material de prensa como documentación técnica son inferiores a la bastante mejor documentación de tiempos anteriores.

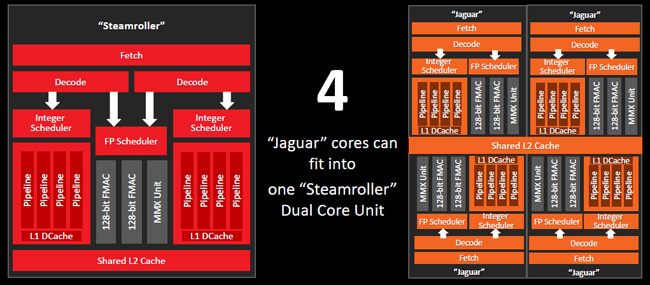

Sobre Jaguar, Puma, etc, coge a Bulldozer, quítale todo lo que tenga que ver con recursos compartidos, quitando toda unidad redundante relacionada con esa posibilidad, y deja el esqueleto del diseño básico, y tienes algo parecido a la línea de cpus Puma-bobcat-jaguar o como se llamen. Una de esas diapositivas poco informativas que ahora AMD ofrece a los sites técnicos puede ser descriptiva de lo que parece ser esta rama arquitectónica respecto a Bulldozer:

Extremadamente simple, pero muestra el "cameo" de que los Jaguar-Kabini podrían ser resultado de una simplificación y eliminación de los elementos compartidos en Bulldozer (pero con más potencial por core en cuanto a unidades de coma flotante, curiosamente). Una estructura de 2-4+2-2, que sería similar a la de Bulldozer bajo carga multihilo, un módulo de Bulldozer se puede considerar que es algo parecido a dos núcleos Jaguar unidos pero fusionando y añadiendo algún elemento (y perdiendo alguno por el camino).

Hay que entender que ambos esquemas no muestran el mismo nivel de detalle, y que es difícil encontrar buenos esquemas de Jaguar o Puma. Pero básicamente parece que fueran la "base" con la que se diseñó Bulldozer pero eliminando del todo de la ecuación la compartición de recursos. De hecho eso permite cierta mayor "robustez" en puntos concretos como la caché L1D o un mejor balance de coma flotante por core (en Bulldozer es "potente" si sólo la usa un único core del módulo, en concurrencia es peor que el diseño de Jaguar, a nivel de unidades de ejecución).

Es posible que la idea inicial sea "la misma", la de partida, simplificar el diseño heredado de Athlon de tres vías, y hacer una cpu equivalente a éste pero de dos vías, más estrecha, y en Bulldozer "magnificarla" a base de compartir recursos para "ofrecer el mismo rendimiento" que los últimos "athlones" (Phenom) pero con menos, y en la línea de Puma sería para reducir consumos sin las maniobras extrañas de Bulldozer. Si partimos un módulo "a la mitad" pasando los recursos compartidos a cada core, se empieza a parecer a Puma.

Bueno, con Jaguar el IPC tiene que ser peor, lo bueno es que no mucho peor (y en alguna condición concreta podría ser "mejor"), pero claro, cuando hablamos de cpus que se parecen lejanamente a Bulldozer, hay un problema, que su IPC de partida es muy bajo (peor que el de Phenom y diría que peor que el de Athlon64), y estamos hablando de cpus que al final funcionan a baja frecuencia, <2GHz. Eso si se consiguieran consumos tan bajos como los de Atom estaría bien, pero no se ha logrado. Sea por la razón que sea (podría ser por el proceso de fabricación puramente).

Resumiendo, AMD tiene un par de productos que venden en las cpus, ninguno es una estrella pero hacen algo de cuentas, el problema es que si quiere volver a x86 y a tener el respeto del mundo PC, va a tener que coger su Bulldozer y AM3, y hacer de una puta vez una plataforma digna.

El problema es que para eso hace falta tiempo y desarrollo, y las CPUs x86 ya no son tan golosas como las CPUs de bajo consumo, porque el mercado ya no tiende (tanto) a PCs de sobremesa, y por eso entre otras cosas Intel ha sacado los Core M. La competencia de Intel ya hace tiempo que no es AMD, sino ARM y derivados. El último salto gordo en rendimiento de Intel fue Sandy Bridge (2011). Sin embargo, si miramos el TDP sí que se ha ido reduciendo (y en portátiles ni te cuento). También está el hecho de que, al no tener el mismo rendimiento que Intel, tienen que bajar bastante el margen de beneficios para poder sacar productos competitivos, por lo que necesitan vender más para obtener ganancias, y al usar dies mayores debido a la tecnología de integración les cuesta más fabricarlos. En resumen, a mi entender AMDs está vendiendo chips con un coste de fabricación para ellos similar al de un i5/i7 por 100-150€ menos que Intel.

El coste de fabricación para AMD de sus AM3 creo que ha de ser de hecho superior al de intel para un i5 LGA 1150, sus cpus pasan de 300 mm2 mientras que las de intel para sobremesa no llegan ni a 200mm2. Ahí intel está ganando dinero a espuertas mientras AMD se conforma con "migajas", aún así, las cpus x86 se venden a buenos precios, mejores de lo que la gente se piensa. Que una cpu valga más de 100€ es en sí un precio relativamente alto, si la gente comparara con las tarjetas gráficas, vería que los precios manejados por gpu vendida al ensamblador de gráficas, teniendo en cuenta el tamaño de die, suele ser más ventajoso que el de una cpu AMD "al peso" de cada mm2 comprado.

Aún así, está muy lejos del rendimiento económico que intel le saca a vender una cpu de menos de 200mm2 por más de 300€. Una R9 290 lleva una gpu de 350 mm2 y completa, con memorias muy caras, PCB y demás, se vende por menos. Una GTX 970 con una gpu de 400 mm2 y más barata en lo demás excepto quizás memorias, pero también son costes añadidos, por 350€.

Básicamente intel se pone las botas con sus ventas. Eso sí, también vende por "menos de 200€" sus i5, que son básicamente la misma cpu, pero claro... sigue siendo un agravio comparativo. Una GTX 750 Ti monta una gpu de 150 mm2, básicamente equivlaente a las cpus intel, y memorias y otros extras por algo menos. Idem si miramos a gpus de AMD.

Las cpus x86 se venden relativamente caras, incluidas las AMD, pero aún así, intel con diferencia le saca un gran beneficio. Esta es la parte donde las ventas de x86 aunque sean bajas numéricamente comparando con otros semiconductores, son enormemente rentables. Si comparamos con un SoC ARM que te valga 10$, pues como que hace falta vender MUCHO más para lograr el mismo rendimiento. Y eso que son pequeñas en die, pero aún así, no tienen el mismo rendimiento de $/mm2.

No es una cuestión de que no tengan pelas, con menos en su momento diseñaron el Athlon original y fue un bombazo, dudo que el Athlon64 fuera diseñado con muchos más recursos de I+D, es una cuestión de tener algo de sensatez y de apartar a toda costa a la gente de marketing de la sección de I+D.

También estarás conmigo en que seguramente el Athlon original sea bastante menos complejo que lo que sea que estén diseñando ahora. La carrera de los MHz acabó, y mejorar el IPC es bastante más complicado.

No te creas, en lo macroscópico era más complejo que los Bulldozer.

Otro asunto es que haya una serie de mejoras que no van tan evidenciados en un diagrama de una cpu a nivel macroscópico, que cambien esta situación y aumenten la "complejidad".

Pero para te hagas una idea, desde el Athlon original hasta el Phenom II hay una línea evolutiva clarísima y que no se tocó ni un poco a nivel macroscópico, por muchas mejoras que se metieran, no se movió ni un poco ciertas partes del diseño.

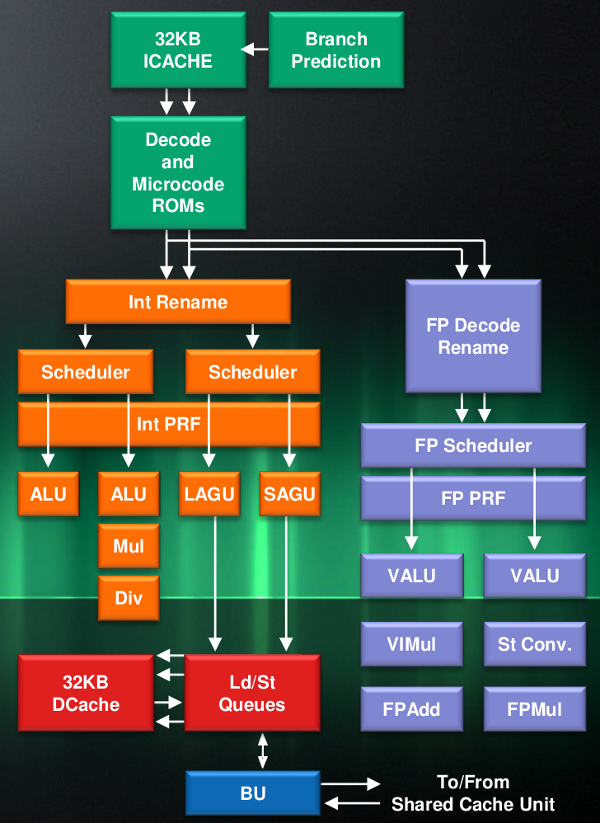

El Athlon original era una cpu que hacía la típica traducción de CISC a un RISC interno (como todas las cpus x86 modernas), y seguía un diseño de tres vías muy definido:

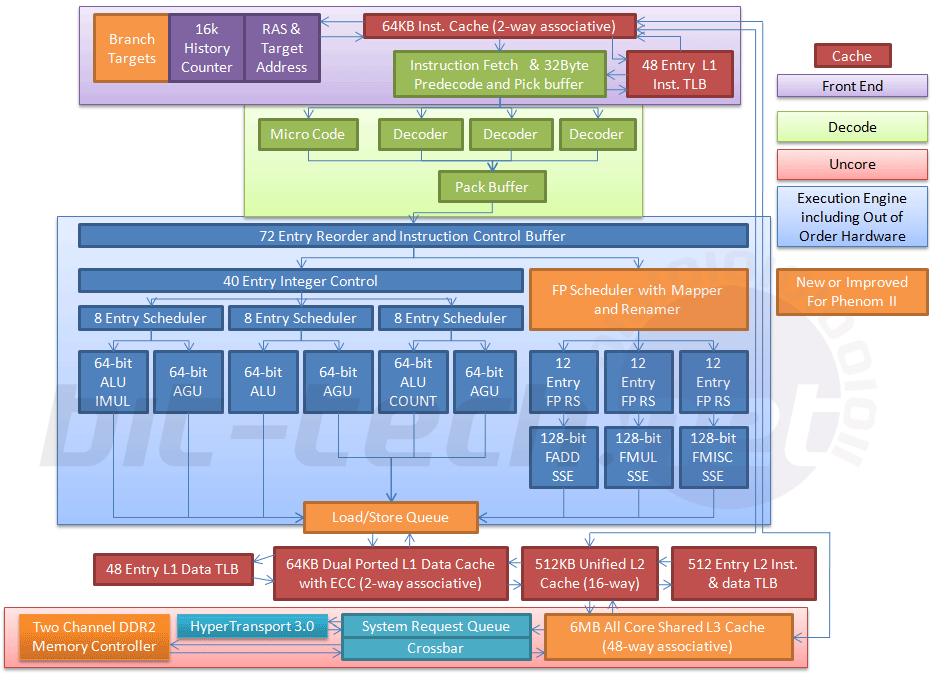

- 3 decoders, una ventana de instrucciones para reordenamiento, un scheduler común para unidades de enteros, y otro para la coma flotante, y una estructura de ejecución de 6 unidades de enteros (siempre 3 AGUs y 3 ALUs), y 3 unidades coma flotante. Esto se mantuvo estable y sin cambios en todas estas cpus, se podían incrementar el tamaño de las entradas de los schedulers, de la ventana de instrucciones, mejoras en la etapa de decodificación, etc, pero la parte general no se tocaba. Lo cual es llamativo dado que intel sí que tocó mucho más estos aspectos en su línea de cpus "core" basadas en el P-III.

Lo mejor es verlo en imágenes:

Athlon:

Athlon64:

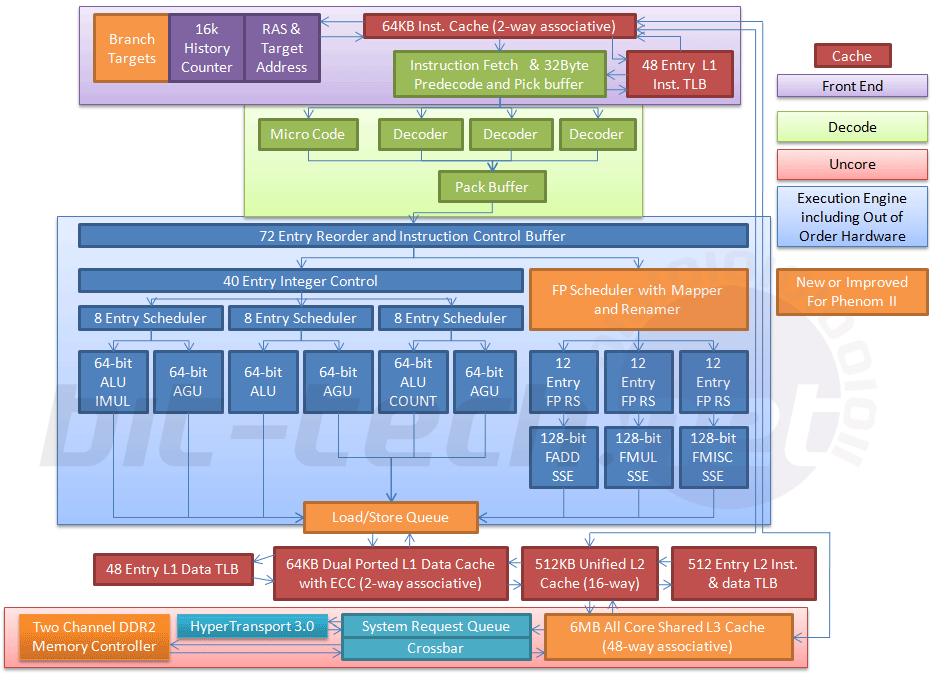

Phenom II:

La estructura general nunca cambió, nunca se agregaron más unidades de ejecución o cambios importantes en éstas, igual que el tema de decodificadores, etc. Se mejoró ampliando el set de instrucciones, integrando controlador de memoria, y mejorando detalles concretos de cada etapa, cachés, etc. Pero no cambiando nada del diseño "grande" de la cpu.

Las mayores diferencias que se observan tienen que ver más con cómo se han hecho los diagramas y qué nivel de detalle muestran en cada sección que a auténticas diferencias, por ejemplo puede parecer que hay una unidad extra de decodificación para "microcódigo" en Phenom, pero no es así, supongo que lo han puesto así para motrar una "vía alternativa" de decodificación que siempre ha sido más lenta, pero vamos, no existe una unidad paralela de decodificación para microcódigo. Y así algún detalle más suelto, hay diferencias, pero no en el esquema general, algunos cambios en cómo se gestionan algunos schedulers, y otras mejoras, pero no a nivel de la funcionalidad macroscópica. Es un diseño 3-(6+3)-3 (decode-exec-retire) desde el Athlon hasta el Phenom II.

))

))![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)

![facepalm [facepalm]](/images/smilies/facepalm.gif)

y soportar HSA pues mucho mejor. Lo que no acabo de ver son los 8MB de L3 cada 4 cores. Bulldozer, que yo sepa, tenía L3 compartida entre todos los cores. ¿Protocolo de coherencia y aumentar el memory gap? Apañados vamos entonces.

y soportar HSA pues mucho mejor. Lo que no acabo de ver son los 8MB de L3 cada 4 cores. Bulldozer, que yo sepa, tenía L3 compartida entre todos los cores. ¿Protocolo de coherencia y aumentar el memory gap? Apañados vamos entonces. y soportar HSA pues mucho mejor. Lo que no acabo de ver son los 8MB de L3 cada 4 cores. Bulldozer, que yo sepa, tenía L3 compartida entre todos los cores. ¿Protocolo de coherencia y aumentar el memory gap? Apañados vamos entonces.

, y posiblemente sea una cpu de servidor y sólo medio de rebote también para equipos de "alto rendimiento".

, y posiblemente sea una cpu de servidor y sólo medio de rebote también para equipos de "alto rendimiento".![disimulando [fiu]](/images/smilies/fiu.gif) )

)![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif) )

)

)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif) Dicho esto, hay más mercado que el de alto rendimiento, claro. Y ya venden APUs que son una solución "conveniente" para equipos de gamas bajas o frugales, si el rendimiento no importa.

Dicho esto, hay más mercado que el de alto rendimiento, claro. Y ya venden APUs que son una solución "conveniente" para equipos de gamas bajas o frugales, si el rendimiento no importa.