Perfect Ardamax escribió:@Zinclair

Te recomiendo que leas mejor

Esa gráfica que pones es (según la propia pagina que has puesto)...

Cito (otra vez)

Consumo.

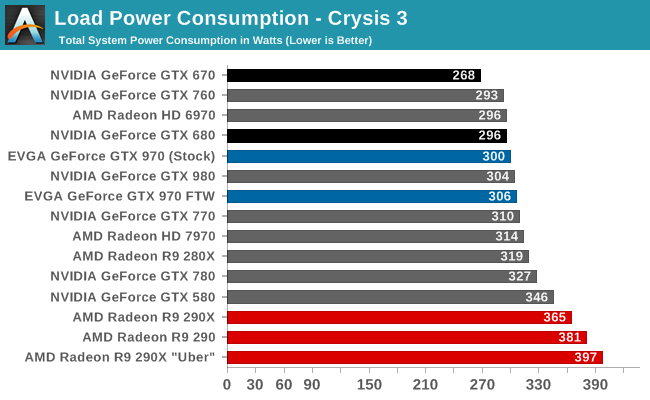

El dato de consumo se ha medido con un medidor de enchufe Efergy eSocket al que únicamente estaba enchufada la torre del ordenador. Es decir, que el dato de consumo es del sistema completo sin tener en cuenta el monitor, altavoces ni demás posibles aparatos. Por ello, también hemos querido incluir el dato de consumo máximo (Full LOAD), estresando además de la gráfica con Furmark el procesador con Prime95.

http://hardzone.es/msi-geforce-gtx-970-gaming-4g/

La MSI GEFORCE GTX 970 GAMING 4G como mucho bajo pruebas de Estrés llega a consumir 220W lo ha puesto @Beatwin

Y como bien dije yo bajo juegos (Condiciones normales) la MSI GEFORCE GTX 970 GAMING 4G puede tener picos de hasta 170W y lo normal es que el consumo normal de forma sostenida no sea mayor de 150W

Saludos

)

) Krain escribió:Dios mío, no he conocido otra gpu que haya recibido más cera que la GTX970

Xpartaco85 escribió:Leyendo la información que habéis puesto con mi fuenteAntec VPF 550 EC 550W 80 Plus Bronze- en teoría debería poder tirar con una 390X si tengo el amperaje suficiente?

Por que al final resulta que consumen prácticamente los mismo, luego muy mal debe estar diseñado el PCB para que haya tanta diferencia de temperatura entre un mismo sistema pero distinto CHIP de un ensamblador.

Xpartaco85 escribió:@KailKatarn Pues entonces si el consumo máximo de todo el equipo por ejemplo de la 290x ronda los 400W con esta de 550W aun tendría margen para la 390X que consume algo mas ?

cheewaca escribió:KailKatarn escribió:Krain escribió:Dios mío, no he conocido otra gpu que haya recibido más cera que la GTX970

La 290 recibió mucha más cera de largo. Que si trabajaba a 100º, que si rendían como el puto culo, que si drivers de mierda, bla bla bla bla. Ahora como está de moda ya nadie se acuerda pero ha sido la tarjeta más denostada de la historia.

Y a la fury le ha caído la misma mierda o más. En los foros americanos o ingleses hay muchas furys, pero muchas rulando, hasta el punto de quedarse sin stock. En España? ninguna, bueno ... un par a lo sumo.

La 390? que si refrito, drivers de mierda, tragona de W como loca, que si calentorra de la hostia, que si sus 8gb no los puede utilizar porque no tiene fuerza bruta para ello (ridículo leer eso y otras muchas cosas que se leen), etc ...

Vamos, a las gráficas de AMD les cae mierda como templos en los foros y sitios españoles como a ninguna otra.

Totalmente de acuerdo. Ademas he de añadir lo siguiente sobre la 970:

Falsas especificaciones ( 256bits de ancho de banda se han quedado en 192, 4GB de vram se han quedado en 3,5, 64 rops se han quedado...), problemas de stuttering cuando se sobrepasaban los 3,5GB de vram que después se ha "solucionado" capando el acceso a la memoria lenta via driver ( el cual volverá a aparecer en cuanto dejen de optimizar para ella como ha pasado con la 660 y veremos como capan el acceso a la misma bajo directx12) y un brutal coil whine.

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

Beatwin escribió:

Sobre DX12, que alguien me explique por qué jugando con Rise of The Tomb Raider va equiparable incluso mejor con una GTX 970 que con una R9 390. Ahh, si, que Tomb Raider ahora está "patrocinado" por NVIDIA (al contrario que el juego de 2013 que estaba más optimizado para AMD). Claro, claro, mientras que Ashes of the Singularity o HITMAN, son juegos totalmente independientes de la marca (risas) y por tanto podemos extrapolar su rendimiento a los "tremendos" beneficios que tiene DX12 sobre AMD y su cacareada superioridad con "shaders asíncronos", que tan importantes son en DX12, que ¡¡ni siquiera están puestos como opcionales ni mucho menos como obligatorios en la especificación oficial!!

Zinclair escribió:Beatwin escribió:

Sobre DX12, que alguien me explique por qué jugando con Rise of The Tomb Raider va equiparable incluso mejor con una GTX 970 que con una R9 390. Ahh, si, que Tomb Raider ahora está "patrocinado" por NVIDIA (al contrario que el juego de 2013 que estaba más optimizado para AMD). Claro, claro, mientras que Ashes of the Singularity o HITMAN, son juegos totalmente independientes de la marca (risas) y por tanto podemos extrapolar su rendimiento a los "tremendos" beneficios que tiene DX12 sobre AMD y su cacareada superioridad con "shaders asíncronos", que tan importantes son en DX12, que ¡¡ni siquiera están puestos como opcionales ni mucho menos como obligatorios en la especificación oficial!!

El Rise of The Tomb Raider va mejor en unas zonas en la 390 y en otras algo mejor en la 970 , no hay una media para saber en cual va mejor realmente, aun que viendo el vídeo entero , si tuviese que apostar diría que cae a favor de la 390,

https://www.youtube.com/watch?v=YHhPOvlnLGM

Yo entiendo que es mas un problema de drivers de Nvidia , ya que la gpu de la 970 es excelente en dx11 , y no se si el Quantum Break esta también patrocinado por AMD , pero dime si es normal este rendimiento en dx12 ,

Quantum Break PC Performance: GTX 970 vs R9 390

https://www.youtube.com/watch?v=zK2BUeYqLVI

cheewaca escribió:anikilador_imperial escribió:Para mi lo grave del asunto 970 no es que la gráfica rinda más o menos, eso me es indiferente. Lo grave es MENTIR y ENGAÑAR al usuario con unas specs falsas. Que a vosotros os da igual, yo lo respeto, pero no voy a comprar a una compañía que me miente en mi cara y luego ni se disculpa.

Ni te molestes, los comerciales tienen que hacer su trabajo y sus monólogos... dentro de poco tendrán que cambiar a EOL en nombre por: "EOL the Clon Wars".

Un saludo

cheewaca escribió:Beatwin escribió:Bla bla bla bla...

Buenas "amigo", esta cuenta no te la tenía fichada, otra más para ignorados...

Aquí tienes toda la info que necesitas y la cual intentas desmentir reiteradamente:

http://www.google.es

Aquí toda la que necesitas para resolver tus dudas respecto al bench del tomb raider:

http://foro.noticias3d.com/vbulletin/sh ... p?t=447661

que no se a que vienen las gilipolleces de los benchs que nadie ha nombrado pero bueno... como siempre en tu línea.

Con Dios

paconan escribió:Ufff como está el patio...

Siempre deciis del mayor margen de OC de las 970...

Estaria bien que hubiera un pequeño pique a ver que pasa si las apretamos las 2...

Y cuando digo apretar.... 970 @ 1600 y la 390 @ 1220 o 1250 de core...

Yo como tengo las 2 se lo que da... Y seguro seguro que más de uno se llevaba una sorpresa (tanto rojos como verdes)

Enrollaos y compartid firestrikes apretados

![Lee! [rtfm]](/images/smilies/rtfm.gif)

pupegbl escribió:paconan escribió:Ufff como está el patio...

Siempre deciis del mayor margen de OC de las 970...

Estaria bien que hubiera un pequeño pique a ver que pasa si las apretamos las 2...

Y cuando digo apretar.... 970 @ 1600 y la 390 @ 1220 o 1250 de core...

Yo como tengo las 2 se lo que da... Y seguro seguro que más de uno se llevaba una sorpresa (tanto rojos como verdes)

Enrollaos y compartid firestrikes apretados

He llegao tarde a esta discusión de "la mía es mejor, compra la mía". Coño paconan, saca de dudas al personal

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)

paconan escribió:pupegbl escribió:paconan escribió:Ufff como está el patio...

Siempre deciis del mayor margen de OC de las 970...

Estaria bien que hubiera un pequeño pique a ver que pasa si las apretamos las 2...

Y cuando digo apretar.... 970 @ 1600 y la 390 @ 1220 o 1250 de core...

Yo como tengo las 2 se lo que da... Y seguro seguro que más de uno se llevaba una sorpresa (tanto rojos como verdes)

Enrollaos y compartid firestrikes apretados

He llegao tarde a esta discusión de "la mía es mejor, compra la mía". Coño paconan, saca de dudas al personal

Deja que se caldeé más el ambiente que si no no tiene gracia![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)

Pero daos cuenta que la amd al ser un chip más tocho escala de forma más bestia...

Tambien decir que la nvidia lleva el tdp más ajustado por bios que la amd (y cuando lo sobrepasas underclock al canto)

![disimulando [fiu]](/images/smilies/fiu.gif)

![maloso [666]](/images/smilies/nuevos2/masmalo.gif)

![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

bilboboy escribió:Vengo a caldear un poco mas el ambiente![maloso [666]](/images/smilies/nuevos2/masmalo.gif)

Entre una 970 y una 380x, ¿cual pensais que es mejor opción a día de hoy?

Que haya paz

pupegbl escribió:bilboboy escribió:Vengo a caldear un poco mas el ambiente![maloso [666]](/images/smilies/nuevos2/masmalo.gif)

Entre una 970 y una 380x, ¿cual pensais que es mejor opción a día de hoy?

Que haya paz

En Quantum Break dices?

Edito: Broma broma, guiño guiño...

bilboboy escribió:pupegbl escribió:bilboboy escribió:Vengo a caldear un poco mas el ambiente![maloso [666]](/images/smilies/nuevos2/masmalo.gif)

Entre una 970 y una 380x, ¿cual pensais que es mejor opción a día de hoy?

Que haya paz

En Quantum Break dices?

Edito: Broma broma, guiño guiño...

De momento al quantum break jugándolo limitado a 30fps en medio/ultra me va bastante bien

Mi pregunta es mas bien en general.

En teoría la 380x aguanta dx12 12_0 creo, pero tiene el computo de los famosos "asíncronos"

Mientras que la 970 soporta dx 12 12_1. pero no tienen los famosos "cómputos asíncronos"

Una usa tecnología mas antigua (por decirlo de cierta manera), pero soporta el cómputo asíncrono por hardware

Y la otra usa una tecnología mas moderna, pero no es capaz de procesar los cómputos asíncronos por hardware ( y de momento tampoco por software)

12_1 seems to be specifically targeted as a goal by Nvidia as they put bare minimum for each feature level and did not have extra features. Asynchronous shaders for example matters more to me than Conservative Rasterization but that is not on a DX12 feature level just as an optional AMD exclusive.

cheewaca escribió:Beatwin escribió:Bla bla bla bla...

Buenas "amigo", esta cuenta no te la tenía fichada, otra más para ignorados...

Aquí tienes toda la info que necesitas y la cual intentas desmentir reiteradamente:

http://www.google.es

Aquí toda la que necesitas para resolver tus dudas respecto al bench del tomb raider:

http://foro.noticias3d.com/vbulletin/sh ... p?t=447661

que no se a que vienen las gilipolleces de los benchs que nadie ha nombrado pero bueno... como siempre en tu línea.

Con Dios

Beatwin escribió:

Vamos a ver, para evitar confusiones, aclaro que los shaders asíncronos y la computación asíncrona no son parte de DX12, nunca lo han sido. Son algo aparte, propio de AMD, como Gameworks de NVIDIA.

Gaiden escribió:En tu poca vida por aquí ya has dicho demasiadas tonterías, y eso que dices vuelve a ser una mentira. No se que puta necesidad tenéis de agarraos a una marca a nivel fanboy como si fueran las tetas de una modelo. En fin, espero que los demás no se dejen contaminar mucho, por mi parte pasas a ignorados junto algún que otro colega verde, que no me gusta perder el tiempo.

Gaiden escribió:Que no sea obligatorio de la spec no significa que no estén en la api, y lo de la comparativa con gameworks para mearse...pero vamos, que paso mucho, en serio...me cansan los fanboys, de lo que sea.

ionesteraX escribió:Yo lo que no entiendo es porque estos hilos se alargan tanto, es mas deberían hasta cerrarse tras resolver la duda, se pregunta cual pillar de las dos, se deja claro que a día de hoy la 390 es mejor opción en la primera pagina y a otra cosa, el resto ya es que si la abuela fuma o monta en bici.

paconan escribió:@pupegbl ves? el mito de la potencia de OC bla bla bla fuera....

la gráfica del FullKiller y esa 290 gráfica más o menos parejas yendo apretaditas....

paconan escribió:@FullKillerUltimate.

http://www.3dmark.com/3dm/8534411

Del baúl de los recuerdos...

Con unos "simples" 1200 / 1600

Por motivos personales no puedo usar el intel (no os preocupeis que no reventó aún)

Tengo que tirar del FX y en ese pc me falta bomba y radiador para poder pinchar una 290 por agua

@pupegbl ves? el mito de la potencia de OC bla bla bla fuera....

la gráfica del FullKiller y esa 290 gráfica más o menos parejas yendo apretaditas....

paconan escribió:@FullKillerUltimate.

http://www.3dmark.com/3dm/8534411

Del baúl de los recuerdos...

Con unos "simples" 1200 / 1600

Por motivos personales no puedo usar el intel (no os preocupeis que no reventó aún)

Tengo que tirar del FX y en ese pc me falta bomba y radiador para poder pinchar una 290 por agua

@pupegbl ves? el mito de la potencia de OC bla bla bla fuera....

la gráfica del FullKiller y esa 290 gráfica más o menos parejas yendo apretaditas....

FullKillerUltimate. escribió:paconan escribió:@FullKillerUltimate.

http://www.3dmark.com/3dm/8534411

Del baúl de los recuerdos...

Con unos "simples" 1200 / 1600

Por motivos personales no puedo usar el intel (no os preocupeis que no reventó aún)

Tengo que tirar del FX y en ese pc me falta bomba y radiador para poder pinchar una 290 por agua

@pupegbl ves? el mito de la potencia de OC bla bla bla fuera....

la gráfica del FullKiller y esa 290 gráfica más o menos parejas yendo apretaditas....

una pena, tengo ganas de realizar pruebas serias con algún usuario con 390.

ya te digo que firestrike es la herramienta mas insegura para juzgar una gpu en su rendimiento final en juegos, como prueba ya te digo que mismas frecuencias la 970 en fires extreme la 290 a 1.270mhz no alcanzaba a la 970 de juanma.

para mi es no es recomendable comprar una 390 con escasos meses, para eso ya están las 290 que sale bastante mas barata, y que llegan mas lejos como aquí se esta demostrando... otra cosa, también hay que matizar, que las 290 que he visto a esas alturas todas pasadas por agua y con mas voltaje de 1.2, lo que se traduce en muchísimo consumo, que por aire seria imposible de mantener, la 970 que he visto llegar a 14.450 han sido con temperaturas máximas de 62 grados estando por aire.

yo igualmente dejo en pie la oferta, cuando intento hablar con seriedad entro en este foro, no me gusta las interminables discusiones que se convierten en fanáticas como aquí esta ocurriendo ahora y no por parte de uno solo precisamente, si alguno con 390 se anima, yo pongo mi 970 para probarla con diferentes juegos tes y su GPUZ marcando parámetros utilizados... todo lo que se hable sobre firestrile para medir rendimientos en juego es tontería.

saludos.

Beatwin escribió:ionesteraX escribió:Yo lo que no entiendo es porque estos hilos se alargan tanto, es mas deberían hasta cerrarse tras resolver la duda, se pregunta cual pillar de las dos, se deja claro que a día de hoy la 390 es mejor opción en la primera pagina y a otra cosa, el resto ya es que si la abuela fuma o monta en bici.

Pues en la primera página yo he visto una opinión argumentada @wwwendigo donde defiende que "Mejor rendimiento a 1080p para la 970, mejor para la 390 en resoluciones superiores". Con un dato además demoledor en cuanto a que sea mejor una u otra "sin discusión", por lo menos a resolución FullHD que es la que usamos la mayoría de usuarios:http://tpucdn.com/reviews/Gigabyte/GTX_980_Ti_XtremeGaming/images/perfrel_1920_1080.png

Entonces no está claro ni mucho menos cuál tarjeta es la mejor.

De cara a futuro, ahora mismo podemos hacer conjeturas en base a humo, diapositivas marketineras, el ashes y poco mas... vamos, que es mas fácil hacer un telescopio con dos piedras y un zapato que saber exactamente como afectará DX12 a las GPU actuales.

Es que ni en un juego tan "proAMD" como Ashes of the Singularity sale NVIDIA malparada con su "buque insignia"GTX 980 Ti (con permiso de la Titan X). Lo único que la Fury X la iguala, pero es que esta última tarjeta no es que la regalen precisamente.

"Los shaders asíncronos son una ventaja para DX12 y por tanto la R9 390 tiene más futuro". Error, esa característica es una ventaja para AMD, no para DX12 ya que no forma parte de dicha API (ni obligatoria ni optativa), aunque eso es lo que pretenden hacer creer, aunque no es asi. Ha hecho mucho daño el humo y marketing de Ashes of the Singularity.

Bolo_assassin escribió:La mia a 1180/1350 ya saca 14009,la puedo apretar mas de núcleo,la mia a pesar de ser memorias Hynix a mas de 1360 da pantallazo negro.Es lo malo de ser tarjeta de lanzamiento.

De todas maneras venia a responder que lo mejor es que esperara,pero siempre en estos post hay alguien que viene a desinformar.