f5inet escribió:es curioso que cuando la noticia pueda ser tomada desde el punto de vista negativo (Overclocking de la consola), Misterxmedia pasa a ser una fuente fiable

Con el texturizado virtualizado, la presión sobre la memoria se ve drásticamente reducida. Incluso con una tarjeta de 8MB sería suficiente para juego a 16 bits y 1024×768 o 32 bits y 800×600, no importa cual sea la carga de texturas.

Las direcciones virtuales pueden tomar como objetivo páginas en la RAM principal, en la ESRAM, o pueden no estar mapeadas. El Shader leer y escribe las páginas no mapeadas en resultados bien definidos, incluyendo códigos opcionales de error, en vez de bloquear la GPU. Esta habilidad es importante para el soporte de recursos en “tiles”, los cuales están parcialmente residentes en la memoria física.

salocin21 escribió:jose1024 escribió:El maximo creo que son 68gb/s segun el tipo de ddr3 y luego la gpu y esram pueden acceder al maximo de velocidad osea 68gb/s, la cpu a 25gb/s y los move engines a 25gb/s y aunque pueden leer y escribir al mismo tiempo no pueden acceder todos a la vez al maximo, vamos que el maximo son 68gb/s y si la gpu esta usando en ese momento todo el ancho de banda el resto de elementos no puede acceder, no se como ira el tema de gerarquias en los accesos pero el maximo es el que es y para graficos es poco, al menos en la forma tradicional y tratandose de texturas.

El bus de esram con la gpu si es realmente alta tanto en promedios como en picos.

Los move engines si tienen un bus independiente pero a la ram solo acceden con 25gb/s

Creo que es asi por lo que he leido.

Es mas por lo que he podido enteneder la idea de Microsoft es coger las texturas romperla en baldosas con los move engines, volverlas a la ram y desde la ram darselas a la gpu usando la esram para guardar la posicion de las baldosas agilizando el trabajo, osea, la idea de microsoft es que gracias a la api es que la memoria para el motor grafico vea una memoria virtual que aunque sera lenta por que en realidad seguira siendo una ddr3 los datos esten fraccionados y por lo tanto no demanden un alto ancho de banda.

Si la memoria es virtual y por lo tanto es transparente para los motores lo veo factible pero eso es algo de lo que tiene que encargarse la api que es quien de verdad habla con el hardware.

Correcto, salvo en que se la RAM esta dividida en dos bloques en dos buses independientes cada uno de ellos de esos 68 gigas/segundo, así que la velocidad real es 136g/s de transferencia apilada.

Eso dando por echo que no monta "stack" por que si no el ancho de banda seria mucho mas grande; aunque no me extrañaría que así pudiera ser y que la arquitectura de xbox sea similar a las que apus que venderá AMD en un año mas o menos, con memoria stack sobre ddr3 y un "optimizador" de memoria sram, pero como esto no esta confirmado pues lo doy por falso para no especular, aunque la placa y los diagramas y hasta las fechas de fin de DNA coinciden sorprendentemente.

Szasz escribió:salocin21 escribió:jose1024 escribió:El maximo creo que son 68gb/s segun el tipo de ddr3 y luego la gpu y esram pueden acceder al maximo de velocidad osea 68gb/s, la cpu a 25gb/s y los move engines a 25gb/s y aunque pueden leer y escribir al mismo tiempo no pueden acceder todos a la vez al maximo, vamos que el maximo son 68gb/s y si la gpu esta usando en ese momento todo el ancho de banda el resto de elementos no puede acceder, no se como ira el tema de gerarquias en los accesos pero el maximo es el que es y para graficos es poco, al menos en la forma tradicional y tratandose de texturas.

El bus de esram con la gpu si es realmente alta tanto en promedios como en picos.

Los move engines si tienen un bus independiente pero a la ram solo acceden con 25gb/s

Creo que es asi por lo que he leido.

Es mas por lo que he podido enteneder la idea de Microsoft es coger las texturas romperla en baldosas con los move engines, volverlas a la ram y desde la ram darselas a la gpu usando la esram para guardar la posicion de las baldosas agilizando el trabajo, osea, la idea de microsoft es que gracias a la api es que la memoria para el motor grafico vea una memoria virtual que aunque sera lenta por que en realidad seguira siendo una ddr3 los datos esten fraccionados y por lo tanto no demanden un alto ancho de banda.

Si la memoria es virtual y por lo tanto es transparente para los motores lo veo factible pero eso es algo de lo que tiene que encargarse la api que es quien de verdad habla con el hardware.

Correcto, salvo en que se la RAM esta dividida en dos bloques en dos buses independientes cada uno de ellos de esos 68 gigas/segundo, así que la velocidad real es 136g/s de transferencia apilada.

Eso dando por echo que no monta "stack" por que si no el ancho de banda seria mucho mas grande; aunque no me extrañaría que así pudiera ser y que la arquitectura de xbox sea similar a las que apus que venderá AMD en un año mas o menos, con memoria stack sobre ddr3 y un "optimizador" de memoria sram, pero como esto no esta confirmado pues lo doy por falso para no especular, aunque la placa y los diagramas y hasta las fechas de fin de DNA coinciden sorprendentemente.

De donde sacas lo de los 136g/s? Simple curiosidad.

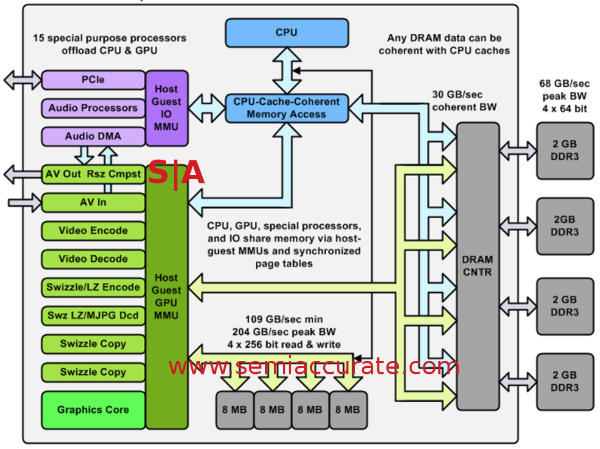

Szasz escribió:No tiene 2 bloques, sino 4 de 64 bits. Unos 17gb/s por cada bloque. 68gb\s en total.

También tiene 4 bloques de Esram, pero esta, a 256bits cada uno.

Lo puedes comprobar aquí:

http://www.tmag.it/wp-content/uploads/2 ... IPie-1.jpg

En el resto del mensaje, muy de acuerdo.

darksch escribió:Yo creo que son 68 por lo menos es lo que siempre nos han dicho. Luego pues se basan en coprocesadores, buses y cachés.

salocin21 escribió:darksch escribió:Yo creo que son 68 por lo menos es lo que siempre nos han dicho. Luego pues se basan en coprocesadores, buses y cachés.

Si 68 son.. Pero 68 por bus y el sistema tiene dos, después para llegar hasta esos 204 gigas teoricos por la aportación de la sram.

Los cooprocesadores no se si estarán para optimizar eso o estará pensado para tareas especificas de DirectX 12

salocin21 escribió:darksch escribió:Yo creo que son 68 por lo menos es lo que siempre nos han dicho. Luego pues se basan en coprocesadores, buses y cachés.

Si 68 son.. Pero 68 por bus y el sistema tiene dos, después para llegar hasta esos 204 gigas teoricos por la aportación de la sram.

Los cooprocesadores no se si estarán para optimizar eso o estará pensado para tareas especificas de DirectX 12

Jose_Redfield escribió:DirectX 12 no acercará Xbox One a los 1080p

según CD Projekt RED

noticia_directx-12-no-acercara-xbox-one-a-los-1080p-segun-cd-projekt-red_24705

Jose_Redfield escribió:DirectX 12 no acercará Xbox One a los 1080p

según CD Projekt RED

noticia_directx-12-no-acercara-xbox-one-a-los-1080p-segun-cd-projekt-red_24705

salocin21 escribió:Hablan de One como si se tratara de un pc estándar, ya que es cierto que DirectX 12 si que va a mejorar las llamadas a dibujado respecto al 11.2 (vamos debería multiplicarlas), peeeero es que One tiene una arquitectura muy lejos de una estándar y en cuando liberen el direxct 12 y le digan a esta gente las posibilidades de sombreado que le da esta arquitectura tan particular (texturas parciales, PBR, etc ) se les va a hacer la boca agua.

Al tiempo, 2015 is incoming

Grinch escribió:Jose_Redfield escribió:DirectX 12 no acercará Xbox One a los 1080p

según CD Projekt RED

noticia_directx-12-no-acercara-xbox-one-a-los-1080p-segun-cd-projekt-red_24705

One ya llega a los 1080p ... por lo que ya de por si el titulo es absurdo.

2º nunca se dijo que direct 12 fuera para los 1080p sino para el rendimiento en si de la consola, ports etc.

y lo mejor de todo es que lees la noticia original y luego la "opinion" y te partes. Juntan la opinion propia con la de los desarrolladores.

Es como si :

Desarrollador : la consola verde esta bien

Noticia : la consola esta bien pero muy verde

xD

Bueno volvemos a los temas de siempre . Yo lo que veo es mucho miedo a d12 ...

Sergitos2 escribió:No, si ahora resultará que los de Cd Projekt no tienen ni idea y tal....

sabueXo escribió:La cagaron al centrarse en TV en vez de en consola como dios manda y ahora lo están pagando.

Esta consola está mal parida y solo lo arregla el sacar una nueva (como hicieron de Xbox a Xbox 360, aunque esas dos fueron consolones y la One es un TDT)

sabueXo escribió:La cagaron al centrarse en TV en vez de en consola como dios manda y ahora lo están pagando.

Esta consola está mal parida y solo lo arregla el sacar una nueva (como hicieron de Xbox a Xbox 360, aunque esas dos fueron consolones y la One es un TDT)

salocin21 escribió:sabueXo escribió:La cagaron al centrarse en TV en vez de en consola como dios manda y ahora lo están pagando.

Esta consola está mal parida y solo lo arregla el sacar una nueva (como hicieron de Xbox a Xbox 360, aunque esas dos fueron consolones y la One es un TDT)

Claro que si campeón.

Ahora en serio:

Hay nueva información del insider de MS..

En resumen:

Confirma que la gpu equivale a 1,3 teraflods x 4 = 5,4 debido a la arquitectura de los nuevos CU y la longitud de palabra.

Tema de los cooprocesadores programables, dice que hay mucho hardware desconocido todavía pero que van a dar mucho juego.

Ancho de banda de la GPU.. Se rumorea que la velocidad real del sistema rondaria los 500g..

Raytracing.. Confirmado que es una maquina pensada para ello, gear 5 tendrá raytracing completo.

Ps4 no tendrá capacidad técnica para raytracing y hablan de una posible ps5 en 2016.

Unreal engine, hay una versión ya especializada para call to metal en xbox one, la versión ps4 esta bloqueada y por eso los retrasos de juegos en esta maquina.

salocin21 escribió:Confirma que la gpu equivale a 1,3 teraflods x 4 = 5,4 debido a la arquitectura de los nuevos CU y la longitud de palabra.

Zokormazo escribió:salocin21 escribió:Confirma que la gpu equivale a 1,3 teraflods x 4 = 5,4 debido a la arquitectura de los nuevos CU y la longitud de palabra.

Confirma? Ein?

Como es eso de que un post de un insider random en un sitio random confirma nada?

Nuhar escribió:No deja de ser mixtermedia, pero si que me parece curioso que en el ultimo post haya cosas que se parecen a lo que flashbackman dice.

¿Se autoalimentaran entre ellos? Jajajaja

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)

Szasz escribió:Efectivamente misterXmedia vuelve a la carga.

He estado repasando su blog y resulta q tenemos la resolución al problema de para q han introducido 8GB de memoria flash.

Resulta q el Procesing in memory (PIM) q debe ser como un mecanismo para conseguir más flops (gpcompute) con un consumo energético reducido, funciona de la siguiente manera:

Dentro del SoC hay:

GPU clusters con su correspondiente CP.

CPU clusters

Hardware de propósito fijo. (Coprocesadores)

Y memoria virtual dentro del SoC, q en el caso de One se utiliza Sram para simular una stacked DRAM de pequeña capacidad y alto ancho de banda.

Fuera del SoC tenemos:

Stacked NVRAM o DRAM ( En el caso de One tenemos, SK Hynix h26m420036MR, q son 8GB stacked NVRAM).

Muy muy interesante. No estaría mal indagar más cosas por ahí. Porq hasta ahora nadie tenia ni idea para q One montaba stacked NVRAM. Todo esto encaja con el discurso de arquitectura de supercomputación.

Para quien quiera echar un vistazo y aportar datos:

http://misterxmedia.livejournal.com/172751.html

fabrihn escribió:no se porque siempre imagine que esos 8GB de memoria eran un tipo de memoria tipo cache, que se podria utilizar por ejemplo al momento de actualizar la consola, o una que otra tarea extra que no ameritace tanta velocidad!!

pero resulta interesante esta funcion que se le pretende dar, como muchas teorias, solo el tiempo lo dira.

siempre es bueno leerlos, cada dia hay algo nuevo que aprender y/o esperar

Terrez escribió:Una pregunta ¿los 8GB que mencionáis, son la memoria RAM o es otra memoria aparte?

Saludos