Multi2Sim supports a cycle-based simulation of superscalar pipelines, modeling instruction fetch, decode, issue, write-back, and commit stages. The model features hardware structures such as the reorder buffer, load/store queues, register file, or trace cache. The pipeline front-end supports different types of branch prediction and micro-instruction decoding, while the back-end implements out-of-order and speculative execution.

A multithreaded pipeline model supports execution of multiple programs or one parallel application spawning child threads. The multithreaded processor shares a common pool of functional units among hardware threads. The rest of the pipeline resources can be configured as private or shared among hardware threads. Multi2Sim supports models for coarse-grain, fine-grain, and simultaneous multithreading.

Hookun escribió:Esta visto que alguno lleva muy mal eso de que no le hagan caso,que le pillen las cagadas...y como salida el insulto fácil a encima usuarios que tienen unos modales intachables aquí.Ayer se te aviso desde moderacion ya pero me parece que el próximo aviso sera con premio.Luego podrás también acusar a eol de sectarios en tu blog y tal...

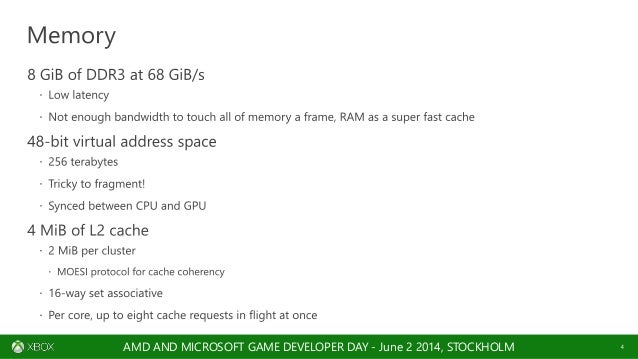

“MOESI hsc uses a MOESI protocol for all of the CPU caches included in the system. For the GPU caches, we add an L2 cache controller that provides coherence between the GPU and CPU L2 caches.”

pspskulls escribió:Bueno, dado el despropósito al que se está llegando en este hilo voy a explicar lo que significa el PDF famoso.

Primero unas preguntas y respuestas rápidas importantes para entender la explicación:

- ¿Tiene Xbox ONE doble GPU?: NO.

- ¿Reserva ONE CPs o CUs para el sistema?: NO.

- ¿Podemos tener una GPU que admita multihilo sin tener doble contexto gráfico?: SI. Podemos tener 2 CP pidiendo tareas a la GPU y la GPU irá realizando las tareas pero no simultáneamente (por ejemplo pensad en un núcleo de CPU de 2 hilos, lo que ejecutan no es simultáneo sino que los hilos cogen la capacidad de proceso según el otro hilo ya no lo necesita). Para que una GPU realice dos tareas GRÁFICAS en paralelo DEBE tener 2 contextos gráficos (no podemos pintar en un lienzo en dos puntos al mismo tiempo si no tenemos dos pinceles). Resalto gráficas porque una GPU puede realizar GPGPU al mismo tiempo que renderiza.

Aquí habláis desde la teoría pero no desde la práctica., y es por eso que no se entiende el porqué de la estructura de One. Para entender la tecnología hay que entender el rendering, el porqué y el cómo se hacen las distintas técnicas actuales y futuras. El factor determinante es el doble contexto gráfico. Ésto es MUY importante, la clave es la palabra "gráfico".

Un ejemplo muy sencillo de renderizado de sombras seria: CPU prepara y pide crear una sombra de un objeto, la GPU entra en juego y la genera. Y así sucesivamente por cada sombra. Hay que tener una cosa MUY clara, renderizar una sombra no necesita PARA NADA los 12 CUs de la consola, ni por tener 12 o 18 va a renderizarla más rápido, una sombra necesita una capacidad de cómputo determinada y que posiblemente con 1 única CU nos bastaría. El problema es que cuando se renderiza se OCUPA la GPU, por lo tanto aunque no necesitemos los 12 CUs, los 12 CUs se van a bloquear para poder pintar la sombra. Obviamente podemos distribuir los CUs, y decir que sólo queremos usar un máximo de CUs para renderizado, y el resto para GPGPU (y aprovechar así el tiempo de renderizado para sacar cómputo). Pero a la hora de renderizar y para los CUs asignados a renderizar TODOS quedan bloqueados.

A partir de aquí C es CPU y G es GPU. Si queremos generar 4 sombras tenemos:

C > G > C > G > C > G > C > G

¿Qué sucede en One?. Que al tener 2 contextos gráficos puede renderizar 2 sombras al mismo tiempo. Con lo que nos queda:

> G > G

C > C

> G > G

Esto es, ni más ni menos, que la mitad del tiempo. ¿Estamos duplicando en este caso el rendimiento gráfico de One?: SÍ. ¿Es One más potente por ello?: NO. La capacidad de cómputo de One es la misma solo que el rendimiento es el doble.

Otro ejemplo seria un engine gráfico basado en tiled forward (http://www.cse.chalmers.se/~olaolss/main_frame.php?contents=publication&id=tiled_shading). Esta implementación se basa en generar el frame final a base de tiles o porciones de pantalla pequeñas (pequeños rectángulos). A parte de las características negativas y positivas de ésta técnica (toda técnica tiene su lado bueno y su lado malo), a dónde quiero ir a parar es en el hecho en el que... teniendo 2 contextos gráficos simultáneos podemos dibujar 2 de esas porciones SIMULTÁNEAMENTE. Con lo que el resultado es que obtenemos el frame en la mitad del tiempo y por tanto doblamos el rendimiento. Aquí también quiero hacer incapié en otra característica única de One: su eSRAM. Dado que esta técnica no requiere de gran ancho de banda, lo que más le beneficia es una memoria RÁPIDA, es decir de bajísima latencia (no confundir RAPIDEZ con ANCHO DE BANDA, no tienen NADA que ver, la rapidez la determina el tiempo para que la memoria vuelva a estar disponible para una nueva petición y ahí importa la latencia, el ancho de banda sólo sirve para MOVER grandes cantidades de memoria de un punto A a un punto B). Quiero decir con esto que de aplicar esta técnica en ambas consolas, One ganaría por absoluta goleada. Pero si aplicamos técnicas más antiguas como un deferred engine PS4 tiene ventaja por su ancho de banda (y de aquí vienen las diferencias en multis hasta ahora en cuanto a resolución o framerate).

A todo esto hay que añadirle que One tiene Full HSA, es decir coherencia total de memoria, algo básico si tenemos más de un contexto gráfico y además GPGPU, porque sí, One puede renderizar dos cosas y hacer GPGPU AL MISMO TIEMPO y compartiendo la MISMA memoria. Y esto es MUY potente y da una serie de posibilidades únicas.

¿Bien... significa todo esto que One doblará su rendimiento?: NO. One doblará su rendimiento GRÁFICO en múltiples tareas gráficas pero el rendimiento GLOBAL de un juego no SÓLO depende de la GPU. Hay muchos otros factores: CPU, memoria, técnicas gráficas utilizadas...

Ahora bien, si a mi se me pregunta: ¿Cuánto crees en promedio que mejorará el rendimiento de One?. Sinceramente y, bajo MI opinión, One incrementará con DX12 el rendimiento entre un 50 a un 75%.

Sorry por el tocho y espero haber dejado bastantes cosas claras.

eloskuro escribió:Full HSA con protocolo MOESI y L2 cache en Xbox One

¿cuantos sistemas actuales tienen Full HSA? ¿Solo Xbox One?“MOESI hsc uses a MOESI protocol for all of the CPU caches included in the system. For the GPU caches, we add an L2 cache controller that provides coherence between the GPU and CPU L2 caches.”

Hookun escribió:eloskuro escribió:Full HSA con protocolo MOESI y L2 cache en Xbox One

¿cuantos sistemas actuales tienen Full HSA? ¿Solo Xbox One?“MOESI hsc uses a MOESI protocol for all of the CPU caches included in the system. For the GPU caches, we add an L2 cache controller that provides coherence between the GPU and CPU L2 caches.”

A día de hoy solo existe en One el FULL HSA.Que es una gran ayuda para los sistemas unificados de memoria.

shaderyt escribió:Eso es imposible que sea full HSA por la propia arquitectura de la consola, es sencillo, el HSA es que la CPU y GPU vean en todo momento lo que tienen la otra guardada en memoria, pero en ONE no sucede por la esram a la que accede solo la GPU(en realidad puede acceder tambien la CPU, pero tiene que hacer un rodeo muy ineficiente a traves de la GPU vamos que no tiene mucho sentido). MS siempre hablo de que tienen algo ``parecido´´ pero ni mucho menos que sea una solucion como la que publicita AMD (hUMA), la unica consola actualmente con posibilidad de ``full hsa´´es ps4 por tener la memoria unificada ya que ese es el requisito para tenerlo(y no no vengo a hacer publicidad de ps4 ni la tengo ni me interesa por ahora, solo la pongo de ejemplo). Si tiene la ddr3, pero por la esram ya no puede ser ``full hsa´´.

Sobre los compute command processor y graphics command processor, es una discucion muy vieja y que a estas alturas se haya redescubierto para darle potencias ocultas a la one es un tanto ridiculo, y no se porque obviais que ps4 tambien tiene 2 de cada, vamos que la cosa sigue igual que siempre.

enaguas escribió:shaderyt escribió:Eso es imposible que sea full HSA por la propia arquitectura de la consola, es sencillo, el HSA es que la CPU y GPU vean en todo momento lo que tienen la otra guardada en memoria, pero en ONE no sucede por la esram a la que accede solo la GPU(en realidad puede acceder tambien la CPU, pero tiene que hacer un rodeo muy ineficiente a traves de la GPU vamos que no tiene mucho sentido). MS siempre hablo de que tienen algo ``parecido´´ pero ni mucho menos que sea una solucion como la que publicita AMD (hUMA), la unica consola actualmente con posibilidad de ``full hsa´´es ps4 por tener la memoria unificada ya que ese es el requisito para tenerlo(y no no vengo a hacer publicidad de ps4 ni la tengo ni me interesa por ahora, solo la pongo de ejemplo). Si tiene la ddr3, pero por la esram ya no puede ser ``full hsa´´.

Sobre los compute command processor y graphics command processor, es una discucion muy vieja y que a estas alturas se haya redescubierto para darle potencias ocultas a la one es un tanto ridiculo, y no se porque obviais que ps4 tambien tiene 2 de cada, vamos que la cosa sigue igual que siempre.

citas celebres: shaderyt, 4 de diciembre de 2014

"eso es imposible en xbox one"

"solo es posible en ps4"

"todo lo que tiene xbox one tambien lo tiene ps4"

"no vengo a publicitar a ps4...no me interesa"

magnific!!

![Aplausos [plas]](/images/smilies/aplauso.gif)

![Aplausos [plas]](/images/smilies/aplauso.gif)

![Aplausos [plas]](/images/smilies/aplauso.gif)

![Aplausos [plas]](/images/smilies/aplauso.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

Here’s the important points, for comparison’s sake. The CPU cache block attaches to the GPU MMU, which drives the entire graphics core and video engine. Of particular interest for our purposes is this bit: “CPU, GPU, special processors, and I/O share memory via host-guest MMUs and synchronized page tables.” If Microsoft is using synchronized page tables, this strongly suggests that the Xbox One supports HSA/hUMA and that we were mistaken in our assertion to the contrary. Mea culpa.

You can see the Onion and Garlic buses represented in both AMD’s diagram and the Microsoft image above. The GPU has a non-cache-coherent bus connection to the DDR3 memory pool and a cache-coherent bus attached to the CPU. Bandwidth to main memory is 68GB/s using 4×64 DDR3 links or 36GB/s if passed through the cache coherent interface. Cache coherency is always slower than non-coherent access, so the discrepancy makes sense.

shaderyt escribió:Sobre los compute command processor y graphics command processor, es una discucion muy vieja y que a estas alturas se haya redescubierto para darle potencias ocultas a la one es un tanto ridiculo, y no se porque obviais que ps4 tambien tiene 2 de cada, vamos que la cosa sigue igual que siempre.

eloskuro escribió:http://www.extremetech.com/gaming/164934-xbox-one-bus-bandwidths-graphics-capabilities-and-odd-soc-architecture-confirmed-by-microsoftHere’s the important points, for comparison’s sake. The CPU cache block attaches to the GPU MMU, which drives the entire graphics core and video engine. Of particular interest for our purposes is this bit: “CPU, GPU, special processors, and I/O share memory via host-guest MMUs and synchronized page tables.” If Microsoft is using synchronized page tables, this strongly suggests that the Xbox One supports HSA/hUMA and that we were mistaken in our assertion to the contrary. Mea culpa.

You can see the Onion and Garlic buses represented in both AMD’s diagram and the Microsoft image above. The GPU has a non-cache-coherent bus connection to the DDR3 memory pool and a cache-coherent bus attached to the CPU. Bandwidth to main memory is 68GB/s using 4×64 DDR3 links or 36GB/s if passed through the cache coherent interface. Cache coherency is always slower than non-coherent access, so the discrepancy makes sense.

Extremetech se autoedito para no llevarse zascas en este sentido

![risa con gafas [chulito]](/images/smilies/nuevos/sonrisa_ani2.gif)

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)

Grinch escribió:Aqui mucha gente diciendo que si no sabeis no hableis y creo que son ellos los que menos idea tienen

darksch escribió:Grinch escribió:Aqui mucha gente diciendo que si no sabeis no hableis y creo que son ellos los que menos idea tienen

Ya se sabe que todos los gurús están en el hilo "Hablemos del interior de PS4". Aquí los zopencos.

![Aplausos [plas]](/images/smilies/aplauso.gif)

![Aplausos [plas]](/images/smilies/aplauso.gif)

cjdiez escribió:darksch escribió:Grinch escribió:Aqui mucha gente diciendo que si no sabeis no hableis y creo que son ellos los que menos idea tienen

Ya se sabe que todos los gurús están en el hilo "Hablemos del interior de PS4". Aquí los zopencos.

Lo verdaderamente extraño es que todo el ejército de astroturfers y tecnolistos que llevan un par de días posteando sin descanso para desacreditar lo expuesto por gente como pspskulls con educación y aportando pruebas, datos y contrastando, son gente (o bots, no lo se) con muy muy pocos mensajes, es como si se hubiesen alineado los planetas en su contra opinión y han sentido la necesidad de dejarse en este hilo 20 de las 24 horas del día.

![Aplausos [plas]](/images/smilies/aplauso.gif)

![como la niña del exorcista [360º]](/images/smilies/nuevos/vueltas.gif)

shaderyt escribió:Agarraros a los famosos 3000 millones es agarraros a un clavo ardiendo, eso no es un argumento es entrar en pura especulacion.

Pd: y ya me voy que lo dije antes y aqui sigo.

Grinch escribió:Aqui mucha gente diciendo que si no sabeis no hableis y creo que son ellos los que menos idea tienen

Eso es imposible que sea full HSA por la propia arquitectura de la consola, es sencillo, el HSA es que la CPU y GPU vean en todo momento lo que tienen la otra guardada en memoria, pero en ONE no sucede por la esram a la que accede solo la GPU(en realidad puede acceder tambien la CPU, pero tiene que hacer un rodeo muy ineficiente a traves de la GPU vamos que no tiene mucho sentido). MS siempre hablo de que tienen algo ``parecido´´ pero ni mucho menos que sea una solucion como la que publicita AMD (hUMA), la unica consola actualmente con posibilidad de ``full hsa´´es ps4 por tener la memoria unificada ya que ese es el requisito para tenerlo(y no no vengo a hacer publicidad de ps4 ni la tengo ni me interesa por ahora, solo la pongo de ejemplo). Si tiene la ddr3, pero por la esram ya no puede ser ``full hsa´´.

Sobre los compute command processor y graphics command processor, es una discucion muy vieja y que a estas alturas se haya redescubierto para darle potencias ocultas a la one es un tanto ridiculo, y no se porque obviais que ps4 tambien tiene 2 de cada, vamos que la cosa sigue igual que siempre.

Fandro escribió:shaderyt escribió:Agarraros a los famosos 3000 millones es agarraros a un clavo ardiendo, eso no es un argumento es entrar en pura especulacion.

Pd: y ya me voy que lo dije antes y aqui sigo.

Los 3000 millones se los gastó Microsoft, pero lo que se ahorró Sony al construir su consola le servió para pagar a gente como tú. Déjalo ya URIAN

P.D. Muchas gracias a todos los foreros que de verdad tratan de descubrir realmente que es y como funciona lo que hay dentro de la máquina.

enaguas escribió:[...]

Para que va servir dx12 en one entonces?

Y dar coba a los lloros de maletines y paridad

shaderyt escribió:No iba a contestar pero ¿Como habeis llegado a la conclusion de que soy urian? Sigo su blog pero de ahi a ser el xD...

A mi me gustaria saber quien es ``questo´´ que se a puesto a criticarme en el blog de urian, si quieres decirme algo me lo dices a la cara, no hace falta que me sigas por donde ando mas alla de EOL que es donde estabamos hablando.

enaguas escribió:shaderyt escribió:No iba a contestar pero ¿Como habeis llegado a la conclusion de que soy urian? Sigo su blog pero de ahi a ser el xD...

A mi me gustaria saber quien es ``questo´´ que se a puesto a criticarme en el blog de urian, si quieres decirme algo me lo dices a la cara, no hace falta que me sigas por donde ando mas alla de EOL que es donde estabamos hablando.

mira tu mucho: "me voy"... pero no te vas...mucho no iba a contestar...pero contestas.....

di la verdad: di que has venido a flamear y que estás flameando

shaderyt escribió:BiG Porras escribió:siguiendo con las frases del compañero @enaguas, y a tenor del ultimo comentario del sujeto en cuestion, solo decir que al compañero le ha faltado decir que DX12 es imposible en Xbox One y que también lo tiene PS4![risa con gafas [chulito]](/images/smilies/nuevos/sonrisa_ani2.gif)

Si no entiendes nada de lo que digo mejor no digas nada(tu y los demas que solo venis a intentar ridiculizar todo lo que diga), ONE ya tiene sus propias APIs basadas en DX, y por usar ps4 DX12 podria usarla, si no lo hace es por MS, las dos consolas tienen CPU jaguar y graficas GCN, asi que es perfectamente capaz de usarlo igual que lo usara la one, pero obviamente MS no iba a darle su DX a la competencia directa en consolas.

Cyborg_Ninja escribió:Pero si lo que estas diciendo no lo entiendes ni tu, estas copiando las frases de Herebus de Meristation practicamente tal cual. No pongo fuente del hilo porque no se si esta permitido, pero estas copiando todo lo que dice el tal cual, hasta su "aparicion" en Meristation no tenias n.p.i de que decir con el nuevo paper de MS.

shaderyt escribió:Cyborg_Ninja escribió:Pero si lo que estas diciendo no lo entiendes ni tu, estas copiando las frases de Herebus de Meristation practicamente tal cual. No pongo fuente del hilo porque no se si esta permitido, pero estas copiando todo lo que dice el tal cual, hasta su "aparicion" en Meristation no tenias n.p.i de que decir con el nuevo paper de MS.

Tambien estoy registrado en meristation ya ves, y si claro, eso sera, es que antes de herebus existia la nada.

Vosotros si que teneis idea citando a soloxbox.com y falconsp.

shaderyt escribió:enaguas escribió:shaderyt escribió:No iba a contestar pero ¿Como habeis llegado a la conclusion de que soy urian? Sigo su blog pero de ahi a ser el xD...

A mi me gustaria saber quien es ``questo´´ que se a puesto a criticarme en el blog de urian, si quieres decirme algo me lo dices a la cara, no hace falta que me sigas por donde ando mas alla de EOL que es donde estabamos hablando.

mira tu mucho: "me voy"... pero no te vas...mucho no iba a contestar...pero contestas.....

di la verdad: di que has venido a flamear y que estás flameando

Es lo que tiene que me querais tanto.

Al menos he argumentado algo desde mi primer comentario, la primera contestación ya fue a intentar ridiculizar lo que dije, asi que no se que esperabais(y tu has sido uno de ellos, que ni has argumentado solo has flameado, eso que estas criticando).

Cyborg_Ninja escribió:shaderyt escribió:Cyborg_Ninja escribió:Pero si lo que estas diciendo no lo entiendes ni tu, estas copiando las frases de Herebus de Meristation practicamente tal cual. No pongo fuente del hilo porque no se si esta permitido, pero estas copiando todo lo que dice el tal cual, hasta su "aparicion" en Meristation no tenias n.p.i de que decir con el nuevo paper de MS.

Tambien estoy registrado en meristation ya ves, y si claro, eso sera, es que antes de herebus existia la nada.

Vosotros si que teneis idea citando a soloxbox.com y falconsp.

Yo citando a quien? pero chaval, tu has visto mis comentarios en este hilo? si he dicho por activa y por pasiva que se dejen de fumadas, que la GPU de One rinde lo que pone que rinde, que no hay doble GPU ni nada por el estilo.

Si quieres negar que estas plagiando los comentarios de Herebus porque tu de por si no tenias ni idea de como interpretar el paper de Microsoft pues tu mismo, pero no hay mas que leer su comentario y luego el tuyo para darse cuenta de que has dicho lo mismo casi con las mismas palabras, cambiandolas un poco para que no se note tanto.

Si vas a la deriva de otros foreros me parece bien, pero encima no tengas la cara de decir "es que no entendeis lo que digo", porque desde que salio el tema llevas usando los argumentos de otros, Polysteres, isma82, Urian y ahora Herebus, al menos se humilde y lo que no entiendas reconocelo y di que te parece mas coherente lo que dice X persona, no te atribuyas el "merito".

No se, bastante claro esta y siempre estoy leyendo para aprender mas, pero resulta que isma, urian y demas si coincido con lo que dicen, ¿si ellos dicen que X tiene 8 de ram DDR3 y yo digo lo mismo estoy plagiando? Pero vamos respeto tu opinion y no quiero malos rollos.

pspskulls escribió:Bueno, dado el despropósito al que se está llegando en este hilo voy a explicar lo que significa el PDF famoso.

Primero unas preguntas y respuestas rápidas importantes para entender la explicación:

- ¿Tiene Xbox ONE doble GPU?: NO.

- ¿Reserva ONE CPs o CUs para el sistema?: NO.

- ¿Podemos tener una GPU que admita multihilo sin tener doble contexto gráfico?: SI. Podemos tener 2 CP pidiendo tareas a la GPU y la GPU irá realizando las tareas pero no simultáneamente (por ejemplo pensad en un núcleo de CPU de 2 hilos, lo que ejecutan no es simultáneo sino que los hilos cogen la capacidad de proceso según el otro hilo ya no lo necesita). Para que una GPU realice dos tareas GRÁFICAS en paralelo DEBE tener 2 contextos gráficos (no podemos pintar en un lienzo en dos puntos al mismo tiempo si no tenemos dos pinceles). Resalto gráficas porque una GPU puede realizar GPGPU al mismo tiempo que renderiza.

Aquí habláis desde la teoría pero no desde la práctica., y es por eso que no se entiende el porqué de la estructura de One. Para entender la tecnología hay que entender el rendering, el porqué y el cómo se hacen las distintas técnicas actuales y futuras. El factor determinante es el doble contexto gráfico. Ésto es MUY importante, la clave es la palabra "gráfico".

Un ejemplo muy sencillo de renderizado de sombras seria: CPU prepara y pide crear una sombra de un objeto, la GPU entra en juego y la genera. Y así sucesivamente por cada sombra. Hay que tener una cosa MUY clara, renderizar una sombra no necesita PARA NADA los 12 CUs de la consola, ni por tener 12 o 18 va a renderizarla más rápido, una sombra necesita una capacidad de cómputo determinada y que posiblemente con 1 única CU nos bastaría. El problema es que cuando se renderiza se OCUPA la GPU, por lo tanto aunque no necesitemos los 12 CUs, los 12 CUs se van a bloquear para poder pintar la sombra. Obviamente podemos distribuir los CUs, y decir que sólo queremos usar un máximo de CUs para renderizado, y el resto para GPGPU (y aprovechar así el tiempo de renderizado para sacar cómputo). Pero a la hora de renderizar y para los CUs asignados a renderizar TODOS quedan bloqueados.

A partir de aquí C es CPU y G es GPU. Si queremos generar 4 sombras tenemos:

C > G > C > G > C > G > C > G

¿Qué sucede en One?. Que al tener 2 contextos gráficos puede renderizar 2 sombras al mismo tiempo. Con lo que nos queda:

> G > G

C > C

> G > G

Esto es, ni más ni menos, que la mitad del tiempo. ¿Estamos duplicando en este caso el rendimiento gráfico de One?: SÍ. ¿Es One más potente por ello?: NO. La capacidad de cómputo de One es la misma solo que el rendimiento es el doble.

Otro ejemplo seria un engine gráfico basado en tiled forward (http://www.cse.chalmers.se/~olaolss/main_frame.php?contents=publication&id=tiled_shading). Esta implementación se basa en generar el frame final a base de tiles o porciones de pantalla pequeñas (pequeños rectángulos). A parte de las características negativas y positivas de ésta técnica (toda técnica tiene su lado bueno y su lado malo), a dónde quiero ir a parar es en el hecho en el que... teniendo 2 contextos gráficos simultáneos podemos dibujar 2 de esas porciones SIMULTÁNEAMENTE. Con lo que el resultado es que obtenemos el frame en la mitad del tiempo y por tanto doblamos el rendimiento. Aquí también quiero hacer incapié en otra característica única de One: su eSRAM. Dado que esta técnica no requiere de gran ancho de banda, lo que más le beneficia es una memoria RÁPIDA, es decir de bajísima latencia (no confundir RAPIDEZ con ANCHO DE BANDA, no tienen NADA que ver, la rapidez la determina el tiempo para que la memoria vuelva a estar disponible para una nueva petición y ahí importa la latencia, el ancho de banda sólo sirve para MOVER grandes cantidades de memoria de un punto A a un punto B). Quiero decir con esto que de aplicar esta técnica en ambas consolas, One ganaría por absoluta goleada. Pero si aplicamos técnicas más antiguas como un deferred engine PS4 tiene ventaja por su ancho de banda (y de aquí vienen las diferencias en multis hasta ahora en cuanto a resolución o framerate).

A todo esto hay que añadirle que One tiene Full HSA, es decir coherencia total de memoria, algo básico si tenemos más de un contexto gráfico y además GPGPU, porque sí, One puede renderizar dos cosas y hacer GPGPU AL MISMO TIEMPO y compartiendo la MISMA memoria. Y esto es MUY potente y da una serie de posibilidades únicas.

¿Bien... significa todo esto que One doblará su rendimiento?: NO. One doblará su rendimiento GRÁFICO en múltiples tareas gráficas pero el rendimiento GLOBAL de un juego no SÓLO depende de la GPU. Hay muchos otros factores: CPU, memoria, técnicas gráficas utilizadas...

Ahora bien, si a mi se me pregunta: ¿Cuánto crees en promedio que mejorará el rendimiento de One?. Sinceramente y, bajo MI opinión, One incrementará con DX12 el rendimiento entre un 50 a un 75%.

Sorry por el tocho y espero haber dejado bastantes cosas claras.

pspskulls escribió:Bueno, dado el despropósito al que se está llegando en este hilo voy a explicar lo que significa el PDF famoso.

Primero unas preguntas y respuestas rápidas importantes para entender la explicación:

- ¿Tiene Xbox ONE doble GPU?: NO.

- ¿Reserva ONE CPs o CUs para el sistema?: NO.

- ¿Podemos tener una GPU que admita multihilo sin tener doble contexto gráfico?: SI. Podemos tener 2 CP pidiendo tareas a la GPU y la GPU irá realizando las tareas pero no simultáneamente (por ejemplo pensad en un núcleo de CPU de 2 hilos, lo que ejecutan no es simultáneo sino que los hilos cogen la capacidad de proceso según el otro hilo ya no lo necesita). Para que una GPU realice dos tareas GRÁFICAS en paralelo DEBE tener 2 contextos gráficos (no podemos pintar en un lienzo en dos puntos al mismo tiempo si no tenemos dos pinceles). Resalto gráficas porque una GPU puede realizar GPGPU al mismo tiempo que renderiza.

Aquí habláis desde la teoría pero no desde la práctica., y es por eso que no se entiende el porqué de la estructura de One. Para entender la tecnología hay que entender el rendering, el porqué y el cómo se hacen las distintas técnicas actuales y futuras. El factor determinante es el doble contexto gráfico. Ésto es MUY importante, la clave es la palabra "gráfico".

Un ejemplo muy sencillo de renderizado de sombras seria: CPU prepara y pide crear una sombra de un objeto, la GPU entra en juego y la genera. Y así sucesivamente por cada sombra. Hay que tener una cosa MUY clara, renderizar una sombra no necesita PARA NADA los 12 CUs de la consola, ni por tener 12 o 18 va a renderizarla más rápido, una sombra necesita una capacidad de cómputo determinada y que posiblemente con 1 única CU nos bastaría. El problema es que cuando se renderiza se OCUPA la GPU, por lo tanto aunque no necesitemos los 12 CUs, los 12 CUs se van a bloquear para poder pintar la sombra. Obviamente podemos distribuir los CUs, y decir que sólo queremos usar un máximo de CUs para renderizado, y el resto para GPGPU (y aprovechar así el tiempo de renderizado para sacar cómputo). Pero a la hora de renderizar y para los CUs asignados a renderizar TODOS quedan bloqueados.

A partir de aquí C es CPU y G es GPU. Si queremos generar 4 sombras tenemos:

C > G > C > G > C > G > C > G

¿Qué sucede en One?. Que al tener 2 contextos gráficos puede renderizar 2 sombras al mismo tiempo. Con lo que nos queda:

> G > G

C > C

> G > G

Esto es, ni más ni menos, que la mitad del tiempo. ¿Estamos duplicando en este caso el rendimiento gráfico de One?: SÍ. ¿Es One más potente por ello?: NO. La capacidad de cómputo de One es la misma solo que el rendimiento es el doble.

Otro ejemplo seria un engine gráfico basado en tiled forward (http://www.cse.chalmers.se/~olaolss/main_frame.php?contents=publication&id=tiled_shading). Esta implementación se basa en generar el frame final a base de tiles o porciones de pantalla pequeñas (pequeños rectángulos). A parte de las características negativas y positivas de ésta técnica (toda técnica tiene su lado bueno y su lado malo), a dónde quiero ir a parar es en el hecho en el que... teniendo 2 contextos gráficos simultáneos podemos dibujar 2 de esas porciones SIMULTÁNEAMENTE. Con lo que el resultado es que obtenemos el frame en la mitad del tiempo y por tanto doblamos el rendimiento. Aquí también quiero hacer incapié en otra característica única de One: su eSRAM. Dado que esta técnica no requiere de gran ancho de banda, lo que más le beneficia es una memoria RÁPIDA, es decir de bajísima latencia (no confundir RAPIDEZ con ANCHO DE BANDA, no tienen NADA que ver, la rapidez la determina el tiempo para que la memoria vuelva a estar disponible para una nueva petición y ahí importa la latencia, el ancho de banda sólo sirve para MOVER grandes cantidades de memoria de un punto A a un punto B). Quiero decir con esto que de aplicar esta técnica en ambas consolas, One ganaría por absoluta goleada. Pero si aplicamos técnicas más antiguas como un deferred engine PS4 tiene ventaja por su ancho de banda (y de aquí vienen las diferencias en multis hasta ahora en cuanto a resolución o framerate).

A todo esto hay que añadirle que One tiene Full HSA, es decir coherencia total de memoria, algo básico si tenemos más de un contexto gráfico y además GPGPU, porque sí, One puede renderizar dos cosas y hacer GPGPU AL MISMO TIEMPO y compartiendo la MISMA memoria. Y esto es MUY potente y da una serie de posibilidades únicas.

¿Bien... significa todo esto que One doblará su rendimiento?: NO. One doblará su rendimiento GRÁFICO en múltiples tareas gráficas pero el rendimiento GLOBAL de un juego no SÓLO depende de la GPU. Hay muchos otros factores: CPU, memoria, técnicas gráficas utilizadas...

Ahora bien, si a mi se me pregunta: ¿Cuánto crees en promedio que mejorará el rendimiento de One?. Sinceramente y, bajo MI opinión, One incrementará con DX12 el rendimiento entre un 50 a un 75%.

Sorry por el tocho y espero haber dejado bastantes cosas claras.

enaguas escribió:Para retomar el orden del hilo y dejar las disputas y seguir con el debate:pspskulls escribió:Bueno, dado el despropósito al que se está llegando en este hilo voy a explicar lo que significa el PDF famoso.

Primero unas preguntas y respuestas rápidas importantes para entender la explicación:

- ¿Tiene Xbox ONE doble GPU?: NO.

- ¿Reserva ONE CPs o CUs para el sistema?: NO.

- ¿Podemos tener una GPU que admita multihilo sin tener doble contexto gráfico?: SI. Podemos tener 2 CP pidiendo tareas a la GPU y la GPU irá realizando las tareas pero no simultáneamente (por ejemplo pensad en un núcleo de CPU de 2 hilos, lo que ejecutan no es simultáneo sino que los hilos cogen la capacidad de proceso según el otro hilo ya no lo necesita). Para que una GPU realice dos tareas GRÁFICAS en paralelo DEBE tener 2 contextos gráficos (no podemos pintar en un lienzo en dos puntos al mismo tiempo si no tenemos dos pinceles). Resalto gráficas porque una GPU puede realizar GPGPU al mismo tiempo que renderiza.

Aquí habláis desde la teoría pero no desde la práctica., y es por eso que no se entiende el porqué de la estructura de One. Para entender la tecnología hay que entender el rendering, el porqué y el cómo se hacen las distintas técnicas actuales y futuras. El factor determinante es el doble contexto gráfico. Ésto es MUY importante, la clave es la palabra "gráfico".

Un ejemplo muy sencillo de renderizado de sombras seria: CPU prepara y pide crear una sombra de un objeto, la GPU entra en juego y la genera. Y así sucesivamente por cada sombra. Hay que tener una cosa MUY clara, renderizar una sombra no necesita PARA NADA los 12 CUs de la consola, ni por tener 12 o 18 va a renderizarla más rápido, una sombra necesita una capacidad de cómputo determinada y que posiblemente con 1 única CU nos bastaría. El problema es que cuando se renderiza se OCUPA la GPU, por lo tanto aunque no necesitemos los 12 CUs, los 12 CUs se van a bloquear para poder pintar la sombra. Obviamente podemos distribuir los CUs, y decir que sólo queremos usar un máximo de CUs para renderizado, y el resto para GPGPU (y aprovechar así el tiempo de renderizado para sacar cómputo). Pero a la hora de renderizar y para los CUs asignados a renderizar TODOS quedan bloqueados.

A partir de aquí C es CPU y G es GPU. Si queremos generar 4 sombras tenemos:

C > G > C > G > C > G > C > G

¿Qué sucede en One?. Que al tener 2 contextos gráficos puede renderizar 2 sombras al mismo tiempo. Con lo que nos queda:

> G > G

C > C

> G > G

Esto es, ni más ni menos, que la mitad del tiempo. ¿Estamos duplicando en este caso el rendimiento gráfico de One?: SÍ. ¿Es One más potente por ello?: NO. La capacidad de cómputo de One es la misma solo que el rendimiento es el doble.

Otro ejemplo seria un engine gráfico basado en tiled forward (http://www.cse.chalmers.se/~olaolss/main_frame.php?contents=publication&id=tiled_shading). Esta implementación se basa en generar el frame final a base de tiles o porciones de pantalla pequeñas (pequeños rectángulos). A parte de las características negativas y positivas de ésta técnica (toda técnica tiene su lado bueno y su lado malo), a dónde quiero ir a parar es en el hecho en el que... teniendo 2 contextos gráficos simultáneos podemos dibujar 2 de esas porciones SIMULTÁNEAMENTE. Con lo que el resultado es que obtenemos el frame en la mitad del tiempo y por tanto doblamos el rendimiento. Aquí también quiero hacer incapié en otra característica única de One: su eSRAM. Dado que esta técnica no requiere de gran ancho de banda, lo que más le beneficia es una memoria RÁPIDA, es decir de bajísima latencia (no confundir RAPIDEZ con ANCHO DE BANDA, no tienen NADA que ver, la rapidez la determina el tiempo para que la memoria vuelva a estar disponible para una nueva petición y ahí importa la latencia, el ancho de banda sólo sirve para MOVER grandes cantidades de memoria de un punto A a un punto B). Quiero decir con esto que de aplicar esta técnica en ambas consolas, One ganaría por absoluta goleada. Pero si aplicamos técnicas más antiguas como un deferred engine PS4 tiene ventaja por su ancho de banda (y de aquí vienen las diferencias en multis hasta ahora en cuanto a resolución o framerate).

A todo esto hay que añadirle que One tiene Full HSA, es decir coherencia total de memoria, algo básico si tenemos más de un contexto gráfico y además GPGPU, porque sí, One puede renderizar dos cosas y hacer GPGPU AL MISMO TIEMPO y compartiendo la MISMA memoria. Y esto es MUY potente y da una serie de posibilidades únicas.

¿Bien... significa todo esto que One doblará su rendimiento?: NO. One doblará su rendimiento GRÁFICO en múltiples tareas gráficas pero el rendimiento GLOBAL de un juego no SÓLO depende de la GPU. Hay muchos otros factores: CPU, memoria, técnicas gráficas utilizadas...

Ahora bien, si a mi se me pregunta: ¿Cuánto crees en promedio que mejorará el rendimiento de One?. Sinceramente y, bajo MI opinión, One incrementará con DX12 el rendimiento entre un 50 a un 75%.

Sorry por el tocho y espero haber dejado bastantes cosas claras.

darksch escribió:@shaderyt en XOne la CPU tiene un acceso de coherencia de datos de 30 GB/s. Así que ni vueltas ni nada raro. Respecto a GPU, ya acaban de responder. Así que podría decirse que sí que es Full HSA, con un ancho de 30 GB/s desde la CPU.

shaderyt escribió:Sobre la otra pregunta de los GCPs y CCP

Arriba a la izquierda tienes la respuesta, cada circulo son los ``graphis´´ y cada recuadro son los ``compute´´. Blanco y en botella.

Ya veo por donde tirais, en cuanto alguien dice algo a favor de la one es una fuente fiable de informacion, en cuanto alguien lo duda es que debe de ser un troll, madre mia no he puesto ni un post y ya me vienen a cuchillo. Ya se me habia olvidado porque no me gustaban estos debates en consolas, pero tranquilos ya os dejo tranquilos con vuestras targiversaciones de informacion.

Ave_fenix Pr 77 escribió:pspskulls escribió:Bueno, dado el despropósito al que se está llegando en este hilo voy a explicar lo que significa el PDF famoso.

Primero unas preguntas y respuestas rápidas importantes para entender la explicación:

- ¿Tiene Xbox ONE doble GPU?: NO.

- ¿Reserva ONE CPs o CUs para el sistema?: NO.

- ¿Podemos tener una GPU que admita multihilo sin tener doble contexto gráfico?: SI. Podemos tener 2 CP pidiendo tareas a la GPU y la GPU irá realizando las tareas pero no simultáneamente (por ejemplo pensad en un núcleo de CPU de 2 hilos, lo que ejecutan no es simultáneo sino que los hilos cogen la capacidad de proceso según el otro hilo ya no lo necesita). Para que una GPU realice dos tareas GRÁFICAS en paralelo DEBE tener 2 contextos gráficos (no podemos pintar en un lienzo en dos puntos al mismo tiempo si no tenemos dos pinceles). Resalto gráficas porque una GPU puede realizar GPGPU al mismo tiempo que renderiza.

Aquí habláis desde la teoría pero no desde la práctica., y es por eso que no se entiende el porqué de la estructura de One. Para entender la tecnología hay que entender el rendering, el porqué y el cómo se hacen las distintas técnicas actuales y futuras. El factor determinante es el doble contexto gráfico. Ésto es MUY importante, la clave es la palabra "gráfico".

Un ejemplo muy sencillo de renderizado de sombras seria: CPU prepara y pide crear una sombra de un objeto, la GPU entra en juego y la genera. Y así sucesivamente por cada sombra. Hay que tener una cosa MUY clara, renderizar una sombra no necesita PARA NADA los 12 CUs de la consola, ni por tener 12 o 18 va a renderizarla más rápido, una sombra necesita una capacidad de cómputo determinada y que posiblemente con 1 única CU nos bastaría. El problema es que cuando se renderiza se OCUPA la GPU, por lo tanto aunque no necesitemos los 12 CUs, los 12 CUs se van a bloquear para poder pintar la sombra. Obviamente podemos distribuir los CUs, y decir que sólo queremos usar un máximo de CUs para renderizado, y el resto para GPGPU (y aprovechar así el tiempo de renderizado para sacar cómputo). Pero a la hora de renderizar y para los CUs asignados a renderizar TODOS quedan bloqueados.

A partir de aquí C es CPU y G es GPU. Si queremos generar 4 sombras tenemos:

C > G > C > G > C > G > C > G

¿Qué sucede en One?. Que al tener 2 contextos gráficos puede renderizar 2 sombras al mismo tiempo. Con lo que nos queda:

> G > G

C > C

> G > G

Esto es, ni más ni menos, que la mitad del tiempo. ¿Estamos duplicando en este caso el rendimiento gráfico de One?: SÍ. ¿Es One más potente por ello?: NO. La capacidad de cómputo de One es la misma solo que el rendimiento es el doble.

Otro ejemplo seria un engine gráfico basado en tiled forward (http://www.cse.chalmers.se/~olaolss/main_frame.php?contents=publication&id=tiled_shading). Esta implementación se basa en generar el frame final a base de tiles o porciones de pantalla pequeñas (pequeños rectángulos). A parte de las características negativas y positivas de ésta técnica (toda técnica tiene su lado bueno y su lado malo), a dónde quiero ir a parar es en el hecho en el que... teniendo 2 contextos gráficos simultáneos podemos dibujar 2 de esas porciones SIMULTÁNEAMENTE. Con lo que el resultado es que obtenemos el frame en la mitad del tiempo y por tanto doblamos el rendimiento. Aquí también quiero hacer incapié en otra característica única de One: su eSRAM. Dado que esta técnica no requiere de gran ancho de banda, lo que más le beneficia es una memoria RÁPIDA, es decir de bajísima latencia (no confundir RAPIDEZ con ANCHO DE BANDA, no tienen NADA que ver, la rapidez la determina el tiempo para que la memoria vuelva a estar disponible para una nueva petición y ahí importa la latencia, el ancho de banda sólo sirve para MOVER grandes cantidades de memoria de un punto A a un punto B). Quiero decir con esto que de aplicar esta técnica en ambas consolas, One ganaría por absoluta goleada. Pero si aplicamos técnicas más antiguas como un deferred engine PS4 tiene ventaja por su ancho de banda (y de aquí vienen las diferencias en multis hasta ahora en cuanto a resolución o framerate).

A todo esto hay que añadirle que One tiene Full HSA, es decir coherencia total de memoria, algo básico si tenemos más de un contexto gráfico y además GPGPU, porque sí, One puede renderizar dos cosas y hacer GPGPU AL MISMO TIEMPO y compartiendo la MISMA memoria. Y esto es MUY potente y da una serie de posibilidades únicas.

¿Bien... significa todo esto que One doblará su rendimiento?: NO. One doblará su rendimiento GRÁFICO en múltiples tareas gráficas pero el rendimiento GLOBAL de un juego no SÓLO depende de la GPU. Hay muchos otros factores: CPU, memoria, técnicas gráficas utilizadas...

Ahora bien, si a mi se me pregunta: ¿Cuánto crees en promedio que mejorará el rendimiento de One?. Sinceramente y, bajo MI opinión, One incrementará con DX12 el rendimiento entre un 50 a un 75%.

Sorry por el tocho y espero haber dejado bastantes cosas claras.

Todo lo que contradiga esto no son mas que falacias....

En cuanto a herebus de meristation no lo soporto....me parece un personaje de lo mas pedante y estoy seguro que no postea solo en meri.

Están haciendo todo lo posible estos semi-comerciales para enturbiar todo lo posible la realidad.

Que no es otra que microsoft se ha gastado con amd 3.000 millones para llevar algo que ps4 no lleva dentro.

Y punto.