Wookiee escribió:Y bueno, contaras tus verdades, que son tan discutibles como las de cualquiera. Para mi es una verdad que si te cambian a pelo la tuya por una 3080 pierdes el culo, del mismo modo que tambien es una verdad que otra cosa es que fueras a reconocerlo.

![adios [bye]](/images/smilies/nuevos2/adio.gif)

garbaje_de_potanzos escribió:@Nomada_Firefox No se no me viene a la mente otro juego así bruto con las texturas y memoria, aunque recuerdo que Control ponerlo con RTX y ajustes altos me ponía las texturas borrosas a veces, sería curioso verlo correr en una 3080 a 4k a ver si hace lo mismo.

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

Escenario

Se pregunta si son 10 GB suficientes en un 3080.

-Los usuarios imparciales del foro comienzan a explicar que 10 GB son suficientes en el 99,9 % de los escenarios.

-Muchos explican que prefieren el precio más bajo que se les ofrece al tener menos vram y que el vram adicional se suma al costo de la tarjeta y el costo adicional no vale la pena para ellos.

-Algunos explican que incluso después de dos años, todavía hay un solo juego que vale la pena jugar y que necesita más de 10 gb.

-Otros explican que el problema con el 3080 es que se queda sin gruñido antes que vram la mayoría de las veces.

Una vez que hemos llegado a esta etapa, puede ocurrir una de tres cosas; aceptación, deflación o negación.

*Aceptación

El usuario acepta las razones expuestas anteriormente y sigue adelante.

*Desviación

Los usuarios del foro ignoran los ejemplos provistos y se desvían usando una pregunta que está diseñada de tal manera que se necesita un solo ejemplo de 10 gb que no son suficientes.

Un título patrocinado por AMD llamado Godfall (un juego en el que nadie aquí en este foro está interesado) se usa ampliamente para responder a esta pregunta cuidadosamente construida mientras se espera que surja algo bueno (ningún otro juego obligatorio lo hace).

Otro título patrocinado por AMD que no cumple con las expectativas pero es mejor que Godfall comienza a usarse.

De repente, Godfall ya no se usa como ejemplo como si ni siquiera existiera y Far Cry 6 se convierte en el nuevo poster child que se usa exclusivamente para responder a esta pregunta.

Los usuarios imparciales intentan explicar una vez más que la cantidad de personas interesadas en jugar FC6 y resulta ser un 4K es muy pequeña. En este punto llegamos a la negación.

*Negación

No me importa lo que digan los demás, no se alinea con mis creencias y, por lo tanto, seguiré impulsando mi narrativa usando mi pregunta cuidadosamente enmarcada cada vez que surja el tema.

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif) De buen rollo, un saludo!

De buen rollo, un saludo! BladeRunner escribió:RTX 4080: un 70% más rápida que la RTX 3080 ¡y con el mismo consumo!

https://elchapuzasinformatico.com/2022/ ... endimiento

- Buena noticia para nuestros bolsillos (factura de la luz) y para el planeta...

- ... a no ser q por la nueva relación hashrate/consumo el minado se vuelva factible, otra vez

- Si aparece a buen precio, corran a comprarla, insensatos!

Sobre la Vram, mejor curarse en salud y partir de 12GB en adelante.

JaviGabber escribió:No quiero seguir ensuciando el hilo pero es que este mensaje del foro overclockers sobre los 10 GB de la 3080 esta gracioso![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

Tienen un hilo de mas de 300 paginas sobre el tema https://forums.overclockers.co.uk/threads/10gb-vram-enough-for-the-3080-discuss.18897519/page-314

@Nomada_Firefox Tio para animar el foro eres el numero uno, me da pereza debatir contigo de las perlas que sueltasDe buen rollo, un saludo!

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Adorando [tadoramo]](/images/smilies/adora.gif) . La mejor compra a nivel de hardware que he hecho en mi vida, y ademas es el modelo que quería desde que se anunciaron las 3000 y se supo que se lanzaría.

. La mejor compra a nivel de hardware que he hecho en mi vida, y ademas es el modelo que quería desde que se anunciaron las 3000 y se supo que se lanzaría.![adios [bye]](/images/smilies/nuevos2/adio.gif)

![Ok! [oki]](/images/smilies/net_thumbsup.gif)

EMC2 escribió:El Ray Tracing ya esta bien implementado en pc.

Nomada_Firefox escribió:Dirás bien mal implementado porque funcionar funciona pero chupa fps como una loca.

PHANTASIA escribió:La verdad que reducir a la mitad los frames al activarlo no lo llamaría yo "bien implementado".

battman80 escribió:El hilo yo diría que está saliendo calcado al del año pasado de las RTX3000, clónico. Mismas verdades, mismas chorradas, mismas excusas, mismos envidiosos hipócritas, etc etc etc.

A ver esas 4000 jugosas si salen de verdad este año y a que precios. Si se cumple un poco lo que se va filtrando y tal, basicamente son GPUS para ir pensando ya en el 8k como algo muy real y palpable, porque en el tema rendimiento de RT, por mucho que mejoren, y debido sobre todo al "lastre" que son las consolas, pocos estudios o ninguno se van a molestar en mejorar la implementacion del trazado de rayos en las versiones de PC de los juegos.

Bueno, para ir pensando en el 8k me refiero con graficos ya en calidades top, y por supuesto, para ir viendo como algo asequible (pagandolo claro, entiendase) los 4k 120 e incluso mas.

Yo he tenido todo tipo de graficas, unas veces mejores, otras peores, pero siempre LA MEJOR que me he podido permitir en cada momento, y nunca me he arrepentido ni me he sentido insatisfecho ni he pensado que jugando en calidades medias o a 40 frames o a menos resolucion me sobraba. Por eso se les tilda de productos "entusiastas", como pasa con cualquier tipo de producto, desde un colonia, hasta unas gafas de sol, pasando por muebles, coche, ropa y hasta mascota. Cada uno es feliz con lo que le mueve la patata, y no hay mas infeliz, por desgracia, que el que quiere algo que no se puede permitir, siendo yo el primero infeliz en ese sentido en multitud de escenarios. Pero no reconocer eso y saltar a las excusas y las teorias de la conspiracion, yo siempre lo veré absurdo y nunca, nunca, me lo creere. No creo que nadie prefiera "por que sí" pan y cebolla a un buen filete, un buen pescado, o el mejor tofu, que se yo. Se entiende la idea.

Mi ultima compra fue a un compi en estos mismos foros, una 3090 que tuvo el detalle de venderme a precio de lanzamiento a pesar de que en ese momento ya estaba subiendo la especulacion como la espuma, y aunque nme han hecho ofertas realmente fuera de sentido (3000 euros, una locura) no la he vendido porque no me ha dado la gana, porque no necesitaba expresamente ese dinero y muy mucho por respeto al compañero que me la vendió a pesar de recibir ofertas mas altas durante los dias de los tratos, por haberse comprometido primero conmigo. Y oye, venía de una 2080Ti y SI HE NOTADO MUCHISIMA MEJORA. Ostia que si se nota como cambia la cancion![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

. La mejor compra a nivel de hardware que he hecho en mi vida, y ademas es el modelo que quería desde que se anunciaron las 3000 y se supo que se lanzaría.

Evidentemente, yo no la uso solo para jugar, tambien para algo de edicion y sobre todo creacion 3d, render y animacion, y es la polla tener, a nivel "amateur", un maquinon asi, el cambio en los tiempos de produccion de los trabajos y el aumento de posibilidades en las cosas que puedo hacer, son otro mundo. Ahora, ya acostumbrado, a veces se me queda "corta", porque llevo el limite tan tan mas allá, que ni la 3090 puede, pero como yo, en mi perfil de usuario, ya he llegado a ese limite, y lo estoy deseando rebasar, tengo claro como el dia que en cuanto se concrete que las 4090 existen y van a salir, me tiro a por ellas de cabeza. Ahora mas que nunca tengo cero dudas de que es una inversion de la que no me voy a arrepentir, porque yo tambien pensaba que "total" de la 2080Ti a la 3090 tampoco iba a notar tanto cambio... Y sí.

Todo está en el tema del perfil de usuario que seas. Pero en esto del hard, de las gpus, y en especial centrado en el gaming, que narices, si te dan una tope de gama, DADA, nunca vas a decir "no gracias prefiero la gama media". No te preocupes, que si la tienes ya encontraras la forma de explotarla, si sabes que terreno pisas y realmente estas dentro de este mundillo al 100%. Otra cosa son esas personas que porque se lo pueden permitir, van por ahi comprando GPUS del calibre que comento para jugar al lol a 1080, y cosas parecidas, y acaban en foros como este llorando y quejandose por las esquinas de lo mucho que han invertido y lo poco que han sentido. Si sabes lo que quieres, y sabes lo que compras, conforme contigo mismo, lo mismo eres feliz con una 770 que con una 3090 o una 6900XT.

Si eres deshonesto contigo mismo, o quieres abordar cosas que te sobrepasan, acabas en los foros poniendo pegas y buscandole tres pies al gato.

![adios [bye]](/images/smilies/nuevos2/adio.gif)

![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

JagerCrow escribió:Viendo lo que se dice de que no renta comprar de salida una gráfica tope de gama, yo creo que eso tiene matices porque si uno compra pensando en cambiar a penas salga algo más potente pues no tiene mucho sentido para eso uno se compra lo que de el rendimiento que uno busca ejemplifiquemos el asunto con las ultimas graficas de nvidia en el escenario de 1080p ultra con juegos actuales de los cuales ya dejé una imagen en este hilo más sin embargo dejo el link y los escalados de ganancia en porcentaje de techpowerup comparados con la 3080 Ti

30% - GTX 980 TI - JUNIO 2015 - no llega a los 40fps

50% - GTX 1080 TI - MARZO 2017 - entre 60fps Y 80fps

64% - RTX 2080 TI - SEPTIEMBRE 2018 - entre 80fps y 100fps

100% -RTX 3080 TI - MAYO 2021 - supera los de 120 fps

el punto es que por ejemplo el compro una GTX 980 Ti de salida es la persona que debería estar pensando en un upgrade después de 7 años y cualquier cosa por encima de una RTX 3060 ya es ganancia, las demás graficas aún son competentes a día de hoy y no encuentro realmente un motivo de peso para tener que cambiar a día de hoy el punto es que se puede jugar bien

entiendo que exista gente que se pueda permitir tener siempre lo más top y pague por ello lo que le corresponda, pero eso no quiere que no rente a un usuario de a pie tener una gráfica tope de gama y tenerla hasta el momento que ya no le permita jugar en las resoluciones y calidades que uno quiera o este acostumbrado

estoy de acuerdo es que uno va estar cambiando para no quedarse "desactualizado" uno no compra lo más top uno compra lo que le da el rendimiento que necesite.... pero si la idea es ir haciendo upgrade uno tarde o temprano terminara llegando a las gráficas tope de gama porque uno no cambia pan por pan y llegado a ese punto te das cuenta que no necesitas una gráfica tope de gama para tener una buena experiencia de juego y el ciclo vuelve a repetirse

Ahora como punto aparte los sigan pensando que el Raytracing solo va por la iluminación y sombras y dicen que eso no renta y que la mejora no es mucha y etc etc etc y si miras los resultados no pueden tener mas razon.. pero eso no está solo para tener mejores gráficos... esta para poder simplificar el desarrollo de juegos y lograr tener un único sistema donde el desarrollador pueda crear sus proyectos... y pues como todo entra por los ojos pues no lo venden como una mejora gráfica y es más que eso, creo que nate gentile es que, más fácil lo ha explicado en su video "Lo que NO te contaron sobre Ray Tracing" lo dejo por aca si a alguien le interesa informase mas

y con respecto a las correcciones que se están haciendo con respecto a las especificaciones se las RTX 4000 no se supone que básicamente ya entraron en producción para las que ya se van a vender este año sea cuales sean..ósea yo lo veo raro.. no creo que en la planta les digan oigan cambiamos las especificaciones paren todo ajusten lo que ya se hizo y las nuevas se hacen ya con los cambios... porque dudo mucho que eso funcione así.... parece que nos estuvieran haciendo una trolleada pero monumental... o que nvidia necesita mantener las expectativas altas porque AMD como que tienen el asunto mejor resuleto, digo asi una como mi opnion

EMC2 escribió:El Ray Tracing esta muy bien implementado en realidad, ya de primeras esta muy optimizado (recortado en palabras tecnicas) para que corra en tiempo real en juegos.

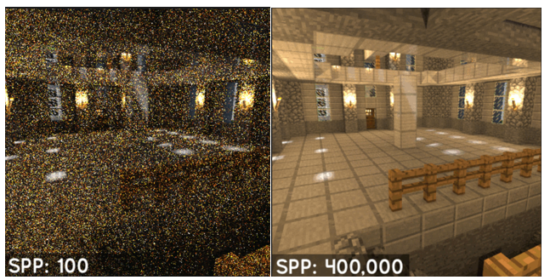

El Ray Tracing completo/puro es increíblemente costoso, y no exagero:

- El Ray Tracing o patchtracing esta diseñado para calcular miles de rayos por cada pixel, para tener un pixel limpio, se puede necesitar hasta de 100 o hasta 50,000 rayos por cada pixel, una resolucion de 1080p ya tiene 2 millones de pixeles, y imaginate la burrada de cálculos que tendria que calcular una GPU, ni en 20 generaciónes de GPU se tendria potencia para mover algo asi....en la peliculas se usan granja de CPU o GPU que pueden tardar minutos en muestrear una imagen y dejarla suave sin ruido, para un juego necesitas al menos un tiempo de 30ms(30fps).

- En el Ray Tracing para juegos eso se recorta de forma brutal, y en juegos generalmente se usan 1 o 3 rayos por pixel, esto genera una imagen ruidosa, pero ahi entra el filtro denoising para limpiar la imagen .

- Y por ultimo el Ray Tracing de juego esta recortado en temas con cantidad de reflejos secundarios o número de rebotes de la GI, que es muy pesado.

En este imagen se puede apreciar lo que comento arriba, para tener Ray Tracing full necesitaría muchísimos rayos/samples por pixel (SPP).

.

.JagerCrow escribió:@wwwendigo mira compañero yo no me voy a poner a discutir resultados porque en el mismo link del articulo donde esta esa imagen están los juegos y las pruebas donde corrieron y los settings etc etc y no tengo motivos para poner en dudas el trabajo hecho por los chicos de tom's Hardware y ponen lo siguiente| y dejo el link para el que quiera verlo

"The eight games we're using for our standard GPU benchmarks hierarchy are Borderlands 3 (DX12), Far Cry 6 (DX12), Flight Simulator (DX12), Forza Horizon 5 (DX12), Horizon Zero Dawn (DX12), Red Dead Redemption 2 (Vulkan), Total War Warhammer 3 (DX11), and Watch Dogs Legion (DX12). The fps score is the geometric mean (equal weighting) of the eight games."

He tenido de las gráficas enunciadas la EVGA GTX 980 Ti FTW, la MSI GTX 1070 Gaming X y la Vega 64 de Sapphire FE y desafortunamente no probe personalmente ninguno de los juegos mencionados con esas graficas asi que no puedo dar una opinion, podría decir que los mass effect o los dead space pero básicamente todos esos juegos rinden igual o en el PUBG don la unica que rinde un poco mas es la Vega, asi que supongo que la idea de la prueba era meter juegos mas recientes

pdriko31 escribió:Perdonad por el offtopic, pero a final de año quiero renovar el pc, sabéis cuando salen las raptor lake? Creo que se llama así la nueva cpu de intel.

DarkMessiah escribió:pdriko31 escribió:Perdonad por el offtopic, pero a final de año quiero renovar el pc, sabéis cuando salen las raptor lake? Creo que se llama así la nueva cpu de intel.

Mr. Google dice que presentación finales de Septiembre y lanzamiento 17 Octubre.

Intel Raptor Lake se lanzarán el 17 de octubre, es decir, casi 3 semanas después de la presentación oficial durante el evento Innovation. En esta fecha, Intel lanzará sus CPUs de la serie K de la 13ª generación de Core «Raptor Lake-S» junto con las placas base de gama alta Z790.

Namaskar escribió:@wwwendigo Yo también hice muchos testeos con la 980ti vs la 1070 / 1080 y diría que está entre ambas. Si se aprieta bien la 980ti sigue dando el callo. La mia subía a 1620mhz con una bios custom que cocine yo mismo.

Pasa un poco lo mismo con la 2080ti que está entre la 3070 / 3080 al menos bajo mis testeos y las he tenido todas.

Para mi sorpresa antes de agenciarme la 3090ti recientemente estuve testando una 1660ti y la verdad que rinde fenomenal con oc muy cerca de la 1070.

Todo ello lo baso siempre en mis propios testeos que trato de hacer con el máximo rigor y siendo muy objetivo, ya que no me muevo por intereses y no arrimo la sardina al ascua que más calienta como si hacen algunas sites. Me fio mucho más de mis resultados que los de cualquier otra site por muy conocida que ésta sea.

Recuerdo aquellos testeos que hice para ti con el 2way sli de las Titan Black para tu blog hace años. Me lo pasé pipa haciendo pruebas.

Un saludo wendigo hace años que no te veía por aquí , me alegra leerte de nuevo.

![adios [bye]](/images/smilies/nuevos2/adio.gif)

EMC2 escribió:Estaba viendo este video, y que poco consumian la serie GTX900 no, comparado con los consumos de hoy en dia. Aunque tambien hay que decir que desde las GTX600 Nvidia hacia trampa debido a la potencia de su arquitectura respecto a la de AMD, Nvidia usaba los chips gama-media(GM204) para venderlos como gama-alta, la GTX 980 usaba el chip destinado para las GTX 960, por eso el consumo corresponde al de una gama media, eran versiones x80TI las que llevaban el chip gama-alta (GM200).

https://youtu.be/94EwxzqncAo

Namaskar escribió:@wwwendigo Yo también hice muchos testeos con la 980ti vs la 1070 / 1080 y diría que está entre ambas. Si se aprieta bien la 980ti sigue dando el callo. La mia subía a 1620mhz con una bios custom que cocine yo mismo.

Pasa un poco lo mismo con la 2080ti que está entre la 3070 / 3080 al menos bajo mis testeos y las he tenido todas.

Para mi sorpresa antes de agenciarme la 3090ti recientemente estuve testando una 1660ti y la verdad que rinde fenomenal con oc muy cerca de la 1070.

Todo ello lo baso siempre en mis propios testeos que trato de hacer con el máximo rigor y siendo muy objetivo, ya que no me muevo por intereses y no arrimo la sardina al ascua que más calienta como si hacen algunas sites. Me fio mucho más de mis resultados que los de cualquier otra site por muy conocida que ésta sea.

Recuerdo aquellos testeos que hice para ti con el 2way sli de las Titan Black para tu blog hace años. Me lo pasé pipa haciendo pruebas.

Un saludo wendigo hace años que no te veía por aquí , me alegra leerte de nuevo.

kikomanco escribió:Namaskar escribió:@wwwendigo Yo también hice muchos testeos con la 980ti vs la 1070 / 1080 y diría que está entre ambas. Si se aprieta bien la 980ti sigue dando el callo. La mia subía a 1620mhz con una bios custom que cocine yo mismo.

Pasa un poco lo mismo con la 2080ti que está entre la 3070 / 3080 al menos bajo mis testeos y las he tenido todas.

Para mi sorpresa antes de agenciarme la 3090ti recientemente estuve testando una 1660ti y la verdad que rinde fenomenal con oc muy cerca de la 1070.

Todo ello lo baso siempre en mis propios testeos que trato de hacer con el máximo rigor y siendo muy objetivo, ya que no me muevo por intereses y no arrimo la sardina al ascua que más calienta como si hacen algunas sites. Me fio mucho más de mis resultados que los de cualquier otra site por muy conocida que ésta sea.

Recuerdo aquellos testeos que hice para ti con el 2way sli de las Titan Black para tu blog hace años. Me lo pasé pipa haciendo pruebas.

Un saludo wendigo hace años que no te veía por aquí , me alegra leerte de nuevo.

como te han cazado de nuevo Cilclito, si es que se te veia a leguas que eras tu con una cuenta clon, venga, que descanses una temporada hasta que vuelvas a la carga con otra cuenta clon

![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

JagerCrow escribió:@wwwendigo sabes haciendo un poco offtopic y según lo que dices de las GTX 980 ti, GTX 1070 (que las tuve ambas) y la GTX 1660 Ti que básicamente se mueven en su rendimiento dentro del mismo margen y con sus diferencias y mejoras según generación, pero al final entregan una experiencia muy igualada.... y el punto es que veo y recuerdo que hay gente/usuarios/personas que toman esas rutas de "upgrade" y pues como que no veo una razon de peso del porque...porque al final tienes nuevo pero te rinde básicamente igual

Voy a hacer un ejercicio mental supongamos que una persona X entra al mundo del pc recien estuvieron disponibles serie 3000 y serie 6000 todos los modelos y se compra lo mejor en precio/rendimiento en ese momento para jugar entre 1080p a 2160p con 60fps en promedio

Creo que sabiendo ajustar iríamos asi:

Nvidia = RTX 3060 Ti

AMD = RX 6700 XT

ahora de cara a la nueva generación de graficas la idea es ir un escalón por encima para justificar el salto en rendimiento no mantener se en la misma gama/serie o buscar dentro de la nueva generación el rendimiento equivalente a lo que ya poseemos

mi punto es, que si realmente cambiamos hardware por hacer un upgrade que valga la pena partiendo desde XX60 o XX70 en 2 o 3 generaciones o si sale un buen descuento se llegara inevitablemente a los topes de gama, que si rente o no que si es necesario es discutible, pero tomando que por lo general la serie/gama XX70 vienen siendo equivalente al tope de gama de la generación anterior y pues visto lo visto ahí es donde está el punto dulce donde te puedes mover bien en la experiencia de juegos a distintas resoluciones y con buenos fps, según como se mire puede ser malo o bueno estar cambiando de hardware o incluso si esperas a que te pida cambio igual por la diferencia de precios entre gamas terminas gastando el mismo o más dinero

es más, siendo objetivos la forma es que se separan las gamas/series en una generación con respecto a la otra están pensadas para que igual sientas que debes cambiar de hardware ya sea que compres lo más top o lo precio/rendimiento igual vas a estar por detrás con un número que te indicara que ahora haciendo la equivalencia estas en un escalafón inferior....

se que a mucha gente no le gusta pensar en estas cosas, y que hay muchas maneras de justificar un "upgrade" y que cuando se tienen 60fps queremos llegar a 144fps y luego a 240fps y luego 360fps y es el cuento de nunca acabar como si la experiencia en 60fps ya no fuera lo suficientemente buena para la mayoría de mortales, lo mismo con las resoluciones, a veces entiendo y me quedo con las limitaciones de las consolas hablando de juegos... porque si a la final lo importante es jugar y no se desde cuando quedo y es más importante la performance que la experiencia de juego porque ya a partir de las consolas tenemos "mínimo aceptable" no es entrar en discusiones ni nada... es ser realistas y mirar cual es el aporte real de las RTX 4000 o las RX 7000 o serán otra generación de transición hasta que se tenga el hardware lo suficientemente potente para full raytracing... o llegara primero el juego en streaming al mismo nivel de jugar local

JagerCrow escribió:Voy a hacer un ejercicio mental supongamos que una persona X entra al mundo del pc recien estuvieron disponibles serie 3000 y serie 6000 todos los modelos y se compra lo mejor en precio/rendimiento en ese momento para jugar entre 1080p a 2160p con 60fps en promedio

Creo que sabiendo ajustar iríamos asi:

Nvidia = RTX 3060 Ti

AMD = RX 6700 XT

kikomanco escribió:a la noticia que se retrasan las RTX 4000 por mi estupendo, no tengo necesidad ninguna de cambiar mi RTX 3080 que es un tarjeton, de retrasarse al primer trimestre del 2023 no las veo saliendo como muy pronto hasta abril

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif) yo espero que no haya retrasos y en septiembre - octubre sepamos algo más.

yo espero que no haya retrasos y en septiembre - octubre sepamos algo más. Schencho escribió:kikomanco escribió:a la noticia que se retrasan las RTX 4000 por mi estupendo, no tengo necesidad ninguna de cambiar mi RTX 3080 que es un tarjeton, de retrasarse al primer trimestre del 2023 no las veo saliendo como muy pronto hasta abril

No te pica el gusanillo del cacharreo? Yo después de 2 años me apetece meterle algo más cañero. Tengo también una RTX 3080 y va de locos para 1440p. En el 99% de los casos puedes rondar los 90 - 120fps en los juegos más exigentes aplicando en algunos casos DLSS o similares. La verdad es que es una locura lo que rinden pero de vez en cuando entro a ver qué nuevas tenemos con la futura RTX 4080 o 4090...yo espero que no haya retrasos y en septiembre - octubre sepamos algo más.

nikocrazy escribió:No tiene mucho sentido empresarialmente posponer tanto tiempo la siguiente generación cuando tienen que rentabilizar la inversión y cumplir con inversores.

La actual generación probablemente este amortizada y tiene que seguir girando la rueda, además tienen la competencia de su rival para este año con lo cual no creo que se relajen. Un retraso siempre es posible pero dudo que sea uno tan largo.

Saludos.

JaviGabber escribió:Si no me he equivocado mirando las rtx 2000 se presentaron el 20 de agosto y las rtx 3000 el 1 de septiembre. Al parecer Nvidia va a seguir en esta línea o sea que perfectamente aún pueden lanzarse en septiembre/octubre.

Que aún no se sepa nada salvo filtraciones es lo normal.

Es cierto que el silencio de los últimos días es sospechoso... Aunque las supuestas bajadas de precio indiquen que quieren limpiar stock .

Yo tengo una 3080 desde diciembre del 2020 y soy de los que tengo ganas de ver algo nuevo .

Pd: ¿De AMD se sabe algo?

JaviGabber escribió:Si no me he equivocado mirando las rtx 2000 se presentaron el 20 de agosto y las rtx 3000 el 1 de septiembre. Al parecer Nvidia va a seguir en esta línea o sea que perfectamente aún pueden lanzarse en septiembre/octubre.

Que aún no se sepa nada salvo filtraciones es lo normal.

Es cierto que el silencio de los últimos días es sospechoso... Aunque las supuestas bajadas de precio indiquen que quieren limpiar stock .

Yo tengo una 3080 desde diciembre del 2020 y soy de los que tengo ganas de ver algo nuevo .

Pd: ¿De AMD se sabe algo?

JagerCrow escribió:se que no es para mi, y perdón yo me meto... pero si en unos meses yo llego a ver una RTX 3090 / 3090 TI en 400 dólares y en contradicción a todo lo que he dicho y a sabiendas de no necesitarla si tengo el dinero disponible y está la oferta yo la compro, cuando tuve la GTX 980 ti y la vega 64 puedo decir que daba cierta seguridad tener el tope de gama del momento pajazos mentales que se hace uno pero bueno

@Nomada_Firefox pues hombre realmente no se con respecto a las afirmaciones que haces y la verdad es ponerse a discutir sobre eso cuando al parecer dependiendo de cómo haga uno las pruebas, puede decir o darse razon para cualquier escenario, entonces lo dejo hay... pero lo que si se es que siguen siendo válidas para una buena experiencia de juego ahora y en el futuro cercano ósea no es que no pueda jugar con ellas