Blackpo92 escribió:Es algo inminente, las consolas ya lo traen y son las que marcan el camino.

DaNi_0389 escribió:Joder pues esta bastante bien, con lo que se venía comentando estos días no esperaba que una 6800 rindiese algo más que la 2080Ti activando Raytracing.

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

Eilex_D escribió:Merece la pena la diferencia de la 6800 vs la 6800XT? Mi idea es para jugar a 1440p

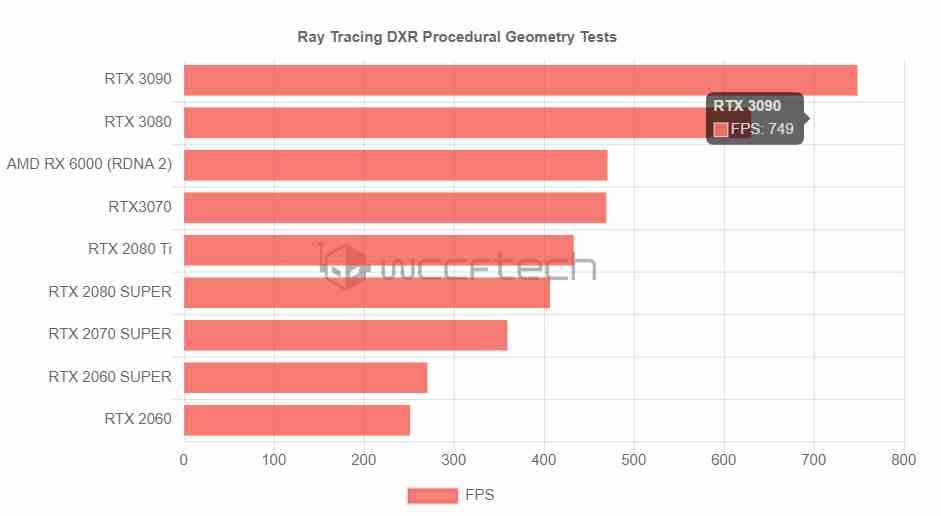

kalanndrakas escribió:"El rendimiento no es excelente, pero esto se debe al hecho de que Ray Traced Shadows Quality se estableció en High". lol .. si es cierto, en realidad está cerca de la 3080 con RTX encendido y es la 6800!!! Y con un ryzen 5 3500...no me voy a hyper... No me voy a hypear... No me voy a hypear..

NicOtE escribió:willygermo escribió:Pacorrr escribió:El G-Sync lo pierdes al ser tecnología privativa y cerrada, hasta que algún día a Nvidia le dé por abrirla cosa que dudo mucho que haga.

No habia pensado yo en eso, otro con un monitor con g-sync por aqui. Ufff, pues ya no tengo tan clara mi elección...

Y he aquí el por qué de los ecosistemas cerrados estilo Apple que son los expertos en esta mierda.

Pero a lo que quería contestar realmente. No existe la opción de Gsync Compatible o eso solo funciona con grafica NVIDIA y monitor Freesync? Y no con grafica Radeon y monitor GSync?

AzagraMac escribió:DaNi_0389 escribió:Joder pues esta bastante bien, con lo que se venía comentando estos días no esperaba que una 6800 rindiese algo más que la 2080Ti activando Raytracing.

la 6800 es la que tengo fichada... me largo de NVIDIA![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

https://www.gigabyte.com/Graphics-Card/GV-R68-16GC-B#kf

neox3 escribió:kalanndrakas escribió:"El rendimiento no es excelente, pero esto se debe al hecho de que Ray Traced Shadows Quality se estableció en High". lol .. si es cierto, en realidad está cerca de la 3080 con RTX encendido y es la 6800!!! Y con un ryzen 5 3500...no me voy a hyper... No me voy a hypear... No me voy a hypear..

Lo que no entiendo es, como han activado el raytracing en tomb raider, si solo tiene compatibilidad para RTX porque el DXR ha salido mucho mas tarde...

Pacorrr escribió:neox3 escribió:kalanndrakas escribió:"El rendimiento no es excelente, pero esto se debe al hecho de que Ray Traced Shadows Quality se estableció en High". lol .. si es cierto, en realidad está cerca de la 3080 con RTX encendido y es la 6800!!! Y con un ryzen 5 3500...no me voy a hyper... No me voy a hypear... No me voy a hypear..

Lo que no entiendo es, como han activado el raytracing en tomb raider, si solo tiene compatibilidad para RTX porque el DXR ha salido mucho mas tarde...

Shadow of the Tomb Raider es DXR desde hace bastante tiempo.

battman80 escribió:

Eso con que Ti?¿ Que configuracion?

Porque nada mas ver la cifra ya se yo que es falsa...O a ver como la sacan.

No os creais todo lo que se publique estos dias, y menos lo que venga de China, que esto es como los dias previos a las reviews autenticas de las Ampere, que se vió DE TODO y luego mas de la mitad era falso hasta la medula.

Yo estoy como algunos por aqui, dudando todavia, porque voy muy bien armado y no tengo prisa en el cambio, pero cuando lo haga posiblemente sea apuntando a lo maximo, asi que dudo del verdadero potencial de estas 6000, ya que la unica que me parece realmente interesando es la 6900XT frente a las Ampere, pero está bastante claro que su rendimiento en RT va a ser bastante inferior. El hecho de que la propia AMD lo oculte es un buen indicativo.

Ya va a depender de cada uno si valoramos mas los x frames de mas que nos de la 6900XT frente a una 3080 o una 3090 incluso, o el hecho de no tener que vernos habiendo gastado 1000+ en una gpu de futuro, y tener que estar renunciando a RT en juegos como Legion, por ejemplo, donde ya el impacto visual es mas que notable entre usarlo y no usarlo (y no se basa en "reflejitos en charchos y cristales"), o bajando resoluciones para poder usarlo con soltura...

Por ahora es todo muy confuso, pero desde mi punto de vista, y conociendo todo lo que hay alrededor, y el tema de los zen3, que suponen plataforma desde cero para tener procesadores que no se van a explotar, porque con los actuales vamos sobradisimos para todo lo que queda de gen, es la 6900XT o ninguna.

![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

battman80 escribió:@Pacorrr gracias, es lo que queria saber, que presets tenia, porque el anisotropico mismo lo tienen a 8x y yo a 16x. Vamos a ver con el preset ultra.

@pmol yo vengo de una RX 580 DE 8GBS, una 2070s y ahora la Ti. El CAS y DLSS NO TIENEN NADA QUE VER. Y eso de que "no se nota la diferencia en la calidad" es absolutamente falso. El Cas viene a ser lo mimo que haces con una gpu Nvidia activando desde el panel de control (o ingame) el reescalado por GPU y lo ellos llaman "enfocar o nitidez" junto al degraining. El resultado NO TIENE QUE VER. Tu pones MK11 con el CAS cpm 580 y rescalando de 1080 a los 4k de mi panel actual y se ve borroso que te cagas. El DLSS no es que se vea mejor que el cas, esque MEJORA LA CALIDAD DE IMAGEN con respecto del 4k normal. Estos dias a salido WD Legion, es otro ejemplo claro de esto. Es poner el DLSS, en rendimiento, ni siquiera es necesario calidad, y la imagen gana una definicion que flipas.

Por supuesto, SINO PUEDES COMPARAR, mal no se ve, pero cuando ves la diferencia, no puedes vivir engañandote, sino en la comunidad de PC vamos a terminar como en la de consolas, creyendonos los cuentos que nos interesen para justificar nuestras compras. No se puede comprar CAS con DLSS por mucho que el movimiento de marketing de AMD lo haya puesto ahora a la vista como para hacer ver que algo tienen comprable, porque no tiene nada que ver, pero ni remotamente, ni los resultados son comparables en absoluto, siendo honestos y realistas, y sin excusas y condicionantes.

Otra cosa es esperar a esa tech que tiene AMD que dice que implementará mas adelante via update, pero esque cuando empezamos con esas promesas, la validez que le doy es la misma que a Nvidia con aquello que dijo de los ssd y sus Ampere. Es la tipica cosa que va pasando el tiempo y se pierde en el olvido, porque de tenerlo, no tendrian listo ya, que las gpus no empezaron a desarrollarlas el mes pasado, llevan años preparando estas gpus.

Sabemos cuando van a liberar reviews??? Cuando van a enviar gpus a los tipicos de youtube para que nos digan realmente que hay? Tengo poco tiempo ultimamente con el trabajo y no he tenido tiempo de ojear canales a ver si los youtubers han dado fechas.

Voy a testear lo del Tomb

, no me lo tomo como nada personal hombre ni he dicho que mientas ni nada de lo que comentas. Solo explico, porque entiendo y veo que muchos no conocen la diferencia, que "fidelyty cas" NO ES NADA. Es una chuminada campera que se invento AMD (el nombre) porque lleva en su software desde hace eones, antes de todo este rollo del 4k, el rtx y todo lo demas. Siempre ha estado ahi. Es un simple "reescalado de la imagen" con un filtro de nitidez, como el que tiene cualquier tele vamos, para que me entiendas. En un movimiento de MARKETING AMD le puso nombre, y en algun juego asociado, como MK11 por ejemplo y no se si el 10, aparecia como opcion a activar, que ademas, y lo mas bonito, te deja activar aunque no tengas una gpu AMD... Y ya te digo que el resultado es nulo, no notas nada, o no mas de lo que se nota con cualquier filtro de nitidez que apliques mediante injectores tipo rehsade, o a traves del soft de la propia gpu en Nvidia o AMD. Simplemente es eso compañero, y lo explico para que lo sepan quienes no lo saben, porque es obvia la intencion de videos como el del tipo ese que comentas, cuando de primeras no explica esto.

, no me lo tomo como nada personal hombre ni he dicho que mientas ni nada de lo que comentas. Solo explico, porque entiendo y veo que muchos no conocen la diferencia, que "fidelyty cas" NO ES NADA. Es una chuminada campera que se invento AMD (el nombre) porque lleva en su software desde hace eones, antes de todo este rollo del 4k, el rtx y todo lo demas. Siempre ha estado ahi. Es un simple "reescalado de la imagen" con un filtro de nitidez, como el que tiene cualquier tele vamos, para que me entiendas. En un movimiento de MARKETING AMD le puso nombre, y en algun juego asociado, como MK11 por ejemplo y no se si el 10, aparecia como opcion a activar, que ademas, y lo mas bonito, te deja activar aunque no tengas una gpu AMD... Y ya te digo que el resultado es nulo, no notas nada, o no mas de lo que se nota con cualquier filtro de nitidez que apliques mediante injectores tipo rehsade, o a traves del soft de la propia gpu en Nvidia o AMD. Simplemente es eso compañero, y lo explico para que lo sepan quienes no lo saben, porque es obvia la intencion de videos como el del tipo ese que comentas, cuando de primeras no explica esto.Blackpo92 escribió:También comentan que según fuentes fiables parece que van a tener problemas con el stock iguales a los de la serie 3000 de Nvidia:

https://wccftech.com/amd-radeon-rx-6900 ... at-launch/

Saludos

VanSouls escribió:Blackpo92 escribió:También comentan que según fuentes fiables parece que van a tener problemas con el stock iguales a los de la serie 3000 de Nvidia:

https://wccftech.com/amd-radeon-rx-6900 ... at-launch/

Saludos

Una tienda de informática Polaca es una fuente fiable? Por favor vamos a contrastar antes de colgar cualquier cosa

Pacorrr escribió:

Tendrás el DLSS activado imagino.

Los de wccftech han hecho pruebas y les da lo mismo que a ti, con DLSS activado https://wccftech.com/amd-radeon-rx-6800 ... -leak-out/

![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

VanSouls escribió:@Blackpo92 Que Benchmarks chinos hablas?? si yo ni he posteado, ni comparado, ni comentado ni nada sobre ellos, si no respondo es por que no me fio nada de eso y no me gusta perder el tiempo

hades0505 escribió:hh1 escribió:AlterNathan escribió:@hh1 Es que el RT no es una tecnología de Nvidia, como el physx, que lo trae 4 juegos mal contados. Es algo que se va a utilizar sí o sí, además el RT, bien utilizado es espectacular.

De que me sirve a mí, que sin uno de los efectos gráficos me de más fps, si luego rinde, según rumores, como una 2080ti. Ni siquiera el precio la acompaña porque AMD se ha subido a la parra

Ahora mismo, a falta de los análisis, la única ventaja son los 16gb de VRAM.

Saludos.

@Blackpo92

Hay tantas cosas inminentes que luego se queda en nada o tardan la tira de años,que yo no lo tengo tan claro como vosotros.

Sí es cierto que AMD podía haber dado un puñetazo sobre la mesa con mejores precios.Pero si hace eso,no sería AMD.

Ahora,con precios tan similares excepto.enla 6900xt,te crea la duda.

Lo tendría tan sencillo como sacar la 6800XT a 599€.

Se cepillan a la 3070 y a la 3080 del tirón...

Pero es AMD....Yo no sé quién planea ahí las estrategias....

Y luego,me vez de sacra una 6800 al precio de la 3070 sabiendo que es más potente,la ponen más cara para que lo mismo no te compense el sobrecoste.Quién paga lo que vale la 6800 cundo por poco más tienes la xt?????

En fin...AMD

¿The has parado a pensar que de hacer eso, tal vez, venderían a pérdidas o, como mucho, harían break-even?

Tuve que quitarle el sonido para poder concentrarme en los subtítulosBruno Ganz es genio en este papel

battman80 escribió:Pacorrr escribió:

Tendrás el DLSS activado imagino.

Los de wccftech han hecho pruebas y les da lo mismo que a ti, con DLSS activado https://wccftech.com/amd-radeon-rx-6800 ... -leak-out/

Hombre, CLARO, de eso va la cosa, de lo que pagas cuando pagas cada gpu y lo que te da. Es como poder activar, que se yo, la oclusion ambiental, y no hacerlo... Repito que el DLSS no solo nos hace ganar frames, esque, MEJORA LA IMAGEN.

Por eso digo que hay que tener todo en cuenta, y por eso en mi caso, sigo esperando, y no pico con las Ampere, hasta ver bien todo, pero lo de AMD me parece muy cogido con pinzas por ahora.

battman80 escribió:Pacorrr escribió:

Tendrás el DLSS activado imagino.

Los de wccftech han hecho pruebas y les da lo mismo que a ti, con DLSS activado https://wccftech.com/amd-radeon-rx-6800 ... -leak-out/

Hombre, CLARO, de eso va la cosa, de lo que pagas cuando pagas cada gpu y lo que te da. Es como poder activar, que se yo, la oclusion ambiental, y no hacerlo... Repito que el DLSS no solo nos hace ganar frames, esque, MEJORA LA IMAGEN.

Por eso digo que hay que tener todo en cuenta, y por eso en mi caso, sigo esperando, y no pico con las Ampere, hasta ver bien todo, pero lo de AMD me parece muy cogido con pinzas por ahora.

@VanSouls las mismas fuentes son las que avisaron con semanas de antelacion que no habrian Amperes ni para el cura del pueblo, y mira si era cierto. Los partners, las tiendas, son las que van a filtrar y saben este tipo de cosas, y cuanto mas pequeña la tienda, mas fiable, porque son las que no tienen nada que perder. Las que no te lo van a decir son las que quieren cobrar 500 pedidos los primeros 30 minutos, teniendo solo 20 gpus, porque ya tienen tu dinero y ya veran si te consiguen una gpu mas adelante o que, pero ya te han enganchado.

Todo lo que sea hardware,va a tener problemas de Stock, porque muchos componentes provienen de las mismas fuentes, y estan muy mal de produccion con el tema Covid. Lo mismo para las consolas, el Oculus, etc etc

Pacorrr escribió:Y me parece muy bien que lo actives, sólo puntualizo que ese no es el rendmiento puro en RT, entra en la ecuación un reescalado. En rendimiento puro RT, si ese leak es cierto, la 6800 estaría por delante de la 2080Ti y la 3070.

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif) Ya veremos, nos esperan dias de muchas filtraciones en una y otra dirección, hasta que liberen reviews. Con las Ampere mira lo que pasó, ni las malas eran tan malas, ni las buenas eran tan buenas, al final resultó ser lo que el sentido comun indicaba que serían, hasta con la 3090.

Ya veremos, nos esperan dias de muchas filtraciones en una y otra dirección, hasta que liberen reviews. Con las Ampere mira lo que pasó, ni las malas eran tan malas, ni las buenas eran tan buenas, al final resultó ser lo que el sentido comun indicaba que serían, hasta con la 3090.battman80 escribió:@Pacorrr pues con todo a tope

Ya te digo que esa cifra era muy baja.

@pmol perdona, que igual las mayusculas te han hecho malinterpretar el tono, las pongo para destacar, no para exaltar, no me lo tomo como nada personal hombre ni he dicho que mientas ni nada de lo que comentas. Solo explico, porque entiendo y veo que muchos no conocen la diferencia, que "fidelyty cas" NO ES NADA. Es una chuminada campera que se invento AMD (el nombre) porque lleva en su software desde hace eones, antes de todo este rollo del 4k, el rtx y todo lo demas. Siempre ha estado ahi. Es un simple "reescalado de la imagen" con un filtro de nitidez, como el que tiene cualquier tele vamos, para que me entiendas. En un movimiento de MARKETING AMD le puso nombre, y en algun juego asociado, como MK11 por ejemplo y no se si el 10, aparecia como opcion a activar, que ademas, y lo mas bonito, te deja activar aunque no tengas una gpu AMD... Y ya te digo que el resultado es nulo, no notas nada, o no mas de lo que se nota con cualquier filtro de nitidez que apliques mediante injectores tipo rehsade, o a traves del soft de la propia gpu en Nvidia o AMD. Simplemente es eso compañero, y lo explico para que lo sepan quienes no lo saben, porque es obvia la intencion de videos como el del tipo ese que comentas, cuando de primeras no explica esto.

Por comparar, se puede comprar el CAS con el escalado de GPU y Nitidez de Nvidia (que no tiene nombre, como no tenia el de amd, pero mañana Nvidia podria llamarle CHUFLIX PTR y parecería mas de lo que es), pero con el DLSS no tiene nada que hacer, es Krilin contra Gogeta SSB. Lo que hace el cas (o la nitidez de Nvidia) es perfilar las imagenes "estiradas" cuando las vemos en un panel de mayor resolución desde una resolucion menor, para que no se vea tan borroso, o para paliar ese efecto borroso. Ese efecto borroso que parece que nadie conoce fuera del mundo del PC, que un servidor personalmente, no soporta.

Respecto de la supuesta tecnologia de AMD que SÍ funcionaría de algun modo de manera parecida a lo que hace el DLSS, pero groseramente, pues no hay IA de por medio, hay que ver en que queda, y ya hablando de promesas, recordar que de DLSS 1.0 al 2.0 el cambio ya ha sido muy notable, y que Nvidia tiene prometido que el 3.0 funcionara sin necesidad de apollo del desarrollador, en cualquier juego con TAA, que vienen a ser todos... Si eso se hace realidad, entonces se van a marcar grandes diferencias. Pero como digo, todo eso está por ver, y tenemos que jugar con lo que es realidad actualmente.

Tampoco ninguno tenemos un ZEN3 con su respectiva placa para poder esperar los resultados que ha conseguido AMD en sus benchs sobre esos juegos. Necesitamos reviews libres y confiables para poder situarnos. De todos modos aun quedan meses por delante para decidirse. A mi tambien me parece extraño que Nvidia haya cancelado las versiones "super" de sus ampere, cuando ya estaban hasta filtradas por ensambladoras, porque, aparentemente, tampoco va tan sobrada sobre AMD, salvo que Nvidia sepa algo que nosotros no sabemos...

elcapoprods escribió:Pacorrr escribió:Y me parece muy bien que lo actives, sólo puntualizo que ese no es el rendmiento puro en RT, entra en la ecuación un reescalado. En rendimiento puro RT, si ese leak es cierto, la 6800 estaría por delante de la 2080Ti y la 3070.

Y de precio.

battman80 escribió:@Pacorrr lo mas raro de esa filtracion, y recuerdo la de las Ampere chinas de los dias previos, es que no hay ninguna necesidad de ocultar la gpu... En el caso de las Ampere por ejemplo, no recuerdo nada asi donde no se viese que la GPU era la que se decía que era. No sabemos quien esta detras de las fotos y cual es su intencion orientacion, pero fijate, que si sumamos el gráfico que ayer publicaron varias webs de hardware, el que puesto yo, y esas fotos, con lo que coincidiria eso, es con el rendimiento de la 6900xt, por encima de la 2080Ti bastante, y un poco por encima de la 3070... Coincide perfectamente. Y si me tapas que gpu estas usando, para decirme que es la menor de las 6000 ...Y AMD con esos resultados, no lo dice a bombo y platillo en la presentación...pues joer...tampoco hay que ser Sherlock Holmes.

Ya veremos, nos esperan dias de muchas filtraciones en una y otra dirección, hasta que liberen reviews. Con las Ampere mira lo que pasó, ni las malas eran tan malas, ni las buenas eran tan buenas, al final resultó ser lo que el sentido comun indicaba que serían, hasta con la 3090.

PD: y ten en cuenta que el DLSS va a estar presente en todos los juegos con RT, asi que sacarlo de la ecuación es un ejercicio inutil.

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![fumando [fumando]](/images/smilies/nuevos/fumando.gif)

![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

battman80 escribió:@Pacorrr el DLSS va a estar siempre que esté presente el RT, te lo aseguro. Incluso en casos donde no hay RT, y detras hay alguien a quien "no le interesaría" el DLSS, como es el caso del Horizon de SONY, está...Porque tu lo que quieres es vender juegos, a todo el mundo, y te da igual si van mejor a los que tienen una gpu u otra. Lo que quieres es que en los analisis ,videos y trailers, se vea tu juego espectacular con RT y a tantos frames como puedas, y si para eso necesitas apollarte en DLSS, lo haces.

Lo que a estas horas de hoy parece de consenso, porque no hay reveldia en contra y si parece que asunción, es que en RT las 6000 no están a la altura de las Ampere, y eso es lo que tenemos que asumir a la hora de apostar por unas u otras. Va a ser dificil y depender mucho de cada usuario, poner todo en la balanza, precios, tecnologias, software y prestaciones asociadas, tasas de frames, tipo de monitor que vamos a usar (quien juege en una tele 4k 60hz, todo lo que sea pasar de los 60 frames, ya le vale, y hay que mirar en otras cosas, porque igual te dan 90 frames que 80).

YA vermos! Pero estos dias previos de debate y charla son de lo mejor que nos dan las gpus![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![fumando [fumando]](/images/smilies/nuevos/fumando.gif)