Boh, esos datos no son creíbles.

Puedo llegar a creerme que en 4K, y mientras no se necesiten más de 4 GB, las Fury X con su memoria HBM y ancho de banda a raudales puedan sacarle ventaja a las 980 Ti en muchas pruebas, pero en todas.... más bien no. Más que nada porque supuestamente algunos de estos juegos sacan provecho a tener más de 4GB, como el mordor.

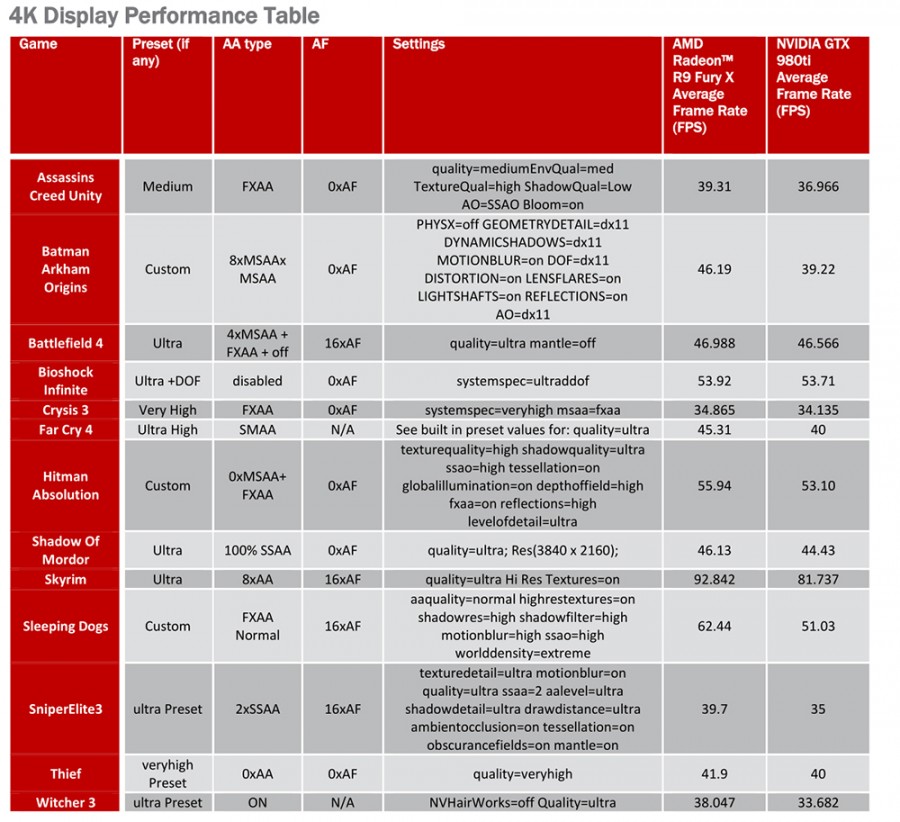

Pero lo que realmente me mosquea de estos datos es ver lo siguiente:

AC3, The Witcher 3, donde la AMD ganaría con un margen mayor que en otros juegos, juegos que van mejor en nvidia claramente, ¿ahora son victorias claras de AMD, WTF?.

Mientras, y esto es lo importante porque va en contraste:

Thief, Mordor, o Hitman Absolution van casi empatadas o por lo menos están más cerca, cuando son juegos que es de conocimiento público que van mejor en las AMD que en las nvidia.

Así que estos datos totalmente anómalos, donde la Fury X saca más ventaja en The Witcher 3 que en Hitman Absolution, no se lo cree ni el tato. Para más inri Hitman Absolution, un juego que es definido por su dependencia con el ancho de banda para escalar el rendimiento.

Podría añadir Crysis 3 a la ecuación, sobre todo si mete MSAA, porque entonces la dependencia con el ancho de banda jugaría precisamente a favor de la Fury X para sacar más rendimiento, no ese empate que se ve ahí.

También muy loco eso del Batman funcionando más rápido en la Fury X, pero en fin... parecen resultados inventados, además malamente, ya que los juegos que van mejor en AMD o en nvidia tienen "comportamientos raros" con lo que sabemos cómo suelen ir. Aunque no conozca la configuración usada en cada una, esos datos huelen a trabajo inventivo de un troll que quiere reírse de la comunidad.

PD: Lo más gracioso es que en wccftech aseguran que son resultados de tests "oficiales" que les han dado desde AMD, un tanto extraño porque si así fuera, aparecería no en wccftech de forma aislada (y su clon videocardz), sino en más lugares.

Ésta es la tabla de cómo habrían pasado las pruebas:

Y simplemente, NO me puedo creer, por mucho interés que haya en manipular datos en un fabricante, que AMD haya pasado estos tests con tantos juegos con el filtro anisotrópico totalmente deshabilitado.

Eso es una barbaridad, no sé si le puede beneficiar tanto en rendimiento, pero desde luego no conozco a nadie que se llame gamer en PC que juegue con el filtro anisotrópico deshabilitado, yo NO juego con él si no es a 16X o como mínimo a 8X, y si no lo uso a 16X es porque el juego no me lo permite seleccionar directamente.

¿Shadow of mordor usnado 100% SSAA a 4K?. El equivalente de usar 8K (2X2 la resolución original) con una Fury, en ultra y este juego. Eso sí, sin aniso. Y 4 GB de VRAM. No way.