![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

Chaquetero escribió:Con esa CPU no vas a poder aprovechar nada por encima de una rtx 3050/rx6600. Esa 7900 te rendirá con mucha suerte como una Rx 6700 por culpa del procesador que ya tiene año y medio y eso es una eternidad en informática, tienes que cambiar ya.

El componente más importante para videojuegos es el procesador.

Además esa CPU no tiene núcleos de smartphone y va a tener un rendimiento de pena para jugar al goty de pc que es el cinebench.

![demoniaco [sati]](/images/smilies/nuevos2/demonio.gif)

joanvicent escribió:Chaquetero escribió:Con esa CPU no vas a poder aprovechar nada por encima de una rtx 3050/rx6600. Esa 7900 te rendirá con mucha suerte como una Rx 6700 por culpa del procesador que ya tiene año y medio y eso es una eternidad en informática, tienes que cambiar ya.

El componente más importante para videojuegos es el procesador.

Además esa CPU no tiene núcleos de smartphone y va a tener un rendimiento de pena para jugar al goty de pc que es el cinebench.

Y no te olvides de los fps extra que dan los leds rgb

Madrileño45 escribió:Antes de nada, esta es mi duda y lo que entiendo hasta ahora. Por eso intento expresar algo a cara al futuro si me conviene quitarme el I5.

Ayer mirando la grafica RX 7900 XTX para temas de juegos comparada con la que tengo ahora la 3070 me mejora. Pero tengo mis dudas, sobre todo que la grafica me sale por 500€ más, y prefiero ahorrármelos si es posible.

El tema de las graficas esta muy caras. Y casualmente me dio por mirar un micro nuevo y veo que la gen 13 vale para mi placa perfectamente LGA 1700.

El micro fácilmente lo vendo fácilmente y a buen precio así que de los 500€ me puede salir por unos 150€ más barato a 350€ euro mas arriba o más abajo.

Antes pasaba de mejorar el micro, ya que para juegos aun siendo de la misma gen no se nota nada del I5 al I7 en juegos. Eso esta muy claro o estaba. Ahora el cambio de gen si se nota, pero no se hasta cuantos fps. Por lo que he estado mirando unos 15-25fps. Y si estoy en lo cierto prefiero el micro antes que gastarme 1200€ en una nueva grafica para unos pocos fps. Si me decís que ganaría unos 50 fps me lanzo a por la grafica.

Ahora viene mi conclusión que a muchos nos puede interesar debatir este tema.

Viene la nex-gen. Puede que los 4 o 6 núcleos y los mhz se van a quedar algo obsoletos en el 2023 en los juegos triple AAA en muchos juegos. Por eso pienso en un futuro y como iniciador al mundo de los video juegos. He estado años sin jugar por que no había un juego que me llamara casi la atención hasta ahora. He visto lo que se nos viene y eso ya son palabras mayores el cambio brutal y dudo mucho que 6 núcleos pueda hacer funcionar un juego en todo ultra a 2k y menos a 4k (pero el 4k para mi es algo que por ahora paso y creo que con la 3070 oc puede ir bien al menos hasta después del verano que ya me pille una 7900 de esas de 24gb vram y haya bajado un poco los precios o lo vea en oferta)

En mi opinión y pensando en cambiar de grafica para el 2023, el I5 que tengo ahora seguro que me hace algo de cuello de botella. Esta es otra parte importante. Si me pillo la 7900 XRT fijo que me hace cuello de botella o no se exprime al máximo la grafica. Puede que me equivoque pero lo añado como duda.

Para mi unos 20 fps por el cambio de micro, es bastante bueno. Pero si la grafica 7900 ( lo digo por que no voy a cambiar de fuente y tengo una de 850w bastante buena a una Nvidia 4080, que encima es más cara) me sube mas de 40 fps, posiblemente me lance a por la grafica antes que el micro si no me hace cuello de botella.

Por calidad/precio, prefiero el micro primero.

zarcelo_2 escribió:Con esa gráfica no vas a mejorar cambiando la CPU

Ahora si metes una 7900 entonces si te hará cuello

Ahí ya te toca ver si te compensa pillar gráfica y luego renovar CPU o quedarte cómo estás y renovar cuando necesites

Renovando CPU no vas a rascar mucho

Quizá los mínimos

Y renovando gráfica vas a ganar los fps que te permita la CPU

Esa amd debe rendir el doble o más que la 3070

Madrileño45 escribió:No veis mi firma?

Ahora bien. ¿Por que la gente para gaming hace OC en un micro y estáis obsesionados en el post de oc? ¿ No se supone que da igual tener mas Mhz no mejora lo juegos? Entonces, por que la palabra gaming y oc es el vocabulario oficial de un profesional gaming que siempre tiene que mencionar que le hice un OC para mejorar algunos fps en un juego? Esta parte no me queda muy clara.

La diferencia de mejorar 1ghz tampoco me mejora los fps de un juego? Es como haberle metido un OC de 1ghz, una barbaridad el cambio.

I5 2.5GHz / 4.4

i7 3.4GHz / 5.4

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif) . Ejemplo

. Ejemplo

(Pero el Oc no creo que lo toque) 5.4 ghz, ya me parece bastante hoy en día.

(Pero el Oc no creo que lo toque) 5.4 ghz, ya me parece bastante hoy en día.

Herionz escribió:@Madrileño45

Claro, pero ellos te están diciendo dos cosas. Primero que mires que tú gráfica tenga espacio para acomodar la potencia de la nueva CPU. Osea, que no la tengas a tope de carga ahora mismo. Si luego claro te metes una mejor pues sin problema.

Segundo, el coste, que a veces no sale a cuenta por ganar pongamos 20% más pues pagar el doble, o el triple, y los cambios extras o componentes que hagan falta, si es que hacen falta. Pero ahí eso ya depende del bolsillo de cada uno.

Y ves con los gráficos que has puesto ahora, yo me guíe por eso para el primer comentario que te dejé. En cinebench saca en single un 20-30% más y en juegos pues escala así, salvo cuando puede aprovechar más núcleos, entonces se dispara. Pero que tienes que tener la GPU acordé para que vayan al unísono.

Y bueno, oc ha ha, temperatura no es todo pero como dices que no vas a hacer pues no te va preocupes.

![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

Madrileño45 escribió:@Herionz Si todo eso lo se. Pero es que este post, ya me ha liado bastante. Unos decis que si, otros que si cuello de botella con la 3070 y con una cpu mejor, me mejora los fps en equilibrio con la potencia de la grafica. El cuello de botella es un decir.

Mira tu grafico, menuda diferencia de fps. Y yo teniendo un buen sistema de refrigerador en la CPU mas el agua de alta calidad. Jugando no paso de los 40º en todo ultra. Vamos, al i7 lo podría subir a 6ghz sin despeinarse de temperatura.(Pero el Oc no creo que lo toque) 5.4 ghz, ya me parece bastante hoy en día.

Es que mi post, es un tema de detalles, no el echo de haberme equivocado hablando de núcleos. Mas bien de mhz para juegos. Esa hubiera sido un buen titulo mejor explicado.

Y luego esta esto, que la verdad si que mejora.

De todas formas estoy dándole mucho interés al tema y aprender sobre cada detalle de un procesador. Eso si, hasta la gen 15 no cambio. La 14 me da igual lo que saquen, con este I7 puede que me aguante hasta la gen 16 con un poco de suerte.

Madrileño45 escribió:@Kavezacomeback Yo me conformaba con unos 20fps para el Cyberpunk, pero 10 bueno se puede ir tirando jaja.

En el cyberpunk todo el ultra y el raytracing en ultra. El cambio de 45 fps a 55 he notado un cambio. Pero no me gusta. He tenido que bajar el raytracing para jugar a 85 fps. Aquí ya se nota el cambio y la suavidad y el raytracing tampoco he notado la diferencia de ultra a bajo, poca cosa.

Cualquier juego que pase de 100 a 144 fps, no se nota casi la diferencia. Yo lo quería para el cyberpunk que es al que ahora estoy muy viciado y metiendo mods a saco. Eso es posible que me renderice mucho el poder jugarlo bien en todo ultra ya que tengo texturas de hasta 4k y 8k.

No sabia yo que mintieran, lo dije por decir

Pero al menos, ya el tema de microprocesador, me lo he quitado del medio ese run run en la cabeza y ya me espero a que bajen mas las graficas tranquilamente y sin prisas. Para el verano seguro que consigo alguna ganga.

Madrileño45 escribió:@Kavezacomeback Yo me conformaba con unos 20fps para el Cyberpunk, pero 10 bueno se puede ir tirando jaja.

En el cyberpunk todo el ultra y el raytracing en ultra. El cambio de 45 fps a 55 he notado un cambio. Pero no me gusta. He tenido que bajar el raytracing para jugar a 85 fps. Aquí ya se nota el cambio y la suavidad y el raytracing tampoco he notado la diferencia de ultra a bajo, poca cosa.

Cualquier juego que pase de 100 a 144 fps, no se nota casi la diferencia. Yo lo quería para el cyberpunk que es al que ahora estoy muy viciado y metiendo mods a saco. Eso es posible que me renderice mucho el poder jugarlo bien en todo ultra ya que tengo texturas de hasta 4k y 8k.

No sabia yo que mintieran, lo dije por decir

Pero al menos, ya el tema de microprocesador, me lo he quitado del medio ese run run en la cabeza y ya me espero a que bajen mas las graficas tranquilamente y sin prisas. Para el verano seguro que consigo alguna ganga.

@hh1 Uno se lia, por que cada uno dice una cosa, que si el micro si voy a ganar, que si no hace cuello de botella, que no voy a ganar.. y luego viendo videos esta claro que mienten.

Pero por lo menos ya me he quitado esa idea. Aunque el i7 nunca viene mal para otras cosas como edición de video que suelo usar. Pero vamos, que ya no cambio de micro en 7 años hasta que este no pueda más con un juego o me haga cuello de botella alguna grafica dentro de 5 años. A este paso, están sacando graficas cada año al igual que los micros. Ya paso de gastar mas dinero. La 3070, me va perfecta, salvo por el cyberpunk, pero si le bajo el raytracing,

me va perfecto a unos 80fps.

@hh1 A ver que pasa en el 2023 con los nuevos juegos y seguramente para los siguientes 3 años sigamos con 8 núcleos mas que sobrados para los triple AAA.

Madrileño45 escribió:No veis mi firma?

Tengo una placa gen4 de unos 170€ compatible con la serie gen13 de intel.

16GB DDR 4 a 3200mhz.

monitor 2k panorámico 144hz. (Por ahora odio el 4k demasiado gastos seria, y tendría que comprarme una 4090 para que me rente bien el 4k para jugar a mas de 80 fps en algunos juegos)

SSD de 7000 mb/s

Antes de nada concluyo algo.

Aunque estéis en lo cierto que el i7 no me vaya a mejorar nada en juegos y como creo que ya dije, lo he pillado para unos 5-8 años y no tener que cambiar ni pensar si cambiar el micro. 16 núcleos da para muchísimos años y por ahora, no hay un juego que supere los 8 núcleos. El 4/6 núcleos a estado ahí durante muchísimos años sin tener que pensar en mas núcleos. Hoy en día sigue en lineal de lo mas usado.

Ahora bien. ¿Por que la gente para gaming hace OC en un micro y estáis obsesionados en el post de oc? ¿ No se supone que da igual tener mas Mhz no mejora lo juegos? Entonces, por que la palabra gaming y oc es el vocabulario oficial de un profesional gaming que siempre tiene que mencionar que le hice un OC para mejorar algunos fps en un juego? Esta parte no me queda muy clara.

La diferencia de mejorar 1ghz tampoco me mejora los fps de un juego? Es como haberle metido un OC de 1ghz, una barbaridad el cambio.

I5 2.5GHz / 4.4

i7 3.4GHz / 5.4

Luego me llega el micro, ya ya subiré si me mejora o no. (Primero a ver si mi placa no le da problemas aunque ya la he actualizado la BIOS para la gen 13)

Madrileño45 escribió:A final lo devolví el i7. Me uso timo de marketing. Aguantaré con el i5 unos 7 años más.

Ni gráficas ni chorradas. Todo puro marketing y poca mejoría con más consumo.

Encima lo que consume y la luz. Otra vez que sube aas de 200€.

Que ganas de llegar a casa para quitar el i7. Nunca más. Me ois! nunca más. El i5 de por vida. Aunque el i5 gen 13. Tiene su puntillo. Pero me aguantaré con el i5 gen 12 unos añ loos más.

![facepalm [facepalm]](/images/smilies/facepalm.gif)

Madrileño45 escribió:@hh1 y también decíais que mejoraba y vídeos en YouTube y páginas profesionales. Mucha confusión. Pero ya todo aclarado.

![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

Sayernz escribió:Por lo que os he leído, para una 4080 y con monitor 2k y 144hz entonces me valdría ese i5 12400 no? estoy mirando para pillar un pc nuevo y dudo que cpu pillar

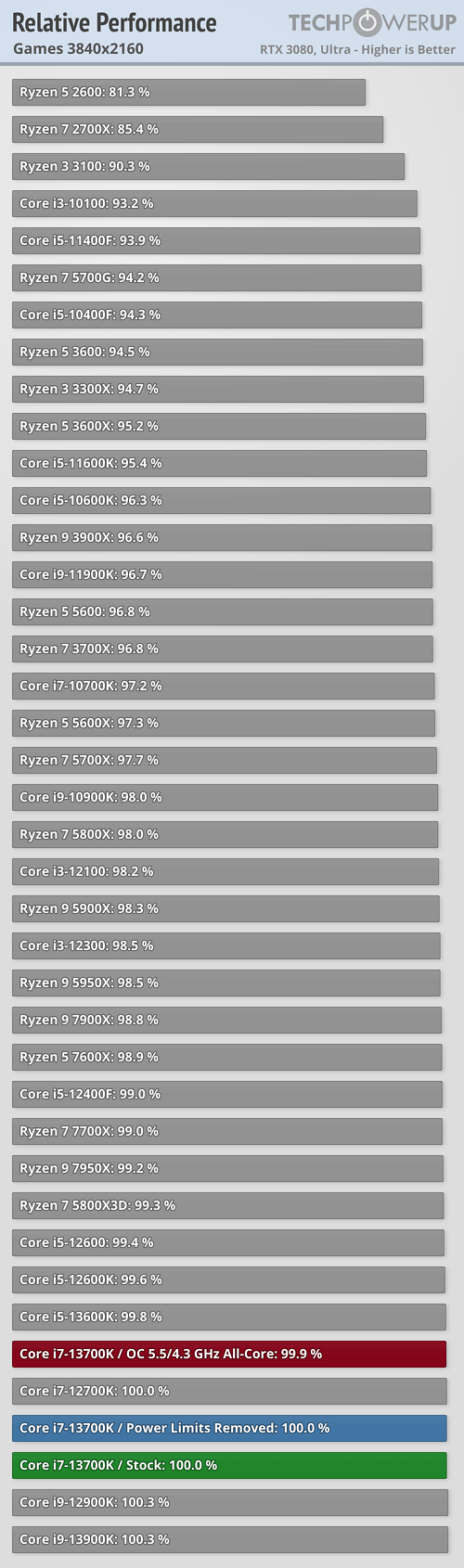

javier español escribió:Si vas a montar una RTX 4080 imagino que no será para resoluciones pequeñas, que en ese caso la CPU en la mayoría de los juegos no importa tanto. Mira en la siguiente review con una RTX 3080 la diferencia que hay de media en juegos a 4K entre un i5-12400F y un i7-13700K, un 1% escaso: https://www.techpowerup.com/review/inte ... 0k/20.html

Así que aunque la RTX 4080 es superior en rendimiento a la RTX 3080 que usan en esa review, dudo mucho que vayas a tener diferencias de 20 fps con un juego entre ambas CPUs, la verdad, a no ser a menos resolución (donde importa más la CPU) y sea un juego de los que se pueden sacar tropecientos fps, en cuyo caso tampoco creo que notes la diferencia, seguramente en ese caso no tengas un monitor de tantos Hz y aún así, tampoco creo que notes la diferencia.

Saludos.

Madrileño45 escribió:Sayernz escribió:Por lo que os he leído, para una 4080 y con monitor 2k y 144hz entonces me valdría ese i5 12400 no? estoy mirando para pillar un pc nuevo y dudo que cpu pillar

Ahí discrepo, creo que con un i5 te va hacer un cuello de botella importante. No va a exprimir al máximo la 4080. Por las vueltas que le he dado en centrarme en este tema, pienso que podría ser así pero me uno a esta duda para un futuro.

javier español escribió:javier español escribió:Si vas a montar una RTX 4080 imagino que no será para resoluciones pequeñas, que en ese caso la CPU en la mayoría de los juegos no importa tanto. Mira en la siguiente review con una RTX 3080 la diferencia que hay de media en juegos a 4K entre un i5-12400F y un i7-13700K, un 1% escaso: https://www.techpowerup.com/review/inte ... 0k/20.html

Así que aunque la RTX 4080 es superior en rendimiento a la RTX 3080 que usan en esa review, dudo mucho que vayas a tener diferencias de 20 fps con un juego entre ambas CPUs, la verdad, a no ser a menos resolución (donde importa más la CPU) y sea un juego de los que se pueden sacar tropecientos fps, en cuyo caso tampoco creo que notes la diferencia, seguramente en ese caso no tengas un monitor de tantos Hz y aún así, tampoco creo que notes la diferencia.

Saludos.Madrileño45 escribió:Sayernz escribió:Por lo que os he leído, para una 4080 y con monitor 2k y 144hz entonces me valdría ese i5 12400 no? estoy mirando para pillar un pc nuevo y dudo que cpu pillar

Ahí discrepo, creo que con un i5 te va hacer un cuello de botella importante. No va a exprimir al máximo la 4080. Por las vueltas que le he dado en centrarme en este tema, pienso que podría ser así pero me uno a esta duda para un futuro.

Pues unos posts atrás puse resultados de una review y no solo una imagen, sino también el enlace a la review, pero si quieres, puedes buscar en otros sitios que hagan reviews y sean fiables, así sacas información de sitios especializados, no solo conjeturas y creencias porque sí o porque lo digan otros sin aportar datos, etc...

Madrileño45 escribió:javier español escribió:javier español escribió:Si vas a montar una RTX 4080 imagino que no será para resoluciones pequeñas, que en ese caso la CPU en la mayoría de los juegos no importa tanto. Mira en la siguiente review con una RTX 3080 la diferencia que hay de media en juegos a 4K entre un i5-12400F y un i7-13700K, un 1% escaso: https://www.techpowerup.com/review/inte ... 0k/20.html

Así que aunque la RTX 4080 es superior en rendimiento a la RTX 3080 que usan en esa review, dudo mucho que vayas a tener diferencias de 20 fps con un juego entre ambas CPUs, la verdad, a no ser a menos resolución (donde importa más la CPU) y sea un juego de los que se pueden sacar tropecientos fps, en cuyo caso tampoco creo que notes la diferencia, seguramente en ese caso no tengas un monitor de tantos Hz y aún así, tampoco creo que notes la diferencia.

Saludos.Madrileño45 escribió:

Ahí discrepo, creo que con un i5 te va hacer un cuello de botella importante. No va a exprimir al máximo la 4080. Por las vueltas que le he dado en centrarme en este tema, pienso que podría ser así pero me uno a esta duda para un futuro.

Pues unos posts atrás puse resultados de una review y no solo una imagen, sino también el enlace a la review, pero si quieres, puedes buscar en otros sitios que hagan reviews y sean fiables, así sacas información de sitios especializados, no solo conjeturas y creencias porque sí o porque lo digan otros sin aportar datos, etc...

Si, todo lo cierto. Pero a mi ya me ha rayado el volver a ver unas comparaciones de micros. Aquí solo vale una grafica y que este al 100% optimizada con el micro. Pero volvería al tema de la duda si es real o puro marketing. Me da a mi que a muchos les pagan para inflar las diferencias de mejoras a lo que nos lleva que todo es falso. Y eso ya se ha visto en quejas o denuncias contra compañías por mentir en comparaciones.

Madrileño45 escribió:Antes de nada, esta es mi duda y lo que entiendo hasta ahora. Por eso intento expresar algo a cara al futuro si me conviene quitarme el I5.

Ayer mirando la grafica RX 7900 XTX para temas de juegos comparada con la que tengo ahora la 3070 me mejora. Pero tengo mis dudas, sobre todo que la grafica me sale por 500€ más, y prefiero ahorrármelos si es posible.

El tema de las graficas esta muy caras. Y casualmente me dio por mirar un micro nuevo y veo que la gen 13 vale para mi placa perfectamente LGA 1700.

El micro fácilmente lo vendo fácilmente y a buen precio así que de los 500€ me puede salir por unos 150€ más barato a 350€ euro mas arriba o más abajo.

Antes pasaba de mejorar el micro, ya que para juegos aun siendo de la misma gen no se nota nada del I5 al I7 en juegos. Eso esta muy claro o estaba. Ahora el cambio de gen si se nota, pero no se hasta cuantos fps. Por lo que he estado mirando unos 15-25fps. Y si estoy en lo cierto prefiero el micro antes que gastarme 1200€ en una nueva grafica para unos pocos fps. Si me decís que ganaría unos 50 fps me lanzo a por la grafica.

Ahora viene mi conclusión que a muchos nos puede interesar debatir este tema.

Viene la nex-gen. Puede que los 4 o 6 núcleos y los mhz se van a quedar algo obsoletos en el 2023 en los juegos triple AAA en muchos juegos. Por eso pienso en un futuro y como iniciador al mundo de los video juegos. He estado años sin jugar por que no había un juego que me llamara casi la atención hasta ahora. He visto lo que se nos viene y eso ya son palabras mayores el cambio brutal y dudo mucho que 6 núcleos pueda hacer funcionar un juego en todo ultra a 2k y menos a 4k (pero el 4k para mi es algo que por ahora paso y creo que con la 3070 oc puede ir bien al menos hasta después del verano que ya me pille una 7900 de esas de 24gb vram y haya bajado un poco los precios o lo vea en oferta)

En mi opinión y pensando en cambiar de grafica para el 2023, el I5 que tengo ahora seguro que me hace algo de cuello de botella. Esta es otra parte importante. Si me pillo la 7900 XRT fijo que me hace cuello de botella o no se exprime al máximo la grafica. Puede que me equivoque pero lo añado como duda.

Para mi unos 20 fps por el cambio de micro, es bastante bueno. Pero si la grafica 7900 ( lo digo por que no voy a cambiar de fuente y tengo una de 850w bastante buena a una Nvidia 4080, que encima es más cara) me sube mas de 40 fps, posiblemente me lance a por la grafica antes que el micro si no me hace cuello de botella.

Por calidad/precio, prefiero el micro primero.

javier español escribió:Madrileño45 escribió:javier español escribió:

Pues unos posts atrás puse resultados de una review y no solo una imagen, sino también el enlace a la review, pero si quieres, puedes buscar en otros sitios que hagan reviews y sean fiables, así sacas información de sitios especializados, no solo conjeturas y creencias porque sí o porque lo digan otros sin aportar datos, etc...

Si, todo lo cierto. Pero a mi ya me ha rayado el volver a ver unas comparaciones de micros. Aquí solo vale una grafica y que este al 100% optimizada con el micro. Pero volvería al tema de la duda si es real o puro marketing. Me da a mi que a muchos les pagan para inflar las diferencias de mejoras a lo que nos lleva que todo es falso. Y eso ya se ha visto en quejas o denuncias contra compañías por mentir en comparaciones.

¿De verdad lo dices en serio? ¿Qué pasa, que les pagan a todos los stios donde hacen reviews? Se podría desconfiar de uno o varios sitios, ¿pero de todos?

Además que aquí en el foro puedes ver las opiniones de muchos usuarios de primera mano, la mía tambien, que he montado tanto los i5, como i7 e i9 y para gaming a resoluciones altas como 4K, ya te digo que no hay apenas diferencias.

En otras tareas como edición, diseño 3D, etc... donde si se usan cuántos más cores/threads es mejor, pues vale, es importante invertir en el mejor procesador posible, pero en gaming, pues la verdad es que lo poquísimo que ganas con un procesador de gama alta respecto a un i5, supone un desembolso económico que puede ser un % altísimo respecto al % mínimo de beneficio en juegos.