![fumando [fumando]](/images/smilies/nuevos/fumando.gif)

![fumando [fumando]](/images/smilies/nuevos/fumando.gif)

dCrypt escribió:Pero vamos a ver, ¿es que AMD no hace lo mismo?

Mr.Gray Fox escribió:Haz el favor de leer bien los artículos, comparan el rendimiento en FP32. Estas gráficas ni se esperan en otra cosa que no sean datacenters, porque fuera de eso las de nVidia les meten una buena paliza en software que aproveche los tensor cores.

dCrypt escribió:dCrypt escribió:Pero vamos a ver, ¿es que AMD no hace lo mismo?

Perdón por la autocita, pero como no encuentro nada en el foro, ya os adelanto que no me equivocaba en dos cosas:

- AMD es tan tramposa como Intel

- En el foro, por alguna misteriosa razón, no se va a hablar mal de AMD

https://elchapuzasinformatico.com/2018/ ... -a-nvidia/

https://wccftech.com/amd-radeon-mi60-re ... -not-used/

Ahora voy a contar los días que pasen hasta que alguien en este foro reclame que se boicotee a AMD por estas prácticas.

Saludos.

dCrypt escribió:Mr.Gray Fox escribió:Haz el favor de leer bien los artículos, comparan el rendimiento en FP32. Estas gráficas ni se esperan en otra cosa que no sean datacenters, porque fuera de eso las de nVidia les meten una buena paliza en software que aproveche los tensor cores.

Los he leído. No es el punto. El punto es que AMD ha "trucado" los benchs para que su GPU parezca competitiva frente a nVidia. O me he perdido algo, o en el foro se defiende a AMD cuando hace lo mismo por lo que se critica a Intel.

BTW, no sé dónde ves software que aproveche los tensor cores, si no es en un [sic]datacenter[/sic]

Saludos.

I don't think you understand the accuracy difference. Every additional bit *doubles* the number of unique values a format can store - so if we were talking about integers, 16 bits gives you 65,536 unique values... And 32-bit gives you 4,294,967,296 unique values. The difference in accuracy is *huge*.

Of course, we're talking about floats, not ints. Floating point formats work by having two parts: an exponent, and a fraction (note: 1 bit is also reserved for holding the sign, but that's constant for all float types). It's basically a binary variant of scientific notation. Each part has a fixed number of bits in it though, which means that the range of valid values for both parts will be *smaller* for 16-bit floats.

This means that not only are 16-bit floats significantly less accurate, but they are also not even capable of storing the same range of values to begin with. If you require the processing of numbers larger than 65504 (largest possible 16-bit float), you're out of luck. 32-bit's largest possible value is roughly 3.402823466*10^38.

The difference is so vast that to say 16-bit is even acceptable is in many cases naive at best. And I haven't even given you the figures for accuracy yet! The fractional part of a 16-bit floating point number is 10 bits wide (11 bits accuracy, kinda, but the first of those 11 bits is assumed to be '1'), giving it log10(2^11) decimal (base 10) digits of accuracy. That's approximately 3.3 digits, so at best 4 digits of accuracy. Compare that to 32-bit floats, which have 23 bits (24 with the implied bit) of accuracy - or about 7.2 decimal digits of precision. That is more than twice as many digits.

Nobody in their right mind ever uses 16-bit floats *unless* they know with absolute certainty that their data will get turned into something only needing about 3 digits of precision. Since most displays use 8-bit (0-255) signals, 16-bit floats in the range of 0.0-1.0 are a great way to calculate things like the final values for colors of pixels. However, even then the precision is unacceptable for complex lighting and color space conversion calculations, so really they're only useful for *output* values.

Tensor cores, of course, have 32-bit output values... But only 16-bit input values. This makes them absolutely worthless for the vast majority of use cases, especially those where any amount of precision is important.

DaNi_0389 escribió:No hace falta llamar al boicot, seguramente nadie del foro tiene intencion de comprar ninguna Mi60.

paco_man escribió:Las dos mienten en este tipo de pruebas, pero Intel además de mentir te intenta estafar.

Mr.Gray Fox escribió:Precios abusivos desde hace años, basura de refrigeración, cambio de socket "porque yo lo valgo", tácticas mafiosas respecto a vulnerabilidades... No sé, creo que son motivos de sobra.

Zeph escribió:Todas las compañias intentan mostrar aquellas pruebas donde su producto es el mas favorable, ignorando aquellas pruebas donde su producto queda peor parado respecto a la competencia. PERO lo que ha hecho INTEL ha sido como poner a dos atletas a correr los 100 metros, pero al corredor de AMD le ha partido una pierna antes y encima le ha colgado un pedrusco de 100 kilos, aun sabiendo que no va a tener ningun problema al ganar la carrera. Todos sabemos que el i9 va a ser el mejor procesador para juegos (si quieres pagar lo que piden), no le hacia falta en ningun momento partirle la pierna al atleta ni ponerle un pedrusco. Se ha pasado de la raya, literalmente, ha querido ESTAFAR.

Saoren escribió:El problema, no es ser Fanboy de ninguna marca. Es estar quemado de las practicas 'poco eticas' (por decirlo ediucadamente) de una empresa que en el mejor de los casos, lo unico que hace es busca de qué manera lucrarse al minimo coste posible. [...]Y si merece algo, es un buen escarmiento por perpetuar las politicas que todos conocemos: cambios de socket por gusto, poca o nula inversion en investigacion, politicas abusivas rozando el limite legal, etc etc etc.

Mr.Gray Fox escribió:No, parece que no los has leído.[...]Desconozco cómo funcionan los tensor cores

AMD themselves escribió:Regarding the comparison – our footnotes for that slide clearly noted the modes so no issues there. Rationale is that FP32 training is used in most cases for FaceID to have 99.99%+ accuracy, for example in banking and other instances that require high levels of accuracy. – AMD

dCrypt escribió:Si no sabes cómo funcionan los tensor cores, lee un poquito.

The matrix multiply inputs A and B are FP16 matrices, while the accumulation matrices C and D may be FP16 or FP32 matrices.

Reléelo (el artículo) y responde después con criterio.

dCrypt escribió:Nadie te ha tachado de Fanboy. Y te andas por las ramas. El punto es que AMD ha usado el benchmark en su beneficio, como Intel. Y nadie sale a despotricar. ¿Es lícito? ¿Es más realista? da lo mismo. La discusión no se inició en esos términos.

Saludos.

¿Es ético? Depende, si aclaran que es para reconocimiento facial donde queda demostrado que el uso de los tensor cores es muy situacional no le veo el problema. ¿Podrían haberlo puesto en grande? Pues hubiera sido un detalle.

exter escribió:A que viene esto en un hilo de CPUs?

dCrypt escribió:exter escribió:A que viene esto en un hilo de CPUs?

Bueno, según lo veas. El hilo va de controversia en benchmarks. Alguien (@dCrypt) apuntó que de controversia nada, que en EoL no se habla nunca mal de AMD, y que lo que se le achacaba como malas prácticas a Intel en AMD ni se menciona. Mi nuevo post de ayer lo viene a demostrar (según yo lo entiendo) ahora en la figura del ofendido y en el segmento de GPUs profesionales.

Saludos.

exter escribió:dCrypt escribió:exter escribió:A que viene esto en un hilo de CPUs?

Bueno, según lo veas. El hilo va de controversia en benchmarks. Alguien (@dCrypt) apuntó que de controversia nada, que en EoL no se habla nunca mal de AMD, y que lo que se le achacaba como malas prácticas a Intel en AMD ni se menciona. Mi nuevo post de ayer lo viene a demostrar (según yo lo entiendo) ahora en la figura del ofendido y en el segmento de GPUs profesionales.

Saludos.

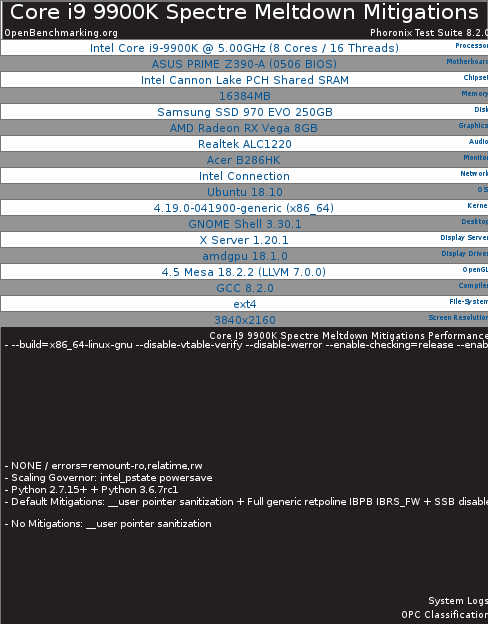

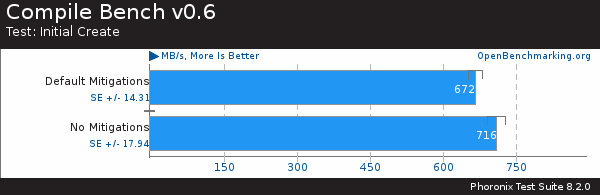

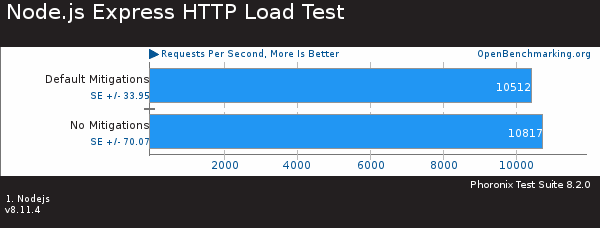

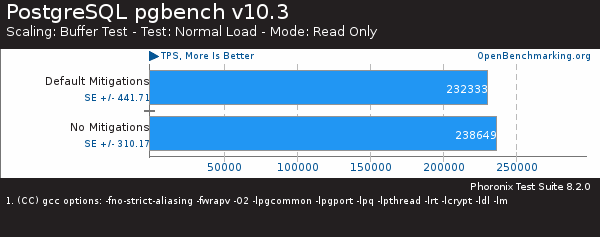

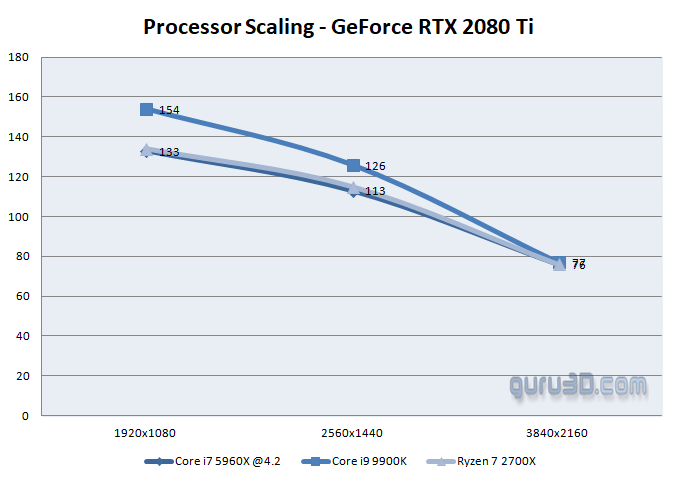

Bench i9 9900K vs i9 8700K vs Threadripper vs RyZEN

Abrid un hilo para las GPUs y que la gente opine.

Bench i9 9900K vs i9 8700K vs Threadripper vs RyZEN: La controversia [nuevo bench]

"Y vaya controversia que ha provocado la publicacion de los benchmarks [...]"

dCrypt escribió:

El hilo va de controversias, no de CPUs.

exter escribió:dCrypt escribió:

El hilo va de controversias, no de CPUs.

No va de controversias "en general", va de esa en concreto de las CPUs en el lanzamiento del 9900K y los bench de Principled Technologies.

dCrypt escribió:[sarcasmo]Bueeeeeno, (en parte) ya vas entrando en razón.[/sarcasmo]

![Aplausos [plas]](/images/smilies/aplauso.gif)

You can choose DX12, still missing, however, are GeForce RTX related option