PilaDePetaca escribió:Veremos cuanta de esa GDDR5 va para el SO, cuanta para VRAM y cuanta para el resto del sistema.

T1100 escribió:PilaDePetaca escribió:Veremos cuanta de esa GDDR5 va para el SO, cuanta para VRAM y cuanta para el resto del sistema.

Al ser memoria compartida es el propio desarrollador quien decide en qué usar la memoria según las necesidades de su juego.

La única cantidad fija reservada sería la del sistema operativo.

naxeras escribió:Todopc-WII escribió:Esos 8 GB de ram dudo que sean DDR5

, valdría una BESTIALIDAD, la gráfica pilla la memoria de ahí según dices, pero un PC se mea encima de la PS4 , pero no, nosotros nos equivocamos y ellos son los dioses que lo saben todo y únicamente tienen la razón.

Ps4 hasta te hace comida, te lava la ropa, ve la tv contigo, sale a pasear al perro, va a estudiar contigo, etc

Pues esta confirmado.

Los gráficos de esas capturas no esperes verlos en wiiu por cierto.

T1100 escribió:Roblock escribió:Y lo del PC se sacará cada vez que digas que la WiiU es menos pontente que PS4/XO, porque estas últimas tampoco sorprenden en nada

Los 8 GB de GDDR5 que lleva PS4 fueron una sorpresa enorme, nadie esperaba que una consola tuviera esa cantidad y más aún tratándose de GDDR5.

Los PC actuales suelen tener entre 4 y 8 GB de memoria DDR3 muy inferior en velocidad a la memoria GDDR5 y solamente las tarjetas gráficas usan GDDR5 porque es carísima, aún así la tarjeta de video más ultrapotente que existe (Nvidia Titan, que cuesta sus 1000 dolarcillos) tiene 6 GB de GDDR5.

Las consolas históricamente siempre han sido muy inferiores a los PC de su época en cantidad de memoria.

Las nuevas consolas (especialmente PS4) constituyen una revolución en ese sentido, poniéndose por encima de los ordenadores.

Lo mejor es que la cantidad de RAM es incluso más importante actualmente para crear un juego con las mayores posibilidades y sin recortes de contenido.

, (y aquí tengo que hacer una pausa porque no puedo parar de reir.

, (y aquí tengo que hacer una pausa porque no puedo parar de reir.

).

).naxeras escribió:Pues esta confirmado.

Los gráficos de esas capturas no esperes verlos en wiiu por cierto.

![llorica [mamaaaaa]](/images/smilies/nuevos/triste_ani4.gif) , si estás comprando continuamente todas las papeletas. Cada vez que abres la boca te toca, xD.

, si estás comprando continuamente todas las papeletas. Cada vez que abres la boca te toca, xD.Johny27 escribió:Ten en cuenta la falta de optimización de pc (el 50% de los recursos desperdiciados) y luego hablamos.

superfenix2020 escribió:nada, ps4 y la Juana están obsoletas antes de salir.

AMD presenta nuevas tarjetas gráficas

http://www.amd.com/US/PRODUCTS/DESKTOP/ ... ies.aspx#2

superfenix2020 escribió:nada, ps4 y la Juana están obsoletas antes de salir.

Chuko25 escribió:Ademas de q no puedes contar solo la ram del pc, si tienes 4/6 de ram hay q sumar lo q tenga la grafica, y cuanto se reserva ps4 para el s.o. 1,5?

superfenix2020 escribió:la xbox 360 era más potente que un Pc potente del momento, allá por finales de 2005. Y costaba 400 euros de salida.

T1100 escribió:

Ahora las consolas salen con 8 GB de RAM (GDDR5 en el caso de PS4) y los ordenadores actuales tienen 4-8 GB.

La memoria ya no será una limitación para los juegos de consola en la próxima generación.

T1100 escribió:superfenix2020 escribió:la xbox 360 era más potente que un Pc potente del momento, allá por finales de 2005. Y costaba 400 euros de salida.

Xbox 360 costaba 299 dólares/euros de salida.

Y cuando salió con sus 512 MB los ordenadores de la época tenían 1-2 GB.

La RAM en X360 y en PS3 es su principal limitación, por ejemplo, el principal impedimento técnico que tiene Minecraft de X360 para alcanzar el nivel de PC es la cantidad de RAM para contener un mundo grande, quitando eso la Xbox mueve de maravilla el juego a 60 fps incluso con varios jugadores a pantalla dividida.

Ahora las consolas salen con 8 GB de RAM (GDDR5 en el caso de PS4) y los ordenadores actuales tienen 4-8 GB.

La memoria ya no será una limitación para los juegos de consola en la próxima generación.

T1100 escribió:superfenix2020 escribió:Ahora las consolas salen con 8 GB de RAM (GDDR5 en el caso de PS4) y los ordenadores actuales tienen 4-8 GB.

La memoria ya no será una limitación para los juegos de consola en la próxima generación.

![loco [mad]](/images/smilies/nuevos/miedo.gif) ,bueno, la RAM no es especialmente cara...mas o menos... xD, de qui a poco, por 400€ esto sera lo que tendremos dado por viejo, de hecho la grafica esta ya pasada de generación ya esta la linea de fantasia 7XX, hablo de nvidia que es la que tiene la mayoria de mis amigos, yo gasto una 460GTX con sus añicos a la esparda y de momento no tengo muy claro cuando la cambiare, me sobra grafica por todos los lados, y 4 gigas de RAM, que solo me interesa ampliarlos por el hecho de que programo y utilizo engines como UDK, tambien sera por que en pc salvo al LOL y algun juego de estrategia, no juego a mucho mas...

,bueno, la RAM no es especialmente cara...mas o menos... xD, de qui a poco, por 400€ esto sera lo que tendremos dado por viejo, de hecho la grafica esta ya pasada de generación ya esta la linea de fantasia 7XX, hablo de nvidia que es la que tiene la mayoria de mis amigos, yo gasto una 460GTX con sus añicos a la esparda y de momento no tengo muy claro cuando la cambiare, me sobra grafica por todos los lados, y 4 gigas de RAM, que solo me interesa ampliarlos por el hecho de que programo y utilizo engines como UDK, tambien sera por que en pc salvo al LOL y algun juego de estrategia, no juego a mucho mas... El diseño de GPU+CPU coincide con gran parte de las características de la E6760 que tanto se ha hablado en los hilos.

Poco ruido, genera poco calor, bajo consumo (la E6760 consume un máximo de 35W)

Un usuario de unos foros, cuyo nick es Xbicio, escribió un mensaje preguntando a la fabricante el modelo de la gráfica incluida en la nueva consola y recibió, sorprendido, respuesta:

"Wii U utiliza una GPU AMD E6769 que está diseñada específicamente para la consola tomando como base la serie 6xxx, pero con las lógicas modificaciones para ajustarse a la configuración de Wii U".

Wii U es la consola más potente con un gran potencial para el futuro. No debemos olvidar, que la GPU de Wii U es de una generación diferente a las de las competidoras actuales. Debido a eso, hay muchas nuevas formas de enfocar las cosas. Que, por un lado, son más fáciles de implementar que las soluciones híbridas especiales utilizadas actualmente en las otras consolas, y por otro lado, trae consigo un rendimiento mucho mejor. En cooperación con el generoso espacio de trabajo, tiene posibilidades increíbles. No hay que olvidar que lo que realmente necesita un desarrollador es poder maximizar el potencial de una consola. Y con equipos como Retro Studios y EAD, Nintendo tiene una ventaja insuperable.

superfenix2020 escribió:la fuente es esta, pero ya ha llovido desde entonces.

http://www.meristation.com/nintendo-wii ... 65/1806930

http://www.3djuegos.com/foros/tema/1626 ... ara-wii-u/

pero como Nintendo no confirma las specs reales, todavía estamos igual que hace un año.

Pero la gpu se acercaría mucho a esa. Estaría modificada o adaptada a la consola claro. No es exactamente igual a la de PC.

PilaDePetaca escribió:superfenix2020 escribió:la fuente es esta, pero ya ha llovido desde entonces.

http://www.meristation.com/nintendo-wii ... 65/1806930

http://www.3djuegos.com/foros/tema/1626 ... ara-wii-u/

pero como Nintendo no confirma las specs reales, todavía estamos igual que hace un año.

Pero la gpu se acercaría mucho a esa. Estaría modificada o adaptada a la consola claro. No es exactamente igual a la de PC.

Ummm, por algunos lados es que hablan de una HD 4670 y por otros de la E6760, aunque claro, con 8 ROP's es bastante difícil diferenciar cual podría ser. Lo de la velocidad re reloj, siempre se puede toquetear lo que haga falta, así que no creo que ese sea un factor determinante para decidir que tipo de tarjeta es. Además, los devkits montaban gráficas de la familia RV7xx, y si no recuerdo mal creo que montaban una hd 4850, y decian que ese era el target de potencia que tendría que llevar finalmente la consola (aunque aún asi, la e6760 se queda un poquito corta en tema de flops en comparación). De todas formas, creo que la E6760 soporta dx11 mientras que la HD 4670 solo tiene soporte dx 10.1 (creo recordar), así que veremos a ver que sale de ahí.

superfenix2020 escribió:la fuente es esta, pero ya ha llovido desde entonces.

http://www.meristation.com/nintendo-wii ... 65/1806930

http://www.3djuegos.com/foros/tema/1626 ... ara-wii-u/

pero como Nintendo no confirma las specs reales, todavía estamos igual que hace un año.

Pero la gpu se acercaría mucho a esa. Estaría modificada o adaptada a la consola claro. No es exactamente igual a la de PC.

superfenix2020 escribió:Iherre decía que pertenecía a la familia R7xx pero customizado.

La verdad, es que flipo con los secretismos que hay en Nintendo y que casi un año después, sigamos sin saber qué gpu y cpu llevan exactamente la wii u.

superfenix2020 escribió:Iherre decía que pertenecía a la familia R7xx pero customizado.

PilaDePetaca escribió:superfenix2020 escribió:Iherre decía que pertenecía a la familia R7xx pero customizado.

Pues eso, los devkits llevaban tarjetas RV7xx (la HD 4850 creo que es la que mas he leido por ahí que llevaban) y se suponía que el target de potencia era ese... ahora no se como habrán acabado, pero si tiene que tener un TDP de 30-35 vatios ya no se que pensar.

superfenix2020 escribió:Amd ha confirmado la Gpu que lleva Wii U, una E6760, por lo visto 5 veces mas potente que la de la Ps3.

La tecnología, optimizada para la consola de Nintendo, deriva de la serie gráfica 6xxx.Un usuario de unos foros, cuyo nick es Xbicio, escribió un mensaje preguntando a la fabricante el modelo de la gráfica incluida en la nueva consola y recibió, sorprendido, respuesta:

"Wii U utiliza una GPU AMD E6769 que está diseñada específicamente para la consola tomando como base la serie 6xxx, pero con las lógicas modificaciones para ajustarse a la configuración de Wii U".

La gráfica de Wii U es del tipo HD4XXX (RV7XX) customizada según los rumores más fiables y su capacidad sería ligeramente superior a las de PS3 o X360.

superfenix2020 escribió:por cierto, viendo que Microsoft al final a overclockeado la xboxOne para tratar de igualar a la Ps4, y viendo los consumos de la Wii U, no me extrañaría nada que la Wii u estuviera un poco underclockeada de salida y que se pudiera subir la frecuencia de su cpu y gpu mediante en una futura actualización cuando el SO esté más depurado y sea más estable.

Johny27 escribió:superfenix2020 escribió:por cierto, viendo que Microsoft al final a overclockeado la xboxOne para tratar de igualar a la Ps4, y viendo los consumos de la Wii U, no me extrañaría nada que la Wii u estuviera un poco underclockeada de salida y que se pudiera subir la frecuencia de su cpu y gpu mediante en una futura actualización cuando el SO esté más depurado y sea más estable.

Una cosa es subirla antes de entrar en producción, donde puedes testear todas y otra subirla tras llevar un año vendiendo consolas y arriesgarte a que casquen un porcentaje de ellas.

Johny27 escribió:superfenix2020 escribió:por cierto, viendo que Microsoft al final a overclockeado la xboxOne para tratar de igualar a la Ps4, y viendo los consumos de la Wii U, no me extrañaría nada que la Wii u estuviera un poco underclockeada de salida y que se pudiera subir la frecuencia de su cpu y gpu mediante en una futura actualización cuando el SO esté más depurado y sea más estable.

Una cosa es subirla antes de entrar en producción, donde puedes testear todas y otra subirla tras llevar un año vendiendo consolas y arriesgarte a que casquen un porcentaje de ellas.

Johny27 escribió:superfenix2020 escribió:por cierto, viendo que Microsoft al final a overclockeado la xboxOne para tratar de igualar a la Ps4, y viendo los consumos de la Wii U, no me extrañaría nada que la Wii u estuviera un poco underclockeada de salida y que se pudiera subir la frecuencia de su cpu y gpu mediante en una futura actualización cuando el SO esté más depurado y sea más estable.

Una cosa es subirla antes de entrar en producción, donde puedes testear todas y otra subirla tras llevar un año vendiendo consolas y arriesgarte a que casquen un porcentaje de ellas.

Fanzelda escribió:Si tuvieras la consola sabrías que seria completamente factible subirla un poco de vueltas. Es un témpano incluso despues de jugar horas, y el consumo y capacidad de la fuente de alimentación lo permite

superfenix2020 escribió:con más razón. has tenido casi 1 año para testearla bien antes de subirla de frecuencia. Microsoft ha tenido menos tiempo de probarla al subirla a última hora de frecuencia, obligados por la Ps4, por ser un 50% más potente.

superfenix2020 escribió:Johny27 escribió:superfenix2020 escribió:por cierto, viendo que Microsoft al final a overclockeado la xboxOne para tratar de igualar a la Ps4, y viendo los consumos de la Wii U, no me extrañaría nada que la Wii u estuviera un poco underclockeada de salida y que se pudiera subir la frecuencia de su cpu y gpu mediante en una futura actualización cuando el SO esté más depurado y sea más estable.

Una cosa es subirla antes de entrar en producción, donde puedes testear todas y otra subirla tras llevar un año vendiendo consolas y arriesgarte a que casquen un porcentaje de ellas.

con más razón. has tenido casi 1 año para testearla bien en tus laboratorios, antes de subirla de frecuencia cuando ya estás 100% convencido de que no tendrá problemas de sobrecalentamiento.

Microsoft ha tenido menos tiempo de probarla porque ha decidido subirla de frecuencia a última hora, obligados por la Ps4, por ser un 50% más potente que la Xone.

Me fío más de la fiabilidad y seriedad de Nintendo en estos temas, que de Microsoft. Con Xbox 360 me demostraron que no tuvieron escrúpulos con sus clientes y lo buenos que son sus ingenieros diseñando consolas.

Y mucho no se han esmerado con la XOne. Han cogido una caja cuadrada y metido dentro todo, estilo PC.

Se nota que ellos no están acostumbrados a fabricar y diseñar aparatos electrónicos de consumo de diseño.

La Ps4 al menos es un poco más pequeña y tiene un mejor diseño, y eso que es más potente.

Y Nintendo, nadie discute que lo hace todo minimalista y buen diseño, pero a la vez, muy fuable. Y eso cuesta, aunque no queramos reconocerlo.

Aún sigo esperando una xbox slim de verdad (estilo wii o wii u en tamaño) o una portátil por parte de Microsoft, a ver si son capaces de diseñarla y fabricarla (y que sea fiable).

Lo suyo son los S.O. no el hardware.

Todopc-WII escribió:(Que tengan slots de memoria, se le pueda cambiar la gráfica) ese día ya no serán consolas tal y como las conocemos.

Johny27 escribió:Fanzelda escribió:Si tuvieras la consola sabrías que seria completamente factible subirla un poco de vueltas. Es un témpano incluso despues de jugar horas, y el consumo y capacidad de la fuente de alimentación lo permite

La temperatura es solo uno de los factores que importan a la hora de hacer una subida de velocidad. Hay diseños que simplemente no aceptan más velocidad por mucho que sigan fríos, los Pentium 3 por ejemplo, o los Athlon XP, que ciertos procesadores por muy fríos que los pusieses (25 grados) no pasaban de cierta velocidad por mucho que les hicieses, y es sabido que el diseño de la cpu de wii u parte de uno que era muy jodido de subir en velocidad.

No es tan fácil como creéis.superfenix2020 escribió:con más razón. has tenido casi 1 año para testearla bien antes de subirla de frecuencia. Microsoft ha tenido menos tiempo de probarla al subirla a última hora de frecuencia, obligados por la Ps4, por ser un 50% más potente.

Con más razón no, con menos, que Nintendo no ha podido testear con la hipotética nueva velocidad las consolas que están ya en las casas. Y la comparación que has puesto de gráficos muestra una diferencia mínima, y más la del batman que se ve que es un simple skin distinto.

sabran escribió:Todopc-WII escribió:(Que tengan slots de memoria, se le pueda cambiar la gráfica) ese día ya no serán consolas tal y como las conocemos.

Hola

Señores hoy es el dia donde la 64 ya no es consola.

Chuko25 escribió:Johny27 escribió:Fanzelda escribió:Si tuvieras la consola sabrías que seria completamente factible subirla un poco de vueltas. Es un témpano incluso despues de jugar horas, y el consumo y capacidad de la fuente de alimentación lo permite

La temperatura es solo uno de los factores que importan a la hora de hacer una subida de velocidad. Hay diseños que simplemente no aceptan más velocidad por mucho que sigan fríos, los Pentium 3 por ejemplo, o los Athlon XP, que ciertos procesadores por muy fríos que los pusieses (25 grados) no pasaban de cierta velocidad por mucho que les hicieses, y es sabido que el diseño de la cpu de wii u parte de uno que era muy jodido de subir en velocidad.

No es tan fácil como creéis.superfenix2020 escribió:con más razón. has tenido casi 1 año para testearla bien antes de subirla de frecuencia. Microsoft ha tenido menos tiempo de probarla al subirla a última hora de frecuencia, obligados por la Ps4, por ser un 50% más potente.

Con más razón no, con menos, que Nintendo no ha podido testear con la hipotética nueva velocidad las consolas que están ya en las casas. Y la comparación que has puesto de gráficos muestra una diferencia mínima, y más la del batman que se ve que es un simple skin distinto.

las consolas q estan en las casas son iguales q las q tendra nintendo, y microsoft q ha probado? Un mes,dos?

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif) [/sarcastic mode off]

[/sarcastic mode off]vamos que es obvio que las suposiciones de AnandTech con respecto al bandwidth de la ram de wiiu no solo estan equivocadas, sino que hicieron suposiciones super bajas de manera intencionada para atraer mas visitas, es mucho mas facil atraer publico con cosas negativas que positivas

, el talon de aquiles en os comentraios de AnandTech estan en suponer que los modulos son de 16 bits, y como son 4 modulos te darioa un bus total de 64bits lo cual es imposible por muchas razones

1.-las consolas de hace 7 años son de 128 bits de bus, asi que como es que nintendo iba despues de tanto tiempo seguir usando un bus de 64bits que ellos mismos vienen usndo desde gamecube?

[Imagen]

2.- no existen gpus de la serie rv770 o del e6760 de menos de 128 bits de bus, el primero puede ser de 256bits o 128 bits, incluso el ultimo que es parasistemas embedidos es de 128 bits, para que la gpu de wiiu tuviera un bus de solo 64bits, tendrian que haber optado por algo tan bajo como un rv710,los cuales fueron diseñados para usar ddr2 y gddr3 en mente, wiiu esta usando ddr3-1600 lo cual es como gddr4, y como pueden ver en la tabla incluso un rv730 puede tener un buis de 128bits si esta pensado en usar gddr3 o gddr4

solo chequen la tabla Chipset table

http://en.wikipedia.org/wiki/Radeon_HD_4000_Series

es obvio que los modulos deben de ser de 32bits para que multiplicados por 4 teden los 128 bits

eso deberia de dar a la ram de wiiu un bndwidth por modulo de 12.8gb/s sumando un total de total de 51.2gb/s

pero si aun lo dudan pueden checar los datos hackeados por el equipo de de homebrew de wiiu y marcan, asi es, los mismo que dijern que el cpu de wiiu es de 1.24gz

solo busquen este nombre en google: Wii U/console - WiiUBrew

no usen correccion de texto entran y esta esta parte

RAM

32MB (MEM1)

2GB (MEM2)

(with 1 GB reserved for the operating system and unavailable to games, consisting of four 4 Gbit (512 MiB) DDR3-1600 memory modules, each 12.8 GB/s bandwidth)

con solo un poquito de ingles se daran cuenta de que dice 4 modulos de 12.8gb/s cada uno, solo multiplicas por 4 y te dara 51.2gb/s

el bandwidt de la edram de wiii puede seguro estar en el tb/s, el de 360 era de 256gb/s pero solo internos que no podian ser aprovechados por su totalidad debido a un bus externo de solo 32gb/s. nintendo ha eliminado este problema poniendo la edram junto a la gpu usando interconexiones y no un bus externo, muy seguramente usando tecnologia SiP planar de renesas, el SiP es algo intermedio entre mcm y soc, podria considerarsele como advanced packaging y parcida a la tecnica de 3d stacking usando transposer. la tecnologia sip es mas barata que la soc, trae casi las mismas ventajas pero ademas de ser menos costoso la testibiliidad es mas fiable entre otras ventajas.

los ports simplemente nop aprovechan la edram pues en el codigo de 360 limita el uso de edram a 10 megas, asi que solo haciendo modificaciones en el codigo o haciendo una version propia de wiiu se podra aprovechar ese bandwidth

dragonsacred escribió:copio un comentario que he visto en otro foro y me ha parecido interesante, a ver que se puee sacar en claro:vamos que es obvio que las suposiciones de AnandTech con respecto al bandwidth de la ram de wiiu no solo estan equivocadas, sino que hicieron suposiciones super bajas de manera intencionada para atraer mas visitas, es mucho mas facil atraer publico con cosas negativas que positivas

el talon de aquiles en os comentraios de AnandTech estan en suponer que los modulos son de 16 bits, y como son 4 modulos te darioa un bus total de 64bits lo cual es imposible por muchas razones

T1100 escribió:dragonsacred escribió:copio un comentario que he visto en otro foro y me ha parecido interesante, a ver que se puee sacar en claro:vamos que es obvio que las suposiciones de AnandTech con respecto al bandwidth de la ram de wiiu no solo estan equivocadas, sino que hicieron suposiciones super bajas de manera intencionada para atraer mas visitas, es mucho mas facil atraer publico con cosas negativas que positivas

el talon de aquiles en os comentraios de AnandTech estan en suponer que los modulos son de 16 bits, y como son 4 modulos te darioa un bus total de 64bits lo cual es imposible por muchas razones

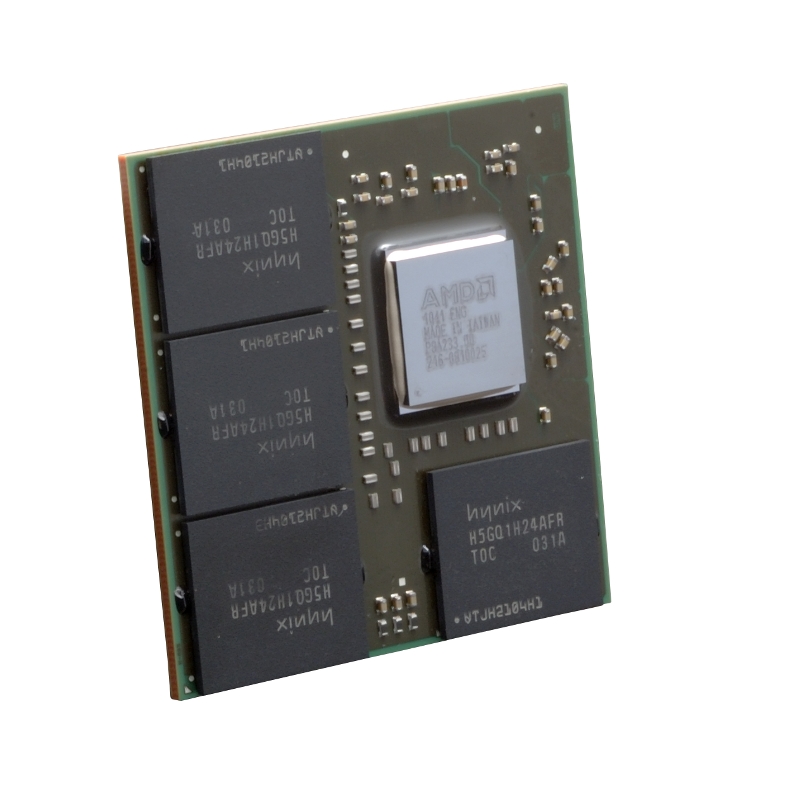

Esta es la memoria que lleva Wii U (se utilizan varios modelos tanto de Samsung como de Hynix, este es uno de ellos)

Estas son las especificaciones de Samsung para ese chip:

La frecuencia de reloj está determinada por la coletilla al final del modelo (HC-12 = 800 MHz)

En la misma página de Samsung se puede ver la diferencia entre GDDR3 y gDDR3 (Wii U), las memorias denominadas por Samsung como "gDDR3" tienen la mitad de bandwidth que las GDDR3 (bus de 16 bits)

http://www.samsung.com/global/business/ ... m/overview

Creo que con esto no hay confusión posible, ¿verdad?