MacGyver escribió:manu7h escribió:Lo del "sobre" lo veo una tontería que solo caería quien "pasa del tema"... Si, meten un sobre vacio y a ti te sale, pero es que en tu cuenta pone por ejemplo "700€ retenciones" o algo parecido, pero es que eso de "retenido" a mi me haría sospechar... Una vez confirman el dinero ya no te lo pueden quitar :S

Eso pensaba yo, Voy a darle mis datos bancarios a ver como termina esto xD

Lo que tengo un poco de miedo que por el camino le pase algo a la grafica, o que se pierda, porque el viaje es largo. ¿en el caso que se perdiera el paquete quien se supone que se tendría que hacer cargo, yo o el comprador?

ismarub escribió:Lo del crysis3 era para ver que siempre puedes ver el limitante en el micro. Evidentemente con un 8320/2600k oceado ahí va a 60 fps.

pero vamos que eso que puede con todos los juegos es una falacia. Siempre andando con matices. Ejemplo que probé en su día:

Daw of war II.

Athlon II x3 .3.1 ghz 35 fps de media

Phenom II 965 4ghz 45 fps de media

2500k stock 66 fps de media

2500k oc 4.5ghz 84fps de media.

Como que no se nota diferencia. Otro caso grave era el battlefield3 con una montaña rusa de fps, donde tener mínimos de 35 fps jugando competitivo era la orden del día. Mejorando el micro, mejoré mis estadísticas. Con eso lo digo todo.

Tampoco es cambiar todos los micros, pero poner cosas equilibradas. Yo para un quad antiguo, pasar de una 270x ni lo intento.

Es más, con el i3 ya he visto que hasta limita en estos juegos a una 750 ti.

sergio_mikkos escribió:Pues la MSi ha vuelto a adelantar a la Gigabyte xDD.

La madre que la parió menudo armatoste, estoy casi convencido de que no me cabe...

wwwendigo escribió:KailKatarn escribió:wwwendigo escribió:Yo pasé de un Q6600 a un i5 2500K que es lo que tengo ahora, le hice OCs hasta 3,6 GHz, y mientras que era un molinillo que agradecía mucho el OC, en juegos, no tenía nada que hacer con OC contra el i5 2500K de stock, pero se notaba una burrada, vamos. Todos los puntos "calientes" de cpudependencia desaparecieron o fueron mitigados tanto como para no ser ya molestos.

Estoy hablando de usar tarjetas como una GTX 560 Ti, así que hazte una idea de con estas novedades, y en la actualidad donde los juegos piden más de cpu que hace 3 años cuando hice este cambio.

Ni tanto, ni tan poco.

Quieres decirme que un Q6600@3'6-3'8ghz hace cuello a una GTX560Ti? lo siento, no. Una cosa, que todo el mundo puede saber, es que el 2500k fuera un caballo ganador por su gran OC y bajas temperaturas con una ganancia de IPC bastante significativa contra lo que ha venido después pero de ahí a intentarme pintar que un C2Q no puede con una GTX560Ti ... es mucho decir.

No estoy absolutamente nada de acuerdo con lo que comentas. Y estoy seguro que muchos usuarios del mod 771 tampoco y los tienen con bastante más gráfica que una GTX560Ti, la cual, encima poco se diferenciaba de una GTX460 de su día que yo tuve oceada a 900mhz de core en mi Q6600@3'8 y me sobró equipo para tenerlo con una HD7850, que barre a las GTX460/560 y sin ningún tipo de problema hasta con la gráfica a 1200mhz de core.

Mucha cuellobotellitis tenéis muchos encima. De todas formas demuéstramelo, quiero ver a una GTX560Ti ahogada por un C2Q a 3'8-4ghz, a la espera me quedo.

A mí me da igual si me crees o no, pero además de tener DATOS sobre el tema:

http://wwwendigo.blogspot.com.es/2011/11/comparativa-q6600-32ghz-vs-2500k-juegos.html

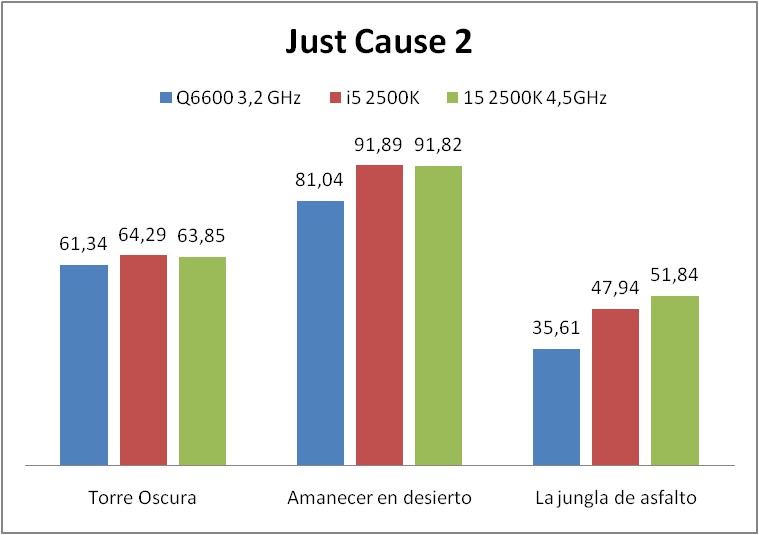

Donde se ven cosas como éstas:

Jugar o no con tasas de 60 fps estables o no, ésa es la cuestión.

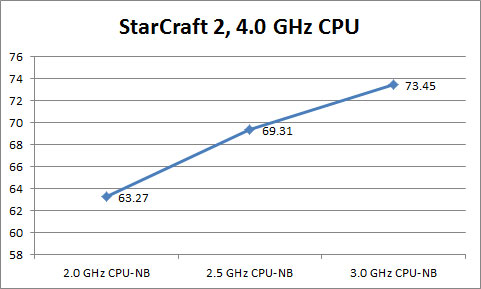

El test "jungla de asfalto" es claramente cpudependiente, y lo único que tiene es una vista aérea en una zona con edificios, algo posible en este juego en ciertas situaciones, la diferencia entre el Q6600 con OC y el 4500K es muy grande, y estamos hablando de tasas por debajod e 60 fps, y no, 400 MHz no cambiaba gran cosa el panorama.

Metro 2033 no llega a 50 fps con el Q6600 a 3,2 GHz, el i5 de stock VA SOBRADO para el potencial de la GTX 560 con esa configuración, ya que no llega (la gráfica) a los 60 fps.

¿Y qué pasa con ciertas situaciones de juegos reales, ni siquiera pasando benchs, donde hay cpudependencia?:

Mira tú, en Borderlands (sí, el primero) en varios puntos de ciertos escenarios, la tasa de fps con el Q6600 bajaba tanto como a 25 fps (a 3,6 GHz cuando lo tuve alguna vez, no llegaba a pasar de 30 fps), mientras el i5 2500 DE STOCK hace 44 fps, con OC se acerca a los 60 fps buscados. Con Dead Rising 2 en parte de los momentos más masivos, la diferencia de tasa de fps es así de masivamente diferente. Ah, estas secciones no mejoraban ni un ápice como ya predije en su momento al pegar un salto desde una GTX 260 a la 560 Ti, y en su momento, ídem con el salto desde la Fermi a varias Kepler, NO tiene nada que ver con la gpu, sólo con la cpu.

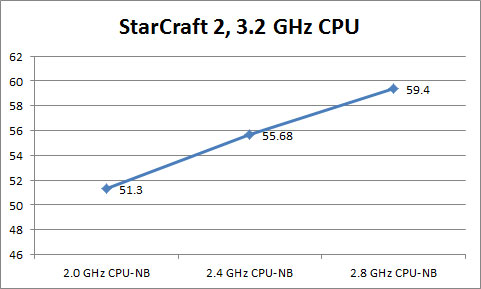

Hay más resultados que apuntan en ese sentido en ese análisis, pero no sólo esos datos, sino la experiencia propia y lo que vi en directo y la sensación real en juego, mira, yo sé distinguir perfectamente cuándo hay limitación por cpu o no en un juego, y en concreto, como sí sé distinguir esto, también sé de paso que cuando esto pasa, da igual si tu gráfica es una GTX 560 Ti o una GTX 980 toda dopada de OC, porque no vas a arañar una mierda de más en fps. Aún recuerdo las masivas mejoras con StarCraft II en ciertos mapeados, donde el i5 de stock iba fluido y el Q6600 como la mierda, aún con todo el OC del mundo (<30 fps, sobre poco más de 20 fps en muchos puntos de éstos mapas/fases de juego exigentes). Y sí, con una GTX 560 Ti como acompañante (sin AA va bastante bien SCII).

Es por eso que me entra la risa cuando veo el típico mantra de "con X cpu tienes suficiente, ya que los fps medios son iguales en tal o cual test" y "la gráfica es demasiado débil", pues va a ser que no, la limitación por cpu ocurre en multitud de juegos aunque sea por zonas o puntos concretos, querer mirar para otro lado usando fps medios en secciones fáciles del juego no va a eliminarlos. Una cpu Qxxxx es una cpu hoy en día muy limitante para muchos casos, y no es buena compañera para muchas gráficas modernas de algo de potencia. Sí, te da en un test "fps medios suficientes", pero ponte a jugar a cosas serias y después hablamos.

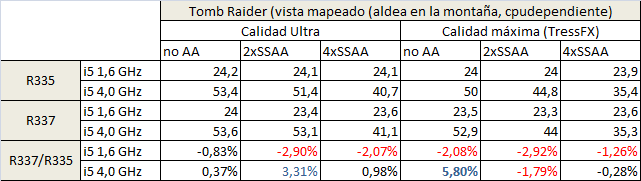

En Tomb Raider hay áreas con la calidad máxima (nivel LOD top) donde OTRA VEZ, la cpu, limita la tasa de fps bien por debajo de 60 fps, dando igual si es una GTX 600/700 u otra gpu más potente, dado que esa limitación de fps se mantiene perfectamente a 720p sin ganar ni un sólo fps, y curiosamente, se mantiene dicha limitación totalmente vinculada a la frecuencia de la cpu, he visto como un i5 de stock apenas llega a 40 fps y cómo se alcanzan casi los 55 fps gracias al OC de la cpu, así que no me vengas diciendo que no existen ciertos límites en una cpu, o que un Q6600 no limita hoy en día, cuando estoy viendo ahora mismo en algunos juegos actuales cómo se puede poner en apuros a un i5, y en su momento vi en directo la ganancia de fps en varios juegos al pasar del Q6600 al i5 2500 (repito, al último lo enfrenté y lo usé inicialmente de stock, y muchísimos juegos ganaban fps o los estabilizaban, y sí, en una GTX 560 Ti).

Estaría bien que no acusaras a nadie de inventarse cosas cuando está hablando de experiencias y además con base, como es mi caso. Uno de los mitos más típico de foros es creer que tal o cual cpu "llega de sobra" para tal gráfica, cuando las situaciones de cpudependencia real muchas veces no tienen nada que ver.

.

.

![guiñando [ginyo]](/images/smilies/nuevos/guinyo_ani1.gif)

rubentribune escribió:MacGyver escribió:manu7h escribió:Lo del "sobre" lo veo una tontería que solo caería quien "pasa del tema"... Si, meten un sobre vacio y a ti te sale, pero es que en tu cuenta pone por ejemplo "700€ retenciones" o algo parecido, pero es que eso de "retenido" a mi me haría sospechar... Una vez confirman el dinero ya no te lo pueden quitar :S

Eso pensaba yo, Voy a darle mis datos bancarios a ver como termina esto xD

Lo que tengo un poco de miedo que por el camino le pase algo a la grafica, o que se pierda, porque el viaje es largo. ¿en el caso que se perdiera el paquete quien se supone que se tendría que hacer cargo, yo o el comprador?

mira el envio en genei.es es mucho mas barato

KailKatarn escribió:

Jajaja, permite que antes de contestarte me parta el pecho porque cuando entras con tus aires de superioridad a intentar dar lecciones es que directamente me da la risa. Ahora empezemos por partes:

Veamos tu imagen del Metro 2033:

Comparémosla contra esta otra de LEGION HARDWARE (fechada en 2010)[b] y no sacada de por ahí donde te de la ganada y ni firmada ni reconocida por nadie, vamos el primer JPG que te has encontrado por ahí:

[/b]

Oh!, vaya! si en un Phenom II 965 no se nota con una HD5870 ni bajándolo a 2ghz ni subiéndolo a 3'6ghz. Que cosas, eh? esto suele pasar cuando uno coge el primer JPG que se encuentra por ahí. Son cosas que pasan.

Link a la review: http://www.legionhardware.com/articles_ ... ide,9.html

Tu imagen del Just Cause 2:

Ahora comparada contra una REVIEW firmada por TOM's HARDWARE donde demuestra lo mismo que antes, que sacar JPGs de vete a saber donde y sin firmar por nadie no suele ser recomendable:

Un 2500k a 4ghz dándo 8 fps más que un Phenom II x4 980 sin oc y sin tocar el NB. Sí, vamos sin lugar a dudas que hay un problema de cuello de botella impresionante en este juego para los C2Q y los Phenom II a 3'8 o 4ghz y más si les subimos el NB a estos últimos, seguro eh?

Lo del Dawn of War ya lo he explicado antes a Ismarub y no me voy a repetir, si quieres lo lees allí. Lo dicho, mucho cuello de botella, eh?

PD: La próxima vez jpgs un poco más serios, anda. Y más si pretendes aleccionar a alguien

![Nop [noop]](/images/smilies/net_thumbsdown.gif) , muy bien por ellos, yo en esa review, además del test dedicado a comprobar el escalado de rendimiento en situaciones de juego real, paso el test con un poquito más de variación de configuraciones gráficas, no sé, para ver mejor las cosas:

, muy bien por ellos, yo en esa review, además del test dedicado a comprobar el escalado de rendimiento en situaciones de juego real, paso el test con un poquito más de variación de configuraciones gráficas, no sé, para ver mejor las cosas:

![facepalm [facepalm]](/images/smilies/facepalm.gif)

![loco [looco]](/images/smilies/nuevos2/borracho.gif)

rubentribune escribió:sergio_mikkos escribió:Pues la MSi ha vuelto a adelantar a la Gigabyte xDD.

La madre que la parió menudo armatoste, estoy casi convencido de que no me cabe...

Por tamaño??

Yo voy a ir a por la gigabyte que tiene mucha mejor temperatura

http://www.guru3d.com/articles_pages/gigabyte_geforce_gtx_970_g1_gaming_review,9.html

http://www.guru3d.com/articles_pages/msi_geforce_gtx_970_gaming_review,9.html

KailKatarn escribió:ismarub escribió:Lo del crysis3 era para ver que siempre puedes ver el limitante en el micro. Evidentemente con un 8320/2600k oceado ahí va a 60 fps.

pero vamos que eso que puede con todos los juegos es una falacia. Siempre andando con matices. Ejemplo que probé en su día:

Daw of war II.

Athlon II x3 .3.1 ghz 35 fps de media

Phenom II 965 4ghz 45 fps de media

2500k stock 66 fps de media

2500k oc 4.5ghz 84fps de media.

Como que no se nota diferencia. Otro caso grave era el battlefield3 con una montaña rusa de fps, donde tener mínimos de 35 fps jugando competitivo era la orden del día. Mejorando el micro, mejoré mis estadísticas. Con eso lo digo todo.

Tampoco es cambiar todos los micros, pero poner cosas equilibradas. Yo para un quad antiguo, pasar de una 270x ni lo intento.

Es más, con el i3 ya he visto que hasta limita en estos juegos a una 750 ti.

Bien, ya has saltado de cuello de botella a que se necesita un i7 oceado o un FX de 4 módulos, eso ya es un avance. Tan avance que estamos hablando de que dejamos fuera tanto a los Phenom II, C2Q e inclusive i5 de la serie sandy, ivy y hasta si me apuras los haswell primeros 4670k sin OC, no? eso le llamas estar bien hecho? yo no lo llamo estar bien hecho.

Luego entramos en el tema de los RTS, de lejos los juegos que más micro piden y lo sabes, pero para eso no tendrías que remontarte al Dawn of War tanto en Starcraft II como en Company of Heroes 2 se nota una barbaridad el IPC, pero eso es de siempre en los RTS, y si no también podemos ir al rome 2 en sus batallas. Eso de lejos es sabido por todo el mundo, pero amigo ... en el caso del C2Q únicamente puedes ganar IPC a mhz pero te aseguro yo que te sorprendería ver en esos juegos a un Phenom II x4 o x6 a 3200mhz de NB porque ya te digo yo que cambia el mundo entero.

Como puedes ver, hasta en el caso de los RTS lo tienes bastante complicado para hundir a un Phenom II x4 a 3000 o 3200 de NB y su bufo impresionante de IPC que coge bajo esas circunstancias.

Luego, por otro lado, el battlefield 3 y 4 es jugado en mi 3er equipo sin ningún tipo de baile de frames de ningún tipo. De hecho da exactamente los mismos FPS que da mi 2º equipo dado a que tienen la misma gráfica y la gráfica toca techo al 99% en todo momento en ambos juegos.

Lo dicho, exageráis los cuellos de botella algunos. Y lo peor es que usáis ejemplos donde hasta un IVY BRIDGE i5 a casi 4ghz toca techo. Vamos, si eso no es software mierdero entonces que es? además un juego muy pasillero y en una única fase donde hunde el PC a cualquiera. Lo único bueno que tiene es que escala en más de 4 núcleos y vés hasta mi Phenom II x6 con mejores gráficas sacando más partido en esa fase que otras soluciones de intel, vamos, de chiste.

Un saludo.

wwwendigo escribió:Mira, estás metiendo la pata no hasta la rodilla, sino hasta los cojones, así que sigue esta serie de pasos antes de decir chorradas sobre de dónde saco los datos y reirte de "mis fuentes":

1.- Coge el móvil, descarga alguna aplicación de lectura de QRs.

2.- Apunta el móvil a la pantalla, en un comentario mío, activa la aplicación y lee el código QR de mi avatar.

3.- Sigue el link que hay en dicho código QR y... oh, sorpresa.

Resulta que te sale esa fuente desconocida, que resulta que soy yo mismo, en reviews que hice en su momento hace años, usando mi Q6600 y mi i5, qué cosas. Mis datos, mis pruebas, ¿dónde están las tuyas? ah no, claro, que tú sabes más porque vas cogiendo migas por ahí... claro.

Es lamentable que vengas con risitas y demás con gráficas de rendimiento en situaciones totalmente distintas a las que yo he testado (está claro que tú del método científico y diseño de un experimento no sabes gran cosa), y por cierto, aquí el que no pone fuentes eres tú, pones imágenes pero no links como en el caso de Toms (no vaya a ser, ¿verdad?), como si así demostraras una mierda, ni me voy a molestar en desgranar y explicar porqué no son comparables cada caso, sólo uno como simple ejemplo de cómo no meter la pata, ése que pones de Tomshardware con Just Cause 2, yo describo perfectamente la situación de cpudependencia como la de la prueba "Jungla de asfalto", tú pones una imagen que no dices qué prueba es, cuando resulta que hay otras dos pruebas que son totalmente gpudependientes como también muestro, y a diferencia de mi caso, donde pongo uno de los tests integrados concretamente de dicho juego. ¿Qué test están usando en Just Cause 2, es un walktrhough o uno de los otros tests? ¿cuál? claro, no pones fuentes, es un buen comienzo para "rebatir" una mierda.

Claro, tú hablas recogiendo pruebas de otros lados de donde no sabemos ni una mierda de test usado. Y yo... paso tests con un setup bien definido, y lo más importante, definiendo claramente las condiciones de cada prueba, algo que te la suda a la hora de comparar churras con merinas. Que no me cuentes milongas, que más torpe no se puede ser con la tontería de cómo has venido diciendo que no sabemos tal o cual, cuando estoy hablando de datos recolectados por mí y no sólo impresiones.

Anda, ríete hombre, ríete de los demás porque te pongan datos de "fuentes sin firmar", y haz más el ridículo así.

PD: Te doy un único aviso, como vayas por ese camino de descalificar ya sabes lo que habrá. A mí no me vengas con vacilillos de patio de recreo.

ismarub escribió:Mira que lo he dicho ya veces. Tenía un phenom II x4. No x6, como lo son las capturas que has puesto (que son de otro forero) y tu tienes un x6. Ya sabemos que en battlfefield agradece el nº de hilos se nota la diferencia entre un procesador mejor o con más hilos. Un quad viejo, i3, etc... no mantiene los 60 fps estables en bft3, que es como se juega idóneo para no ir por debajo del resto. Sobre subir el nb, para llegar a esos extremos necesitas una placa base demasiado buena. De nada sirve ahorrar por un lado y luego lo gastamos por otro. Por lo tanto, no es apto para todos.

Pero vamos, si un juego cpu-dependiente no da la talla con un quad antiguo, se dice y punto, porque me ha pasado y por eso cambié en su día. Muy mala compra el x4 en 2011 a pesar del precio. Recomendar una gráfica gama alta actual a esos equipos es tirar el dinero y desinformar.

He visto recomendar hd 7970 a i3 sandys diciendo que va a rendir al 100%. Una cosa es cuellobotellitis y otra recomendar equipos claramente desproporcionados.

ICETOSKI escribió:A ver no os asusteis con la gigabyte.Mi caja es una CM 431 y pone 31cm como mucho.

Pero el.windforce acaba en punta,y esos 31 cm es hasta la punta,y esta punta entra entre las bahias para discos duros.

Ahora mismo lo he medido y cabria hasta 31,7 exactamente,para quien le pudiera interesar

sergio_mikkos escribió:ICETOSKI escribió:A ver no os asusteis con la gigabyte.Mi caja es una CM 431 y pone 31cm como mucho.

Pero el.windforce acaba en punta,y esos 31 cm es hasta la punta,y esta punta entra entre las bahias para discos duros.

Ahora mismo lo he medido y cabria hasta 31,7 exactamente,para quien le pudiera interesar

Y mi caja es una Antec Nine Hundred Two v3 y ya te digo yo que así a ojo no cabe...

PD: Se agradecería que dejarais el offtopic sí.

De las últimas 5 páginas veo 10 comentarios interesantes relacionados con el tema y el resto basura.

.

.Hay placas que te hacen los 2800-3200mhz de NB desde que salieron las 890FX, vamos, desde el principio de estas plataformas, otra cosa es que la gente siga pensando que ahorrar en placa es lo mejor que puede hacer con su equipo.

Por descontado que estoy a favor de que los equipos se monten equilibrados, faltaría, pero lo que estoy diciendo es que no estoy para nada de acuerdo en que la vida de los C2Q subidos y los Phenom II bien subidos (y con su NB como Dios manda) hayan dicho su última palabra.

Que no me compraba uno ahora y le montaba una 970/980? de acuerdo, pero de ahí a tenerlo y plantearte cambiar la plataforma entera pues como que no y menos en el caso de los Phenom II que subir el NB los hace dispararse, vamos, es que a un Phenom II x6 bien subido le ponía la 970 pero sin mirar atrás.

PD: Y luego no olvidemos MANTLE y DX12 que precisamente está ahí para ayudar a estos micros, apus y derivados.

Todo viene por esto:cheito escribió:

en todos los juegos la grafica se pone al 99% de carga asi que no me hace cuello de botella, es un proce muy competente a 3,8/4,0Claro que se nota mucho el OC en cualquier plataforma, en 775, que encima son grandes oceadores, pues como en todos. Yo tuve un Q6600 2'4@3'8ghz OC y aún me arrepiento de haberlo vendido en su día y tengo un amigo con un Q9650 3ghz@4'2ghz que directamente con una HD7950@1200//1700 le va absolutamente todo.

De hecho en DSOgaming usan un C2Q de estos desde hace mucho y siempre estudian el resultado que les da respecto al micro. El problema es que el consumismo ha hecho mucho daño y el marketing más.

De ahí las replicas. Casos de juegos que limiten esas plataformas, los hay y más casos que plataformas recientes. Es como lo de jugar en ultra con un pc de hace 4 años. Luego dicen que si a 30, que si a 720p, etc... matizando. Al final seguro que acabáis matizando, que si juegos mal optimizados, que si esa saga no me gusta ,etc.....

Al principio decís que un qxxx puede sin pestañear con todo y que cambiar, prácticamente es consumismo. Así lo he visto yo. De ahí que algunos no estemos deacuerdo por propia experiencia y que ni se me ocurriría recomendar una 970 o 980 si no va a poner algo mejor en breve.

Sobre el phenom II, al principio tenía una placa 760 y luego una 890fx usada. Como es lógico, si compré el phenom II era para ahorrar. Si hay que gastar mucho más en el resto, me iba a por un i5 bloqueado y placa salchichera. Me iba a dar más rendimiento sin tener que tocar nada.

Hasta aquí el offtopic. Saludos.

ismarub escribió:Offtopic:Hay placas que te hacen los 2800-3200mhz de NB desde que salieron las 890FX, vamos, desde el principio de estas plataformas, otra cosa es que la gente siga pensando que ahorrar en placa es lo mejor que puede hacer con su equipo.

Por descontado que estoy a favor de que los equipos se monten equilibrados, faltaría, pero lo que estoy diciendo es que no estoy para nada de acuerdo en que la vida de los C2Q subidos y los Phenom II bien subidos (y con su NB como Dios manda) hayan dicho su última palabra.

Que no me compraba uno ahora y le montaba una 970/980? de acuerdo, pero de ahí a tenerlo y plantearte cambiar la plataforma entera pues como que no y menos en el caso de los Phenom II que subir el NB los hace dispararse, vamos, es que a un Phenom II x6 bien subido le ponía la 970 pero sin mirar atrás.

PD: Y luego no olvidemos MANTLE y DX12 que precisamente está ahí para ayudar a estos micros, apus y derivados.

Todo viene por esto:cheito escribió:

en todos los juegos la grafica se pone al 99% de carga asi que no me hace cuello de botella, es un proce muy competente a 3,8/4,0Claro que se nota mucho el OC en cualquier plataforma, en 775, que encima son grandes oceadores, pues como en todos. Yo tuve un Q6600 2'4@3'8ghz OC y aún me arrepiento de haberlo vendido en su día y tengo un amigo con un Q9650 3ghz@4'2ghz que directamente con una HD7950@1200//1700 le va absolutamente todo.

De hecho en DSOgaming usan un C2Q de estos desde hace mucho y siempre estudian el resultado que les da respecto al micro. El problema es que el consumismo ha hecho mucho daño y el marketing más.

De ahí las replicas. Casos de juegos que limiten esas plataformas, los hay y más casos que plataformas recientes. Es como lo de jugar en ultra con un pc de hace 4 años. Luego dicen que si a 30, que si a 720p, etc... matizando. Al final seguro que acabáis matizando, que si juegos mal optimizados, que si esa saga no me gusta ,etc.....

Al principio decís que un qxxx puede sin pestañear con todo y que cambiar, prácticamente es consumismo. Así lo he visto yo. De ahí que algunos no estemos deacuerdo por propia experiencia y que ni se me ocurriría recomendar una 970 o 980 si no va a poner algo mejor en breve.

Sobre el phenom II, al principio tenía una placa 760 y luego una 890fx usada. Como es lógico, si compré el phenom II era para ahorrar. Si hay que gastar mucho más en el resto, me iba a por un i5 bloqueado y placa salchichera. Me iba a dar más rendimiento sin tener que tocar nada.

Hasta aquí el offtopic. Saludos.

Si nos basamos en el ejemplo que tú has puesto cualquier i5 hasta actual hace cuello de botella a las gráficas. Yo lo que si veo siempre es que cuando se intenta hablar de cuello de botella se va a la misma fase de un juego que ni un IVY a casi 4ghz puede con él y con eso se basa que hay cuello de botella. Lo siento, yo no lo veo así, para mi un juego que no pueda dar el do-de-pecho con un IVY a 4ghz es un insulto a la inteligencia y al buen software. Y luego cuando no es esa fase siempre se habla de RTS y ya has visto lo que subir el NB es capaz de hacer en el Phenom II.

Empezamos a recomendar a todos los usuarios de i5 que cambien la plataforma?

Si hablamos de ahorrar ya no digamos lo que está ahorrando el ususario de un phenom II x6 a 4 o más ghz y con un NB de 3000 o 3200 que puede tener desde hace 4-5 años tranquilamente. Ese si que ha ahorrado y sigue ahorrando dinero. Y no quien ha cambiado de plataforma ya 1 o 2 veces porque le han dicho que tiene cuello de botella.

ismarub escribió:Mira que lo he dicho ya veces. Tenía un phenom II x4. No x6, como lo son las capturas que has puesto (que son de otro forero) y tu tienes un x6. Ya sabemos que en battlfefield agradece el nº de hilos se nota la diferencia entre un procesador mejor o con más hilos. Un quad viejo, i3, etc... no mantiene los 60 fps estables en bft3, que es como se juega idóneo para no ir por debajo del resto. Sobre subir el nb, para llegar a esos extremos necesitas una placa base demasiado buena. De nada sirve ahorrar por un lado y luego lo gastamos por otro. Por lo tanto, no es apto para todos.

Pero vamos, si un juego cpu-dependiente no da la talla con un quad antiguo, se dice y punto, porque me ha pasado y por eso cambié en su día. Muy mala compra el x4 en 2011 a pesar del precio. Recomendar una gráfica gama alta actual a esos equipos es tirar el dinero y desinformar.

He visto recomendar hd 7970 a i3 sandys diciendo que va a rendir al 100%. Una cosa es cuellobotellitis y otra recomendar equipos claramente desproporcionados.

Pero vamos, aquí hay que guiarse sólo de benchs sintéticos como el de tomb raider totalmente gpu-dependiente (no el juego en algunas zonas). Luego si no va del todo bien en algunos juegos o no aprovecha la gráfica, es culpa del juego, programación,,etc... Todo para no admitir que no se compró con cabeza.

Es lo que es. El i3 seguramente irá muy bien en varios juegos que usen pocos hilos pesados, pero sólo son 2 cores y acabará pagando el pato en alguno, como de hecho me pasó al desactivar dos cores en el i5 y pasar pruebas (de juego real, locura total) de BF4 en mapeados de single, donde arrastraba el culo incluso a 4 GHz, como no lo hacía el quad a 1,6 GHz.

Lo mismo pasa con muchos AMD, la potencia total si se usan muchos hilos y está bien ponderado, es buena, pero los juegos tienen la manía de no ser así su distribución de carga, tienden a cargar mucho en algún hilo por parte de sus subsistemas del juego más pesados, el resultado, bajadas de tasas de fps en situaciones complicadas. Igual queda bonito en un bench o incluso parece ir bien en un walkthrough, hasta que llega una situación de darle candela y se va a tomar todo por culo.

El Q6600 es una cpu muy pasada ya, sigue siendo capaz para muchas cosas, pero ni de coña se puede considerar una buena cpu para un equipo gamer medio hoy en día, porque va a ralentizar mucho sí o sí en situaciones más habituales que lo contrario. Eso ya pasaba hace 3 años, más va a pasar ahora con los juegos y gráficas actuales, más pesados/potentes.

KailKatarn escribió:A ver te voy a hablar claro:

Para empezar, tus pruebas, me dan exactamente igual. Por qué? por la sencilla razón que yo no estoy ahí para saber ni como tienes configurados tus equipos, como tienes hechas las cosas y menos después de mirar REVIEWS HECHAS POR PROFESIONALES (y que se gastan bastantes menos humos que tú, pero bastantes bastantes menos) chocan abultadamente contra las tuyas, y más cuando me estabas mostrando METRO 2033 como un juego CPU dependiente (cuando todo el mundo sabe que es GPU dependiente a morir) y directamente has podido ver que ni de 2ghz a 3'8ghz lo notan.

Que te haces tus reviews? me parece bien, pero de ahí a que te creas que las voy a tomar como referencia de nada o que me van a valer más que reviews hechas y firmadas por profesionales que de no cumplirlas como dios manda se juegan su credibilidad pues que quieres que te diga, como que las tuyas me dan igual. Luego por descontado lejos de hablar de la parte de la selva ya saltamos a que si en el just cause 2 en tal sitio y tal bla bla bla, y tal y cual, porque claro, que una parte de un juego pida algo más de micro es asunto absoluto para cambiarse la plataforma.

Además, que no me vas a enseñar nada. Que he tenido un Q6600@3'8ghz, tengo a mano cualquier día un Q9650@4'2ghz y encima, por si fuera poco tengo un Phenom II x6@4'2ghz y a 3000NB y los he tenido y tengo con mejores gráficas que las que las estás pinchando tú y NO HABÍA CUELLO DE BOTELLA NI LO HAY. Vamos, que no me vas a enseñar ni a mostrar, ni a mi, ni a los profesionales como has podido ver, cosas que hemos probado o podemos probar in-situ.

Lo dicho, cuando necesite tus lecciones (y vaya lecciones) ya te llamo si eso. Y sigo recomendando a todos aquellos usuarios que tengan sus C2Q y Phenom II x4 y x6 que sigan disfrutando sus equipos y que se olviden de la cuellobotellitis, la cuellobotellitis son los padres y basarlo en fases de juego da hasta risa.

Bien, agradezco que hables más "claro", pero sobre todo sin tanta risita y falta de respeto a mis datos, que no son ni invenciones ni mitos de foro que yo haya leido y me los crea.

Sobre lo que dices, me extraña que digas que no controlas el setup de mis pruebas y demás, y después me vengas con resultados ajenos de los que controlas si cabe menos (en mis reviews hay siempre una descripción de setup hard/conf igual o mejor que muchas reviews "profesionales"). Tú mismo, porque estás diciendo que mis pruebas "no valen" o "no las quieres" pero después usas materiales peor definidos y con gente con la que además no obtienes ningún feedback para aclarar las dudas. Yo me baso en mi experiencia pero no subjetiva, sino objetiva, no soy ningún novato en estos temas y por desgracia me conozco la mierda que hay detrás de muchos sites "afamados", que son bastante mediocres en su trabajo (y aún así, puedo estimar sus resultados, pero NO sin un punto crítico y según cómo sea su procedimiento).

Como ya he dicho, esas lecciones que tan malas te parecen, deberías tomarlas en cuenta, porque a diferencia de sites así, yo cuando analizo algo, tengo en cuenta eso de cómo va algo en juego o, si veo cualquier tipo de anomalía, lo digo y no la escondo. Otra cosa no seré, pero metódico lo soy como en algunos otros lados no lo son.

Yo hablo de que es en juego cuando se notan esos bajones, y no entiendo que alguien que dice que juega niegue la importancia de dichos bajones, porque precisamente:

En Borderlands 1 cuando sucecen estos bajones, no son momentáneos, sino que se dan en secciones enteras de algunos mapeados (normalmente con bastantes edificios a la vista), algunos de ellos tan importantes y visitados como Tartarus Station, o de forma muy masiva en T-Bone junction de las expansiones. Pasa más en los mapas de éstos que en el original, pero pasa en todos con esta opción gráfica cpudependiente a las claras, y como ya he dicho, es masivo en ciertos mapas, haciendo difícilmente jugable el momento en un Q6600, o no precisamente fluido del todo en un i5 de stock como el 2500K.

En Dead Rising 2 las ralentizaciones y bajones a 40 fps son normales en situaciones de muchos enemigos (el 50% del juego) con un Q6600, pero eso no es lo malo dado que esto es aún jugable (pero LEJOS de ser perfecto), sino que básicamente en las áreas del final, dado que cada vez hay más y más zombis, hacen al juego mucho más cpudependiente (en un i5 como la seda, pero en un Q6600.. no tan bien, precisamente).

En Tomb Raider, hay mapas enteros como "Aldea en la montaña" muy cpudependientes, no sólo es que sea como he puesto antes, un punto de hundimiento del rendimiento, que lo hay, sino que la tasa en general baja bastante, sobre todo cuando se está mirando hacia las vistas con más "detalles lejanos". Son horas de juego en ese mapa, ya que es revisitado.

En Lost Planet 1 situaciones como la fase de la caverna son muy distintas en una cpu y en otra, y no es el único área con este tipo de problema.

Es un suma y sigue, ni siquiera me voy a hablar de juegos modernos, pongo juegos considerados "ligeros" pero que no lo son tantos, recuerdo perfectamente las ralentizaciones muy fuertes en mapas de la campaña con el Q6600 que desaparecieron con el i5, te aseguro que jugar a "The Dig" con el Q6600 vs el 2500K, aún con una GTX 560 Ti, es una experiencia muy distinta, en un caso roza lo injugable, y de hecho se nota por una bajada enorme del rendimiento de juego PROPIO, que da lugar a un aparentemente aumento de dificultad subjetivo (porque tardas en realizar comandos a unidades por culpa de ese rendimiento, y es una fase que exige rapidez de ejecución de comandos en distintas áreas), no son sólo un par de situaciones escondidas.

Una cosa es el conformismo y otra muy distinta tragar con rendimientos que sabes insuficientes con la idea de "después irá mejor", y pases mal varias fases por esto. No es ninguna broma el efecto de una buena cpu en muchos juegos, y lo que más claro me ha quedado con el tiempo, es que si te gastas el dinero en gráficas de gama media para alta, moléstate también en gastar en una cpu "media.alta" como mínimo, porque se va a notar.

No es ningún mito, no es cuestión de montar una cpu ultra-cara, es que si no montas una mínimamente ágil, acabarás notando incluso donde no te esperas la falta de músculo, porque los juegos reales... al final poco tienen que ver con mostrar fps medios de la fase de inicio o un bench integrado, lamentablemente. La mayoría de juegos no están necesariamente balanceados en carga de cpu de forma SIMILAR en todo su transcurso.

. Solo comento no se casi nada de Sli/crossfire

. Solo comento no se casi nada de Sli/crossfire  Saludos

Saludos tony huerta escribió:Alguien tiene la torre Cooler Master 690-III, por si sabe si la Gigabyte 980 entraría.

tony huerta escribió:Alguien tiene la torre Cooler Master 690-III, por si sabe si la Gigabyte 980 entraría.

ICETOSKI escribió:sergio_mikkos escribió:ICETOSKI escribió:A ver no os asusteis con la gigabyte.Mi caja es una CM 431 y pone 31cm como mucho.

Pero el.windforce acaba en punta,y esos 31 cm es hasta la punta,y esta punta entra entre las bahias para discos duros.

Ahora mismo lo he medido y cabria hasta 31,7 exactamente,para quien le pudiera interesar

Y mi caja es una Antec Nine Hundred Two v3 y ya te digo yo que así a ojo no cabe...

PD: Se agradecería que dejarais el offtopic sí.

De las últimas 5 páginas veo 10 comentarios interesantes relacionados con el tema y el resto basura.

Te lo digo porque tengo una 290 tambien con el windforce y el fabricante pone que mide 29 pero a la hora de medirla,esos 29cm son desde el anclaje a la caja pero en su punto mas exterior,es decir donde los tornillos.Si la mido desde la chapa de metal,es decir,a partir de los tornillos a mi me dan 28cm.Asi que yo diria que si tienes 30 cm desde tornillos a bahias ha de caber.

Fijate que el windforce acaba en punta,y esa punta es mas pequeña que el ancho de las bahias,asi que tendrias esa punta un pelin metida en las bahias,pero cabria.

Lo comento por si alguien quiere la gugabyte si o si por temas de temperaturas porque es la mas fresca segun todos los benchmarks

ICETOSKI escribió:tony huerta escribió:Alguien tiene la torre Cooler Master 690-III, por si sabe si la Gigabyte 980 entraría.

Macho,en esa caja caben hasta 42cm,tienes de sobra.Solo has de desmontar el kit central de bahias y listo.

saludos

saludos tony huerta escribió:ICETOSKI escribió:tony huerta escribió:Alguien tiene la torre Cooler Master 690-III, por si sabe si la Gigabyte 980 entraría.

Macho,en esa caja caben hasta 42cm,tienes de sobra.Solo has de desmontar el kit central de bahias y listo.

Gracias, viendo las specs. en la web ya lo he visto, debi mirarlo antes de preguntar.

Un porron ajajjaja

Un porron ajajjaja ICETOSKI escribió:Por favor que alguien pare estos offtopic o crear otro hilo para el asunto.

Respetar un poco el hilo y el contenido del titulo por favor

![demoniaco [sati]](/images/smilies/nuevos2/demonio.gif) )

)

Light Killuminati escribió:He visto por ahí recientemente que las gtx970 requieren 30Amperios y recomiendan 500w como ya sabían.

En caso de Sli serian 60A minimo, y eso solo dan las fuentes desde 750w.

Lo digo por uno que quería ponerse sli 970 en una fuente 650w, seguramente tendrá 50Amperios. De W sobra pero de Amperios nose algo puede flojear por ahí. Solo comento no se casi nada de Sli/crossfire

Saludos

alanwake escribió:ICETOSKI escribió:Por favor que alguien pare estos offtopic o crear otro hilo para el asunto.

Respetar un poco el hilo y el contenido del titulo por favor

siempre que entra el mismo de siempre, los hilos donde aparecen las palabras "amd/mantle" ya se jodió.. ya se ha reportado algun mensaje, a ver si de una vez le pegan un buen aviso (la moderación ya sabe)

Me tienta un sli de 970 leñe, pero resistiré

![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

cheito escribió:Yo referente al offtopic solo dije hace unos hilos que mi idea es coger una 970 ahora y actualizar la plataforma cuando el i7 5820k baje de precio, sobre todo placas... y que tengo un q9550 oceado a 3,8 que no le hace cuello de botella a mi gtx 660 ti...

La relacion con el hilo es que si os parece razonable a lo largo del proximo año actualizar mi equipo de la siguiente manera:

1- Gtx 970 ahora

2- i7 5820k+placa+ram cuando bajen de precio

3- Otra Gtx 970 para hacer sli a largo plazo

Scofield escribió:Si no voy a jugar en 4k, me recomendáis la 970 o la 760? Valen la pena esos 100 euros de diferencia si "sólo" juego en full hd?

http://www.pccomponentes.com/movil/msi_ ... gddr5.html

cheito escribió:Yo referente al offtopic solo dije hace unos hilos que mi idea es coger una 970 ahora y actualizar la plataforma cuando el i7 5820k baje de precio, sobre todo placas... y que tengo un q9550 oceado a 3,8 que no le hace cuello de botella a mi gtx 660 ti...

La relacion con el hilo es que si os parece razonable a lo largo del proximo año actualizar mi equipo de la siguiente manera:

1- Gtx 970 ahora

2- i7 5820k+placa+ram cuando bajen de precio

3- Otra Gtx 970 para hacer sli a largo plazo

wwwendigo escribió:OFFTOPIC:

Respuesta:Bien, agradezco que hables más "claro", pero sobre todo sin tanta risita y falta de respeto a mis datos, que no son ni invenciones ni mitos de foro que yo haya leido y me los crea.

Sobre lo que dices, me extraña que digas que no controlas el setup de mis pruebas y demás, y después me vengas con resultados ajenos de los que controlas si cabe menos (en mis reviews hay siempre una descripción de setup hard/conf igual o mejor que muchas reviews "profesionales"). Tú mismo, porque estás diciendo que mis pruebas "no valen" o "no las quieres" pero después usas materiales peor definidos y con gente con la que además no obtienes ningún feedback para aclarar las dudas. Yo me baso en mi experiencia pero no subjetiva, sino objetiva, no soy ningún novato en estos temas y por desgracia me conozco la mierda que hay detrás de muchos sites "afamados", que son bastante mediocres en su trabajo (y aún así, puedo estimar sus resultados, pero NO sin un punto crítico y según cómo sea su procedimiento).

Como ya he dicho, esas lecciones que tan malas te parecen, deberías tomarlas en cuenta, porque a diferencia de sites así, yo cuando analizo algo, tengo en cuenta eso de cómo va algo en juego o, si veo cualquier tipo de anomalía, lo digo y no la escondo. Otra cosa no seré, pero metódico lo soy como en algunos otros lados no lo son.

Yo hablo de que es en juego cuando se notan esos bajones, y no entiendo que alguien que dice que juega niegue la importancia de dichos bajones, porque precisamente:

En Borderlands 1 cuando sucecen estos bajones, no son momentáneos, sino que se dan en secciones enteras de algunos mapeados (normalmente con bastantes edificios a la vista), algunos de ellos tan importantes y visitados como Tartarus Station, o de forma muy masiva en T-Bone junction de las expansiones. Pasa más en los mapas de éstos que en el original, pero pasa en todos con esta opción gráfica cpudependiente a las claras, y como ya he dicho, es masivo en ciertos mapas, haciendo difícilmente jugable el momento en un Q6600, o no precisamente fluido del todo en un i5 de stock como el 2500K.

En Dead Rising 2 las ralentizaciones y bajones a 40 fps son normales en situaciones de muchos enemigos (el 50% del juego) con un Q6600, pero eso no es lo malo dado que esto es aún jugable (pero LEJOS de ser perfecto), sino que básicamente en las áreas del final, dado que cada vez hay más y más zombis, hacen al juego mucho más cpudependiente (en un i5 como la seda, pero en un Q6600.. no tan bien, precisamente).

En Tomb Raider, hay mapas enteros como "Aldea en la montaña" muy cpudependientes, no sólo es que sea como he puesto antes, un punto de hundimiento del rendimiento, que lo hay, sino que la tasa en general baja bastante, sobre todo cuando se está mirando hacia las vistas con más "detalles lejanos". Son horas de juego en ese mapa, ya que es revisitado.

En Lost Planet 1 situaciones como la fase de la caverna son muy distintas en una cpu y en otra, y no es el único área con este tipo de problema.

Es un suma y sigue, ni siquiera me voy a hablar de juegos modernos, pongo juegos considerados "ligeros" pero que no lo son tantos, recuerdo perfectamente las ralentizaciones muy fuertes en mapas de la campaña con el Q6600 que desaparecieron con el i5, te aseguro que jugar a "The Dig" con el Q6600 vs el 2500K, aún con una GTX 560 Ti, es una experiencia muy distinta, en un caso roza lo injugable, y de hecho se nota por una bajada enorme del rendimiento de juego PROPIO, que da lugar a un aparentemente aumento de dificultad subjetivo (porque tardas en realizar comandos a unidades por culpa de ese rendimiento, y es una fase que exige rapidez de ejecución de comandos en distintas áreas), no son sólo un par de situaciones escondidas.

Una cosa es el conformismo y otra muy distinta tragar con rendimientos que sabes insuficientes con la idea de "después irá mejor", y pases mal varias fases por esto. No es ninguna broma el efecto de una buena cpu en muchos juegos, y lo que más claro me ha quedado con el tiempo, es que si te gastas el dinero en gráficas de gama media para alta, moléstate también en gastar en una cpu "media.alta" como mínimo, porque se va a notar.

No es ningún mito, no es cuestión de montar una cpu ultra-cara, es que si no montas una mínimamente ágil, acabarás notando incluso donde no te esperas la falta de músculo, porque los juegos reales... al final poco tienen que ver con mostrar fps medios de la fase de inicio o un bench integrado, lamentablemente. La mayoría de juegos no están necesariamente balanceados en carga de cpu de forma SIMILAR en todo su transcurso.

Ahora que ya me hablas con más normalidad intentaré yo hablarte con respeto y moderación:

Mira, me has nombrado juegos de PC que yo no puedo considerar ni juegos. La inmensa mayoría de juegos de Capcom son un desastre en PC completa y totalmente absoluto, lo siento, no puedo contar como juegos serios software de tan lamentable calidad y especialmente los lost planet y los dead rising. Son directamente un insulto al software bien hecho.

Luego sobre el borderlands 1 ya te puedo decir que no estoy de acuerdo. Hace nada me pasé con un par de amigos el 1 y el 2 a 4 players co-op in-situ, no cada uno en su casa, y precisamente uno de los equipos que estuvo jugando al 1 y al 2 era el Q9650@4'2ghz con la HD7950@1200//1700 y 60 fps como rocas tenía el tio. No sé si lo jugarías recién salido, que el juego estuvo desastrosamente sacado a pc, pero con el paso del tiempo lo mejoraron mucho y que decir del 2 que muestra mapas más grandes y funciona mucho mejor en cualquier equipo, y más que nada te lo digo porque también se lo pasó a 60 fps como rocas.

Si nos ponemos en esos planes podríamos decir que cualquier micro a día de hoy hace cuello al crysis 1. Hay juegos que simplemente están hechos como el culo y los que mencionas precisamente son de los primeros de la lista en estar hechos como el culo, los de capcom (conocida como cap-port).

Hay juegos que muestran mucho más en pantalla que van mucho mejor que esos 2 juegos que comentas, y eso no deja de demostrar una y otra vez que están hechos como el culo. Sólo hay que ver como rinde ese Q9650@4'2ghz en MANTLE en el BF4.

Siempre ha habido juegos basura y moverlos a base de fuerza bruta cuando hay juegos que muestran mucho más pidiendo mucho menos sólo demuestra que están hechos como el culo y que no merece la pena ni ponerse a analizarlos y mucho menos jugarlos.

Scofield escribió:Si no voy a jugar en 4k, me recomendáis la 970 o la 760? Valen la pena esos 100 euros de diferencia si "sólo" juego en full hd?

http://www.pccomponentes.com/movil/msi_ ... gddr5.html

Andrese7 escribió:Chicos, ¿qué ensamblador cojo de PCComponentes, Gigabyte o MSI?

nuha2009 escribió:Yo acabo de preguntar a Amazon.es y me han dicho que las nuevas tarjetas gráficas nvidia no la van tener en venta. No se si estaba hablando de otra cosa o no tiene ni puta idea.

KailKatarn escribió:Ahora que ya me hablas con más normalidad intentaré yo hablarte con respeto y moderación:

Mira, me has nombrado juegos de PC que yo no puedo considerar ni juegos (sobrada... vamos). La inmensa mayoría de juegos de Capcom son un desastre en PC completa y totalmente absoluto (por eso fueron pioneros de juegos portados a DX10 y en uso de multicore con el MT framework), lo siento, no puedo contar como juegos serios software de tan lamentable calidad y especialmente los lost planet y los dead rising (dame un mejor ejemplo, a ver qué consideras "buena calidad", por curiosidad de programador, nada más). Son directamente un insulto al software bien hecho. (oleeee,

).

Luego sobre el borderlands 1 ya te puedo decir que no estoy de acuerdo. Hace nada me pasé con un par de amigos el 1 y el 2 a 4 players co-op in-situ, no cada uno en su casa, y precisamente uno de los equipos que estuvo jugando al 1 y al 2 era el Q9650@4'2ghz con la HD7950@1200//1700 y 60 fps como rocas tenía el tio. No sé si lo jugarías recién salido, que el juego estuvo desastrosamente sacado a pc, pero con el paso del tiempo lo mejoraron mucho y que decir del 6 que muestra mapas más grandes y funciona mucho mejor en cualquier equipo, y más que nada te lo digo porque también se lo pasó a 60 fps como rocas.

Si nos ponemos en esos planes podríamos decir que cualquier micro a día de hoy hace cuello al crysis 1. Hay juegos que simplemente están hechos como el culo y los que mencionas precisamente son de los primeros de la lista en estar hechos como el culo, los de capcom (conocida como cap-port).

Hay juegos que muestran mucho más en pantalla que van mucho mejor que esos 2 juegos que comentas (dime uno, que como DR2 muestre varios cientos de enemigos en pantalla, mientras los combates, por curiosidad), y eso no deja de demostrar una y otra vez que están hechos como el culo (no, no has demostrado nada con esto, sólo estás despotricando contra CAPCOM porque te he puesto X ejemplos, pero no has dicho ni una sóla razón para que sean "malos ports", precisamente, insisto, uno de los primeros juegos DX10, Lost Planet, Resident Evil 5, usaban quad cores bien mientras otros juegos no pasadan de un único core, incluso juegos PC 100%). Sólo hay que ver como rinde ese Q9650@4'2ghz en MANTLE en el BF4 (no sé qué tiene que ver Mantle y BF4 con otros juegos, aunque seguramente tendrá rascadas de rendimiento igual que no te ha mostrado dihco usuario, o simplemente, que no las ves cuando pasan)).

Siempre ha habido juegos basura y moverlos a base de fuerza bruta cuando hay juegos que muestran mucho más pidiendo mucho menos (dime un juego que muestra mucho más de la época de DR2 o de Lost planet, a ver....) sólo demuestra que están hechos como el culo y que no merece la pena ni ponerse a analizarlos y mucho menos jugarlos (o sea, que despotricas pero por lo visto no has jugado, que no te gusten, tiene un pase, pero para criticarlos por "cómo están programados", ¿no deberías jugarlos y conocer de primera mano a qué "problemas" hago referencia, campeón?, más que nada porque estoy hablando de momentos con 200-300 enemigos en pantalla fácilmente, y no paras de decir "juegos que muestran más en pantalla" en el peor de los ejemplos posibles).

Normalidad, dice, como si me hubiera contestado antes con normalidad a mí descojonándote vivo de los datos aportados... y diciendo que no tenía ni puta idea de lo que hablaba, que si cuellodebotellitis e historias varias...![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

En fin, al grano, sobre lo que dices aquí:

1.- Los juegos son los que hay en el mercado, no los que tú quieras definir como "juegos de verdad", te gustarán más o menos, pero lo que no puedes decir es que no hay problemas con cpus en juegos, y cuando se mencionan juegos concretos que van perfectos SI tienes suficiente cpu, decir que no son juegos. O escurrirte por la tangente y decir que son malos juegos para disculpar el tema. Se necesita cpu claro que sí.

2.- Lo siento, pero NO. CAPCOM ha sido una de las mejores casas a la hora de hacer ports desde consola y que más ha tenido en cuenta al pc, qué rápido te olvidas que fueron ellos los pioneros en el uso de DX10 cuando incluso la mayoría de juegos de PC no lo usaban (Lost Planet, Resident Evil 5), o han sido de los pocos que han usado la teselación de una forma notable y mejorando mucho la calidad, (lost planet 2). Se adelantaron años al uso de ciertas técnicas a la mayoría de títulos en PC, ni más ni menos.

Precisamente el motor MT Framework es todo un buen ejemplo de motor de juego BIEN PROGRAMADO, ya quisieran otros tener algo como este sistema, fue de los que mejor aprovecharon los multicore, con un balanceo de carga entre cpus que tardaría años en verse en otros motores, una eficiencia altísima, lo cual ha permitido que CAPCOM introdujera en varios de sus juegos cantidades masivas de enemigos, nunca vistas en PC antes (Dead Rising 2 requiere cpu porque aún usando DX9, el juego hace un uso masivo de recursos gráficos a la hora de representar cientos de modelos en un mismo frame, Lost Planet tiene escenas también masivas de muchas decenas o cientos de enemigos en pantalla, todo es fácil cuando en un juego sólo muestras un par de modelos, por detallados que sean, lo jodido es cuando haces cosas como el MT framework).

Pionero en el uso de DX10, 11, y usado como referencia y prueba gráfica durante años y años por multitud de sites, dicen que los juegos de CAPCOM han sido bien valorados en rendimiento. No me parece que sepas mucho de progamación si criticas justo a juegos como éstos, yo me dedico a programar, así que quizás por eso aprecio que con el MT framework CAPCOM atacara varios problemas que hoy en día se dedican a atacar motores modernos y que han servido a algunos desarrolladores, incluso de gpus, para verter ríos de tinta sobre optimización o incluso sacarse APIs de la manga para "solucionar el problema" de representar tantos personajes en pantalla.

Tanto es así que hay un clamor y cierto consenso sobre la bajada de calidad y el abandono de MT framework por parte de CAPCOM por usar motores como el UE3, ya que han implicado una bajada de calidad gráfica más que una mejora, como ha pasado en sus últimos títulos, junto a su abandono del portado hacia versiones de DX avanzadas y con nuevos efectos gráficos, como ha pasado con el último DmC, inferior al anterior técnicamente, Lost Planet 3, un retroceso en muchos puntos técnicos respecto a las versiones anteriores basadas en MT, y así una larga lista de juegos que han empeorado como resultado del abandono del motor gráfico de la casa por otro externo, más fácil de usar seguramente, sobre todo cuando se contratan equipos de desarrollo externos para proyectos nuevos.

MT framework usa mejor las cpus multicore que UE3, y cuando enfrentamos la última versión de MT usada contra la existente del UE3 en ese momento, en efectos gráficos no es inferior en absoluto, al contrario. Menos flexible, puede, pero no es ni menos potente ni de peor calidad gráfica.

Dicho esto, a mí lo que me importa de los juegos es la jugabilidad, y Lost Planet era muy jugable (LP2 ya perdió muchísimo, parece que LP3 vuelve a ser un poco mejor a pesar del cambio de motor y su menor calidad gráfica en PC), Dead Rising 2 es un juego extremadamente bien balanceado como tal. Pero por supuesto exigen una buena cpu, porque hacen cosas no tan fáciles que otros juegos no se atreven a hacer: Mostrar cientos de modelos en pantalla.

Sobre Borderlands, ya he dicho que hay que ponerlo a tope y activar sobre todo el tema de las sombras dinámicas del juego, y la oclusión ambiental, el dof se elimina porque sólo sirve para emborronar la imagen, puede que hayan arreglado algún problema con parches, pero sigue mostrando algunos puntos calientes de cpudependencia:

https://imageshack.com/i/idMzJ9qap

Esto con un i5 a 4 GHz, 52 fps, y se nota la bajada, en un Q6600 aún a 3,6 GHz se notaba mucho más. Todo parcheado, así que sí, existe el problema, porque lo único que necesito para replicarlo es poner la configuración correcta gráfica, e ir a las zonas que conozco donde se produce este problema. A todo esto, no es lo mismo un Q9650 a 4,2 GHz que un Q6600, aunque vaya a 3,6 GHz lo cual es poco recomendable por lo tragón que es así. O tu amigo no tiene la misma configuración gráfica activada, o simplemente le da igual que ocurran bajadas, digamos que a 40 fps puntuales. En un juego como éste es llamativo, no es un Dead Rising con cientos de enemigos precisamente, sólo es el efecto de AO combinado con sombras dinámicas el que provoca esto, si alguno tiene que tener críticas por estar mal programado, éste es Borderlands/UE3 por implementar tan mal un efecto gráfico altamente gestionado por la cpu (y un único core, añado).

En definitiva, por mucho que quieras llamarles "juegos basura" a algunos títulos porque requieren cpu, resulta que no lo son, o no tanto como pretendes. Acertaste con uno de los mejores engines de juegos para lanzar críticas, el Borderlands te demuestro que puede ir mal aún usando el popular y en teoría depurado UE3, de hecho hay muchos más juegos que usan variantes de UE con problemas de rendimiento por sobrecarga de un proceso que los que puedas encontrar con MT, que cuando sucede como es el caso de DR2, es con una grandísima razón a esgrimir (cientos de entidades y modelos a gestionar y renderizar, sólo por el tema de llamadas al API o la gestión en la propia cpu de IA y otros, ya justifica todo).

Starcraft 2 no es tampoco una mierda de juego, podrás criticarle lo que quieras, por ejemplo el uso de pocos cores, pero es un referente como juego. Tomb Raider, idem, usa bien los multicore, pero el tema del LOD lo gestiona un subsitema concreto del sistema gráfico del juego, va por tanto por un único hilo de ejecución, y en los mapas más pesados y con todo a tope el LOD (opción de PC, seguramente en consola no se llega a ver así), se nota directamente en el rendimiento del juego según la cpu.

Por otro lado, me gustaría verte con un Q9550 a 3,8 y una GTX 970.... no de tránsito, sino como equipo gamer. Sería divertido ver cómo le sacas "provecho"...

PD: Te dejo unas coletillas en cursiva a tu respuesta, porque vamos... es para enmarcar lo que dices sobre soft ajeno y de los mejores motores de juegos y ports realizados en los últimos años (sí, CAPCOM era un ejemplo de realizar BIEN un port hasta hace poco con su cambio de políticas respecto a motor de juego y port al PC, sobre todo en los casos vinculados al uso del MT que son los que dices, justamente).

Y ... qué curioso que LP y RE5 hayan sido usados masivamente durante años como benchs de reviews, para ser tan malos ports y soft como dices que son (MT) los juegos de CAPCOM. Hoy en día están más que superados, pero durante AÑOS han sido referencia gráfica, cuando apenas había juegos DX10 o DX11.

Esos ataques gratuitos contra juegos me parece fuera de lugar, más cuando son un referente gráfico de su época (y sí, también de buena programación, multihilo bien usado, etc). ¿Es necesario para defender el punto? porque de todas formas, ésta es la realidad de los juegos en el mercado, e insisto, justo estos juegos mencionados no son ejemplo de "malos ports", para eso coge un Dead Space o similar, que los disfruto igual, pero anda que no dan por culo con tonterías de un mal port hasta en temas triviales como el Vsync.

ICETOSKI escribió:sergio_mikkos escribió:ICETOSKI escribió:A ver no os asusteis con la gigabyte.Mi caja es una CM 431 y pone 31cm como mucho.

Pero el.windforce acaba en punta,y esos 31 cm es hasta la punta,y esta punta entra entre las bahias para discos duros.

Ahora mismo lo he medido y cabria hasta 31,7 exactamente,para quien le pudiera interesar

Y mi caja es una Antec Nine Hundred Two v3 y ya te digo yo que así a ojo no cabe...

PD: Se agradecería que dejarais el offtopic sí.

De las últimas 5 páginas veo 10 comentarios interesantes relacionados con el tema y el resto basura.

Te lo digo porque tengo una 290 tambien con el windforce y el fabricante pone que mide 29 pero a la hora de medirla,esos 29cm son desde el anclaje a la caja pero en su punto mas exterior,es decir donde los tornillos.Si la mido desde la chapa de metal,es decir,a partir de los tornillos a mi me dan 28cm.Asi que yo diria que si tienes 30 cm desde tornillos a bahias ha de caber.

Fijate que el windforce acaba en punta,y esa punta es mas pequeña que el ancho de las bahias,asi que tendrias esa punta un pelin metida en las bahias,pero cabria.

Lo comento por si alguien quiere la gugabyte si o si por temas de temperaturas porque es la mas fresca segun todos los benchmarks

wwwendigo escribió:Normalidad, dice, como si me hubiera contestado antes con normalidad a mí descojonándote vivo de los datos aportados... y diciendo que no tenía ni puta idea de lo que hablaba, que si cuellodebotellitis e historias varias...![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

En fin, al grano, sobre lo que dices aquí:

1.- Los juegos son los que hay en el mercado, no los que tú quieras definir como "juegos de verdad", te gustarán más o menos, pero lo que no puedes decir es que no hay problemas con cpus en juegos, y cuando se mencionan juegos concretos que van perfectos SI tienes suficiente cpu, decir que no son juegos. O escurrirte por la tangente y decir que son malos juegos para disculpar el tema. Se necesita cpu claro que sí.

2.- Lo siento, pero NO. CAPCOM ha sido una de las mejores casas a la hora de hacer ports desde consola y que más ha tenido en cuenta al pc, qué rápido te olvidas que fueron ellos los pioneros en el uso de DX10 cuando incluso la mayoría de juegos de PC no lo usaban (Lost Planet, Resident Evil 5), o han sido de los pocos que han usado la teselación de una forma notable y mejorando mucho la calidad, (lost planet 2). Se adelantaron años al uso de ciertas técnicas a la mayoría de títulos en PC, ni más ni menos.

Precisamente el motor MT Framework es todo un buen ejemplo de motor de juego BIEN PROGRAMADO, ya quisieran otros tener algo como este sistema, fue de los que mejor aprovecharon los multicore, con un balanceo de carga entre cpus que tardaría años en verse en otros motores, una eficiencia altísima, lo cual ha permitido que CAPCOM introdujera en varios de sus juegos cantidades masivas de enemigos, nunca vistas en PC antes (Dead Rising 2 requiere cpu porque aún usando DX9, el juego hace un uso masivo de recursos gráficos a la hora de representar cientos de modelos en un mismo frame, Lost Planet tiene escenas también masivas de muchas decenas o cientos de enemigos en pantalla, todo es fácil cuando en un juego sólo muestras un par de modelos, por detallados que sean, lo jodido es cuando haces cosas como el MT framework).

Pionero en el uso de DX10, 11, y usado como referencia y prueba gráfica durante años y años por multitud de sites, dicen que los juegos de CAPCOM han sido bien valorados en rendimiento. No me parece que sepas mucho de progamación si criticas justo a juegos como éstos, yo me dedico a programar, así que quizás por eso aprecio que con el MT framework CAPCOM atacara varios problemas que hoy en día se dedican a atacar motores modernos y que han servido a algunos desarrolladores, incluso de gpus, para verter ríos de tinta sobre optimización o incluso sacarse APIs de la manga para "solucionar el problema" de representar tantos personajes en pantalla.

Tanto es así que hay un clamor y cierto consenso sobre la bajada de calidad y el abandono de MT framework por parte de CAPCOM por usar motores como el UE3, ya que han implicado una bajada de calidad gráfica más que una mejora, como ha pasado en sus últimos títulos, junto a su abandono del portado hacia versiones de DX avanzadas y con nuevos efectos gráficos, como ha pasado con el último DmC, inferior al anterior técnicamente, Lost Planet 3, un retroceso en muchos puntos técnicos respecto a las versiones anteriores basadas en MT, y así una larga lista de juegos que han empeorado como resultado del abandono del motor gráfico de la casa por otro externo, más fácil de usar seguramente, sobre todo cuando se contratan equipos de desarrollo externos para proyectos nuevos.

MT framework usa mejor las cpus multicore que UE3, y cuando enfrentamos la última versión de MT usada contra la existente del UE3 en ese momento, en efectos gráficos no es inferior en absoluto, al contrario. Menos flexible, puede, pero no es ni menos potente ni de peor calidad gráfica.

Dicho esto, a mí lo que me importa de los juegos es la jugabilidad, y Lost Planet era muy jugable (LP2 ya perdió muchísimo, parece que LP3 vuelve a ser un poco mejor a pesar del cambio de motor y su menor calidad gráfica en PC), Dead Rising 2 es un juego extremadamente bien balanceado como tal. Pero por supuesto exigen una buena cpu, porque hacen cosas no tan fáciles que otros juegos no se atreven a hacer: Mostrar cientos de modelos en pantalla.

Sobre Borderlands, ya he dicho que hay que ponerlo a tope y activar sobre todo el tema de las sombras dinámicas del juego, y la oclusión ambiental, el dof se elimina porque sólo sirve para emborronar la imagen, puede que hayan arreglado algún problema con parches, pero sigue mostrando algunos puntos calientes de cpudependencia:

[IMG=http://imagizer.imageshack.us/v2/150x100q90/661/MzJ9qa.png][/IMG]

Esto con un i5 a 4 GHz, 52 fps, y se nota la bajada, en un Q6600 aún a 3,6 GHz se notaba mucho más. Todo parcheado, así que sí, existe el problema, porque lo único que necesito para replicarlo es poner la configuración correcta gráfica, e ir a las zonas que conozco donde se produce este problema. A todo esto, no es lo mismo un Q9650 a 4,2 GHz que un Q6600, aunque vaya a 3,6 GHz lo cual es poco recomendable por lo tragón que es así. O tu amigo no tiene la misma configuración gráfica activada, o simplemente le da igual que ocurran bajadas, digamos que a 40 fps puntuales. En un juego como éste es llamativo, no es un Dead Rising con cientos de enemigos precisamente, sólo es el efecto de AO combinado con sombras dinámicas el que provoca esto, si alguno tiene que tener críticas por estar mal programado, éste es Borderlands/UE3 por implementar tan mal un efecto gráfico altamente gestionado por la cpu (y un único core, añado).

En definitiva, por mucho que quieras llamarles "juegos basura" a algunos títulos porque requieren cpu, resulta que no lo son, o no tanto como pretendes. Acertaste con uno de los mejores engines de juegos para lanzar críticas, el Borderlands te demuestro que puede ir mal aún usando el popular y en teoría depurado UE3, de hecho hay muchos más juegos que usan variantes de UE con problemas de rendimiento por sobrecarga de un proceso que los que puedas encontrar con MT, que cuando sucede como es el caso de DR2, es con una grandísima razón a esgrimir (cientos de entidades y modelos a gestionar y renderizar, sólo por el tema de llamadas al API o la gestión en la propia cpu de IA y otros, ya justifica todo).

Starcraft 2 no es tampoco una mierda de juego, podrás criticarle lo que quieras, por ejemplo el uso de pocos cores, pero es un referente como juego. Tomb Raider, idem, usa bien los multicore, pero el tema del LOD lo gestiona un subsitema concreto del sistema gráfico del juego, va por tanto por un único hilo de ejecución, y en los mapas más pesados y con todo a tope el LOD (opción de PC, seguramente en consola no se llega a ver así), se nota directamente en el rendimiento del juego según la cpu.

Por otro lado, me gustaría verte con un Q9550 a 3,8 y una GTX 970.... no de tránsito, sino como equipo gamer. Sería divertido ver cómo le sacas "provecho"...

PD: Te dejo unas coletillas en cursiva a tu respuesta, porque vamos... es para enmarcar lo que dices sobre soft ajeno y de los mejores motores de juegos y ports realizados en los últimos años (sí, CAPCOM era un ejemplo de realizar BIEN un port hasta hace poco con su cambio de políticas respecto a motor de juego y port al PC, sobre todo en los casos vinculados al uso del MT que son los que dices, justamente).

Y ... qué curioso que LP y RE5 hayan sido usados masivamente durante años como benchs de reviews, para ser tan malos ports y soft como dices que son (MT) los juegos de CAPCOM. Hoy en día están más que superados, pero durante AÑOS han sido referencia gráfica, cuando apenas había juegos DX10 o DX11.

Esos ataques gratuitos contra juegos me parece fuera de lugar, más cuando son un referente gráfico de su época (y sí, también de buena programación, multihilo bien usado, etc).

Te sonará a que te intento tomar el pelo o faltarte al respeto pero te lo tengo que preguntar así: Me estás vacilando? me tomas el pelo o algo por el estilo?

Por qué te hago esa pregunta porque me parto de risa de que me intentes vender que los juegos de CAPCOM son un referente de la programación y de los ports a pc. Para empezar el port del lost planet 1 fue lamentablemente irrisorio, el del 2 ya directamente un insulto a la cara de cualquier jugón de pc y los dead rising 1, 2 y 3 una tomadura de pelo y de las grandes. Hablamos de la misma compañía? esa compañía que hasta capa mucho de sus juegos a 30fps porque directamente hacen un port 1:1 y que chute como pueda? en serio ... me tienes que estar vacilando.

Y cuando hablamos del borderlands 1 y 2 ... que te pensabas que estabamos jugando en bajo? para empezar en mi 1er y 2º equipo hasta lo jugué con PHYSX A FULL a 60fps como rocas con todo absolutamente a tope, igualmente en el Q9650 salvo que en este no se activo el physx. Que me quieres decir? que yo no he podido tener delante de mis ojos a un Q9650 moviendo el borderlands 1 y 2 a 60fps como rocas?

Y ahora hablemos todavía aun más claro:

Algún juego de CAPCOM muestra más que el BF4 en pantalla? !NO! , piden más recursos? !SI! , muestran menos en pantalla? !SI! pues si estamos hablando de software, si un juego necesita más recursos que otro para mostrar menos cosas en pantalla en mi pueblo se llama de una forma: CUTREPORT.

Si me dijeses que son juegos que muestran menos y por lo tanto piden menos pues entraríamos en la zona de lo normal y lo esperable .... pero juegos que muestran una mierda en pantalla pidiendo más recursos que el BF4? sí, juegos genialmente hechos. Vamos, vergüenza de software es como se llama eso.

Y luego, tengo 2 plataformas que me llegan a los 5ghz (a voltajes locos, sí, pero 5ghz) que suelo tener de max a 4'8 y normalmente a 4'6ghz que puedo comparar día tras día con cualquier tipo de software o de juego contra mi Phenom II x6@4'2ghz y 3200nb, y desde luego, pudiendo comparar esas dos plataformas de forma directa y hasta con la misma gráfica pues no me vas a venir aquí a decirme como van y como no.

Y ya, para terminar, decirte que flaco favor haces a los usuarios de PC si ves un juego hecho como el culo y asocias los requisitos que pide (simplemente por estar hecho como el culo) y asociar que el hardware del pc tiene que adaptarse a base de fuerza bruta a él. De hecho, de seguir tu teoría, como todavía no tenemos ningún micro que mueva a 60fps constantes o de mínimos en Crysis y Crysis Warhead (aun pidiendo este algo menos) y que sólo usan hasta 2 cores ... pues tenemos absolutamente cuello de botella todos en nuestros pcs.

Vanagloriar el software basura de PC es precisamente lo que nos está llevando a los cutreports que nos traen una y otra vez. El día que vea un juego de esos mostrar lo que muestra BF4 y que se mueva con la soltura que lo hace este y más con MANTLE ... entonces hablamos. Mientras hablemos de juegos que muestran menos en pantalla y encima no tienen a 64 jugadores dándose estopa en un mapa enorme sin popping ... estamos hablando de cutreports, simple y llanamente cutreports.

Ahora resulta que CAP-PORT es el camino a seguir por los desarrolladores. Que sera lo siguiente, nombrar a UBIPORT la compañia nº1 de software de PC? venga ya! , esperaba por lo menos una conversación seria.

josele69 escribió:Que tal las Zotac? yo con mi GTX 460 de Zotac oceada de fabrica y todavia con bastante margen (es la version amp! creo) nunca he tenido ningun problema, me ha dado un rendimiento genial y es super silenciosa. Siguen en la misma linea?

![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

josele69 escribió:Que tal las Zotac? yo con mi GTX 460 de Zotac oceada de fabrica y todavia con bastante margen (es la version amp! creo) nunca he tenido ningun problema, me ha dado un rendimiento genial y es super silenciosa. Siguen en la misma linea?

cheyen2008 escribió:Bueno, me la he jugado.

KailKatarn escribió:Te sonará a que te intento tomar el pelo o faltarte al respeto pero te lo tengo que preguntar así: Me estás vacilando? me tomas el pelo o algo por el estilo?

Por qué te hago esa pregunta porque me parto de risa de que me intentes vender que los juegos de CAPCOM son un referente de la programación y de los ports a pc. Para empezar el port del lost planet 1 fue lamentablemente irrisorio, el del 2 ya directamente un insulto a la cara de cualquier jugón de pc y los dead rising 1, 2 y 3 una tomadura de pelo y de las grandes. Hablamos de la misma compañía? esa compañía que hasta capa mucho de sus juegos a 30fps porque directamente hacen un port 1:1 y que chute como pueda? en serio ... me tienes que estar vacilando.

Y cuando hablamos del borderlands 1 y 2 ... que te pensabas que estabamos jugando en bajo? para empezar en mi 1er y 2º equipo hasta lo jugué con PHYSX A FULL a 60fps como rocas con todo absolutamente a tope, igualmente en el Q9650 salvo que en este no se activo el physx. Que me quieres decir? que yo no he podido tener delante de mis ojos a un Q9650 moviendo el borderlands 1 y 2 a 60fps como rocas?

Y ahora hablemos todavía aun más claro:

Algún juego de CAPCOM muestra más que el BF4 en pantalla? !NO! , piden más recursos? !SI! , muestran menos en pantalla? !SI! pues si estamos hablando de software, si un juego necesita más recursos que otro para mostrar menos cosas en pantalla en mi pueblo se llama de una forma: CUTREPORT.

Si me dijeses que son juegos que muestran menos y por lo tanto piden menos pues entraríamos en la zona de lo normal y lo esperable .... pero juegos que muestran una mierda en pantalla pidiendo más recursos que el BF4? sí, juegos genialmente hechos. Vamos, vergüenza de software es como se llama eso.

Y luego, tengo 2 plataformas que me llegan a los 5ghz (a voltajes locos, sí, pero 5ghz) que suelo tener de max a 4'8 y normalmente a 4'6ghz que puedo comparar día tras día con cualquier tipo de software o de juego contra mi Phenom II x6@4'2ghz y 3200nb, y desde luego, pudiendo comparar esas dos plataformas de forma directa y hasta con la misma gráfica pues no me vas a venir aquí a decirme como van y como no.

Y ya, para terminar, decirte que flaco favor haces a los usuarios de PC si ves un juego hecho como el culo y asocias los requisitos que pide (simplemente por estar hecho como el culo) y asociar que el hardware del pc tiene que adaptarse a base de fuerza bruta a él. De hecho, de seguir tu teoría, como todavía no tenemos ningún micro que mueva a 60fps constantes o de mínimos en Crysis y Crysis Warhead (aun pidiendo este algo menos) y que sólo usan hasta 2 cores ... pues tenemos absolutamente cuello de botella todos en nuestros pcs.

Vanagloriar el software basura de PC es precisamente lo que nos está llevando a los cutreports que nos traen una y otra vez. El día que vea un juego de esos mostrar lo que muestra BF4 y que se mueva con la soltura que lo hace este y más con MANTLE ... entonces hablamos. Mientras hablemos de juegos que muestran menos en pantalla y encima no tienen a 64 jugadores dándose estopa en un mapa enorme sin popping ... hablamos.

Ahora resulta que CAP-PORT es el camino a seguir por los desarrolladores. Que sera lo siguiente, nombrar a UBIPORT la compañia nº1 de software de PC? venga ya! , esperaba por lo menos una conversación seria.

Lo que me he reido con tu contestación, mira, no es por faltar, pero me ha quedado claro que no tienes ni idea de programación (lo cual de por sí no es delito, no pasa nada, pero sí que hables sobre programación de soft y su calidad "mala" sin saber del tema) ni analizar siquiera lo que ves en pantalla en cuanto a trabajo de cpu, que me digas que un juego como BF4 muestra mucho más por pantalla que los "cutreports" de CAPCOM mencionados, cuando estamos hablando del trabajo de la cpu.... cuántas veces te lo he dicho, el PROBLEMA no es lo que se muestra en gráficos chirifláuticos de la muerte con efectos X, sino ... el número de objetos, entidades, cuyo estado hay que actualizar en el motor del juego, en IA, físicas, etc, y no un juego donde hay una decena o dos decenas de entidades "vivas" en juego, o ni eso si es en red, más eso sí, un mapeado muy bonito pero que es más una cuestión puramente gráfica que otra cosa. Sí, el subsistema gráfico en la parte de la cpu tiene que estar muy refinado y bien balanceado, pero poco más, la física medianamente desarrollada, pero no tanto como cuando hay que simular muchos más objetos por simples que sean, además todos sabemos que los BF desde BF:BC2 han ido atrás en simulación física, se ha pasado de unos entornos destruibles bastante completos a unos con un par de elementos destruibles predefinidios y altamente scriptados, un auténtico paso atrás justo en esto.

Otra cosa que me mata es que vuelvas una y otra vez con BF4 para intentar atacar a juegos que tienen.... algunos 6-7 años de antiguëdad, ¿en serio, pretendes una discusión seria y lo primero que haces es descontextualizar todo y sacar a los juegos de su contexto histórico para atacarlos comparándolos con BF4? La razón de que fueran mencionados es tan simple como que eran juegos que ya hace 3-4 años yo notaba, con toooodoo configurado a tope y sobre todo en momentos de clara gestión de multitudes de objetos por la cpu (física, IA y setup 3D a enviar a la pipe gráfica de DX), que vengas hablando de ports de CAPCOM, los cuales ya he dicho que han bajado el nivel en los últimos años, y a la vez ignores... lo que ya te he dicho.

Que estos ports "de mierda" fueron los pioneros de uso de DX10 (Lost planet y RE5), o de DX11 y sobre todo, DX11 con teselación como dios manda (Lost Planet 2). Esa parte la has esquivado muy rápidamente y has vuelto a la carga diciendo que son una mierda de juegos mal portados, e historias varias con ese gran ejemplo de programación que es BF4 (juego más parcheado y con más problemas no he visto, incluido incluso la versión de mantle que tanto te gusta, ésa que rinde MENOS que la versión DX en gráficas modernas como la R9 285, que tiene bemoles, ah, ya ha dicho AMD que es culpa del juego, no de ellos, precisamente has escogido un juego de cojones para hablar de "parcheado" y buena optimización, sí señor, y ojo, yo no le niego el mérito a BF4, pero si tu vara de medir la calidad del soft es ésta... vamos).

Es curioso, esquivas una y otra vez los hechos mencionados, datos:

http://en.wikipedia.org/wiki/List_of_games_with_DirectX_10_support

Vaya, el quinto con soporte DX10, lost planet. Para ser un mierdaport resulta que era uno de los más avanzados juegos para PC cuando salió. De hecho el único anterior que usa DX10 de forma meritoria sería el Call of Juarez, pero con la trampa de que realmente salió este soporte con un parche a posteriori del lanzamiento. A saber si ésa es la fecha del parche o lanzamiento del juego. O sea que igual ni eso y es sino el primero, casi, en usar DX10.

Después vendrían otros como DmC y RE5, que tú "no te tomas en serio", pero resulta que fueron punteros en usar APIs en windows y multicores, y en la época en que había motores así de MALOS como Gamebryo como representantes de uso de multihilo (muy limitado comparado con el uso de MT de multihilo), con juegos como Oblivion, que eran incapaces de escalar en cpus quad core, dado que ya no exprimían demasiado siquiera a dual cores, en esa época, resulta que juegos como Lost Planet mostraron cómo usar multihilo bien en cpus con más de 2 cores. Pero nada, son malos ports y ya está.

Ni siquiera estoy defendiendo si son buenos o malos juegos, LP2 perdió por algún lado la jugabilidad del anterior LP, pero nadie puede negar que fue de los primeros en soportar DX11, y sobre todo, con teselación como manda, no con chorradas como "charcos que ondulan" como se hizo con Dirt 2 y otros:

http://en.wikipedia.org/wiki/List_of_games_with_DirectX_11_support

Una lista donde aparece entre los primeros, más si se lee las notas y se ve que la mayoría de juegos "anteriores" con soporte DX11 lo recibieron a posteriori de la salida de LP2 via parches. Esto es, es literalmente uno de los primeros, y el primero en un uso masivo de teselación que además mejoraba la calidad gráfica de forma real, no como hoy en día seguimos sin ver en la mayoría de casos.

Por cierto, nunca dije que los LP dieran problemas de rendimiento, lo digo porque me parece que asumes que todos estos juegos hay que criticarlos porque los menciono como juegos donde se ve la mejora en cpus potentes, pero en estos casos los menciono porque cuando usan masivas cantidades de ENEMIGOS sí se nota la cpu. Nunca dije que no fuera suficiente el rendimiento, ni siquiera en LP en la escena de la cueva, sino que se notaba la mejora y más en bench al usar cpus superiores. Y se notaba mucho además al pasar de dual cores a un quad core, sin duda una muestra de la baja calidad del soft que son, claro, que no saben usar multihilo ni nada..