virtus escribió:@LynX que modelo te has comprado?

LynX escribió:virtus escribió:@LynX que modelo te has comprado?

https://www.pccomponentes.com/asus-dual-geforce-rtx-4070-oc-edition-12gb-gddr6x-dlss3

GF3 escribió:El triste mundo de las gráficas, y la estafa que nos hemos tragado todos, que hasta una 4090, una gráfica de 2.000 euros sufra para mover un dlc de un juego, no es triste, es que da pena.

Rendimiento de Cyberpunk 2077: Phantom Liberty a prueba con 25 tarjetas gráficas

Luego vendrán las pruebas con fake frame y dlss 3.5, y parecerá que todo esta muy chulo, y que el juego va a 300 fps, pero la realidad es que a rendimiento puro son basura las gráficas.

Un saludo

GF3 escribió:El triste mundo de las gráficas, y la estafa que nos hemos tragado todos, que hasta una 4090, una gráfica de 2.000 euros sufra para mover un dlc de un juego, no es triste, es que da pena.

Rendimiento de Cyberpunk 2077: Phantom Liberty a prueba con 25 tarjetas gráficas

Luego vendrán las pruebas con fake frame y dlss 3.5, y parecerá que todo esta muy chulo, y que el juego va a 300 fps, pero la realidad es que a rendimiento puro son basura las gráficas.

Un saludo

GF3 escribió:El triste mundo de las gráficas, y la estafa que nos hemos tragado todos, que hasta una 4090, una gráfica de 2.000 euros sufra para mover un dlc de un juego, no es triste, es que da pena.

Rendimiento de Cyberpunk 2077: Phantom Liberty a prueba con 25 tarjetas gráficas

Luego vendrán las pruebas con fake frame y dlss 3.5, y parecerá que todo esta muy chulo, y que el juego va a 300 fps, pero la realidad es que a rendimiento puro son basura las gráficas.

Un saludo

LynX escribió:Pues a mí me ha sorprendido gratamente el uso del DLSS más el FG en mi 4070 en el Cyberpunk, creía que se vería peor. Solo en el phomode puedo ver durante unos 2 segundos como unos reflejos raros en la piel de mi personaje que desaparecen en 2 segundos o así (aunque me sale una opción que no me deja activar para activar rt en photomode). En movimiento con el DLSS en calidad y el FG activados no noto ninguna diferencia respecto a si no los uso (bueno solo los fps que se van al cuerno). Aunque solo lo estuve probando ayer y he de probarlo más.

En lo que estoy de acuerdo es que las gráficas actuales son un timo, pero si quieres jugar a los juegos actuales es lo que hay.

jeslet escribió:dos dudas, no entiendo del tema, pero me he puesto con el undervolt para mi 4070 y en las prueba de rendimiento del Cyberpunk antes de hacerlo me daba 70fps y después 81fps. Esto es posible? lo pregunto desde el mas absoluto desconocimiento. Algunos comentarios que he podido leer son del estilo, que si no es fiable, que si no vale la pena en una 4070, que si no hay riesgo, que si es recomendable hacerlo, que la grafica no sufre, etc,etc, con lo que no se si lo he hecho bien o lo he hecho mal o a saber, me estoy rallando por si a la grafica le va a pasar algo.

...y en el panel de Nvidia hay que hacer algo? tocar algo, activar cosas para sacar mas rendimiento? También he visto videos de peña que activan mil cosas para ganar no se cuantos fps sin perder calidad, o para que todo funcione mejor y tengo la cabeza que me va a explotar.

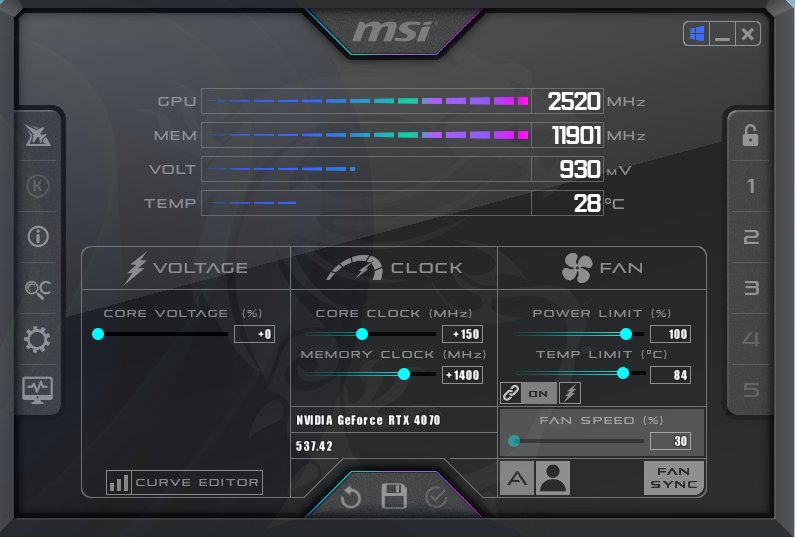

garbaje_de_potanzos escribió:@jeslet Con la prueba de un juego sólo no te quedes, y mas con Cyberpunk que tiene tendencia a cambiarte el nivel de DLSS por la jeta sin que te des cuenta, así que lo mas seguro esque haya sido eso. Si al hacer undervolt no has subido muy mucho los relojes de fábrica (cosa que dudo mucho) no debería varíar los fps, de hecho normalmente se pierde un poco de rendimiento si quieres reducir mucho el consumo y temperaturas. Yo por ejemplo mi 4070 la he dejado en 915mv y bajado el core clock a 2600mhz y consume apenas 120Watts de media y pierde algo menos de un 10% de rendimiento, y la cabrona apenas supera los 53ºC a tope xD

Aunque para juegos exigentes supongo que buscaré un undervolt que mantenga relojes de fábrica y reducir los milivoltios hasta que sea estable.

Merece la pena?? Pues no se, yo siempre pienso que dejarla lo mas fresquita y eficiente posible afecta positivamente a su longevidad, y si tienes problemas de temperatura o potencia es un must hacerlo.

En mi caso las ganancias de rendimiento por aumentar Mhz son mínimas, ya he probado el límite de mi 4070 que es subir el core a 3.100Mhz y las memorias a 11.500Mhz (esto es casi +300Mhz y +1.000Mhz respectivamente) y apenas se traduce en un 5% mas de rendimiento en juegos, así que paso de rallarme en rascar algo mas de reloj a la hora de bajar milivolts, que como al final eres tú el que asigna ambos valores manualmente usando ese método pues por eso dije de mantener los relojes de serie y bajar todo lo posible el consumo xD

En mi caso las ganancias de rendimiento por aumentar Mhz son mínimas, ya he probado el límite de mi 4070 que es subir el core a 3.100Mhz y las memorias a 11.500Mhz (esto es casi +300Mhz y +1.000Mhz respectivamente) y apenas se traduce en un 5% mas de rendimiento en juegos, así que paso de rallarme en rascar algo mas de reloj a la hora de bajar milivolts, que como al final eres tú el que asigna ambos valores manualmente usando ese método pues por eso dije de mantener los relojes de serie y bajar todo lo posible el consumo xDgarbaje_de_potanzos escribió:@hh1 Yo esque desde que aprendí a usar el Core Voltaje Curve Editor del Afterburner no uso otra cosa para UV/OCEn mi caso las ganancias de rendimiento por aumentar Mhz son mínimas, ya he probado el límite de mi 4070 que es subir el core a 3.100Mhz y las memorias a 11.500Mhz (esto es casi +300Mhz y +1.000Mhz respectivamente) y apenas se traduce en un 5% mas de rendimiento en juegos, así que paso de rallarme en rascar algo mas de reloj a la hora de bajar milivolts, que como al final eres tú el que asigna ambos valores manualmente usando ese método pues por eso dije de mantener los relojes de serie y bajar todo lo posible el consumo xD

Por eso también me extraña mucho que a @jeslet le haya aumentado el rendimiento en el bench del CP 2077 casi un 20% sólo por hacer UV, básicamente es imposible a no ser que su gráfica estuviera haciendo un thermal throttling bestial de serie, cosa que tampoco me creo. Seguro que se le cambió el nivel de DLSS por si sólo sin darse cuenta, que a mi me lo ha hecho alguna vez.

garbaje_de_potanzos escribió:@hh1 Yo esque desde que aprendí a usar el Core Voltaje Curve Editor del Afterburner no uso otra cosa para UV/OCEn mi caso las ganancias de rendimiento por aumentar Mhz son mínimas, ya he probado el límite de mi 4070 que es subir el core a 3.100Mhz y las memorias a 11.500Mhz (esto es casi +300Mhz y +1.000Mhz respectivamente) y apenas se traduce en un 5% mas de rendimiento en juegos, así que paso de rallarme en rascar algo mas de reloj a la hora de bajar milivolts, que como al final eres tú el que asigna ambos valores manualmente usando ese método pues por eso dije de mantener los relojes de serie y bajar todo lo posible el consumo xD

Por eso también me extraña mucho que a @jeslet le haya aumentado el rendimiento en el bench del CP 2077 casi un 20% sólo por hacer UV, básicamente es imposible a no ser que su gráfica estuviera haciendo un thermal throttling bestial de serie, cosa que tampoco me creo. Seguro que se le cambió el nivel de DLSS por si sólo sin darse cuenta, que a mi me lo ha hecho alguna vez.

ditifet escribió:garbaje_de_potanzos escribió:@hh1 Yo esque desde que aprendí a usar el Core Voltaje Curve Editor del Afterburner no uso otra cosa para UV/OCEn mi caso las ganancias de rendimiento por aumentar Mhz son mínimas, ya he probado el límite de mi 4070 que es subir el core a 3.100Mhz y las memorias a 11.500Mhz (esto es casi +300Mhz y +1.000Mhz respectivamente) y apenas se traduce en un 5% mas de rendimiento en juegos, así que paso de rallarme en rascar algo mas de reloj a la hora de bajar milivolts, que como al final eres tú el que asigna ambos valores manualmente usando ese método pues por eso dije de mantener los relojes de serie y bajar todo lo posible el consumo xD

Por eso también me extraña mucho que a @jeslet le haya aumentado el rendimiento en el bench del CP 2077 casi un 20% sólo por hacer UV, básicamente es imposible a no ser que su gráfica estuviera haciendo un thermal throttling bestial de serie, cosa que tampoco me creo. Seguro que se le cambió el nivel de DLSS por si sólo sin darse cuenta, que a mi me lo ha hecho alguna vez.

Es que lo recomendable no es subir todo lo que se pueda la frecuencia o bajar todo lo que se pueda el voltaje con la frecuencia de serie sino un equilibrio entre los dos valores

Un ejemplo seria:

Stock 1770 mhz @ 1.050v

OC + UV 1915 mhz @ 0.950 = un 10% de rendimiento extra

Que puedes subir a 1950 mhz la frecuencia con el voltaje de serie (1.050v) claro pero lo que dice @hh1 no va a mantenerlo todo el tiempo a los 1950 mhz, va a bajar a menos de 1900 mhz cuando la gráfica esté caliente y estresada, dando menos rendimiento

Tampoco sirve dejar la frecuencia de stock de 1770 mhz para meterle 0.850v, va a rendir igual que de stock o solo un pelín mas

Tienes que buscar la máxima frecuencia que puedas mantenerla todo el tiempo sin que baje y por ello se buscar el menor voltaje posible. Al ser este mas bajo que de stock puedes subir la frecuencia por encima.

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

_anVic_ escribió:ditifet escribió:garbaje_de_potanzos escribió:@hh1 Yo esque desde que aprendí a usar el Core Voltaje Curve Editor del Afterburner no uso otra cosa para UV/OCEn mi caso las ganancias de rendimiento por aumentar Mhz son mínimas, ya he probado el límite de mi 4070 que es subir el core a 3.100Mhz y las memorias a 11.500Mhz (esto es casi +300Mhz y +1.000Mhz respectivamente) y apenas se traduce en un 5% mas de rendimiento en juegos, así que paso de rallarme en rascar algo mas de reloj a la hora de bajar milivolts, que como al final eres tú el que asigna ambos valores manualmente usando ese método pues por eso dije de mantener los relojes de serie y bajar todo lo posible el consumo xD

Por eso también me extraña mucho que a @jeslet le haya aumentado el rendimiento en el bench del CP 2077 casi un 20% sólo por hacer UV, básicamente es imposible a no ser que su gráfica estuviera haciendo un thermal throttling bestial de serie, cosa que tampoco me creo. Seguro que se le cambió el nivel de DLSS por si sólo sin darse cuenta, que a mi me lo ha hecho alguna vez.

Es que lo recomendable no es subir todo lo que se pueda la frecuencia o bajar todo lo que se pueda el voltaje con la frecuencia de serie sino un equilibrio entre los dos valores

Un ejemplo seria:

Stock 1770 mhz @ 1.050v

OC + UV 1915 mhz @ 0.950 = un 10% de rendimiento extra

Que puedes subir a 1950 mhz la frecuencia con el voltaje de serie (1.050v) claro pero lo que dice @hh1 no va a mantenerlo todo el tiempo a los 1950 mhz, va a bajar a menos de 1900 mhz cuando la gráfica esté caliente y estresada, dando menos rendimiento

Tampoco sirve dejar la frecuencia de stock de 1770 mhz para meterle 0.850v, va a rendir igual que de stock o solo un pelín mas

Tienes que buscar la máxima frecuencia que puedas mantenerla todo el tiempo sin que baje y por ello se buscar el menor voltaje posible. Al ser este mas bajo que de stock puedes subir la frecuencia por encima.

Esas frecuencias y voltajes son de Turing o Ampere, en esas dos arquitecturas sí tenia más sentido hacer undervolt.

Pero en las 4000 excepto la 4090 ( porque tiene más headroom de serie ) no le veo demasiado sentido a hacer UV de la 4080 para abajo, que son muy eficientes incluso de fábrica y los consumos son muy moderados tirando a bajos.

En la 4090 tengo varios perfiles, el más eficiente con UV consigo entre un 40 y un 45% más de eficiencia perdiendo un 5% de rendimiento vs de serie, usando voltajes muy bajos.

Con el voltaje que trae de fábrica puedo ponerla cerca de 3100mhz y meterle otros 3 ghz en las memos vs 2800mhz core 10500mhz memos que trae de stock. Con lo que los consumos son más o menos igual ( ya que mantengo el voltaje de serie ) pero se gana bastante rendimiento porque subo casi 300mhz en el core y 3ghz en memos.

Lo de mantener las temps controladas en las 4000 ( en general la mayoría de ensambles ) es bastante sencillo para evitar el throttling y evitar bajada de clocks. En el caso de mi 4090 raras veces la veo más alla de 50 grados incluso con overcock la puedo mantener bien a raya sin que me bajen los clocks ni 15 mhz .

garbaje_de_potanzos escribió:@_anVic_ Joder +3Ghz de OC a la GDDR6X?? Yo pensaba no probar mas de +1Ghz que era lo que mas o menos me admitía la memoria GDDR6 de la 2060Super que tenía. Que bestia xD

Y bueno si consigo que la gráfica me vaya a velocidad de stock consumiendo 50 o 70Watts menos siempre será mejor, si que son eficientes pero pueden serlo mas aún, yo lo veo un WIN/WIN

EDIT.- Pues el Afterburner "sólo" me deja subir 2Ghz las memorias, he estado probando un rato y es estable jajajaja no me lo esperaba. Pero aun así sólo gano un 3% de rendimiento así que al menos en mi caso lo veo un poco tontería la verdad

GF3 escribió:@ditifet

Tengo una 4070Ti que a sobredimensionada no le gana nadie, tuve que hacer bricolaje a la caja para meterla.

La mayoría de juegos no me funcionan a más de 53º, y en verano con 35º en la habitación lo máximo que ha tenido son 70º.

No me hace falta hacer UV para nada, y no creo que a la mayoría de la gente le haga falta, puede que en series anteriores si, pero en la 4XXX es raro que se necesite.

Un saludo

KKnot escribió:¿Hay algún cable mas recomendable de unos 4 metros actualmente que no se vaya de precio? Es para usar con 4K@120hz, HDR y Atmos... que al final todo suma, porque poniendo el equipo a 2K no me pasa.

garbaje_de_potanzos escribió:Pero que yo me hago varios perfiles, uno "low profile" donde palmo ~10% rendimiento pero la gráfica consume la mitad (100Watts) ideal para juegos con poca chicha gráfica, un perfil con los relojes de stock pero minimizando el consumo al máximo (consumiendo ~145Watts y mismo rendimiento que de serie), y otro perfil con OC para juegos mas exigentes intentando también que consuma algo menos que de fábrica.

Además que la 4070 la uso en un monitor 1080p y ahí va muy sobrada, osea no entiendo bien que me queréis decir. Ajustar un único perfil para todo?? Nunca lo hice así, prefiero mi método xD

BennBeckman escribió:Qué modelo de 4090 recomendáis actualmente? Hay un montón y no me decido...

anavas44 escribió:BennBeckman escribió:Qué modelo de 4090 recomendáis actualmente? Hay un montón y no me decido...

Generalmente la más barata, porque todas rinden parecido (diferencias del 2-3% máximo a lo sumo).

BennBeckman escribió:anavas44 escribió:BennBeckman escribió:Qué modelo de 4090 recomendáis actualmente? Hay un montón y no me decido...

Generalmente la más barata, porque todas rinden parecido (diferencias del 2-3% máximo a lo sumo).

Pero entiendo que en cuanto a materiales unas diferirán de otras. ¿No?

No me gustaría gastarme 1500€ en un cacharro de plástico chino...

anavas44 escribió:BennBeckman escribió:anavas44 escribió:

Generalmente la más barata, porque todas rinden parecido (diferencias del 2-3% máximo a lo sumo).

Pero entiendo que en cuanto a materiales unas diferirán de otras. ¿No?

No me gustaría gastarme 1500€ en un cacharro de plástico chino...

Todas las marcas son ensambladoras oficiales aprobadas por nvidia, no vas a tener cacharros de plástico chino (bueno, realmente todas son plástico chino, pero de buena calidad).

Dicho esto, mi experiencia ha sido:

- Zotac 4090 AMP Airo - a los 6 meses se me jodió y esta marca tarda MESES en tramitar los RMA

- Asus ROG Strix 4090 - mi actual 4090, preciosa, materiales de calidad, y probablemente la 4090 que más sube por aire, pero claro, tiene un precio que a mi parecer no compensa a no ser que la consigas de oferta

KKnot escribió:Un tema, que lo mas seguro es que sea cosa del cable. Tengo una TV Oled 4K y una 4090, y un cable HDMI de 6 metros hdmi 2.1 feizlink de fibra, pero me pasa muchas veces que al cambiar de resolución, se me va la imagen, y tarda mucho en volver, tanto que lo mejor muchas veces es apagar la tv y encender (que no siempre funciona).

¿Hay algún cable mas recomendable de unos 4 metros actualmente que no se vaya de precio? Es para usar con 4K@120hz, HDR y Atmos... que al final todo suma, porque poniendo el equipo a 2K no me pasa.

BennBeckman escribió:Qué modelo de 4090 recomendáis actualmente? Hay un montón y no me decido...

_anVic_ escribió:anavas44 escribió:BennBeckman escribió:Pero entiendo que en cuanto a materiales unas diferirán de otras. ¿No?

No me gustaría gastarme 1500€ en un cacharro de plástico chino...

Todas las marcas son ensambladoras oficiales aprobadas por nvidia, no vas a tener cacharros de plástico chino (bueno, realmente todas son plástico chino, pero de buena calidad).

Dicho esto, mi experiencia ha sido:

- Zotac 4090 AMP Airo - a los 6 meses se me jodió y esta marca tarda MESES en tramitar los RMA

- Asus ROG Strix 4090 - mi actual 4090, preciosa, materiales de calidad, y probablemente la 4090 que más sube por aire, pero claro, tiene un precio que a mi parecer no compensa a no ser que la consigas de oferta

Que clocks te hace de serie y con overclock esa 4090 Strix?

Te lo digo más que nada porque al final es cuestión de suerte... tuve una 4090 Palit ( un modelo muy básico, con un vrm bastante precario ) me costó 1600€ y me hacia 3150mhz en el core y cerca de los 12400mhz en memos sin despeinarse.

ditifet escribió:KKnot escribió:Un tema, que lo mas seguro es que sea cosa del cable. Tengo una TV Oled 4K y una 4090, y un cable HDMI de 6 metros hdmi 2.1 feizlink de fibra, pero me pasa muchas veces que al cambiar de resolución, se me va la imagen, y tarda mucho en volver, tanto que lo mejor muchas veces es apagar la tv y encender (que no siempre funciona).

¿Hay algún cable mas recomendable de unos 4 metros actualmente que no se vaya de precio? Es para usar con 4K@120hz, HDR y Atmos... que al final todo suma, porque poniendo el equipo a 2K no me pasa.

Yo tengo este y me va perfecto

NEWDERY Cable HDMI 2.1 8K 5 Metro, Cable HDMI 5M Macho a Macho 8K@60Hz, 4K@120Hz / 144Hz DSC, Soporte eARC, HDR10+, VRR, Dolby Vision, HDCP 2.2/2.3, Compatible con PS5 / Xbox One X/Fire TV (Negro) https://amzn.eu/d/gXBA9oo

4k a 120 Hz y HDR sin problema con una Bravia con HDMI 2.1 obviamente y una 3090

Lo tengo desde hace 1 año y medio

SonMf escribió:¿ Esperaríais al nuevo conector de la 4090 tanto en la tarjeta gráfica como en la fuente de alimentación?

SonMf escribió:¿ Esperaríais al nuevo conector de la 4090 tanto en la tarjeta gráfica como en la fuente de alimentación?

_anVic_ escribió:Acabo de testar el FSR 3 en el Forespoken. También ha salido para el Immortals of Aveum.

No va nada mal. Me han sorprendido muy gratamente las latencias.

Funciona de lujo con la 4090 forzando V-sync desde el panel de control de nvidia. Igual que hago con FG. El que se anime que lo pruebe y que nos cuente que tal su experiencia.

uchi23a escribió:Con intención de pasar por agua (alphacool waterblock)

¿Que gpu seria mejor? (4080)

Estoy entre: Tuf (asus) | Amp Airo (Zotac) | y Msi sin ningún modelo exacto aun claro elegido...

En un principio iba a elegir Asus... pero la serie 4000 en asus salieron malas... ya que son las mas le llega a Osmanys Martinez (un youtuber que repara gpus a nivel profesional....

ditifet escribió:

Las Asus que comenta Osmanys se refiere en general, no solo en las 4000

richichan escribió:Estoy pensando en agenciarme una 4070ti, teniendo un Ryzen 3700x tendría mucho cuello de botella?

No me queda muy claro

Gracias!