Asran escribió:Tengo una Rx 6800 también de referencia.... una grafica que vale 599€ y la verdad que le da mil patadas en el culo a la de Nvidia en construcción, en algunos juegos pierdo 10/20 0 30 fps y en otros saca mas que la de Nvidia según quien esponsorice el juego y consumiendo 100W menos, pero a la hora de las temperaturas no hay puto color, 4 Gb mas

de Vram y si pasan de 75º es un milagro. Muy mal por Nvidia con sus 3080,3080ti y 3090... tener que ver Streamers a los que se les queman las memorias en directo jugando al diablo II remaster..... penoso.

Asran escribió:@Dracot

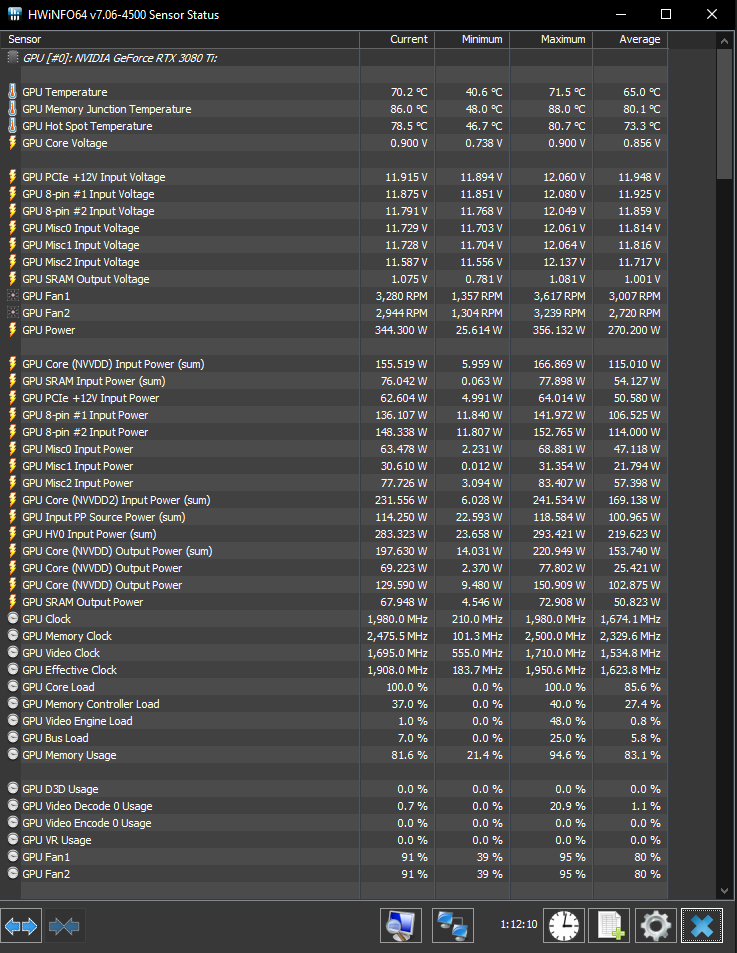

Yo tengo una 3080ti y afirmo lo que hice el amigo, consumen 100W mas que su homologo en amd, 8nm de samsung (nvidia) vs 7nm de TSMC(amd) en la seria 4000 nvidia va a volver a comprar los chips a TSMC y las memorias se calientas mucho mas entorno a 30 grados mas. Lo unico mejor que tienen estas 3000 con respecto a la competencia es el RTX, antes tenian el Dlss pero ahora amd saco su propia tecnologia que si veis videos es igual de buena y ademas es una teclnologia libre y no propietaria como la de nvidia, lo vas a poder usar tanto en amd como en nvidia hasta con intel... ah y se me olvida 6gb de vram mas que la 3080 y 4 gb mas que mi 3080 ti. Las cosas hay que decirlas como son yo tengo una 6800 y una 3080ti se de lo que hablo, probad las cosas he informaros antes de echar la lengua a pacer.

He pedido otros thermal Pads y lo volvere a intentar este viernes me llegaran y la vuelvo a abrir.

Dfx escribió:Bueno, en lo único que puedo dar la razón es que la GDDR6X igual no ha sido tan buena elección, habiendo caminos de buses más grandes o el acercamiento de AMD con Infinity Cache. Pero también es verdad que el problema con la VRAM lo venimos arrastrando desde hace varias generaciones, los fabricantes se preocupan de refrigerar la GPU pero poco de la VRAM, reutilizan diseños de disipador si es posible y repiten errores.

La GDDR6X requiere de especial atención en el disipador y de thermalpads de calidad, cosa que cojean casi todos los ensambladores. Yo también pienso que el acercamiento de Infinity Cache era más inteligente, pero también hay que decir que 128MB es insuficiente y ya se ve venir en rumores de RDNA 3 que subirá bastante.

PepeC12 escribió:Yo estoy deacuerdo, creo que la 6800xt es mejor gráfica.

Compite con la 3080, se calienta menos, tiene una construcción mejor y mucha más vram (veremos en los próximos años si importa esa vram o no).

Luego es verdad que en rt está al nivel de la 3070 y no hay dlss, auque el fsr es sorprendentemente bueno.

En cualquier caso lo que es una vergüenza es la gama baja, hardware unboxed lo decía ir twitter, tenemos el mismo precio/rendimiento en la gama baja que cuando salió la 580 (vale un 47% menos que la 6600xt y rinde el mismo porcentaje menos).

Nvidia tampoco se libra con la gama baja.

DarkMessiah escribió:the_aeon escribió:Jorginhone escribió:@the_aeon

Curioso tio,me molesto en mirar hasta un video para ayudarte a ti expresamente y ni respondes?,suerte en tu arreglo man.

@Vli

No sabia que un tornillo pueda valer de masa,tambien esta el caso contrario de esta gente que se dedica a electronica y tiene bandejas que estan dividas en diferentes compartimentos para separar todo el despiece y que no se pierda nada xD,el caso totalmente opuesto.

Perdona, ya he visto el vídeo yo también, ya he visto que va así, he pedido otros pads que me llegan mañana.

Gracias por el interés, se agradece

Qué tal fue?

JaviGabber escribió:Dfx escribió:Bueno, en lo único que puedo dar la razón es que la GDDR6X igual no ha sido tan buena elección, habiendo caminos de buses más grandes o el acercamiento de AMD con Infinity Cache. Pero también es verdad que el problema con la VRAM lo venimos arrastrando desde hace varias generaciones, los fabricantes se preocupan de refrigerar la GPU pero poco de la VRAM, reutilizan diseños de disipador si es posible y repiten errores.

La GDDR6X requiere de especial atención en el disipador y de thermalpads de calidad, cosa que cojean casi todos los ensambladores. Yo también pienso que el acercamiento de Infinity Cache era más inteligente, pero también hay que decir que 128MB es insuficiente y ya se ve venir en rumores de RDNA 3 que subirá bastante.

Se agradece leer a usuarios como tú, subes el nivel del hilo, nivel que algunos tiran por tierra.

Espero que la gente sepa diferenciar a los trolls y flames para no desinformarse.

the_aeon escribió:DarkMessiah escribió:the_aeon escribió:Perdona, ya he visto el vídeo yo también, ya he visto que va así, he pedido otros pads que me llegan mañana.

Gracias por el interés, se agradece

Qué tal fue?

Ya se lo que paso, la segunda vez que abrí la grafica chafe un poco los pads para que hicieran mejor contacto, fue un gran error, hizo que no tocaran el disipador.

Hoy he puesto los mismos pero de 2 mm y lógicamente el núcleo no toca con el disipador y calienta a tope, pero la solución ha sido chafarlos un poco y perfecto, solucionado!

Ahora la vram ha bajado mas que con los 1.5mm, van mejor los 2mm un poco chafados que los de 1.5mm, ahora la vram habrá bajado unos 10-12 grados jugando.

Igualmente yo para la 3080 FE compraría los Gelid de 2 mm, pero ahora mismo no hay stock, parece que dan mejores resultados, pero ahora mismo ya estoy contento y me he quitado el susto de encima.

Rvilla87 escribió:Asran escribió:Tengo una Rx 6800 también de referencia.... una grafica que vale 599€ y la verdad que le da mil patadas en el culo a la de Nvidia en construcción, en algunos juegos pierdo 10/20 0 30 fps y en otros saca mas que la de Nvidia según quien esponsorice el juego y consumiendo 100W menos, pero a la hora de las temperaturas no hay puto color, 4 Gb mas

de Vram y si pasan de 75º es un milagro. Muy mal por Nvidia con sus 3080,3080ti y 3090... tener que ver Streamers a los que se les queman las memorias en directo jugando al diablo II remaster..... penoso.

Estás siendo bastante partidista con AMD. ¿Qué tal el DLSS y el Ray Tracing en tu AMD? Si comparas 2 cosas cuenta lo bueno y lo malo y no te quedes solo con lo bueno.

Por otra parte, lo del video de diablo, ¿puedes poner 2 ejemplos (hablas en plural)? Me extraña mucho que se carguen las gráficas jugando a tremendo "portento" gráfico... vamos es que si se les rompe con ese juego lo mínimo a pensar es que es un defecto de esas gráficas en concreto (la de esos usuarios, no me refiero al modelo) y eso pasa con gráficas nvidia, amd y con todo tipo de dispositivos. ¿O estás insinuando que las 3080+ no pueden con Diablo 2 remaster porque se queman?

Asran escribió:Rvilla87 escribió:Asran escribió:Tengo una Rx 6800 también de referencia.... una grafica que vale 599€ y la verdad que le da mil patadas en el culo a la de Nvidia en construcción, en algunos juegos pierdo 10/20 0 30 fps y en otros saca mas que la de Nvidia según quien esponsorice el juego y consumiendo 100W menos, pero a la hora de las temperaturas no hay puto color, 4 Gb mas

de Vram y si pasan de 75º es un milagro. Muy mal por Nvidia con sus 3080,3080ti y 3090... tener que ver Streamers a los que se les queman las memorias en directo jugando al diablo II remaster..... penoso.

Estás siendo bastante partidista con AMD. ¿Qué tal el DLSS y el Ray Tracing en tu AMD? Si comparas 2 cosas cuenta lo bueno y lo malo y no te quedes solo con lo bueno.

Por otra parte, lo del video de diablo, ¿puedes poner 2 ejemplos (hablas en plural)? Me extraña mucho que se carguen las gráficas jugando a tremendo "portento" gráfico... vamos es que si se les rompe con ese juego lo mínimo a pensar es que es un defecto de esas gráficas en concreto (la de esos usuarios, no me refiero al modelo) y eso pasa con gráficas nvidia, amd y con todo tipo de dispositivos. ¿O estás insinuando que las 3080+ no pueden con Diablo 2 remaster porque se queman?

Otro que habla sin saber... has probado a jugar al diablo 2 y ponerlo en alto? yo si y a veces no me da los 144 fps, es un juego con el que se calienta un infierno la grafica porque aunque te parezca que no "porque sus graficos se ven feos" ese juego es exigente y sino te animo a que vayas y lo instales y compruebes con un programa de monitoreo si es verdad o no lo que te estoy diciendo.

El Dlss en las de Amd va muy bien se llama Fsr lo estan empezando a implementar en los juegos y da el mismo rendimiento que el dlss pero tambien te digo una cosa comprarme una grafica de 720€ o 1200 como en el caso de mi 3080ti para sacar pecho de una tecnologica de reescalado es para hacernoslo mirar, por ese dinero no tendria que hacer falta ninguna tecnologia que tenga que reconstruir una resolucion mas baja para darme fps extra, nos la meten por el culo con una tecnologia que no tendria que existir por el dinero que estamos gastanto y aun encima les aplaudimos. Por ese dinero tendrian que irnos los juegos todos como la seda. Ahi te va un video, si esque......... hablar por hablar.

https://youtu.be/zDJxBykV1C0?t=205

Jorginhone escribió:@dfx mi placa lleva backplate que es del tamaño de la placa,es enorme,para refrigerar el vrm y es 20 grados mas bajo en temperatura que la placa asus de mismo rango de precio,sin backplate y tambien el vrm es peor dicho de paso que me imagino influira.

En graficas hace poco vi un mod de una 3080 o ti con mini disipadores cuadrados de aluminio con aletas pegados al backplate y un ventilador encima "volando" para ayudar a extrae el calor ,los habia puesto estrategicamente encima de las memorias y mejoro temperatura pero no recuerdo el dato exacto😅,10 grados aprox,no lo recuerdo exactamente,lo cuento como una curiosidad basicamente

Coincido que el backplate deberia ser usado como disipacion,ademas con lo que valen las graficas si ven que hace falta algo mejor y tienen que invertir 10€ mas?,que lo hagan,no hay excusa seguro que aun asi es bastante rentable.

ale210 escribió:Se ha venido para casa una ASUS ROG STRIX 3070 POR 799€, ¿cómo veis este modelo?

https://www.coolmod.com/asus-rog-strix- ... ry_id=1521

ViRuSz escribió:ale210 escribió:Se ha venido para casa una ASUS ROG STRIX 3070 POR 799€, ¿cómo veis este modelo?

https://www.coolmod.com/asus-rog-strix- ... ry_id=1521

Para mí es el mejor modelo, pero ni loco pagaría 799€ por una 3070.

Todopc-WII escribió:Lo de AMD nunca va a conseguir lo que consigue el DLSS de Nvidia y es de cajón, uno va por software y el otro es por hardware... , por más qué la peña se empeñe, nunca va a llegar al nivel de Nvidia.

ale210 escribió:@DarkMessiah @ViRuSz

Obviamente tiene sobre precio...pero por lo que cuesta una FE que tienes que estar viviendo con el móvil pegado al partAlert y encima las temperaturas que tienen no son muy allá... no es una locura pillar una custom, pero vamos, que ni puta gracia me hace pagarlo.

Todopc-WII escribió:Lo de AMD nunca va a conseguir lo que consigue el DLSS de Nvidia y es de cajón, uno va por software y el otro es por hardware... , por más qué la peña se empeñe, nunca va a llegar al nivel de Nvidia.

ale210 escribió:@DarkMessiah @ViRuSz

Obviamente tiene sobre precio...pero por lo que cuesta una FE que tienes que estar viviendo con el móvil pegado al partAlert y encima las temperaturas que tienen no son muy allá... no es una locura pillar una custom, pero vamos, que ni puta gracia me hace pagarlo.

Dfx escribió:JaviGabber escribió:Dfx escribió:Bueno, en lo único que puedo dar la razón es que la GDDR6X igual no ha sido tan buena elección, habiendo caminos de buses más grandes o el acercamiento de AMD con Infinity Cache. Pero también es verdad que el problema con la VRAM lo venimos arrastrando desde hace varias generaciones, los fabricantes se preocupan de refrigerar la GPU pero poco de la VRAM, reutilizan diseños de disipador si es posible y repiten errores.

La GDDR6X requiere de especial atención en el disipador y de thermalpads de calidad, cosa que cojean casi todos los ensambladores. Yo también pienso que el acercamiento de Infinity Cache era más inteligente, pero también hay que decir que 128MB es insuficiente y ya se ve venir en rumores de RDNA 3 que subirá bastante.

Se agradece leer a usuarios como tú, subes el nivel del hilo, nivel que algunos tiran por tierra.

Espero que la gente sepa diferenciar a los trolls y flames para no desinformarse.

Creo que tampoco estamos acostumbrados a que ambas marcas hayan sido tan competitivas y el precio también va desvirtuando un poco el debate. Te agradezco el comentario.

Yo tengo la 3080 y como usuario "entusiasta" he visto el problema rápido, lo he solventado con thermalpad y ya está. Me molesta tocar una GPU que tiene menos de un mes y que cuesta lo que cuesta por un fallo del ensamblador, por mucho que digan que 100º entra dentro de los parámetros y no pasada nada. Si lo miras del lado usuario normal, el tema de establecer una protección a la memoria GDDR6X probablemente venia de cara a problemas futuros, porque si no ha pasado ni un año desde el lanzamiento y ya vemos tantos problemas, no me quiero imaginar en el periodo de pasada garantia (+2 años) esos thermalpad como estarán.

Yo tengo todo NVIDIA en mis PC principales y me gusta como marca sin llegar al fanatismo cerrado, por eso se reconocer que en esta generación RDNA 2 tiene sus puntos fuertes de eficiencia, VRAM e Infinity Cache, pero se ha quedado un poco corta en Ray Tracing y que realmente Infinity Cache igual se ha quedado algo corta para los juegos que vendrán, el camino es seguir engordando texturas.

En diseño AMD no se ha complicado la vida con el modelo de referencia, hemos dicho adiós a las turbinas, que ya era hora, pero a mi por ejemplo lo de NVIDIA con el pass-through, a pesar de que la mia Aorus XTREME también lo lleva, no me gusta en exceso. De hecho, ya he comentado en el hilo alguna vez que ahora que el multi-GPU ha muerto, ojalá algunos ensambladores comiencen a considerar diseños de triple-slot, pero 2+1, un diseño activo como siempre frontal y un backplate diseñado para refrigerar de verdad, que se ha demostrado infinidad de veces ya que un backplate bien hecho que refrigere aporta muchas ventajas. Esta idea tampoco es nueva, de hecho EKWB vende un bloque doble para las RTX para ambas caras de la GPU, que sinceramente, es la gloria.

PepeC12 escribió:Ojala triunfe el FSR y el DLSS quede en el olvido, porque será mejor para todos, es que mismamente con el FSR podemos escalar cualquier cosa, videojuegos, videos, lo que sea.

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif) etc..... Veo bien que haya gente que valore estas cosas pero hay que entender que muchos compranos GPUs para disfrutarlas a tope desde el día 1, dentro de 2 o 3 años a saber que GPU tendré o donde estaré

etc..... Veo bien que haya gente que valore estas cosas pero hay que entender que muchos compranos GPUs para disfrutarlas a tope desde el día 1, dentro de 2 o 3 años a saber que GPU tendré o donde estaré ![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

Asran escribió:Otro que habla sin saber... has probado a jugar al diablo 2 y ponerlo en alto? yo si y a veces no me da los 144 fps, es un juego con el que se calienta un infierno la grafica porque aunque te parezca que no "porque sus graficos se ven feos" ese juego es exigente y sino te animo a que vayas y lo instales y compruebes con un programa de monitoreo si es verdad o no lo que te estoy diciendo.

Asran escribió:El Dlss en las de Amd va muy bien se llama Fsr lo estan empezando a implementar en los juegos y da el mismo rendimiento que el dlss

), ¿te crees que no la conocía después de las veces que se ha puesto en este hilo? Te dije concretamente DLSS porque con una Nvidia tienes DLSS y FSR mientras que con una AMD solo tienes FSR. Y ya se verá a medio o largo plazo pero ahora mismo es mejor DLSS aparte que mas juegos son compatibles con DLSS. Y hablas de rendimiento... claro, porque de calidad no te interesa, no? No son pocos los análisis que dicen que DLSS tiene más calidad.

), ¿te crees que no la conocía después de las veces que se ha puesto en este hilo? Te dije concretamente DLSS porque con una Nvidia tienes DLSS y FSR mientras que con una AMD solo tienes FSR. Y ya se verá a medio o largo plazo pero ahora mismo es mejor DLSS aparte que mas juegos son compatibles con DLSS. Y hablas de rendimiento... claro, porque de calidad no te interesa, no? No son pocos los análisis que dicen que DLSS tiene más calidad.Asran escribió:pero tambien te digo una cosa comprarme una grafica de 720€ o 1200 como en el caso de mi 3080ti para sacar pecho de una tecnologica de reescalado es para hacernoslo mirar, por ese dinero no tendria que hacer falta ninguna tecnologia que tenga que reconstruir una resolucion mas baja para darme fps extra, nos la meten por el culo con una tecnologia que no tendria que existir por el dinero que estamos gastanto y aun encima les aplaudimos. Por ese dinero tendrian que irnos los juegos todos como la seda. Ahi te va un video, si esque......... hablar por hablar.

https://youtu.be/zDJxBykV1C0?t=205

Asran escribió:@eR_pOty tienes razon la veo 2 generaciones por detras:

https://www.youtube.com/watch?v=Z21CPnd0ib8

![enrojecido [ayay]](/images/smilies/nuevos/sonrojado_ani1.gif)

Asran escribió:Ultimo mensaje que dejo aqui, mientras haya lameculos de una sola marca en concreto los que perdemos somos nosotros los consumidores la serie 3000 no son malas graficas pero en algunos modelos han patinado y hay que reconocerlo, sino nos mean en la boca y nos lo tragamos tan ricamente, que tenga que abrir mi 3080ti porque las memorias se ponen a 110 grados y hagan thermal throttling es muy normal, espera pero como tienen mejor rtx tecnologia que esta implementada en el 1% de los juegos del mercado y me ofrecen una tecnologia de reescalado por IA ya esta puedo estar contento.

La generacion pasada no toque una sola grafica de amd, tuve una rtx 2060, esta generacion tengo una 6800 y le di la oportunidad a la 3080ti y me quedo con la 6800 de calle, menos ruido, mucho menos consumo, no hay que abrirla por posibles temperaturas excesivas de la Vram, sin usar tecnicas de reescalado pierdo 20 fps a lo sumo depende del juego en algunos incluso le gana a la 3080ti y vale exactamente la mitad de dinero.

https://hardzone.es/noticias/tarjetas-g ... ermal-pad/

Asran escribió:Ultimo mensaje que dejo aqui, mientras haya lameculos de una sola marca en concreto los que perdemos somos nosotros los consumidores la serie 3000 no son malas graficas pero en algunos modelos han patinado y hay que reconocerlo, sino nos mean en la boca y nos lo tragamos tan ricamente, que tenga que abrir mi 3080ti porque las memorias se ponen a 110 grados y hagan thermal throttling es muy normal, espera pero como tienen mejor rtx tecnologia que esta implementada en el 1% de los juegos del mercado y me ofrecen una tecnologia de reescalado por IA ya esta puedo estar contento.

La generacion pasada no toque una sola grafica de amd, tuve una rtx 2060, esta generacion tengo una 6800 y le di la oportunidad a la 3080ti y me quedo con la 6800 de calle, menos ruido, mucho menos consumo, no hay que abrirla por posibles temperaturas excesivas de la Vram, sin usar tecnicas de reescalado pierdo 20 fps a lo sumo depende del juego en algunos incluso le gana a la 3080ti y vale exactamente la mitad de dinero.

https://hardzone.es/noticias/tarjetas-g ... ermal-pad/

Asran escribió:Ultimo mensaje que dejo aqui [...]

PepeC12 escribió:Yo desde luego tengo claro que iria a por una 6800 o 6800 xt por encima de las nvidia, por consumo y vram simplemente, pero porque el RT no me llama la atencion, prefiero apostar por FSR antes que DLSS y suelo alargar mucho la vida de las graficas por lo que la vram creo que va ser importante.

Asran escribió:Ultimo mensaje que dejo aqui, mientras haya lameculos de una sola marca en concreto los que perdemos somos nosotros los consumidores la serie 3000 no son malas graficas pero en algunos modelos han patinado y hay que reconocerlo, sino nos mean en la boca y nos lo tragamos tan ricamente, que tenga que abrir mi 3080ti porque las memorias se ponen a 110 grados y hagan thermal throttling es muy normal, espera pero como tienen mejor rtx tecnologia que esta implementada en el 1% de los juegos del mercado y me ofrecen una tecnologia de reescalado por IA ya esta puedo estar contento.

La generacion pasada no toque una sola grafica de amd, tuve una rtx 2060, esta generacion tengo una 6800 y le di la oportunidad a la 3080ti y me quedo con la 6800 de calle, menos ruido, mucho menos consumo, no hay que abrirla por posibles temperaturas excesivas de la Vram, sin usar tecnicas de reescalado pierdo 20 fps a lo sumo depende del juego en algunos incluso le gana a la 3080ti y vale exactamente la mitad de dinero.

https://hardzone.es/noticias/tarjetas-g ... ermal-pad/

![Ok! [oki]](/images/smilies/net_thumbsup.gif)

Asran escribió:@colado Pues no voy a despotricar sobre una grafica que tengo y de la cual hay aspectos que estan muy mal en otro hilo que no sea el propio de Nvidia no? o deberia de ir a decirlo a algun hilo de amd... menudo genio.

@Rvilla87 Yo no prefiero ni Fsr ni Dlss creo que son tecnologias que no deberian de existir por el precio que estamos pagando por una tarjeta grafica y eso de que Rtx no me llama la atencion lo dices tu, a mi me gusta obviamente pero es una tecnologia que esta lejos 1 de ser un estandar en la mayoria de juegos del mercado y 2 que esta muy verde aun y el coste de rendiminto por activarlo es aberrante y he probado el Cyberbug con RTX y dlss en la 3080ti lo que si que creo es que de aqui a unos años Fsr sera mas estandar que Dlss por el mismo motivo que FreeSync es mas estandar ahora que G-sync en monitores.

Lo que mas gracia me hace es saber que con los que estoy debatiendo no habeis probado una grafica de las nuevas de Amd en la puta vida y yo he testeado y requetesteado las 4 graficas de esta nueva gen que han pasado por mis manos, undervolt, Oc, medicion de temperaturas de rendimiento en todos los juegos que tengo es mas disfruto mas probando esas cosas y trasteando que jugando.

@Valhan todas las graficas de esta generacion: rtx 3060,rtx 3060ti,rtx 3070,rtx 3070ti,rx 6600xt, rx 6700xt, rx 6800, rx 6800xt, y rx 6900xt no tienen problemas de temperatura con las memorias, las que si lo tienen son: rtx 3080, rtx 3080ti y rtx 3090 y no en todas las ensambladoras, por ejemplo las founders todas tienene ese problema, pero la Ensambladora Palit por ejemplo sus 3080ti el maximo de temperatura de sus Vram son 82 grados depende de que thermalPads haya colocado cada emsambladora.

@FranciscoVG la competencia de la 6900xt es la 3090 no te confundas y la 6900 xt consume 50W menos que la 3080ti, el Tjuction de la 3080ti tambien llega a altas temperaturas si no le haces undervolt. El problema reside en las memorias que no les puedes hacer undervolt y lo unico que te queda por hacer es rezar para que algun dia no se te quemen si juegas mucho o abrirla y cambiar la chapuzada que hicieron con los thermal pad de mierda que les pusieron.

https://www.youtube.com/watch?v=boIIA9Ts3BQ&t=393s

6800Xt vs 3080ti 670€ vs 1199€

Jorginhone escribió:pero porque os rayais de esta manera,una cosa es hablar de hardware sanamente otra es hacer una guerra,que cada uno disfrute lo que tenga y fuera.

eR_pOty escribió:Para mi no compiten en absoluto, AMD esta 2 pasos/generaciones por detras de Nvidia mientras no tenga hardware dedicado para raytracing y el otro paso es que el FSR es un arma de doble filo que lo unico que hace es beneficiar a los usuarios que compren una nvidia mientras que el DLSS no beneficia a los usuarios de amd (y ya no entro en si uno es muchisimo mejor que el otro)

Asran escribió:@colado Pues no voy a despotricar sobre una grafica que tengo y de la cual hay aspectos que estan muy mal en otro hilo que no sea el propio de Nvidia no? o deberia de ir a decirlo a algun hilo de amd... menudo genio.

colado escribió:Asran escribió:@colado Pues no voy a despotricar sobre una grafica que tengo y de la cual hay aspectos que estan muy mal en otro hilo que no sea el propio de Nvidia no? o deberia de ir a decirlo a algun hilo de amd... menudo genio.

Claro que puedes venir a despotricar, pero con argumentos y sin faltar, que si lameculos, que si es una mierda. Dudo que la tengas, segun tus mensajes has tenido al menos 8 graficas de la ultima generacion de amd/nvidia. Y encima vas diciendo que una 3080ti es inferior a una 6800xt cuando todos los benchmarks y pruebas dicen que no.

Que se calienta la vram en las fe, si, pero si te pasan de 110°C es que tienes un horno de caja.

Repito, hueles a troll “genio”.

Respecto a @Camoranesi tu estas mas que retratado como troll con tus mensajes

Asran escribió:colado escribió:Asran escribió:@colado Pues no voy a despotricar sobre una grafica que tengo y de la cual hay aspectos que estan muy mal en otro hilo que no sea el propio de Nvidia no? o deberia de ir a decirlo a algun hilo de amd... menudo genio.

Claro que puedes venir a despotricar, pero con argumentos y sin faltar, que si lameculos, que si es una mierda. Dudo que la tengas, segun tus mensajes has tenido al menos 8 graficas de la ultima generacion de amd/nvidia. Y encima vas diciendo que una 3080ti es inferior a una 6800xt cuando todos los benchmarks y pruebas dicen que no.

Que se calienta la vram en las fe, si, pero si te pasan de 110°C es que tienes un horno de caja.

Repito, hueles a troll “genio”.

Respecto a @Camoranesi tu estas mas que retratado como troll con tus mensajes

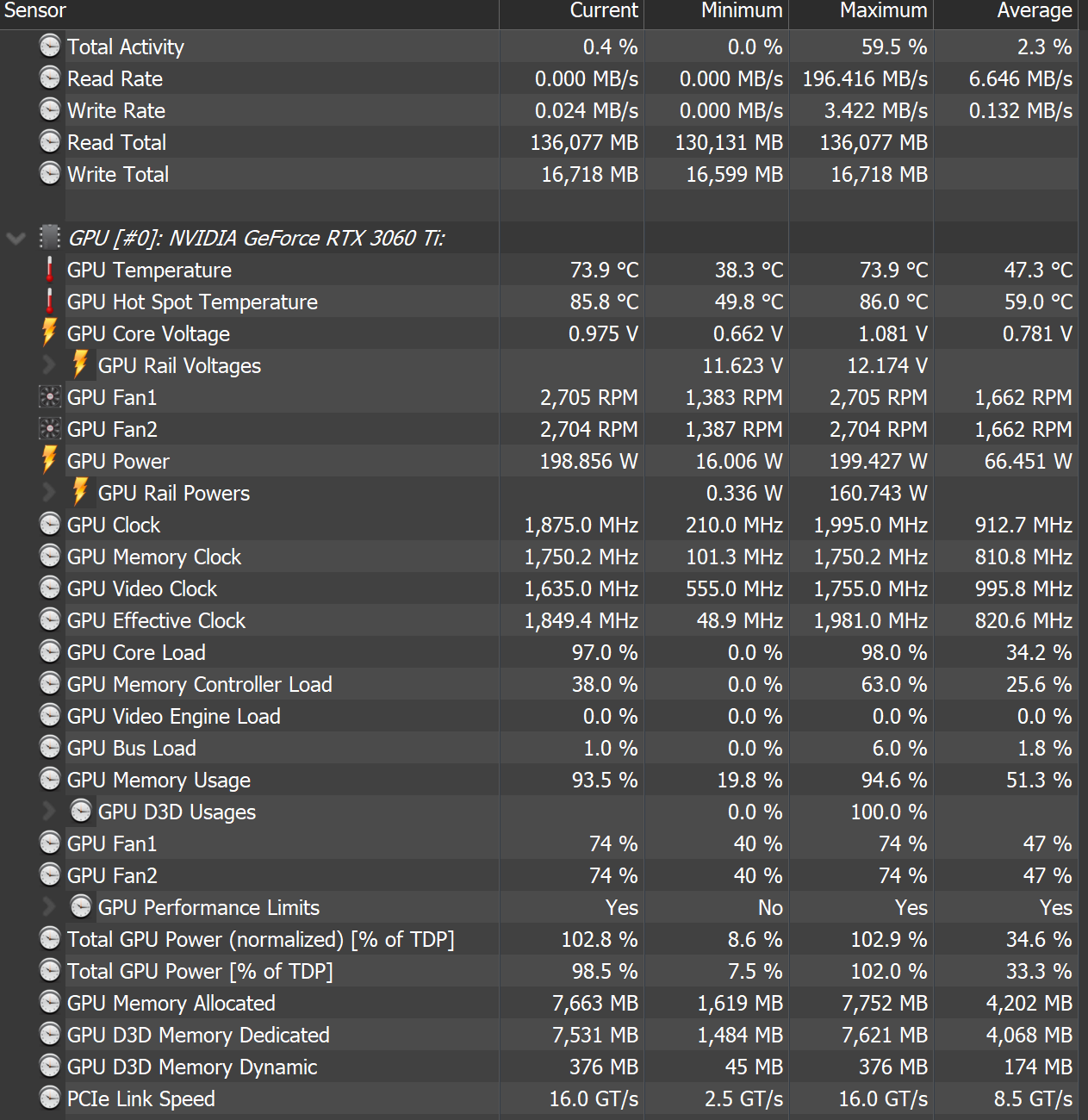

https://imgur.com/a/TY5oGsa

Lo que tu digas maquina. Te vuelvo a repetir he probado 4 graficas de esta gen de diciembre a Agosto 3060ti, 3070, rx 6800 y rtx 3080ti no se yo quien sera el troll y tampoco tengo una caja poco ventilada

Ah espera que ahi te va otra y si te fijas muy muy bien, veras que tengo puesta la 6800 en vez de la 3080Ti porque literalmente jugando al diablo II se ponen las memorias a mas de 100 graditos ricos y eso que vivo en el norte que raramente pasamos de 20 grados de temp ambiente.

Sacaria muy gustosamente la Amd para poner la 3080 con el diablo para hacerte una rica captura y darte con ella en los morros, pero se acabo la Beta y no puedo entrar.

https://imgur.com/a/LIjMrHk