Dfx escribió:eR_pOty escribió:Para mi no compiten en absoluto, AMD esta 2 pasos/generaciones por detras de Nvidia mientras no tenga hardware dedicado para raytracing y el otro paso es que el FSR es un arma de doble filo que lo unico que hace es beneficiar a los usuarios que compren una nvidia mientras que el DLSS no beneficia a los usuarios de amd (y ya no entro en si uno es muchisimo mejor que el otro)

AMD tiene unidades dedicadas Ray Accelerator por cada CU, igual que NVIDIA tiene sus núcleos RT por cada SM. Lo que no tiene AMD son Tensors.

Yo mismo he dicho que el acercamiento de AMD con los Ray Accelerator ha sido tímido para ser la primera generación, pero aún así, bueno, han dado resultado. De todas maneras NVIDIA también viene quedándose corta en unidades RT, así que si estamos a dos generaciones por detrás es de una aplicación del Ray Tracing fluida y efectiva.

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

PepeC12 escribió:Asran escribió:Ultimo mensaje que dejo aqui, mientras haya lameculos de una sola marca en concreto los que perdemos somos nosotros los consumidores la serie 3000 no son malas graficas pero en algunos modelos han patinado y hay que reconocerlo, sino nos mean en la boca y nos lo tragamos tan ricamente, que tenga que abrir mi 3080ti porque las memorias se ponen a 110 grados y hagan thermal throttling es muy normal, espera pero como tienen mejor rtx tecnologia que esta implementada en el 1% de los juegos del mercado y me ofrecen una tecnologia de reescalado por IA ya esta puedo estar contento.

La generacion pasada no toque una sola grafica de amd, tuve una rtx 2060, esta generacion tengo una 6800 y le di la oportunidad a la 3080ti y me quedo con la 6800 de calle, menos ruido, mucho menos consumo, no hay que abrirla por posibles temperaturas excesivas de la Vram, sin usar tecnicas de reescalado pierdo 20 fps a lo sumo depende del juego en algunos incluso le gana a la 3080ti y vale exactamente la mitad de dinero.

https://hardzone.es/noticias/tarjetas-g ... ermal-pad/

No merece la pena discutir con fanaticos, no vas a cambiarles de opinion.

Que cada uno haga lo que quiera, tampoco es que haya stock ni precios competentes en ningun sitio.

Yo desde luego tengo claro que iria a por una 6800 o 6800 xt por encima de las nvidia, por consumo y vram simplemente, pero porque el RT no me llama la atencion, prefiero apostar por FSR antes que DLSS y suelo alargar mucho la vida de las graficas por lo que la vram creo que va ser importante.

Al final parece que Nvidia y Amd han hecho un pacto de no agresion porque basicamente ofrecen lo mismo por el mismo precio, son productos super parecidos por mas que nos empeñemos en que esta es mejor o no.

![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

colado escribió:Sobre la cantidad de vram y que envejecera peor la tarjeta que menos vram tenga lo llevo escuchandolo desde que me interese por el mundo de la informatica hace mas de 15 años, y siempre, siempre, una grafica se queda anticuada por la potencia grafica del chip que por el tamaño de su vram. Cuando una 3070/6800 se quede corta para jugar a ciertos juegos, no sera porque se sature sus memorias. Ademas, no es lo mismo la vram de una 3070-3080 que una 1080ti con 11gb, el bus es muchisimo mayor y con menos hacen mucho mas.

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

neox3 escribió:colado escribió:Sobre la cantidad de vram y que envejecera peor la tarjeta que menos vram tenga lo llevo escuchandolo desde que me interese por el mundo de la informatica hace mas de 15 años, y siempre, siempre, una grafica se queda anticuada por la potencia grafica del chip que por el tamaño de su vram. Cuando una 3070/6800 se quede corta para jugar a ciertos juegos, no sera porque se sature sus memorias. Ademas, no es lo mismo la vram de una 3070-3080 que una 1080ti con 11gb, el bus es muchisimo mayor y con menos hacen mucho mas.

yo creo que al final es una tonteria fijarse en la vram, mientras el equipo este compensado con cantidad decente de ram normal y discos ssd, el juego tirará de esa ram o de memoria virtual.

Tengo una 3080 de 10gigas, y me he puesto hace unos dias con resident evil village,, todo a tope, jugando a 2k, escala de resolucion aumentada... me detecta en la gráfica 9 gigas y pico,, y el medidor de uso de vram en "rojo" , y marcando 12gigas y pico de vram....

El juego va como la seda

colado escribió:Sobre la cantidad de vram y que envejecera peor la tarjeta que menos vram tenga lo llevo escuchandolo desde que me interese por el mundo de la informatica hace mas de 15 años, y siempre, siempre, una grafica se queda anticuada por la potencia grafica del chip que por el tamaño de su vram. Cuando una 3070/6800 se quede corta para jugar a ciertos juegos, no sera porque se sature sus memorias. Ademas, no es lo mismo la vram de una 3070-3080 que una 1080ti con 11gb, el bus es muchisimo mayor y con menos hacen mucho mas.

![facepalm [facepalm]](/images/smilies/facepalm.gif)

katatsumuri escribió:Por lo menos no estáis discutiendo por la escasez, es bueno ver eso de "Mi gpu es la mejo!", yo aún sigo sin gpu

Hegolan escribió:katatsumuri escribió:Por lo menos no estáis discutiendo por la escasez, es bueno ver eso de "Mi gpu es la mejo!", yo aún sigo sin gpu

Y mejor que no, todavía falta muchísimo, hoy mismo ha dicho nvidia que va a seguir igual durante la gran mayoría del 2022, y como le pase algo a Taiwán con todos los líos que se están montando ya si que nos vamos a reír.

https://www.pcmag.com/news/nvidia-gpu-s ... ty-of-2022

Cyborg_Ninja escribió:Lo que quiero decir es que una tontería ya te digo yo que no va a ser. Otro asunto es que sea algo inasumible ni nada parecido, pero al menos en mi experiencia, más vale quedarte corto de gráfica que de VRAM. Solo hay que ver las gráficas de 2013-2014-2015, que modelos con potencia similar las de 2GB se mueren y las de 4GB aguantan muchísimo mejor el tipo.

Importante en mi opinión es.

colado escribió:Cyborg_Ninja escribió:Lo que quiero decir es que una tontería ya te digo yo que no va a ser. Otro asunto es que sea algo inasumible ni nada parecido, pero al menos en mi experiencia, más vale quedarte corto de gráfica que de VRAM. Solo hay que ver las gráficas de 2013-2014-2015, que modelos con potencia similar las de 2GB se mueren y las de 4GB aguantan muchísimo mejor el tipo.

Importante en mi opinión es.

Bueno, si hablamos de tarjetas de 2014, voy a coger la mejor de aquella epoca contra las gama baja/media de 2 años despues, la 780ti con sus 3 gb de vram, rinde mas o menos igual que una 1050ti 4gb, pero si la comparamos con la 1060 3gb, la keppler sale perdiendo por bastante aun teniendo la misma cantidad de vram. Si la 780ti tuviese 10gb, el resultado seria el mismo.

Tener mas vram te hace envejecer mejor? Para mi no, porque dentro de 2,3 o 4 años tendras que bajar requisitos y resoluciones para que el chip grafico pueda con el juego, por lo que el consumo de vram disminuye.

Que hay 2 juegos que saturan con 8gb? Cuales? A que resolucion? Que de optimizados estan?

Cyborg_Ninja escribió:neox3 escribió:colado escribió:Sobre la cantidad de vram y que envejecera peor la tarjeta que menos vram tenga lo llevo escuchandolo desde que me interese por el mundo de la informatica hace mas de 15 años, y siempre, siempre, una grafica se queda anticuada por la potencia grafica del chip que por el tamaño de su vram. Cuando una 3070/6800 se quede corta para jugar a ciertos juegos, no sera porque se sature sus memorias. Ademas, no es lo mismo la vram de una 3070-3080 que una 1080ti con 11gb, el bus es muchisimo mayor y con menos hacen mucho mas.

yo creo que al final es una tonteria fijarse en la vram, mientras el equipo este compensado con cantidad decente de ram normal y discos ssd, el juego tirará de esa ram o de memoria virtual.

Tengo una 3080 de 10gigas, y me he puesto hace unos dias con resident evil village,, todo a tope, jugando a 2k, escala de resolucion aumentada... me detecta en la gráfica 9 gigas y pico,, y el medidor de uso de vram en "rojo" , y marcando 12gigas y pico de vram....

El juego va como la seda

A ver, el caso de RE suele ser diferente porque el medidor de uso de VRAM no es real. Al menos en RE2/RE3 y sospecho que en el Village será igual. Si realmente necesitaras 12GB de VRAM el juego te iría a tirón limpio. De hecho en RE2 es lo contrario, se aconsejaba superar el límite de VRAM en las opciones porque era mas bien una caché de texturas.

Seguramente si usas programas para medir el uso no estará usando la vram completa. De hecho creo que solo hay un par de juegos en el mercado que se atragantan un poco pero con 8GB de VRAM y tú GPU tiene 10.

Lo que quiero decir es que una tontería ya te digo yo que no va a ser. Otro asunto es que sea algo inasumible ni nada parecido, pero al menos en mi experiencia, más vale quedarte corto de gráfica que de VRAM. Solo hay que ver las gráficas de 2013-2014-2015, que modelos con potencia similar las de 2GB se mueren y las de 4GB aguantan muchísimo mejor el tipo.

Importante en mi opinión es.

![brindis [beer]](/images/smilies/nuevos2/brindando.gif) en todo caso es sólo una opinión personal.

en todo caso es sólo una opinión personal. PepeC12 escribió:@joanvicent

Yo diría que si, al nivel de la 6800 tienes tres opciones en nvidia, la 3070, 3070ti y 3080.

Lo más parecido en rendimiento es la 3070ti, pero amd tiene 16 gb de vram vs 8 de nvidia. Hoy puede valer con 8 pero estas muy en el límite.

Si pretendes que te dure más de 4 años yo veo mas seguro una 6800 ( por la vram más que nada).

Al final las dos marcas ofrecen el mismo rendimiento por el mismo precio más o menos.

ReinRaus escribió:Como veis una gigabyte 3070 ti por 820 euros? Nueva en tienda

ReinRaus escribió:Como veis una gigabyte 3070 ti por 820 euros? Nueva en tienda

Laguna_I escribió:Para encontrarlas a buen precio qué hacéis? Existen grupos/bots de Telegram?

Laguna_I escribió:Para encontrarlas a buen precio qué hacéis? Existen grupos/bots de Telegram?

Laguna_I escribió:Para encontrarlas a buen precio qué hacéis?

![ok [ok]](/images/smilies/nuevos2/okis.gif)

eR_pOty escribió:Laguna_I escribió:Para encontrarlas a buen precio qué hacéis?

Leerse el hilo y no preguntar lo mismo a cada pagina. Mano de santo

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

Vli escribió:@the_aeon Las 3000 tienen un extra boost en la velocidad del núcleo, te meten entre 15 y 30Mhz extras al tope que le tienes asignado. Esto provoca que muchas veces en undervolt crashee al rato porque en X es estable pero X+15 no.

PepeC12 escribió:Por lo visto ya hay otro competidor al DLSS.

Este me ha sorprendido la verdad:

https://videocardz.com/newz/intel-xess- ... it-matures

Intel XeSS, se basa al igual que el DLSS en vectores de movimiento y redes de neuronas,

Utiliza instrucciones XMX o DP4a y es open source.

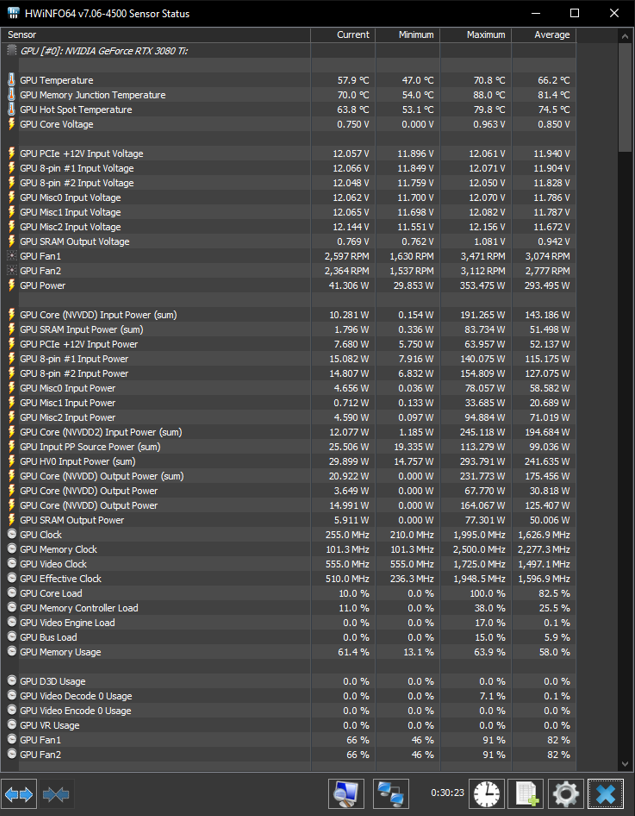

ViRuSz escribió:Después de 1 hora jugando al Horizon con los ventiladores de la gráfica al 90%, he tenido estas temperaturas:

Debo ser un suertudo por no tener 100 grados en las memorias como se dice por aquí.

PepeC12 escribió:Por lo visto ya hay otro competidor al DLSS.

Este me ha sorprendido la verdad:

https://videocardz.com/newz/intel-xess- ... it-matures

Intel XeSS, se basa al igual que el DLSS en vectores de movimiento y redes de neuronas,

Utiliza instrucciones XMX o DP4a y es open source.

LynX escribió:¿De estas 3080 cuál os compraríais? (Al mismo precio las 3)

- Asus TUF Gaming OC

- MSI Gaming Z Trio

- Gigabyte Gaming OC

the_aeon escribió:El Horizon no es un buen ejemplo para mirar temperaturas de la memoria, juega al resident village o metro exodus y luego nos dices....

LynX escribió:¿De estas 3080 cuál os compraríais? (Al mismo precio las 3)

- Asus TUF Gaming OC

- MSI Gaming Z Trio

- Gigabyte Gaming OC

LynX escribió:¿De estas 3080 cuál os compraríais? (Al mismo precio las 3)

- Asus TUF Gaming OC

- MSI Gaming Z Trio

- Gigabyte Gaming OC

ViRuSz escribió:the_aeon escribió:El Horizon no es un buen ejemplo para mirar temperaturas de la memoria, juega al resident village o metro exodus y luego nos dices....

Tras media hora de Metro...

El Resident Evil Village no lo tengo, así que...

the_aeon escribió:ViRuSz escribió:the_aeon escribió:El Horizon no es un buen ejemplo para mirar temperaturas de la memoria, juega al resident village o metro exodus y luego nos dices....

Tras media hora de Metro...

El Resident Evil Village no lo tengo, así que...

Que modelo es? es una founders?

Jorginhone escribió:Acabo de leer un mensaje en el foro que se merece un quote en toda regla:

"+1 Que yo vendi mi targeta 1080 a principios de año casi al precio que me costo nueva hace 4 años para tratar de pillar una 3070, pero nunca salio a pvp y mejor me pille PS5, esta si en 500 usd y asi seguire hasta que esto vuelva a la normalidad o me aviento toda la generacion en PS5, no pienso pagar esos precios."

Hace lo mismo timando a alguien y se queja de los precios?

Menuda picaresca,me recuerda totalmente a los usuarios que fueron a vender corriendo sus 2080ti intentando piyar al incauto por banda,yo tenia una y no hice eso y seguro mas de uno palmo pasta malvendiendo su grafica.

Luego nos quejamos de los precios y no es justificable que pase esto y no todo el mundo es igual obviamente pero tambien hay especimenes de este palo.