hh1 escribió:Pollonidas escribió:hh1 escribió:Hay que tener en cuenta que la 4090 es muy bestia.

Yo creo que en raster la 5080 ,que encima ,no es una 80 realmente , va a estar por debajo .

La va a superar reescalando.

Es más ,ten en cuenta que la 5090 es el doble que la 5080 .

Si la 5080 fuese ya mejor en raster que la 4090, cuanto le sacaría a esta la 5090?

Una brutalidad que tampoco se ha dado jamás.

Y eso en raster .

Que si nos vamos a reescalado , hablaríamos de barbaridades.

Lo dudo mucho y más cuando no cambian de nodo.

Las mejoras de nodo lo que aportan son frecuencias más altas y consumos menores a igualdad de todo lo demás, a nivel de potencia lo que se nota es la arquitectura y el número de unidades de cómputo.

No te digo que no a lo de que la 5090 es literalmente el doble de la 5080 si las specs que se han filtrado son ciertas, pero en tamaño del die es "solo" un 20% más que la 4090, creo que el salto generacional en el tope de gama no va a ser superior a lo que se ha visto otras veces.

Y sobre lo anterior, aunque me moje demasiado, yo pienso que en raster puro y duro la 5080 debería ser claramente superior a la 4090. Sin escalado ni "trucos". Simplemente porque desde el punto de vista de márketing no tiene sentido otra cosa. Puedo equivocarme, claro, pero me parecería un movimiento "raro" cuanto menos.zeo360 escribió:Buenas,

No se como veis cambiar una 3080 + 185€ por una 4070 Ti.

Un saludo

No está mal desde el punto de vista económico, pero yo personalmente no haría el cambio, primero por esperar a lo que salga como dicen los compañeros, y segundo porque bajas dos gamas, incluso si es más potente. Por la 4070Ti super, todavía me lo pensaría, pero de nuevo, no creo que salga a cuenta correr para que se devalúe menos tu gráfica porque la que pongas en su lugar también debería perder valor en la misma proporción.

Saludos

Pues si el salto no va a ser tan grande ,según lo que dices, que puede ser, pues siendo la 5080 la mitad que la 5090 (que obviamente, en rendimiento no tiene porqué ser literal), pues dudo mucho que la 5080 ,como ya dije, supere a la 4090 en raster.

Y ahí dejaría claro, porqué Nvidia estaría jugando con el tema de los tensor cores y los cuda cores, para conseguir mayor diferencia en reescalado ,ya que, como dices, en ratser ,no va a ser tan sencillo, o lo mismo ,ni les interesa subir tanto y tiran más por el otro camino.

the_aeon escribió:hh1 escribió:Pollonidas escribió:Las mejoras de nodo lo que aportan son frecuencias más altas y consumos menores a igualdad de todo lo demás, a nivel de potencia lo que se nota es la arquitectura y el número de unidades de cómputo.

No te digo que no a lo de que la 5090 es literalmente el doble de la 5080 si las specs que se han filtrado son ciertas, pero en tamaño del die es "solo" un 20% más que la 4090, creo que el salto generacional en el tope de gama no va a ser superior a lo que se ha visto otras veces.

Y sobre lo anterior, aunque me moje demasiado, yo pienso que en raster puro y duro la 5080 debería ser claramente superior a la 4090. Sin escalado ni "trucos". Simplemente porque desde el punto de vista de márketing no tiene sentido otra cosa. Puedo equivocarme, claro, pero me parecería un movimiento "raro" cuanto menos.

No está mal desde el punto de vista económico, pero yo personalmente no haría el cambio, primero por esperar a lo que salga como dicen los compañeros, y segundo porque bajas dos gamas, incluso si es más potente. Por la 4070Ti super, todavía me lo pensaría, pero de nuevo, no creo que salga a cuenta correr para que se devalúe menos tu gráfica porque la que pongas en su lugar también debería perder valor en la misma proporción.

Saludos

Pues si el salto no va a ser tan grande ,según lo que dices, que puede ser, pues siendo la 5080 la mitad que la 5090 (que obviamente, en rendimiento no tiene porqué ser literal), pues dudo mucho que la 5080 ,como ya dije, supere a la 4090 en raster.

Y ahí dejaría claro, porqué Nvidia estaría jugando con el tema de los tensor cores y los cuda cores, para conseguir mayor diferencia en reescalado ,ya que, como dices, en ratser ,no va a ser tan sencillo, o lo mismo ,ni les interesa subir tanto y tiran más por el otro camino.

Yo tengo claro que la 5080 cuando actives DLSS, FG y RT va a ser superior a la 4090, cuanto superior no lo se.

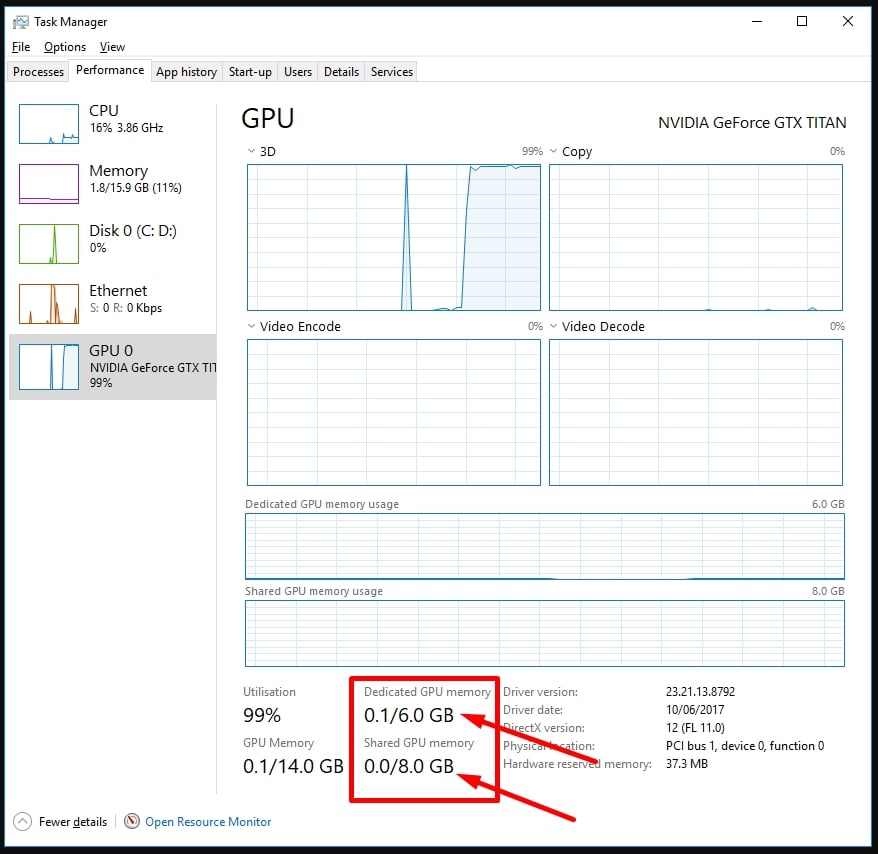

La cosa está si será siendo superior si se saturan sus 16 gb.

Rvilla87 escribió:@PSX22 la autoridad, en este contexto, no se la concede uno mismo sino los demás. No sé cómo crees que te ven pero desde luego a mi no me sirve un mensaje simple sin demostración alguna por tu parte (no así para algún que otro forero).

La autoridad se pierde cuando uno se contradice. Y para muestra 2 que puedo encontrar fácil con una búsqueda rápida:- Antes para ti DLSS 3 hacía que use menos VRAM (entre otras mezclas de conceptos del tema DLSS) cuando es justo lo contrario y de hecho ahora ya parece que lo has aprendido ("Apagas DLSS3 ( -1GB vram automaticamente"). Quizás tu fuente anterior era ese youtuber tortilla?

- Cuando decías que la VRAM la medían bien los fabricantes, y desde que te compraste la nueva gráfica con mas VRAM ahora te preocupa mas el tema (cuando ya en su momento había problemas de VRAM en algunos juegos).

Y para nada era necesaria una biblia, simplemente con decir que "he hecho pruebas" ya valía si se te tuviera un mínimo de autoridad (que ni afirmo ni desmiento, cada uno te considerará como crea). Pero como en EOL se acostumbra a ver mensajes afirmando cosa sin ton ni son pues qué quieres que te diga, normalmente no me creo casi nada porque la mayoría son invenciones sin fundamento alguno.

Si a ti te sirve con ese nivel de desinformación, perfecto, a mi no. Pero bueno, no es el único tema donde está mas que claro que no nos vamos a entender, pero al menos ha servido que para que no soltar únicamente la desinformación "mas vram = problema" como hiciste entender sino que pusiste pruebas de ese juego específico (porque no aplica a todos los juegos por igual, cosa que hemos hablado muchas veces en este tipo de hilos).

PSX22 escribió:[...] jamas he dicho que DLSS3 consuma menos vram, eso seria ser un sucio necio jaja. Pero nadie puede ser engañado con eso, si esa tecnologia ha usado mas memoria de siempre. Lo leerias mal. Que tambien puede ser que sea un post de humor, no digo que no.

PSX22 escribió:@Rvilla87

paradojicamente lo puse porque normalmente cuando usas DLSS3 reduces resolucion y por tanto vram, pero en este caso aumenta , en cyberpunk no es asi, cuando uso 4K nativo me usa mucha mas vram que cuando uso 4K DLSS FG, no es una norma. y no viene de un analisis sino de probarlo yo mismo

![Aplausos [plas]](/images/smilies/aplauso.gif)

Rvilla87 escribió:PSX22 escribió:[...] jamas he dicho que DLSS3 consuma menos vram, eso seria ser un sucio necio jaja. Pero nadie puede ser engañado con eso, si esa tecnologia ha usado mas memoria de siempre. Lo leerias mal. Que tambien puede ser que sea un post de humor, no digo que no.

No puede ser que cada vez que digas una tontería vengas con la excusa de que era humor. Esas excusas se las cuentas a un niño de 5 años que quizás a él se la cuelas, a la gente adulta no se la cuelas tan fácilmente.

Tu mensaje donde, según tú, NO decías que DLSS 3 consumía menos VRAM:PSX22 escribió:@Rvilla87

paradojicamente lo puse porque normalmente cuando usas DLSS3 reduces resolucion y por tanto vram, pero en este caso aumenta , en cyberpunk no es asi, cuando uso 4K nativo me usa mucha mas vram que cuando uso 4K DLSS FG, no es una norma. y no viene de un analisis sino de probarlo yo mismo

Y fíjate que ni hace falta entrar en la famosa confusión de llamar DLSS 3 a todo (el super resolution y el FG, entre otras cosas) cuando no es todo, porque lo pones mas fácil al usar las 2 veces el mismo término: DLSS 3. Así que no hay duda posible.

O te equivocaste en mezclar conceptos o en decir que DLSS 3 consumía menos VRAM, no vengas ahora con excusas baratas. Pero vale, que sí, que será humor, no?

Avísanos si te acepten en el club de la comedia, que al menos ahí quizás nos reiremos un rato

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

Rvilla87 escribió:@PSX22 pero a quién le estás explicando los componentes del DLSS si te lo expliqué en su momento al ver que te confundías? hilo_hilo-oficial-nvidia-ada-lovelace-rtx4000_2446714_s13450#p1754949626

De hecho ahora leyendo el principio de ese mensaje ya veo que vuelvo a equivocarme perdiendo el tiempo contigo, ya olvidé lo absurdo que era hablar contigo de estas cosas. En fin, buenas noches porque aquí termina mi conversación contigo.

PSX22 escribió:Rvilla87 escribió:@PSX22 pero a quién le estás explicando los componentes del DLSS si te lo expliqué en su momento al ver que te confundías? hilo_hilo-oficial-nvidia-ada-lovelace-rtx4000_2446714_s13450#p1754949626

De hecho ahora leyendo el principio de ese mensaje ya veo que vuelvo a equivocarme perdiendo el tiempo contigo, ya olvidé lo absurdo que era hablar contigo de estas cosas. En fin, buenas noches porque aquí termina mi conversación contigo.

al fin reconoces que no puedes conversar por falta de dominio de la jerga tecnologica, el DLSS3 no existe ya , van por la version 3.8.10 y no tiene nada que ver con el FG. Debe ser que andas despistado con las quest y no has podido ir al dia. Espero que vayas revisando novedades sino no podras entender mucho mas. Es pronto para dormir, pero descansa

PSX22 escribió:@bigsefirot

No es mejor una FE ( founders que una rog strix 4090) eso te han mentido si te lo han dicho. Lo que pasa es que si quieres la opcion mas barata sin suelen ser de salida las founders.

Lo que si esta claro es que si quieres ir a futuro bien servido, no te compres una 5080 de 16gb, porque con esa memoria si vas a 4K y path tracing YA las esta pasando canutas la 4080 . Y dejarse 1500 papeles para que dia 1 ya haya juegos que no podras poner a su tope con DLSS3 FG + Path tracing PT pues como que no.

He puesto las siglas con letras por ayudar, pero de normal nunca pongo nada que no sea DLSS Q o Balanced, FG ON VRR PT on 4K , pero asi ayuda esta vez

PSX22 escribió:@the_aeon

Indiana jones me usa 20GB vram al maximo 4K DLAA FG ON y PT pleno

Comprobado ayer

24gb seria lo minimo

El que quiera entender que entienda

gojesusga escribió:Vergüenza tenia que darle a los desarrolladores tener que activar dlss, frame generations y mierdas varias para poder jugar a buenos frames, al final lo que se está haciendo es perder calidad, gastandote 1000€ para arriba... Más vergüenza aun Nvidia por haber sacado esas tecnologías...

![llorica [mamaaaaa]](/images/smilies/nuevos/triste_ani4.gif)

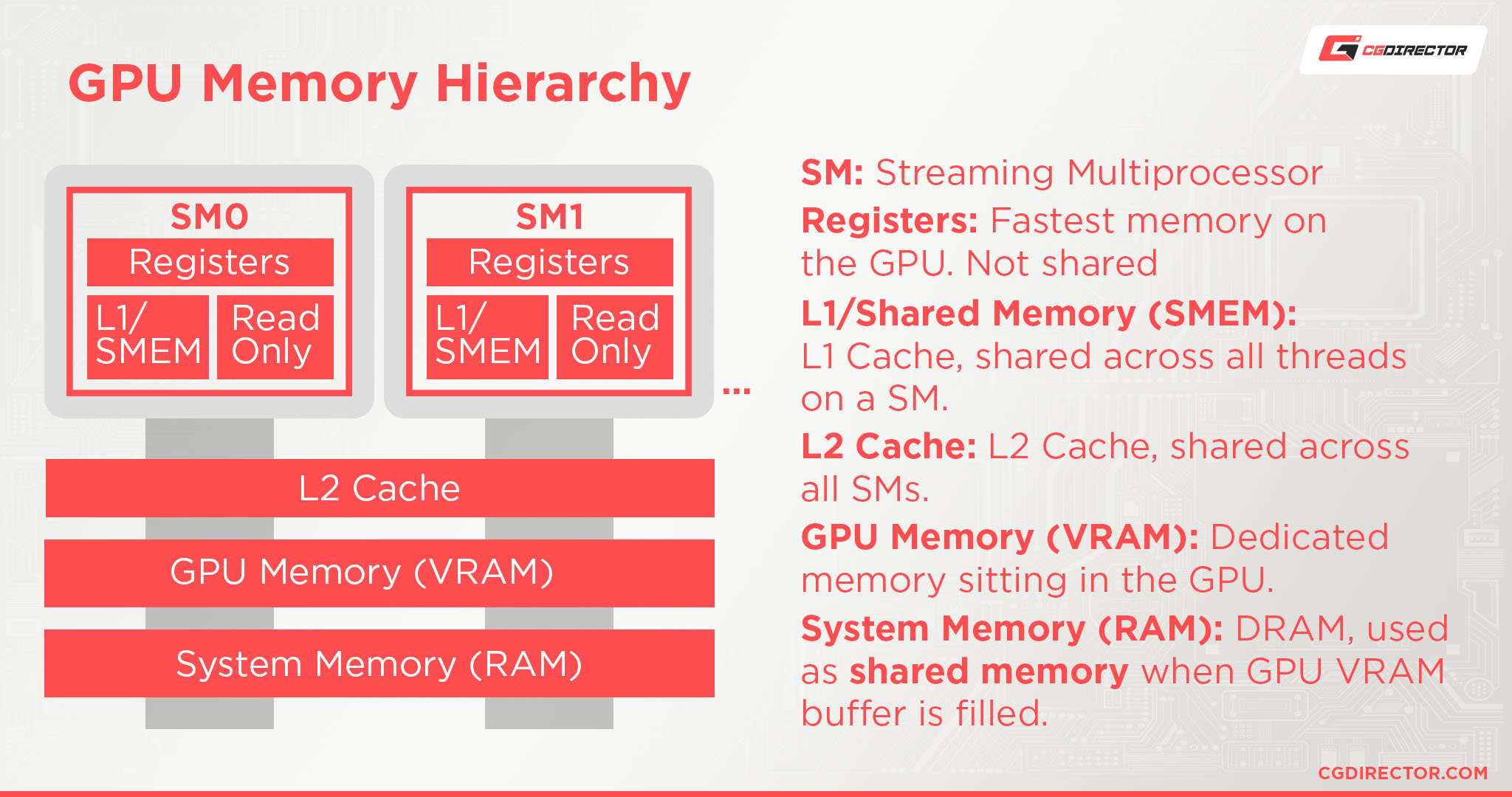

SECHI escribió:Como te consume mas que los 16gb de vram de tu tarjeta? Tira de memoria virtual de un ssd?

SECHI escribió:PSX22 escribió:@the_aeon

Indiana jones me usa 20GB vram al maximo 4K DLAA FG ON y PT pleno

Comprobado ayer

24gb seria lo minimo

El que quiera entender que entienda

Como te consume mas que los 16gb de vram de tu tarjeta? Tira de memoria virtual de un ssd?

the_aeon escribió:https://elchapuzasinformatico.com/2024/12/nvidia-rtx-5080-rendimiento-version-24-gb-384-bits/

5080 un 10% superior a la 4080?? En serio?

Larga vida a mi 4090

the_aeon escribió:https://elchapuzasinformatico.com/2024/12/nvidia-rtx-5080-rendimiento-version-24-gb-384-bits/

5080 un 10% superior a la 4080?? En serio?

Larga vida a mi 4090

the_aeon escribió:https://elchapuzasinformatico.com/2024/12/nvidia-rtx-5080-rendimiento-version-24-gb-384-bits/

5080 un 10% superior a la 4080?? En serio?

Larga vida a mi 4090

![llorica [mamaaaaa]](/images/smilies/nuevos/triste_ani4.gif)

PSX22 escribió:@SECHI

Pues ira perfecta si usas 1440p dlss calidad sin PT y texturas en medio y ajustes en medio

En caso extremo usa low

SECHI escribió:the_aeon escribió:https://elchapuzasinformatico.com/2024/12/nvidia-rtx-5080-rendimiento-version-24-gb-384-bits/

5080 un 10% superior a la 4080?? En serio?

Larga vida a mi 4090

Si pero un 40% mas de potencia en RT y a 1000$ la founder (1200€ en españa con impuestos y cambio de moneda).

No se, no se, habra que verla en movimiento con bench fiables y que se confirmen estos precios.

@PSX22 @654321

Gracias por las aclaraciones. Pues ya me fijare a ver que me hace mi 3080 con mis tristes 10gb de vram

![Adorando [tadoramo]](/images/smilies/adora.gif)

![adios [bye]](/images/smilies/nuevos2/adio.gif)

PSX22 escribió:@SECHI

Loseless te puede salvar mucho y las texturas en medio no ven casi nada peor que ultra, cambia el volumen de las residentes en memoria, pase de supremo a low y la mesa no se veia pixelada, sino igual

olbhap escribió:Quizá con RAM DDR5 es suficientemente rápida como para no necesitar más de 16GB VRAM?

Es que, algo no me cuadra si finalmente la 5080 la presentan con solo 16GB VRAM

Rvilla87 escribió:...NO vas a ponerlo a ultra sino medio o alto y por lo tanto no te vas a quedar corto de VRAM. Por lo tanto el problema no es que la gráfica en cuestión esté corta de VRAM sino que el usuario no la sabe usar.

![por aquí! [poraki]](/images/smilies/nuevos/dedos.gif)

Valhan escribió:Rvilla87 escribió:...NO vas a ponerlo a ultra sino medio o alto y por lo tanto no te vas a quedar corto de VRAM. Por lo tanto el problema no es que la gráfica en cuestión esté corta de VRAM sino que el usuario no la sabe usar.

Gastarte 1400€ en una gráfica recien sacada al mercado y tener que bajar resolución y poner gráficos en medio porque sino se ahoga es absurdo.

Señor Rvilla, a riesgo de que jamás me venda su TV, debo admitir que se merece un baneo de como mínimo tres meses.

PSX22 escribió:@bigsefirot

No es mejor una FE ( founders que una rog strix 4090) eso te han mentido si te lo han dicho. Lo que pasa es que si quieres la opcion mas barata sin suelen ser de salida las founders.

Lo que si esta claro es que si quieres ir a futuro bien servido, no te compres una 5080 de 16gb, porque con esa memoria si vas a 4K y path tracing YA las esta pasando canutas la 4080 . Y dejarse 1500 papeles para que dia 1 ya haya juegos que no podras poner a su tope con DLSS3 FG + Path tracing PT pues como que no.

He puesto las siglas con letras por ayudar, pero de normal nunca pongo nada que no sea DLSS Q o Balanced, FG ON VRR PT on 4K , pero asi ayuda esta vez

PSX22 escribió:@hh1

Pues esque 1200 seria la low cost FE

Cuanto van a valer las demas?? Si fuera 1100 lo aceptaria pero que no, chino juan no tiene competencia

PSX22 escribió:@Valhan

No le hagas caso esta bajo de conocimientos ya que esta centrado en las quest3 que se ha comprado xd

La 5080 es para 4K. Y puedo confirmarte que ya hay juegos de este año que en 4K ultra y path consumen 16GB y mas, seria craso error la

5080 de 16, pero la de 24 si seria future proof

@PepeC12 si pero la ps5 no te mueve wu kong a 60 ni 120 estables, no hablo de graficos sino fluidez y eso di te afecta a la jugabilidad

Valhan escribió:Rvilla87 escribió:...NO vas a ponerlo a ultra sino medio o alto y por lo tanto no te vas a quedar corto de VRAM. Por lo tanto el problema no es que la gráfica en cuestión esté corta de VRAM sino que el usuario no la sabe usar.

Gastarte 1400€ en una gráfica recien sacada al mercado y tener que bajar resolución y poner gráficos en medio porque sino se ahoga es absurdo.

Señor Rvilla, a riesgo de que jamás me venda su TV, debo admitir que se merece un baneo de como mínimo tres meses.

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

PepeC12 escribió:PSX22 escribió:@Valhan

No le hagas caso esta bajo de conocimientos ya que esta centrado en las quest3 que se ha comprado xd

La 5080 es para 4K. Y puedo confirmarte que ya hay juegos de este año que en 4K ultra y path consumen 16GB y mas, seria craso error la

5080 de 16, pero la de 24 si seria future proof

@PepeC12 si pero la ps5 no te mueve wu kong a 60 ni 120 estables, no hablo de graficos sino fluidez y eso di te afecta a la jugabilidad

Ya bueno, tu hablas de jugar con FG que es como tener la mitad de fps a nivel de input lag.

Al final tú pones brillibrilli aumentando la latencia y fastidiando la jugabilidad y los de PS5 bajan la calidad y la resolución.

Para mi es parecido.

![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

PSX22 escribió:PepeC12 escribió:PSX22 escribió:@Valhan

No le hagas caso esta bajo de conocimientos ya que esta centrado en las quest3 que se ha comprado xd

La 5080 es para 4K. Y puedo confirmarte que ya hay juegos de este año que en 4K ultra y path consumen 16GB y mas, seria craso error la

5080 de 16, pero la de 24 si seria future proof

@PepeC12 si pero la ps5 no te mueve wu kong a 60 ni 120 estables, no hablo de graficos sino fluidez y eso di te afecta a la jugabilidad

Ya bueno, tu hablas de jugar con FG que es como tener la mitad de fps a nivel de input lag.

Al final tú pones brillibrilli aumentando la latencia y fastidiando la jugabilidad y los de PS5 bajan la calidad y la resolución.

Para mi es parecido.

Y como te crees que se juega en PS5? hay generacion de frames para alcanzar 60, y creeme que ese generador es mucho peor que DLSS3 FG con reflex, para empezar cuando llegas a 120 con FG partes de 60, lo que partes de input lag por frame de 16ms y no 33ms partiendo de 30. El nivel de artefactos y latencia no es la misma liga. Ademas yo no he dicho que sea con FG los 120, nada impide poner 1440p low sin PT en wu kong PC y alcanzas 120 fps sin FG sin ningun problema, y mas con las CPU de eol, que son en plan 7800x3d , no es parecido en PC Puedes ponerte si quieres una latencia de 4ms y 240fps en fornite, pones todo low 1080p y ya lo tienes hasta con GPUs no tan punteras. En pc se puede, en consola es lo que te dan, no , no es lo mismo. En PC puedes decidir jugar a 30 FPS 8K, y no, no es lo mismo 8K 30 nativos que 1080p 30 fps en hellblande 2 no, aunque el input lag sea parecido, no , no es lo mismo.

@hh1

pero por favor zotac o KFA2 eso la gente huye como de la peste xd La gente si ve una buena oferta mira antes una Asus , MSI, gygabyte, no es todo KFA2 o ROG strix, hay terminos medios, luego que si los conectores se queman xd

Supongo que se te ha caido un litro de aceite en el teclado porque las tildes milagrosamente estan , pero lo de invetar GPU's que no existen, tienes un don no? que si la 4089 o la 6080 xd me tomo con humor

PSX22 escribió:@hh1

claro que hay ONY y PNY tambien xd. Pero "por lo que sea eh " cuando PCC pone la 4070 super a 599 estando a 650 son las primeras en agotarse, y cuando no queda nada de nada ( como ahora mismo) es cuando las zotac y KFA2 se venden mas, y no no, no se rompen mas, simplemente algo con peor materiales o peor construccion, no tiene porque romperse mas una PNY que una AORUS o AERO, simplemente a mismo precio la gente prefiere la estetica o los materiales, por eso en ofertas vuelan, si no hay , lo normal es que vendan mas. El caso no me lies, las 5080 no creo que salgan en 1200, que van a salir mas baratas que las 4080 en su dia en 2022?

huuumf hummf ya puedo olerlas! estamos a dias del chino juan se suba a escenario veguero

Zeratulastur escribió:NVIDIA está machacando a Intel y AMD en ventas de GPU: tiene el 90% de la cuota mundial, la más alta de su historia

https://elchapuzasinformatico.com/?p=580470

Valhan escribió:Me sorprende más el porcentaje de posts de @PSX22 en el hilo. Lo de nVidia ni me impresiona, pero que cada vez que alguien diga algo, la siguiente respuesta en el hilo sea del compañero, es algo que no se valora.

Aún estaríamos en la primera página si no fuera por su labor. Da igual a la hora que entres, que nunca estarás solo.

Tengo la rueda del ratón que ha perdido hasta el dibujo.