Tecmok escribió:kikomanco escribió:Cullen escribió:No se si lo indicasteis ya pero acabo de entrar en la web de nvidia y las 2080ti founders están agotadas.

De momento para ellos todas, no pago más de 900€ por una gama premiun, ni siquiera una founder, por una founder cómo mucho 750€ y por una premium 850€ cómo me valió la actual 1080ti que me compré de salida

a que te refieres con premium? perdona mi ignorancia

Tecmok escribió:kikomanco escribió:Cullen escribió:No se si lo indicasteis ya pero acabo de entrar en la web de nvidia y las 2080ti founders están agotadas.

De momento para ellos todas, no pago más de 900€ por una gama premiun, ni siquiera una founder, por una founder cómo mucho 750€ y por una premium 850€ cómo me valió la actual 1080ti que me compré de salida

a que te refieres con premium? perdona mi ignorancia

kikomanco escribió:terriblePICHON escribió:kikomanco escribió:El oc en Pascal es nulo, yo me compré la aorus 1080ti y solo le pude subir 50 MHz en el core y 400 en memorias, de cómo venía de serie, (que ya viene con oc aplicado) la tengo por curva, que es donde más estable es el oc, por que por barra de MHz cada salto de temperatura va disminuyendo la velocidad del core, en Pascal la temperatura influye mucho el el Boost 2.0 con la que funciona la gráfica

Si lo haces por curva no te baja los MHz a razón de la temperatura?

Porque yo desde el primer día cuando supera los 53 grados me baja 13 MHz, luego a los 57 otra bajada y la última a los 62, que es lo máximo que la he visto subir de temperatura... Al final se queda estable en 2050 si está por debajo de los 61 grados y sino a 2037....

Lo raro que si pasó un 3dmark con los ventiladores a tope y no me pasa de 52 grados me mantiene los 2076 sin problema , con las memos a 6000...

Si te baja, pero menos y es más estable, pero aún así tu gráfica ha salido muy muy buena, que te mantenga 2050 en el core y 6000 en memorias es una pata negra, yo la tengo por curva y aplicado undervolt, la tengo a 0.980v y 1976 MHz, y es raro ver que alcance los 60 grados con curva 1:1 a que voltaje la tienes tú?

@stealwilliams hombre, tiene que ser más silenciosa que el modelo turbina, pero no creo que sea más silenciosa que los modelos custom de la serie Pascal por que el TDP de las turing es más elevado, eso es lo que quise decir en mi anterior Post

terriblePICHON escribió:@kikomanco

Con undervolt a 1.000 se mantiene en 2012 con las memos a 5600 sino se cuelga,

Y en estado normal digamos a 1.050 no toco el voltaje...y yo pensando que me salió lenta... La 1070 me hacía los 2150 sin despeinarse, ya se que no son la misma pero me parecía poco para una TI.

![Adorando [tadoramo]](/images/smilies/adora.gif)

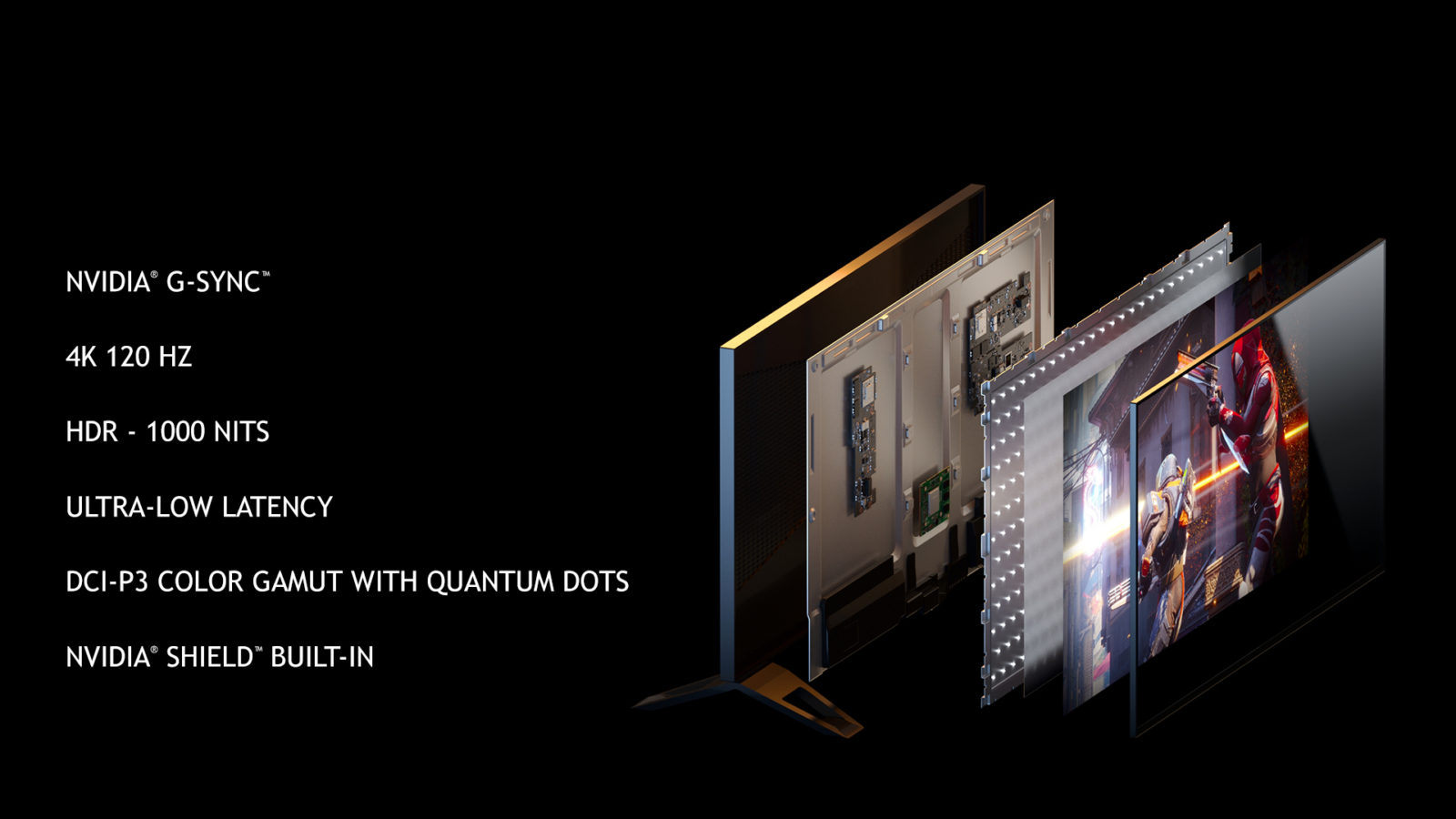

frikidaguel escribió:Yo prefiero monitor de 27" antes que esos monstruos, menudos mareos pillaria jugando a shooters, sobre el precio no me extraña, grandes diagonales, 4k, gsync y a 120 hz, supongo que con hdr, es hasta normal ese precio, normal comparandolo con el asus 4k 144hz de 2600 euros, me refiero. Como dice alguien por ahi, ojala pronto salga todo eso en oled y tengamos negros de verdad, la imagen y el color mejoraria mucho en los juegos. Se que iba a salir un monitor oled pero sin gsync y a 60 hz, no se si al final salió o lo cancelaron, quizas hay problemas de quemados, aunque a mi no me importaria tener que hacer sesiones cortas o quitar los marcadores estaticos en juegos, con tal de tener un monitor oled 4k gsync 120 hz hdr, mi sueño humedo!

, pero repito no es personal, es sólo un consejo y que antes de escribir leas y pienses las cosas(lo digo por tachar a los que poseen una 1080ti, que tienen hard obsoleto y no sirve de nada), aquí somos muchísimos que estamos metidos en esto mas de 20 años y sabemos que rinde X y que vale Y y si X + Y está equilibrado para lo que ofrece

, pero repito no es personal, es sólo un consejo y que antes de escribir leas y pienses las cosas(lo digo por tachar a los que poseen una 1080ti, que tienen hard obsoleto y no sirve de nada), aquí somos muchísimos que estamos metidos en esto mas de 20 años y sabemos que rinde X y que vale Y y si X + Y está equilibrado para lo que ofrece![Ok! [oki]](/images/smilies/net_thumbsup.gif)

Stealwilliam escribió:En la conferencia se dijo que la Founders, con el máximo OC, sonaba una quinta parte de lo que sonaba una 1080Ti (se entiende, por el contexto, que también con el OC a tope). A falta de comprobarlo, es lo único confirmado hasta ahora.

Lo mejor es que a algunos os dicen que una persona que estuvo presente ha dicho que no sonaban apenas y salís a decir que eso es imposible y a montaros la película en base a nada, porque ni habéis estado allí ni parece que hayáis escuchado lo que se dijo en la conferencia.

kikomanco escribió:frikidaguel escribió:Yo prefiero monitor de 27" antes que esos monstruos, menudos mareos pillaria jugando a shooters, sobre el precio no me extraña, grandes diagonales, 4k, gsync y a 120 hz, supongo que con hdr, es hasta normal ese precio, normal comparandolo con el asus 4k 144hz de 2600 euros, me refiero. Como dice alguien por ahi, ojala pronto salga todo eso en oled y tengamos negros de verdad, la imagen y el color mejoraria mucho en los juegos. Se que iba a salir un monitor oled pero sin gsync y a 60 hz, no se si al final salió o lo cancelaron, quizas hay problemas de quemados, aunque a mi no me importaria tener que hacer sesiones cortas o quitar los marcadores estaticos en juegos, con tal de tener un monitor oled 4k gsync 120 hz hdr, mi sueño humedo!

yo juego en una oled 4k (mi firma) y tranquilo no se queman, ya tienen proteccion dentro del panel para que la imagen estatica no lo sea (internamente) hace como una especie de barrido, asi que tranquilo por eso, y si juego a shoter en ella y es una pasada, no me quiero imaginar como debde ser en un buen monitor oled gaming

KnightSparda escribió:Yo tengo una duda de como funcionará el DLSS, tendremos que seleccionar 1080p en la resolución de renderizado del juego y luego activar el DLSS para tener la misma definición de por ejemplo un 4k, o simplemente dejamos la resolución del monitor nativa por defecto, y al activar el DLSS ya se encarga directamente el sistema de renderizar en 1080p y luego reescalarlo a 4k para que funcione como si fuese un 4k pero con menor consumo?

![facepalm [facepalm]](/images/smilies/facepalm.gif)

KnightSparda escribió:Soy consciente de ello, pero entonces como funcionará, tendremos que seleccionar nosotros una resolución más baja y luego activar el dlss? O será como una opción de resolución de renderizado tipo slider?

adriano_99 escribió:KnightSparda escribió:Soy consciente de ello, pero entonces como funcionará, tendremos que seleccionar nosotros una resolución más baja y luego activar el dlss? O será como una opción de resolución de renderizado tipo slider?

No me estas entendiendo.

Ya existen opciones de AA que hacen super sampling eh?

Esto lo que hace es un super sampling con mejor calidad visual y con cero perdida de rendimiento porque lo hacen los tensor cores.

Pero no deja de ser una opción de AA totalmente independiente a la resolución del juego.

Prototiper escribió:adriano_99 escribió:KnightSparda escribió:Soy consciente de ello, pero entonces como funcionará, tendremos que seleccionar nosotros una resolución más baja y luego activar el dlss? O será como una opción de resolución de renderizado tipo slider?

No me estas entendiendo.

Ya existen opciones de AA que hacen super sampling eh?

Esto lo que hace es un super sampling con mejor calidad visual y con cero perdida de rendimiento porque lo hacen los tensor cores.

Pero no deja de ser una opción de AA totalmente independiente a la resolución del juego.

Suena demasiado bien.

kikomanco escribió:a ver cuando os enterais que a 4k el Antialias no es necesario, madre mia que manera de vender la moto estos de Nvidia

KnightSparda escribió:O sea que la idea es seleccionar 1080p de resolución y activar este AA para que la calidad quede cercana al 4k, no?

KnightSparda escribió:O sea que la idea es seleccionar 1080p de resolución y activar este AA para que la calidad quede cercana al 4k, no?

Xlooser escribió:Eso es lo que yo entiendo como super-resolución; que reconstruye una imagen de baja resolución en una de alta resolución. En este caso, 1080p a 4K, me gustaría ver el resultado, confío en que la calidad sea muy buena.

@mondillo el precio es alto debido a una suma de factores: el chip es grande, los Tensor Cores son caros también, y sobre todo, Nvidia domina el mercado.

adriano_99 escribió:KnightSparda escribió:O sea que la idea es seleccionar 1080p de resolución y activar este AA para que la calidad quede cercana al 4k, no?Xlooser escribió:Eso es lo que yo entiendo como super-resolución; que reconstruye una imagen de baja resolución en una de alta resolución. En este caso, 1080p a 4K, me gustaría ver el resultado, confío en que la calidad sea muy buena.

@mondillo el precio es alto debido a una suma de factores: el chip es grande, los Tensor Cores son caros también, y sobre todo, Nvidia domina el mercado.

Que noooooooooo.

https://www.softzone.es/2016/08/26/anti ... aa-y-msaa/

Lo que hace ya existe en varios métodos y todos son antialiasing que no tienen nada pero nada nada que ver con tu resolucion.

Esto aplica ese mismo antialiasing por supersampling utilizando los tensor cores en vez de los cuda cores por lo que no se pierde rendimiento.

Lo que hará es lo que ha hecho siempre el AA y es que si tu imagen por lo que sea tiene dientes de sierra los va a eliminar.

Pero si seleccionas 1080p vas a ver todo a 1080p y con calidad de 1080p

Pero sin dientes de sierra.

Xlooser escribió:adriano_99 escribió:KnightSparda escribió:O sea que la idea es seleccionar 1080p de resolución y activar este AA para que la calidad quede cercana al 4k, no?Xlooser escribió:Eso es lo que yo entiendo como super-resolución; que reconstruye una imagen de baja resolución en una de alta resolución. En este caso, 1080p a 4K, me gustaría ver el resultado, confío en que la calidad sea muy buena.

@mondillo el precio es alto debido a una suma de factores: el chip es grande, los Tensor Cores son caros también, y sobre todo, Nvidia domina el mercado.

Que noooooooooo.

https://www.softzone.es/2016/08/26/anti ... aa-y-msaa/

Lo que hace ya existe en varios métodos y todos son antialiasing que no tienen nada pero nada nada que ver con tu resolucion.

Esto aplica ese mismo antialiasing por supersampling utilizando los tensor cores en vez de los cuda cores por lo que no se pierde rendimiento.

Lo que hará es lo que ha hecho siempre el AA y es que si tu imagen por lo que sea tiene dientes de sierra los va a eliminar.

Pero si seleccionas 1080p vas a ver todo a 1080p y con calidad de 1080p

Pero sin dientes de sierra.

¿Entonces por qué Nvidia habla de super-resolución si la super-resolución no está implementada?

adriano_99 escribió:Xlooser escribió:adriano_99 escribió:

Que noooooooooo.

https://www.softzone.es/2016/08/26/anti ... aa-y-msaa/

Lo que hace ya existe en varios métodos y todos son antialiasing que no tienen nada pero nada nada que ver con tu resolucion.

Esto aplica ese mismo antialiasing por supersampling utilizando los tensor cores en vez de los cuda cores por lo que no se pierde rendimiento.

Lo que hará es lo que ha hecho siempre el AA y es que si tu imagen por lo que sea tiene dientes de sierra los va a eliminar.

Pero si seleccionas 1080p vas a ver todo a 1080p y con calidad de 1080p

Pero sin dientes de sierra.

¿Entonces por qué Nvidia habla de super-resolución si la super-resolución no está implementada?

Porque es lo que se utiliza para cargarse los dientes de sierra e imperfecciones pero eso no es nada nuevo, el super sampling lleva años utilizándose.

Lo que ha hecho Nvidia ahora es que el rendimiento no se vaya a la puta cuando lo usas.

KnightSparda escribió:Efectivamente, lo que se lleva leyendo todos estos días es que el sistema nuevo es una especie de reescalado o checkerboard como hacen las consolas, básicamente el PC renderiza a 1080p y luego el AA añade definición, es más, la imagen ésta que lleva todo el dia rodando, demuestra que la misma imagen en 1080p con el DLSS para simular el 8k da un resultado espectacular, por lo que yo he entendido es así como funciona, si no no sería revolucionario ni tendría sentido, que sentido tiene un método de AA que por muy poco que chupe lo tengas que activar en 4k, si en 4k el rendimiento ya va a ser malo.

De ahí que nvidia use las gráficas ya expuestas comparando las pascal en 4k y las turing con DLSS, ellos consideran el 1080p reescalado a 4k con DLSS como 4k, de ahí que el rendimiento se doble.

EDITO, añado la imagen.

KnightSparda escribió:Me respondo a mi mismo, con este post de reddit explicandolo, básicamente es lo que yo he dicho, la gente que tenga monitores o TVs 4k, van a seleccionar activar el DLSS y lo que hará la gráfica en el juego será renderizar a 1080p y reescalar a 4k la imagen, de manera que a efectos del ojo tu vas a ver la imagen completada con la AI como si fuese 4k aun que tu gráfica sólo este renderizando a 1080p y reescalandola.

Como dice el chaval del post, no es un método de AA, si no que es un reescalado en toda regla, algo similar a lo que hacen las consolas nuevas, pero de manera más eficiente en temas de potencia, y con resultados superiores en términos de calidad.

Ésta tecnologia es una puta pasada, y es la clave para que se pueda combinar con el rayotracing para poder jugar a 4k reescalados y 60 fps.

Aquí el enlace en cuestión de la explicación:

https://www.reddit.com/r/nvidia/comment ... i/e4r3lj6/

adriano_99 escribió:KnightSparda escribió:Me respondo a mi mismo, con este post de reddit explicandolo, básicamente es lo que yo he dicho, la gente que tenga monitores o TVs 4k, van a seleccionar activar el DLSS y lo que hará la gráfica en el juego será renderizar a 1080p y reescalar a 4k la imagen, de manera que a efectos del ojo tu vas a ver la imagen completada con la AI como si fuese 4k aun que tu gráfica sólo este renderizando a 1080p y reescalandola.

Como dice el chaval del post, no es un método de AA, si no que es un reescalado en toda regla, algo similar a lo que hacen las consolas nuevas, pero de manera más eficiente en temas de potencia, y con resultados superiores en términos de calidad.

Ésta tecnologia es una puta pasada, y es la clave para que se pueda combinar con el rayotracing para poder jugar a 4k reescalados y 60 fps.

Aquí el enlace en cuestión de la explicación:

https://www.reddit.com/r/nvidia/comment ... i/e4r3lj6/

Pues a mi me parece una absoluta perdida de tiempo para intentar contentar a todos los que no paraban de llorar porque iban a tener que bajar la resolución.

Da igual lo que digan un reescalado por mucha IA que haya nunca va a ser tan bueno como una resolución nativa.

Y si me equivoco porque reescalar desde 1080p? Porque no desde 720p? 480p?

Me parece un lavado de cara hasta que se pueda con el ray tracing a 4k.

KnightSparda escribió:Pues no es lo que yo he estado leyendo este par de días, al parecer toda la gente que ha podido ver el DLSS en acción dicen que es una maldita locura, y teniendo un monitor 4k al lado para comparar dicen que la imagen era literalmente igual, que era imposible diferenciar, vamos no se tu pero si ahora se centran en usar potencia para mejorar los juegos en complejidad gráfica ya que el tema rendimiento va a quedar solucionado con la AI para emular de manera brutal una resolución mayor, para mi es la panacea a ésta guerra absurda de resoluciones y framerates, se queda todo solucionado.

Es más, me atrevo a decir que ésto ya esta pasando, las consolas precisamente es lo que han hecho, han conseguido mejorar en sobremanera su complejidad gráfica hasta puntos que con su baja potencia eran impensables gracias a que precisamente el tema de la resolución ha quedado paliado por los chekerboards.

El único tema que queda en el aire, es ver hasta que punto los juegos que vayan saliendo soporten éste sistema que requiere de el apoyo de nvidia para poder sacar su jugo.

adriano_99 escribió:KnightSparda escribió:Pues no es lo que yo he estado leyendo este par de días, al parecer toda la gente que ha podido ver el DLSS en acción dicen que es una maldita locura, y teniendo un monitor 4k al lado para comparar dicen que la imagen era literalmente igual, que era imposible diferenciar, vamos no se tu pero si ahora se centran en usar potencia para mejorar los juegos en complejidad gráfica ya que el tema rendimiento va a quedar solucionado con la AI para emular de manera brutal una resolución mayor, para mi es la panacea a ésta guerra absurda de resoluciones y framerates, se queda todo solucionado.

Es más, me atrevo a decir que ésto ya esta pasando, las consolas precisamente es lo que han hecho, han conseguido mejorar en sobremanera su complejidad gráfica hasta puntos que con su baja potencia eran impensables gracias a que precisamente el tema de la resolución ha quedado paliado por los chekerboards.

El único tema que queda en el aire, es ver hasta que punto los juegos que vayan saliendo soporten éste sistema que requiere de el apoyo de nvidia para poder sacar su jugo.

Lo que hacen las consolas me parece una verdadera chapuza para simular que tienen mas potencia y engañar a la gente y por mas que esto sea mejor no me parece muy distintos.

Y vuelvo a decir, si de verdad no notas nada la diferencia, porque pararse en el 1080p?

Porque no reducir todavía mas la resolucion original?

720p tampoco debería de notarse casi nada y 480 p igual se nota un poco pero tendriamos """"""""""4k"""""""""" a 200 o 300 fps.

No me lo creo, y ver que nos llega la guarrada de las consolas me hierve la sangre.