blade133bo escribió:Saltador_Ne0 escribió:

Impresionante.

Si lo es, ¿que no podia enviar imagenes a color?

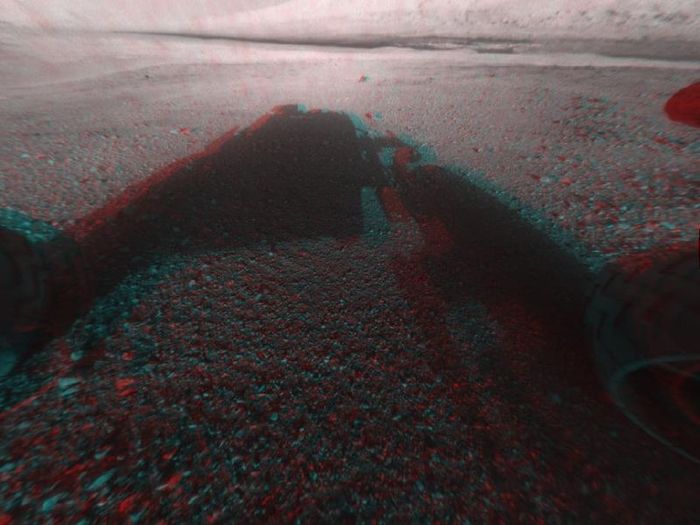

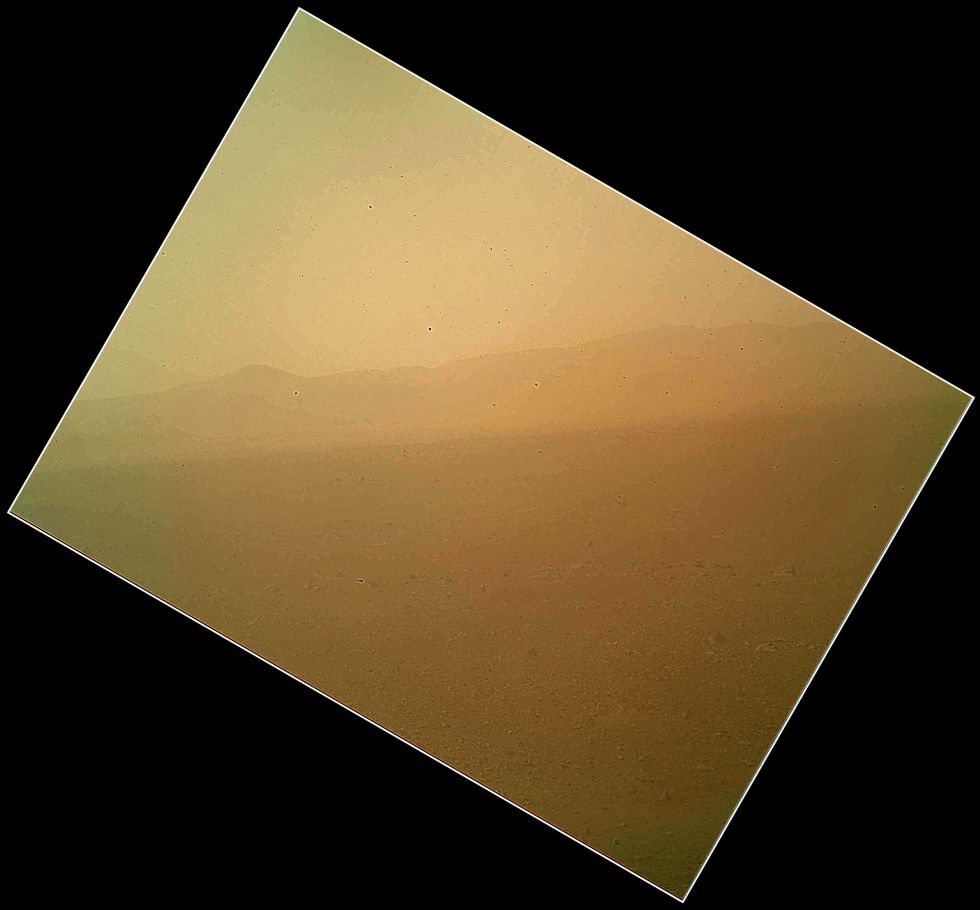

Por lo visto si se puede.

Perfect Ardamax escribió:KoX escribió:SkaL escribió:

Sobre lo de chocar asteroides y para el nucleo de la tierra durante millones de años... ¿No podria ser eso lo que le ocurre a martes y que tarde o temprano se volvera a activar?

Según vi yo en el documental sobre Marte, está deformado, lo que podria ser que le afecte al núcleo y jamás pueda de nuevo "ponerse en marcha". Esta deformación le pudo ser causada por el impacto con un obejeto grande posiblemente en el proceso de "creación de una luna"

Las lunas de marte son simples asteroides de cinturon de asteroides que han sido capturados por la gravedad marciana.

Ademas el nucleo de marte no esta deformado lo que tu estas diciendo es la dicotomía marciana (diferencia notable entre un hemisferio y el otro) El hemisferio sur (izquierda) es elevado mientras que el norte (derecha) es casi llano he incluso esta hundido.

Esto se piensa que fue causado por el impacto de un enorma objeto (de hecho todo el hemisferio norte se piensa que es asi devido a que es "una gigantesca cuenca de impacto")

Saludos

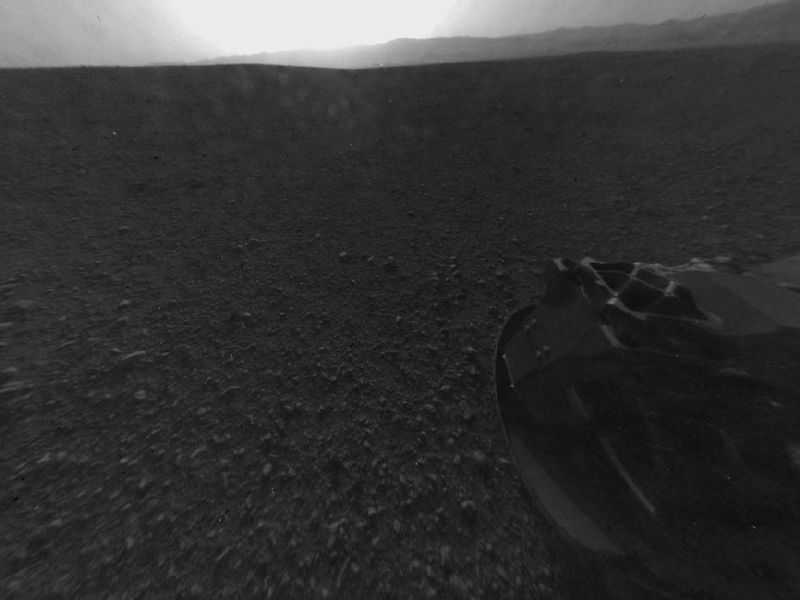

HispaCoder escribió:Buenos días, ya hay imágenes a color del curiosity, eso sí se ve mal porque por lo visto el filtro protector de la camara tiene mucha mierda en polvo quemado por el descenso, imagino que esos protectores podran retirarse para dejar el objetivo impoluto.

HispaCoder escribió:Buenos días, ya hay imágenes a color del curiosity, eso sí se ve mal porque por lo visto el filtro protector de la camara tiene mucha mierda en polvo quemado por el descenso, imagino que esos protectores podran retirarse para dejar el objetivo impoluto.

Moraydron escribió:Por cierto,es off-topic pero como creo que hay mucho fan del espacio en el hilo,os recomiendo el reportaje de 4º milenio de "sonidos del espacio" imagino que estara en youtube,no es nada esoterico ni ocultista,todo lo contrario son sonidos registrados por distintas sondas de la nasa.

Un saludo.

vik_sgc escribió:SoteBcn escribió:

Philip J Fry escribió:vik_sgc escribió:SoteBcn escribió:

Lo que te comentaba es que si tienes que mandar un valor-numero para tener una foto en blanco y negro, pues manda el otro valor-numero( lo que te he comentado de las restas) , que a efectos de ancho de banda es lo mismo, y consigues gracias a la ingeniería y las matemáticas una imagen en color sin aumentar el ancho de banda, no es magia., estamos hablando de que el coste es cero , es como renunciar a la información de color sin motivo . Lo de el cambio de la tele en B/N a color, es un ben ejemplo, en el otro hilo lo tienes...

Si quieres saber algo de modulaciones pregúntale a google y dedícale tiempo, esto no te lo digo a malas, pero tienes que tener una base teórica y el tema es espeso.

PD: He dicho varias veces en el otro hilo que yo no le encuentro explicación, que no significa que no la haya. Pero hasta que alguien me lo explique solo me queda la censura, pero bien explicado, no diciendo cosas al tuntun sabiendo un poco por encima del tema.

Philip J Fry escribió:vik_sgc escribió:SoteBcn escribió:

Lo que te comentaba es que si tienes que mandar un valor-numero para tener una foto en blanco y negro, pues manda el otro valor-numero( lo que te he comentado de las restas) , que a efectos de ancho de banda es lo mismo, y consigues gracias a la ingeniería y las matemáticas una imagen en color sin aumentar el ancho de banda, no es magia., estamos hablando de que el coste es cero , es como renunciar a la información de color sin motivo . Lo de el cambio de la tele en B/N a color, es un ben ejemplo, en el otro hilo lo tienes...

Si quieres saber algo de modulaciones pregúntale a google y dedícale tiempo, esto no te lo digo a malas, pero tienes que tener una base teórica y el tema es espeso.

PD: He dicho varias veces en el otro hilo que yo no le encuentro explicación, que no significa que no la haya. Pero hasta que alguien me lo explique solo me queda la censura, pero bien explicado, no diciendo cosas al tuntun sabiendo un poco por encima del tema.

Philip J Fry escribió:No, digo que mandas un solo numero,

Si buscas en Internet lo encontraras, que de verdad que no me lo invento. Lo puedes encontrar buscando fundamentos de la televisión y leyendo bastante.

Tu mandas (R-Y) por pixel o en toda la linea, y en la linea o pixel siguiente (B-Y),sigue siendo un solo valor por pixel o linea, recuerda, un solo valor, con esto tienes tres valores de la ecuación que tiene cuatro incógnitas, osea que lo tienes todo. Aun asi, nuestro cerebro no necesita toda la info de color, de ahí el tema de los muestreos en digital 2:2:2, 4:2:2 etc, nuestros ojos y el cerebro hacen la integración y lo percibimos "bien".

Acabo de recordar dándole vueltas, que se mandaba el producto (R-Y)(B-Y), un solo valor, que si se descompone tiens tres valores de la ecuación con cuatro incognitas. ¿De esto ultimo no estoy del todo seguro?, pero me parece que si era asi. Aun asi el primer método también funciona.

Solo es necesario mandar un solo valor por pixel o linea, con eso, las matemáticas y nuestro cerebro se consigue el resto, a coste cero!!!

Me remito al mejor ejemplo posible, el cambio de tv en blanco y negro a tv en color se hizo sin aumentar el ancho de banda. Porque no se aplican esos principios??

vik_sgc escribió:Philip J Fry escribió:No, digo que mandas un solo numero,

Si buscas en Internet lo encontraras, que de verdad que no me lo invento. Lo puedes encontrar buscando fundamentos de la televisión y leyendo bastante.

Tu mandas (R-Y) por pixel o en toda la linea, y en la linea o pixel siguiente (B-Y),sigue siendo un solo valor por pixel o linea, recuerda, un solo valor, con esto tienes tres valores de la ecuación que tiene cuatro incógnitas, osea que lo tienes todo. Aun asi, nuestro cerebro no necesita toda la info de color, de ahí el tema de los muestreos en digital 2:2:2, 4:2:2 etc, nuestros ojos y el cerebro hacen la integración y lo percibimos "bien".

Acabo de recordar dándole vueltas, que se mandaba el producto (R-Y)(B-Y), un solo valor, que si se descompone tiens tres valores de la ecuación con cuatro incognitas. ¿De esto ultimo no estoy del todo seguro?, pero me parece que si era asi. Aun asi el primer método también funciona.

Solo es necesario mandar un solo valor por pixel o linea, con eso, las matemáticas y nuestro cerebro se consigue el resto, a coste cero!!!

Me remito al mejor ejemplo posible, el cambio de tv en blanco y negro a tv en color se hizo sin aumentar el ancho de banda. Porque no se aplican esos principios??

Puede que tengas razón, pero necesito mejores explicaciones porque estoy estudiando a la vez cosicas de cuántica y es estar con dos materias bastante espesas y distintas a la vez.

Pero ya te digo que, por lo que estoy viendo, puede que sí tengas razón.

(Seguiré pensando en ello, esto no ha terminado xD).

Philip J Fry escribió:No, digo que mandas un solo numero,

Si buscas en Internet lo encontraras, que de verdad que no me lo invento. Lo puedes encontrar buscando fundamentos de la televisión y leyendo bastante.

Tu mandas (R-Y) por pixel o en toda la linea, y en la linea o pixel siguiente (B-Y),sigue siendo un solo valor por pixel o linea, recuerda, un solo valor, con esto tienes tres valores de la ecuación que tiene cuatro incógnitas, osea que lo tienes todo. Aun asi, nuestro cerebro no necesita toda la info de color, de ahí el tema de los muestreos en digital 2:2:2, 4:2:2 etc, nuestros ojos y el cerebro hacen la integración y lo percibimos "bien".

Acabo de recordar dándole vueltas, que se mandaba el producto (R-Y)(B-Y), un solo valor, que si se descompone tiens tres valores de la ecuación con cuatro incognitas. ¿De esto ultimo no estoy del todo seguro?, pero me parece que si era asi. Aun asi el primer método también funciona.

Solo es necesario mandar un solo valor por pixel o linea, con eso, las matemáticas y nuestro cerebro se consigue el resto, a coste cero!!!

Me remito al mejor ejemplo posible, el cambio de tv en blanco y negro a tv en color se hizo sin aumentar el ancho de banda. Porque no se aplican esos principios??

Realk en el hilo de ovnis esta tarde lo he explicado detalladamente de todas las formas posibles.. Pásate por allí y me dices, que no me apetece escribir todo otra vez.

josemurcia escribió:Philip J Fry escribió:No, digo que mandas un solo numero,

Si buscas en Internet lo encontraras, que de verdad que no me lo invento. Lo puedes encontrar buscando fundamentos de la televisión y leyendo bastante.

Tu mandas (R-Y) por pixel o en toda la linea, y en la linea o pixel siguiente (B-Y),sigue siendo un solo valor por pixel o linea, recuerda, un solo valor, con esto tienes tres valores de la ecuación que tiene cuatro incógnitas, osea que lo tienes todo. Aun asi, nuestro cerebro no necesita toda la info de color, de ahí el tema de los muestreos en digital 2:2:2, 4:2:2 etc, nuestros ojos y el cerebro hacen la integración y lo percibimos "bien".

Acabo de recordar dándole vueltas, que se mandaba el producto (R-Y)(B-Y), un solo valor, que si se descompone tiens tres valores de la ecuación con cuatro incognitas. ¿De esto ultimo no estoy del todo seguro?, pero me parece que si era asi. Aun asi el primer método también funciona.

Solo es necesario mandar un solo valor por pixel o linea, con eso, las matemáticas y nuestro cerebro se consigue el resto, a coste cero!!!

Me remito al mejor ejemplo posible, el cambio de tv en blanco y negro a tv en color se hizo sin aumentar el ancho de banda. Porque no se aplican esos principios??

Realk en el hilo de ovnis esta tarde lo he explicado detalladamente de todas las formas posibles.. Pásate por allí y me dices, que no me apetece escribir todo otra vez.

A ver, la televisión en blanco y negro y a color era analógico, no tiene nada que ver, esto es digital, está mandando una archivo que pesa X, y ese X pesa más a color que en blanco y negro, haz la prueba desaturando una imagen. Te estás liando con cosas que no tienen nada que ver.

vik_sgc escribió:A ver, la televisión en blanco y negro y a color era analógico, no tiene nada que ver, esto es digital, está mandando una archivo que pesa X, y ese X pesa más a color que en blanco y negro, haz la prueba desaturando una imagen. Te estás liando con cosas que no tienen nada que ver.

josemurcia escribió:vik_sgc escribió:

Lo mandan a través de señales analógicas.

Claro que la señal es analógica, pero la información que transmite no.

vik_sgc escribió:Ya, pero durante la transmisión intervienen el modulado y la multiplexación, técnicas para ahorrar ancho de banda. Y por lo que he estado leyendo y lo que ha dicho él no creo que se esté haciendo un lío.

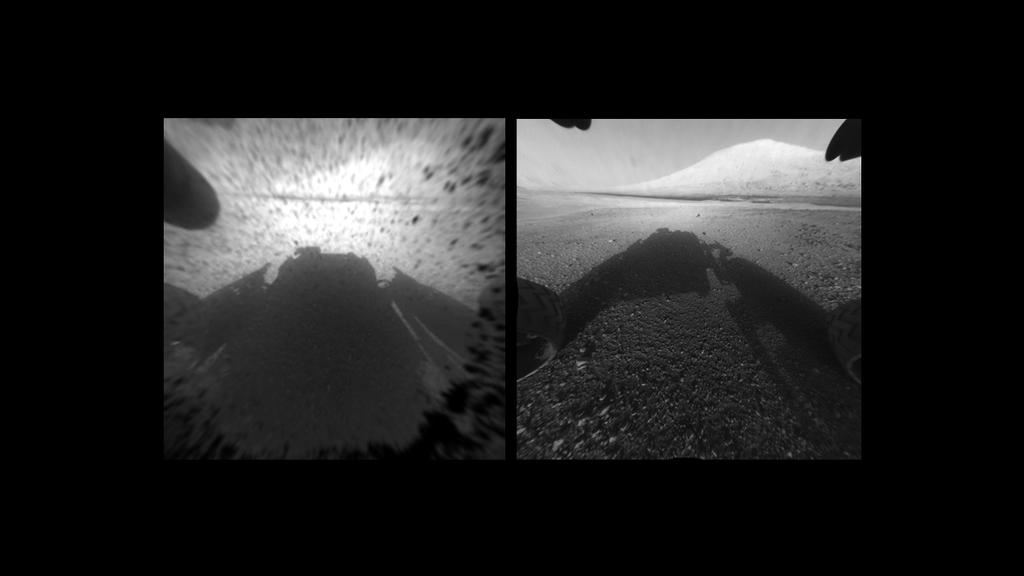

Dracarys escribió:Foto de la sonda MRO localizando el paracaídas y demás:

Philip J Fry escribió:No, digo que mandas un solo numero,

Si buscas en Internet lo encontraras, que de verdad que no me lo invento. Lo puedes encontrar buscando fundamentos de la televisión y leyendo bastante.

Tu mandas (R-Y) por pixel o en toda la linea, y en la linea o pixel siguiente (B-Y),sigue siendo un solo valor por pixel o linea, recuerda, un solo valor, con esto tienes tres valores de la ecuación que tiene cuatro incógnitas, osea que lo tienes todo. Aun asi, nuestro cerebro no necesita toda la info de color, de ahí el tema de los muestreos en digital 2:2:2, 4:2:2 etc, nuestros ojos y el cerebro hacen la integración y lo percibimos "bien".

Acabo de recordar dándole vueltas, que se mandaba el producto (R-Y)(B-Y), un solo valor, que si se descompone tiens tres valores de la ecuación con cuatro incognitas. ¿De esto ultimo no estoy del todo seguro?, pero me parece que si era asi. Aun asi el primer método también funciona.

Solo es necesario mandar un solo valor por pixel o linea, con eso, las matemáticas y nuestro cerebro se consigue el resto, a coste cero!!!

Me remito al mejor ejemplo posible, el cambio de tv en blanco y negro a tv en color se hizo sin aumentar el ancho de banda. Porque no se aplican esos principios??

Realk en el hilo de ovnis esta tarde lo he explicado detalladamente de todas las formas posibles.. Pásate por allí y me dices, que no me apetece escribir todo otra vez.

ReinLOL escribió:Moraydron escribió:Por cierto,es off-topic pero como creo que hay mucho fan del espacio en el hilo,os recomiendo el reportaje de 4º milenio de "sonidos del espacio" imagino que estara en youtube,no es nada esoterico ni ocultista,todo lo contrario son sonidos registrados por distintas sondas de la nasa.

Un saludo.

para aficionados al universo la serie the universe. 7 temporadas, casi 80 capitulos, fullHD,...

recuerdo un capitulo en donde hablaron de los sonidos que emiten los planetas, y como los podias escuchar usando una radio... muy curioso. tambien recuerdo el hexagono del polo de saturno y muchas mas cosas curiosas.

lo dicho muy recomendable para cualquier fan.

el segundo capitulo que emitieron se centraba exclusivamente en marte:

http://www.youtube.com/watch?v=Jlhg3A-cWO4

Philip J Fry escribió:No, digo que mandas un solo numero,

Si buscas en Internet lo encontraras, que de verdad que no me lo invento. Lo puedes encontrar buscando fundamentos de la televisión y leyendo bastante.

Tu mandas (R-Y) por pixel o en toda la linea, y en la linea o pixel siguiente (B-Y),sigue siendo un solo valor por pixel o linea, recuerda, un solo valor, con esto tienes tres valores de la ecuación que tiene cuatro incógnitas, osea que lo tienes todo. Aun asi, nuestro cerebro no necesita toda la info de color, de ahí el tema de los muestreos en digital 2:2:2, 4:2:2 etc, nuestros ojos y el cerebro hacen la integración y lo percibimos "bien".

Acabo de recordar dándole vueltas, que se mandaba el producto (R-Y)(B-Y), un solo valor, que si se descompone tiens tres valores de la ecuación con cuatro incognitas. ¿De esto ultimo no estoy del todo seguro?, pero me parece que si era asi. Aun asi el primer método también funciona.

Solo es necesario mandar un solo valor por pixel o linea, con eso, las matemáticas y nuestro cerebro se consigue el resto, a coste cero!!!

Me remito al mejor ejemplo posible, el cambio de tv en blanco y negro a tv en color se hizo sin aumentar el ancho de banda. Porque no se aplican esos principios??

Realk en el hilo de ovnis esta tarde lo he explicado detalladamente de todas las formas posibles.. Pásate por allí y me dices, que no me apetece escribir todo otra vez.

![burla2 [burla2]](/images/smilies/nuevos/burla_ani1.gif)

)

)Philip J Fry escribió:Jose Murcia:

No es lo mismo tener una imagen en el ordenador y desaturarla, que claro que te va a ocupar menos, pero en tu caso la imagen no la tienes que transmitir, cuando tienes que mandarla la imagen sufre un proceso de codificación para comprimirla y la modulas para mandarla. Esto es otra cosa. Entre TV analogía y digital los fundamentos para mandar señales es el mismo, hoy en deia digitalizas una señal analógica para mandarla y luego la pasas a analógico para representara por pantalla

Realk:

Lo que dices de perder calidad de imagen es correcto, es algo normal cuando tienes un limitado ancho de banda.

Por un lado tienes la Y(luminancia), R,G,B. En cada pixel tienes esos tres LED y la Y indica el valor de luz que tiene que tener cada pixel.

Una imagen RGB máxima calidad tendría un muestreo 4:4:4 se manda toda la información de cada pixel.

La formula de la señal de lumunancia es:

Y=0.299R+0.587G+0.114B

Como G es la que mas ocupa se mandan las diferencias de (R-Y) y (G-Y), que se llamarian U y V, siendo:

(R-Y)+Y=R

(B-Y)+Y=G

Normalmente se manda U y V solo, y con eso se consigue toda la información.

No es que se mande solo la luminancia, o solo las componentes de color. Se digitaliza directamente la resta. Es un numero, lo bueno es lo que se puede sacar de ese numero, en vez de mandar un numero que solo nos diga la luminancia, mandamos otro que nos pueda dar más cosas mejor.

Los CCD de las cámaras captan toda la información, depende de lo que se haga luego con ella.

Hasta el punto que ni siquiera el DVD viene con toda la información. Un muestreo 4:2:2 significa que mandas toda información de luminancia, y la mitad de color (U y V), y un muestreo 4:2:0 manda toda la info de luz y una de color (V o U), este ultimo creo que es el formato MPEG-1

Escribiendo lo anterior le he dado al coco y acabo de ver una cosa, el muestreo así se hace para comprimir y meter todo en un DVD, en tema de transmisión es bueno ya que son menos datos para digitalizar y con lo cual transmitir , pero ¿porque digitalizar valores de Y, pudiendo digitalizar de U o V, o de U y V alternadas y así después sacarlo todo?, esto ultimo lo estoy "pensando en voz alta", aquí me quedo por hoy, tengo la cabeza como un bombo después del coñazo que he soltado, mañana pensare en esto ultimo, si alguien lo ve claro que lo comunique.

Estwald:

Yo también pienso que las fotos son para vender la moto y que lo que los científicos quieren son datos de las sondas.Sobre el tema del color y el B/N arriba puedes leer como lo llevo. Espero respuesta constructiva.

Don pelayo:

Justo con este tema no utilizo el buscador de google, mas bien desempolvo apuntes ya que el tema es espesito(no se si me explico), el caso no es fijarse en quien te lo dice, el caso es leer lo que te dicen, pensar sobre ello y sacar conclusiones, si un loco te dice que 2+2=4 sigue siendo cierto aunque este loco, y no estoy diciendo que este loco. Por cierto me han abducido, me han llevado a marte, he estado delante del Curiosity y mañana por la mañana sale mi culo en primer plano en todos los periodicos...

Elelegido escribió:Dracarys escribió:Foto de la sonda MRO localizando el paracaídas y demás:

Menudo ejemplo, ahí, enguarranando to marte

kulebra escribió:donde se puede seguir los futuros movimientos del MSL Curiosity???? (si puede ser en spanish mejor).

Philip J Fry escribió:Estwald:

Yo también pienso que las fotos son para vender la moto y que lo que los científicos quieren son datos de las sondas.Sobre el tema del color y el B/N arriba puedes leer como lo llevo. Espero respuesta constructiva.

Estwald escribió:Philip J Fry escribió:Estwald:

Yo también pienso que las fotos son para vender la moto y que lo que los científicos quieren son datos de las sondas.Sobre el tema del color y el B/N arriba puedes leer como lo llevo. Espero respuesta constructiva.

La respuesta mejor que te puedo dar es que una imagen RGB de 24 bits convertida en otra YUV de 24 bits no son la misma: la segunda tiene pérdida al aplicar las conversiones (por lógica). El truco práctico del formato es que por ejemplo, lo puedes organizar de forma que si divides la imagen en pequeños mosaicos de 2x2 píxeles, compartirían el valor de crominancia todos ellos para diferentes valores de luminancia (es decir, tendrías que almacenar 2x2 Y + 1 U + 1 V) y en cierta forma, ya tienes un nivel de compresión (por ejemplo, si tienes una imagen RGB de 384x288 píxeles y 8 bits por componente, ocuparía 331776 bytes mientras que usando YUV de esta forma a 8 bits también, ocuparía 165888 bytes. Es un ahorro interesante pero a costa de perder calidad en color y sigue ocupando más que si envías la imagen en B/N)

Esto que describo es típico de JPEG-MPEG que a su vez aplican su sistema de compresión y no vamos a descubrir ahora la diferencia de tamaño de datos entre una imagen RAW y otra en formato JPEG.

¿Que por que no lo usan?. Pues chico, en realidad no tengo ni idea de si lo están usando o no o tienen previsto usarlo: habrá imágenes que tomen en alta resolución que no puedan comprimir por falta de proceso/memoria o que simplemente, no quieran comprimir de esa forma o no les sea prioritario. Tampoco es raro que procesen aquí las imágenes que no tienen por qué venir en condiciones óptimas de origen y lo que está claro es que fotografías de Marte ya tenemos, sigue siendo igual de rojizo y lo que han mandado allí es un laboratorio muy sofisticado que tiene tareas mas importantes que realizar.

Pero está claro que las imágenes se pueden comprimir, evidentemente.

![alien [alien]](/images/smilies/nuevos2/alien.gif)

![fumando [fumando]](/images/smilies/nuevos/fumando.gif)

Philip J Fry escribió:

Una pregunta, si digitalizando U y V puedes sacar las componentes de color y la luminancia con las formulas "tipicas" ¿donde se produce la perdida?¿no se recupera la señal al completo?.(creo que la perdida se pierde en la digitalización).

Philip J Fry escribió:Estwald escribió:Philip J Fry escribió:Estwald:

Yo también pienso que las fotos son para vender la moto y que lo que los científicos quieren son datos de las sondas.Sobre el tema del color y el B/N arriba puedes leer como lo llevo. Espero respuesta constructiva.

La respuesta mejor que te puedo dar es que una imagen RGB de 24 bits convertida en otra YUV de 24 bits no son la misma: la segunda tiene pérdida al aplicar las conversiones (por lógica). El truco práctico del formato es que por ejemplo, lo puedes organizar de forma que si divides la imagen en pequeños mosaicos de 2x2 píxeles, compartirían el valor de crominancia todos ellos para diferentes valores de luminancia (es decir, tendrías que almacenar 2x2 Y + 1 U + 1 V) y en cierta forma, ya tienes un nivel de compresión (por ejemplo, si tienes una imagen RGB de 384x288 píxeles y 8 bits por componente, ocuparía 331776 bytes mientras que usando YUV de esta forma a 8 bits también, ocuparía 165888 bytes. Es un ahorro interesante pero a costa de perder calidad en color y sigue ocupando más que si envías la imagen en B/N)

Esto que describo es típico de JPEG-MPEG que a su vez aplican su sistema de compresión y no vamos a descubrir ahora la diferencia de tamaño de datos entre una imagen RAW y otra en formato JPEG.

¿Que por que no lo usan?. Pues chico, en realidad no tengo ni idea de si lo están usando o no o tienen previsto usarlo: habrá imágenes que tomen en alta resolución que no puedan comprimir por falta de proceso/memoria o que simplemente, no quieran comprimir de esa forma o no les sea prioritario. Tampoco es raro que procesen aquí las imágenes que no tienen por qué venir en condiciones óptimas de origen y lo que está claro es que fotografías de Marte ya tenemos, sigue siendo igual de rojizo y lo que han mandado allí es un laboratorio muy sofisticado que tiene tareas mas importantes que realizar.

Pero está claro que las imágenes se pueden comprimir, evidentemente.

Una pregunta, si digitalizando U y V puedes sacar las componentes de color y la luminancia con las formulas "tipicas" ¿donde se produce la perdida?¿no se recupera la señal al completo?.(creo que la perdida se pierde en la digitalización).

Por otro lado, y esto se contradice con lo que yo decía en un principio, pienso que si se digitaliza la imagen eliminando el muestreo de crominancia y lo dejas en 4:0:0, mandas la imagen en B/N utilizando menos bits. Ellos toman la medida de suprimir toda la info de color para tener la info de luz al 100%. En vez de hacer un 80% 20%.

Lo que si tengo claro es que las imágenes en color llegaran mas adelante, como hasta ahora.Veremos lo que nos deparan.

Y = 0,299 R + 0,587 G + 0,114 B

U = 0,492 (B - Y)

= -0,147 R - 0,289 G + 0,436 B

V = 0,877 (R - Y)

= 0,615 R - 0,515 G - 0,100 B