argam escribió:No entiendo, se supone que el senyor Burger iba a hablar de xbox one y acaba saliendo por los cerros de Ubeda con arquitecturas FPGA en los servidores de Bing?

No seria mas sencillo realmente hablar de Xbox One y dejarse de rodeos?

Un saludo!

Nuhar escribió:Es que yo por lo menos me estoy liando bastante, como encima estais ironicos... cualquiera se aclara.

Si iban a hablar de la arquitectura de xbox one y hablan de FPGA será porque estan dentro de la One, digo yo, ¿no?

Venga, mojaros un poco y afirmar algo jajaja.

Zokormazo escribió:Oh quiza, no sera que los FPGAs estan en la nube para el cloud computing? xD

Nuhar escribió:Zokormazo escribió:Oh quiza, no sera que los FPGAs estan en la nube para el cloud computing? xD

Si estarian en la nube hablarian entonces de Azure (o como se llame ahora el servicio) y no de Xbox One, y yo creo que venía escrito en la temática.

Me imagino que tendre que esperar a la demo oficial para users de microsoft, espero que Coco y Epi me ayuden a entender todo esto

Aunque xbox one no tenga FPGA y sus coprocesadores no sean reprogramables y todas esas cosas... Que los servidores que use Microsoft sean el doble de potentes nos vendrá muy bien para calculos de fisicas

Aunque xbox one no tenga FPGA y sus coprocesadores no sean reprogramables y todas esas cosas... Que los servidores que use Microsoft sean el doble de potentes nos vendrá muy bien para calculos de fisicas  por ejemplo.

por ejemplo. mecro escribió:Yo lo que me pregunto es si la consola se planteo desde un primer momento para rular en Dx12 + nube a medio plazo, asumiendo que el inicio de la misma iba a salir pero parada técnicamente en los juegos que la ps4.

La verdad es que si tuviera que elegir de nuevo cual comprarme, casi con seguridad tiraría a por la ps4. Desde mi punto de vista llega a alcanzar mejor lo que ofrece un PC de alta gama hoy en día pero sigo teniendo esa esperanza, ilusión, inocencia de que la One realmente es superior en rendimiento. Eso si, cuando se use adecuadamente las herramientas para lo que yo creo que esta parida (Dx12 + Nube)

LaBestiaHumana+ escribió:Ni de coña pensaban esta diferencia, sino lo hubieran reconocido, ellos asumian tener peor grafica pero se tragaron, que la PS4 tendría 4 Gigas de Ram y ellos sabian que con 8 o 12, sería mucha diferencia que compensaria esa pequeña diferencia de potencia gráfica.

Ademas el efecto de suavizado gráfico de la memoria interna, ya había hecho milagros en la 360.

YO "creo" que pensaron que para su sistema de 3 niveles era recomendable 12 Gigas, pero si su competencia tenia 4, con 8 Gb les quedaria amplio margen. Ahora tienen que optimizar todo.

Entre la memoria, y las prisas que le metió la competencia el resultado.

Por ahora la nube en xbox one es lo mismo que en 360 mejores servidores, ping y "matchmaking". Nada novedoso.

Ejemplo titanfall.

Si algun otro juego vacilan de la nube, decírmelo que estoy deseando de descubrir su "magia".

Usuario: "¿y el poder de la nube?.

Microsoft: Culpa vuestra de no estar siempre online.

Usuario: TitanFall es online todos los usuarios tienen que estar online para jugar, porque no implementa la mejora grafica del 300% que dijisteis?

Microsoft: En Titanfall, se utiliza para el matchmaking.

Usuario: La 360 tb lo tiene se beneficia tb de la nube¿?mecro escribió:Yo lo que me pregunto es si la consola se planteo desde un primer momento para rular en Dx12 + nube a medio plazo, asumiendo que el inicio de la misma iba a salir pero parada técnicamente en los juegos que la ps4.

La verdad es que si tuviera que elegir de nuevo cual comprarme, casi con seguridad tiraría a por la ps4. Desde mi punto de vista llega a alcanzar mejor lo que ofrece un PC de alta gama hoy en día pero sigo teniendo esa esperanza, ilusión, inocencia de que la One realmente es superior en rendimiento. Eso si, cuando se use adecuadamente las herramientas para lo que yo creo que esta parida (Dx12 + Nube)

Geim escribió:Phil Spencer sobre DX12:

"It will help developers on XBOX One. It's not going to be a massive change but will unlock more capability for devs."

https://twitter.com/XboxP3/status/478731382660034560

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

chris76 escribió:Geim escribió:Phil Spencer sobre DX12:

"It will help developers on XBOX One. It's not going to be a massive change but will unlock more capability for devs."

https://twitter.com/XboxP3/status/478731382660034560

creo que este hombre no se entera de la pelicula,que no va a haber un gran canvio con directx12 dice,esto es por que no a leido a flasbackman y mitermxmedia xd!!!

hadock0 escribió:chris76 escribió:Geim escribió:Phil Spencer sobre DX12:

"It will help developers on XBOX One. It's not going to be a massive change but will unlock more capability for devs."

https://twitter.com/XboxP3/status/478731382660034560

creo que este hombre no se entera de la pelicula,que no va a haber un gran canvio con directx12 dice,esto es por que no a leido a flasbackman y mitermxmedia xd!!!

Y ahora es cuando hay que reirse, no?

chris76 escribió:Geim escribió:Phil Spencer sobre DX12:

"It will help developers on XBOX One. It's not going to be a massive change but will unlock more capability for devs."

https://twitter.com/XboxP3/status/478731382660034560

creo que este hombre no se entera de la pelicula,que no va a haber un gran canvio con directx12 dice,esto es por que no a leido a flasbackman y mitermxmedia xd!!!

Szasz escribió:will unlock more capability for devs."

No se va a convertir en una titan Z, pero desbloqueara más capacidades. Cordura, sí, pero otro paso adelante.

hadock0 escribió:chris76 escribió:Geim escribió:Phil Spencer sobre DX12:

"It will help developers on XBOX One. It's not going to be a massive change but will unlock more capability for devs."

https://twitter.com/XboxP3/status/478731382660034560

creo que este hombre no se entera de la pelicula,que no va a haber un gran canvio con directx12 dice,esto es por que no a leido a flasbackman y mitermxmedia xd!!!

Y ahora es cuando hay que reirse, no?

Nuhar escribió:Es que lo de los 5 Tflops... Ya lo de los 2,6 Tflops me parece una autentica burrada.

Yo lo que tenía entendido (corregirme si me equivoco) que con el directx12 "supuestamente" se podría usar al 100% el hardware de la consola y el rendimiento iba a ser superior, pero que también es un software que iba a integrar la nube en la consola.

Ahora, lo de cuanto es el rendimiento en la xbox one o como iba a afectar la nube es el misterio que todos queremos saber.

Nuhar escribió:Estas cosas hay que cogerlas con pinzas, una mejora del 10-20% no es un cambio significativo, no va a ser una gran revolución como puede ser el cloud computing (en caso que realmente funcione).

Pero si el 10% "del kinect" ya se esta notando, tener otro tanto adicional se notaria bastante. Habrá que esperar para averiguar cuanto es capaz de mejorar

Zokormazo escribió:Nuhar escribió:Estas cosas hay que cogerlas con pinzas, una mejora del 10-20% no es un cambio significativo, no va a ser una gran revolución como puede ser el cloud computing (en caso que realmente funcione).

Pero si el 10% "del kinect" ya se esta notando, tener otro tanto adicional se notaria bastante. Habrá que esperar para averiguar cuanto es capaz de mejorar

Puede que si, puede que no tanto. Con el 10% "del kinect" han liberado ancho de banda ademas de potencia, lo que ha podido suponer un incremento extra por liberar un cuello de botella. Si fuera el caso, liberar otro tanto no tendria una subida escalar en el rendimiento. Se notaria pero no tanto.

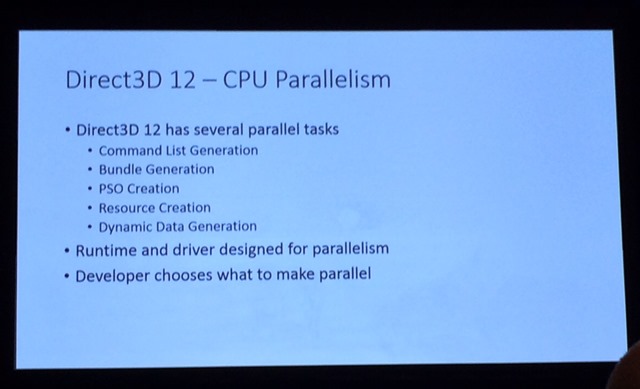

darksch escribió:Yo lo que creo es que no se termina de entender. No es cuestión de un 10%, 20%, 50%. Es cuestión de poner a funcionar el sistema como se diseñó en sus comunicaciones internas y REPARTIENDO el trabajo de la API (render, sonido, etc.) entre todos los coprocesadores + todos los núcleos de CPU, que ahora sólo se una 1 para tareas de la API.

¿Cuánto % de mejora supone esto?. No se puede cuantificar, lo que debe entenderse es como eliminación de cuellos de botella o limitadores por cargar demasiado 1 único componente, que es el 1er núcleo de la CPU que es la que ahora lo hace todo. Cuando lo sobrecargas ya puedes tener todo lo que quieras por otros lados que ahí te vas a quedar.

Lo que cabe esperar pues, no es un % en bruto, sino mayor tasa de fps especialmente con carga, mayor número de elementos, poder hacer juegos a 60 fps que antes serían impensables. Pero no porque de repente corra el doble, sino porque antes podrían encontrarse limitados al cargar demasiado 1 solo núcleo. Por lo tanto si el limitador de 30 fps es la GPU, en DX12 el juego seguirá a 30 fps (seguramente quitando slow-down), y la única forma de subirle fps sería bajando resolución.

En resumen, que a partir de DX12 los juegos estarán limitados por GPU. Para mí es muy ventajoso porque aparte de permitir mayor complejidad (más elementos, más procesamiento, etc.), permite, llegado el caso de alcanzar el tope de la GPU, decidir, si lo quieres poner a mayor resolución a 30 fps o menor a 60 fps. Es como cuando tienes un PC cuya CPU está por encima de la GPU.

Así que no debe buscarse un % de mejora, otra vez con los numeritos de las narices, sino tal y como se ha dicho abrir posibilidades.

darksch escribió:Yo lo que creo es que no se termina de entender. No es cuestión de un 10%, 20%, 50%. Es cuestión de poner a funcionar el sistema como se diseñó en sus comunicaciones internas y REPARTIENDO el trabajo de la API (render, sonido, etc.) entre todos los coprocesadores + todos los núcleos de CPU, que ahora sólo se una 1 para tareas de la API.

¿Cuánto % de mejora supone esto?. No se puede cuantificar, lo que debe entenderse es como eliminación de cuellos de botella o limitadores por cargar demasiado 1 único componente, que es el 1er núcleo de la CPU que es la que ahora lo hace todo. Cuando lo sobrecargas ya puedes tener todo lo que quieras por otros lados que ahí te vas a quedar.

Lo que cabe esperar pues, no es un % en bruto, sino mayor tasa de fps especialmente con carga, mayor número de elementos, poder hacer juegos a 60 fps que antes serían impensables. Pero no porque de repente corra el doble, sino porque antes podrían encontrarse limitados al cargar demasiado 1 solo núcleo. Por lo tanto si el limitador de 30 fps es la GPU, en DX12 el juego seguirá a 30 fps (seguramente quitando slow-down), y la única forma de subirle fps sería bajando resolución.

En resumen, que a partir de DX12 los juegos estarán limitados por GPU. Para mí es muy ventajoso porque aparte de permitir mayor complejidad (más elementos, más procesamiento, etc.), permite, llegado el caso de alcanzar el tope de la GPU, decidir, si lo quieres poner a mayor resolución a 30 fps o menor a 60 fps. Es como cuando tienes un PC cuya CPU está por encima de la GPU.

Así que no debe buscarse un % de mejora, otra vez con los numeritos de las narices, sino tal y como se ha dicho abrir posibilidades.

druida escribió:darksch escribió:Yo lo que creo es que no se termina de entender. No es cuestión de un 10%, 20%, 50%. Es cuestión de poner a funcionar el sistema como se diseñó en sus comunicaciones internas y REPARTIENDO el trabajo de la API (render, sonido, etc.) entre todos los coprocesadores + todos los núcleos de CPU, que ahora sólo se una 1 para tareas de la API.

¿Cuánto % de mejora supone esto?. No se puede cuantificar, lo que debe entenderse es como eliminación de cuellos de botella o limitadores por cargar demasiado 1 único componente, que es el 1er núcleo de la CPU que es la que ahora lo hace todo. Cuando lo sobrecargas ya puedes tener todo lo que quieras por otros lados que ahí te vas a quedar.

Lo que cabe esperar pues, no es un % en bruto, sino mayor tasa de fps especialmente con carga, mayor número de elementos, poder hacer juegos a 60 fps que antes serían impensables. Pero no porque de repente corra el doble, sino porque antes podrían encontrarse limitados al cargar demasiado 1 solo núcleo. Por lo tanto si el limitador de 30 fps es la GPU, en DX12 el juego seguirá a 30 fps (seguramente quitando slow-down), y la única forma de subirle fps sería bajando resolución.

En resumen, que a partir de DX12 los juegos estarán limitados por GPU. Para mí es muy ventajoso porque aparte de permitir mayor complejidad (más elementos, más procesamiento, etc.), permite, llegado el caso de alcanzar el tope de la GPU, decidir, si lo quieres poner a mayor resolución a 30 fps o menor a 60 fps. Es como cuando tienes un PC cuya CPU está por encima de la GPU.

Así que no debe buscarse un % de mejora, otra vez con los numeritos de las narices, sino tal y como se ha dicho abrir posibilidades.

Precisamente esa paralelizacion que llegará de forma global en dx12 para hardware diverso ya esta presente en la API actual de Xbox one mediante el uso de extensiones. De otra forma en la vida podrias haber visto Ryse corriendo en nucleos jaguar.

Zokormazo escribió:En xone se notara mas que en un i7, mas que nada porque sus cores son bastante menos potentes que los de un i7. Y si el cuello de botella lo tenemos en core0... ding, bingo xD

eloskuro escribió:druida escribió:darksch escribió:Yo lo que creo es que no se termina de entender. No es cuestión de un 10%, 20%, 50%. Es cuestión de poner a funcionar el sistema como se diseñó en sus comunicaciones internas y REPARTIENDO el trabajo de la API (render, sonido, etc.) entre todos los coprocesadores + todos los núcleos de CPU, que ahora sólo se una 1 para tareas de la API.

¿Cuánto % de mejora supone esto?. No se puede cuantificar, lo que debe entenderse es como eliminación de cuellos de botella o limitadores por cargar demasiado 1 único componente, que es el 1er núcleo de la CPU que es la que ahora lo hace todo. Cuando lo sobrecargas ya puedes tener todo lo que quieras por otros lados que ahí te vas a quedar.

Lo que cabe esperar pues, no es un % en bruto, sino mayor tasa de fps especialmente con carga, mayor número de elementos, poder hacer juegos a 60 fps que antes serían impensables. Pero no porque de repente corra el doble, sino porque antes podrían encontrarse limitados al cargar demasiado 1 solo núcleo. Por lo tanto si el limitador de 30 fps es la GPU, en DX12 el juego seguirá a 30 fps (seguramente quitando slow-down), y la única forma de subirle fps sería bajando resolución.

En resumen, que a partir de DX12 los juegos estarán limitados por GPU. Para mí es muy ventajoso porque aparte de permitir mayor complejidad (más elementos, más procesamiento, etc.), permite, llegado el caso de alcanzar el tope de la GPU, decidir, si lo quieres poner a mayor resolución a 30 fps o menor a 60 fps. Es como cuando tienes un PC cuya CPU está por encima de la GPU.

Así que no debe buscarse un % de mejora, otra vez con los numeritos de las narices, sino tal y como se ha dicho abrir posibilidades.

Precisamente esa paralelizacion que llegará de forma global en dx12 para hardware diverso ya esta presente en la API actual de Xbox one mediante el uso de extensiones. De otra forma en la vida podrias haber visto Ryse corriendo en nucleos jaguar.

darksch escribió:

En resumen, que a partir de DX12 los juegos estarán limitados por GPU. Para mí es muy ventajoso porque aparte de permitir mayor complejidad (más elementos, más procesamiento, etc.), permite, llegado el caso de alcanzar el tope de la GPU, decidir, si lo quieres poner a mayor resolución a 30 fps o menor a 60 fps. Es como cuando tienes un PC cuya CPU está por encima de la GPU.

Así que no debe buscarse un % de mejora, otra vez con los numeritos de las narices, sino tal y como se ha dicho abrir posibilidades.

druida escribió:darksch escribió:

En resumen, que a partir de DX12 los juegos estarán limitados por GPU. Para mí es muy ventajoso porque aparte de permitir mayor complejidad (más elementos, más procesamiento, etc.), permite, llegado el caso de alcanzar el tope de la GPU, decidir, si lo quieres poner a mayor resolución a 30 fps o menor a 60 fps. Es como cuando tienes un PC cuya CPU está por encima de la GPU.

Así que no debe buscarse un % de mejora, otra vez con los numeritos de las narices, sino tal y como se ha dicho abrir posibilidades.

Un detalle en el que estas errando, si hay una gran CPU dependencia no afecta a la resolucion de hecho uno de los sintomas para saber que la tienes es que no ganas nada de rendimiento bajandola.