Zokormazo escribió:Nuhar escribió:Estais comparando una preview del windows 10 que es poco mas que una actuqlizacion del windows 8.1 con la version final?, pero si falta un año!!! Anda que no quedan cosas por meter... Tiempo al tiempo

A eso voy.

En este hilo un poco mas arriba se ha preguntado si creemos que el desarrollo de win10 ha empezado despues de one o que.

Yo sinceramente creo que el desarrollo del software como tal si que ha empezado hace "poco". Otra cosa es el planteamiento del mismo. Pero el desarrollo en si no tiene pinta de llevar dos años de vida.

. Teniendo en cuenta que tanto dicha característica (XDMA) junto con otras como True Audio están disponibles a partir de Bonaire (GCN 1.1) y que curiosamente la 7790 es Bonaire... no se de q te extrañas de que haya un hardware counter con dicha característica

. Teniendo en cuenta que tanto dicha característica (XDMA) junto con otras como True Audio están disponibles a partir de Bonaire (GCN 1.1) y que curiosamente la 7790 es Bonaire... no se de q te extrañas de que haya un hardware counter con dicha característica  incluso hay otro para TrueAudio.

incluso hay otro para TrueAudio.Maybe the most interesting product, at least released today, is the AMD Radeon R7 260X (replacing the Radeon HD 7790). Once again, the ASIC between these two cards is identical. Specifications and performance should be nearly indistinguishable when compared. I was intrigued to learn that the HD 7790 GPU was the test subject for two new technologies: an updated CrossFire integration and AMD TrueAudio. These hidden features have a chance to be enabled with future drivers.

Nuhar escribió:Zokormazo escribió:Nuhar escribió:Estais comparando una preview del windows 10 que es poco mas que una actuqlizacion del windows 8.1 con la version final?, pero si falta un año!!! Anda que no quedan cosas por meter... Tiempo al tiempo

A eso voy.

En este hilo un poco mas arriba se ha preguntado si creemos que el desarrollo de win10 ha empezado despues de one o que.

Yo sinceramente creo que el desarrollo del software como tal si que ha empezado hace "poco". Otra cosa es el planteamiento del mismo. Pero el desarrollo en si no tiene pinta de llevar dos años de vida.

Los informaticos no se contratan ni se despiden a rachas.

Llevan diseñando el windows, dx, consola, etc, desde antes de lanzarse su versión anterior, asi que imaginate hace cuantos años llevan pensando en lo que iban a hacer...

Hay que comer todos los dias

. Ni multiplicar saben ya los que se inventan estas paridas.

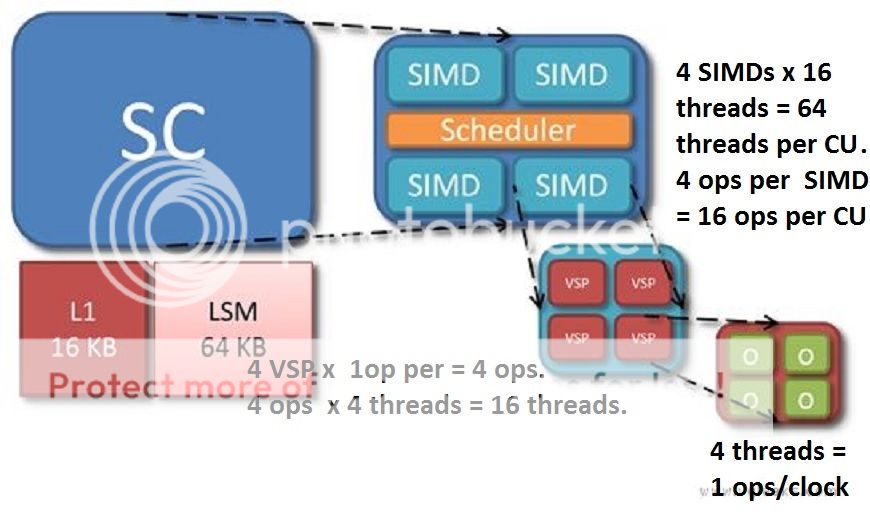

. Ni multiplicar saben ya los que se inventan estas paridas. josemurcia escribió:Mola porque los cálculos multiplican mágicamente por 4 la capcidad de los SIMD cuando arriba deja bien claro que cada SIMD son 16 threads/clock, no 64. Ni multiplicar saben ya los que se inventan estas paridas.

VSP --------- Vector Scalar Unit ------------ Four per SIMD, each operations on four threads per block

josemurcia escribió:Mola porque los cálculos multiplican mágicamente por 4 la capcidad de los SIMD cuando arriba deja bien claro que cada SIMD son 16 threads/clock, no 64. Ni multiplicar saben ya los que se inventan estas paridas.

papatuelo escribió:josemurcia escribió:Mola porque los cálculos multiplican mágicamente por 4 la capcidad de los SIMD cuando arriba deja bien claro que cada SIMD son 16 threads/clock, no 64. Ni multiplicar saben ya los que se inventan estas paridas.

Se supone que eso lo hacen por la definición de VSP, pero de eso yo ni puñetera idea. Para que te voy a decir otra cosa.VSP --------- Vector Scalar Unit ------------ Four per SIMD, each operations on four threads per block

Vector: A group of 64 threads that execute in lockstep.

VSP: Four per SIMD, each operating on four threads per clock.

josemurcia escribió:papatuelo escribió:josemurcia escribió:Mola porque los cálculos multiplican mágicamente por 4 la capcidad de los SIMD cuando arriba deja bien claro que cada SIMD son 16 threads/clock, no 64. Ni multiplicar saben ya los que se inventan estas paridas.

Se supone que eso lo hacen por la definición de VSP, pero de eso yo ni puñetera idea. Para que te voy a decir otra cosa.VSP --------- Vector Scalar Unit ------------ Four per SIMD, each operations on four threads per block

Es lo que digo, que la gente que hace estas gilipolleces no tiene ni puta idea de lo que está diciendo.Vector: A group of 64 threads that execute in lockstep.

VSP: Four per SIMD, each operating on four threads per clock.

Lo que quiere decir que cada pulso de reloj se ejecutan 4 hilos en paralelo. Por ejemplo:

Ciclo 1: los hilos 1 2 3 4

Ciclo 2: los hilos 5 6 7 8

Ciclo 3: los hilos 9 10 11 12

.

.

.

Ciclo 16: los hilos 61 62 63 64

Ciclo 17: los hilos 1 2 3 4

Eso es lo que significa trabajar en lockstep.

Cada VSP opera a 4 hilos por ciclo, no hay más.

josemurcia escribió:Si eso ya lo dice el paper. Lo que yo comentaba es la tontería de multiplicar por 4 by the face los hilos en paralelo que ejecuta cada VSP.

papatuelo escribió:

X D M A en el SDK filtrado???

Wait!!!!!

Que es X D M A?

sabueXo escribió:Igual estoy diciendo una tontería porque no lo he comprobado con otros juegos, pero creo que la beta del halo 5 ya usa el séptimo core.

Me he fijado que cuando empieza la partida, la luz roja del kinect se apaga. Pasa eso con otros juegos?

sabueXo escribió:Igual estoy diciendo una tontería porque no lo he comprobado con otros juegos, pero creo que la beta del halo 5 ya usa el séptimo core.

Me he fijado que cuando empieza la partida, la luz roja del kinect se apaga. Pasa eso con otros juegos?

Chifrinillo escribió:papatuelo escribió:

X D M A en el SDK filtrado???

Wait!!!!!

Que es X D M A?

Bueno, vayamos por partes please!

¿XQ en la XONE hay X D M A y su X D K tiene constancia de él?

Szasz escribió:No tengo ni idea. Se supone que solo debería aparecer las cosas que se vayan a usar en One, no?

También aparece el TrueAudio en los papers?

Sino aparece, blanco y en botella.

Pada escribió:Yo creo que es bastante evidente que hay algún tipo de dualidad en la GPU, por todas las declaraciones de los ultimos meses, las pistas y la filtración del SDK. Pero una cosa es eso y otra es que ahora resulte que es una máquina de 4 o 5TF como cacarean algunos, a esas personas les pediría que no se flipen mucho porque después llegan los chascos también, y creo que ya se está viendo lo suficiente como para repartir algunos zascas pero tampoco creo que sea muy necesario hacer sangre o como digo "fliparse" mucho porque después llegan los zascas en la otra dirección xD.... porque he visto alguna "corriente" cuasi-religiosa en EOF que no es nada sana tampoco.

Szasz escribió:josemurcia escribió:Si eso ya lo dice el paper. Lo que yo comentaba es la tontería de multiplicar por 4 by the face los hilos en paralelo que ejecuta cada VSP.

Yo hay no entro, no se si multiplica x4 "by the face" la potencia de One. Solo digo que VSP es una nueva nomenclatura y que podemos decir que One tiene multiplicado por 4 la cantidad de vectores sobre GCN. Y sino me equivoco esto es muy importante para el paralelismo.

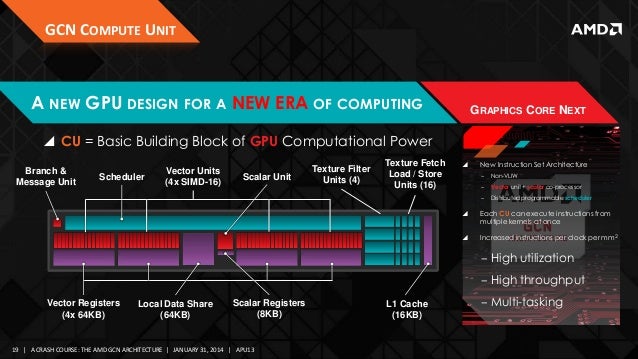

"Each CU has four Vector Units (VUs), each with 16 ALUs, for a total of 64 ALUs per CU. Thus, the number of ALUs per SIMD/CU is the same. The main difference is that, unlike the shader processors in a SIMD engine, each of the four VUs can be scheduled independently. The CU has its own hardware scheduler that's able to assign wavefronts to available VUs with limited out-of-order capability to avoid dependency bottlenecks.

This is the key to better compute performance because it gives each VU the ability to work on different wavefronts if a dependency exists in the queue"

http://www.tomshardware.com/reviews/radeon-hd-7970-benchmark-tahiti-gcn,3104-2.html

7) It's for our TrueAudio Technology (TrueAudio is codenamed "ACP" and it runs a background service that helps manage audio tasks in games.

"This is the key to better compute performance because it gives each VU the ability to work on different wavefronts if a dependency exists in the queue"

Szasz escribió:Chifrinillo escribió:papatuelo escribió:

X D M A en el SDK filtrado???

Wait!!!!!

Que es X D M A?

Bueno, vayamos por partes please!

¿XQ en la XONE hay X D M A y su X D K tiene constancia de él?

No tengo ni idea. Se supone que solo debería aparecer las cosas que se vayan a usar en One, no?

También aparece el TrueAudio en los papers?

Sino aparece, blanco y en botella.

Pada escribió:Yo creo que es bastante evidente que hay algún tipo de dualidad en la GPU, por todas las declaraciones de los ultimos meses, las pistas y la filtración del SDK. Pero una cosa es eso y otra es que ahora resulte que es una máquina de 4 o 5TF como cacarean algunos, a esas personas les pediría que no se flipen mucho porque después llegan los chascos también, y creo que ya se está viendo lo suficiente como para repartir algunos zascas pero tampoco creo que sea muy necesario hacer sangre o como digo "fliparse" mucho porque después llegan los zascas en la otra dirección xD.... porque he visto alguna "corriente" cuasi-religiosa en EOF que no es nada sana tampoco.

NeCLaRT escribió:Pada escribió:Yo creo que es bastante evidente que hay algún tipo de dualidad en la GPU, por todas las declaraciones de los ultimos meses, las pistas y la filtración del SDK. Pero una cosa es eso y otra es que ahora resulte que es una máquina de 4 o 5TF como cacarean algunos, a esas personas les pediría que no se flipen mucho porque después llegan los chascos también, y creo que ya se está viendo lo suficiente como para repartir algunos zascas pero tampoco creo que sea muy necesario hacer sangre o como digo "fliparse" mucho porque después llegan los zascas en la otra dirección xD.... porque he visto alguna "corriente" cuasi-religiosa en EOF que no es nada sana tampoco.

Pero es que lo que ha habido con Xbox One es muy fuerte, algo que yo nunca habia visto desde luego (tuve una atari 2600), quiza con la Xbox 1, que aquello era poco menos que el advenimiento del demonio, pero claro las circunstancias son incomparables, creo que proporcionalmente es mas grave lo que se ha hecho con One.

Ahora mismo en portada sigue habiendo gente diciendo que es una gpu de una generacion anterior y cosas asi, pero lo peor es que troleos aposta aparte, hay gente que lees sus mensajes y te das cuenta de que estan totalmente convencidos de lo que dicen, que no es troleo como hacen muchos otros. Y eso viene de todo aquello.

A mi la verdad que que algunos se pasen con lo de zascas y demas, pues aunque no lo comparto, lo puedo entender dado lo que hay.

si quiera)

si quiera)

0mag escribió:Entonces... ando un poco perdido... Que es lo que tiene flipando a los entendidos? ... Se confirmó el doble contexto gráfico? ... Un pequeño resumen para todos los no entendidos, vendría perfecto

BiG Porras escribió:0mag escribió:Entonces... ando un poco perdido... Que es lo que tiene flipando a los entendidos? ... Se confirmó el doble contexto gráfico? ... Un pequeño resumen para todos los no entendidos, vendría perfecto

Para unos si (entre otras cosas), para otros no, cada uno te contestara lo que le interesa hacer creer, este hilo no es el mas indicado para encontrar una respuesta ciertamente objetiva...

lo que YO CREO, es que se confirman muchas de las cosas que en este hilo se tacharon de imposibles y aberrantes, y esos que lo pesaban, unos siguen en sus trece, negando la mayor y otros lo asumen pero quitan hierro al asunto...

djfran28 escribió:Yo creo que no va a haber un tremendo salto, seguramente se iguale rendimiento con "la otra" y la pelea ya no pase a contar píxeles con ojos bionicos si no a exclusivos y funcionalidades del sistema operativo que al final es lo que nos interesa a los usuarios.

El hardware sin el software no es nada, un trozo de metal, que nadie lo olvide. Pero el software milagros no hace.

Horizonte de sucesos escribió:djfran28 escribió:Yo creo que no va a haber un tremendo salto, seguramente se iguale rendimiento con "la otra" y la pelea ya no pase a contar píxeles con ojos bionicos si no a exclusivos y funcionalidades del sistema operativo que al final es lo que nos interesa a los usuarios.

El hardware sin el software no es nada, un trozo de metal, que nadie lo olvide. Pero el software milagros no hace.

El rendimiento que puede dar esta arquitectura es un misterio, pues es la primera de todas. No tenemos nada en el mercado para comparar y hacernos una idea aproximada, NADA. Y esto en parte tiene su magia, verdad?

djfran28 escribió:Horizonte de sucesos escribió:djfran28 escribió:Yo creo que no va a haber un tremendo salto, seguramente se iguale rendimiento con "la otra" y la pelea ya no pase a contar píxeles con ojos bionicos si no a exclusivos y funcionalidades del sistema operativo que al final es lo que nos interesa a los usuarios.

El hardware sin el software no es nada, un trozo de metal, que nadie lo olvide. Pero el software milagros no hace.

El rendimiento que puede dar esta arquitectura es un misterio, pues es la primera de todas. No tenemos nada en el mercado para comparar y hacernos una idea aproximada, NADA. Y esto en parte tiene su magia, verdad?

Hombre tanto como misterios... Hacen arquitecturas adrede calculando rendimientos, que luego optimizan y tal pero quien los diseña lo hace sabiendo no juntando piezas y que iker las explique jejeje falta que den herramientas a los programadores para aprovechar la arquitectura y hacer el juego en los tiempos que dan ahora de desarrollo.

![como la niña del exorcista [360º]](/images/smilies/nuevos/vueltas.gif)

![fumando [fumando]](/images/smilies/nuevos/fumando.gif)

djfran28 escribió:Por milagro me refiero a mensajes que he leído con 4k y tal, eso sería un milagro.

papatuelo escribió:Lo del 4K se alimenta sobre todo por unas cap de Halo 5 que se supone que son directfeed y no recuerdo si eran 2K o 4K.

La explicación más normal es que no sean directfeed.

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)

The Xbox One allocates seven of such graphics contexts to games.

Read more at http://gamingbolt.com/xbox-one-gpu-has- ... LpRYIgT.99