LordVulkan escribió:Lo mejor es el fan escocido acusando al responsable técnico de Nanite de FUD contra PlayStation y pidiendo a Tim Sweeney que controle a sus empleados, metiendo en la mención a todo el alto cargo de Sony que ha pillao.

pabloc escribió:Mira que se hace sangre cuando fue solo un usuario que ha dicho varias cosas que no estaban muy acertadas.

Lo mismo que pasó con Xbox en el pasado con la potencia oculta y el poder de la nube.

LordVulkan escribió:Lo mejor es el fan escocido acusando al responsable técnico de Nanite de FUD contra PlayStation y pidiendo a Tim Sweeney que controle a sus empleados, metiendo en la mención a todo el alto cargo de Sony que ha pillao.

![facepalm [facepalm]](/images/smilies/facepalm.gif)

![facepalm [facepalm]](/images/smilies/facepalm.gif)

mocolostrocolos escribió:¿Créeis que se trata de TLOU Factions o de otro Multijugador?

https://www.pushsquare.com/news/2021/06 ... er_project

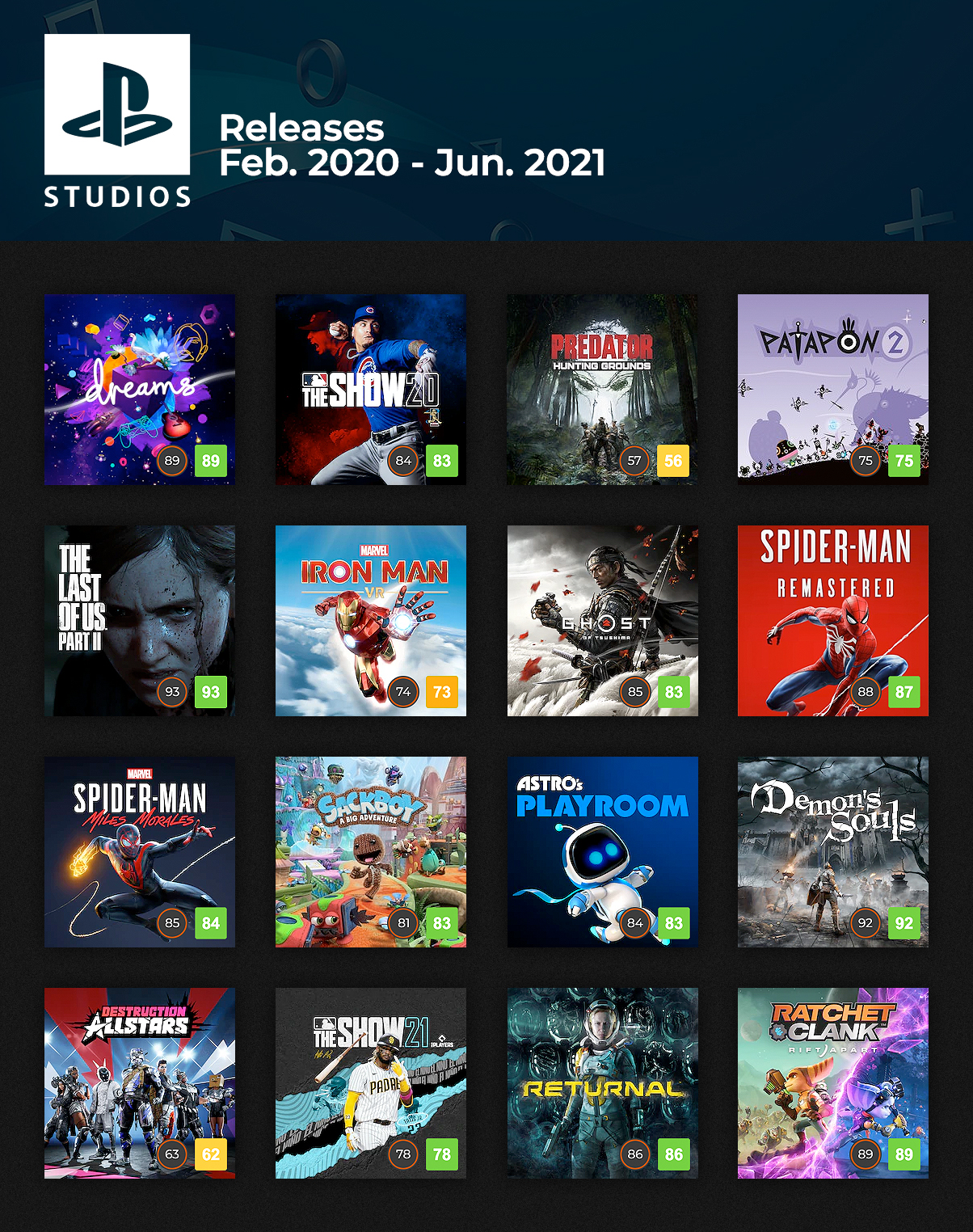

Rokzo escribió:He visto esta imagen:

Y WTF creo que no he oído hablar absolutamente nada de ese Predator. Así de bueno habrá salido

Rokzo escribió:He visto esta imagen:

Y WTF creo que no he oído hablar absolutamente nada de ese Predator. Así de bueno habrá salido

Rokzo escribió:He visto esta imagen:

Y WTF creo que no he oído hablar absolutamente nada de ese Predator. Así de bueno habrá salido

manmartin escribió:A mi me parece tremendo la compresión en los juegos de Ps5, no sé si es el algoritmo los dev kits o que, pero los juegos ocupan bastante menos que en series x.

ryo hazuki escribió:Esa imagen deja una cosa clarisima, que Sony deberia de dejar de producir juegos multijugador, porque vaya tela xD

davidDVD escribió:Yo me lo creeré cuando lo vea plasmado en los videojuegos; como en este último Ratchet... el cuál hace un muy buen uso de lo que se le pediría a un SSD (aprovechar su velocidad para integrarlo al gameplay, pero está claro que no todos los desarrollos pedirán eso; en un 'PES' solo cargaría rápido y ya xD)

Plage escribió:El problema de predator es que lo tendrían que haber sacado como F2P he ir desbloqueando personajes y demás, pero prefirieron sacarlo a 40€ si mal no recuerdo, aún así no es de playstation studios

mocolostrocolos escribió:Debe ser un PC con SSD mágico.

mocolostrocolos escribió:mocolostrocolos escribió:Debe ser un PC con SSD mágico.

Pues no, parece que la demo podría correr sobre un HDD de acuerdo con Branchild:

https://www.resetera.com/threads/epic-g ... t-66829594

[The goal (dream) with Nanite was to remove the notion of technical budgets and constraints for 3D Artists so that they can just focus the art itself, regardless of quality

The virtualization of geometry is a lot harder to implement in practice than the virtualization of textures due to factors like rendering cost

GPU driven pipeline for Nanite, which allows optimizations like reduced draw call requirements per scene

Draw calls are per material, not per object. All opaque geometry can now be rendered with just a single draw call

In this demo, pixel sized triangles used software rasterizer, as it's up to 3x faster than hardware rasterizer. Big triangles use hw rasterizer (rasterizer chosen on per cluster basis)

Average frame for demo was ~1400p upscaled to 4k via temporal upsampling

Nearly zero CPU time and very little CPU cost. Most of the work handled by the GPU

Proprietary compression tech to keep file sizes in check (the immense amount of geometry would take up too much space otherwise)

All Nanite data on disk (compressed) was 6.14 GB in total

Texture data far larger than geometry data

16k x 16k virtualized shadow maps work in a similar way to Nanite by only rendering shadow detail that's perceptible (shadow pixels)

The scenes shown are demonstrated using a free roam camera to show that scripting is not necessary and that there isn't any masked loading

Entire level was loaded into memory (mainly for the purposes of showing that the infamous crack was not used to hide streaming)

Self-shadowing makes it easier to see the increased fidelity of actual geometry compared to normal maps

Demo shown is not using world partitioning (the tech hadn't fully developed by the time the demo was made)

The closer the camera is to a given mesh, the more faithful the geometry will be relative to the source model (the delta in fidelity is practically imperceptible without visualization data)

128 triangles per cluster. Cluster sizes on screen are roughly the same, regardless of viewing distance, which allows the triangles to have similarly stable counts on screen

On average, there weren't much more than 20M tris rendered on screen, even with billions of triangles from source geometry. The tri count will scale with resolution

Nanite supports hard surface model meshes as well, not just organic assets from megascans/photogrammetry

The ring on the portal at the end of the demo is not actually a unique mesh, but made from instanced geometry like the statues shown earlier in the demo

LordVulkan escribió:mocolostrocolos escribió:mocolostrocolos escribió:Debe ser un PC con SSD mágico.

Pues no, parece que la demo podría correr sobre un HDD de acuerdo con Branchild:

https://www.resetera.com/threads/epic-g ... t-66829594

[The goal (dream) with Nanite was to remove the notion of technical budgets and constraints for 3D Artists so that they can just focus the art itself, regardless of quality

The virtualization of geometry is a lot harder to implement in practice than the virtualization of textures due to factors like rendering cost

GPU driven pipeline for Nanite, which allows optimizations like reduced draw call requirements per scene

Draw calls are per material, not per object. All opaque geometry can now be rendered with just a single draw call

In this demo, pixel sized triangles used software rasterizer, as it's up to 3x faster than hardware rasterizer. Big triangles use hw rasterizer (rasterizer chosen on per cluster basis)

Average frame for demo was ~1400p upscaled to 4k via temporal upsampling

Nearly zero CPU time and very little CPU cost. Most of the work handled by the GPU

Proprietary compression tech to keep file sizes in check (the immense amount of geometry would take up too much space otherwise)

All Nanite data on disk (compressed) was 6.14 GB in total

Texture data far larger than geometry data

16k x 16k virtualized shadow maps work in a similar way to Nanite by only rendering shadow detail that's perceptible (shadow pixels)

The scenes shown are demonstrated using a free roam camera to show that scripting is not necessary and that there isn't any masked loading

Entire level was loaded into memory (mainly for the purposes of showing that the infamous crack was not used to hide streaming)

Self-shadowing makes it easier to see the increased fidelity of actual geometry compared to normal maps

Demo shown is not using world partitioning (the tech hadn't fully developed by the time the demo was made)

The closer the camera is to a given mesh, the more faithful the geometry will be relative to the source model (the delta in fidelity is practically imperceptible without visualization data)

128 triangles per cluster. Cluster sizes on screen are roughly the same, regardless of viewing distance, which allows the triangles to have similarly stable counts on screen

On average, there weren't much more than 20M tris rendered on screen, even with billions of triangles from source geometry. The tri count will scale with resolution

Nanite supports hard surface model meshes as well, not just organic assets from megascans/photogrammetry

The ring on the portal at the end of the demo is not actually a unique mesh, but made from instanced geometry like the statues shown earlier in the demo

No se donde lees que no, en el propio post que enlazas dice que sí.

bigfoot_ escribió:1. Desde el desconocimiento y sin ganas de flammear, cuando salió el Spiderman MM, la gente se hacía pajas con la transición de una fase a mundo abierto (recuerdo un gif que salía por una ventana de una iglesia o algo así), que eso era el magicSSD y no se qué, que menuda velocidad de carga para volver al mundo abierto...

1Luego en PS4 resultaba que era idéntico (salvando distancias de dibujado, resolución etc etc), pero es que en ps4 el kraken y no se que ostias, vamos excusas varias pero víctimas del hype que no se bajaban de la burra...

2. A mí el que cambies de mapa rápido-instantáneo no dice nada de la velocidad del SSD (entiéndeme que sea la polla que lo es pero no deja de ser un ssd), más si cuando aparece la ventana esa dimensional ya se ha cargado en la RAM el mapa al que vas a saltar...

3. Resumiendo que lo que te quería preguntar, ¿os referís a la velocidad del SSD, sólo por ese cambio de mapas?

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

Mulzani escribió:El handicap que tienen las consolas, por las cuales el uso del SSD es un paso importante, es la falta de memoria RAM.

En un PC esos problemas son menores, porque tenemos 2 pool de memoria, uno con la memoria del sistema, que hoy ya se está yendo hacia los 32 GB (y 64 GB en los entusiastas), y otro pool de memoria para la GPU, que está por los 8-16 GB, según el modelo de tarjeta. Al tener 2 pool de memoria, puedes ir metiendo a la más lenta (pero que es mucho más rápida que un SSD) a la RAM del sistema, para luego subirlo a la memoria de la GPU, el uso de un SSD o HDD es "desestimable" si podemos cargar en la RAM del sistema lo necesario una vez está ya corriendo el juego.

Así, es posible utilizar casi toda la memoria de la GPU, pudiendo liberar memoria de la GPU y cargarla del sistema cuando sea necesario, sin que repercuta en el rendimiento y, así, pudiendo tener una cantidad de assets, texturas y calidad de éstas muy alta.

Pero en consolas tenemos un problema, las de pasada generación tenían 8 GB (disponibles mucho menos), mientras que las de actual generación hemos pasado a los 16GB (algo menos disponible), tanto para CPU como para GPU, ahí ya tenemos una carencia de RAM importante. Eso obligaba que, por un lado, el uso del HDD tuviera que hacerse una lectura secuencial completa en cada nivel (unos tiempos de carga muy altos) y que, si quisieras ir cargando al vuelo del HDD, tener que liberar bastante más espacio de la RAM, para lo que fuera por venir, obligando a una cantidad y calidad de assets más baja.

Ahora, con el uso del SSD (y otras tecnologías asociadas como la compresión, el I/O controller o el FastPath), se permite aumentar mucho más el uso de la memoria, ya que el acceso a los datos es mucho más rápido que con el HDD, podemos liberar y cargar RAM en streaming sin muchos problemas, además, con las tecnologías asociadas, se puede eliminar más morralla que tenías que cargar antes, que te ocupaba RAM, pero que no ibas a utilizar en ese momento.

No es que el SSD sea mágico, pero sí que permite, por un lado, ahorrar costes en cuanto a RAM de sistema o de GPU necesitas (ya no es necesario cantidades tan ingentes de RAM), por otro, crear un streaming de datos a la memoria de la GPU contínuo para ir cambiando assets o texturas de manera más dinámica y, así, aumentar la calidad visual (sobretodo en variedad), además de reducir el espacio requerido en el disco principal, pues no requiere de la redundancia obligada en los HDD, por culpa de la baja velocidad de lectura aleatoria.

En cuanto a la demo de Nanite, pues normal que funcione bien en un PC con HDD, con lo que ocupa (6-7GB comprimidos), incluso descomprimidos, puedes perfectamente subirlo a la RAM sin problemas de espacio para luego ir cargando en la memoria de la GPU.

Nuhar escribió:Supongo que quiere decir que al leer desde el disco duro y no desde la raam te permite liberar el espacio que ocupan las texturas y tener todas a 4k - 8k...lo de assetts.. No se a que se refiere

Zeta V escribió:Nuhar escribió:Supongo que quiere decir que al leer desde el disco duro y no desde la raam te permite liberar el espacio que ocupan las texturas y tener todas a 4k - 8k...lo de assetts.. No se a que se refiere

Yo muy al principio, cuando se empezó a especular sobre los SSD en las consolas y las nuevas arquitecturas, pensaba que los tiros podrian ir por ahi, por mostrar texturas directamente del SSD (que no se ni si seria posible dividir el framebuffer en dos localizaciones), pero si no me estoy equivocando, la cosa realmente no es asi.

Repito, si no me equivoco, o hay algo que no he entendido, o que no me he enterado (si no que me corrija alguien), la Gpu ve lo que hay en el SSD, de ahi lo pasa a la RAM y de ahi a la pantalla (simplificando un poco el proceso). Si esto es asi, no es posible tener mejor calidad de texturas (y diria que tampoco te aporta tener mas variedad de texturas que un HDD). La RAM va a seguir siendo el factor limitante en ese sentido, igual que antes. Si todo lo que se muestra en pantalla viene de la RAM, esta es la que te va a limitar en cuanto a cantidad/calidad de texturas.

¿que aporta el SSD? Antes, creo que era la Gpu la que pedia una textura a la Cpu, la Cpu la busca en el disco, la pasa a la Ram y una vez en la Ram ya la ve la Gpu para mostrarla en pantalla (algo asi). Con el SSD y todo el tema del IO, te evitas ese circuito, lo que permite ahorrar tiempo. Si a esto, le añades que de por si el SSD es mas rapido, se reducen drasticamente los tiempos... pero nada mas.

Mj90 escribió:Zeta V escribió:Nuhar escribió:Supongo que quiere decir que al leer desde el disco duro y no desde la raam te permite liberar el espacio que ocupan las texturas y tener todas a 4k - 8k...lo de assetts.. No se a que se refiere

Yo muy al principio, cuando se empezó a especular sobre los SSD en las consolas y las nuevas arquitecturas, pensaba que los tiros podrian ir por ahi, por mostrar texturas directamente del SSD (que no se ni si seria posible dividir el framebuffer en dos localizaciones), pero si no me estoy equivocando, la cosa realmente no es asi.

Repito, si no me equivoco, o hay algo que no he entendido, o que no me he enterado (si no que me corrija alguien), la Gpu ve lo que hay en el SSD, de ahi lo pasa a la RAM y de ahi a la pantalla (simplificando un poco el proceso). Si esto es asi, no es posible tener mejor calidad de texturas (y diria que tampoco te aporta tener mas variedad de texturas que un HDD). La RAM va a seguir siendo el factor limitante en ese sentido, igual que antes. Si todo lo que se muestra en pantalla viene de la RAM, esta es la que te va a limitar en cuanto a cantidad/calidad de texturas.

¿que aporta el SSD? Antes, creo que era la Gpu la que pedia una textura a la Cpu, la Cpu la busca en el disco, la pasa a la Ram y una vez en la Ram ya la ve la Gpu para mostrarla en pantalla (algo asi). Con el SSD y todo el tema del IO, te evitas ese circuito, lo que permite ahorrar tiempo. Si a esto, le añades que de por si el SSD es mas rapido, se reducen drasticamente los tiempos... pero nada mas.

El SSD según la primera demo de ue5 en ps5, permitía tener texturas a 8k si no me equivoco. Era posible porque el SSD está cargando en la ram sólo lo que estés viendo en pantalla, descartando lo que no ves.

Zeta V escribió:Mj90 escribió:Zeta V escribió:

Yo muy al principio, cuando se empezó a especular sobre los SSD en las consolas y las nuevas arquitecturas, pensaba que los tiros podrian ir por ahi, por mostrar texturas directamente del SSD (que no se ni si seria posible dividir el framebuffer en dos localizaciones), pero si no me estoy equivocando, la cosa realmente no es asi.

Repito, si no me equivoco, o hay algo que no he entendido, o que no me he enterado (si no que me corrija alguien), la Gpu ve lo que hay en el SSD, de ahi lo pasa a la RAM y de ahi a la pantalla (simplificando un poco el proceso). Si esto es asi, no es posible tener mejor calidad de texturas (y diria que tampoco te aporta tener mas variedad de texturas que un HDD). La RAM va a seguir siendo el factor limitante en ese sentido, igual que antes. Si todo lo que se muestra en pantalla viene de la RAM, esta es la que te va a limitar en cuanto a cantidad/calidad de texturas.

¿que aporta el SSD? Antes, creo que era la Gpu la que pedia una textura a la Cpu, la Cpu la busca en el disco, la pasa a la Ram y una vez en la Ram ya la ve la Gpu para mostrarla en pantalla (algo asi). Con el SSD y todo el tema del IO, te evitas ese circuito, lo que permite ahorrar tiempo. Si a esto, le añades que de por si el SSD es mas rapido, se reducen drasticamente los tiempos... pero nada mas.

El SSD según la primera demo de ue5 en ps5, permitía tener texturas a 8k si no me equivoco. Era posible porque el SSD está cargando en la ram sólo lo que estés viendo en pantalla, descartando lo que no ves.

Para tener texturas 8k no hace falta tener SSD ni toda la arquitectura que se ha diseñado en Ps5. WiiU (ahi queda el hardware que montaba) ya usaba texturas 8k en algun juego.

La transferencia de datos en ancho de banda del SSD a la RAM es de 5.5 y de la RAM a la pantalla 448. Eso significa que si todo lo que esta en la Ram se esta viendo en pantalla, algo que no ves en pantalla y lo quieras mostrar, no da tiempo a pasarlo en el intervalo que se renderiza un frame.

Mj90 escribió:Zeta V escribió:Mj90 escribió:

El SSD según la primera demo de ue5 en ps5, permitía tener texturas a 8k si no me equivoco. Era posible porque el SSD está cargando en la ram sólo lo que estés viendo en pantalla, descartando lo que no ves.

Para tener texturas 8k no hace falta tener SSD ni toda la arquitectura que se ha diseñado en Ps5. WiiU (ahi queda el hardware que montaba) ya usaba texturas 8k en algun juego.

La transferencia de datos en ancho de banda del SSD a la RAM es de 5.5 y de la RAM a la pantalla 448. Eso significa que si todo lo que esta en la Ram se esta viendo en pantalla, algo que no ves en pantalla y lo quieras mostrar, no da tiempo a pasarlo en el intervalo que se renderiza un frame.

Texturas 8k en ese nuevo motor gráfico y simplemente cargándolo cuando es necesario pues es un avance creo yo.

Sobre lo que comentas al final, la demo de ue5 estaba funcionando así y Ratchet según comentan está funcionando así o de manera similar, descartando lo que no estás viendo en pantalla.

Zeta V escribió:Mj90 escribió:Zeta V escribió:

Para tener texturas 8k no hace falta tener SSD ni toda la arquitectura que se ha diseñado en Ps5. WiiU (ahi queda el hardware que montaba) ya usaba texturas 8k en algun juego.

La transferencia de datos en ancho de banda del SSD a la RAM es de 5.5 y de la RAM a la pantalla 448. Eso significa que si todo lo que esta en la Ram se esta viendo en pantalla, algo que no ves en pantalla y lo quieras mostrar, no da tiempo a pasarlo en el intervalo que se renderiza un frame.

Texturas 8k en ese nuevo motor gráfico y simplemente cargándolo cuando es necesario pues es un avance creo yo.

Sobre lo que comentas al final, la demo de ue5 estaba funcionando así y Ratchet según comentan está funcionando así o de manera similar, descartando lo que no estás viendo en pantalla.

No se que tiene que ver el tocino con la velocidad. UE5 es un motor nuevo y en la demo que mostraron usaron texturas a 8k ¿que quieres decir con eso? ¿cual es el avance en ?

Yo no estoy hablando de lo que dice o deja de decir la gente en los foros, estoy hablando de los frios numeros oficiales y que con ellos en la mano, no es posible hacer eso que tu estas diciendo (salvo que haya algo que no nos hayan contado).

davidDVD escribió:bigfoot_ escribió:1. Desde el desconocimiento y sin ganas de flammear, cuando salió el Spiderman MM, la gente se hacía pajas con la transición de una fase a mundo abierto (recuerdo un gif que salía por una ventana de una iglesia o algo así), que eso era el magicSSD y no se qué, que menuda velocidad de carga para volver al mundo abierto...

1Luego en PS4 resultaba que era idéntico (salvando distancias de dibujado, resolución etc etc), pero es que en ps4 el kraken y no se que ostias, vamos excusas varias pero víctimas del hype que no se bajaban de la burra...

2. A mí el que cambies de mapa rápido-instantáneo no dice nada de la velocidad del SSD (entiéndeme que sea la polla que lo es pero no deja de ser un ssd), más si cuando aparece la ventana esa dimensional ya se ha cargado en la RAM el mapa al que vas a saltar...

3. Resumiendo que lo que te quería preguntar, ¿os referís a la velocidad del SSD, sólo por ese cambio de mapas?

1. Pero ese es un cross-gen, ahí no hace falta "alinear" los componentes para que no haya esperas, la base es una PS4 con HDD... cualquier placa base actual podría (ya que es simplemente acceder/cargar rápido, quitas la transición)

2. Lo del Ratchet yo lo veo más complicadete, no por nada, más bien porque están sacando cosas (para PC) del mismo estilo de lo que presentó Cerny para PS5 en su día (acceso directo sin pasar por CPU o tal), de momento yo no sé si sirve lo actual (tal y cómo está planteado); más que nada porque no hay otro juego que haga lo mismo (creo); de momento no actualizo el PC por si acaso![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

3. Es lo que Nvidia (RTX IO) o Cerny presentó (lecturas directas sin intervención de CPU, y demás cosas técnicas xD)

Mulzani escribió:@Zeta V

A ver, es porque ya no es necesario precargar de antemano tantas texturas o elementos.

Antes, en una consola, si querías eliminar el tener que hacer una pantalla de carga, necesitas ir cargando los datos de antemano para poder quitar la pantalla de carga, eso implica tener residente en memoria muchos datos que no se usarán hasta pasado un tiempo, por lo que estás limitando la cantidad de memoria RAM disponible para la escena actual.

Con la carga mediante el SSD (y las tecnologías asociadas), puedes cargar los datos casi sobre la marcha, permitiendo poder usar más memoria RAM para la escena actual y menos para la que va a venir, porque podrás ir cargándola a posteriori.

De ahí que permitas meter, o más variedad de texturas, o con más calidad...

Para un mundo abierto, es una mejora importante en cuanto a meter más calidad, para un escenario cerrado, con cargas por nivel, la diferencia no es tan palpable, salvo en el tiempo de carga.

Eso sí, el limitante de la GPU va a seguir estando ahí, si tu GPU sólo permite disponer de una cantidad de elementos en escena, el uso del SSD no va a permitir aumentar dichos elementos.

Con la carga mediante el SSD (y las tecnologías asociadas), puedes cargar los datos casi sobre la marcha, permitiendo poder usar más memoria RAM para la escena actual y menos para la que va a venir, porque podrás ir cargándola a posteriori.

.Que todo lo que tendría que mover ps5 en este caso sería imposible tenerlo todo en la memoria y menos justo a tiempo si no fuese por el SSD

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

triki1 escribió:Y yo que pense que el nivel maximo de flipada eran las ultimas peliculas del Fast&Furious, lo del trailer del Battlefield CGI con el piloto saltando del avion con el bazooka en mano para derribar otro avion y volver al suyo ya alcanza niveles estratosfericos de ridiculo.............y gameplay en la conferencia de MS, pues vale, lo podian haber dicho antes y me hubiese ahorrado ver ésto que no aporta absolutamente nada.

exar escribió:Me ha parecido estar viendo Fast & Furious, en serio. Bueno, ahora el 13 toca gameplay, veremos qué tal? El 13 hay confe de EA o lo esperamos para la de Microsoft?

Veo que no soy el único que ha pensado en F&F![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)