[Alex] escribió:MikeFg escribió:@parh La 3080 salió a 600€ y esta sale a 1100€, es el doble de precio, ya depende de lo que valore cada uno.

La 3080 salió a 719€ y duró a ese precio 1-2 meses antes de subir a la luna.

719€ no es la mitad de 1.119€, aunque sea un puto robo.

Strait escribió:RaD3R escribió:En rendimiento, cuál es la diferencia media entre una 3080 y una 4080S? Más de un 30%? Sin contar con el frame generation.

La 4080 es aprox un 50% más potente que la 3080, así que sí.

RaD3R escribió:Strait escribió:RaD3R escribió:En rendimiento, cuál es la diferencia media entre una 3080 y una 4080S? Más de un 30%? Sin contar con el frame generation.

La 4080 es aprox un 50% más potente que la 3080, así que sí.

Por lo que he visto en vídeos, se mueve entre un 30 y 40% más de rendimiento. Que no está mal. Pero si la serie 5x sale en 2025, y yo no juego a 4k, creo que no daré el salto ahora.

PSX22 escribió:@Pollonidas

como va a ser lo mismo una 4060ti o mi 4070 que una 4080Super, no es el doble una 4080S que mi 4070? no pueden ser a la vez gamas medias ambas, si una vale 599 y otra 1200

pagar 2600 es un ferrari y rinde mejor por euro, pero es tirar el dinero si juegas a 1440 por ejemplo, esa 4090 te da para casi 4 tarjetas 4070, es decir, una te cubre 4-5 años de etapa gaming y la otra opcion podrias cubrir 20 años de etapa gaming.... como va a ser mejor inversion 5 años que 20 jugando al maximo nivel ( asumiendo 2K 120hz)

Strait escribió:RaD3R escribió:Strait escribió:

La 4080 es aprox un 50% más potente que la 3080, así que sí.

Por lo que he visto en vídeos, se mueve entre un 30 y 40% más de rendimiento. Que no está mal. Pero si la serie 5x sale en 2025, y yo no juego a 4k, creo que no daré el salto ahora.

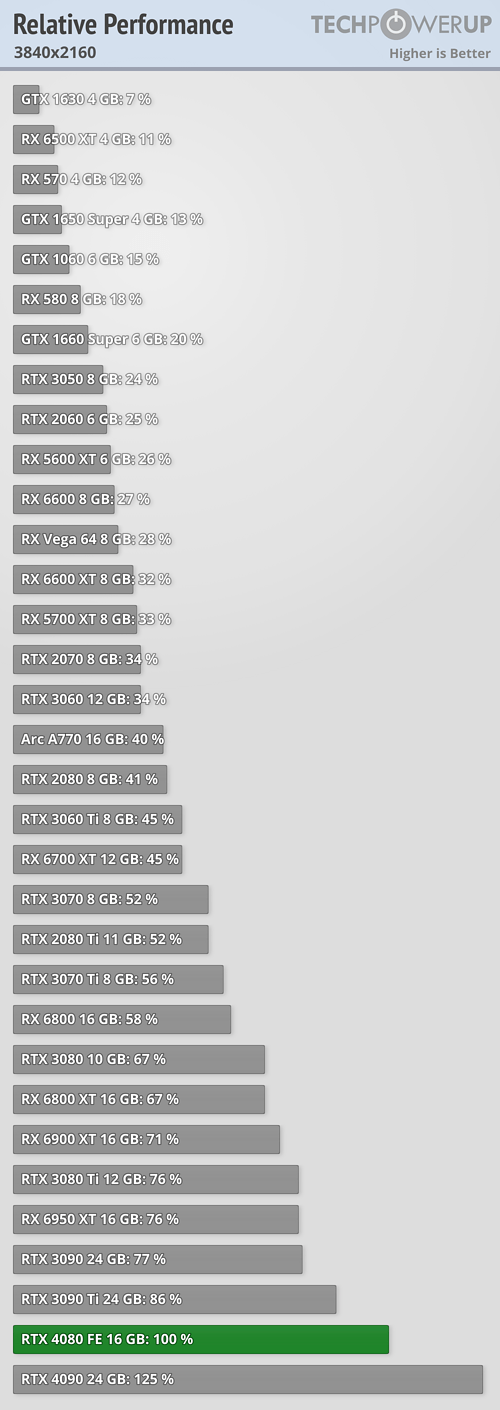

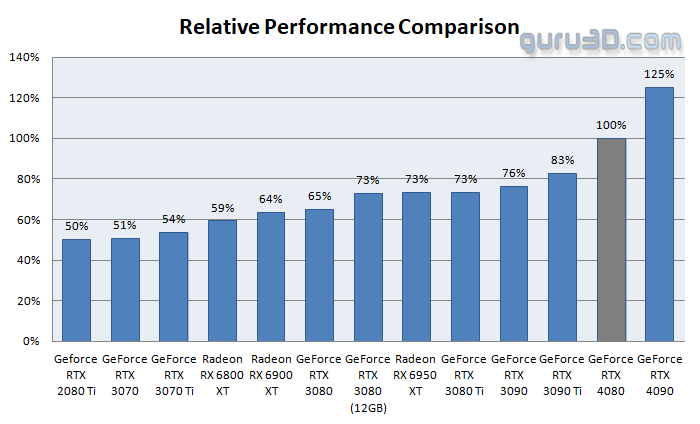

La 3080 tiene una potencia relativa frente a la 4080 de entre un 65% y 67% según reviews de páginas decentes. A día de hoy con optimización de drivers es probable que la diferencia sea algo más. Si partimos de la 3080 tenemos que 100 es un 150% más de 66 (un 50% más para que nos entendamos):

Fuente techpowerup y guru3d.

parh escribió:@PSX22 creo que debes cambiar un poco el chip. Las graficas de PC no son como las consolas. Me refiero a que dices que puedes alargar 4-5 años una 4070... no lo veo la verdad, en menos de 2 años (por no decir año y medio) a una 4070 ya se le empezaran a ver las costuras, y en 5 años como tu dices , ya ni te digo, tendrias que bajar tanto los settings a los juegos que no valdria la pena con respecto a su version consola (que se supone que estamos en PC gaming porque nos gusta jugar con una calidad notoriamente superior a la de la consola de turno)

RaD3R escribió:

Eso es exactamente lo que he dicho, sí. Entre un 30 y un 40% más de rendimiento, lo que he visto en gameplays comparativos. No está mal, es la diferencia mínima que yo le exigiría a un cambio de GPU.

parh escribió:@PSX22 creo que debes cambiar un poco el chip. Las graficas de PC no son como las consolas. Me refiero a que dices que puedes alargar 4-5 años una 4070... no lo veo la verdad, en menos de 2 años (por no decir año y medio) a una 4070 ya se le empezaran a ver las costuras, y en 5 años como tu dices , ya ni te digo, tendrias que bajar tanto los settings a los juegos que no valdria la pena con respecto a su version consola (que se supone que estamos en PC gaming porque nos gusta jugar con una calidad notoriamente superior a la de la consola de turno)

Kurosawa42 escribió:Mi sensacion es que el usuario de a pie/ usuario gaming somos algo residual ( Mas ahora que antes ) y que por la parte que toca a Nvidia, el negocio de la IA o similares es lo que les importa porque ahi es donde ganan y mucho.

Nosotros somos migajas ¿A quien le importa unas migajas teniendo un pastel inmenso ?

![a lágrima viva [buuuaaaa]](/images/smilies/nuevos/triste_ani3.gif)

654321 escribió:Kurosawa42 escribió:Mi sensacion es que el usuario de a pie/ usuario gaming somos algo residual ( Mas ahora que antes ) y que por la parte que toca a Nvidia, el negocio de la IA o similares es lo que les importa porque ahi es donde ganan y mucho.

Nosotros somos migajas ¿A quien le importa unas migajas teniendo un pastel inmenso ?

OJALA fuese tu sensación !!!!

Es la cruda realidad, NVIDIA vale ahora 100 veces mas que hace 10 años, es la sexta compañía mas grande del mundo en capitalación bursatil.

https://companiesmarketcap.com/nvidia/marketcap/

Vamos, que vender el doble de GPUs de gama media, pero mas baratas, pues no les cambiaría nada.

Lo único que nos puede salvar es que alguien saque unos chips de IA mas eficientes que los de NVIDIA ...

[Alex] escribió:Cuál será la próxima?

![a lágrima viva [buuuaaaa]](/images/smilies/nuevos/triste_ani3.gif)

adriano_99 escribió:RaD3R escribió:

Eso es exactamente lo que he dicho, sí. Entre un 30 y un 40% más de rendimiento, lo que he visto en gameplays comparativos. No está mal, es la diferencia mínima que yo le exigiría a un cambio de GPU.

No estás mirando bien los porcentajes.

No es lo mismo decir que la 3080 es un 35% más lenta que la 4080 que decir que la 4080 es un 35% mas rapida.

Lo que la tabla dice es que la 3080 tiene un 65% del rendimiento de la 4080, es decir que si la 4080 en un juego te da 100fps la 3080 te da 65.

En ese caso 100/65 = 1,538 lo que significa que la 4080 es un 53,8% mas rapida que la 3080, no un 35.

En los porcentajes es muy importante sobre quien se aplican, no son números absolutos sino relativos a algo.

Un ejemplo un poco mas extremo;si la gráfica A da 50 fps y la gráfica B da 100 fps podemos decir que:

-La gráfica A es un 50% mas lenta que la gráfica B

-La gráfica B es un 100% mas rapida que la gráfica A.

Si por ejemplo tuvieses una gráfica C que fuese un 50% mas rapida que la A esa daria 75fps.

neox3 escribió:

pues veo el video super fluido, la calidad es la ostia...

PSX22 escribió:@Pollonidas

La verdad que me ha venido bien el texto para ponerme al dia el chips nomenclatura nvidia y tal, en general comparto lo que dices, pero eso si la gama media te la venden a 600 y te da para 90-100 fps a graficos altos 1440p para 4-5 años, pues oye ni tan mal. No podemos pretender que nos vendan una 4070 a precio de una 7600GT de la epoca, estamos en otras decadas. Las graficas valen el doble, pero las casas o comida no? pues veo natural que crezcan en proporcion a la vida general. Es que lo de pagar 60€ por un juego como cyberpunk en 2023 y los 60 que costaba el Orange BOX de xbox 360, pues no lo veo natural ni logico.

Que por mi podria valer la 4090 600€ como consumidor es una cosa y como alguien que entiende que la economia no se va a congelar es otra cosa.

Como digo a mi por una cantidad de la mitad del SMI me dan 1440 ultra 60+ fps , en 2004 no jugabamos a 1440p 100fps a los juegos top de la epoca por la mitad del SMI de la epoca ( unos 300€).

Lo que no me ha gustado es que rinden muy bien, pero a costa de DLSS y framegeneration , preferiria mas poder de computo crudo que usar trucos de IA, pero supongo que no se puede hacer 100teraflops en 100watts con la tecnologia actual.

parh escribió:@PSX22 creo que debes cambiar un poco el chip. Las graficas de PC no son como las consolas. Me refiero a que dices que puedes alargar 4-5 años una 4070... no lo veo la verdad, en menos de 2 años (por no decir año y medio) a una 4070 ya se le empezaran a ver las costuras, y en 5 años como tu dices , ya ni te digo, tendrias que bajar tanto los settings a los juegos que no valdria la pena con respecto a su version consola (que se supone que estamos en PC gaming porque nos gusta jugar con una calidad notoriamente superior a la de la consola de turno)

Rvilla87 escribió:parh escribió:@PSX22 creo que debes cambiar un poco el chip. Las graficas de PC no son como las consolas. Me refiero a que dices que puedes alargar 4-5 años una 4070... no lo veo la verdad, en menos de 2 años (por no decir año y medio) a una 4070 ya se le empezaran a ver las costuras, y en 5 años como tu dices , ya ni te digo, tendrias que bajar tanto los settings a los juegos que no valdria la pena con respecto a su version consola (que se supone que estamos en PC gaming porque nos gusta jugar con una calidad notoriamente superior a la de la consola de turno)

Estás definiendo el típico caso de ultritis. Si tienes ese "problema" (porque parece que os obligue a cambiar de gráfica y no sepáis jugar en otra config diferente a ultra), es evidente que se debe cambiar el chip. Ahora, si no tienes ese "problema" puedes alargar las gráficas mas de lo que piensas.

La de gente que ha estirado por ejemplo las 970GTX o las 1060GTX sin problema... y hablo al menos de mi caso con la 970GTX, que no juego a competitivos y sin poder tener reescalado ni frame generator aguanté 6 años (desde octubre 2015 hasta diciembre 2021). Pasé de empezar a jugar todo a 1080p en ultra a +60fps a terminar jugando a medio/alto (depende del juego) a unos 40fps.

Luego habláis de ejemplos como Alan Wake 2 como caso puntual de juego muy exigente ¿Es que acaso en consola creéis que está a 4k ultra con ray tracing o path tracing? Claro que no (info). Recuerdo hace unos meses ver la comparación de DF y menudos efectos cutrillos de reflejos debido al no RT que tenia en consola en el agua. La configuración con más calidad en consola comparado con PC es "Medio" con un par de apartados mas bajo todavía. Aquí lo explica DF (donde al principio explica la no-magia de las consolas), comparando su configuración optimizada de PC con el modo rendimiento (60fps) y calidad (30fps) de PS5: https://youtu.be/QrXoDon6fXs?t=686

Una cosa es que en consola salgan los juegos mas optimizados que en PC, y otra que en PC no puedas aguantar mas de 3 años con una misma gráfica competente (no hablo de comprarse una 3060 para jugar a 4k ultra a juegos exigentes).

Rvilla87 escribió:La de gente que ha estirado por ejemplo las 970GTX o las 1060GTX sin problema... y hablo al menos de mi caso con la 970GTX, que no juego a competitivos y sin poder tener reescalado ni frame generator aguanté 6 años (desde octubre 2015 hasta diciembre 2021). Pasé de empezar a jugar todo a 1080p en ultra a +60fps a terminar jugando a medio/alto (depende del juego) a unos 40fps.

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

kaiserphantom escribió:A mi me parece que a la mínima que te bajas del "ultra" una 4070 es gráfica de SOBRA para jugar los próximos 5 años a 1440p@60 a todos los títulos.

metalero24 escribió:Este año me he terminado (y apurando cada uno casi al 100% del contenido) el Alan Wake 2, Starfield y Howard's Legacy con una 6900xt, sin absolutamente ningún problema.

Mi truco es centrarme en disfrutar del juego, y nunca nunca poner el contador de frames visible.

Entiendo a quienes van a lo más top y me parece genial querer disfrutar de los mejores gráficos con cuántas más tecnologías de iluminación y demás mejor. Ves algunos mods "ultrarealistas" de CP2077 o el GTA5 o Minecraft y es flipante.

Y también entiendo a quienes simplemente quieren disfrutar de los juegos, actuales o no tanto, y no le dan tanta importancia a los gráficos.

En resumen, a cada uno le durará su gráfica lo que le venga en gana. Todo dependerá del gasto que esté dispuesto a afrontar para satisfacer su vicio.

En estos foros creo que lo normal es que abunde más el perfil entusiasta que busca lo más top, lo que puede provocar un sesgo en la percepción de lo que es más habitual, que está claro que no es cambiar de gráfica cada año - generación.

dicker31 escribió:metalero24 escribió:Este año me he terminado (y apurando cada uno casi al 100% del contenido) el Alan Wake 2, Starfield y Howard's Legacy con una 6900xt, sin absolutamente ningún problema.

Mi truco es centrarme en disfrutar del juego, y nunca nunca poner el contador de frames visible.

Entiendo a quienes van a lo más top y me parece genial querer disfrutar de los mejores gráficos con cuántas más tecnologías de iluminación y demás mejor. Ves algunos mods "ultrarealistas" de CP2077 o el GTA5 o Minecraft y es flipante.

Y también entiendo a quienes simplemente quieren disfrutar de los juegos, actuales o no tanto, y no le dan tanta importancia a los gráficos.

En resumen, a cada uno le durará su gráfica lo que le venga en gana. Todo dependerá del gasto que esté dispuesto a afrontar para satisfacer su vicio.

En estos foros creo que lo normal es que abunde más el perfil entusiasta que busca lo más top, lo que puede provocar un sesgo en la percepción de lo que es más habitual, que está claro que no es cambiar de gráfica cada año - generación.

Bueno,es que aunque ya no es una de las 2 o 3 graficas mas potentes del mundo como si fue lo en su salida,sigue siendo una gráfica media alta actual.Que tampoco es ningún hierro.Yo con una gráfica bastante peor(RX 6800)sigo jugando en buenas condiciones.

Al final a mi lo que me importa son los juegos.Me gusta que se vean lo mejor posible,claro...pero si un juego de verdad te divierte no estas mirando si la sombra de un candelabro está mas o menos realista.

aim_dll escribió:dicker31 escribió:metalero24 escribió:Este año me he terminado (y apurando cada uno casi al 100% del contenido) el Alan Wake 2, Starfield y Howard's Legacy con una 6900xt, sin absolutamente ningún problema.

Mi truco es centrarme en disfrutar del juego, y nunca nunca poner el contador de frames visible.

Entiendo a quienes van a lo más top y me parece genial querer disfrutar de los mejores gráficos con cuántas más tecnologías de iluminación y demás mejor. Ves algunos mods "ultrarealistas" de CP2077 o el GTA5 o Minecraft y es flipante.

Y también entiendo a quienes simplemente quieren disfrutar de los juegos, actuales o no tanto, y no le dan tanta importancia a los gráficos.

En resumen, a cada uno le durará su gráfica lo que le venga en gana. Todo dependerá del gasto que esté dispuesto a afrontar para satisfacer su vicio.

En estos foros creo que lo normal es que abunde más el perfil entusiasta que busca lo más top, lo que puede provocar un sesgo en la percepción de lo que es más habitual, que está claro que no es cambiar de gráfica cada año - generación.

Bueno,es que aunque ya no es una de las 2 o 3 graficas mas potentes del mundo como si fue lo en su salida,sigue siendo una gráfica media alta actual.Que tampoco es ningún hierro.Yo con una gráfica bastante peor(RX 6800)sigo jugando en buenas condiciones.

Al final a mi lo que me importa son los juegos.Me gusta que se vean lo mejor posible,claro...pero si un juego de verdad te divierte no estas mirando si la sombra de un candelabro está mas o menos realista.

Toda persona que tenga una grafica de la serie 2000 de nvidia o de la 5000 de amd no debe de cambiar de grafica hasta que salga la siguente gen...si es que juega a 1080p claro

Yo voy a aguantar la 3060ti aunque ya me estoy encontrando juegos donde la vram le falta pero no voy a pasar por el aro y si amd saca algo majo en el rango de la gama media nvidia no me vuelve a ver el pelo en un tiempo

Se raja mucho de los drivers de amd pero los de nvidia...tengo un libro para rajar de esos drivers

aim_dll escribió:@dicker31 Bueno eh...

De primeras te encuentras que nvidia experencie y el panel de control son dos apps distintas...luego si quiero usar nvidia experence me tengo que loguear...es decir si quiero grabar algo o es haciendo login o nada...luego el panel de control de nvidia necesita un repaso, es como pillar un delorean y volver a w95 y luego yo personalmente tengo un problema la mar de gracioso, cuando tengo las dos pantallas encendidas a veces tengo un pantallazo negro en los dos monitores de un segundo y vuelve(el log de windows me tira un crash del driver)

Amd tiene otros problemas pero al menos el driver es en una sola app y es mas vistoso

He estado con las dos marcas y a mi a nivel de driver me dio menos problemas la 480 que la 3060ti

dicker31 escribió:aim_dll escribió:@dicker31 Bueno eh...

De primeras te encuentras que nvidia experencie y el panel de control son dos apps distintas...luego si quiero usar nvidia experence me tengo que loguear...es decir si quiero grabar algo o es haciendo login o nada...luego el panel de control de nvidia necesita un repaso, es como pillar un delorean y volver a w95 y luego yo personalmente tengo un problema la mar de gracioso, cuando tengo las dos pantallas encendidas a veces tengo un pantallazo negro en los dos monitores de un segundo y vuelve(el log de windows me tira un crash del driver)

Amd tiene otros problemas pero al menos el driver es en una sola app y es mas vistoso

He estado con las dos marcas y a mi a nivel de driver me dio menos problemas la 480 que la 3060ti

Si,hombre.Yo hablo de estabilidad.Que el panel de nvidia necesita un rediseño está claro.Pero para que te hagas una idea.Cuando compre mi tv resulta que no me funcionaba VRR.Bueno vale,voy a escribir a Sony a ver que me dicen...y Sony me contesta que en las LG y otras marcas tampoco funciona,que no es cosa suya.Bueno,pues na,voy a darles la vara a AMD...Pues me contestan diciendome que son conscientes del problema y que estará proximamente solucionado.Pasan los meses,los drivers y la cosa sigue igual.Les vuelvo a escribir y me contestan que están trabajando en ello...que proximamente estará resuelto...y lo resolvieron.Lo unico es que solo tardaron 8 meses.

![brindis [beer]](/images/smilies/nuevos2/brindando.gif) y tanto el Low Spec Gamer y el Máster Race están bien si se divierten.

y tanto el Low Spec Gamer y el Máster Race están bien si se divierten. Gnoblis escribió:Lo bonito de PC es que puedes jugar y/o cacharrear como quieres y hasta donde te de el presupuesto

¿Qué tienes ultritis puedes cambiar la gráfica cada año porque la serie anterior ya no es la más top? Pues adelante

¿Qué quieres hacer correr el juego en el hardware más viejo que puedas? Adelante, hasta modificando archivos de configuración del juego o metiéndole mods de FSR si hace falta.

La PC permite ambos extremos y todos los puntos intermediosy tanto el Low Spec Gamer y el Máster Race están bien si se divierten.

Gnoblis escribió:Lo bonito de PC es que puedes jugar y/o cacharrear como quieres y hasta donde te de el presupuesto

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)

rubencbr escribió:Ja, ja, ja.

Pues yo sigo con mi GTX1080 a 1440p, 60 fps y el RE4 Remake lo mueve de lujo, obviamente bajando algún parámetro pero ahí sigue la Pascal dando la talla.

GF3 escribió:espero que me dure al menos 6 años también.

Nomada_Firefox escribió:GF3 escribió:espero que me dure al menos 6 años también.

Pues lo dudo muchisimo si juegas al top 20. La GTX 1080, fue una grafica que como toda la serie 10, tuvo un salto bastante significativo de rendimiento por la llegada de ciertos productos de VR que requerian más chicha. Y luego sí, se ha ido sacando graficas cada 2 años más potentes pero ya no fue tan significativo como para que la GTX 1060 rindiera como una GTX 980. Y ahora sucede que los juegos han aumentado el uso de memoria y de tarjeta grafica porque estamos al final de la vida de las actuales consolas, practicamente casi esperando a las siguientes, asi que de aqui a 2 años van a salir unos juegos muy exigentes.

Asi que tendrias que ser alguien como yo, jugando a cosas más viejunas. De juegos de este año pasado, solo jugare al de Avatar y cuando lo haga puede ser dentro de un año tranquilamente o más. Todavia empece a jugar al Red Dead Redemtion el año pasado y aún no lo termine. Así, si dura una grafica.

practicamente casi esperando

Nomada_Firefox escribió:Y mirando esa tecnologia, no se puede uno imaginar que las consolas de ahora vayan a durar 7 años en el mercado en un mundo donde las CPUs mejoran un 20% cada año y las GPUs el doble cada 2. Han pasado ya varias generaciones. No estamos en 2013, estamos en 2024, la tecnologia y lo que se puede hacer en un juego, esta como esta, pidiendo más.

Wookiee escribió:Nomada_Firefox escribió:GF3 escribió:espero que me dure al menos 6 años también.

Pues lo dudo muchisimo si juegas al top 20. La GTX 1080, fue una grafica que como toda la serie 10, tuvo un salto bastante significativo de rendimiento por la llegada de ciertos productos de VR que requerian más chicha. Y luego sí, se ha ido sacando graficas cada 2 años más potentes pero ya no fue tan significativo como para que la GTX 1060 rindiera como una GTX 980. Y ahora sucede que los juegos han aumentado el uso de memoria y de tarjeta grafica porque estamos al final de la vida de las actuales consolas, practicamente casi esperando a las siguientes, asi que de aqui a 2 años van a salir unos juegos muy exigentes.

Asi que tendrias que ser alguien como yo, jugando a cosas más viejunas. De juegos de este año pasado, solo jugare al de Avatar y cuando lo haga puede ser dentro de un año tranquilamente o más. Todavia empece a jugar al Red Dead Redemtion el año pasado y aún no lo termine. Así, si dura una grafica.

Hace poco mas de 3 años del lanzamiento de las nuevas consolas ¿y ya consideras que estamos esperando a las nuevas? Es más, acaban de lanzar la primera revisión seria de ps5...

XBOX 360 unos 8 años

PS3 unos 7 (con revisión a la mitad de su vida)

XBOX ONE 7 años (con revisión a la mitad de su vida)

PS4 7 años (con revisión a la mitad de su vida)

No se... yo diría que teniendo en cuenta todo ello estaríamos llegando ahora a la mitad de su vida.

pero el tiempo de los desarrollos lo esperamos igual.

pero el tiempo de los desarrollos lo esperamos igual.hh1 escribió:Todo depende.

Xbox por lo visto,va a sacar su nueva consola ya en 2026.

Nomada_Firefox escribió:Yo prefiero jugar todo en ultra y por encima de 60fps. No me he comprado un monitor gaming para no usarlo. Hasta uso distintos perfiles de color dependiendo de a que juegue. Tampoco me duele usar el FSR, DLSS o lo que haga falta.

Respecto a las consolas actuales. Escribi.practicamente casi esperando

¿Cuando empezamos a saber de las PS5 y Xbox? Tiempo antes de que fueran lanzadas en 2020 y salieron con muchisimo retraso. Se podria facilmente decir que salieron con algo más de un año de retraso y claramente con tecnologia del 2019 o antes.

Y mirando esa tecnologia, no se puede uno imaginar que las consolas de ahora vayan a durar 7 años en el mercado en un mundo donde las CPUs mejoran un 20% cada año y las GPUs el doble cada 2. Han pasado ya varias generaciones. No estamos en 2013, estamos en 2024, la tecnologia y lo que se puede hacer en un juego, esta como esta, pidiendo más.

hh1 escribió:Wookiee escribió:

Hace poco mas de 3 años del lanzamiento de las nuevas consolas ¿y ya consideras que estamos esperando a las nuevas? Es más, acaban de lanzar la primera revisión seria de ps5...

XBOX 360 unos 8 años

PS3 unos 7 (con revisión a la mitad de su vida)

XBOX ONE 7 años (con revisión a la mitad de su vida)

PS4 7 años (con revisión a la mitad de su vida)

No se... yo diría que teniendo en cuenta todo ello estaríamos llegando ahora a la mitad de su vida.

Todo depende.

Xbox por lo visto,va a sacar su nueva consola ya en 2026.

Gnoblis escribió:Bueno, eso de que las graficas doblan potencia cada dos años es matizable, a lo mejor la serie 90 si pero te bajas de la tope de gama y los incrementos se reducen y se reducen. El salto en la serie 60 ha sido ridículo