garbaje_de_potanzos escribió:

Si, ese ya tiene mejor pinta. ¿No os da la impresión tambien que muchos juegos por no decir todos no estan pensados para estas resoluciones y fps? yo lo llamaria el efecto consola, los juegos estan diseñados para mantener tasas de 30/60 fps y al pasarlos a PC solo los desbloquean pero siguen teniendo un alto grado de bloqueo.

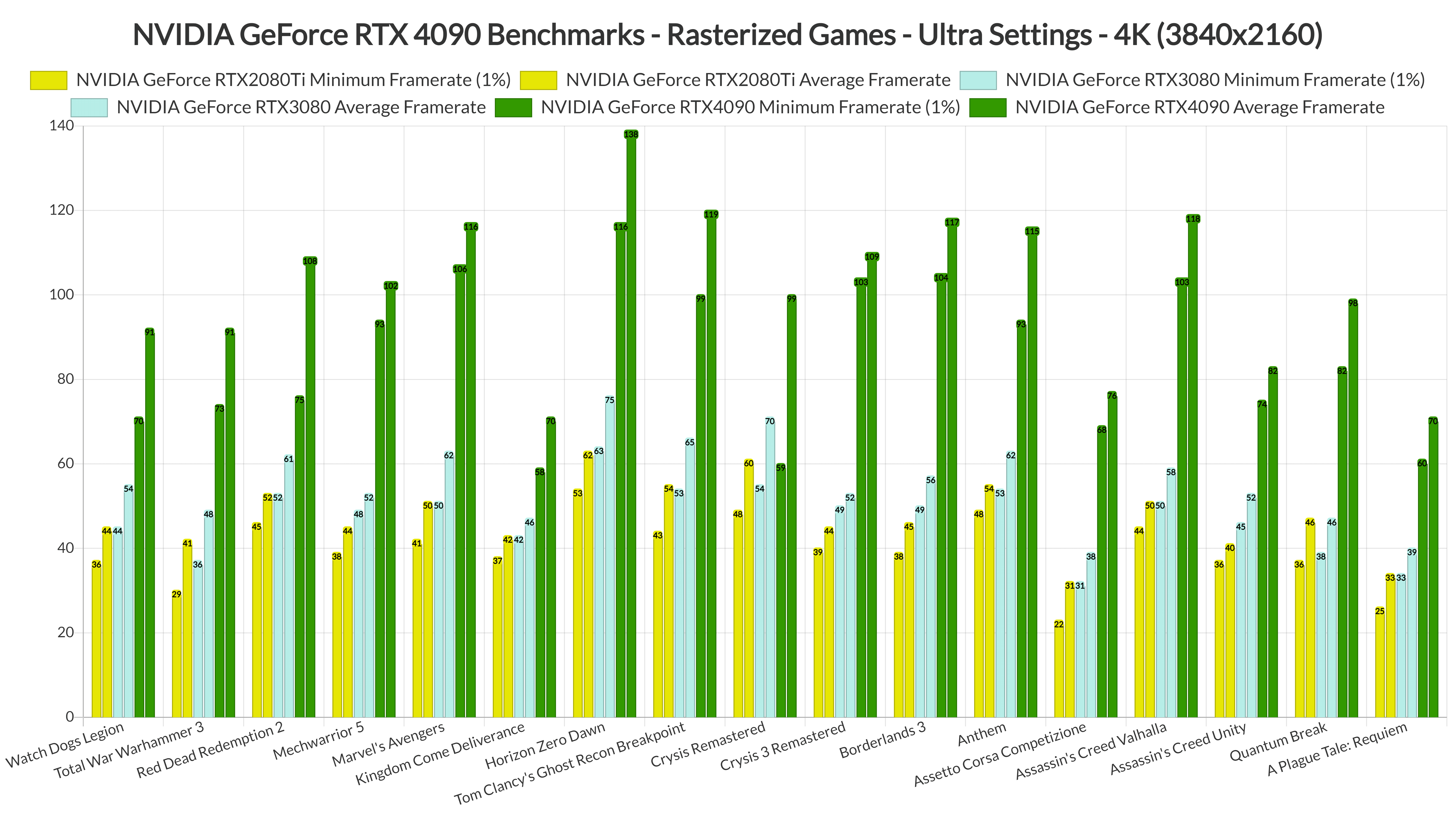

@jacklolita les quitas el DLSS y sobretodo el 3 y no es para tanto. Ademas no olvidemos lo comentado, usar DLSS no es mejor en calidad que no usarlo. Aunque no niego que el ultimo ha mejorado mucho. Asi que en las RTX 40 pagas el software y el hardware no es para tanto, me recuerda a Creative y sus tarjetas de sonido.

@LynX La 4060 por regla de 3, es una grafica de 1080p. A esa resolución, la gracia es no usar DLSS para mantener el maximo de calidad grafica. Como casi seguro sea como una 3060Ti o 3070, pues practicamente podemos saber que sucedera. Eso sí, no niego que puede interesar el usar el DLSS 3 a 1440p.

@Valhan muy bueno eso de la versión hacendado

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)

¿A que resolución juegas?

Con tu comentario de la vram, pienso que les quitas el software de Nvidia y por hardware estas graficas son pauperrimas si las comparas con una Intel A770 con 16gb de memoria. Ironicamente Intel no tiene software bueno.

@beatle ¿Tantos fps hay entre esas dos CPUs? ese juego tenia unos requisitos gordisimos, debe ser el rey de la trampa grafica.