Kalakatita escribió:Yo no soy experto, pero desde luego los ingenieros de Nvidia seguro que sí lo son. Indudablemente mucho mas que todos los que estamos aquí. Asi pues, confio en que no se quede toda una 3080 corta de VRAM por un “descuido” o simplemente por tacañeria. Estas gráficas estan diseñadas para lo que se viene, que sin ser para nada consolero, si que considero que son las consolas las que marcan lo que vamos a poder ver graficamente esta proxima gen. Evidentemente mejorado en pc, mejoradisimo en ocasiones, a mayor resolucion y fps.. Pero al final las consolas “dicen” cuando empieza una nueva gen y cuando no. Asi esta el mercado.

Asi que si Nvidia ha sacado estas graficas, habran tenido en cuenta cientos de factores que nosotros ignoramos y por ello, por mi parte, tienen mi confianza.

Nowcry escribió:josemurcia escribió:Nowcry escribió:Y por otro lado la diferencia de memoria 14 de GDDR (memoria dedicada para juegos segun rumores de PS5) vs 8 gb de GDDR es demasiado grande para que no afecte a las texturas, la iluminación la 3070 va a ser la ganadora pero sinceramente en texturas y detalles va a ser bastante mierdera en comparacion.

Un saludo.

Claro, porque todo el mundo sabe que la memoria solo la utiliza la GPU.

Nooo lo pone bien 14 GB de GDDR, he restado los 2 GB reservados para el sistema. Siquires mete 1 Gb mas para procesos del juego o incluso mete dos.

hablamos de 12 GB vs 8 GB me parece bastante normal lo que se esta comentando.

@battman80 A ver por donde sale AMD, espero que puedan ser competitivos si tenemos estos precios es por ellos. Aunque nunca he sido muy pro AMD por malas experiencias en el pasado. Se que estan mejorando bastante.

@hh1 En potencia esta perfectas pero cambio de consolas con mas VRAM, logicamente se necesita mas VRAM.

@josemurcia tecnologia nueva, ahora ya me la he estudiado.

![facepalm [facepalm]](/images/smilies/facepalm.gif) , ahora por lo visto va a sacar dos versiones de cada una de sus tres gpus, una con gddr6 y la otra con hbm2

, ahora por lo visto va a sacar dos versiones de cada una de sus tres gpus, una con gddr6 y la otra con hbm2 ![facepalm [facepalm]](/images/smilies/facepalm.gif) .

.![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif) ), dicen, al menos las gddr6. No puedo evitar recordar el sangrante caso de la 580 de 8gbs y la 1060 de 6gbs,...

), dicen, al menos las gddr6. No puedo evitar recordar el sangrante caso de la 580 de 8gbs y la 1060 de 6gbs,... ![idea [idea]](/images/smilies/nuevos2/idea.gif) .

. josemurcia escribió:Nowcry escribió:josemurcia escribió:Claro, porque todo el mundo sabe que la memoria solo la utiliza la GPU.

Nooo lo pone bien 14 GB de GDDR, he restado los 2 GB reservados para el sistema. Siquires mete 1 Gb mas para procesos del juego o incluso mete dos.

hablamos de 12 GB vs 8 GB me parece bastante normal lo que se esta comentando.

@battman80 A ver por donde sale AMD, espero que puedan ser competitivos si tenemos estos precios es por ellos. Aunque nunca he sido muy pro AMD por malas experiencias en el pasado. Se que estan mejorando bastante.

@hh1 En potencia esta perfectas pero cambio de consolas con mas VRAM, logicamente se necesita mas VRAM.

@josemurcia tecnologia nueva, ahora ya me la he estudiado.

¿2GB para todos los procesos de la CPU? No se en que mundo vives, pero la CPU y la RAM van a tener mucho más peso esta generación que en la anterior, la GPU con la nueva I/O no necesita tanta memoria, y por algo NVIDIA ha metido "solo" 8 y 10GB en sus gamas altas.

Y habrás estudiado lo que quieras, que ni tu ni ninguno de nosotros sabemos como está implementado RTX I/O y ya estás diciendo que no puede ser igual de bueno que el de PS5 en base a invenciones tuyas.

Nowcry escribió:Solo se que el ancho de banda máximo pico teniendo en cuenta compresión es de 14 GB/s con eso ya se como compararlo.

Eilex_D escribió:Sería mucha locura pillar una 3080 para jugar 1080p 75hz con todo en ultra y que me aguantase bastantes años?

Garbans escribió:gunman1976 escribió:

Que dios te conserve la vista porque el gusto te empieza a fallar.

En cualquier caso a mi esta no me llama porque voy a por la Watercooled.

A ver cuando publican precios y disponibilidad.

P.D.: Es coña lo de arriba. Como dicen algunos para gustos los colores o las opiniones son como los culos, todo el mundo tenemos uno.

Es que EVGA tiene 4 modelos de los cuales 2 son watercooled

https://www.evga.com/articles/01434/evg ... 30-series/

adriano_99 escribió:Eilex_D escribió:Sería mucha locura pillar una 3080 para jugar 1080p 75hz con todo en ultra y que me aguantase bastantes años?

Ningún juego a 1080p va a aprovechar toda la potencia de una 3080 en mas tiempo del que tardará en salir una 4070 mejor y mas barata.

Lo veo una muy muy mala compra para esa resolución.

Incluso a 1440p 75hz lo veo demasiado.

KindapearHD escribió:Estoy viendo las customs y joder, que feas son. Un paso atrás respecto a las 2000. La mayoría horribles.

josemurcia escribió:Nowcry escribió:Solo se que el ancho de banda máximo pico teniendo en cuenta compresión es de 14 GB/s con eso ya se como compararlo.

El ancho de banda máximo y constante son 7Gbps que es lo que dan los NVMe nuevos sobre PCIe4, punto.

PS5 tiene 5.5 y Xbox Series X 2.4, no hay más.

Los ratios de compresión sin pérdida es 2:1 para todas, que es lo que ofrecen los algoritmos actuales, y por eso son 14Gbps de media al igual que en PS5 son 9 y en Series X son 4.8, nada de pico.

gojesusga escribió:adriano_99 escribió:Eilex_D escribió:Sería mucha locura pillar una 3080 para jugar 1080p 75hz con todo en ultra y que me aguantase bastantes años?

Ningún juego a 1080p va a aprovechar toda la potencia de una 3080 en mas tiempo del que tardará en salir una 4070 mejor y mas barata.

Lo veo una muy muy mala compra para esa resolución.

Incluso a 1440p 75hz lo veo demasiado.

No estoy de acuerdo, puedes jugar a 1080p subido el antialising a tope o el DSR a tope o combinación de ambos

battman80 escribió:No puedo evitar recordar el sangrante caso de la 580 de 8gbs y la 1060 de 6gbs,....

sitosnk escribió:sobre el tema de memoria no se como ira, pero si una xbox series s para 1440p monta 10gb en total un pc con 16gb de ram y 8gb de vram ha de tener suficiente para 1440p y 10gb para 4k deberian ir biren.

al menos apriori

pero en pocos meses se vera todo

saludos

adriano_99 escribió:Eilex_D escribió:Sería mucha locura pillar una 3080 para jugar 1080p 75hz con todo en ultra y que me aguantase bastantes años?

Ningún juego a 1080p va a aprovechar toda la potencia de una 3080 en mas tiempo del que tardará en salir una 4070 mejor y mas barata.

Lo veo una muy muy mala compra para esa resolución.

Incluso a 1440p 75hz lo veo demasiado.

Wanderlei escribió:adriano_99 escribió:Eilex_D escribió:Sería mucha locura pillar una 3080 para jugar 1080p 75hz con todo en ultra y que me aguantase bastantes años?

Ningún juego a 1080p va a aprovechar toda la potencia de una 3080 en mas tiempo del que tardará en salir una 4070 mejor y mas barata.

Lo veo una muy muy mala compra para esa resolución.

Incluso a 1440p 75hz lo veo demasiado.

para 1440p 170hz lo verias bien? o mejor esperar a las ti por el tema de la vram?

Nowcry escribió:No hombre no 7 GB/s es el pico máximo de 4 canales de PCIeGen4. Con compresión en pico máximo son 14 GB/s teniendo en cuenta compresión de texturas de alto rendimiento,se espera un rendimiento sostenido de 5-8 GB/s compresión metida. Esta perfecta no hace falta mucho mas. Pero anda lejos de los 22GB/s de pico de PS5 sin tener en cuenta oddle textures y 9 GB/s sostenido sin compresión de texturas de alto rendimiento posiblemente se lleguen a 11GB/s con Odde textures. Pero esas diferencias solo se explotaran por los estudios 1st de sony.

El resto se adecuara a lo que permita realmente PCIeGen4x con configuraciones a PCIeGen3 mediante opciones para adecuarse a la penetración del mercado. Al menos hasta finales de 2021- mediados 2022 que PCieGen5 salga debido al empuje de I/O como garante gráfico. A partir de ahí ya nadie tosera a PC en ningún apartado.

ayran escribió:KindapearHD escribió:Estoy viendo las customs y joder, que feas son. Un paso atrás respecto a las 2000. La mayoría horribles.

+1000 Gran parte por esto voy a ir a por una FE. Me parecen muy sobrias.

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)

Blackpo92 escribió:Una duda compis, ésto del nuevo cable de 12 pines lleva un adaptador o como funciona? adaptas 2 de 6 al de 12 o cómo?

Un saludo

Blackpo92 escribió:En cuanto a vatios, sabéis más o menos que fuente se necesita para una 3070-3080?

Salu2

Blackpo92 escribió:En cuanto a vatios, sabéis más o menos que fuente se necesita para una 3070-3080?

Salu2

Nowcry escribió:sitosnk escribió:sobre el tema de memoria no se como ira, pero si una xbox series s para 1440p monta 10gb en total un pc con 16gb de ram y 8gb de vram ha de tener suficiente para 1440p y 10gb para 4k deberian ir biren.

al menos apriori

pero en pocos meses se vera todo

saludos

Depende de para cuanto tiempo tiempo quieres que te dure la GPU, si me dices que con un par de años te vale creo que no tendras problema. Si la quieres para 5 años o los 7 años de Gen, simplemente no creo que se pueda conseguir sin recucir de forma significativa las experiencias graficas.

Ni yo sé si esto está escrito de forma irónica o es un resumen objetivo.

descoat escribió:He estado viendo los modelos de todos los fabricantes, pero en ningún lado han especificado la cantidad de Vram que llevarán. Es extraño. Por ahora sólo sabemos los de las Founder.

Por cierto, me ha gustado bastante lo que ha sacado nividia. Mi modelo va a ser la 3080 rtx con bloque de agua. Esperemos que vengan más modelos de los que vino con la serie 20xx ya que a penas estaba el bloque de agua EK de MSI en la 2080 y 2080 ti.

Por otro lado, también tenemos que ser cautos con el % de problemas de hardware ya que ese proceso de fabricación de samsung 7nm no está muy pulido.

Antoniopua escribió:¿Estais seguros de que las Customs se van a ir mucho de precio esta vez? Tengo dudas de que solo se vayan 100 Euros a lo máximo y no se porque... Comprar ahora una 2080 Ti, es buena compra dependiendo de la configuración a la que se juegue. Esa gráfica era para 4k y mínimo 2k, por tanto comprarla barata pero jugar por debajo de la resolución para la que fue creada lo veo caro. Yo personalmente hubiese esperado a la 3070.

josemurcia escribió:Nowcry escribió:No hombre no 7 GB/s es el pico máximo de 4 canales de PCIeGen4. Con compresión en pico máximo son 14 GB/s teniendo en cuenta compresión de texturas de alto rendimiento,se espera un rendimiento sostenido de 5-8 GB/s compresión metida. Esta perfecta no hace falta mucho mas. Pero anda lejos de los 22GB/s de pico de PS5 sin tener en cuenta oddle textures y 9 GB/s sostenido sin compresión de texturas de alto rendimiento posiblemente se lleguen a 11GB/s con Odde textures. Pero esas diferencias solo se explotaran por los estudios 1st de sony.

El resto se adecuara a lo que permita realmente PCIeGen4x con configuraciones a PCIeGen3 mediante opciones para adecuarse a la penetración del mercado. Al menos hasta finales de 2021- mediados 2022 que PCieGen5 salga debido al empuje de I/O como garante gráfico. A partir de ahí ya nadie tosera a PC en ningún apartado.

¿Ves como no tienes ni idea y te lo inventas todo?

Los 14 Gbps efectivos son los mismos que los 9 de PS5 y los 4.8 de XSX, punto. Porque todos los algoritmos de compresión sin pérdida actuales rondan el ratio 2:1, DEFLATE y Kraken un poco menos de 2:1 y BCPack un poco más, pero al final todos rondan lo mismo.

La compresión se hace offline y los juegos vienen comprimidos como vienen, que hablas como si la compresión se hiciera en tiempo real. Y la descompresión se hace en hardware, por lo tanto los picos son porcentualmente los mismos para todos. Insisto, el mismo bloque de assets va a ocupar comprimido lo mismo +-10% en PC, PS5 y XSX, y el ancho de banda efectivo es el del canal, por lo tanto la tasa de transferencia será proporcional al ancho de banda, no hay magia aquí.

Oodle Textures se puede utilizar también en PC y XSX, porque va antes de la compresión en bloque, y las mejoras son las mismas que usarlo en PS5.

Oodle Textures se puede utilizar también en PC y XSX, porque va antes de la compresión en bloque, y las mejoras son las mismas que usarlo en PS5.

Fernialonso88 escribió:Pues yo fui uno de los polletes q compró una 2080 super en julio, creyendo q saldrian carisimas las amparito, y vaya maldita sorpresa! !

De todas maneras, como a muchos otros del foro, el tema de la vram de la 3080 q es la q me llamaba la atencion por la relacion precio/potencia, me hecha totalmente para atras y me hace olerme una version ti o super para principios d 2021, con mas vram, o eso espero.

Creo q aguantare y ya de paso la amortizaré, pq vaya palo nos han pegado a los tontos como yo, q compramos una 2080super, ya ni te cuento a los de la 2080ti, caguen tooo......!!!!

ikemen escribió:Quisiera intervenir con un apunte para todos los que piensan que la Vram se puede quedar corta, hay que tener en cuenta, que Ampere viene sobrada de Tensor Cores. Dichos tensor cores se usan para comprimir y descomprimir datos, que pueden reducir la memoria de Video (VRAM) entre un 20-40%. Así que en teoría los 8GB de la 3070 rendirían como los 11GB de la 2080ti. Y los 10GB de la 3080 podrían ser equivalentes a 14GB de la gen anterior.

ikemen escribió:Quisiera intervenir con un apunte para todos los que piensan que la Vram se puede quedar corta, hay que tener en cuenta, que Ampere viene sobrada de Tensor Cores. Dichos tensor cores se usan para comprimir y descomprimir datos, que pueden reducir la memoria de Video (VRAM) entre un 20-40%. Así que en teoría los 8GB de la 3070 rendirían como los 11GB de la 2080ti. Y los 10GB de la 3080 podrían ser equivalentes a 14GB de la gen anterior.

Nowcry escribió:Venga voy a jugar tu juego.

Vale todos los algoritmos de compresion sin perdida rondan el ratio 2:1, puesto que la capacidad de trasferencia de PS5 es de 5,5 GB/s en RAW le corresponden 11 GB/s de comprimido con un ratio 2:1 (gracias a oddle textures) y no 9 como ya te he comentado mas arriba.Oodle Textures se puede utilizar también en PC y XSX, porque va antes de la compresión en bloque, y las mejoras son las mismas que usarlo en PS5.

Claro pero ya ha sido tenida en cuenta con el ratio 2:1 excepto en PS5. Que en Road to PS5 los ratios ofrecidos son sin Oddle Textures porque aun no habia completado su desarrollo. Ya que fue presentado semanas despues.

Nowcry escribió:En cuanto al SSD a ver como te respondo:

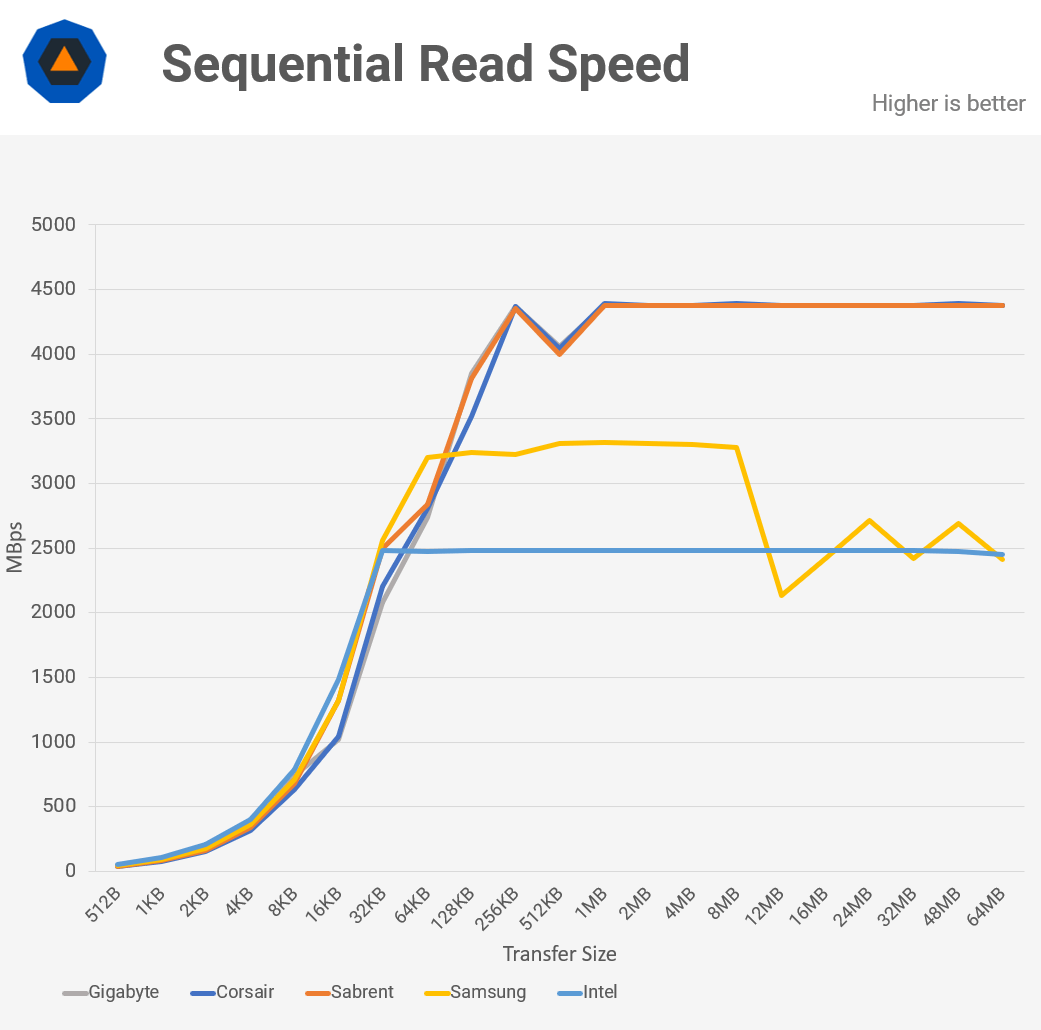

Esto es un benchmark de un Samsung 970 Pro SSD PCIeGen3 cuyo maximo teorico se encuentra en 4 GB/s pero el máximo teórico alcanzado se sitúa realmente en 3,5 GB/s y como finalmente solo es capaz de mantenerlos en picos observa lo que hace el amarillo que es el Samsung 970 Evo con los canales saturados en lectura secuencial PCIeGen3.

Puedes observar como en lectura secuencial el SSD cae hasta los 2500 MB/s, ya no hablemos con lecturas aleatorias. No los canales PCIeGen4 saturados a los 7GB/s no son sostenibles en el tiempo. Ni tampoco aproximables. Si te fijas en cualquier bechmark o SSD de Gen 3 como aclaracion dire que tanto el azul como el naranja son PCIeGen4 y son capaces de sostener 5 GB/s porque los canales aun no estan saturados, pero el comportamiento sera el mismo cuando saturen.

Durante un tiempo pico se sostiene y luego cae por interrupciones del sistema.

Y todo esto haciendo un benchmark SSD to CPU read, no quieras imaginar lo que vas a encontrar agregando una capa de abstracción superior RTX IO y metiendo un proceso de descompresión de por medio.

Enserio deja de acusar de inventar y revisa tus conocimientos.

Un saludo.

Atto Disk Benchmark

One of the finest tools available to measure storage performance is ATTO. I love it to death as it is so reliable and produces such accurate results. The great thing about ATTO is that we can test with predefined block sizes. So we can test with a 32 MB sequence of 4 KB files, yet also 32 MB in 1 MB files. This gives us an excellent scope of overall performance with small and large files.

Pulet escribió:

Pues si eso es cierto, en el doom no veo casi el doble de diferenca eh, como mucho un 40% más.

Pulet escribió:

Pues si eso es cierto, en el doom no veo casi el doble de diferenca eh, como mucho un 40% más.

![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

Pulet escribió:

Pues si eso es cierto, en el doom no veo casi el doble de diferenca eh, como mucho un 40% más.

Valhan escribió:Pulet escribió:

Pues si eso es cierto, en el doom no veo casi el doble de diferenca eh, como mucho un 40% más.

Aparte de lo que te han comentado, he leido que debe ser fake, ya que el que ha subido el video parece que solo tiene videos con hardware de "baja categoria", y se preguntan de done ha sacado una 3080 para hacer las pruebas.