jiujinkai escribió:oskilla84 escribió:Supongo que una 3090 junto a un 7700k seria una locura,verdad?

No entiendo por qué? Yo voy a pillarme al final la 3090 con un 8700k, yo creo que estos procesadores son más que suficientes.

![loco [mad]](/images/smilies/nuevos/miedo.gif) es normal que la gente acabe dudando

es normal que la gente acabe dudandoalvaro200 escribió:Sacado de la propia Nvidia en reddit, hablando sobre el tema de la VRAM:Why only 10 GB of memory for RTX 3080? How was that determined to be a sufficient number, when it is stagnant from the previous generation?

[Justin Walker] We’re constantly analyzing memory requirements of the latest games and regularly review with game developers to understand their memory needs for current and upcoming games. The goal of 3080 is to give you great performance at up to 4k resolution with all the settings maxed out at the best possible price.

In order to do this, you need a very powerful GPU with high speed memory and enough memory to meet the needs of the games. A few examples - if you look at Shadow of the Tomb Raider, Assassin’s Creed Odyssey, Metro Exodus, Wolfenstein Youngblood, Gears of War 5, Borderlands 3 and Red Dead Redemption 2 running on a 3080 at 4k with Max settings (including any applicable high res texture packs) and RTX On, when the game supports it, you get in the range of 60-100fps and use anywhere from 4GB to 6GB of memory.

Extra memory is always nice to have but it would increase the price of the graphics card, so we need to find the right balance.

Fuente

wildchild_bcn escribió:jiujinkai escribió:oskilla84 escribió:Supongo que una 3090 junto a un 7700k seria una locura,verdad?

No entiendo por qué? Yo voy a pillarme al final la 3090 con un 8700k, yo creo que estos procesadores son más que suficientes.

si miras el hilo verás que la gente está diciendo que prácticamente necesitas un 3900 para que valga la pena una 3080 o una 3090es normal que la gente acabe dudando

incluso con un 6700 tiraría bien dependiendo de la resolución y del framerate al que se quiera llegar

![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

Lemmiwinks escribió:pdriko31 escribió:Copio y pego la contestación de Nvidia sobre la Vram:

Serie RTX 30

¿Por qué solo 10 GB de memoria para RTX 3080? ¿Cómo se determinó que era un número suficiente, cuando está estancado de la generación anterior?

[Justin Walker] Analizamos constantemente los requisitos de memoria de los juegos más recientes y los revisamos periódicamente con los desarrolladores de juegos para comprender sus necesidades de memoria para los juegos actuales y futuros. El objetivo de 3080 es brindarle un gran rendimiento con una resolución de hasta 4k con todas las configuraciones al máximo al mejor precio posible.

Para hacer esto, necesita una GPU muy potente con memoria de alta velocidad y suficiente memoria para satisfacer las necesidades de los juegos. Algunos ejemplos: si nos fijamos en Shadow of the Tomb Raider, Assassin's Creed Odyssey, Metro Exodus, Wolfenstein Youngblood, Gears of War 5, Borderlands 3 y Red Dead Redemption 2 ejecutándose en un 3080 a 4k con la configuración máxima (incluida cualquier alta aplicable res texturas) y RTX On, cuando el juego lo admite, obtienes un rango de 60-100 fps y usas desde 4GB hasta 6GB de memoria.

Siempre es bueno tener memoria adicional, pero aumentaría el precio de la tarjeta gráfica, por lo que debemos encontrar el equilibrio adecuado.

Y cuanto mas hubiera costado sacar una 3080 con 16gb y una 3070 con 12gb? 50€ mas? Yo creo que hubiera sido mucha mejor opcion.

Yo aqui solo veo una estrategia por parte de nvidia para las futuras ti con mas vram. Cada nuevas graficas hay que vender el hype, y esta generacion ha sido la potencia bruta

palet escribió:Y de las 3060 se sabe algo?

jmjayme escribió:PREGUNTA IMPORTANTE

Hola, hoy me llega mi nueva MSI 1660 Super, tengo el equipo algo desfasado ya y en el foro me recomendaron que cambiara las memos y la gráfica (tenía una GTX 950) y ya con eso renovaba un añito el PC. En realidad no me hace mucha falta, yo juego en consola, pero quería ugar al Flight Simulator y de paso subir la calidad a los otros pocos juegos que tengo en PC como Anno 1800, Planet Zoo, los Total War...)

Por eso lo que mas me interesaba es que fuera silenciosa (uso el pc sbre todo para navegar), no consuma mucho (mi fuente tiene 400W) y moderadamente potente. Pues justo hoy cuando me llega me dicen en el hilo que devuelva la 1660 y me espere a la Ampere de 500 pavos.

¿QUE HAGO?

i3rk escribió:Pregunta para entendidos.

Voy pensando jubilar mi 2070 (normal, no super) por una 3080. Sobre todo la quiero para poder rular en 2k ultra a 60fps cosas de next gen y VR (Actualmente hay algunos juegos que van justos). Iba a aguantar con la 2070 unos años más, pero si de verdad dicen que la 3080 tiene más rendimiento que una 2080 ti, no me lo pienso (No sé si esto será verdad).

Ahora, tengo un i7 8800k y 16GB de RAM, con 4 discos duros (2 SSD) con una fuente de 850W. Preguntas locas que me hago (Soy novato en esto)

¿Tendría que cambiar la placa base para esto?

¿Con la fuente de alimentación que tengo llego a la potencia necesaria?

i3rk escribió:Pregunta para entendidos.

Voy pensando jubilar mi 2070 (normal, no super) por una 3080. Sobre todo la quiero para poder rular en 2k ultra a 60fps cosas de next gen y VR (Actualmente hay algunos juegos que van justos). Iba a aguantar con la 2070 unos años más, pero si de verdad dicen que la 3080 tiene más rendimiento que una 2080 ti, no me lo pienso (No sé si esto será verdad).

Ahora, tengo un i7 8800k y 16GB de RAM, con 4 discos duros (2 SSD) con una fuente de 850W. Preguntas locas que me hago (Soy novato en esto)

¿Tendría que cambiar la placa base para esto?

¿Con la fuente de alimentación que tengo llego a la potencia necesaria?

wildchild_bcn escribió:i3rk escribió:Pregunta para entendidos.

Voy pensando jubilar mi 2070 (normal, no super) por una 3080. Sobre todo la quiero para poder rular en 2k ultra a 60fps cosas de next gen y VR (Actualmente hay algunos juegos que van justos). Iba a aguantar con la 2070 unos años más, pero si de verdad dicen que la 3080 tiene más rendimiento que una 2080 ti, no me lo pienso (No sé si esto será verdad).

Ahora, tengo un i7 8800k y 16GB de RAM, con 4 discos duros (2 SSD) con una fuente de 850W. Preguntas locas que me hago (Soy novato en esto)

¿Tendría que cambiar la placa base para esto?

¿Con la fuente de alimentación que tengo llego a la potencia necesaria?

la 3080 en teoria va a ser bastante superior a la 2080ti, pero falta ver analisis reales

con el equipo que tienes vas sobrado para una 3080

la fuente de alimentación tiene suficiente potencia pero habria que ver la calidad de esta... que marca y modelo es?

es muy importante esto ya que hay fuentes maluchas que marcan 700 800 900w y luego cuando le enchufas algo cañero pueden petar

Neo-Harkell escribió:@maikel_eol @lucer1 No, si me la voy a pillar, la veo muy buena a un buen precio. No creo que el i7-8700k le de problemas de cuello de botella. Pero el hilo desmoraliza un poco bastante, la verdad.

i3rk escribió:Pregunta para entendidos.

Voy pensando jubilar mi 2070 (normal, no super) por una 3080. Sobre todo la quiero para poder rular en 2k ultra a 60fps cosas de next gen y VR (Actualmente hay algunos juegos que van justos). Iba a aguantar con la 2070 unos años más, pero si de verdad dicen que la 3080 tiene más rendimiento que una 2080 ti, no me lo pienso (No sé si esto será verdad).

Ahora, tengo un i7 8800k y 16GB de RAM, con 4 discos duros (2 SSD) con una fuente de 850W. Preguntas locas que me hago (Soy novato en esto)

¿Tendría que cambiar la placa base para esto?

¿Con la fuente de alimentación que tengo llego a la potencia necesaria?

d2akl escribió:i3rk escribió:Pregunta para entendidos.

Voy pensando jubilar mi 2070 (normal, no super) por una 3080. Sobre todo la quiero para poder rular en 2k ultra a 60fps cosas de next gen y VR (Actualmente hay algunos juegos que van justos). Iba a aguantar con la 2070 unos años más, pero si de verdad dicen que la 3080 tiene más rendimiento que una 2080 ti, no me lo pienso (No sé si esto será verdad).

Ahora, tengo un i7 8800k y 16GB de RAM, con 4 discos duros (2 SSD) con una fuente de 850W. Preguntas locas que me hago (Soy novato en esto)

¿Tendría que cambiar la placa base para esto?

¿Con la fuente de alimentación que tengo llego a la potencia necesaria?

Más que la potencia de esos 850W.. que marca es la fuente?

Daicon escribió:elamos escribió:El que tenga dudas de si debe cambiarse la fuente de alimentación o no para una 3080 que se meta en la web https://outervision.com/power-supply-calculator y ahí verá si con su equipo actual o futuro necesita cambiarse la psu

En mi caso con mi equipo actual un i5 9600k a 4.6 + RTX 3080 y 16gb de ram me pide una de 650w indicando que la potencia de carga es de 575 W

Actualmente tengo una be quiet 100% modular de 700w plus Gold un buen pepino de fuente así que me quedo tranquilo.

Si cambiase la cpu y le pusiera un i7 10700k a 5.1 me pediria una de 700w siendo la potencia de carga de 621w, así que nada parece que me he librado de renovar psu

Mejor que eso, se compre un enchufe inteligente, por 10 euros.

Le haga un streas al pc, y el máximo que le dé, ya sabe el sobrante que le queda para la gráfica.s

i3rk escribió:@elamos Muchas gracias por tu respuesta. Voy a bichear la página a ver que tal. Placa espero no cambiar en un tiempo (Me petó la mia y la tuve que cambiar hace unos meses... Con todo lo que eso conlleva).wildchild_bcn escribió:i3rk escribió:Pregunta para entendidos.

Voy pensando jubilar mi 2070 (normal, no super) por una 3080. Sobre todo la quiero para poder rular en 2k ultra a 60fps cosas de next gen y VR (Actualmente hay algunos juegos que van justos). Iba a aguantar con la 2070 unos años más, pero si de verdad dicen que la 3080 tiene más rendimiento que una 2080 ti, no me lo pienso (No sé si esto será verdad).

Ahora, tengo un i7 8800k y 16GB de RAM, con 4 discos duros (2 SSD) con una fuente de 850W. Preguntas locas que me hago (Soy novato en esto)

¿Tendría que cambiar la placa base para esto?

¿Con la fuente de alimentación que tengo llego a la potencia necesaria?

la 3080 en teoria va a ser bastante superior a la 2080ti, pero falta ver analisis reales

con el equipo que tienes vas sobrado para una 3080

la fuente de alimentación tiene suficiente potencia pero habria que ver la calidad de esta... que marca y modelo es?

es muy importante esto ya que hay fuentes maluchas que marcan 700 800 900w y luego cuando le enchufas algo cañero pueden petar

Esta es

https://www.amazon.es/gp/product/B07S3X ... UTF8&psc=1

A punto estuve de pillar una NFortec de 1000W pero me dijeron que era roña siendo generosos.

![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

i3rk escribió:d2akl escribió:i3rk escribió:Pregunta para entendidos.

Voy pensando jubilar mi 2070 (normal, no super) por una 3080. Sobre todo la quiero para poder rular en 2k ultra a 60fps cosas de next gen y VR (Actualmente hay algunos juegos que van justos). Iba a aguantar con la 2070 unos años más, pero si de verdad dicen que la 3080 tiene más rendimiento que una 2080 ti, no me lo pienso (No sé si esto será verdad).

Ahora, tengo un i7 8800k y 16GB de RAM, con 4 discos duros (2 SSD) con una fuente de 850W. Preguntas locas que me hago (Soy novato en esto)

¿Tendría que cambiar la placa base para esto?

¿Con la fuente de alimentación que tengo llego a la potencia necesaria?

Más que la potencia de esos 850W.. que marca es la fuente?

Corsair RM850

https://www.amazon.es/gp/product/B07S3X ... =cmprd2-21

Colorful35 escribió:Que guapa la Zotac https://www.coolmod.com/zotac-gaming-ge ... ica-precio y 5 años de garantia

Colorful35 escribió:Que guapa la Zotac https://www.coolmod.com/zotac-gaming-ge ... ica-precio y 5 años de garantia

Neo-Harkell escribió:Pero el hilo desmoraliza un poco bastante, la verdad.

calloudiano escribió:PD: La PS5 no es equivalente a una 2070 Super, ya que no se pueden comparar Tflops de una arquitectura a otra, y tampoco el nivel de optimizacion de un PC se parece en nada al nivel de optimizacion de una consola.

Posiblemente la PS5 rinda bastante cerca de lo que vas a obtener en una 3070 en un entorno "normal" sin contar con RT y posiblemente se acerque a un rendimiento de una 3080 en un entorno de micropoligono sin contar con RT. Que es por otra parte para lo que ha sido diseñada la consola.

Algunas de las perlas que se leen en el hilo de consolas jajajajaja

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif) . Será como el extraño caso de benjamin button pero con los TFlops, a medida que vayan estrujándola mas y mas, menos TFLops tendrá.

. Será como el extraño caso de benjamin button pero con los TFlops, a medida que vayan estrujándola mas y mas, menos TFLops tendrá.

Nomada_Firefox escribió:Neo-Harkell escribió:Y tampoco veo nada que diga que Ampere no va a funcionar bien en una CPU de 6 nucleos/12 hilos. Similar a los millones de Ryzen 5 3600. Si fuera un 4 nucleos. Pues sí, no le iba a poder sacar todo el rendimiento. Pero no hay indicativo de lo contrario. Son todo fantasmadas de gente aburrida.

Buxeri escribió:Colorful35 escribió:Que guapa la Zotac https://www.coolmod.com/zotac-gaming-ge ... ica-precio y 5 años de garantia

Me gusta mas el otro modelo, el amp extreme, ojala no se vaya mucho de precio, porque es de las que mas me ha gustado de modelos customs.

maikel_eol escribió:jmjayme escribió:PREGUNTA IMPORTANTE

Hola, hoy me llega mi nueva MSI 1660 Super, tengo el equipo algo desfasado ya y en el foro me recomendaron que cambiara las memos y la gráfica (tenía una GTX 950) y ya con eso renovaba un añito el PC. En realidad no me hace mucha falta, yo juego en consola, pero quería ugar al Flight Simulator y de paso subir la calidad a los otros pocos juegos que tengo en PC como Anno 1800, Planet Zoo, los Total War...)

Por eso lo que mas me interesaba es que fuera silenciosa (uso el pc sbre todo para navegar), no consuma mucho (mi fuente tiene 400W) y moderadamente potente. Pues justo hoy cuando me llega me dicen en el hilo que devuelva la 1660 y me espere a la Ampere de 500 pavos.

¿QUE HAGO?

Hombre siempre hay que comprar según tus necesidades, esa gráfica es estupenda para lo que quieres, y la diferencia de precio la guardas para cuando montes un equipo acorde a una gráfica de 500€

Zaguer escribió:Pero como os gusta exagerar todo de verdad

Yo soy pecero a muerte, pero que queréis que os diga, no he visto nada en PC que se asemeje al TLOU2, es una BESTIA gráficamente. Que va a 30fps y no llega a 4k nativos? ok, eso son solo números, el juego se ve mejor que ningún otro que you haya visto.

Cada plataforma tiene sus cosas buenas y sus cosas malas, pero dejar de quitarle merito a las consolas por que hacen muy muy bien lo único que pueden hacer, ejecutar juegos.

vencedor escribió:Hola A todos,

Antes he leido bastantes veces que la memoria incorporada en la 3070 es GDDR6 de 8 GB.

En la pagina Web de Nvidia pone que es memoia GDDR6X de 8 GB, lo qual entiendo que siendo X es una diferencia no?

Saludos.

d2akl escribió:vencedor escribió:Hola A todos,

Antes he leido bastantes veces que la memoria incorporada en la 3070 es GDDR6 de 8 GB.

En la pagina Web de Nvidia pone que es memoia GDDR6X de 8 GB, lo qual entiendo que siendo X es una diferencia no?

Saludos.

En la presentación de Nvidia salía la 3070 GDDR6...

Ahora en la web ponen que es la X??

No entiendo nada.

vencedor escribió:Hola A todos,

Antes he leido bastantes veces que la memoria incorporada en la 3070 es GDDR6 de 8 GB.

En la pagina Web de Nvidia pone que es memoia GDDR6X de 8 GB, lo qual entiendo que siendo X es una diferencia no?

EDIT: En la pagina principal pone GDDR6 y en las especificaciones de dentro GDDR6X.... menudos....

Saludos.

d2akl escribió:vencedor escribió:Hola A todos,

Antes he leido bastantes veces que la memoria incorporada en la 3070 es GDDR6 de 8 GB.

En la pagina Web de Nvidia pone que es memoia GDDR6X de 8 GB, lo qual entiendo que siendo X es una diferencia no?

Saludos.

En la presentación de Nvidia salía la 3070 GDDR6...

Ahora en la web ponen que es la X??

No entiendo nada.

Neo-Harkell escribió:Joer, iba a pillar la 3080 para sustituir mi vieja 1080, pero lees este hilo y parece que si la compras te estas dejando estafar por Nvidia xD

Eilex_D escribió:d2akl escribió:vencedor escribió:Hola A todos,

Antes he leido bastantes veces que la memoria incorporada en la 3070 es GDDR6 de 8 GB.

En la pagina Web de Nvidia pone que es memoia GDDR6X de 8 GB, lo qual entiendo que siendo X es una diferencia no?

Saludos.

En la presentación de Nvidia salía la 3070 GDDR6...

Ahora en la web ponen que es la X??

No entiendo nada.

Lo acabo de mirar, si te vas a especificaciones pone GDDR6, si le das a ver especificaciones completas pone GDDR6X. No entiendo...

@tigerscream

Luzbel_bcn escribió:Panfrismix escribió:Vuelvo a repetir lo que he dicho ayer. Estáis dando por hecho que los datos de Nvidia son verdaderos. Creo que deberíamos esperar a los benchmark. Por que el hecho de que una tarjeta de 500 euros rinda mas que una que ahora mismo se está vendiendo por más de 1000 nueva..... Es fácil de creer pero puede que no sea tan así cuando salgan benchmarks de prensa y usuarios.

No se habla de lo que datos que dio Nvidia sino de este vídeo:

https://youtu.be/cWD01yUQdVA

josemurcia escribió:.

Oodle Texture no tiene nada que ver con la compresión en bloque, los 9 Gbps vienen de que Kraken da un ratio de compresión sin pérdida media de 1.65:1, por eso he dicho un poco menos de 2:1.

Oodle Texture no entra en la ecuación, porque como digo, los mismos beneficios se aplican al resto de algoritmos de compresión.

Además Oodle Texture no se puede aplicar a modelos y animaciones, y es un algoritmo de compresión con pérdida, por lo que solo interesa aplicarlo a determinadas texturas.

Realmente no se puede estimar una media de lo que aportaría Oodle Texture sin establecer primero que % de texturas comprimidas con pérdida se van a transferir en un determinado tiempo. Y aunque lo determinaramos sería el mismo tamaño en todos los sistemas por lo que la mejora porcentual sería la misma en todos.

Compresión de textura Oodle:

Oodle Texture es un SDK para codificar texturas de GPU a formatos BC1-BC7 que se pueden comprimir mucho más pequeños. Oodle Texture puede hacer codificaciones BCN de máxima calidad que son 5-15% más pequeñas después de la compresión.

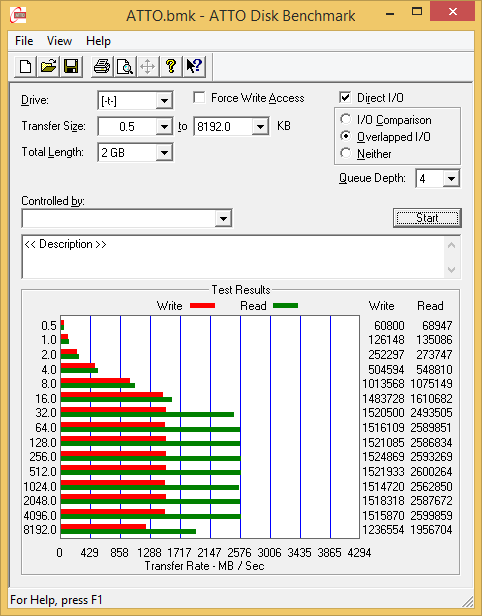

josemurcia escribió:.Nowcry escribió:En cuanto al SSD a ver como te respondo:

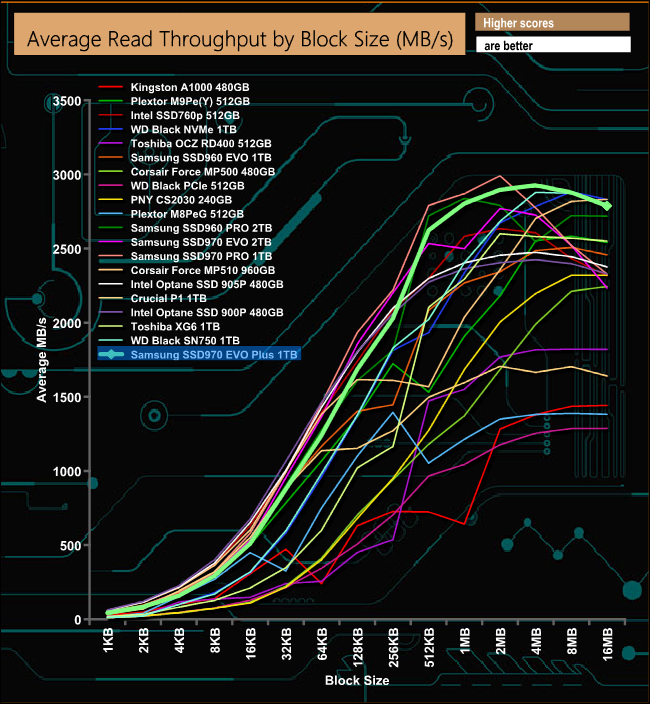

Esto es un benchmark de un Samsung 970 Pro SSD PCIeGen3 cuyo maximo teorico se encuentra en 4 GB/s pero el máximo teórico alcanzado se sitúa realmente en 3,5 GB/s y como finalmente solo es capaz de mantenerlos en picos observa lo que hace el amarillo que es el Samsung 970 Evo con los canales saturados en lectura secuencial PCIeGen3.

Puedes observar como en lectura secuencial el SSD cae hasta los 2500 MB/s, ya no hablemos con lecturas aleatorias. No los canales PCIeGen4 saturados a los 7GB/s no son sostenibles en el tiempo. Ni tampoco aproximables. Si te fijas en cualquier bechmark o SSD de Gen 3 como aclaracion dire que tanto el azul como el naranja son PCIeGen4 y son capaces de sostener 5 GB/s porque los canales aun no estan saturados, pero el comportamiento sera el mismo cuando saturen.

Durante un tiempo pico se sostiene y luego cae por interrupciones del sistema.

Y todo esto haciendo un benchmark SSD to CPU read, no quieras imaginar lo que vas a encontrar agregando una capa de abstracción superior RTX IO y metiendo un proceso de descompresión de por medio.

Enserio deja de acusar de inventar y revisa tus conocimientos.

Un saludo.

Esos picos no son por saturación, el eje X no va ligado al tiempo, es el tamaño de bloque de la operación y para cada tamaño de bloque se testea exactamente la misma transferencia. Lo único que te dice ese benchmark es que si vas a leer un archivo, hazlo en bloques de entre 1 y 8MB, si lo haces de menos o si lo haces de más, el 970 Evo Plus da un rendimiento subóptimo, cosa que por lo que parece es problema de ese SSD en particular.Atto Disk Benchmark

One of the finest tools available to measure storage performance is ATTO. I love it to death as it is so reliable and produces such accurate results. The great thing about ATTO is that we can test with predefined block sizes. So we can test with a 32 MB sequence of 4 KB files, yet also 32 MB in 1 MB files. This gives us an excellent scope of overall performance with small and large files.

https://www.guru3d.com/articles-pages/h ... iew,6.html

Puede que ese benchmark en concreto muestre un problema de firmware que Samsung solucionó via update, porque puedes ver el mismo test en otras webs donde no tiene ese problema.

https://www.kitguru.net/components/ssd- ... -review/5/

Eilex_D escribió:d2akl escribió:vencedor escribió:Hola A todos,

Antes he leido bastantes veces que la memoria incorporada en la 3070 es GDDR6 de 8 GB.

En la pagina Web de Nvidia pone que es memoia GDDR6X de 8 GB, lo qual entiendo que siendo X es una diferencia no?

Saludos.

En la presentación de Nvidia salía la 3070 GDDR6...

Ahora en la web ponen que es la X??

No entiendo nada.

Lo acabo de mirar, si te vas a especificaciones pone GDDR6, si le das a ver especificaciones completas pone GDDR6X. No entiendo...

@tigerscream

https://www.nvidia.com/es-es/geforce/gr ... /rtx-3070/

nerkaid escribió:Nomada_Firefox escribió:Neo-Harkell escribió:Y tampoco veo nada que diga que Ampere no va a funcionar bien en una CPU de 6 nucleos/12 hilos. Similar a los millones de Ryzen 5 3600. Si fuera un 4 nucleos. Pues sí, no le iba a poder sacar todo el rendimiento. Pero no hay indicativo de lo contrario. Son todo fantasmadas de gente aburrida.

Este tema viene más por la arquitectura de las nuevas consolas, por las cuales los nuevos juegos llevarán un formato de 8/16 hilos de procesamiento, y los equipos con menos que eso tendrán que compartir hilos en el mismo nucleo con el consecuente impacto en el rendimiento.

Nowcry escribió:No voy a seguir discutiendo tonterías ve a la página oficial y lee las primeras líneas.

http://www.radgametools.com/oodlekraken.htmCompresión de textura Oodle:

Oodle Texture es un SDK para codificar texturas de GPU a formatos BC1-BC7 que se pueden comprimir mucho más pequeños. Oodle Texture puede hacer codificaciones BCN de máxima calidad que son 5-15% más pequeñas después de la compresión.

Oddle textures es un sistema de codificación que junto con un descompresor ya sea Zlib o Kraken sirve para comprimir texturas en formato BCn (BC1-BC7) lo que que es el equivalente a BCPack solo que SX combina BCpack como codificador y usa Zlib de compresor. Los ratios de compresión 2:1 se alcanzan utilizando el sistema de codificación Oddle/BCpack que solo afecta a texturas organizandolas y un compresor Zlib o Kraken que es de uso general y mejora con el codificador

Puedes usar Oddle textures o BCpack o lo que quieras pero no puedes usar los dos y mucho menos tenerlos en cuenta en los ratios dos veces. El ratio 2:1 son alcanzados

y anunciados son utilizando los codificadores de textura + compresores el que te de la gana. Que por cierto no son con RDO al menos para una compresión del 15-20%, del 20% al 50% es casi imperceptible y es lo que se usa. Oddle textures codification + compresión puede ser descomprimido por CPU, GPU shaders o hardware dedicado de PS5/SX.

El codificador de texturas no se ha tenido en cuenta en Road to Ps5 como nos comenta un desarrollador oficial pero MS si ha tenido en cuenta en SX y Nvidia si lo ha tenido en cuenta en RTXIO.

Y por ello el IO de PS5 llega a 11 GB/s sostenido y con picos de 22 GB/a.

Nowcry escribió:

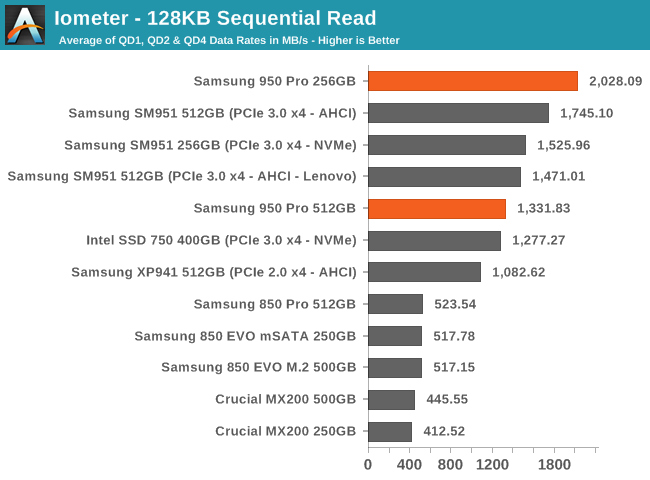

Vale ahora que ya he llegado a este punto, utilizo el mismo benchmarkt que sugieres y avanzó por las páginas hasta average read y encontramos esto:

Donde el pico máximo corresponde es 2,926.71 MB / s. Siendo 4000 MB/s la capacidad máxima de un canal PCIeGen3 teóricamente y que en la práctica tendrá picos de 3500 MB/s con unos 3000 MB/s de sostenido.

En un SSD PCIEGEN4 obtendrás unos 6000 MB/s de sostenido y unos picos de 7000 MB/s que son los equivalentes a los que te he comentado y todo esto sin sufrir interrupciones ni pasar por una capa de abstracción RTX IO por ser un benchmark.

Vuelvo a decir no acuses de inventar y investiga un poco. Y ya no voy a perder más el tiempo si en realidad todo esto tiene poca o ninguna importancia. Que cada cual investigue y crea lo que quiera creer.

DaNi_0389 escribió:@tigerscream

Si, te van a dar el mismo descuento que cuando la memoria asimetrica de la gtx970.

david14mh escribió:El modelo de KFA2 de la 3070 mola bastante y es el mismo precio que la founders(aunque faltaria ver si regalan tambien algun juego y el año de Geforce Now). https://www.coolmod.com/kfa2-geforce-rt ... ica-precio

Lo que si veo es que por ejemplo el PCB de la 3070 de KFA2 es "normal" y no esta recortado como el founders. Pero sin embargo la Zotac 3070 la veo muy enana y no se si ventilará bien. https://www.coolmod.com/zotac-gaming-ge ... ica-precio

¿Que opinais?