xineloeol escribió:El nuevo modelo transformer en DLSS 4 sí que me parece una pasada, de momento tiene una penalización en rendimiento sobre el antiguo CNN más que razonable, pero que irán mejorando seguro.

Así a bote pronto el DLSS 4 rendimiento › DLSS 3 calidad, tanto en estabilidad de imagen como ghosting, que parece erradicado totalmente.

Y encima funciona en todas las RTX.

tonicab escribió:He visto que casi todas las customs de 5090 son de largas unos 33cms para arriba y en mi caja sólo caben de 30 cms para abajo (la FE si cabría justa) y todo porque tengo el radiador delante ya que encima de la caja no cabe.

Tengo dos opciones. Primero comprar otra gráfica (pero casi todas superan los 30cms por el triple ventilador) o bien comprar una RL más pequeña y ponerla encima del ordenador.

Una putada gorda.

tonicab escribió:He visto que casi todas las customs de 5090 son de largas unos 33cms para arriba y en mi caja sólo caben de 30 cms para abajo (la FE si cabría justa) y todo porque tengo el radiador delante ya que encima de la caja no cabe.

Tengo dos opciones. Primero comprar otra gráfica (pero casi todas superan los 30cms por el triple ventilador) o bien comprar una RL más pequeña y ponerla encima del ordenador.

Una putada gorda.

SnakeElegido escribió:Todas esas pruebas de HW Unboxed usando 30fps como base son basura.

[...]

Lo más gracioso es que todo lo que estoy diciendo, lo dice él en el vídeo. Con lo que no entiendo porqué usan las evidencias de 30fps

Rvilla87 escribió:SnakeElegido escribió:Todas esas pruebas de HW Unboxed usando 30fps como base son basura.

[...]

Lo más gracioso es que todo lo que estoy diciendo, lo dice él en el vídeo. Con lo que no entiendo porqué usan las evidencias de 30fps

Hombre, todo lo que dices dudo que lo digan en el video porque de decirlo estarían diciendo que ese test partiendo de 30 fps es basura y se estarían tirando piedras contra su propio tejado, dejándose de inútiles ellos mismos

Ya comenté que un caso que veo muy claro es el de la MUCHA gente (la mayoría) que va a comprar la gama 5060 o por ahí, donde los juegos con reescalado ya aplicado puede que les vaya a 30 fps o incluso menos (corregido, dije nativo) y se piense que con MFG x4 tenga 120hz en su TV 120/144hz de forma espectacular... no, eso no va así y muchos pueden malinterpretar el marketing de Nvidia, como explicas con lo de que los fps iniciales son nativos y le falta añadir el reescalado.

El video de Hardware Unboxed es útil, solo que no para todas las personas (quién quiere 240fps en su TV de 60hz?). No entiendo el problema en hacer pruebas bajo unas condiciones concretas las cuales puede tener la mayoría de jugadores ya que la gama x060 es históricamente la mas usada. De hecho es que la misma prueba la hicieron con el FG "normal" y no pasó nada, es una simple demostración para ver hasta cuánto se puede exprimir el FG sin ver demasiados artefactos.

Y por poner un ejemplo de posible mal uso de MFG, review de la 4070 (simulando una 5060 mas o menos) donde Cyberpunk 2077 a 1440p (suponiendo que juega a 4k y ya le ha aplicado el reescalado) con ray tracing (que no path tracing) va a menos de 40 fps. Eso no va a escalar bien con el FG y ya tiene el reescalado aplicado. Eso con ray tracing, pues imagínate si esa persona se piensa que como la 5090 lo mueve con path tracing a 240fps puede configurar el juego con path tracing que total, mientras su 5060 lo mueva a 60 fps con MFGx4 (partiendo por ejemplo de 10 fps nativos) ya le está bien... porque claro de qué ese usuario iba a esperar ver artefactos como puños? Si en el video de Nvidia se ve muy bien

Quizás a ti te parece muy obvio que una gráfica como la 5060 no es para 4k con gráficos muy altos y ray tracing pero con el marketing y la vendida de moto de Nvidia creo que es muy factible pensar que habrá mucha gente que crea que su 5060 (insisto, la gama mas vendida históricamente) es capaz de cosas inalcanzables para ella.

SG_SIYU escribió:hombre tienes otra, cambiar de caja. que tal y como están las RL te saldría creo que mejor. Eso si, tienes que trasladar todo el equipo, con la RL solo es eso y listo.

Borlanchos escribió:Cambia de caja por 50€

Rvilla87 escribió:SnakeElegido escribió:Todas esas pruebas de HW Unboxed usando 30fps como base son basura.

[...]

Lo más gracioso es que todo lo que estoy diciendo, lo dice él en el vídeo. Con lo que no entiendo porqué usan las evidencias de 30fps

Hombre, todo lo que dices dudo que lo digan en el video porque de decirlo estarían diciendo que ese test partiendo de 30 fps es basura y se estarían tirando piedras contra su propio tejado, dejándose de inútiles ellos mismos

Ya comenté que un caso que veo muy claro es el de la MUCHA gente (la mayoría) que va a comprar la gama 5060 o por ahí, donde los juegos con reescalado ya aplicado puede que les vaya a 30 fps o incluso menos (corregido, dije nativo) y se piense que con MFG x4 tenga 120hz en su TV 120/144hz de forma espectacular... no, eso no va así y muchos pueden malinterpretar el marketing de Nvidia, como explicas con lo de que los fps iniciales son nativos y le falta añadir el reescalado.

El video de Hardware Unboxed es útil, solo que no para todas las personas (quién quiere 240fps en su TV de 60hz?). No entiendo el problema en hacer pruebas bajo unas condiciones concretas las cuales puede tener la mayoría de jugadores ya que la gama x060 es históricamente la mas usada. De hecho es que la misma prueba la hicieron con el FG "normal" y no pasó nada, es una simple demostración para ver hasta cuánto se puede exprimir el FG sin ver demasiados artefactos.

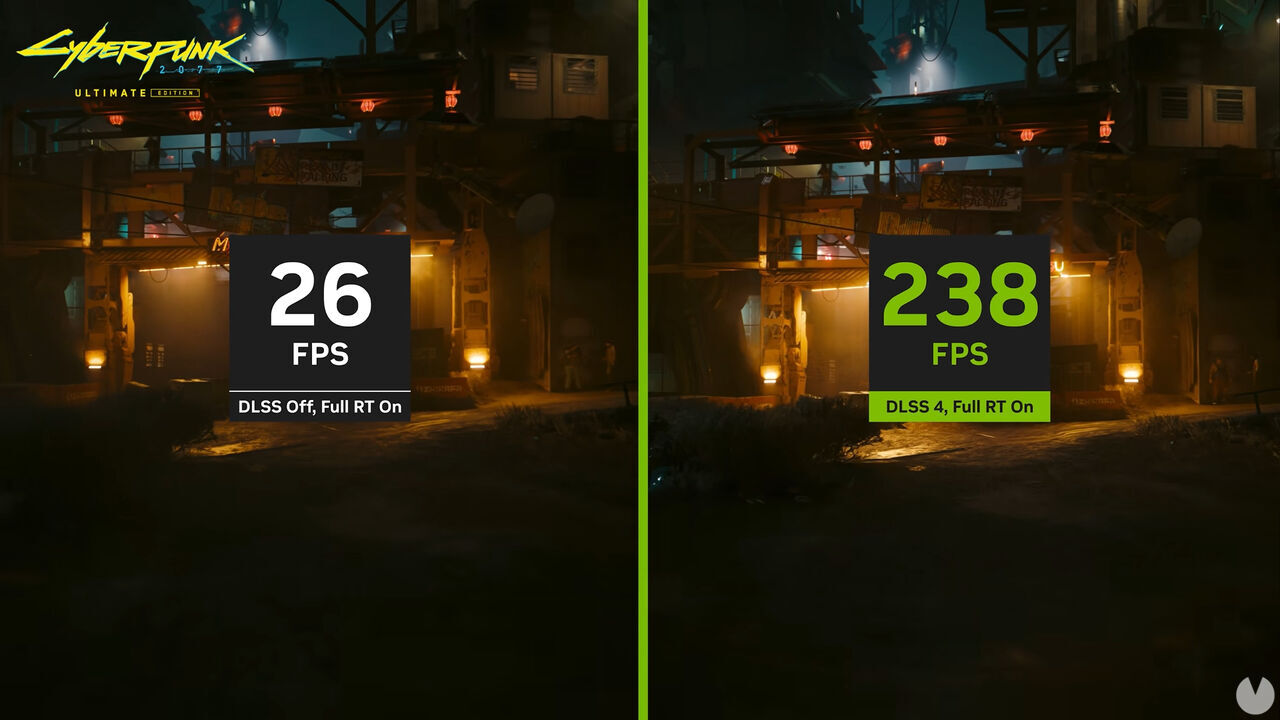

Y por poner un ejemplo de posible mal uso de MFG, review de la 4070 (simulando una 5060 mas o menos) donde Cyberpunk 2077 a 1440p (suponiendo que juega a 4k y ya le ha aplicado el reescalado) con ray tracing (que no path tracing) va a menos de 40 fps. Eso no va a escalar bien con el FG y ya tiene el reescalado aplicado. Eso con ray tracing, pues imagínate si esa persona se piensa que como la 5090 lo mueve con path tracing a 240fps puede configurar el juego con path tracing que total, mientras su 5060 lo mueva a 60 fps con MFGx4 (partiendo por ejemplo de 10 fps nativos) ya le está bien... porque claro de qué ese usuario iba a esperar ver artefactos como puños? Si en el video de Nvidia se ve muy bien

Quizás a ti te parece muy obvio que una gráfica como la 5060 no es para 4k con gráficos muy altos y ray tracing pero con el marketing y la vendida de moto de Nvidia creo que es muy factible pensar que habrá mucha gente que crea que su 5060 (insisto, la gama mas vendida históricamente) es capaz de cosas inalcanzables para ella.

Rvilla87 escribió:SnakeElegido escribió:Todas esas pruebas de HW Unboxed usando 30fps como base son basura.

[...]

Lo más gracioso es que todo lo que estoy diciendo, lo dice él en el vídeo. Con lo que no entiendo porqué usan las evidencias de 30fps

Hombre, todo lo que dices dudo que lo digan en el video porque de decirlo estarían diciendo que ese test partiendo de 30 fps es basura y se estarían tirando piedras contra su propio tejado, dejándose de inútiles ellos mismos

Borlanchos escribió:Seguro que la mayoría de los que critican los “fake frames” no distinguiría frames nativos de los fake

xineloeol escribió:Así a bote pronto el DLSS 4 rendimiento › DLSS 3 calidad, tanto en estabilidad de imagen como ghosting, que parece erradicado totalmente.

Y encima funciona en todas las RTX.

MrKafka escribió:Yo le he puesto FG y DLSS a mi coche y aunque tiene 90cv, ahora me marca x4 la velocidad. Flipa como voy a 320km/h, niño. Gracias Nvidia!

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

Sicopro escribió:El gamer promedio debe estar preocupadísimo y echando pestes del MFG. Supongo que les preocupa mucho que con: drivers beta, sin Reflex 2 (frame warp reduce el input lag más), partiendo de 30 FPS con MFG X4, limitando aposta a 120 FPS, ralentizando el juego al 10-25-50 % y ampliando la imagen entre un 300-500 %, salen artefactos de vez en cuando y aumenta el input lag. Claramente van a jugar así.

La realidad es que MFG X4 en un escenario de uso normal, sin los frames bloqueados, partiendo de 40-50 FPS base da un resultado muy bueno y un input lag de 8-10 ms. Eso con drivers beta, forzando transformers en juegos que no tienen parche oficial y sin Reflex 2.

Los artefactos se han pulido mucho, especialmente el ghosting con transformers, en la vegetación o en las aspas de ventiladores en CP2077 siguen habiendo artefactos que ya estaban presentes en el FG de las RTX 40. Nadie ha dicho que la tecnología sea perfecta, pero es perfectamente jugable y tiene todo el sentido para monitores con alta tasa de refresco o para juegos muy exigentes, el típico juego en el que si quieres ir en ultra y con RT te quedas entre 40-55 FPS con DLSS, y con FG o MFG obtienes entre 80-240 FPS, logrando una mayor fluidez y un input lag muy jugable. Ese es el escenario de uso, no es para shooters competitivos (se juegan en bajo con cientos de FPS nativos y Reflex), ni para partir de 30 FPS (sin DLSS, ese escenario no es realista).

tonicab escribió:He visto que casi todas las customs de 5090 son de largas unos 33cms para arriba y en mi caja sólo caben de 30 cms para abajo (la FE si cabría justa) y todo porque tengo el radiador delante ya que encima de la caja no cabe.

Tengo dos opciones. Primero comprar otra gráfica (pero casi todas superan los 30cms por el triple ventilador) o bien comprar una RL más pequeña y ponerla encima del ordenador.

Una putada gorda.

Sicopro escribió:El gamer promedio debe estar preocupadísimo y echando pestes del MFG. Supongo que les preocupa mucho que con: drivers beta, sin Reflex 2 (frame warp reduce el input lag más), partiendo de 30 FPS con MFG X4, limitando aposta a 120 FPS, ralentizando el juego al 10-25-50 % y ampliando la imagen entre un 300-500 %, salen artefactos de vez en cuando y aumenta el input lag. Claramente van a jugar así.

La realidad es que MFG X4 en un escenario de uso normal, sin los frames bloqueados, partiendo de 40-50 FPS base da un resultado muy bueno y un input lag de 8-10 ms. Eso con drivers beta, forzando transformers en juegos que no tienen parche oficial y sin Reflex 2.

Los artefactos se han pulido mucho, especialmente el ghosting con transformers, en la vegetación o en las aspas de ventiladores en CP2077 siguen habiendo artefactos que ya estaban presentes en el FG de las RTX 40. Nadie ha dicho que la tecnología sea perfecta, pero es perfectamente jugable y tiene todo el sentido para monitores con alta tasa de refresco o para juegos muy exigentes, el típico juego en el que si quieres ir en ultra y con RT te quedas entre 40-55 FPS con DLSS, y con FG o MFG obtienes entre 80-240 FPS, logrando una mayor fluidez y un input lag muy jugable. Ese es el escenario de uso, no es para shooters competitivos (se juegan en bajo con cientos de FPS nativos y Reflex), ni para partir de 30 FPS (sin DLSS, ese escenario no es realista).

.

.SnakeElegido escribió:retabolil escribió:

Pero es que a partir de 120Hz también es mucho más difícil percibir mejora, que a partir de 30.

Estoy de acuerdo en que a mayor FPS, más dificil es notar la diferencia en fluidez. Pero también pienso que es una cuestión subjetiva, con lo que no tiene sentido discutir si es mejor o peor. Cada persona lo verá de una forma distinta. Personalmente, yo creo que no soy capaz de notar facilmente mas de 120fps, pero entiendo que habrá gente que sí. O que como minimo, quiera que la tasa de refresco que sale de su pantalla sea la mayor posible, por comodidad visual.retabolil escribió:Según como funcione de 30fps a 60, va a funcionar de 60 a 120. Va a acentuar lo bueno y lo malo en la misma proporción. Los artefactos no se van a apreciar tanto de 60 a 120fps como de 30 a 60fps, pero lo bueno -la mejora en fluidez- tampoco. A mí sí me parece bien usar 30fps como banco de pruebas, porque es donde mejor se puede apreciar la capacidad de esa tecnología basada en AI.

En esto no estoy de acuerdo. Corregidme si me equivoco, pero estamos hablando de interpolación de frames, con lo que tiene que insertar uno (o 3) frames generados por IA entre dos frames reales. Usemos este gif random para explicar mi argumento de forma bien entendible:

Vale, si partimos de una tasa de frames baja, ponte que este es el Frame A:

Y este es el Frame B:

Es un ejemplo exagerado pero sigueme el rollo.

Si la IA tiene que inventarse la transición entre los frames A (preparando el puño) y B (el tipo golpeado), seguramente lo que se invente sea bastante desastroso.

Si por el contrario partimos de una tasa de frames mucho más alta (70 u 80 por ejemplo, que es más del doble), quiere decir que el Frame B sería este:

En el que se ve el puño en movimiento. Si la IA tiene que generar lo existente entre los Frames A y B, la similitud es mucho más alta. La transición es mucho más facil de dibujar de forma correcta. Y además, como bien dices, cuanto mayor framerate, menos oportunidad de ver dichos artefactos.

Pero es que además, no solo es eso. Sino que esta técnica solo añade frames visualmente hablando, no a la lógica del juego. De modo que, imaginémonos que FG no añade latencia y no añade artefactos. Aun con ese supuesto soñado, si con 30fps sacas 120fps, verás 120fps, pero seguirás teniendo la sensación de jugar a 30fps, con lo que no has ganado mucho. Mientras que si con 80fps sacas 320fps, pues al menos sigues teniendo la sensación de jugar a 80fps, que es super fluido.

De nuevo, corregidme si me equivoco. Cuanto más sabio se vuelva uno, mejor.

Un saludo,

parh escribió:MrKafka escribió:Yo le he puesto FG y DLSS a mi coche y aunque tiene 90cv, ahora me marca x4 la velocidad. Flipa como voy a 320km/h, niño. Gracias Nvidia!

El debate es mas bien en torno al FG (y en particular al FGx4) con las otra tecnologias DLSS, a saber, SR y RR, hay cuasi unanimidad que mejora en todo a la anterior versión. Mas calidad de imagen y/o mas FPS, no agrega latencia y es "gratis" para todas las graficas RTX. Me parece espectacular.

![Ok! [oki]](/images/smilies/net_thumbsup.gif)

pakolo1977 escribió:Me voy a mojar, las rtx 6000 serán poco mejores en raster, algo mejores en rt, mucho mejores en ia y mucho mejores en generación de cuadros falsos. Se presentarán en agosto o septiembre de 2027, con litografía de 3 nanómetros y costarán directamente los dos riñones, los cojones y la polla (suman 23) porque la tasa de chips defectuosos por oblea todavía será exorbitante.

![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

SnakeElegido escribió:Rvilla87 escribió:SnakeElegido escribió:Todas esas pruebas de HW Unboxed usando 30fps como base son basura.

[...]

Lo más gracioso es que todo lo que estoy diciendo, lo dice él en el vídeo. Con lo que no entiendo porqué usan las evidencias de 30fps

Hombre, todo lo que dices dudo que lo digan en el video porque de decirlo estarían diciendo que ese test partiendo de 30 fps es basura y se estarían tirando piedras contra su propio tejado, dejándose de inútiles ellos mismos

Pues sí que lo dicen sí, desde el segundo puto minuto:

Dicen que son incapaces de grabar y reproducir correctamente 240fps (por limitaciones de grabado y que youtube solo permite 60fps), asi que parten de 30.

")?

")?![Ok! [oki]](/images/smilies/net_thumbsup.gif) y por eso puse expresamente MFG, pienso que para cualquier usuario con un monitor 4K120HZ el FG X2 a secas le puede ser más que suficiente, que en parte estás un poco más cubierto "a futuro" pudiendo poner un X3 o un X4 y estirar la vida de la gráfica? también es verdad y eso con la 5070Ti se podrá hacer.

y por eso puse expresamente MFG, pienso que para cualquier usuario con un monitor 4K120HZ el FG X2 a secas le puede ser más que suficiente, que en parte estás un poco más cubierto "a futuro" pudiendo poner un X3 o un X4 y estirar la vida de la gráfica? también es verdad y eso con la 5070Ti se podrá hacer.![Ok! [oki]](/images/smilies/net_thumbsup.gif) es la mejor gráfica calidad/precio de las 5000

es la mejor gráfica calidad/precio de las 5000 xineloeol escribió:El MFG lo ha pintado muy bonito Nvidia en sus gráficas, pero más allá de la latencia, que es similar al FG 2x tradicional (+7ms), su mayor problema actualmente son los artefactos que produce:

MFG genera una cantidad de artefactos mucho mayor en detalles como la vegetación, como muestran en Harry Potter o Star Wars Outlaws. En Alan Wake 2 directamente es un festival casi en cualquier escena que se gira la cámara, para mí personalmente lo hace injugable en su estado actual para este juego en concreto.

También hay que tener en cuenta que la tasa base de renderización baja a medida que aplicamos MFG 3x, 4x:

Esto es otro problema en juegos donde vayamos pelín justos de fps de forma nativa, en este emplo pasamos de 83 en FG 2x a 72 en MFG 4x.

kamy33 escribió:tonicab escribió:He visto que casi todas las customs de 5090 son de largas unos 33cms para arriba y en mi caja sólo caben de 30 cms para abajo (la FE si cabría justa) y todo porque tengo el radiador delante ya que encima de la caja no cabe.

Tengo dos opciones. Primero comprar otra gráfica (pero casi todas superan los 30cms por el triple ventilador) o bien comprar una RL más pequeña y ponerla encima del ordenador.

Una putada gorda.

Por si te ayuda Nvidia tiene un listado oficial de modelos SFF para cajas pequeñas. Yo estoy igual que tu, no me gusta tener una caja gigante y en la mia, que en principio sólo caben hasta 30cm metí una 4080 Super de 32cm, eso si, me toca quitar disipador de la CPU y RAM si quiero sacarla.

https://www.nvidia.com/en-us/geforce/ne ... sff-ready/

xineloeol escribió:El MFG lo ha pintado muy bonito Nvidia en sus gráficas, pero más allá de la latencia, que es similar al FG 2x tradicional (+7ms), su mayor problema actualmente son los artefactos que produce:

MFG genera una cantidad de artefactos mucho mayor en detalles como la vegetación, como muestran en Harry Potter o Star Wars Outlaws. En Alan Wake 2 directamente es un festival casi en cualquier escena que se gira la cámara, para mí personalmente lo hace injugable en su estado actual para este juego en concreto.

También hay que tener en cuenta que la tasa base de renderización baja a medida que aplicamos MFG 3x, 4x:

Esto es otro problema en juegos donde vayamos pelín justos de fps de forma nativa, en este emplo pasamos de 83 en FG 2x a 72 en MFG 4x.

papatuelo escribió:Esta tabla va dura, directa al higado de los de la iglesia del input lag

Hay que buscar otro clavo ardiendo al que agarrarse

Sicopro escribió:Tanto AMD con UDNA y Sony con PS6 van a seguir el mismo camino que Nvidia con el renderizado neural y la IA. No hay otra alternativa, la realidad tecnológica y el coste de las obleas se impone. Cada vez es más caro reducir el nodo, más los problemas de tunelización cuántica, fugas de corriente, etc.

El renderizado neural va a ir cogiendo fuerza en unos meses, en 1-2 años tendrá más impacto en videojuegos, y en 3 años con la llegada de PS6 estaremos de lleno en el renderizado neural y RT en la mayoría de videojuegos recientes. Una RTX 50 ya te ofrece compatibilidad con toda esa tecnología, simplemente van por delante de la competencia. La gente no cambia de GPU en todas las generaciones, mucha gente compra una GPU para 4 años o incluso más.

Para ese entonces las GPUs más utilizadas en Steam serán las RTX 5060, 5060 Ti, 5070, 6060, 6060 Ti 6070 y sus equivalentes en AMD con UDNA. Todas esas GPUs ya tendrán soporte de renderizado neural.

Alguno puede pensar: "para eso me espero a una RTX 60", pues adelante. Basta que pongas RTX 6000 en este hilo para ver la cantidad de veces que he dicho que el que quiera más potencia bruta o tenga una GPU de gama alta RTX 40, no es necesario que compre una RTX 50 y que puede esperar a las RTX 60. Pero en cualquier caso os podéis ir olvidando de grandes saltos de potencia bruta. De hecho, el último gran salto va a ser el de los 2 nm, luego ya van a ser saltos de décimas de nanómetro.

Tampoco sabemos si van a utilizar el proceso a 2 nm de TSMC o el de 3 nm para ahorrar costes en las RTX 60, si optan por el proceso a 3 nm el salto que vamos a tener es similar a esto (siendo optimista):

- RTX 6090: 140 TFLOPS (+35 %)

- RTX 6080: 70 TFLOPS (+30 %)

- RTX 6070 Ti: 58 TFLOPS (+32 %)

- RTX 6070: 40 TFLOPS (+29 %)

Eso es solo en TFLOPS para rasterizado (FP32), luego hay que añadir las mejoras en RT y Tensor, así que el salto en rendimiento va a ser mayor que con respecto a las RTX 50, pero tampoco va a ser una locura de drogas. Si finalmente tiran del proceso a 2 nm si que estaríamos hablando de un salto mayor, pero en cualquier caso sería el último gran salto. Luego ya entramos en procesos de décimas de nanómetro en cada nuevo nodo. Se acabó la fiesta de la ley de Moore.

No entiendo a los que renegáis de la IA y echáis pestes del I+D vinculado a toda esa tecnología. El sentido de la IA es precisamente dar solución a los límites de la ley de Moore permitiendo que la evolución gráfica en los videojuegos siga progresando.

- No os gusta que gracias a la IA puedas tener RT o PT, la iluminación es una de las características que más impacto tiene en la calidad visual de los videojuegos. Afecta a múltiples aspectos.

- No os gusta el NTC que permite ahorrar hasta 7 veces más VRAM, eso permite meter texturas enormes y aumentar drásticamente la calidad visual. Para el que no lo sepa, el NTC es como aplicar DLSS pero a la compresión de texturas.

- No os mola que se pueda conseguir un RT con un menor costo computacional con técnicas como la radiance cache.

- Tampoco el reescalado mediante DLSS o FSR.

- Ni los frames interpolados.

- Ni tampoco una mayor geometría, mejoras en las caras de los NPC o incluso tener IA generativa en dichos NPC para una mayor rejugabilidad y una narrativa más dinámica.

- Mejoras en texturas complejas con transparencias.

Si solamente se centraran en la potencia bruta en rasterizado seguiríamos en el pleistoceno a nivel de avance gráfico, es precisamente ahora cuando hemos llegado a un punto de inflexión a la hora de reducir más el nodo. El timing para meter el renderizado neural ha sido perfecto.

En la décima generación de consolas vamos a tragar RT y renderizado neural hasta en la sopa, y yo que me alegro, ya que gracias a eso vamos a tener una generación con muchas más innovaciones que en la novena, y no solo con respecto a la calidad de los gráficos.

Esa décima generación que se va a estrenar en noviembre de 2027 nos va a pillar casi con la salida de las RTX 60 Super, así que ya estaremos en la segunda iteración del renderizado neural y los RTX shaders. AMD ya estará de lleno metida en UDNA y con su propia versión de esa tecnología, lo mismo las consolas basadas en el hardware de AMD y UDNA. Todo eso os debería poner palotes de cara a lo que se viene, vamos a ver más avances en esa generación que en la mayoría de las anteriores (excepto el paso del 2D al 3D), y no solo en gráficos, también en los NPCs.

beatle escribió:Oh, Dios mio, se ven artefactos jugando al 6% de velocidad y con un zoom de 500%![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

Hardware Unboxed son pro AMD y Nvidia haters de toda la vida.

6,25% speed![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

Borlanchos escribió:papatuelo escribió:Esta tabla va dura, directa al higado de los de la iglesia del input lag

Hay que buscar otro clavo ardiendo al que agarrarse

Uffff duro para los haters fakeframes

Ricardo__ escribió:beatle escribió:Oh, Dios mio, se ven artefactos jugando al 6% de velocidad y con un zoom de 500%![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

Hardware Unboxed son pro AMD y Nvidia haters de toda la vida.

6,25% speed![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

Creo que debo tener el ordenador roto o algo, porque acabo de probar el Hogwarts Legacy con el DLSS 4 forzado y el generador de fotogramas se nota muchísimo: hay halos alrededor del personaje, los subtítulos se ven dobles y demás. Igual van a sacar un parche o puede que las series 5000 lo gestionen mucho mejor.

Y esto, tirado en la cama a 3 metros de la pantalla.

esami escribió:Borlanchos escribió:papatuelo escribió:Esta tabla va dura, directa al higado de los de la iglesia del input lag

Hay que buscar otro clavo ardiendo al que agarrarse

Uffff duro para los haters fakeframes

A mi me explotaba la cabeza. Leyendo en el foro las malas latencias del MFG y luego cuando veia este tipo de pruebas e intentaba documentarme veia que mejoraba respecto del nativo.

Borlanchos escribió:Mas nos vale que vayamos asumiendo que el futuro son frames por AI. A mi me jode infinito porque juego en VR y el DLSS, entero en todas sus funciones, no me vale de nada. Y cuando no juego en VR (pocas veces) lo hago en una oled de 60fps así que no voy a aprovechar el FG. Pero es lo que hay