A ver si aclaramos un poco el tema del sonido 3D. Éste en juegos se usa a través de una API de sonido 3D, que ofrece una serie de funcionalidades para establecer las fuentes de sonido respecto a un oyente (normalmente el personaje o la cámara), en un espacio 3D, es decir, posicionamiento, dirección del sonido (por efecto doppler), volumen, etc.

Luego estos datos se convertirán al formato oportuno de salida, que será Dolby Atmos, DTS, PCM, o el que sea, y en base al número de canales, 5.1, 7.1, etc.

En resumen, se programa con una API y luego se convierte a un formato de salida.

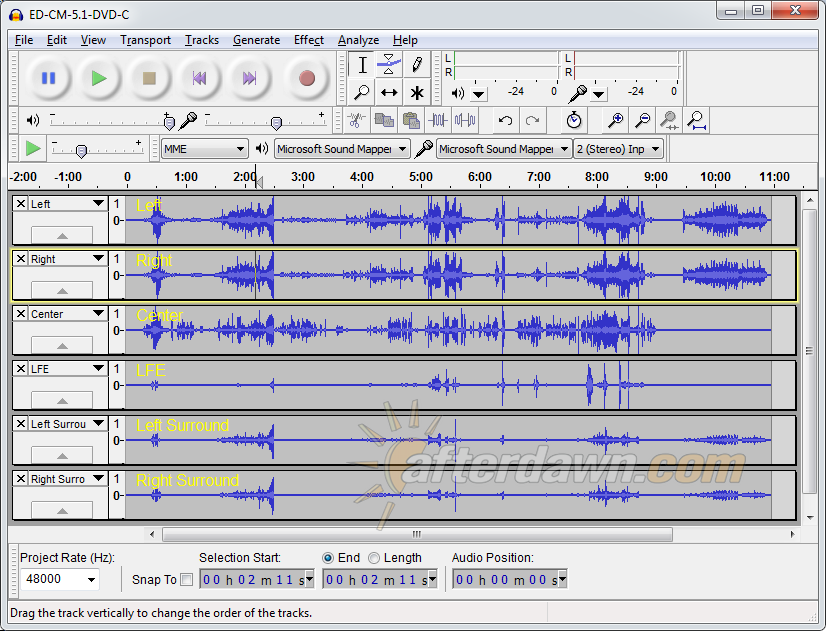

En qué consiste dicha conversión, pues primero hay que convertir esos vectores y metadatos (volumen, etc.) en ondas, es decir, amplitud, mezcla de canales (si un sonido debe salir por varios), etc. Una imagen vale más que mil palabras, hay que convertir esa serie de metadatos en esto:

Qué hace el chip de sonido 3D, pues dicha conversión. Y por aclararlo también, la XOne de 2013 ya lo llevaba.

Si luego tenemos la salida configurada en algún formato Bitstream, como algún Dolby o DTS, es decir, distinto de PCM, pues toca codificarlo (a veces supone compresión) a dicho formato, para que el AVR externo lo reconozca y lo decodifique, para finalmente enviar las señales eléctricas a los altavoces, que es lo que hace que suenen. Esto ya no es cosa del chip de sonido 3D, si no de un conversor, que puede ser también por software, o mediante un co-procesador, normalmente incluído en cualquier consola si ésta te deja poner dichos formatos de salida. Por ejemplo, la X360 tenía un codificador Dolby Digital, por eso es el único formato de salida que deja poner. Aunque también puede integrarse todo en el mismo chip.

En juegos hay que programarlo, evidentemente, no se va a usar solo, el acceso al chip es a través de la API puesta a disposición del programador. Que hay quien no la use, pues lo hay, Unity 3D lleva el audio integrado por software, y no hay constancia de que use el audio por hardware en ninguna de sus variantes ni intención de usarlo.