Zaguer escribió:Tiene pinta de que la FE 3080 es mas pequeña que las custom no? mi caja es enana y necesito la gráfica mas pequeña que haya (dentro de las 3080).

La FE son 285mm, tiene pinta de que las custom son mas de 30cm...

yonnah escribió:Existe diferencia respecto a potencia la founders y las custom o solo es refrigeración y diseño?

goku593 escribió:Wanderlei escribió:Una cuestión, cuando habláis de que se puede quedar corta de vram la 3080, habláis de resoluciones 4k o 2k?

Voy a comprar la 3080 para sacar partido a mi monitor 1440p 170hz, no me interesa para nada el 4k. Creéis que se quedará corta en 4 años que es lo que pienso aguantarla?

Se queda corta ya. Imagina en 4 años.

Horizon se come 12 Gbs de Vram.

Smoje escribió:Zaguer escribió:Tiene pinta de que la FE 3080 es mas pequeña que las custom no? mi caja es enana y necesito la gráfica mas pequeña que haya (dentro de las 3080).

La FE son 285mm, tiene pinta de que las custom son mas de 30cm...

Esto es una lista parcial, pero te puedes hacer una idea:

garbagecrystal escribió:goku593 escribió:garbagecrystal escribió:

No hay DLSS 3.0.

¿Pero el DLSS de las 3000 es distinto al de las 2000? ¿Hay una nueva versión compatible con las nuevas?

Es el mismo. Se supone que con más tensor cores pues igual se ejecuta más rápido, claro.

De hecho, que me venga a la cabeza no hay nada tecnológicamente hablando en las 3000 que no se esté en las 2000, a parte claro está del PCIe4

goku593 escribió:garbagecrystal escribió:Nomada_Firefox escribió:Supongo que esto va por el DirectStorage que Nvidia vende como RTX IO. Nada más lejos de la realidad, no es algo de Nvidia, es de Microsoft y lo van a incorporar a Windows 10. Asi que no es algo exclusivo de Ampere.

Asi que Ampere solo trae el DLSS 3.0

No hay DLSS 3.0.

¿Pero el DLSS de las 3000 es distinto al de las 2000? ¿Hay una nueva versión compatible con las nuevas?

Nomada_Firefox escribió:La unica gracia de Ampere es la fuerza bruta. Ese 40% de mejora razonable provocado por sacar graficas cada 2 años. Normal que la 3070 sea mejor que la 2080Ti. Y la 3060 por regla de 3 deberia ser igual o casi que una 2080.

Antoniopua escribió:La compraré donde más barata sea... sobre las tiendas de aquí, ellos sabrán lo que hacen...

garbagecrystal escribió:Bio81 escribió:eimia escribió:buenas, como veis una 3080 para una placa base pci express 3.0? tengo entendido que funcionan mejor con una placa pci 4.0.

Aqui en este enlace dicen que es un rotundo NO, que no es necesario el pci 4.0 para gaming.

Vosotros como lo veis?

https://hardzone.es/noticias/tarjetas-g ... x-3070-ti/

así es , el PCI-E 3.0 16x sobra incluso para 8K:

Si entiendo bien esa imagen, está calculando si el PCIe es suficiente comparándolo con el fillrate necesario para la resolución objetivo.

Eso no me parece que tenga sentido alguno

Nomada_Firefox escribió:El PCIe 4.0 es nada porque las diferencias entre el 4.0 y el 3.0 son infimas.

Nomada_Firefox escribió:Nadie lo ha confirmado todavia pero se supone que el DLSS de Ampere se puede usar en cualquier juego con TAA. Mientras que eso no estaba en las RTX 2000.

Pero dicha afirmación es un sin sentido porque los juegos con TAA son los mismos que usan DLSS. No va a haber juegos con TAA que no usen DLSS seguramente. Admito que es el humo que algunos han querido vender.

Zaguer escribió:Aqui en UK la mas barata es la Palit

https://www.overclockers.co.uk/palit-ge ... 5d-pl.html

£10 mas barata que la FE. Vamos yo es que no me lo pienso, voy a por la FE de cabeza xD

Aquí el listado completo por si a alguien le interesa:

https://www.overclockers.co.uk/pc-compo ... =1&sSort=3

Bio81 escribió:garbagecrystal escribió:Bio81 escribió:

así es , el PCI-E 3.0 16x sobra incluso para 8K:

Si entiendo bien esa imagen, está calculando si el PCIe es suficiente comparándolo con el fillrate necesario para la resolución objetivo.

Eso no me parece que tenga sentido alguno

lo que en esa imagen se compara es al ancho de banda necesario para 4k 144 Hz con una profundidad de color de 10 Bit da 35.83 Gbps y el PCI-E 3.0 X16 tiene un ancho de banda de 126.4 Gbps

https://www.profesionalreview.com/2019/ ... fica-nada/

https://elchapuzasinformatico.com/2019/ ... os-gamers/

https://hardwaresfera.com/noticias/hard ... os-gamers/

wildchild_bcn escribió:WGP Kakashii escribió:estoy viendo la foto de la strix en pccom y parece q tiene 3 conectores de corriente, es asi?

si, la strix va a tener 3 conectores de corriente

para los preocupados del tema nvme y pcie4:

SSD Requirement for Ampere

Pengwin17523 – Will there be a certain ssd speed requirement for RTX I/O?

[Tony Tamasi] There is no SSD speed requirement for RTX IO, but obviously, faster SSD’s such as the latest generation of Gen4 NVMe SSD’s will produce better results, meaning faster load times, and the ability for games to stream more data into the world dynamically. Some games may have minimum requirements for SSD performance in the future, but those would be determined by the game developers. RTX IO will accelerate SSD performance regardless of how fast it is, by reducing the CPU load required for I/O, and by enabling GPU-based decompression, allowing game assets to be stored in a compressed format and offloading potentially dozens of CPU cores from doing that work. Compression ratios are typically 2:1, so that would effectively amplify the read performance of any SSD by 2x.

https://videocardz.com/newz/nvidia-prov ... -30-series

garbagecrystal escribió:Nomada_Firefox escribió:El PCIe 4.0 es nada porque las diferencias entre el 4.0 y el 3.0 son infimas.

Bueno, es el doble de ancho de banda en el bus. Ya veremos si juega un papel importante o no, pero lo cierto es que no podemos utilizar información actual y extrapolar si cambiamos el paradigma y se espera acceso directo al NVME de ahora en adelante.

Lo que sí que pienso yo es que hasta que los NVME medios saturen el PCIe3 faltan algunos años.Nomada_Firefox escribió:Nadie lo ha confirmado todavia pero se supone que el DLSS de Ampere se puede usar en cualquier juego con TAA. Mientras que eso no estaba en las RTX 2000.

Pero dicha afirmación es un sin sentido porque los juegos con TAA son los mismos que usan DLSS. No va a haber juegos con TAA que no usen DLSS seguramente. Admito que es el humo que algunos han querido vender.

Nadie ha confirmado eso ni lo van a confirmar porque no será así.

Por un lado, no hay diferencias en DLSS entre las 2000 y las 3000. Falta ver el white paper pero al final DLSS es un algoritmo que NO está en el hardware, por lo que la única diferencia en ese sentido entre las 2000 y las 3000 será la velocidad a la que puedan aplicarlo. Eso puede hacer que en el mismo tiempo puedan inferir más o mejor, así que quizá ganamos calidad o penalizamos menos el framerate en las 3000, pero la tecnología en sí es la misma en una 2000.

Por otro lado, aplicar DLSS vía drivers en los juegos con TAA no tiene mucho sentido. No es como aplicar un efecto de post procesado y a correr. Otra cosa es que se inventen un reescalador por post basado en ML, pero eso no sería DLSS.

![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

garbagecrystal escribió:Bio81 escribió:garbagecrystal escribió:

Si entiendo bien esa imagen, está calculando si el PCIe es suficiente comparándolo con el fillrate necesario para la resolución objetivo.

Eso no me parece que tenga sentido alguno

lo que en esa imagen se compara es al ancho de banda necesario para 4k 144 Hz con una profundidad de color de 10 Bit da 35.83 Gbps y el PCI-E 3.0 X16 tiene un ancho de banda de 126.4 Gbps

https://www.profesionalreview.com/2019/ ... fica-nada/

https://elchapuzasinformatico.com/2019/ ... os-gamers/

https://hardwaresfera.com/noticias/hard ... os-gamers/

Entonces lo he entendido bien, pero sigo sin verle el sentido.

Vale, necesitas 35.83 Gbps para mover un frontbuffer de 4k 144 veces por segundo, pero para generar ese frontbuffer necesitarás más datos que esos 35.83 Gbps. De lo contrario no nos harían falta memorias de GPUs de más de 40 Gbps y estamos ya llegando a los 1000 GB/s (que no gigabits)

No digo que PCIe4 hoy en día sea necesario, eso ya lo veremos los próximos años, pero que esa comparativa no tiene mucho sentido sí que lo digo

Bio81 escribió:garbagecrystal escribió:Bio81 escribió:

lo que en esa imagen se compara es al ancho de banda necesario para 4k 144 Hz con una profundidad de color de 10 Bit da 35.83 Gbps y el PCI-E 3.0 X16 tiene un ancho de banda de 126.4 Gbps

https://www.profesionalreview.com/2019/ ... fica-nada/

https://elchapuzasinformatico.com/2019/ ... os-gamers/

https://hardwaresfera.com/noticias/hard ... os-gamers/

Entonces lo he entendido bien, pero sigo sin verle el sentido.

Vale, necesitas 35.83 Gbps para mover un frontbuffer de 4k 144 veces por segundo, pero para generar ese frontbuffer necesitarás más datos que esos 35.83 Gbps. De lo contrario no nos harían falta memorias de GPUs de más de 40 Gbps y estamos ya llegando a los 1000 GB/s (que no gigabits)

No digo que PCIe4 hoy en día sea necesario, eso ya lo veremos los próximos años, pero que esa comparativa no tiene mucho sentido sí que lo digo

esa comparativa la hizo intel , puedes entrar en los enlaces y leer para saber de que va el tema

josemurcia escribió:

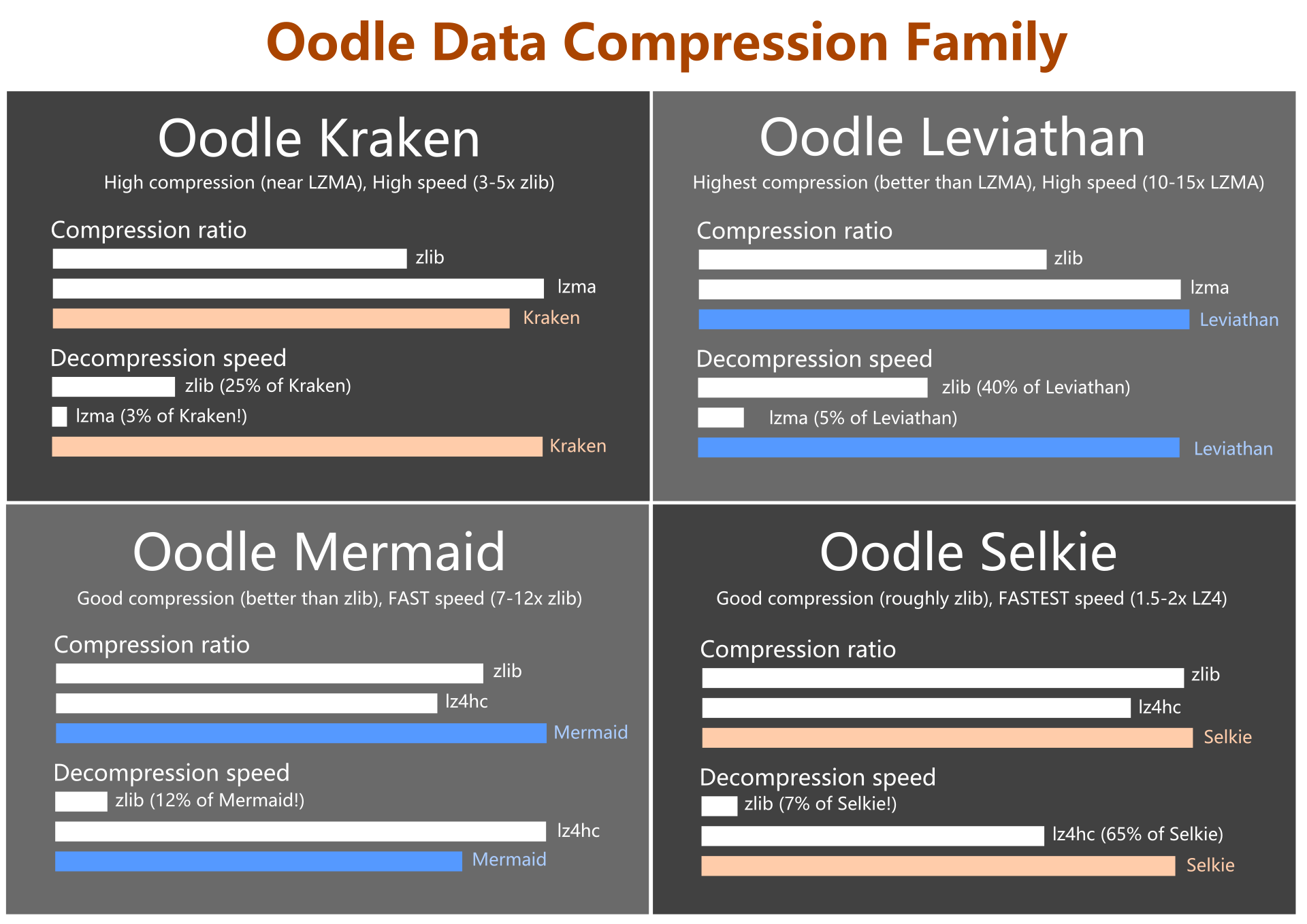

Tienes razón, BCPack es compresión de texturas, no de bloque. En ese caso en XSX se puede usar Oodle Texture + ZLib que dará un rendimiento similar a Oodle Texture + Kraken, pero como te digo no es un rendimiento que puedas extrapolar al aplicar solo a texturas con compresión.

Lo demás como siempre te lo inventas, los ratios 2:1 de Microsoft y NVIDIA son de usar BCn + Zlib o BCPack + ZLib en el caso de Xbox (supuestamente, lo mismo BCPack ofrece una compresión similar a Oodle Texture con compresión).

josemurcia escribió:

No te basta con publicar un benchmark sin saber interpretarlo si no que ahora pones otro distinto, con otras condiciones distintas y te inventas que es por saturación del PCIe.

Cada benchmark pone a prueba condiciones diferentes que rinden de forrma diferente según la disposición de las memorias, su calidad, el microcontrolador, el firmware, etc.

Si en otro benchmark da peor resultado es porque la velocidad anunciada de los SSD es en condiciones óptimas, como se ve en el benchmark ATTO, en condiciones más parecidas a un uso real siempre darán por debajo por simples limitaciones del propio disco, y puedes ver que pasa lo mismo con todos los SSD, da igual que "saturen" el PCIe o no.

Por ejemplo el Samsung 950 Pro que en ATTO da 2.5Gbps de lectura pero luego en otros tests menos óptimos da 2.

https://www.anandtech.com/show/9702/sam ... gb-512gb/8

Las evidencias las tienes ahí, puedes seguir inventándote que el PCIe se satura o asumir que con el disco adecuado el ancho de banda en PC será un 30% mayor que el de PS5 sobre PCIe 4.

Nowcry escribió:

Ahi queria llegar yo, eso es imposible, Zlib nunca rendirá como kraken. Para que iba nadie a gastarse la pasta en la licencia de kraken si Zlib rinde igual y es gratis...........pues porque no rinden igual.

Nowcry escribió:

Puedes seguir pensando que no se interpretar un los benchmark, ya solo puedo explicarlo por reduccion a lo absurdo:

Puesto que eres el único de todos los foros en los que se esta hablando de esto incluido el de Nvidia que piensa que los 14 GB/s son sostenidos.

También debes ser el único que intenta demostrar que en MS/Sony/fabricantes de SSD son idiotas y que por ejemplo en MS no supieron usar sus dos lineas de PCIeGen4 las cuales según tu teoría podrían conseguir unos 4 GB/s teóricos y que según tu podrían conseguir 3,5 GB/s sostenidos y curiosamente les han asignado una trasferencia de 2,5 GB/s sostenidos oficialmente.

Y luego en Sony que han conseguido un SSD de 12 canales de 1 GB/s que en realidad ofrecería una trasferencia de 12 GB/s han puesto de pico 11GB/s (22 GB/s comprimido) y sostenidos 9 GB/s. Joe mira que son inútiles pudiendo saturar las lineas de PCI sin ningún problema.

La próxima vez les mandamos tu curriculum y ya se lo diseñas tu.

josemurcia escribió:Nowcry escribió:

Ahi queria llegar yo, eso es imposible, Zlib nunca rendirá como kraken. Para que iba nadie a gastarse la pasta en la licencia de kraken si Zlib rinde igual y es gratis...........pues porque no rinden igual.

En escenarios reales es solo un 10% más eficiente que ZLib, lo dice el propio Cerny en su video.

https://youtu.be/ph8LyNIT9sg?t=1015

Un 10% de mejora en la compresión sin pérdida palidece comparación a la diferencia entre el ancho de banda de un SSD PCIe 4 frente al de PS5. Y eso contando con que NVIDIA no soporte Kraken en su HW.Nowcry escribió:

Puedes seguir pensando que no se interpretar un los benchmark, ya solo puedo explicarlo por reduccion a lo absurdo:

Puesto que eres el único de todos los foros en los que se esta hablando de esto incluido el de Nvidia que piensa que los 14 GB/s son sostenidos.

También debes ser el único que intenta demostrar que en MS/Sony/fabricantes de SSD son idiotas y que por ejemplo en MS no supieron usar sus dos lineas de PCIeGen4 las cuales según tu teoría podrían conseguir unos 4 GB/s teóricos y que según tu podrían conseguir 3,5 GB/s sostenidos y curiosamente les han asignado una trasferencia de 2,5 GB/s sostenidos oficialmente.

Y luego en Sony que han conseguido un SSD de 12 canales de 1 GB/s que en realidad ofrecería una trasferencia de 12 GB/s han puesto de pico 11GB/s (22 GB/s comprimido) y sostenidos 9 GB/s. Joe mira que son inútiles pudiendo saturar las lineas de PCI sin ningún problema.

La próxima vez les mandamos tu curriculum y ya se lo diseñas tu.

Vamos, que ante la evidencia de los datos sales por el carril del medio a tirar de falacias ad populum, pues muy bien, mándale tu CV tu a Cerny que parece que podrías hacer magia y ofrecerles el doble de rendimiento del que han conseguido en PS5 con el mismo HW.

Metalyard escribió:Yo lo que no entiendo es que hasta hace dos días , una 2080Ti era un graficón con 11GB y ahora una 3080 con 10GB se queda corta

![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

Bio81 escribió:Metalyard escribió:Yo lo que no entiendo es que hasta hace dos días , una 2080Ti era un graficón con 11GB y ahora una 3080 con 10GB se queda corta

tu lo has dicho ahora , pero con juegos de nueva generación lo mas probable y conociendo a Nvidia es que saque una 3080 Super con mas Vram en unos meses o un año para el que quiera jugar a 4k sin sacrificar texturas o algún efecto grafico con la 3080 de 10 GB y te obligue a pasar por caja de nuevo , ahí esta el tema , la 2080 Ti a ido bien de memoria en la generación de ps4 y xbox one , pero eso no garantiza que siga siendo así en un año por ejemplo

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

alvaro200 escribió:Sacado de la propia Nvidia en reddit, hablando sobre el tema de la VRAM:Why only 10 GB of memory for RTX 3080? How was that determined to be a sufficient number, when it is stagnant from the previous generation?

[Justin Walker] We’re constantly analyzing memory requirements of the latest games and regularly review with game developers to understand their memory needs for current and upcoming games. The goal of 3080 is to give you great performance at up to 4k resolution with all the settings maxed out at the best possible price.

In order to do this, you need a very powerful GPU with high speed memory and enough memory to meet the needs of the games. A few examples - if you look at Shadow of the Tomb Raider, Assassin’s Creed Odyssey, Metro Exodus, Wolfenstein Youngblood, Gears of War 5, Borderlands 3 and Red Dead Redemption 2 running on a 3080 at 4k with Max settings (including any applicable high res texture packs) and RTX On, when the game supports it, you get in the range of 60-100fps and use anywhere from 4GB to 6GB of memory.

Extra memory is always nice to have but it would increase the price of the graphics card, so we need to find the right balance.

Fuente

Metalyard escribió:Bio81 escribió:Metalyard escribió:Yo lo que no entiendo es que hasta hace dos días , una 2080Ti era un graficón con 11GB y ahora una 3080 con 10GB se queda corta

tu lo has dicho ahora , pero con juegos de nueva generación lo mas probable y conociendo a Nvidia es que saque una 3080 Super con mas Vram en unos meses o un año para el que quiera jugar a 4k sin sacrificar texturas o algún efecto grafico con la 3080 de 10 GB y te obligue a pasar por caja de nuevo , ahí esta el tema , la 2080 Ti a ido bien de memoria en la generación de ps4 y xbox one , pero eso no garantiza que siga siendo así en un año por ejemplo

Umm no se no se, creo que se está exagerando un poco con el tema de la Vram de las gráficas...

Si nos referimos a que la VRam está sobretodo relacionado con el texturizado de los juegos, creo que cobra su importancia el tener mayor capacidad de Ram simplemente y plantarse con un mínimo de 32GB y tener instalado los juegos en un SSD obviamente...es decir, por ponerte un ejemplo, mi GTX 1080 se defiende bastante bien con sus 8GB GDDR5X a una media de 40/45 FPS a 3440X1440 mi Skyrim SE con 1000 mods con texturas en 8K y 4K que se rien de las de Red Dead Redemption 2...Eso sí, tuve que ampliar a 32GB de Ram al equipo![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

ikemen escribió:alvaro200 escribió:Sacado de la propia Nvidia en reddit, hablando sobre el tema de la VRAM:Why only 10 GB of memory for RTX 3080? How was that determined to be a sufficient number, when it is stagnant from the previous generation?

[Justin Walker] We’re constantly analyzing memory requirements of the latest games and regularly review with game developers to understand their memory needs for current and upcoming games. The goal of 3080 is to give you great performance at up to 4k resolution with all the settings maxed out at the best possible price.

In order to do this, you need a very powerful GPU with high speed memory and enough memory to meet the needs of the games. A few examples - if you look at Shadow of the Tomb Raider, Assassin’s Creed Odyssey, Metro Exodus, Wolfenstein Youngblood, Gears of War 5, Borderlands 3 and Red Dead Redemption 2 running on a 3080 at 4k with Max settings (including any applicable high res texture packs) and RTX On, when the game supports it, you get in the range of 60-100fps and use anywhere from 4GB to 6GB of memory.

Extra memory is always nice to have but it would increase the price of the graphics card, so we need to find the right balance.

Fuente

He leído el articulo que han testeado varios juegos TOP de la actualidad y el consumo medio de VRAM oscila entre 4~6 GB (6~10 GB de la generación Turing), lo cual concuerda con la reducción por la compresión de los tensor cores, un 40% del consumo de VRAM.

Por lo tanto la RTX 3070 viene preparada con un pequeño margen para aguantar mínimo 3 años a Full para 1440p y +70~120fps o 4K 60fps en Ultra. Y la 3080 estimo que no será hasta 2024 cuando aparezca algún juego que puedan empezar a demandar mas de 10GB (Teoricos 14GB de la generación Turing) sobrada para 4K 60fps en Ultra/High durante un lustro.

Por otro lado, yo pronostico que la RTX 3060 tendrá 6GB de VRAM GDDR6 a 16 Ggps, a aprox 1,8 Ghz y tendría una potencia de 12 Tflops. Siendo así ligeramente superior a la RTX 2080 Super, costando sus 300€ Ideal para 1080 a full durante los próximos 5 años o 1440p +60fps para los próximos 3 años y defendiéndose en 4K 60fps en los juegos actuales en Ultra.

Edit: Como todos sabemos, podemos alargar la vida de las gráficas bajando settings. Yo estube con una GTX 670 de 2GBGDDR5 de 2012 a 2018. Porque jugaba a 1080p. Pero a la que me pillé un monitor 1440p 144hz te pide otra gráfica mas pepino. Me pillé la GTX 1060 de 6GBGDD5, de transición, llevo con ella 2 años, pero deseando pillarme una 3070 o 3080 para darle cera y que me dure mínimo 6 añitos.

ikemen escribió:alvaro200 escribió:Sacado de la propia Nvidia en reddit, hablando sobre el tema de la VRAM:Why only 10 GB of memory for RTX 3080? How was that determined to be a sufficient number, when it is stagnant from the previous generation?

[Justin Walker] We’re constantly analyzing memory requirements of the latest games and regularly review with game developers to understand their memory needs for current and upcoming games. The goal of 3080 is to give you great performance at up to 4k resolution with all the settings maxed out at the best possible price.

In order to do this, you need a very powerful GPU with high speed memory and enough memory to meet the needs of the games. A few examples - if you look at Shadow of the Tomb Raider, Assassin’s Creed Odyssey, Metro Exodus, Wolfenstein Youngblood, Gears of War 5, Borderlands 3 and Red Dead Redemption 2 running on a 3080 at 4k with Max settings (including any applicable high res texture packs) and RTX On, when the game supports it, you get in the range of 60-100fps and use anywhere from 4GB to 6GB of memory.

Extra memory is always nice to have but it would increase the price of the graphics card, so we need to find the right balance.

Fuente

He leído el articulo que han testeado varios juegos TOP de la actualidad y el consumo medio de VRAM oscila entre 4~6 GB (6~10 GB de la generación Turing), lo cual concuerda con la reducción por la compresión de los tensor cores, un 40% del consumo de VRAM.

Por lo tanto la RTX 3070 viene preparada con un pequeño margen para aguantar mínimo 3 años a Full para 1440p y +70~120fps o 4K 60fps en Ultra. Y la 3080 estimo que no será hasta 2024 cuando aparezca algún juego que puedan empezar a demandar mas de 10GB (Teoricos 14GB de la generación Turing) sobrada para 4K 60fps en Ultra/High durante un lustro.

Por otro lado, yo pronostico que la RTX 3060 tendrá 6GB de VRAM GDDR6 a 16 Ggps, a aprox 1,8 Ghz y tendría una potencia de 12 Tflops. Siendo así ligeramente superior a la RTX 2080 Super, costando sus 300€ Ideal para 1080 a full durante los próximos 5 años o 1440p +60fps para los próximos 3 años y defendiéndose en 4K 60fps en los juegos actuales en Ultra.

Edit: Como todos sabemos, podemos alargar la vida de las gráficas bajando settings. Yo estube con una GTX 670 de 2GBGDDR5 de 2012 a 2018. Porque jugaba a 1080p. Pero a la que me pillé un monitor 1440p 144hz te pide otra gráfica mas pepino. Me pillé la GTX 1060 de 6GBGDD5, de transición, llevo con ella 2 años, pero deseando pillarme una 3070 o 3080 para darle cera y que me dure mínimo 6 añitos.

Lebroncito escribió:Miles Wolf escribió:

La VRAM que montan la 3070 y la 3080 es justita (para jugar a más de 1080p y 60Hz digo), no hay que darle más vueltas..

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

pero de donde coño salis vosotros?

Wanderlei escribió:yonnah escribió:@Gwyn D) Por la 3090 y no tendras problema

E) Atracar un banco para costear la 3090