ditifet escribió:pinturito escribió:ditifet escribió:

Cuantas 8000/9000/200 quieres juapo?![enrojecido [ayay]](/images/smilies/nuevos/sonrojado_ani1.gif)

Ostras tienes toda la coleccion![enamorado [amor]](/images/smilies/nuevos/enamorado.gif)

![enamorado [amor]](/images/smilies/nuevos/enamorado.gif)

que chulada.... por cierto, creo recordar que la 9800gtx era casi practicamente la misma grafica que la 8800gtx, para que luego vengan diciendo que antes entre generaciones habia el doble o el triple de rendimiento

Exacto y la GTX250 que sacaron después otro refrito de la 8800GTX, por cierto Pccomponentes malditos timadores, se me jodió una GTX250 y no quisieron cambiármela en garantía, Ni 1 maldito pendrive les he vuelto a comprar.

Para los que dicen que con el tiempo y la fama van a peor, fué su 1 o 2º año de apertura y ya la liaban.

DJ Deu escribió:Antes con cada generación de gráficas se duplicaba o triplicaba la potencia de una a otra.

Que a ti te parece bien que se potencien tecnologías para engañarte y hacerte ver que ganas frames con ello? Me parece perfecto, pero a mi me parece una estafa.

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif) , no se qué tiempo tendría pero un año y pico duró.

, no se qué tiempo tendría pero un año y pico duró. Sicopro escribió:@DJ Deu

Estamos de coña, al menos yo lo estoy, no te mosques. Pero vamos que has entrado como un elefante en una cacharrería soltando mierda básicamente y encima llamando a la gente fanboy.

@ditifet

Una colección espectacular, de hecho veo que tienes el ensamble que tuve, es la de color verde y blanco de XFX, me acuerdo de la imagen. Aunque creo que esa es la GTS y me parece que la que tenía era la GTX, pero no me acuerdo ya.

ditifet escribió:pinturito escribió:Sicopro escribió:@pinturito

Por eso le decía lo de comentario pollavieja, habla del pleistoceno, de la época de las GeForce 8800 GTX y por ahí, de la cual por cierto tuve un ensamble de XFX.

Ahí si que fue del doble pero eso era el 2006, por eso lo de casi 20 años.

O una de 2, o es un troll y viene en busca de flame, o no ha tocado un PC en los ultimos 20 años como tu bien dices, hagan sus apuestas.

Por cierto yo tambien tuve una Geforce 8800 GTX de 512 megas con un intel core 2 quad Q6600 creo que fue el primer procesador de Intel con 4 nucleos despues de eso salieron los primero I3, I5, I7.....

Cuantas 8000/9000/200 quieres juapo?![enrojecido [ayay]](/images/smilies/nuevos/sonrojado_ani1.gif)

metallah escribió:dunkam82 escribió:joshicko escribió:@rusochan yo voy a hacer eso mismo que te comentan los compis, me sigo quedando con mi 5800x y voy a pillarme la 5070ti.

No merece el cambio de irse a una cpu un poco mejor cuando lo importante y lo mejor para jugar lo vas a conseguir con la gráfica.

Así a futuro tienes tiempo de ahorrar y cambiar a la siguiente plataforma am5 o quizás futurible am6.

Yo voy a ir a por la 5080 con el 5800X también y tan ricamente, 0 preocupaciones.

Pues yo tengo un 3800x y tenía pensado pasarme a AM5, pero puesto que todo está tan caro, no sé si pillarme un 5700x3d, que están tirados de precio y pillar la 5070ti o 5080 y tirar. Para jugar a 1440p y 120 fps (y VR), ¿cómo lo veis?

Saludos.

RVNLOFT escribió:Echad un vistazo en el 1:44:28 a la pregunta y a la respuesta

https://youtu.be/HLxVskv2zs0

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

dunkam82 escribió:RVNLOFT escribió:Echad un vistazo en el 1:44:28 a la pregunta y a la respuesta

https://youtu.be/HLxVskv2zs0

Me sé de alguno de cuyo nombre no quiero acordarme que últimamente entra a este hilo para decir paridas que le puede dar un patatús si ve eso

neox3 escribió:Con esto gana enteros el rumor de que la proxima xbox, llevará grafica nvidia...

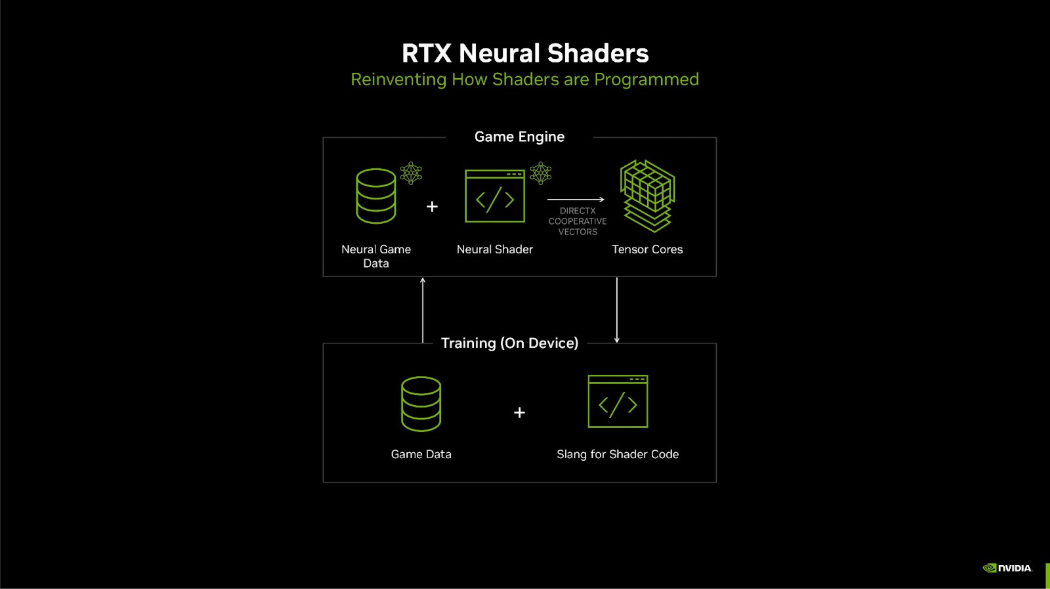

Microsoft is working with partners such as AMD, Intel, NVIDIA, and Qualcomm to integrate cooperative vector support into the DirectX ecosystem, allowing AI-accelerated graphical computation to flow much more seamlessly.

HakiGold escribió:Al menos que Nvidia se tenga escondido algún aumentó de IPC que saldrá en las review.. efectivamente las RTX 5000 serian un refrito, serían las RTX4000 con Cudas y ancho de banda extra.

![brindis [beer]](/images/smilies/nuevos2/brindando.gif)

RVNLOFT escribió:Echad un vistazo en el 1:44:28 a la pregunta y a la respuesta

https://youtu.be/HLxVskv2zs0

HakiGold escribió:Y ya es el segundo juego que no mejora nada en Ray Tracing apesar que Nvidia reclama mejoras en los RT Cores y aquí había un usuario inventandose cosas de la IA que iba mejorar un montón el Ray Tracing.....

Impacto en el Ray Tracing (RT):

Optimización del rendimiento:

Los nuevos Tensor Cores de quinta generación permitirán aplicar técnicas de IA para calcular y predecir reflejos, sombras y refracciones más rápido, complementando el cálculo tradicional del RT. Esto significa que, aunque el RT seguirá utilizando núcleos específicos para sus cálculos físicos, la IA podría suavizar y completar algunos de estos cálculos con una fracción del esfuerzo computacional.

Calidad visual mejorada:

La IA puede "rellenar" detalles en escenas con RT, generando iluminación global y efectos visuales complejos con menor costo en rendimiento. Esto podría hacer que el RT sea más accesible en tarjetas de gama media o incluso en portátiles, ya que se dependerá menos de la fuerza bruta del hardware.

Integración con DLSS 4:

DLSS 4 y su capacidad de Multi Frame Generation también tendrán un impacto en el RT. Al generar múltiples cuadros adicionales mediante IA, los juegos podrán mantener un RT fluido incluso en resoluciones altas como 4K.

Impacto en CUDA:

Optimización del pipeline de gráficos:

Al integrar más IA en el pipeline gráfico, CUDA permitirá una delegación más eficiente de tareas entre núcleos RT, Tensor Cores y los núcleos CUDA, optimizando el uso general de la GPU.

Los Tensor Cores están diseñados para acelerar operaciones matriciales y cálculos relacionados con la IA, como inferencias en redes neuronales. Con tecnologías como DLSS 4 y neural shaders, muchas de las tareas que antes requerían cálculos intensivos en FP32 pueden ser asumidas por los Tensor Cores.

Por ejemplo:

Upscaling de imágenes.

Generación de cuadros adicionales (frame generation).

Compresión y reconstrucción de texturas.

Predicción de trayectorias de luz para complementar el ray tracing.

Menor carga en núcleos CUDA:

Las tareas que históricamente dependían de núcleos CUDA, como la rasterización, sombreado y parte del ray tracing, ahora se dividen con los Tensor Cores. Esto libera a los núcleos CUDA para concentrarse en cálculos críticos de FP32.

Reducción de la dependencia de TFLOPS FP32:

Mayor rendimiento relativo:

Si los Tensor Cores y RT Cores asumen tareas específicas, el rendimiento general de la GPU ya no estará tan atado a la cantidad de TFLOPS FP32. Esto significa que una GPU con menos núcleos CUDA, pero con Tensor Cores más avanzados, podría ofrecer un rendimiento superior en gráficos y simulaciones optimizadas por IA.

Enfoque en rendimiento real:

El rendimiento ya no se medirá únicamente en TFLOPS FP32, sino en métricas más representativas como cuadros por segundo en juegos con RT+DLSS, capacidad de generar cuadros adicionales y procesamiento de efectos avanzados en tiempo real.

Blackwell Brings AI to Shaders

Twenty-five years ago, NVIDIA introduced GeForce 3 and programmable shaders, which set the stage for two decades of graphics innovation, from pixel shading to compute shading to real-time ray tracing. Alongside GeForce RTX 50 Series GPUs, NVIDIA is introducing RTX Neural Shaders, which brings small AI networks into programmable shaders, unlocking film-quality materials, lighting and more in real-time games.

Rendering game characters is one of the most challenging tasks in real-time graphics, as people are prone to notice the smallest errors or artifacts in digital humans. RTX Neural Faces takes a simple rasterized face and 3D pose data as input, and uses generative AI to render a temporally stable, high-quality digital face in real time.

RTX Neural Faces is complemented by new RTX technologies for ray-traced hair and skin. Along with the new RTX Mega Geometry, which enables up to 100x more ray-traced triangles in a scene, these advancements are poised to deliver a massive leap in realism for game characters and environments.

The power of neural rendering, DLSS 4 and the new DLSS transformer model is showcased on GeForce RTX 50 Series GPUs with Zorah, a groundbreaking new technology demo from NVIDIA.

NVIDIA today unveiled next-generation hardware for gamers, creators, and developers—the GeForce RTX 50 Series desktop and laptop GPUs. Alongside these GPUs, NVIDIA introduced NVIDIA RTX Kit, a suite of neural rendering technologies to ray trace games with AI, render scenes with immense geometry, and create game characters with lifelike visuals. RTX Kit enhances geometry, textures, materials, and lighting, providing greater visual fidelity and performance for complex open worlds while reducing artifacts, instability, and VRAM usage. Developers can integrate individual—or all—RTX Kit SDKs directly into their rendering pipeline.

HakiGold escribió:@ditifet

Estás mezclando GPU la contrincante de la GTX200 si la memoria no me falla fueron las HD4000 o HD5000, R9 200 salieron años después 2013 o 2014 creo.

Esa R9 295 x2 fue un caso especial de consumo, pero es que vamos esa GPU era una GPU doble pegada en el PCB, no se puede comparar con una 5090 que es una sola GPU que consume 600w, las GPU duales andaban en los 300-400w, y las de una sola GPU menos.

Y aun así 300w ya se consideraban un consumo altísimo.

joshicko escribió:@rusochan yo voy a hacer eso mismo que te comentan los compis, me sigo quedando con mi 5800x y voy a pillarme la 5070ti.

No merece el cambio de irse a una cpu un poco mejor cuando lo importante y lo mejor para jugar lo vas a conseguir con la gráfica.

Así a futuro tienes tiempo de ahorrar y cambiar a la siguiente plataforma am5 o quizás futurible am6.

Goncatin escribió:Yo tengo una pregunta al respecto, todo esto se hace en local, o el dlss y el fg necesita conexión a internet?

Consolero97 escribió:Las 80 y 90 por precio quedan descartadas para mi, pero una 5070ti me cuadra bastante, con jugar a 1440p en ultra a 120fps y en 4K un minimo de 60 en cualquier juego me sobraria.

Y creo que con la 5070ti podria ir servido, opiniones? Vengo de una series X y despues de haber jugado toda la vida en consolas, me quiero aventurar en el mundo del PC

pakolo1977 escribió:Aunque soy un poco ludita y siempre diré que a la larga la ia nos va a dar problemas grandes a los seres humanos, para esto en particular no hay un peligro inmediato y en el día a día lo uso porque también no queda más remedio.

El Black myth wukong por ejemplo se arrastra por el fango si desactivo dlss y fg pero dejo el rt activado. Y así ya hay no pocos juegos, está claro que esto ha venido para quedarse. Ya me gustaría que todo el mundo hiciera cosas al nivel de calidad gráfica de red dead redemption 2 solamente con raster o que optimizaran las cosas nivel doom eternal. Cuando llegó el chino juan en el 2018 al principio me flipó ver el raytracing en tiempo real y le tiré a una 2080 founders para verlo de primera mano, pero vaya, que ya llevamos más de 6 años y eso ya no sorprende.

Ahora todo el mundo se flipa con la prestidigitación, los que fueron la semana pasada al CES ese no paran de contar parabienes de lo que se viene, que a fin de cuentas no deja de ser el truco de la chistera y el conejo. Quiero decir, está claro que de aquí a un mes van a haber videojuegos que se van a ver todavía mejor de lo que se ven ahora mismo y hasta sin tener que cambiar de gráfica rtx. Pero el que quiera ver todos los trucos a la vez tiene que pasar por caja y además dejarse por lo menos 650 euros teniendo mucha suerte.

Más honesto es pagar la entrada a un teatro y ver en directo a Juan Tamariz hacer cartomagia, por lo menos este hombre no esconde lo que es. Los dos juanes cada uno a su manera son los mejores magos del mundo.

Y por qué me pongo así? Porque estoy seguro totalmente de que una rtx 2080ti y sus 11 GBs. de VRAM GDDR6 podría perfectamente hacer todos esos trucos igualito que una serie 5000, puede que no a 4k o le cueste en 1440p, pero en 1080p seguro que sí. Y no va a pasar porque al chino juan no le sale de los cojones habilitarlo.

Cuánto dinero perderían si lo hicieran? Seguro que no tanto como algunos puedan pensar. A estas alturas estoy ya muy cansado de la cerrazón estilo apple que hace el chino juan para no parar de vendernos cosas cada vez más caras.

Y además está claro que cada vez los que jugamos videojuegos menos le importamos porque la pasta gansa está en otro sitio. El gaming para este ya es un escaparate bonito para una tienda que en realidad es de maquinaria industrial.

Goncatin escribió:Yo tengo una pregunta al respecto, todo esto se hace en local, o el dlss y el fg necesita conexión a internet?

Consolero97 escribió:Y creo que con la 5070ti podria ir servido, opiniones? Vengo de una series X y despues de haber jugado toda la vida en consolas, me quiero aventurar en el mundo del PC

kamy33 escribió:Parece que en Coolmod ya van apareciendo algunas, quitando las que se listan en 1000€, el resto de precios podría encajar en los finales:

Edit: No, el botón del carrito no funciona, ya he probado

HakiGold escribió:@ditifet

Estás mezclando GPU la contrincante de la GTX200 si la memoria no me falla fueron las HD4000 o HD5000, R9 200 salieron años después 2013 o 2014 creo.

Esa R9 295 x2 fue un caso especial de consumo, pero es que vamos esa GPU era una GPU doble pegada en el PCB, no se puede comparar con una 5090 que es una sola GPU que consume 600w, las GPU duales andaban en los 300-400w, y las de una sola GPU menos.

Y aun así 300w ya se consideraban un consumo altísimo.

XTC908 escribió:No compréis el humo de Nvidia, esperad al humo de AMD que sabe mejor y contamina menos.

dunkam82 escribió:RVNLOFT escribió:Echad un vistazo en el 1:44:28 a la pregunta y a la respuesta

https://youtu.be/HLxVskv2zs0

Me sé de alguno de cuyo nombre no quiero acordarme que últimamente entra a este hilo para decir paridas que le puede dar un patatús si ve eso

Sicopro escribió:Todo esto es posible gracias al gran salto en AI TOPS con los Tensor Cores de quinta generación. Por eso mostraba tanto Jensen Huang el salto en AI TOPS, la chicha de la arquitectura y tecnología se encuentra aquí. Todo esto va a ir llegando progresivamente a los juegos, no va a estar de golpe en un mes.

- Neural Texture Compression

- Neural Radiance Cache

- RTX Mega Geometry

- RTX Neural Faces

- RTX Neural Materials

Todo explicando en el link adjunto:

https://wccftech.com/nvidia-rtx-kit-shows-how-neural-rendering-will-power-the-next-visual-leap-in-gaming/

Aquí todo sobre el Nvidia RTX Kit y lo que va a permitir.

https://developer.nvidia.com/rtx-kit/#iq771z

Resumen en español:

El conjunto NVIDIA RTX Kit tiene amplias aplicaciones, desde acelerar el trazado de rayos con IA hasta representar humanos digitales mucho más realistas y renderizar escenas que presentan enormes cantidades de geometría.

Empecemos con lo que posiblemente sea la mayor innovación. Con la arquitectura Blackwell, NVIDIA presenta los denominados RTX Neural Shaders. Se trata de pequeñas redes neuronales que se deben inyectar en sombreadores programables para lograr diversos efectos beneficiosos. Con el próximo SDK de RTX Neural Shaders, los desarrolladores de juegos pueden entrenar sus datos de juego y código de sombreador en una PC con IA RTX acelerada con NVIDIA Tensor Cores. Durante la fase de entrenamiento, los datos neuronales del juego se comparan con el resultado de los datos tradicionales y se refinan a lo largo de varios ciclos.

RTX Neural Texture Compression es invaluable para comprimir fácilmente miles de texturas en menos de un minuto y, al mismo tiempo, ahorrar hasta 7 veces más VRAM en comparación con las texturas comprimidas en bloques tradicionales, sin ninguna desventaja aparente en la calidad. En la nueva demostración técnica, las texturas RTX NTC solo ocupan 80 MB, mientras que las texturas comprimidas en bloques regulares requieren 520 MB de VRAM.

Esto significa que se va ir logrando reducir el consumo de VRAM.

RTX Neural Materials utiliza IA para comprimir código de sombreado complejo que normalmente está reservado para materiales fuera de línea, lo que brinda un procesamiento de material hasta cinco veces más rápido y permite que haya activos de mayor calidad disponibles en los juegos.

Por último, la IA se utiliza en RTX Neural Radiance Cache para inferir una cantidad infinita de rebotes después de los uno o dos rebotes iniciales, lo que mejora la iluminación indirecta y el rendimiento de rebotes múltiples. NRC ya está disponible desde hace un tiempo como parte del RTX GI SDK y pronto se incorporará a RTX Remix y Portal con RTX.

Los SDK de compresión de texturas neuronales y sombreadores neuronales RTX se agregarán al kit NVIDIA RTX a finales de este mes. Microsoft también anunció hoy que DirectX pronto agregará compatibilidad con vectores cooperativos, lo que brindará un rendimiento acelerado para las GPU GeForce RTX al usar sombreadores neuronales RTX.

El NVIDIA RTX Kit también incluye RTX Mega Geometry, que debutará en Alan Wake 2 de Remedy con una actualización gratuita a finales de este año. El video de demostración de CES 2025 proporcionó una vista previa de la tecnología, que tiene como objetivo mejorar la carga de trazado de rayos en escenas con grandes cantidades de geometría, como en los juegos impulsados por Nanite de Unreal Engine 5. Según NVIDIA, RTX Mega Geometry acelera la construcción de BVH, lo que permite el trazado de rayos de hasta cien veces más triángulos que el estándar actual. Estará disponible a finales de este mes en el RTX Kit y pronto a través de la rama NVIDIA RTX Unreal Engine.

Franmy98 escribió:Viniendo de una generacion muy antigua (ni siquiera serie RTX), creeis mejor ir a por una 4080 o esperar a la 5070?

Me la pela el raster, quiero jugar a +60fps y ya, o a 120fps 1080p como muchisimo.

Lo unico que me preocupa es la VRAM, que son 16GB frente a 12GB de la nueva 5070. Para VR o utilizar software de IA...quiza 12 se queda corto? Como han dicho tambien que la nueva serie 50 va a estar mas optimizada en consumo de VRAM

Sicopro escribió:Todo esto es posible gracias al gran salto en AI TOPS con los Tensor Cores de quinta generación. Por eso mostraba tanto Jensen Huang el salto en AI TOPS, la chicha de la arquitectura y tecnología se encuentra aquí. Todo esto va a ir llegando progresivamente a los juegos, no va a estar de golpe en un mes.

- Neural Texture Compression

- Neural Radiance Cache

- RTX Mega Geometry

- RTX Neural Faces

- RTX Neural Materials

Todo explicando en el link adjunto:

https://wccftech.com/nvidia-rtx-kit-shows-how-neural-rendering-will-power-the-next-visual-leap-in-gaming/

Franmy98 escribió:Viniendo de una generacion muy antigua (ni siquiera serie RTX), creeis mejor ir a por una 4080 o esperar a la 5070?

Me la pela el raster, quiero jugar a +60fps y ya, o a 120fps 1080p como muchisimo.

Lo unico que me preocupa es la VRAM, que son 16GB frente a 12GB de la nueva 5070. Para VR o utilizar software de IA...quiza 12 se queda corto? Como han dicho tambien que la nueva serie 50 va a estar mas optimizada en consumo de VRAM