SOTN escribió:Porqué este juego tarda tanto en compilar shaders en qué se han equivocado para que esto suceda al portear el juego?

ionesteraX escribió:SOTN escribió:Porqué este juego tarda tanto en compilar shaders en qué se han equivocado para que esto suceda al portear el juego?

Sony tiene un poco de lio con esto de los shaders, se les atraganta y no saben muy bien que hacer ( precompilar o no ) ya que por ejemplo en el horizon a cada parche te lo cambiaban, yo estoy a favor de hacerla pero en los menus del juego y despues en segundo plano, no hacerla es simplemente un suicidio en algunos motores gráficos.

Hay gente reportando 5 horas de espera para compilar, yo creo que huele más a bug que otra cosa ya que en su anterior juego portado a pc ( uncharted ) había compilación pero no tardaba tanto tiempo.

ionesteraX escribió:SOTN escribió:Porqué este juego tarda tanto en compilar shaders en qué se han equivocado para que esto suceda al portear el juego?

Sony tiene un poco de lio con esto de los shaders, se les atraganta y no saben muy bien que hacer ( precompilar o no ) ya que por ejemplo en el horizon a cada parche te lo cambiaban, yo estoy a favor de hacerla pero en los menus del juego y despues en segundo plano, no hacerla es simplemente un suicidio en algunos motores gráficos.

Hay gente reportando 5 horas de espera para compilar, yo creo que huele más a bug que otra cosa ya que en su anterior juego portado a pc ( uncharted ) había compilación pero no tardaba tanto tiempo.

Senegio escribió:adri079 escribió:Se nota más moviento en el hilo de este Port de Sonymala que en el del resident Evil 4 REMAKE GOTY....como se nota que es gratis y en el otro trae denuvo jajaja. Luego se niega la mayor de ciertos temitas en pc...

Y pese a todo ahí están los datos del dinero que ha generado cada plataforma. Casi 50% el PC, el resto del pastel a repartirse entre todas las consolas.

También este juego tiene mucho más marketing detrás. Pero bueno, lo del hilo de DENUVO en este subforo siempre ha sido la risa. Es la versión 2.0 del eufemismo de la “copia de seguridad” que se hacía en EOL para decir “yo no pirateo”.

SOTN escribió:Si nadie comprase la 4060 cuando salga, nvidia no volvería a cometer la guarrada de sacar gráficas en 2023 con 8g de ram NADIE deberia de comprarla y veríais como espabilaban.

KailKatarn escribió:Cyborg_Ninja escribió: @KailKatarn Yo sinceramente no creo que el juego sirva de ejemplo de nada. Es un juego con base en una PS5, que lo ejecuta a 60fps una cpu equivalente (más o menos) a un Ryzen 3600. Arriba o abajo. Que pida más procesador (que cuidado, algunos no son nada cpu dependientes y rascan de lo lindo por usar MAL la cpu) de lo normal también podría ser perfectamente por mala optimización, o porque la usa francamente bien.

Pero vamos, tienes razón en que el juego parece tremendamente exigente en cuanto a cpu. He visto un 5600X al 95% de uso a unos 70-80fps con una 3060Ti. Lo que no creo es que se deba invertir tanto en CPU como en GPU, al menos a 60fps, la que pincha y corta en la mayoría de juegos es la gráfica y es mucho más fácil que se te quede corta esta.

Seguramente este juego reciba parches a lo bestia, sobre todo por la cpu. Si me dijeras que un juego full next gen que nos deje boquiabiertos empiece a pedir CPU a mansalva... pero es un juego de PS5 que tampoco es que vaya más allá de TLOU 2, un juego con PS4 fat de base.

Que vengas a decir que es un juego con una PS4 fat de base, el cual va a 30fps con caídas y con gráficos bastante peores que lo que podemos ver en PC no hay por donde cogerlo. Como tampoco hay por donde coger el intentar defender que en PC hemos venido a jugar a 60fps y que cada vez vayan saliendo más juegos que piden mucha CPU y siempre se justifique con "es que están mal optimizados".

Ya van "A plaguetale requiem" y ya me dijiste lo mismo, "Dead Space Remake", "Hogwarts Legacy" y ahora este "The last of US" donde el uso de CPU está muy por encima de lo habitual. Que oye, que te quieres justificar en que para 60fps quizás no tanto cuando muestras un vídeo de un 5800X3D al 45-50% para 50-60fps en una de las escenas que menos CPU pide, pues ya te digo yo que ese 5800X3D te empieza a hacer cuello en partes del juego a 80-90fps porque ya me ha pasado a mi y con los shaders compilados. Ah! y eso en el prólogo, que ya veremos si todavía hay escenas más CPU demandantes.

A todo esto hay que sumarle que mientras una GPU al 100% no es ningún problema salvo que te va a limitar los fps hasta donde llegue, una CPU al 100% te puede generar stuttering, y eso sólo hablando de hilos maximizados, así que ya no hablemos de la CPU al 100% de uso real. Eso de recomendar priorizar la GPU por encima de la CPU es el mayor error de base de absolutamente todo pc-gamer, sin descontar que una CPU potente te va a permitir aprovechar gráficas más modernas y actualizar.

Sinceramente, a mi me da igual lo que cada uno haga con su dinero, pero priorizar la GPU sobre la CPU en un PC gamer es directamente tirar el dinero. Ahora bien, también se puede intentar usar CPUs de calculadoras en pleno 2023 y decir que todo está mal optimizado y protestar, o comprar gráficas con 8gb de VRAM en pleno 2023 y protestar igualmente.

zero2006xl escribió:Chicos, no podemos estar en un sub de juegos de PC echándonos mierda entre nosotros. Los colectivos deberían ir todos a una y no este rollito que nos traemos. Por partes:

Cyborg_Ninja escribió:Este juego con 2-3 parches empezará a volar con CPUs de 100 euros pero ya para entonces te habrás quedado con la impresión inicial, tal y como has hecho con esos, aunque sea erróneo, e intentaras meterle a la peña en la cabeza que necesitan un 5800x3d como mínimo, y para nada.

aim_dll escribió:ionesteraX escribió:SOTN escribió:Porqué este juego tarda tanto en compilar shaders en qué se han equivocado para que esto suceda al portear el juego?

Sony tiene un poco de lio con esto de los shaders, se les atraganta y no saben muy bien que hacer ( precompilar o no ) ya que por ejemplo en el horizon a cada parche te lo cambiaban, yo estoy a favor de hacerla pero en los menus del juego y despues en segundo plano, no hacerla es simplemente un suicidio en algunos motores gráficos.

Hay gente reportando 5 horas de espera para compilar, yo creo que huele más a bug que otra cosa ya que en su anterior juego portado a pc ( uncharted ) había compilación pero no tardaba tanto tiempo.

Pero esta gente no ha hecho control de calidad? Me parece increíble que un juego asi con todo el ruido que lleva la serie salga en este estado y a 60 euros!

zero2006xl escribió:SOTN escribió:Si nadie comprase la 4060 cuando salga, nvidia no volvería a cometer la guarrada de sacar gráficas en 2023 con 8g de ram NADIE deberia de comprarla y veríais como espabilaban.

Esto es otro tema con el que estoy de acuerdo.

Pero lo que no podemos pretender es pedir a nuestros compañeros del gremio que compren más VRAM cuando quizá el juego se podría portar para aprovechar mejor los recursos de los que dispone la tarjeta. No digo que sea así en todos los casos ni mucho menos, pero dudo mucho que este juego que es pasillero (no lo digo como crítica eh) a más no poder, necesite tanta VRAM por sus cojones.

*Pasillero = escenarios bien delimitados y en los que avanzas prácticamente en una línea recta. Que no son sandbox ni mundos abiertos con mil sitios diferentes que visitar sin tiempos de carga.

KailKatarn escribió:zero2006xl escribió:Chicos, no podemos estar en un sub de juegos de PC echándonos mierda entre nosotros. Los colectivos deberían ir todos a una y no este rollito que nos traemos. Por partes:

A ver, estás dando a entender que algunos usuarios venimos a reírnos o algo así de los usuarios de 8GB de VRAM o los 16GB de RAM o las CPUs de pocos núcleos y te equivocas.

Vamos a se realistas:

1º Las gráficas de 8GB de VRAM se ven de manera mayoritaria desde hace más de 6 años. Una "simple" GTX1070 ya contaba con 8GB de VRAM GDDR5. ¿Te parece normal pretender tener la misma cantidad de VRAM 6 años después? pues evidentemente muchos no lo vemos normal. No se montó la marimorena cuando 2GB no fueron suficientes, ni tampoco vuando 4 o 6GB de VRAM dejaron de ser suficientes.

2º ¿Cuanto llevamos con 16GB de RAM? ¿10 años? ¿más? pues es evidente que los motores y el software avanza y al final vas a necesitar 32GB y quizás hasta dentro de no mucho 64GB sea el standard. ¿Es eso malo? pues yo no vi todas esas quejas cuando se tuvo que saltar de 4 a 8GB de Ram ni de 8 a 16GB de RAM.

3º Las CPUs de 4 y 6 núcleos + HT llevan con nosotros desde hace más de 12 años entre nosotros. ¿De verdad nos vamos a asustar que en pleno 2023 haya juegos punteros gráficamente que necesiten 8/16 a altas frecuencias? pues tampoco lo entiendo.

Aquí no es cuestión ni de reírse ni de criticar a nadie. Ahora bien, si has estado dispuesto a comprar una gráfica moderna con la misma VRAM que hace 6 años, pretender seguir usando la misma RAM que hace 10 años y CPUs de hace 10-12 años pues sinceramente, has elegido muy mal los componentes para tener un PC equilibrado.

Eso sí, parece ser que si mencionas todo esto están en su derecho de cargarse en tus muertos peludos, que a mi me parece cojonudo y me río que te cagas, pero evidentemente no era una jugada inteligente.Cyborg_Ninja escribió:Este juego con 2-3 parches empezará a volar con CPUs de 100 euros pero ya para entonces te habrás quedado con la impresión inicial, tal y como has hecho con esos, aunque sea erróneo, e intentaras meterle a la peña en la cabeza que necesitan un 5800x3d como mínimo, y para nada.

Ajam, sí.

yosu888 escribió:Esk la culpa no es de nvdia.

SOTN escribió:Porqué este juego tarda tanto en compilar shaders en qué se han equivocado para que esto suceda al portear el juego?

yosu888 escribió:Esk la culpa no es de nvdia.

Lo que está pasando a día de hoy que sacan los juegos sin optimizar apenas, y ese es el gran problema de la industria a día de hoy, pero hoy en día tenemos una crisis muy profunda y optimizar un par de años más un juego significa más recursos y más dinero por parte de los inversores y lo que buscan es un desarrollo de mucho brilli brilli en el menor tiempo posible, sacamos el producto roto y con el tiempo lo vamos puliendo pero primero crear hype, sacar el producto y vender todo lo posible para recuperar la inversión y conseguir los máximos beneficios posibles.

Así que aquí hay dos temas bien diferenciados, uno que nvdia es verdad que es una racana con los GB de RAM en sus gpus y otra las compañías de juegos.

Yo por suerte tengo una 4090 y no tengo ningún tipo de problemas con the last of US ni con resident Evil 4 remake, los estoy disfrutando muchísimo si ningun cuelgue y todo al máximo con rt y 4k.

fonso86 escribió:SOTN escribió:Porqué este juego tarda tanto en compilar shaders en qué se han equivocado para que esto suceda al portear el juego?

Han utilizado una libreria de Oodle (la 2.9.6) que tiene bug conocido de fugas de memoria. Si se sustituye el archivo por el de la versión anterior (2.9.5) que no tiene ese problema, ya tarda en compilar lo shaders lo normal. En Nexusmod han subido el archivo con la versión sin el bug https://www.nexusmods.com/thelastofuspart1/mods/11 O si tenéis instalado el Warframe o el Fifa 23, tambien se puede coger el archivo de ahí, que lleva esa versión.

Eso sí, solo arregla lo de la compilación de shaders, no el resto de problemas que tiene el port.

![enamorado [amor]](/images/smilies/nuevos/enamorado.gif)

![enamorado [amor]](/images/smilies/nuevos/enamorado.gif)

KailKatarn escribió:zero2006xl escribió:Chicos, no podemos estar en un sub de juegos de PC echándonos mierda entre nosotros. Los colectivos deberían ir todos a una y no este rollito que nos traemos. Por partes:

A ver, estás dando a entender que algunos usuarios venimos a reírnos o algo así de los usuarios de 8GB de VRAM o los 16GB de RAM o las CPUs de pocos núcleos y te equivocas.

Vamos a se realistas:

1º Las gráficas de 8GB de VRAM se ven de manera mayoritaria desde hace más de 7 años. Una "simple" GTX1070 ya contaba con 8GB de VRAM GDDR5. ¿Te parece normal pretender tener la misma cantidad de VRAM 7 años después? pues evidentemente muchos no lo vemos normal. No se montó la marimorena cuando 2GB no fueron suficientes, ni tampoco vuando 4 o 6GB de VRAM dejaron de ser suficientes.

2º ¿Cuanto llevamos con 16GB de RAM? ¿10 años? ¿más? pues es evidente que los motores y el software avanza y al final vas a necesitar 32GB y quizás hasta dentro de no mucho 64GB sea el standard. ¿Es eso malo? pues yo no vi todas esas quejas cuando se tuvo que saltar de 4 a 8GB de RAM ni de 8 a 16GB de RAM.

3º Las CPUs de 4 y 6 núcleos + HT llevan con nosotros desde hace más de 12 años entre nosotros. ¿De verdad nos vamos a asustar que en pleno 2023 haya juegos punteros gráficamente que necesiten 8/16 a altas frecuencias? pues tampoco lo entiendo. Como tampoco entenderé las quejas de cuando se necesiten más de 8/16 y los 16/32 sean el standard o todavía más.

Aquí no es cuestión ni de reírse ni de criticar a nadie. Ahora bien, si has estado dispuesto a comprar una gráfica moderna con la misma VRAM que hace 7 años, pretender seguir usando la misma RAM que hace 10 años o más y CPUs de hace 12 años, pues sinceramente, has elegido muy mal los componentes para tener un PC equilibrado.

Eso sí, parece ser que si mencionas todo esto están en su derecho de cargarse en tus muertos peludos, que a mi me parece cojonudo y me río que te cagas, pero evidentemente no era una jugada inteligente. Todo esto sin descontar que los motores y el software avanzan, y siempre llegará un momento que necesites más de todo. Ahora bien, eso parece que no se quiere entender y es que todo sale fatal optimizado. Luego actualizan el PC o equilibran lo que les falla y entonces todo bien hasta que llega el juego que pide 32GB de VRAM y 64GB de RAM y vuelta a empezar. Si es siempre lo mismo.Cyborg_Ninja escribió:Este juego con 2-3 parches empezará a volar con CPUs de 100 euros pero ya para entonces te habrás quedado con la impresión inicial, tal y como has hecho con esos, aunque sea erróneo, e intentaras meterle a la peña en la cabeza que necesitan un 5800x3d como mínimo, y para nada.

Ajam, sí.

Kurosawa42 escribió:yosu888 escribió:Esk la culpa no es de nvdia.

Lo que está pasando a día de hoy que sacan los juegos sin optimizar apenas, y ese es el gran problema de la industria a día de hoy, pero hoy en día tenemos una crisis muy profunda y optimizar un par de años más un juego significa más recursos y más dinero por parte de los inversores y lo que buscan es un desarrollo de mucho brilli brilli en el menor tiempo posible, sacamos el producto roto y con el tiempo lo vamos puliendo pero primero crear hype, sacar el producto y vender todo lo posible para recuperar la inversión y conseguir los máximos beneficios posibles.

Así que aquí hay dos temas bien diferenciados, uno que nvdia es verdad que es una racana con los GB de RAM en sus gpus y otra las compañías de juegos.

Yo por suerte tengo una 4090 y no tengo ningún tipo de problemas con the last of US ni con resident Evil 4 remake, los estoy disfrutando muchísimo si ningun cuelgue y todo al máximo con rt y 4k.

Hola, normal te vaya, bien, lo digo de buen rollo ;-.) Faltaria mas que con una grafica de mas de 2000 euros no fuese bien pero es lo que dije ¿Somos conscientes en la dinamica que estamos entrando? ¿Que va a costar la serie 5000 si esto sigue?

Yo ya explique que soy el primero en caer ,es nuestro hobby... Pero mas vamos muy mal como esto siga asi, ojala me equivoque.

Lo que tengo claro es que ni fabricantes de componentes, ni de graficas..etc,etc estan perdiendo dinero , estan ganando mas aun.El que crea esto no es asi, felicidades te han convencido para justificar...etc,etc.

Saludos.

Ghandig escribió: a plague tale decidieron sacarlo a 30fps porque no quisieron quitarle el RT

Salu2.

yosu888 escribió:Kurosawa42 escribió:yosu888 escribió:Esk la culpa no es de nvdia.

Lo que está pasando a día de hoy que sacan los juegos sin optimizar apenas, y ese es el gran problema de la industria a día de hoy, pero hoy en día tenemos una crisis muy profunda y optimizar un par de años más un juego significa más recursos y más dinero por parte de los inversores y lo que buscan es un desarrollo de mucho brilli brilli en el menor tiempo posible, sacamos el producto roto y con el tiempo lo vamos puliendo pero primero crear hype, sacar el producto y vender todo lo posible para recuperar la inversión y conseguir los máximos beneficios posibles.

Así que aquí hay dos temas bien diferenciados, uno que nvdia es verdad que es una racana con los GB de RAM en sus gpus y otra las compañías de juegos.

Yo por suerte tengo una 4090 y no tengo ningún tipo de problemas con the last of US ni con resident Evil 4 remake, los estoy disfrutando muchísimo si ningun cuelgue y todo al máximo con rt y 4k.

Hola, normal te vaya, bien, lo digo de buen rollo ;-.) Faltaria mas que con una grafica de mas de 2000 euros no fuese bien pero es lo que dije ¿Somos conscientes en la dinamica que estamos entrando? ¿Que va a costar la serie 5000 si esto sigue?

Yo ya explique que soy el primero en caer ,es nuestro hobby... Pero mas vamos muy mal como esto siga asi, ojala me equivoque.

Lo que tengo claro es que ni fabricantes de componentes, ni de graficas..etc,etc estan perdiendo dinero , estan ganando mas aun.El que crea esto no es asi, felicidades te han convencido para justificar...etc,etc.

Saludos.

Tube suerte y pille la kfa2 por 1800 euros.

Jejejejejeje.

Yo esk esto lo veo como un hobby que me parece tan caro como cualquier otro.

Saludos

MutantCamel escribió:Que los shaders tarden una hora en compilarse porque el juego viene con una librería bugueada significa que esta gente ni siquiera se ha dignado a hacer el más mínimo testing. Aunque lo pueda mover en mi pc, con mi pasta que no cuenten hasta que arreglen el percal y encima lo rebajen.

chorriwuarri escribió:lo mejor de todo es que en twitter han perdido perdon, y han dicho que estan escuchando a la gente

tienen que pedir perdon por intentar estafar a la gente porque esto lo han sacado sabiendo como estaba, aun asi la gente dandole las gracias por su duro trabajo y por escuchar

KailKatarn escribió:zero2006xl escribió:Chicos, no podemos estar en un sub de juegos de PC echándonos mierda entre nosotros. Los colectivos deberían ir todos a una y no este rollito que nos traemos. Por partes:

A ver, estás dando a entender que algunos usuarios venimos a reírnos o algo así de los usuarios de 8GB de VRAM o los 16GB de RAM o las CPUs de pocos núcleos y te equivocas.

Vamos a ser realistas:

1º Las gráficas de 8GB de VRAM se ven de manera mayoritaria desde hace más de 7 años. Una "simple" GTX1070 ya contaba con 8GB de VRAM GDDR5. ¿Te parece normal pretender tener la misma cantidad de VRAM 7 años después? pues evidentemente muchos no lo vemos normal. No se montó la marimorena cuando 2GB no fueron suficientes, ni tampoco vuando 4 o 6GB de VRAM dejaron de ser suficientes.

2º ¿Cuanto llevamos con 16GB de RAM? ¿10 años? ¿más? pues es evidente que los motores y el software avanza y al final vas a necesitar 32GB y quizás hasta dentro de no mucho 64GB sea el standard. ¿Es eso malo? pues yo no vi todas esas quejas cuando se tuvo que saltar de 4 a 8GB de RAM ni de 8 a 16GB de RAM.

3º Las CPUs de 4 y 6 núcleos + HT llevan con nosotros desde hace más de 12 años entre nosotros. ¿De verdad nos vamos a asustar que en pleno 2023 haya juegos punteros gráficamente que necesiten 8/16 a altas frecuencias? pues tampoco lo entiendo. Como tampoco entenderé las quejas de cuando se necesiten más de 8/16 y los 16/32 sean el standard o todavía más.

Aquí no es cuestión ni de reírse ni de criticar a nadie. Ahora bien, si has estado dispuesto a comprar una gráfica moderna con la misma VRAM que hace 7 años, pretender seguir usando la misma RAM que hace 10 años o más y CPUs de hace 12 años, pues sinceramente, has elegido muy mal los componentes para tener un PC equilibrado.

Eso sí, parece ser que si mencionas todo esto están en su derecho de cargarse en tus muertos peludos, que a mi me parece cojonudo y me río que te cagas, pero evidentemente no era una jugada inteligente. Todo esto sin descontar que los motores y el software avanzan, y siempre llegará un momento que necesites más de todo. Ahora bien, eso parece que no se quiere entender y es que todo sale fatal optimizado. Luego actualizan el PC o equilibran lo que les falla y entonces todo bien hasta que llega el juego que pide 32GB de VRAM y 64GB de RAM y vuelta a empezar. Si es siempre lo mismo.

PD: El port no está hecho por Iron Galaxy unicamente, Naughty Dog han colaborado con ellos y son los que han dado el visto bueno a la salida del juego.Cyborg_Ninja escribió:Este juego con 2-3 parches empezará a volar con CPUs de 100 euros pero ya para entonces te habrás quedado con la impresión inicial, tal y como has hecho con esos, aunque sea erróneo, e intentaras meterle a la peña en la cabeza que necesitan un 5800x3d como mínimo, y para nada.

Ajam, sí.

KailKatarn escribió:yosu888 escribió:Esk la culpa no es de nvdia.

Lo siento, vender en pleno 2023 gráficas de 1000€ con 12GB de VRAM es timo de NVIDIA igualmente (RTX4070/4070Ti) y pretender sacar por 700€ o más una 4060Ti con 8GB de VRAM ya no es una timada, es una tomadura de pelo por parte de NVIDIA.

Ya en la 3000 Series engañaron y timaron cosa mala, lo de esta generación ya no hay por donde cogerlo. La RTX3080 con la buena potencia calidad/precio que tenía con 10GB fue un robo, sacar la 3080Ti con 12GB y lo que valía, robo a mano armada directamente.

De hecho hasta si me apuras los 16GB de VRAM de la RTX4080 por 1600€ o más me sigue pareciendo otro robo.

fonso86 escribió:SOTN escribió:Porqué este juego tarda tanto en compilar shaders en qué se han equivocado para que esto suceda al portear el juego?

Han utilizado una libreria de Oodle (la 2.9.6) que tiene bug conocido de fugas de memoria. Si se sustituye el archivo por el de la versión anterior (2.9.5) que no tiene ese problema, ya tarda en compilar lo shaders lo normal. En Nexusmod han subido el archivo con la versión sin el bug https://www.nexusmods.com/thelastofuspart1/mods/11 O si tenéis instalado el Warframe o el Fifa 23, tambien se puede coger el archivo de ahí, que lleva esa versión.

Eso sí, solo arregla lo de la compilación de shaders, no el resto de problemas que tiene el port.

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

zero2006xl escribió:Pero estoy contigo en que debemos avanzar. Pero creo que debemos hacerlo en condiciones. No que para tener un poco más de detalle en algunas texturas necesito 2 o 4 gb más de VRAM. Si me vas a pedir requisitos, si me vas a hacer gastarme el doble o el triple que en la consola de la que viene un juego, haz que valga la pena. Eso es lo que yo les pido a las desarolladoras. Que esto ya lo hablé en su momento, que a dos años de salida de PS3 por 600 euros te comprabas un PC que movía Crysis que se meaba literalmente en cualquier consola. En 2015, a dos años de la salida de PS4, te montabas un PC por casi el mismo precio que la consola y jugabas similar. En 2023, a poco más de dos años del lanzamiento de PS5 sigues teniendo que gastar el doble para tener una experiencia similar. Y encima comiéndonos ports que necesitan 10 parches para funcionar correctamente. Así no.

katatsumuri escribió:Lo he ajustado todo a mi VR ram, el resultado:

Parece una película de Tim Burton.

Espero que al reiniciar se arregle, ya que antes puse todo a tope ultra y se veía el juego lo que iba a tirones.

viendo la foto de arriba. Yo hace un rato lo probé en el portatil y me salió un Joel que parecía Sonic con los polígonos de los pelos y una especie de "barba" blanca.

viendo la foto de arriba. Yo hace un rato lo probé en el portatil y me salió un Joel que parecía Sonic con los polígonos de los pelos y una especie de "barba" blanca.

katatsumuri escribió:Lo he ajustado todo a mi VR ram, el resultado:

Parece una película de Tim Burton.

Espero que al reiniciar se arregle, ya que antes puse todo a tope ultra y se veía el juego lo que iba a tirones.

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

KailKatarn escribió:zero2006xl escribió:Chicos, no podemos estar en un sub de juegos de PC echándonos mierda entre nosotros. Los colectivos deberían ir todos a una y no este rollito que nos traemos. Por partes:

A ver, estás dando a entender que algunos usuarios venimos a reírnos o algo así de los usuarios de 8GB de VRAM o los 16GB de RAM o las CPUs de pocos núcleos y te equivocas.

Vamos a ser realistas:

1º Las gráficas de 8GB de VRAM se ven de manera mayoritaria desde hace más de 7 años. Una "simple" GTX1070 ya contaba con 8GB de VRAM GDDR5. ¿Te parece normal pretender tener la misma cantidad de VRAM 7 años después? pues evidentemente muchos no lo vemos normal. No se montó la marimorena cuando 2GB no fueron suficientes, ni tampoco vuando 4 o 6GB de VRAM dejaron de ser suficientes.

2º ¿Cuanto llevamos con 16GB de RAM? ¿10 años? ¿más? pues es evidente que los motores y el software avanza y al final vas a necesitar 32GB y quizás hasta dentro de no mucho 64GB sea el standard. ¿Es eso malo? pues yo no vi todas esas quejas cuando se tuvo que saltar de 4 a 8GB de RAM ni de 8 a 16GB de RAM.

3º Las CPUs de 4 y 6 núcleos + HT llevan con nosotros desde hace más de 12 años. ¿De verdad nos vamos a asustar que en pleno 2023 haya juegos punteros gráficamente que necesiten 8/16 a altas frecuencias? pues tampoco lo entiendo. Como tampoco entenderé las quejas de cuando se necesiten más de 8/16 y los 16/32 sean el standard o todavía más.

Aquí no es cuestión ni de reírse ni de criticar a nadie. Ahora bien, si has estado dispuesto a comprar una gráfica moderna con la misma VRAM que hace 7 años, pretender seguir usando la misma RAM que hace 10 años o más y CPUs de hace 12 años, pues sinceramente, has elegido muy mal los componentes para tener un PC equilibrado.

Eso sí, parece ser que si mencionas todo esto están en su derecho de cargarse en tus muertos peludos, que a mi me parece cojonudo y me río que te cagas, pero evidentemente no era una jugada inteligente. Todo esto sin descontar que los motores y el software avanzan, y siempre llegará un momento que necesites más de todo. Ahora bien, eso parece que no se quiere entender y es que todo sale fatal optimizado. Luego actualizan el PC o equilibran lo que les falla y entonces todo bien hasta que llega el juego que pide 32GB de VRAM y 64GB de RAM y vuelta a empezar. Si es siempre lo mismo.

PD: El port no está hecho por Iron Galaxy unicamente, Naughty Dog han colaborado con ellos y son los que han dado el visto bueno a la salida del juego.Cyborg_Ninja escribió:Este juego con 2-3 parches empezará a volar con CPUs de 100 euros pero ya para entonces te habrás quedado con la impresión inicial, tal y como has hecho con esos, aunque sea erróneo, e intentaras meterle a la peña en la cabeza que necesitan un 5800x3d como mínimo, y para nada.

Ajam, sí.

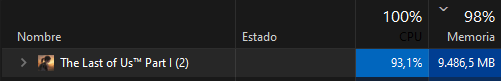

zBoID escribió:No creo que sea culpa de los componentes que en el menú principal, que es una puñetera ventana, esté así:

Fleishmann escribió:Una cosa con la que no estoy de acuerdo es con los usuarios que dicen que no se ve bien, que sus gráficos son de PS4 retocados, o cosas de este estilo.

Más allá de la optimización y el consumo, donde todo debate está más que justificado, el juego para mi se ve de escándalo.

![sonrisa [sonrisa]](/images/smilies/nuevos/risa_ani1.gif)

zero2006xl escribió:Entiendo todo lo que dices @KailKatarn pero yo no pido la luna. Creo que podemos pedir que hagan las cosas un poco mejor y opino que 8 GB VRAM / 16 GB RAM deberían ser suficientes para correr las texturas del juego a calidad de consola. Y que para jugar por encima de esa calidad no se debería de ir a fuerza bruta, si no utilizar alternativas que ofrece el PC. No hablo ya solo de este juego sino de cualquier Port. Almacenar más en RAM si la VRAM no es suficiente y tirar de DirectStorage para agilizar procesos de comunicación entre el hardware, optimizar más la carga de recursos en pantalla, y un largo etcétera. Que sé que lleva tiempo y dinero, pero que si me vas a pedir 60 pavos de un juego que ya has amortizado en consola, al menos curratelo.

KailKatarn escribió:zero2006xl escribió:Pero estoy contigo en que debemos avanzar. Pero creo que debemos hacerlo en condiciones. No que para tener un poco más de detalle en algunas texturas necesito 2 o 4 gb más de VRAM. Si me vas a pedir requisitos, si me vas a hacer gastarme el doble o el triple que en la consola de la que viene un juego, haz que valga la pena. Eso es lo que yo les pido a las desarolladoras. Que esto ya lo hablé en su momento, que a dos años de salida de PS3 por 600 euros te comprabas un PC que movía Crysis que se meaba literalmente en cualquier consola. En 2015, a dos años de la salida de PS4, te montabas un PC por casi el mismo precio que la consola y jugabas similar. En 2023, a poco más de dos años del lanzamiento de PS5 sigues teniendo que gastar el doble para tener una experiencia similar. Y encima comiéndonos ports que necesitan 10 parches para funcionar correctamente. Así no.

No puedes comparar un hardware cerrado con una plataforma abierta con 1000 tipos de configuraciones y a la que se le pide que el acabado final se vea mejor que en consola y a veces hasta pidiendo más del doble de framerate que en estas últimas, cuando no se pide 4 veces más 30fps vs 120fps que se piden muchas veces en PC.

En consola tienes la memoria unificada y puedes repartir la carga de la misma según la escena a renderizar. Necesitas más VRAM? se la das a la GPU, necesitas más RAM? se la das a la CPU y así en todo momento de manera asíncrona, en PC no puedes hacer eso, porque cada uno de los componentes lleva su propia RAM.

Y eso es el menor de los detalles, porque como tu bien dices, las consolas tienen hardware dedicado para diversas funciones que en PC tienes que tirar de CPU (véase el Spiderman). Este juego luce mejor en PC en ultra que en la PlayStation 5, y tiene un acabado técnico que es de auténtico portento hoy por hoy. ¿Pretendes mover el mayor portento de PC con el mismo hardware que hace 10 años?

Hasta el Resident Evil 4 Remake, que ha salido en Playstation 4, está colgando a mucha gente si pone todo en ULTRA + RT con 8 y 10GB de VRAM. Ahora bien, parece ser que CAPCOM si puede hacerlo en un juego con un acabado técnico que aunque no está mal, no es ni comparable con este TLOU, pero Naugty Dog no puede hacerlo, ellos lo tienen prohibido.

Este juego pide máquina porque ofrece un acabado técnico muy pepino. Todo lo demás es negarse la realidad. Y tú como cliente claro que te puedes quejar y pedir hasta la luna, ahora bien, los milagros no existen. Podrán rascar de aquí y de allá, pero no puedes hacer que un juego muy demandante pase a necesitar absolutamente nada de nada.

KailKatarn escribió:zBoID escribió:No creo que sea culpa de los componentes que en el menú principal, que es una puñetera ventana, esté así:

Se llama compilación de shaders y pone cualquier CPU al 100%. Ya tengas 2 núcleos o 20, utiliza todos al 100% para tardar lo menos posible. Y sí, lo hace en el menú.Fleishmann escribió:Una cosa con la que no estoy de acuerdo es con los usuarios que dicen que no se ve bien, que sus gráficos son de PS4 retocados, o cosas de este estilo.

Más allá de la optimización y el consumo, donde todo debate está más que justificado, el juego para mi se ve de escándalo.

El juego en ULTRA es lo más pepino que se ha podido ver hasta la fecha en PC, ahora bien, parece ser que lo más pepino que se ha visto hasta la fecha en PC tiene que pedir como mucho un dual core, 2gb de RAM y 512MB de VRAM. En serio, con este tipo de "sensatez" va clara la PC Master Race.

worf escribió:Mira macho.En PS5 como en Xbox series X tienen ocho gigas para RAM y V RAM.En TOTAL.

worf escribió:Si han puesto a un monton de chimpances a golpear tecados no es culpa de el usuario final.

worf escribió:[

Lo siento.

Mira macho.En PS5 como en Xbox series X tienen ocho gigas para RAM y V RAM.En TOTAL.

zBoID escribió:El tema shaders también es para darle de comer aparte... Creo que a la mayoría le da tiempo a completar la jornada laboral, hacer horas extra, volver a casa, cenar, volver al PC y que quede aún la mitad de carga.

El juego va a tener varios parches, eso es innegable, pero a ver como explica Naughty Dog de aquí a unos meses que el juego funcione como debe, y que de salida no lo hiciera. Que la explicación la sabemos todos, pero la excusa no.

zBoID escribió:KailKatarn escribió:zBoID escribió:No creo que sea culpa de los componentes que en el menú principal, que es una puñetera ventana, esté así:

Se llama compilación de shaders y pone cualquier CPU al 100%. Ya tengas 2 núcleos o 20, utiliza todos al 100% para tardar lo menos posible. Y sí, lo hace en el menú.Fleishmann escribió:Una cosa con la que no estoy de acuerdo es con los usuarios que dicen que no se ve bien, que sus gráficos son de PS4 retocados, o cosas de este estilo.

Más allá de la optimización y el consumo, donde todo debate está más que justificado, el juego para mi se ve de escándalo.

El juego en ULTRA es lo más pepino que se ha podido ver hasta la fecha en PC, ahora bien, parece ser que lo más pepino que se ha visto hasta la fecha en PC tiene que pedir como mucho un dual core, 2gb de RAM y 512MB de VRAM. En serio, con este tipo de "sensatez" va clara la PC Master Race.

El tema shaders también es para darle de comer aparte... Creo que a la mayoría le da tiempo a completar la jornada laboral, hacer horas extra, volver a casa, cenar, volver al PC y que quede aún la mitad de carga.

El juego va a tener varios parches, eso es innegable, pero a ver como explica Naughty Dog de aquí a unos meses que el juego funcione como debe, y que de salida no lo hiciera. Que la explicación la sabemos todos, pero la excusa no.

me encanta esa última frase.

me encanta esa última frase.zero2006xl escribió:Creo que este juego es lo típico de una relación que ya está tocada y en la discusión número 471 estalla lo de las 470 anteriores. Exagerando un poco vaya, pero para ilustrar.

Y esto me gusta. A ver si reaccionan, coño.

SOTN escribió:Si nadie comprase la 4060 cuando salga, nvidia no volvería a cometer la guarrada de sacar gráficas en 2023 con 8g de ram NADIE deberia de comprarla y veríais como espabilaban.

![fumando [fumando]](/images/smilies/nuevos/fumando.gif)