Harl escribió:Esos datos son de tarjetas Tesla (para computación no para juegos)

http://www.nvidia.es/object/product_tes ... 70_es.html

Las nuevas Geforce se dicen que no saldrán hasta marzo:

http://www.maximumpc.com/article/news/n ... ge_refresh

http://www.xbitlabs.com/news/video/disp ... mours.html

http://www.tomshardware.com/news/nvidia ... ,9326.html

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif)

Scrible escribió:Harl escribió:Esos datos son de tarjetas Tesla (para computación no para juegos)

http://www.nvidia.es/object/product_tes ... 70_es.html

Las nuevas Geforce se dicen que no saldrán hasta marzo:

http://www.maximumpc.com/article/news/n ... ge_refresh

http://www.xbitlabs.com/news/video/disp ... mours.html

http://www.tomshardware.com/news/nvidia ... ,9326.html

Cierto, pero ese es el chip que formara parte de las fermi aparte del GT300 segun dice el articulo de donde lo he extraido:

http://forums.overclockersclub.com/inde ... pic=171001

O no he entendido bien el articulo y es un fail, si es asi, perdon

lynnfield escribió:Yo creo que es que quieren sacar esas Tesla basadas en Fermi antes que las GPU de escritorio, y han recortado unos cuantos cores para sacar más unidades funcionales por oblea (se ve que el número de chips funcionales de 512 cores era patético).

![enrojecido [ayay]](/images/smilies/nuevos/sonrojado_ani1.gif)

Harl escribió:lynnfield escribió:Yo creo que es que quieren sacar esas Tesla basadas en Fermi antes que las GPU de escritorio, y han recortado unos cuantos cores para sacar más unidades funcionales por oblea (se ve que el número de chips funcionales de 512 cores era patético).

Esos es lo raro que aunque las especificaciones estén ya las Tesla se supone que salen después de las GeForce

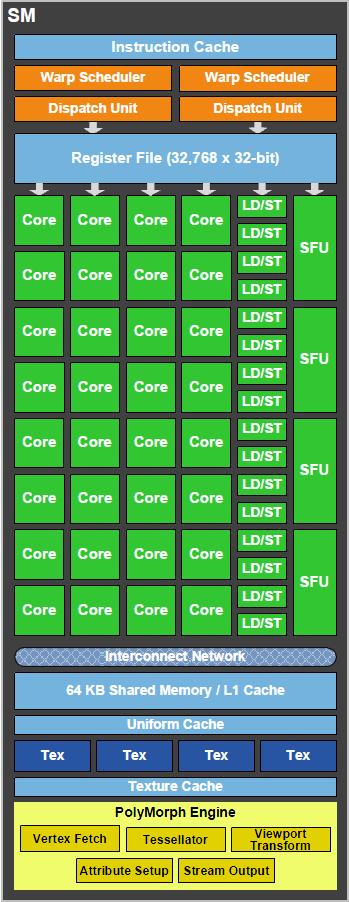

La verdad es que Fermi cada día pinta peor, lo han diseñado pensando más en computación que en gráficos (quizás pensando en el Larrabee, que Intel ha cancelado ...)

Por ejemplo lo del ECC Nvidia presume de que el chip tiene ECC a todos los niveles (chequeo y corrección de errores).

Cuando el ECC se activa parte de la memoria se dedica a guarda datos redundantes así

las versiones de 6 GB pasan a usar 4GB por que los otros dos se quedan para corrección. Pero aunque el ECC se desactive el chip sigue teniendo transistores dedicados a ello (que ocuparan bastante espacio)

El ECC en ciertos entornos de computación puede ser muy util (de hecho lo han incluido a petición de desarrolladores)

¿Pero y en juegos de que sirve? pues prácticamente de nada.

Así que la versión GeForce de Fermi tendra un montón de transistores ocupando espacio (aumentando el coste, TDP, etc ..) para nada (El ECC no esta solo en el controlador de memoria, sino en las caches, los registros, todo ...).

Estamos hablando de un chip mastodontico con 3000 millones de transistores (frente a los 2100 millones de las ATI) un 50% más de transistores pero un 30% de las ALU's

Vale que los shader de Nvidia son escalares y no vectoriales, pero aun así ...

Como Nvidia no este eliminado el ECC en la GeForce para "adelgazar" el chip, y así poder aumentar la velocidad de reloj reducir TDP etc ... ,o lo muy veo crudo para ellos.

Cada día esto me recuerda más a las FX 5800

![enrojecido [ayay]](/images/smilies/nuevos/sonrojado_ani1.gif)

Avtom escribió:Impresionantes cifras sí, pero supongo que Fermi necesitará otra caja de PC con dos fuentes de alimentación de 1220w cada una para que funcione... Yo creo que aunque la potencia gráfica es importante, también deberían centrar esfuerzos en la optimización y el consumo...

VA A CAER UNA en mis manos.

Hombre, por webos tiene que rendir más que las ATI, sólo por los 6 meses de demora... Sino, menuda estafa jeje.

Hombre, por webos tiene que rendir más que las ATI, sólo por los 6 meses de demora... Sino, menuda estafa jeje.Vas a gastarte también el pastón que vale?

![más risas [+risas]](/images/smilies/nuevos/risa_ani3.gif) ). Y tampoco creo que consuman tanto.

). Y tampoco creo que consuman tanto. djohny24 escribió:Como hoy me siento pitoniso auguro que va a valer por lo menos, la 360 100 ó 120€ más que la 5870.

La 380 se acercará segurísimo a los 500€ y consumos de la 5970, cosa que realmente yo no me compraría porque una dual, es una dual ^^

El precio va a dictar su éxito o fracaso inicial.

![llorando [snif]](/images/smilies/nuevos/triste_ani1.gif)

LordArthas escribió:lo más normal, a la par que triste, es que tengas razón y que las GF100 sean carillas... eso sí, tengo una ligera sesación de que la GTX360 puede andar sobre 300-350€ y la GTX380 moverse sobre los 400-450€

Manjimaru escribió:LordArthas escribió:lo más normal, a la par que triste, es que tengas razón y que las GF100 sean carillas... eso sí, tengo una ligera sesación de que la GTX360 puede andar sobre 300-350€ y la GTX380 moverse sobre los 400-450€

Esos precios los firmaba ya mismo. Ojalá me equivoque, pero puestos a jugar a pitonisos, veo más GTX360 acercándose a los 400 y GTX380 a los 500.

El problema es que no me gustaría cambiar de ensamblador y seguir con EVGA, lo que haría que la broma me saliera todavía más cara, aunque merece la pena. En fin, esperaremos acontecimientos...

![como la niña del exorcista [360º]](/images/smilies/nuevos/vueltas.gif)

Ballantines escribió:Y yo me pregunto porque no emplean las tecnologias que estan utilizando para ION y sacan series para pc de sobremesa con consumos reducidos, tamaño reducido y temperaturas reducidas. Si analizamos bien no hay termino medio, pasamos de gráficas integradas con muy poco rendimiento a centrales nucleares enormes caras y calurosas. No podrían coger una gtx285 y manteniendo su rendimiento optimizarla?, reducir los nm del procesador,etc

.

. djohny24 escribió:jaja sip, lo admito, pero por los precio / rendimiento. También indirectamente me interesa que salgan cuanto antes para que el mercado sufra una reducción de precios importante o al menos tangible.

Realmente merece tanto la pena tirar por gráficas de tan alto rendimiento? Cierto es que ahí están las primeras cifras y espero que no sean meras operaciones de marketing y contener a la gente, porque si realmente tienen un precio razonable y ATI no tiene competencia directa en precio / rendimiento, volveré a cogerme una nvidia como cuando en su día tenía las 6800 / 8800GTS.

Soy chaquetero y lo primero es mirar la guita, por eso "defiendo" a quien defiendo (con ciertos argumentos a ser posible). No me lo tengáis muy en cuenta

Ah EDITO:

Me deje de poner posts atrás esta noticia que no se comentó pero que también afecta a susodicha tarjetica:

http://www.fudzilla.com/content/view/17122/65/

"The card features a dual slot design and needs two power connectors, which is actually nothing new for this part of the graphics market. The cooler completely surrounds the card and our first impression was that the card was noisy and probably quite hot."

Jo, por qué no las hacen todas más pequeñas?? Inclusive ATI. Realmente, no caben en una placa "normal"?

lynnfield escribió:Ballantines escribió:Y yo me pregunto porque no emplean las tecnologias que estan utilizando para ION y sacan series para pc de sobremesa con consumos reducidos, tamaño reducido y temperaturas reducidas. Si analizamos bien no hay termino medio, pasamos de gráficas integradas con muy poco rendimiento a centrales nucleares enormes caras y calurosas. No podrían coger una gtx285 y manteniendo su rendimiento optimizarla?, reducir los nm del procesador,etc

Creo que van a hacer algo asi, sacar gt200 a 40nm, pero para gama media. De todas formas no comparemos ION con Fermi, que posiblemente estemos hablando de 50 veces más rendimiento como minimo, y una tarjeta mucho más capacitada para todo. Bastante habrán hecho ya con el consumo, de donde no hay no se puede sacar jeje...

Tambien los Atom consumen mucho menos que los Core 2 Duo, y de la diferencia de rendimiento es mejor no hablar jeje.

e4ff00 escribió:Parece que ya tenemos los nombres para las nuevas Fermi... GTX480/470. La serie GTX380/370 a tomar por cu*****. Con una 310 hay de sobra

Seguro que han modificado ya tanto esta nueva serie de arriba a abajo que hasta han tenido que cambiar el nombre.

Un Saludo.

![Que me parto! [qmparto]](/images/smilies/net_quemeparto.gif)

Anubi escribió:que te apuestas que ahora apareceran graficas de la serie 200 renombradas, como si fueran de la 300.

e4ff00 escribió:Anubi escribió:que te apuestas que ahora apareceran graficas de la serie 200 renombradas, como si fueran de la 300.

Si, y la gente comprando y pensando que son las nuevas Fermi... esperemos de que no haya muchos asi, victimas de confusion.

EDITO: aaaah y como ahora se trata de un nombre nuevo vamos a subir mas los precios, que hay excusa

. Estas gráficas no me la colarán ni a tí, ni a mi, ni a nadie de aquí porque sabemos del tema, se la colaran al pobrecillo de turno que vaya al MierdaMarkt o a una tienda poco seria, vamos, lo de siempre.

. Estas gráficas no me la colarán ni a tí, ni a mi, ni a nadie de aquí porque sabemos del tema, se la colaran al pobrecillo de turno que vaya al MierdaMarkt o a una tienda poco seria, vamos, lo de siempre. Marcos1 escribió:e4ff00 escribió:Anubi escribió:que te apuestas que ahora apareceran graficas de la serie 200 renombradas, como si fueran de la 300.

Si, y la gente comprando y pensando que son las nuevas Fermi... esperemos de que no haya muchos asi, victimas de confusion.

EDITO: aaaah y como ahora se trata de un nombre nuevo vamos a subir mas los precios, que hay excusa

La gente que las compre no lo hara pensando que es una Fermi, entre otras cosas porque no tendrá ni idea de lo que narices es Fermi. Estas gráficas no me la colarán ni a tí, ni a mi, ni a nadie de aquí porque sabemos del tema, se la colaran al pobrecillo de turno que vaya al MierdaMarkt o a una tienda poco seria, vamos, lo de siempre.

Anubi escribió:Eh? Lol, hay que joderse, estos de nvidia son la bomba poniendo nombres, que te apuestas que ahora apareceran graficas de la serie 200 renombradas, como si fueran de la 300.

Anubi escribió:Por fin dan fechas para la salida oficial de las graficas, y es mas de lo que se esperaba, para finales de abril, principios de marzo, pero lo bueno es que aseguran que habra disponibles varios modelos para cumplir con la gama media-alta y baja

VIA http://www.guru3d.com/news/volume-nvidi ... -may-2010/

nogarder escribió:Y digo yo, veo a la gente vendiendo como locos GTX que costaron un paston y 4570 hacia arriba para pillarse casi la misma grafica pero co DX11....

Pero si aun no hay nada para DX11 y se sabe que va a tardar un tiempo, y los juegos actuales van perfectamente hasta con una 8800GT (yo tengo una) y juego a todo...porque tanta prisa en que saquen algo que ahora mismo no hace falta?

Este mundo es de locos, la gente critica a las consolas porque solo tienen una duracion de 5 años, y en pc en cambio la gente como loca por cambiar de grafica y cpu cada año sino es antes...yo desde luego no pienso cambiar de pc cada año, simplemente por moda o porque los programadores pasen de optimizar codigos en pc y solo lo hagan para consola....

que me iban los juegos como la mierda,pero lo que dices es cierto,veo gente con GTX295 vendiendolas de 2ª mano para comprar una GTX 495

que me iban los juegos como la mierda,pero lo que dices es cierto,veo gente con GTX295 vendiendolas de 2ª mano para comprar una GTX 495  DDD pero bueno,si tienen el dinero hay que respetar que se lo gasten en lo que les de la gana.Ahora,yo tengo claro que mi grafica va a durar como minimo 2 años y medio.

DDD pero bueno,si tienen el dinero hay que respetar que se lo gasten en lo que les de la gana.Ahora,yo tengo claro que mi grafica va a durar como minimo 2 años y medio.