razieljas escribió:¡¡POR FIN!!

Ya tengo la Zotac RTX 2080 Ti AMP! montada.

Os pongo una galería de fotos:

https://imgur.com/a/St3Bv70

He probado el 3DMark y me da 12909 puntos, aunque creo que tener el Gsync activado resta, en TechPowerUp les da 13000 raspados. De sonoridad muy muy bien, no suena más que la EVGA GTX 1080 FTW que tenía y se quedó a 60C durante todo el test.

¿Qué usáis para ver el % de utilización de GPU en los juegos? En el Shadow of the Tomb Raider estoy viendo prácticamente el doble de framerate a 1440p 21:9.

Strait escribió:No sé si se habrá puesto ya por aquí, pero nvidia está trabajando en que el cambio a la serie 2000 merezca la pena de verdad https://www.youtube.com/watch?v=mFSLro_OXLQ

adriano_99 escribió:Strait escribió:No sé si se habrá puesto ya por aquí, pero nvidia está trabajando en que el cambio a la serie 2000 merezca la pena de verdad https://www.youtube.com/watch?v=mFSLro_OXLQ

Ese vídeo pierde toda la credibilidad en el momento en que no muestra nada en pantalla que pruebe a que gráfica se corresponden esos rendimientos, pueden ser totalmente distintas y sólo tenemos su palabra.

Pero nada, mejor seguir alimentando un bulo de internet que se ha demostrado varias veces ser falso:

https://www.youtube.com/watch?v=GBkGu4Wd7vg

https://www.youtube.com/watch?v=lY7_ujxbdNY

Strait escribió:adriano_99 escribió:Strait escribió:No sé si se habrá puesto ya por aquí, pero nvidia está trabajando en que el cambio a la serie 2000 merezca la pena de verdad https://www.youtube.com/watch?v=mFSLro_OXLQ

Ese vídeo pierde toda la credibilidad en el momento en que no muestra nada en pantalla que pruebe a que gráfica se corresponden esos rendimientos, pueden ser totalmente distintas y sólo tenemos su palabra.

Pero nada, mejor seguir alimentando un bulo de internet que se ha demostrado varias veces ser falso:

https://www.youtube.com/watch?v=GBkGu4Wd7vg

https://www.youtube.com/watch?v=lY7_ujxbdNY

Tampoco me vale que me pongas vídeos de canales que trabajan con marcas (entre ellas nvidia) y que son más medios de propaganda que informativos.

El Pelanas escribió:¿Qué rtx 2080ti es buena en cuanto el número de ventiladores para que disipe mejor el calor? La de Asus, Nvidia...

Strait escribió:adriano_99 escribió:Strait escribió:No sé si se habrá puesto ya por aquí, pero nvidia está trabajando en que el cambio a la serie 2000 merezca la pena de verdad https://www.youtube.com/watch?v=mFSLro_OXLQ

Ese vídeo pierde toda la credibilidad en el momento en que no muestra nada en pantalla que pruebe a que gráfica se corresponden esos rendimientos, pueden ser totalmente distintas y sólo tenemos su palabra.

Pero nada, mejor seguir alimentando un bulo de internet que se ha demostrado varias veces ser falso:

https://www.youtube.com/watch?v=GBkGu4Wd7vg

https://www.youtube.com/watch?v=lY7_ujxbdNY

Tampoco me vale que me pongas vídeos de canales que trabajan con marcas (entre ellas nvidia) y que son más medios de propaganda que informativos.

the_gooseman escribió:Lo cierto es que con los últimos drivers van peor todas las graficas Nvidia, incluidas las Turing

razieljas escribió:Una 2080 Ti va a estar de vacaciones a 1080p por mas frame rate que quieras, cosa que tú CPU no va a dar a basto, es tirar el dinero. Además tienes un no K, luego imagino que va a frecuencias nominales, olvídate ya.

Las 2080Ti no son para 1080p.

![carcajada [carcajad]](/images/smilies/nuevos/risa_ani2.gif)

vtec16 escribió:razieljas escribió:Una 2080 Ti va a estar de vacaciones a 1080p por mas frame rate que quieras, cosa que tú CPU no va a dar a basto, es tirar el dinero. Además tienes un no K, luego imagino que va a frecuencias nominales, olvídate ya.

Las 2080Ti no son para 1080p.

No entiendo nada lo de que las 2080ti no son para los 1080p.

Yo tengo 3 monitores, pero ahora te voy a hablar de un 4k 60hz y un 1080p 144hz.

Mi tarjeta anterior era una gtx 1080 subida de oc todo lo que se podia.

Cuando utilizaba el 1080p 144hz, en juegos como Evil Whitin 2 jugaba entre 80 y 90fps y muchas opciones graficas en nivel medio, se que este juego no tiene la mejor optimizacion, pero te puedo poner mas juegos de ejemplo, en 4k me olvidaba de jugar.

Ahora con la 2080ti juego con todo en ultra entre 120 y 140fps, una autentica gozada con la suavidad que se mueve y también puedo jugar en 4k bajando algunas cosas con framerate bastante estable entre 50 y 60hz, pero esto es aparte.

Mi procesador es un 5820k subido a 4,2ghz, vamos que todos sabemos que no es el mejor procesador para juegos.

Asi que, que alguien me explique lo de que con una 2080ti no aprovechas un monitor 1080p 144hz y encima comentais que con una 1080 suficiente cuando yo la he tenido y con muchos juegos metiendo detalles altos le costaba llegar a 80fps y ahora con casi cualquiera que pruebo me va a 140 y 160 fps con la punta del...

que alguien me lo explique por que no lo entiendo

EDITO: Es mas, me he dado cuenta que estaba jugando ahora al Evil Whitin 2 con el perfil "light" que tengo con frecuencias 1845mhz para que no me pase de 65º, asi que si le aprieto los fps se irán por encima de los 140 facil.

tigretong escribió:desde el momento q en 4k saca mas distancia la 2080ti a la 1080ti q en 1080p, es q la grafica la estas desapovechando (escala menos)

aun asi, no me entra en la cabeza q alguien se compre 1 grafica de 1400e para jugar a 1080p

vtec16 escribió:@adriano_99

No estoy de acuerdo del todo y te lo digo porque tuve también una 1080ti durante unos dias y con los ssaa x2 o x4 se ahoga, la 2080ti los aguanta mucho mas holgada. Otra cosa es que en benchs esos lo prueben como les salgan de las pelotas, con opciones graficas mas estandar.

Si le metes todo al maximo se va a notar la diferencia por fuerza bruta de una a otra, por lo menos en mi 5820k pero en el resto siempre que no sea un desproposito de procesador también se tiene que notar.

tigretong escribió:desde el momento q en 4k saca mas distancia la 2080ti a la 1080ti q en 1080p, es q la grafica la estas desapovechando (escala menos)

aun asi, no me entra en la cabeza q alguien se compre 1 grafica de 1400e para jugar a 1080p

paco_man escribió:tigretong escribió:desde el momento q en 4k saca mas distancia la 2080ti a la 1080ti q en 1080p, es q la grafica la estas desapovechando (escala menos)

aun asi, no me entra en la cabeza q alguien se compre 1 grafica de 1400e para jugar a 1080p

Conozco a varios que con monitores 2k activan el DSR para poner el juego a 4k y ver una imagen cristalina, sin dientes de sierra ni lineas parpadeantes. Según dicen es el mejor antialiasing, aunque para hacer eso te hace falta una tarjeta con mucho músculo, aunque depende del juego.

vtec16 escribió:@adriano_99

No estoy de acuerdo del todo y te lo digo porque tuve también una 1080ti durante unos dias y con los ssaa x2 o x4 se ahoga, la 2080ti los aguanta mucho mas holgada. Otra cosa es que en benchs esos lo prueben como les salgan de las pelotas, con opciones graficas mas estandar.

Si le metes todo al maximo se va a notar la diferencia por fuerza bruta de una a otra, por lo menos en mi 5820k pero en el resto siempre que no sea un desproposito de procesador también se tiene que notar.

Letrina escribió:Me parece que al final no comprare ningúna tarjeta gráfica xDD

https://www.noticias3d.com/noticia.asp?idnoticia=76038

250€ por algo que rinde como la RTX2070 y gtx1080ti?

Lo que compremos ahora si se confirma todo esto, va a durar 2 años máximo, para entonces tendremos algo bastante bastante mejor, parece que eso si es el salto, tal vez RTX en esta tecnología era lo que querían.

Ayer me dejaban una Gt´x1080ti Founders Edition por 350€ sin garantía, pero ese disipador... es que ni por ese precio, sino fuera por eso la hubiera pillado, sobretodo por no tener ni la garantía del fabricante, porque me dejan otra de gigabyte pero que le pasa lo mismo que no tiene garantía... pero ya son unos precios que te lo puedes plantear, ara... como le pase algo has palmado 350€

La putada ahora es si compras un monitor con g-sync te casas con nvidia, y si es free-sync te casas con AMD... eso no mola...

adriano_99 escribió:Letrina escribió:Me parece que al final no comprare ningúna tarjeta gráfica xDD

https://www.noticias3d.com/noticia.asp?idnoticia=76038

250€ por algo que rinde como la RTX2070 y gtx1080ti?

Lo que compremos ahora si se confirma todo esto, va a durar 2 años máximo, para entonces tendremos algo bastante bastante mejor, parece que eso si es el salto, tal vez RTX en esta tecnología era lo que querían.

Ayer me dejaban una Gt´x1080ti Founders Edition por 350€ sin garantía, pero ese disipador... es que ni por ese precio, sino fuera por eso la hubiera pillado, sobretodo por no tener ni la garantía del fabricante, porque me dejan otra de gigabyte pero que le pasa lo mismo que no tiene garantía... pero ya son unos precios que te lo puedes plantear, ara... como le pase algo has palmado 350€

La putada ahora es si compras un monitor con g-sync te casas con nvidia, y si es free-sync te casas con AMD... eso no mola...

Vega también iba a pasarse por el forro a las 1080ti costando la mitad y todos sabemos cómo acabó.

Hasta que no lo vea no me lo creo.

albertoooooooooo escribió:adriano_99 escribió:Letrina escribió:Me parece que al final no comprare ningúna tarjeta gráfica xDD

https://www.noticias3d.com/noticia.asp?idnoticia=76038

250€ por algo que rinde como la RTX2070 y gtx1080ti?

Lo que compremos ahora si se confirma todo esto, va a durar 2 años máximo, para entonces tendremos algo bastante bastante mejor, parece que eso si es el salto, tal vez RTX en esta tecnología era lo que querían.

Ayer me dejaban una Gt´x1080ti Founders Edition por 350€ sin garantía, pero ese disipador... es que ni por ese precio, sino fuera por eso la hubiera pillado, sobretodo por no tener ni la garantía del fabricante, porque me dejan otra de gigabyte pero que le pasa lo mismo que no tiene garantía... pero ya son unos precios que te lo puedes plantear, ara... como le pase algo has palmado 350€

La putada ahora es si compras un monitor con g-sync te casas con nvidia, y si es free-sync te casas con AMD... eso no mola...

Vega también iba a pasarse por el forro a las 1080ti costando la mitad y todos sabemos cómo acabó.

Hasta que no lo vea no me lo creo.

Nunca dijeron que Vega fuera a costar la mitad, dijo que igualarían rendimiento y lo hicieron, lo que pasa es que con unos consumos y temperaturas... (Que casualmente ahora tienen las 20XX). Y se llevó unos palos tremendos por ello. Además HBM2 supuso una subida de precio por lo que esta vez AMD no pudo competir en precio.

@Letrina ráscale un poco el precio y métele un Accelero, es lo que hice yo con mi HD7970 y contentísimo

Letrina escribió:Me parece que al final no comprare ningúna tarjeta gráfica xDD

https://www.noticias3d.com/noticia.asp?idnoticia=76038

250€ por algo que rinde como la RTX2070 y gtx1080ti?

Lo que compremos ahora si se confirma todo esto, va a durar 2 años máximo, para entonces tendremos algo bastante bastante mejor, parece que eso si es el salto, tal vez RTX en esta tecnología era lo que querían.

Ayer me dejaban una Gt´x1080ti Founders Edition por 350€ sin garantía, pero ese disipador... es que ni por ese precio, sino fuera por eso la hubiera pillado, sobretodo por no tener ni la garantía del fabricante, porque me dejan otra de gigabyte pero que le pasa lo mismo que no tiene garantía... pero ya son unos precios que te lo puedes plantear, ara... como le pase algo has palmado 350€

La putada ahora es si compras un monitor con g-sync te casas con nvidia, y si es free-sync te casas con AMD... eso no mola...

![facepalm [facepalm]](/images/smilies/facepalm.gif)

vtec16 escribió:@adriano_99

Monitor 1440p tengo, un LG 21:9 3440x1440 ips 60hz. Como había comentado tengo 3 monitores pero parece que para poder tener una 2080ti tengas que tener un 4k y jugar a 60hz (con suerte) y no lo digo por ti pero si por muchos comentarios que se leen aqui y que si tienes un 1080p de 144hz es una locura utilizarlo en una 2080ti..

Al igual que el que dice que un monitor 1080p cuesta 100€. Yo tengo un Samsung Qled que cuesta 270€ de 23.5 y se ve muy bien y seguramente sea mejor monitor que muchos 2k que hay por ahí.

Creo que todo no es ni blanco ni negro hay otra gama de colores.

La 2080ti va a tirar siempre mas que cualquier grafica en 1080p 144hz, siempre, y no hace falta meter un saax4. Otra cosa es que en proporción no le saques tanto provecho, puedes hacer undervolt bajar un poco las frecuencias y que no te pase de 60°, es otra forma de aprovechar esa potencia extra.

albertoooooooooo escribió:@adriano_99 tampoco he dicho que no tenga mejor rendimiento por W, he dicho que ha aumentado al nivel de Vega. De todas maneras el objetivo debería ser mejorar rendimiento y bajar consumo, a ver con los 7nm de Navi en que queda y si esto se cumple.

adriano_99 escribió:vtec16 escribió:@adriano_99

Monitor 1440p tengo, un LG 21:9 3440x1440 ips 60hz. Como había comentado tengo 3 monitores pero parece que para poder tener una 2080ti tengas que tener un 4k y jugar a 60hz (con suerte) y no lo digo por ti pero si por muchos comentarios que se leen aqui y que si tienes un 1080p de 144hz es una locura utilizarlo en una 2080ti..

Al igual que el que dice que un monitor 1080p cuesta 100€. Yo tengo un Samsung Qled que cuesta 270€ de 23.5 y se ve muy bien y seguramente sea mejor monitor que muchos 2k que hay por ahí.

Creo que todo no es ni blanco ni negro hay otra gama de colores.

La 2080ti va a tirar siempre mas que cualquier grafica en 1080p 144hz, siempre, y no hace falta meter un saax4. Otra cosa es que en proporción no le saques tanto provecho, puedes hacer undervolt bajar un poco las frecuencias y que no te pase de 60°, es otra forma de aprovechar esa potencia extra.

Bueno, mi opinión sigue siendo que no tiene sentido pero allá cada uno obviamente.albertoooooooooo escribió:@adriano_99 tampoco he dicho que no tenga mejor rendimiento por W, he dicho que ha aumentado al nivel de Vega. De todas maneras el objetivo debería ser mejorar rendimiento y bajar consumo, a ver con los 7nm de Navi en que queda y si esto se cumple.

Tampoco es cierto desde el momento en que la inmensa mayoría de compañeros del foro que tienen turing simplemente ajustando un poco la curva de ventiladores no llegan a los 70 grados.

No hay ni punto de comparación entre als temperaturas de turing y las de vega.

albertoooooooooo escribió:

Una Vega64 con ventiladores por defecto no pasa de 75° en las review, como las 2080ti.

Hazle una curva y verás como tampoco llega a los 70.

adriano_99 escribió:albertoooooooooo escribió:

Una Vega64 con ventiladores por defecto no pasa de 75° en las review, como las 2080ti.

Hazle una curva y verás como tampoco llega a los 70.

75 grados es una barbaridad para una de las custom tochas, es mas o menos como las turing founders y eso que son de las peores.

No hay punto de comparación.

albertoooooooooo escribió:adriano_99 escribió:albertoooooooooo escribió:

Una Vega64 con ventiladores por defecto no pasa de 75° en las review, como las 2080ti.

Hazle una curva y verás como tampoco llega a los 70.

75 grados es una barbaridad para una de las custom tochas, es mas o menos como las turing founders y eso que son de las peores.

No hay punto de comparación.

Hombre hay 2 grados de diferencia contra el mismo modelo tope de gama...

albertoooooooooo escribió:@adriano_99 no son trampas, es el modo por defecto y con el que se ha hecho la comparativa. Entiendo que para la vega es lo mismo, pero no se indica en ninguna de los bench. Aún asi, son los valores que recordaba y no se van tanto como tu quieres hacer creer. La temperatura ha subido una barbaridad en la serie 20 quieras o no, pese a que haya aumentado el rendimiento.

Por otra parte, he visto que asus está sacando versiones "Advanced edition" de sus gráficas, están en pccomponentes por ejemplo. ¿Alguien sabe las diferencias con el modelo normal?"

![Ok! [oki]](/images/smilies/net_thumbsup.gif)

![facepalm [facepalm]](/images/smilies/facepalm.gif)

Mayban36 escribió:De verdad se ha llegado al punto de defender que las serie 2000 no consumen tanto?

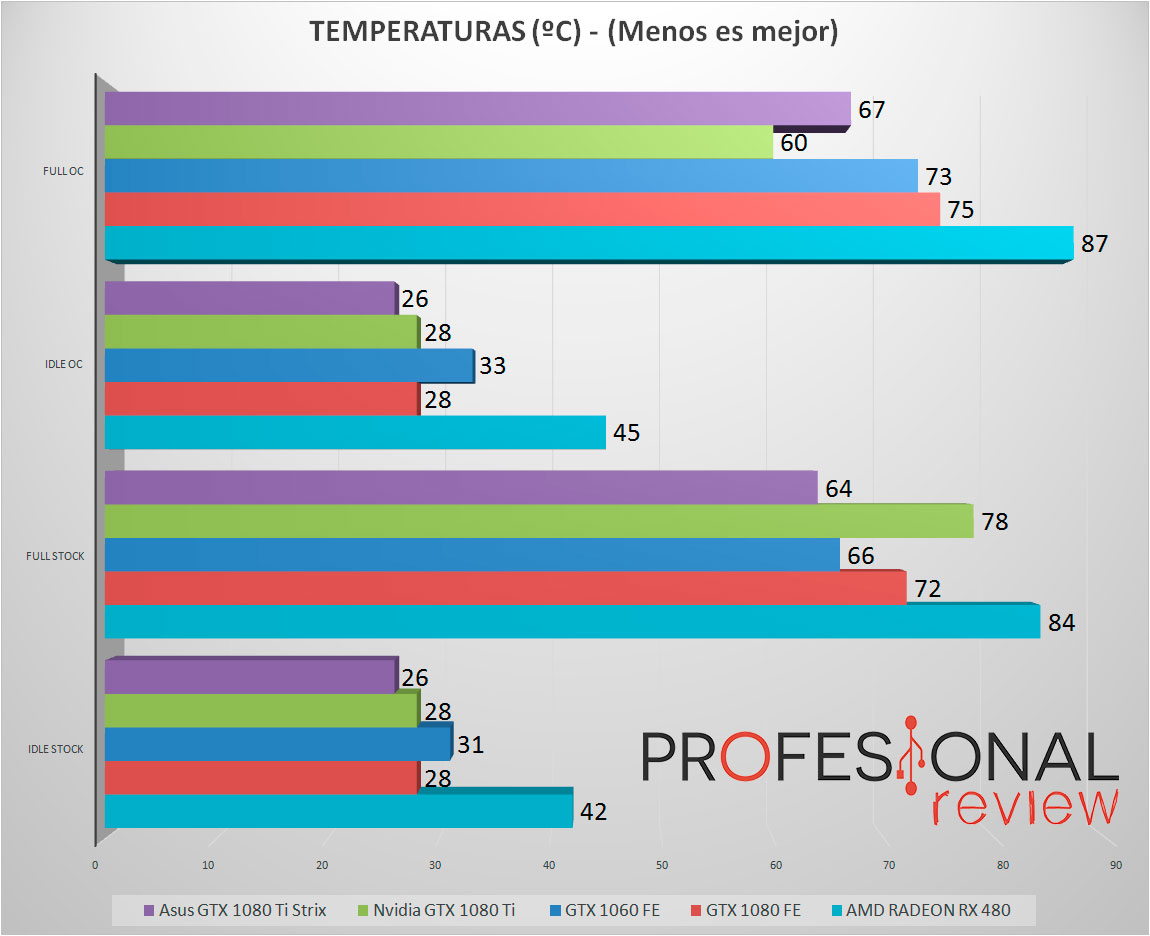

albertoooooooooo escribió:@adriano_99 con esa gráfica solo confirmas lo que yo he dicho, que la 2080ti es unos 8-9° más caliente que una 1080ti, te das cuenta? Para mi eso es una subida bastante alta, pero bueno...todos a bailar al son de Nvidia... Para mi decir que 2° de diferencia es poder decir que están al mismo nivel de temperatura (cosa que no pasaba con la 1080ti que se quedaba a más de 10°)Mayban36 escribió:De verdad se ha llegado al punto de defender que las serie 2000 no consumen tanto?

Si hijo si... Parece que sean las gráficas mas frescas y eficientes del mundo...

adriano_99 escribió:albertoooooooooo escribió:@adriano_99 con esa gráfica solo confirmas lo que yo he dicho, que la 2080ti es unos 8-9° más caliente que una 1080ti, te das cuenta? Para mi eso es una subida bastante alta, pero bueno...todos a bailar al son de Nvidia... Para mi decir que 2° de diferencia es poder decir que están al mismo nivel de temperatura (cosa que no pasaba con la 1080ti que se quedaba a más de 10°)Mayban36 escribió:De verdad se ha llegado al punto de defender que las serie 2000 no consumen tanto?

Si hijo si... Parece que sean las gráficas mas frescas y eficientes del mundo...

Pero tío, que dejes de ignorar lo datos que no te dan la razón!!!!

No puedes simplemente usar el dato mas elevado correspondiente a un modo centrado en hacer el mínimo de ruido posible y quedarte tan pancho cuando tienes el modo rendimiento que la deja 10 grados mas bajos.

En fin, paso, tienes tu discurso que vas a repetir una y otra vez te pongan las pruebas que te pongan.

Ni te molestes, directo a ignorados.

vtec16 escribió:@adriano_99

Monitor 1440p tengo, un LG 21:9 3440x1440 ips 60hz. Como había comentado tengo 3 monitores pero parece que para poder tener una 2080ti tengas que tener un 4k y jugar a 60hz (con suerte) y no lo digo por ti pero si por muchos comentarios que se leen aqui y que si tienes un 1080p de 144hz es una locura utilizarlo en una 2080ti..

Al igual que el que dice que un monitor 1080p cuesta 100€. Yo tengo un Samsung Qled que cuesta 270€ de 23.5 y se ve muy bien y seguramente sea mejor monitor que muchos 2k que hay por ahí.

Creo que todo no es ni blanco ni negro hay otra gama de colores.

La 2080ti va a tirar siempre mas que cualquier grafica en 1080p 144hz, siempre, y no hace falta meter un saax4. Otra cosa es que en proporción no le saques tanto provecho, puedes hacer undervolt bajar un poco las frecuencias y que no te pase de 60°, es otra forma de aprovechar esa potencia extra.

Strait escribió:Yo he tenido que volver a drivers anteriores por errores visuales en casi todos los juegos y hasta en el escritorio de windows. Indagando en el foro de nvidia he visto el hilo donde habían puesto ese vídeo, y a más de un usuario diciendo que también lo había notando en los driver 4xx con respecto a los 3xx. No sé qué creer.

albertoooooooooo escribió: ............Además que desde un principio solo he indicada que habian subido las temp y consumo como las subió Vega en su día. Ahora parece que es normal 400W en una 2080ti pero inasumible en una Vega. A mí personalmente me la pela porque tengo una fuente de 1250W, solo ha sido un comentario. Además que en profesionaReview, por usar la misma web que has puesto tu indican 69° (no 63 como tu dices de 10° de diferencia). Cada web da unas temperaturas, usa las que a ti más te guste para dormir tranquilo defendiendo tu gráfica favorita

wwwendigo escribió:¿Porqué es escandaloso el consumo de Vega?, porque da el rendimiento de un GP104, consumiendo mucho más (<fps/W), y aún por encima salió a posteriori, cuando lo normal en un mercado es que de productos posteriores a uno referencia para los demás es que se superen sus cualidades, que no ha sido en absoluto el caso.

joseanime16 escribió:Buenas, señores para los que la tenga la 2080 Ti.

¿Se puede jugar a todos los juegos a 4K@60Hz sin bajadas?

Me estoy planteando comprar una.

![enamorado [amor]](/images/smilies/nuevos/enamorado.gif)