Según señala Nvidia, Volta brindará una mejora mucho más que significativa frente a Pascal, quintuplicando su rendimiento en teraflops y multiplicando por 15 el ofrecido por la arquitectura Maxwell. La firma asegura que esto supone ir cuatro veces más rápido que la ley de Moore, aunque no está del todo claro de si la compañía habla de la arquitectura en términos generales o si se refiere a sus aplicaciones profesionales como la Tesla V100, que es monstruo por derecho propio dirigido a un mercado muy concreto y muy alejado del consumidor común.

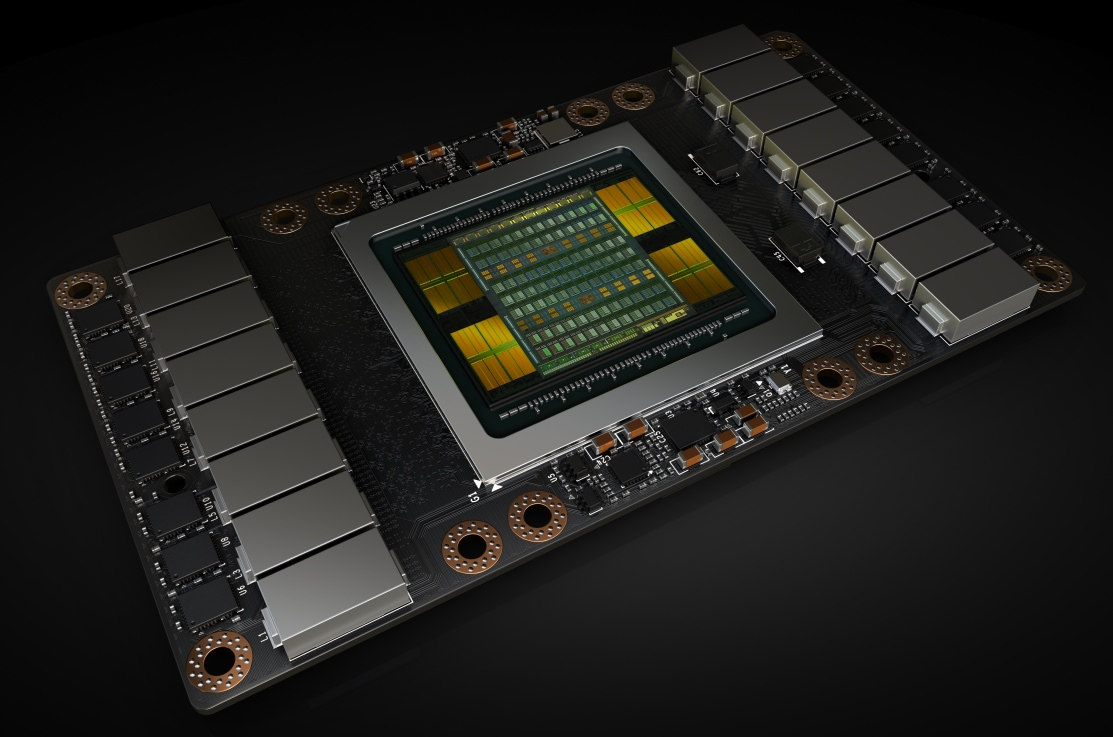

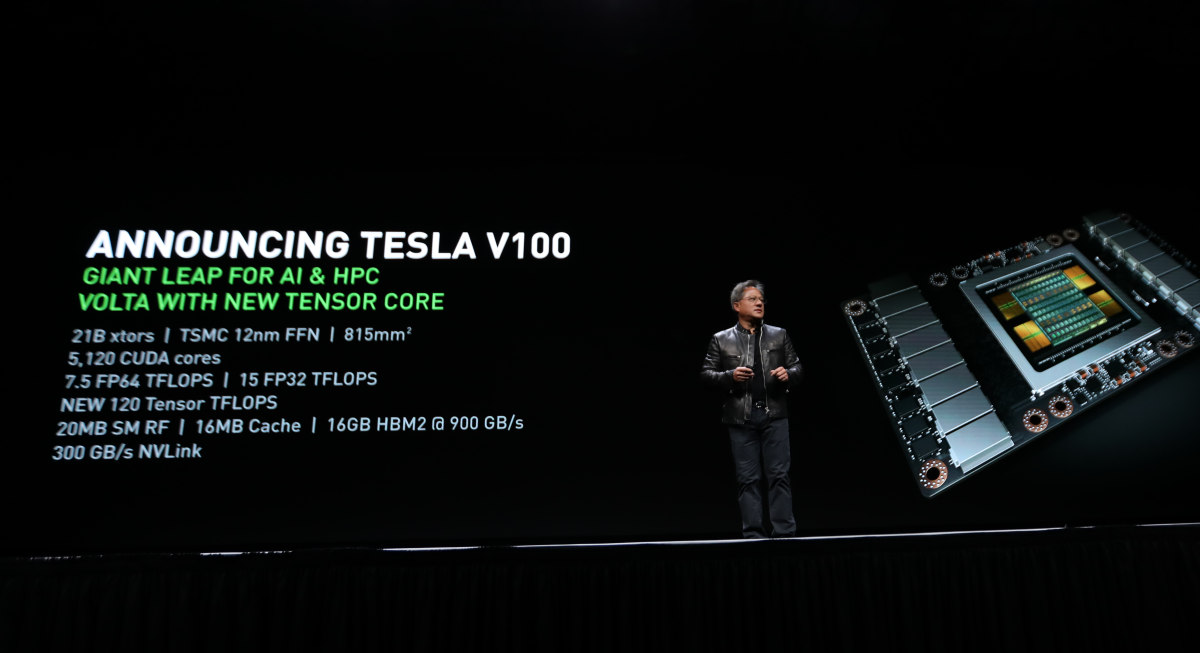

Sucesora de la Tesla P100 anunciada el año pasado, la nueva V100 viene con una ficha técnica que se antoja una hipérbole en sí misma, aglutinando en su nuevo procesador gráfico GV100 21.000 millones de transistores y 5.120 núcleos CUDA con una velocidad de reloj de 1.455 MHz (curiosamente, un poco por debajo de los 1.480 MHz del modelo precedente).

Cada una de estas tarjetas NVLink de nueva generación utilizará 16 GB de memoria HBM2 con una interfaz de 900 GB/s y tendrá un TDP de 300 vatios. En términos de rendimiento, Nvidia señala en su ficha la posibilidad de alcanzar 7,5 TFLOPS FP64, 15 TFLOPS F32 (eran 5,3 y 10,6 en el modelo anterior, respectivamente) y 120 TFLOPS Tensor.

Un punto notable es la enorme superficie ocupada por el procesador. El tamaño del die es extraordinariamente grande, con nada más y nada menos que 815 milímetros cuadrados. Aparentemente es el límite absoluto que ha podido alcanzar TSMC usando su proceso FinFet de 12 nm.

Según Huang, en su desarrollo se han ido 3.000 millones de dólares, una cantidad que obviamente Nvidia espera recuperar con la venta de equipos profesionales con varias de estas tarjetas. Amazon y Microsoft son algunas de las firmas que ya han expresado su interés. Nvidia ofrecerá una estación de trabajo con cuatro tarjetas Tesla V100 por el módico precio de 69.000 dólares, pero también habrá un servidor de alto rendimiento para inteligencia artificial con ocho tarjetas y una tarifa de 149.000 dólares.